Finnes det et AI-søkindeks? Hvordan AI-motorer indekserer innhold

Lær hvordan AI-søkindekser fungerer, forskjellene mellom ChatGPT, Perplexity og SearchGPTs indekseringsmetoder, og hvordan du kan optimalisere innholdet ditt fo...

Oppdag de grunnleggende forskjellene mellom AI-indeksering og Google-indeksering. Lær hvordan LLM-er, vektorembeddinger og semantisk søk endrer informasjonsinnhenting og hva det betyr for synligheten av innholdet ditt.

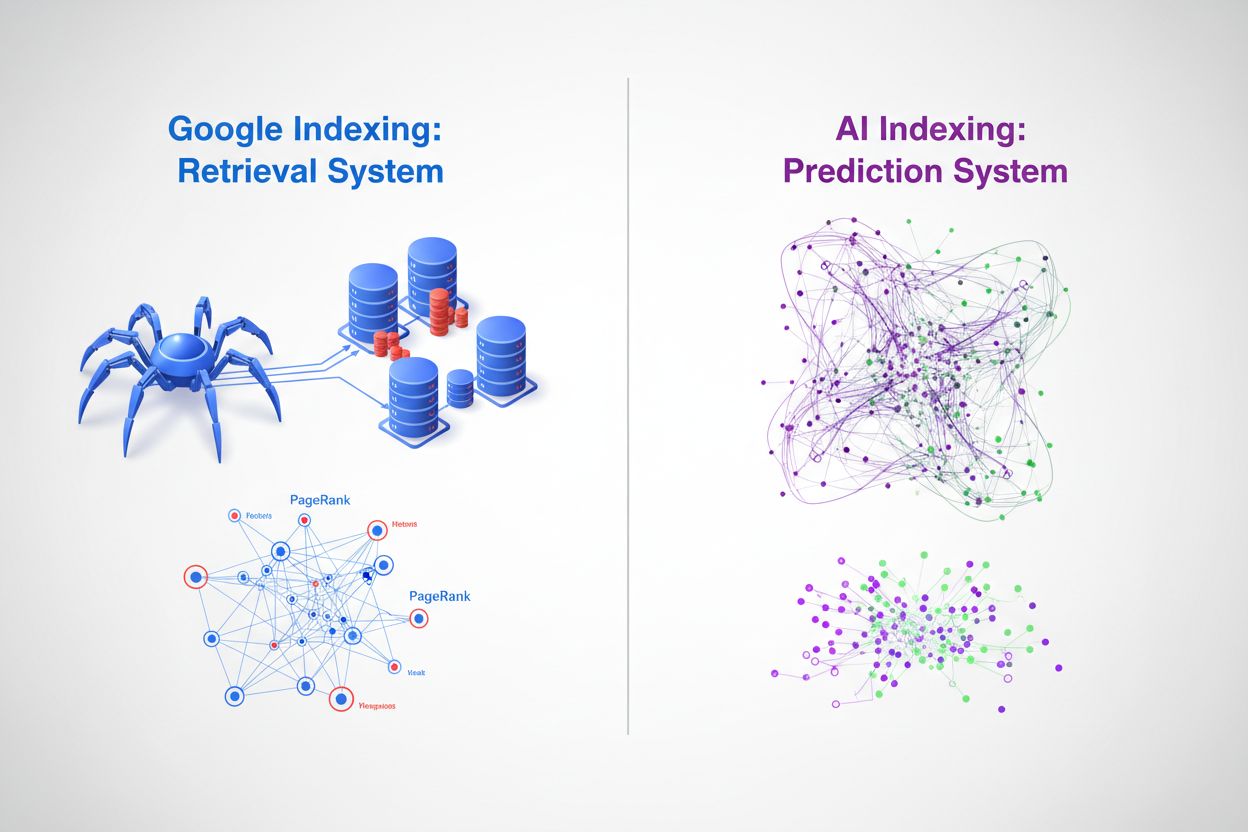

I sin kjerne representerer Google-indeksering og AI-indeksering to fundamentalt ulike tilnærminger til å organisere og hente informasjon. Googles tradisjonelle søkemotor fungerer som et gjenfinningssystem—den gjennomsøker nettet, katalogiserer innhold og returnerer rangerte lenker når brukere søker etter spesifikke nøkkelord. Til sammenligning fungerer AI-indeksering gjennom store språkmodeller (LLM-er) som ChatGPT, Gemini og Copilot som et prediksjonssystem—den koder enorme mengder treningsdata i nevrale nettverk og genererer kontekstuelt relevante svar direkte. Mens Google spør “hvor er denne informasjonen?”, spør AI “hva er det mest relevante svaret?” Dette skillet endrer grunnleggende hvordan innhold oppdages, rangeres og presenteres for brukere, og skaper to parallelle, men stadig mer sammenkoblede informasjonssystemer.

Googles indekseringsprosess følger en veletablert arbeidsflyt som har dominert søkemarkedet i over to tiår. Googlebot-crawlere traverserer systematisk nettet, følger lenker fra side til side og samler innhold som deretter bearbeides gjennom Googles indekseringsinfrastruktur. Systemet trekker ut nøkkelsignaler som nøkkelord, metadata og lenkestruktur, og lagrer denne informasjonen i enorme distribuerte databaser. Googles proprietære PageRank-algoritme vurderer viktigheten av sider basert på antallet og kvaliteten på lenker som peker til dem, ut fra prinsippet om at viktige sider får flere lenker fra andre viktige sider. Nøkkelordmatching er fortsatt sentralt for relevansvurdering—når en bruker skriver inn et søk, identifiserer Googles system sider med de eksakte eller semantisk lignende begrepene og rangerer dem ut fra hundrevis av rangeringsfaktorer, inkludert domeneautoritet, innholdsaktualitet, brukeropplevelsessignaler og tematisk relevans. Denne tilnærmingen utmerker seg ved å finne spesifikk informasjon raskt og har vist seg svært effektiv for navigasjons- og transaksjonssøk, noe som forklarer Googles 89,56 % markedsandel på søk og behandling av 8,5–13,7 milliarder søk daglig.

| Aspekt | Google-indeksering | Detaljer |

|---|---|---|

| Primær mekanisme | Nettskraping & indeksering | Googlebot traverserer nettsider systematisk |

| Rangeringsalgoritme | PageRank + 200+ faktorer | Lenker, nøkkelord, aktualitet, brukeropplevelse |

| Datarepresentasjon | Nøkkelord & lenker | Teksttokens og hyperlenkeforhold |

| Oppdateringsfrekvens | Kontinuerlig crawling | Sanntidsindeksering av nytt/oppdatert innhold |

| Spørringsprosessering | Nøkkelordmatching | Eksakt og semantisk matching av nøkkelord |

| Markedsandel | 89,56 % globalt | 8,5–13,7 milliarder søk daglig |

AI-modeller bruker en grunnleggende annen indekseringsmekanisme sentrert rundt vektorembeddinger og semantisk forståelse i stedet for nøkkelordmatching. Under trening prosesserer LLM-er milliarder av teksttokens, og lærer å representere konsepter, relasjoner og betydninger som høy-dimensjonale vektorer i en prosess kalt embedding-generering. Disse embeddingene fanger semantiske relasjoner—for eksempel, “konge” minus “mann” pluss “kvinne” gir omtrent “dronning”—slik at modellen kan forstå kontekst og intensjon i stedet for bare å matche tegnstrenger. Indekseringsprosessen i AI-systemer omfatter flere sentrale mekanismer:

Denne tilnærmingen gjør at AI-systemer kan forstå brukerintensjon selv når spørsmål bruker annen terminologi enn kildematerialet, og å syntetisere informasjon på tvers av flere konsepter for å generere nye svar. Resultatet er et fundamentalt annerledes gjenfinningsparadigme der “indeksen” er distribuert i de nevrale nettverksvektene i stedet for å lagres i en tradisjonell database.

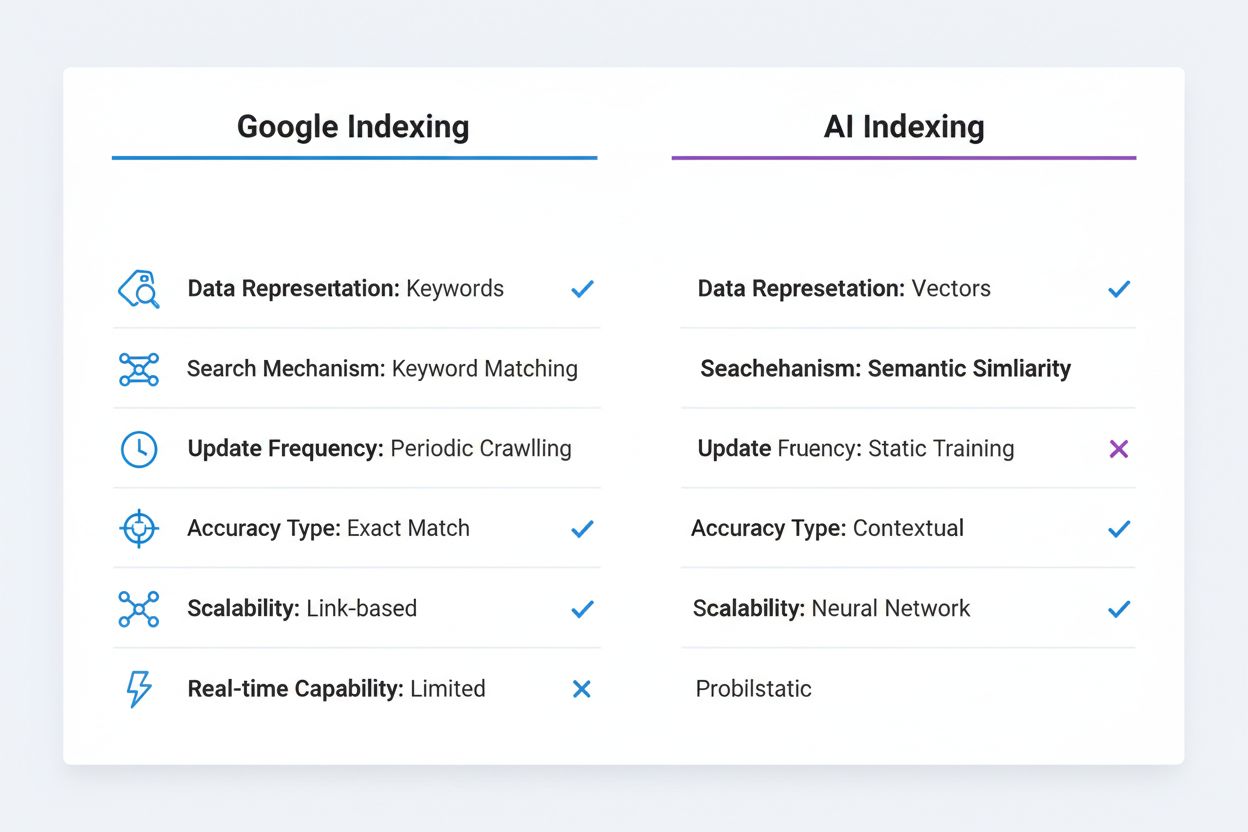

De tekniske forskjellene mellom Google-indeksering og AI-indeksering gir store konsekvenser for synlighet og oppdagbarhet av innhold. Eksakt nøkkelordmatching, som fortsatt er viktig i Googles algoritme, er stort sett irrelevant i AI-systemer—en LLM forstår at “automobil”, “bil” og “kjøretøy” er semantisk likeverdige uten eksplisitt nøkkelordoptimalisering. Googles indeksering er deterministisk og reproduserbar; det samme søket gir de samme rangerte resultatene for ulike brukere og tidspunkter (med unntak av personalisering). AI-indeksering er probabilistisk og variabel; samme spørring kan gi ulike svar basert på temperaturinnstillinger og samplingsparametere, selv om den underliggende kunnskapen er den samme. Googles system er overlegent på strukturert, diskret informasjon som produktpriser, åpningstider og faktiske datapunkter, noe det kan trekke ut og vise i rike utdrag og kunnskapspaneler. AI-systemer har utfordringer med slik presis, oppdatert informasjon fordi treningsdataene har en kunnskapsgrense og ikke kan hente sanntidsdata uten eksterne verktøy. Omvendt utmerker AI-systemer seg på kontekstforståelse og syntese, og kobler sammen ulike konsepter og forklarer komplekse sammenhenger på naturlig språk. Googles indeksering krever eksplisitt lenking og sitering—innhold må publiseres på nettet og lenkes til for å bli oppdaget. AI-indeksering opererer på implisitt kunnskap kodet under trening, noe som betyr at verdifull informasjon låst i PDF-er, betalingsmurer eller private databaser forblir usynlig for begge systemene, men av ulike grunner.

| Sammenligningsaspekt | Google-indeksering | AI-indeksering |

|---|---|---|

| Datarepresentasjon | Nøkkelord & lenker | Vektorembeddinger |

| Søkemekanisme | Nøkkelordmatching | Semantisk likhet |

| Oppdateringsfrekvens | Periodisk crawling | Statisk treningsdata |

| Nøyaktighetstype | Fokus på eksakt treff | Kontekstuell forståelse |

| Skalerbarhetsmodell | Lenke-basert autoritet | Nevrale nettverksvekter |

| Sanntidskapasitet | Ja (med crawling) | Begrenset (uten RAG) |

Fremveksten av vektordatabaser utgjør en avgjørende bro mellom tradisjonell indeksering og AI-drevet gjenfinning, og gjør det mulig for virksomheter å implementere semantisk søk i stor skala. Vektordatabaser som Pinecone, Weaviate og Milvus lagrer høy-dimensjonale embeddinger og utfører likhetssøk med metrikker som cosinuslikhet og euklidsk avstand, slik at systemer kan finne semantisk relaterte innhold selv når eksakte nøkkelord ikke matcher. Denne teknologien driver Retrieval-Augmented Generation (RAG), en teknikk der AI-systemer spør vektordatabaser for å hente relevant kontekst før de genererer svar, noe som dramatisk forbedrer nøyaktigheten og gir tilgang til proprietær eller oppdatert informasjon. RAG-systemer kan hente de mest semantisk like dokumentene til et brukerforespørsel på millisekunder, slik at AI-modellen får grunnleggende informasjon å sitere og bygge videre på. Google har integrert semantisk forståelse i sin kjernealgoritme gjennom BERT og påfølgende modeller, og beveger seg forbi ren nøkkelordmatching til å forstå søkeintensjon og innholdsbetydning. Vektordatabaser muliggjør sanntidsgjenfinning av relevant informasjon, slik at AI-systemer kan få tilgang til oppdaterte data, virksomhetsspesifikke kunnskapsbaser og spesialisert informasjon uten ny trening. Denne kapasiteten er spesielt nyttig for bedriftsapplikasjoner, der organisasjoner trenger at AI-systemer svarer på spørsmål om proprietær informasjon med høy nøyaktighet og verifiserbare sitater.

Fremveksten av AI-indeksering endrer grunnleggende hvordan innhold får synlighet og driver trafikk. Zero-click-fenomenet—der Google besvarer spørsmål direkte i søkeresultatet uten at brukeren klikker seg videre til kildesiden—har akselerert dramatisk med AI-integrasjon, og AI-chatboter tar dette enda lenger ved å generere svar uten synlig attribusjon. Tradisjonell klikktrafikk erstattes av AI-sitater, der innholdsskapere får synlighet gjennom omtale i AI-genererte svar i stedet for brukerklikk. Dette gir store konsekvenser: et merke nevnt i et ChatGPT-svar kan nå millioner av brukere uten å generere direkte trafikk eller gi analysedata om engasjement. Merkevareautoritet og tematisk ekspertise blir stadig viktigere ettersom AI-systemer er trent til å sitere autoritative kilder og gjenkjenne domeneekspertise, noe som gjør det avgjørende for virksomheter å bygge tydelige autoritetssignaler i innholdet. Strukturert datamerking blir mer verdifullt i denne sammenhengen, fordi det hjelper både Google og AI-systemer å forstå innholdets kontekst og troverdighet. Synlighet handler ikke lenger bare om å rangere på nøkkelord—det handler om å bli anerkjent som en autoritativ kilde verdig sitering av AI-systemer som prosesserer milliarder av dokumenter og må skille pålitelig informasjon fra feilinformasjon.

I stedet for at AI-indeksering erstatter Google-indeksering, ser fremtiden ut til å være preget av konvergens og sameksistens. Google har allerede begynt å integrere AI-funksjoner direkte i søket sitt gjennom AI Overview (tidligere SGE), som genererer AI-drevne sammendrag sammen med tradisjonelle søkeresultater, og skaper et hybridsystem som kombinerer Googles indekseringsinfrastruktur med generativ AI. Denne tilnærmingen lar Google beholde sin kjernefordel—omfattende nettkartlegging og lenkeanalyse—mens de legger til AI-ens evne til å syntetisere og kontekstualisere informasjon. Andre søkemotorer og AI-selskaper følger lignende strategier, med Perplexity som kombinerer nettsøk med AI-generering, og Microsoft som integrerer ChatGPT i Bing. De mest avanserte informasjonsinnhentingssystemene vil sannsynligvis bruke multimodale indekseringsstrategier som kombinerer tradisjonell nøkkelordbasert gjenfinning for presis informasjon og semantisk/vektorbasert gjenfinning for kontekstuell forståelse. Organisasjoner og innholdsskapere må forberede seg på et landskap der innhold må optimaliseres for flere oppdagelsesmekanismer samtidig—tradisjonell SEO for Googles algoritme, strukturert data for AI-systemer og semantisk rikdom for vektorbasert gjenfinning.

Innholdsstrateger og markedsførere må nå ha en dobbel optimaliseringstilnærming som adresserer både tradisjonelle søk og AI-indekseringsmekanismer. Dette betyr å opprettholde sterk nøkkelordoptimalisering og lenkebygging for Google, samtidig som man sikrer at innholdet viser tematisk autoritet, semantisk dybde og kontekstuell rikdom som AI-systemer gjenkjenner og siterer. Implementering av omfattende strukturert datamerking (Schema.org) blir avgjørende, da det hjelper både Google og AI-systemer å forstå innholdets kontekst, troverdighet og relasjoner—dette er spesielt viktig for E-E-A-T-signaler (Erfaring, Ekspertise, Autoritet, Troverdighet) som påvirker både rangering og sannsynlighet for sitering. Å lage grundig, omfattende innhold som utforsker temaer i dybden blir mer verdifullt enn noen gang, ettersom AI-systemer oftere siterer autoritative, grundig dokumenterte kilder som gir fullstendig kontekst, i motsetning til tynne, nøkkelordoptimaliserte sider. Organisasjoner bør implementere sitatovervåkingssystemer for å spore omtaler i AI-genererte svar, på samme måte som de sporer tilbakekoblinger, med forståelse for at synlighet i AI-utdata representerer en ny form for fortjent medieomtale. Å bygge en kunnskapsbase eller innholdshub som viser tydelig ekspertise på spesifikke områder øker sannsynligheten for å bli anerkjent som en autoritativ kilde av AI-systemer. Til slutt innebærer fremveksten av Generative Engine Optimization (GEO) som disiplin at markedsførere må forstå hvordan de strukturerer innhold, bruker naturlige språkstrukturer og bygger autoritetssignaler som appellerer både til algoritmiske rangeringssystemer og AI-sitasjonsmekanismer—en mer nyansert og sofistikert tilnærming enn tradisjonell SEO alene.

Skillet mellom AI-indeksering og Google-indeksering handler ikke om at den ene erstatter den andre, men om en grunnleggende utvidelse av hvordan informasjon organiseres, hentes og presenteres for brukere. Googles gjenfinningsbaserte tilnærming er fortsatt kraftig for å finne spesifikk informasjon raskt, mens AI sin prediksjonsbaserte tilnærming utmerker seg i syntese, kontekst og forståelse av brukerintensjon. De mest suksessrike organisasjonene blir de som forstår dette dualistiske landskapet og optimaliserer innhold og digital tilstedeværelse for begge systemene samtidig. Ved å forstå de tekniske forskjellene mellom disse indekseringsmetodene, implementere strukturert data, bygge tematisk autoritet og spore synlighet på tvers av både tradisjonelt søk og AI-plattformer, kan organisasjoner sikre at innholdet deres forblir synlig og verdifullt i et stadig mer komplekst informasjonslandskap. Fremtidens søk er ikke én—den er mangfoldig, distribuert og stadig mer intelligent.

Google-indeksering er et gjenfinningssystem som gjennomsøker nettet, katalogiserer innhold og returnerer rangerte lenker basert på nøkkelord og lenker. AI-indeksering er et prediksjonssystem som koder treningsdata i nevrale nettverk og genererer kontekstuelt relevante svar direkte. Google spør 'hvor er denne informasjonen?' mens AI spør 'hva er det mest relevante svaret?'

Vektorembeddinger konverterer tekst og andre data til høy-dimensjonale numeriske matriser som fanger opp semantisk betydning. Disse embeddingene gjør det mulig for AI-systemer å forstå at 'bil', 'automobil' og 'kjøretøy' er semantisk likeverdige uten eksplisitt nøkkelordmatching. Lignende konsepter representeres som vektorer nær hverandre i høy-dimensjonalt rom.

Tradisjonelle AI-modeller har en kunnskapsgrense og kan ikke pålitelig hente sanntidsinformasjon. Men Retrieval-Augmented Generation (RAG)-systemer kan spørre vektordatabaser og nettressurser for å hente oppdatert informasjon før de genererer svar, og bygger dermed bro over dette gapet.

GEO er en fremvoksende disiplin med fokus på å optimalisere innhold for AI-genererte svar i stedet for tradisjonelle søkerangeringer. Det vektlegger tematisk autoritet, strukturert data, semantisk dybde og merkevarens troverdighet for å øke sannsynligheten for å bli sitert av AI-systemer.

Nøkkelordssøk matcher eksakte eller lignende ord i dokumenter. Semantisk søk forstår meningen og intensjonen bak spørsmål, slik at det kan finne relevante resultater selv når det brukes ulik terminologi. For eksempel kan et semantisk søk etter 'smarttelefon' også gi resultater for 'mobilenhet' eller 'mobiltelefon.'

I stedet for å erstatte ser fremtiden ut til å være konvergens. Google integrerer AI-funksjoner i sitt søk gjennom funksjoner som AI Overviews, og skaper hybride systemer som kombinerer tradisjonell indeksering med generativ AI. Organisasjoner må optimalisere for begge systemene samtidig.

En vektordatabase lagrer høy-dimensjonale embeddinger og utfører likhetssøk ved hjelp av metrikker som cosinuslikhet. Den er avgjørende for å implementere semantisk søk og Retrieval-Augmented Generation (RAG), slik at AI-systemer kan få tilgang til og hente relevant informasjon i stor skala på millisekunder.

Markedsførere bør ha en dobbel optimaliseringstilnærming: opprettholde tradisjonell SEO for Google samtidig som de bygger tematisk autoritet, implementerer strukturert data, lager omfattende innhold og sporer AI-sitater. Fokuser på å demonstrere ekspertise og troverdighet for å bli gjenkjent som en autoritativ kilde av AI-systemer.

Spor hvordan merkevaren din vises i AI-genererte svar fra ChatGPT, Gemini, Perplexity og Google AI Overviews. Få sanntidsinnsikt i dine AI-sitater og synlighet.

Lær hvordan AI-søkindekser fungerer, forskjellene mellom ChatGPT, Perplexity og SearchGPTs indekseringsmetoder, og hvordan du kan optimalisere innholdet ditt fo...

Forstå den kritiske forskjellen mellom indeksering og sitering i søkemotorer og AI-systemer. Lær hvordan indeksering lagrer innhold og hvordan siteringer gir sy...

Lær hvordan AI-søkeindeksering konverterer data til søkbare vektorer, slik at AI-systemer som ChatGPT og Perplexity kan finne og sitere relevant informasjon fra...