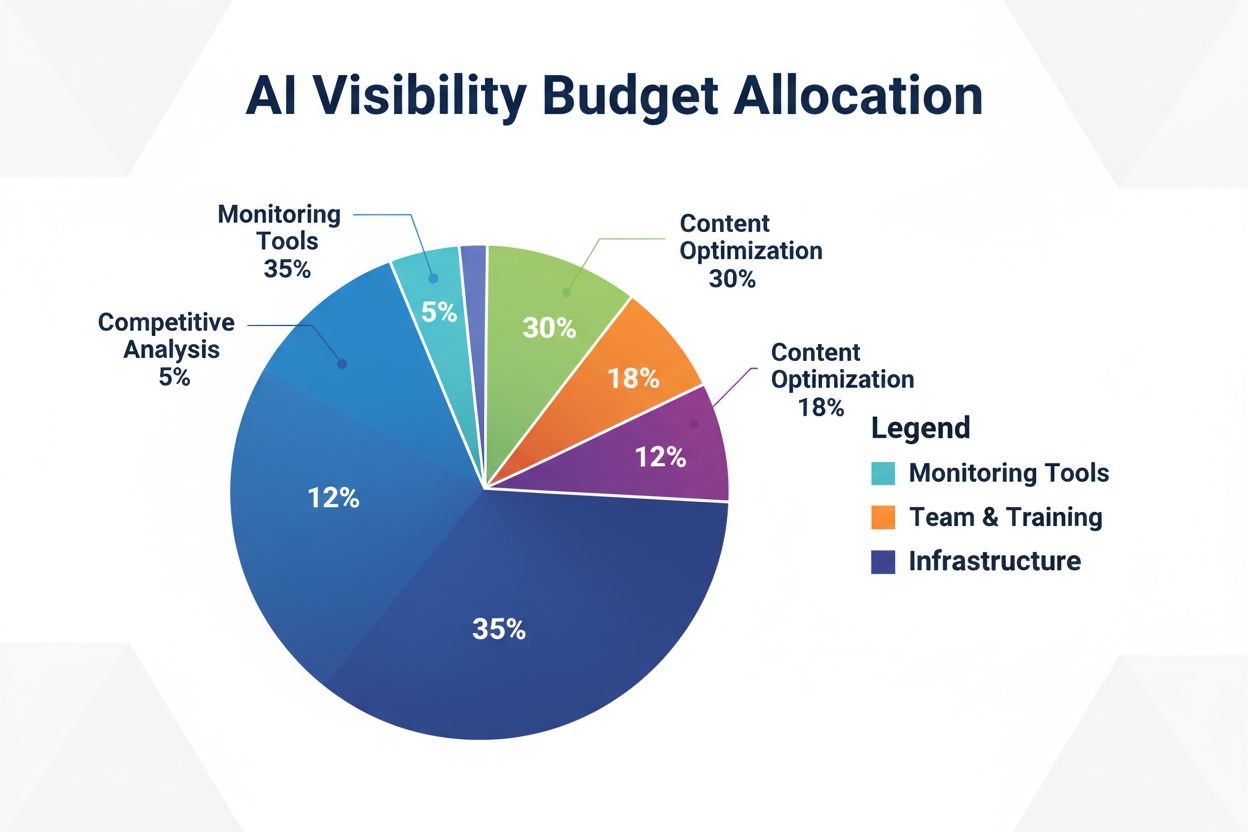

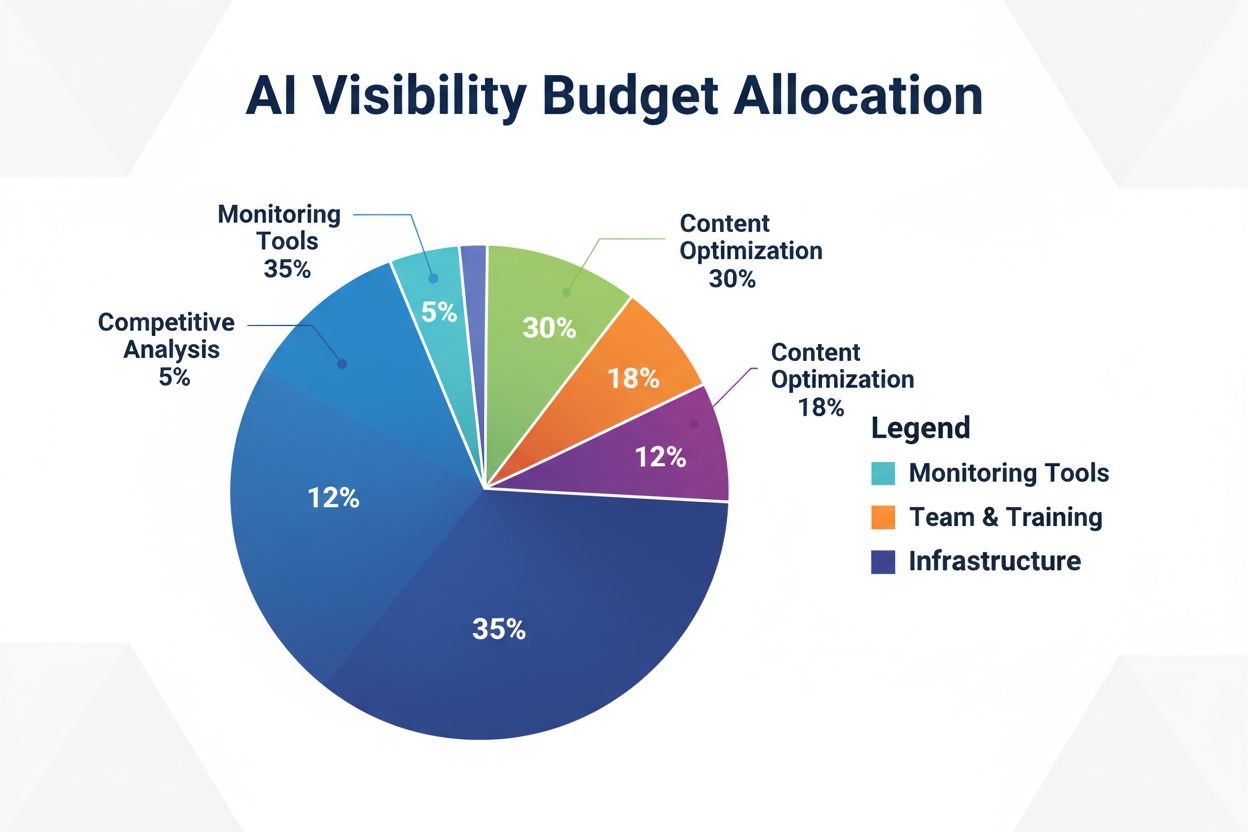

AI-synlighetsbudsjettering: Hvor skal du allokere ressursene dine

Lær hvordan du strategisk kan allokere AI-synlighetsbudsjettet ditt på overvåkingsverktøy, innholdsoptimalisering, teamressurser og konkurranseanalyse for å mak...

Lær hvordan du implementerer effektive retningslinjer for AI-innholdsstyring med synlighetsrammeverk. Oppdag regulatoriske krav, beste praksis og verktøy for å administrere AI-systemer på en ansvarlig måte.

AI-synlighet refererer til den omfattende evnen til å observere, spore og forstå hvordan kunstige intelligenssystemer opererer i ditt innholdsøkosystem. I innholdsstyring fungerer synlighet som det grunnleggende laget som gjør det mulig for organisasjoner å opprettholde kontroll, sikre samsvar og redusere risiko forbundet med AI-generert og AI-behandlet innhold. Uten klar synlighet inn i AI-systemene opererer organisasjoner i blinde—ute av stand til å oppdage skjevheter, sikre regulatorisk samsvar eller svare på nye trusler. Synlighet først-styring forvandler reaktiv krisehåndtering til proaktiv risikoforebygging, og lar team ta informerte beslutninger om innholdskvalitet, autentisitet og samsvar med organisasjonens verdier.

De fleste organisasjoner står overfor et kritisk styringsgap mellom deres AI-adopsjonshastighet og deres evne til å styre disse systemene effektivt. Forskning viser at 63 % av organisasjoner mangler formelle AI-styringsprogrammer, noe som gjør dem sårbare for regelbrudd, omdømmetap og operasjonelle feil. Dette gapet øker etter hvert som AI-systemene blir mer sofistikerte og integrert i kjernevirksomheten, noe som gjør synlighet stadig vanskeligere å oppnå uten dedikerte rammeverk og verktøy. Konsekvensene strekker seg utover regulatoriske sanksjoner—organisasjoner uten synlighet sliter med å opprettholde innholdskvalitet, oppdage skadelige utfall og demonstrere ansvarlighet overfor interessenter. Å lukke dette gapet krever målrettede investeringer i synlighetsmekanismer som gir sanntidsinnsikt i AI-systemers atferd og innholdsresultater.

| Aspekt | Reaktiv styring | Proaktiv styring |

|---|---|---|

| Oppdagelse | Problemer identifiseres etter offentlig eksponering | Kontinuerlig overvåking oppdager problemer tidlig |

| Respons | Krisehåndtering og skadebegrensning | Forebyggende tiltak og risikoredusering |

| Samsvar | Etterkorrigering og straff | Løpende samsvarsverifisering |

| Risiko | Høy eksponering for ukjente trusler | Systematisk risikokartlegging og -styring |

Effektive AI-innholdsstyringspolicies hviler på seks grunnleggende prinsipper som styrer beslutningstaking og operasjonelle praksiser på tvers av organisasjonen. Disse prinsippene danner et sammenhengende rammeverk som balanserer innovasjon med ansvar, og sikrer at AI-systemer tjener organisasjonens mål samtidig som de beskytter interessenter. Ved å forankre disse prinsippene i policy etablerer du klare forventninger til hvordan AI-systemene skal oppføre seg og hvordan teamene skal håndtere dem. Prinsippene virker sammen—åpenhet muliggjør ansvarlighet, menneskelig tilsyn sikrer rettferdighet, og personvern bygger tillit. Organisasjoner som operasjonaliserer disse prinsippene konsekvent, utkonkurrerer jevnaldrende på regulatorisk samsvar, interessenttillit og langsiktig bærekraft.

Det regulatoriske landskapet for AI-styring har akselerert dramatisk, med flere rammeverk som nå etablerer obligatoriske krav for organisasjoner som implementerer AI-systemer. EU AI Act representerer den mest omfattende regulatoriske tilnærmingen, og klassifiserer AI-systemer etter risikonivå og pålegger strenge krav for høyrisikoprogrammer som innholdsmoderering og -generering. NIST AI Risk Management Framework gir en fleksibel, ikke-preskriptiv tilnærming som hjelper organisasjoner å identifisere, måle og håndtere AI-risiko på tvers av virksomheten. ISO 42001 etablerer internasjonale standarder for AI-ledelsessystemer og tilbyr organisasjoner en strukturert metode for implementering av styring på tvers av virksomheten. I tillegg gir Executive Orders i USA og nye delstatsreguleringer et lappeteppe av krav som organisasjoner må navigere. Disse rammeverkene møtes på felles temaer: åpenhet, ansvarlighet, menneskelig tilsyn og kontinuerlig overvåking—noe som gjør synlighet til en avgjørende faktor for regulatorisk samsvar.

Å bygge et robust policyrammeverk krever systematisk vurdering av dine nåværende AI-systemer, innholdsstrømmer og risikobilde. Start med å gjennomføre en omfattende AI-inventar som dokumenterer hvert system som genererer, behandler eller distribuerer innhold, inkludert formål, datainnganger og potensiell påvirkning på interessenter. Deretter etablerer du styringsnivåer som tildeler ulike tilsynsnivåer basert på risiko—høyrisikosystemer som innholdsmoderering krever intensiv overvåking, mens lavrisikoapplikasjoner kan ha en lettere styring. Utvikle klare policies som spesifiserer hvordan hvert system skal operere, hvilke utfall som er akseptable, og hvordan teamene skal reagere på problemer. Opprett ansvarlighetsstrukturer som tildeler eierskap for policy-etterlevelse og etablerer eskaleringsprosedyrer for styringsutfordringer. Til slutt implementerer du målingsmekanismer som sporer policy-etterlevelse og gir data for kontinuerlig forbedring av styringsmetodikken.

Å oppnå AI-synlighet krever at man tar i bruk spesialiserte verktøy og vurderingsmekanismer som gir sanntidsinnsikt i systematferd og innholdsresultater. Overvåkingsdashbord samler data fra AI-systemer, innholdsplattformer og samsvarssystemer i enhetlige visninger som muliggjør rask problemoppdagelse. Revisjonsspor fanger detaljerte poster over AI-beslutninger, innholdsmodifikasjoner og styringstiltak, noe som skaper ansvarlighet og støtter regulatoriske undersøkelser. Vurderingsrammeverk evaluerer systematisk AI-systemer mot styringsprinsipper, identifiserer hull og forbedringsmuligheter før problemer eskalerer. Automatiserte deteksjonssystemer flagger potensielt problematisk innhold, skjeve utfall eller policybrudd, og reduserer behovet for manuell gjennomgang samtidig som konsistensen forbedres. Organisasjoner som investerer i omfattende synlighetsverktøy får konkurransefortrinn innen regulatorisk samsvar, interessenttillit og operasjonell effektivitet.

Kontinuerlig overvåking forvandler styring fra en periodisk samsvarsøvelse til en løpende operasjonell disiplin som oppdager og svarer på problemer i sanntid. Etabler overvåkingsprotokoller som definerer hvilke måleparametere som er viktigst for hvert AI-system—nøyaktighetsrater, skjevhetsindikatorer, innholdskvalitetspoeng og hyppighet av policybrudd. Implementer automatiserte varslingssystemer som varsler relevante team når måleparametere faller utenfor akseptable intervaller, slik at rask undersøkelse og respons muliggjøres. Lag tilbakemeldingssløyfer som kobler overvåkingsdata tilbake til systemforbedring, slik at team kan finjustere AI-modeller og styringsprosesser basert på faktisk ytelse. Planlegg regelmessige samsvarsgjennomganger som vurderer om overvåkingssystemene selv fortsatt er effektive, og om styringspolicies må oppdateres som følge av nye risikoer eller regulatoriske endringer. Organisasjoner som integrerer kontinuerlig overvåking i sine operasjoner, oppnår raskere problemløsning, lavere samsvarskostnader og sterkere tillit blant interessenter.

Effektiv AI-innholdsstyring krever koordinert innsats på tvers av flere organisatoriske funksjoner, der hver bidrar med essensiell ekspertise og perspektiv til styringsbeslutninger. Juridiske og samsvarsteam sikrer at policies er i tråd med regulatoriske krav og håndterer eksterne forhold til tilsynsmyndigheter. Tekniske team implementerer overvåkingssystemer, vedlikeholder revisjonsspor og optimaliserer AI-systemenes ytelse innenfor styringsrammene. Innholds- og redaksjonsteam anvender styringspolicies i praksis, og tar daglige beslutninger om innholdskvalitet og hensiktsmessighet. Risikostyrings- og etikkteam vurderer nye trusler, identifiserer potensielle skader og anbefaler policyjusteringer for å møte nye utfordringer. Toppledelsen stiller ressurser til rådighet, setter organisatoriske prioriteringer og viser engasjement for styring gjennom sine beslutninger og kommunikasjon. Organisasjoner som samordner disse funksjonene rundt felles styringsmål, oppnår bedre resultater enn de hvor styring forblir isolert i enkeltavdelinger.

AI-innholdsstyring er settet med retningslinjer, prosesser og kontroller som sikrer at AI-generert og AI-behandlet innhold forblir pålitelig, i samsvar og i tråd med organisasjonens verdier. Det omfatter alt fra innholdsopprettelse og validering til overvåking og hendelseshåndtering.

Synlighet gjør det mulig for organisasjoner å forstå hvor AI-systemer opererer, hvordan de presterer og hvilke risikoer de skaper. Uten synlighet blir styring reaktiv og ineffektiv. Synlighet forvandler styring fra krisehåndtering til proaktiv risikoforebygging.

Viktige rammeverk inkluderer EUs AI Act (juridisk bindende risikobasert klassifisering), NIST AI Risk Management Framework (fleksibel veiledning), ISO 42001 (internasjonale standarder) og ulike Executive Orders og delstatsreguleringer. Hvert rammeverk legger vekt på åpenhet, ansvarlighet og menneskelig tilsyn.

Bruk strukturerte vurderingsrammeverk tilpasset anerkjente standarder som NIST AI RMF eller ISO 42001. Vurder eksisterende kontroller mot rammeverkskrav, identifiser hull og fastsett ønsket modenhetsnivå. Regelmessige vurderinger gir innsikt i systemiske svakheter og forbedringsmuligheter.

Effektive policies bør dekke akseptable brukstilfeller, regler for datakilder, dokumentasjonskrav, prosedyrer for menneskelig tilsyn, overvåkingsmekanismer og eskaleringsprosedyrer. Policies må operasjonaliseres gjennom verktøy og arbeidsflyter som team faktisk bruker i det daglige arbeidet.

Styring bør overvåkes kontinuerlig med regelmessige formelle gjennomganger minst kvartalsvis. Sanntidsovervåking oppdager problemer umiddelbart, mens periodiske gjennomganger vurderer om styringsrammeverkene fortsatt er effektive og om policies må oppdateres som følge av nye risikoer eller regulatoriske endringer.

Effektive verktøy inkluderer overvåkingsdashbord for sanntidsmålinger, revisjonsspor for ansvarlighet, vurderingsrammeverk for kontrollevaluering, automatiske deteksjonssystemer for policybrudd og risikokvantisering. Disse verktøyene bør integreres på tvers av din teknologiske plattform.

AmICited overvåker hvordan AI-systemer og LLM-er refererer til merkevaren din på tvers av GPT-er, Perplexity og Google AI Overviews. Dette gir synlighet i din AI-tilstedeværelse, hjelper deg å forstå hvordan innholdet ditt brukes av AI-systemer, og gjør det mulig for deg å beskytte merkevarens omdømme i et AI-drevet innholdsøkosystem.

AmICited sporer hvordan AI-systemer og LLM-er siterer innholdet ditt på tvers av GPT-er, Perplexity og Google AI Overviews. Få synlighet i din AI-tilstedeværelse og beskytt merkevarens omdømme.

Lær hvordan du strategisk kan allokere AI-synlighetsbudsjettet ditt på overvåkingsverktøy, innholdsoptimalisering, teamressurser og konkurranseanalyse for å mak...

Lær hvordan medieselskaper oppnår synlighet i AI-genererte svar gjennom innholdsoptimalisering, fortjent media, digital PR og strategisk posisjonering på AI-pla...

Lær hva AI-synlighetsattribusjon er, hvordan det skiller seg fra tradisjonell SEO, og hvorfor det er avgjørende for moderne markedsførings-suksess å overvåke hv...