Hvordan datavisualiseringer hjelper AI-søk og LLM-synlighet

Lær hvordan datavisualiseringer forbedrer AI-søkesynlighet, hjelper LLM-er å forstå innhold, og øker siteringer i AI-genererte svar. Oppdag optimaliseringsstrat...

Oppdag hvordan AI-modeller siterer visuelle data og diagrammer. Lær hvorfor datavisualisering er viktig for AI-siteringer, og hvordan du kan spore ditt visuelle innhold med AmICited.

Visuelle data utgjør en grunnleggende flaskehals for moderne store språkmodeller, som hovedsakelig er trent på tekstbasert informasjon og sliter med å prosessere, tolke og sitere diagrammer med samme presisjon som de bruker på skriftlig innhold. Dagens LLM-er møter betydelige begrensninger når de støter på datavisualiseringer—de må først konvertere visuelle elementer til tekstbeskrivelser, en prosess som ofte mister avgjørende nyanser, presise verdier og kontekstuelle sammenhenger som ligger i det opprinnelige diagrammet. Mangelen på evne til å prosessere visuelle data nøyaktig i LLM-systemer gjør at diagrammer, grafer og infografikk ofte ikke blir sitert eller blir sitert feil, noe som skaper et troverdighetsgap for innholdsskapere som investerer tid i å lage visualiseringer av høy kvalitet. Denne utfordringen er spesielt viktig for forskere, analytikere og organisasjoner som er avhengige av AI for å bearbeide diagrammer og syntetisere informasjon, da manglende attribusjon undergraver både den opprinnelige skaperens innsats og påliteligheten til AI-genererte sammendrag. Å forstå disse begrensningene er avgjørende for alle som lager visuelt innhold i et stadig mer AI-drevet informasjonslandskap.

Ulike AI-systemer tilnærmer seg sitering av visuelt innhold med varierende grad av sofistikasjon, avhengig av underliggende arkitektur og treningsmetoder. Tabellen under illustrerer hvordan ledende AI-plattformer håndterer visuelle siteringer:

| AI-modell | Evne til visuell sitering | Siteringsformat | Nøyaktighetsnivå | Multimodal støtte |

|---|---|---|---|---|

| ChatGPT (GPT-4V) | Moderat | Beskrivende tekst | 65–75% | Ja (bildeinput) |

| Claude 3 | Høy | Detaljert attribusjon | 80–85% | Ja (visjon-aktivert) |

| Perplexity AI | Høy | Kilde + visuell referanse | 85–90% | Ja (web-integrert) |

| Google AI Overviews | Moderat–høy | Innebygd sitering | 75–80% | Ja (bildesøk) |

| Gemini Pro Vision | Moderat | Kontekstuell referanse | 70–78% | Ja (multimodal) |

Claude utmerker seg i attribusjon av visuelt innhold, og gir ofte detaljert kildeinformasjon og visuell kontekst ved referering til diagrammer, mens Perplexity AI er best på å integrere visuelle siteringer med nettbaserte kilder, og skaper et mer komplett attribusjonsspor. ChatGPTs GPT-4V kan behandle bilder, men faller ofte tilbake på generiske beskrivelser fremfor presise siteringer, spesielt ved komplekse finansielle diagrammer eller vitenskapelige visualiseringer. Google AI Overviews forsøker å opprettholde innebygd sitering for visuelt innhold, men forveksler noen ganger skaperen av diagrammet med datakilden, noe som gir uklarhet rundt korrekt attribusjon. For innholdsskapere betyr dette at samme visualisering kan få svært ulik behandling avhengig av hvilket AI-system som analyserer det—et diagram kan bli korrekt sitert i Claude, men fullstendig unattributert i ChatGPT, noe som fremhever behovet for standardiserte protokoller for visuelle siteringer i AI-økosystemet.

Datavisualisering spiller en overraskende innflytelsesrik rolle i hvordan AI-modeller forstår og representerer informasjon, siden diagrammer og grafer i treningsdatasett lærer modellene å gjenkjenne mønstre, sammenhenger og hierarkier i komplekse data. Kvaliteten og mangfoldet av visuelle data i treningssettene påvirker direkte hvor godt AI-systemer senere kan tolke og sitere liknende visualiseringer, noe som betyr at modeller trent på omfattende visuelle datasett viser betydelig bedre prestasjon i attribusjon av visuelt innhold. Visuelle mønstre lært i treningen påvirker modellens output på subtile, men målbare måter—en modell som er trent mye på korrekt merkede, vitenskapelige diagrammer vil mer sannsynlig generere nøyaktige siteringer for tilsvarende visualiseringer enn en modell som hovedsakelig er trent på tekst. Utfordringen forsterkes av at de fleste store språkmodeller ble trent på data fra internett, hvor visuelt innhold ofte mangler metadata, alt-tekst eller kildehenvisning, og dermed opprettholdes en syklus der AI lærer å tolke diagrammer uten å lære å sitere dem. Organisasjoner som investerer i høykvalitets, godt dokumenterte datasett for visualisering, bygger i realiteten bedre grunnlag for fremtidens AI-systemer, selv om denne investeringen fortsatt er lite brukt i bransjen.

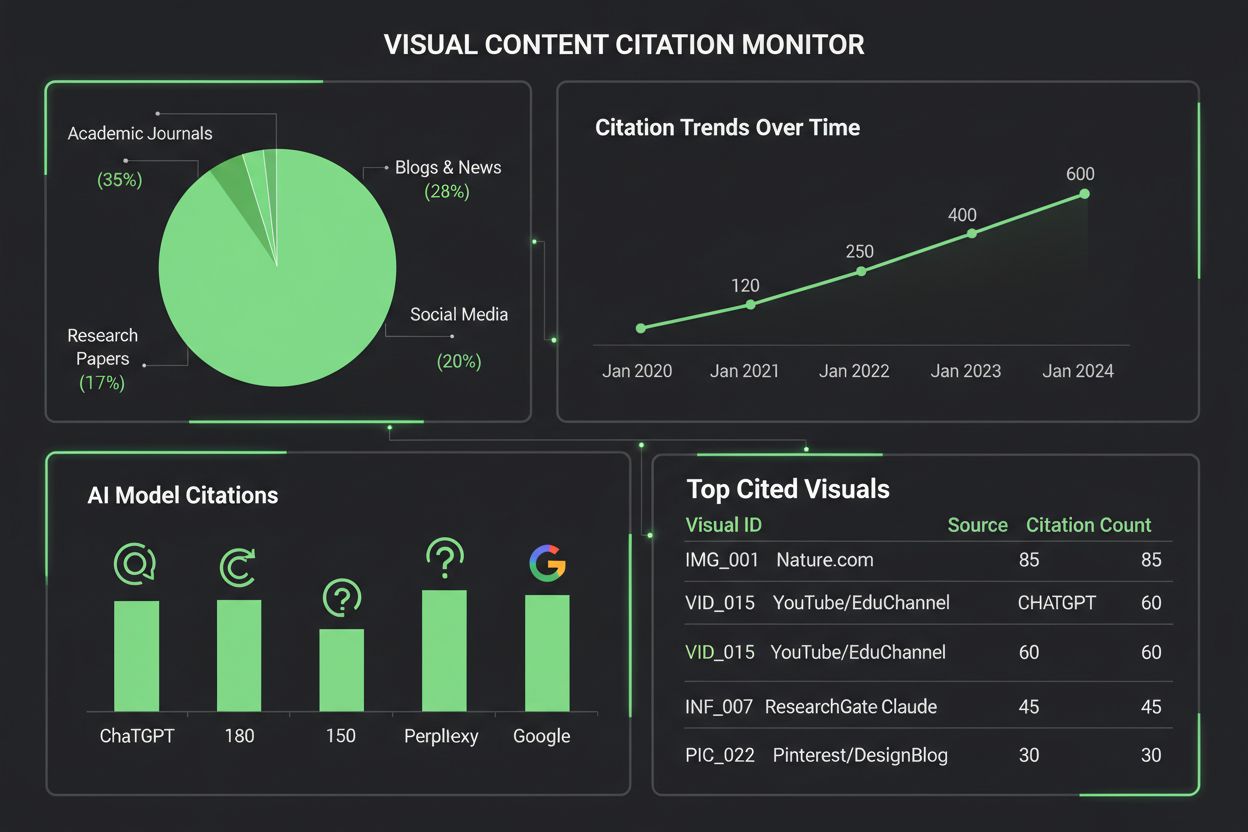

Å overvåke hvordan AI-systemer siterer visuelt innhold krever en flerlags tilnærming som kombinerer automatisert deteksjon med manuell verifisering. Viktige sporingsmetoder inkluderer:

AmICited.com spesialiserer seg på å spore siteringer av visuelt innhold på tvers av flere AI-plattformer, og gir innholdsskapere detaljerte rapporter om hvordan diagrammene deres blir referert til, attribuert eller oversett av ChatGPT, Claude, Perplexity, Google AI og andre systemer. Viktigheten av å overvåke visuelle siteringer kan ikke overvurderes—uten skikkelig sporing mister skapere oversikt over hvordan arbeidet deres påvirker AI-generert innhold, og det blir umulig å arbeide for bedre siteringspraksis eller forstå rekkevidden til visualiseringene. AmICiteds verktøy for overvåking av visuelt innhold fyller dette viktige gapet ved å gi skapere varsler i sanntid når diagrammene siteres, detaljerte analyser av siteringsnøyaktighet og handlingsrettede innsikter for å forbedre synligheten av visuelt innhold i AI-systemer.

Å lage visualiseringer som oftere blir sitert av AI-systemer krever bevisste designvalg med fokus på klarhet, rikdom på metadata og maskinlesbarhet. Sterke, høy-kontrast fargepaletter og tydelig merking øker AI sin evne til å tolke diagrammer, ettersom modeller sliter med subtile graderinger, overlappende elementer og tvetydige forklaringer som mennesker enkelt forstår. Inkluder omfattende alt-tekstbeskrivelser som ikke bare beskriver hva diagrammet viser, men også underliggende datasammenhenger, nøkkelfunn og kildeinformasjon—disse metadataene danner grunnlaget for nøyaktige AI-siteringer. Legg inn strukturert data i visualiseringene dine ved hjelp av standarder som JSON-LD eller mikrodata, slik at AI kan hente ut presise verdier og sammenhenger uten å måtte tolke bildet visuelt. Sørg for at diagramtitler er beskrivende og spesifikke fremfor generiske, siden AI-modeller bruker titler som primære anker for å forstå og sitere visuelt innhold. Gi kildehenvisning direkte i visualiseringen gjennom fotnoter, vannmerker eller integrerte kildelabels, slik at AI ikke kan skille diagrammet fra dets opprinnelse. Organisasjoner som implementerer disse praksisene ser målbare forbedringer i hvordan visuelt innhold blir sitert på tvers av AI-plattformer, noe som gir bedre attribusjon, økt synlighet og sterkere faglig troverdighet.

Landskapet for overvåkingsverktøy for visuelle siteringer utvides stadig etter hvert som organisasjoner ser viktigheten av å spore hvordan AI-systemer refererer til visuelt innhold. AmICited.com utmerker seg som en helhetlig løsning spesielt utviklet for å overvåke siteringer av visuelt innhold på tvers av flere AI-plattformer, og gir skapere detaljerte dashbord som viser nøyaktig når og hvordan diagrammene deres blir sitert av ChatGPT, Claude, Perplexity, Google AI Overviews og nye AI-systemer. Tradisjonelle siteringsplattformer som Google Scholar og Scopus fokuserer hovedsakelig på akademiske artikler og tekstbaserte siteringer, og etterlater visuelt innhold i stor grad uovervåket og unattributert. Spesialiserte verktøy som Tinybird og lignende datavisualiseringsplattformer integrerer nå siteringssporing, slik at organisasjoner kan overvåke hvordan deres sanntidsvisualiseringer blir brukt og referert til av AI-systemer. AmICiteds visuelle analyse gir målinger av siteringsfrekvens, nøyaktighetsrater og plattformspesifikke mønstre, slik at innholdsskapere kan forstå hvilke AI-systemer som attribuerer arbeidet korrekt, og hvor det kreves tiltak. For organisasjoner som tar beskyttelsen av sitt visuelle immaterielle innhold og forståelsen av innflytelsen i AI-drevne informasjonsøkosystem på alvor, har det blitt essensielt å implementere en dedikert løsning for overvåking av visuelle siteringer som AmICited.com—det forvandler siteringssporing fra passiv observasjon til aktiv forvaltning som gir bedre attribusjon.

Dagens AI-modeller har varierende evner når det gjelder å sitere visuelt innhold. Mens avanserte modeller som Claude og Perplexity kan referere til diagrammer med rimelig nøyaktighet, sliter mange systemer med korrekt attribusjon. De fleste LLM-er er hovedsakelig trent på tekstdata, noe som gjør visuelle siteringer mindre pålitelige enn tekstsiteringer. Derfor er overvåkingsverktøy som AmICited avgjørende for å spore hvordan visualiseringene dine faktisk blir sitert.

AmICited.com tilbyr omfattende overvåking av visuelt innhold på tvers av flere AI-plattformer, inkludert ChatGPT, Claude, Perplexity og Google AI Overviews. Plattformen bruker automatisk visuell fingeravtrykksteknologi og metadataanalyse for å identifisere når dine diagrammer dukker opp i AI-generert innhold, og gir varsler i sanntid samt detaljerte analyser av siteringsnøyaktighet og -frekvens.

AI-systemer siterer diagrammer mer presist når de har sterke, høy-kontrast farger, tydelig merking, beskrivende titler og omfattende alt-tekst. Inkludering av strukturert datamerking, kildehenvisning i selve visualiseringen og godt organiserte forklaringer forbedrer AI sin behandling og siteringsrate betydelig. Å lage flere versjoner av komplekse visualiseringer—en forenklet for AI og en detaljert for mennesker—øker også synligheten.

Basert på dagens evner viser Claude 3 og Perplexity AI høyest nøyaktighet innen attribusjon av visuelt innhold, med siteringsrater på 80–90 %. Google AI Overviews og Gemini Pro Vision presterer moderat godt på 75–80 %, mens ChatGPTs GPT-4V, til tross for visuelle evner, ofte faller tilbake på generiske beskrivelser fremfor presise siteringer. Disse evnene utvikler seg stadig etter hvert som modellene oppdateres.

Sporing av visuelle siteringer er avgjørende for merkevaresynlighet, vurdering av innholdsverdi og beskyttelse av immaterielle rettigheter. Når dine diagrammer blir korrekt sitert av AI-systemer, øker det merkevarens synlighet i AI-generert innhold, bekrefter innholdets innflytelse og gir innsikt i hvordan arbeidet ditt påvirker AI-drevet informasjonssyntese. Uten sporing mister du oversikt over rekkevidden og effekten av innholdet ditt.

AmICited spesialiserer seg på å spore siteringer av visuelt innhold på tvers av flere AI-plattformer, og tilbyr detaljerte dashbord som viser når og hvordan diagrammene dine blir sitert. Plattformen gir varsler i sanntid, måler siteringsnøyaktighet, tilbyr plattformspesifikke analyser og gir handlingsrettede innsikter for å øke synligheten av visuelt innhold. Det gjør siteringssporing til aktiv forvaltning av ditt visuelle immaterielle innhold.

Tekstsiteringer i AI-systemer er generelt mer pålitelige fordi LLM-er hovedsakelig trenes på tekstdata. Visuelle siteringer krever flere prosesseringssteg—AI må først konvertere visuelle elementer til tekstbeskrivelser, noe som ofte mister nyanser og presise verdier. Denne konverteringsprosessen gir flere muligheter for feil, og gjør visuelle siteringer mindre nøyaktige og konsistente enn tekstsiteringer på tvers av ulike AI-plattformer.

Absolutt. Følg beste praksis som å bruke sterke, høy-kontrast farger, lage beskrivende titler og alt-tekst, legge inn strukturert datamerking, og inkludere kildehenvisning direkte i visualiseringene. Unngå subtile graderinger, overlappende elementer og tvetydige forklaringer. Vurder å lage forenklede versjoner av komplekse diagrammer spesielt for AI-behandling. Disse forbedringene gjør visualiseringene dine mer synlige og siterbare for AI-systemer.

Følg med på hvordan AI-systemer siterer dine diagrammer og visualiseringer på tvers av ChatGPT, Claude, Perplexity og Google AI. Få varsler i sanntid og detaljerte analyser av attribusjon av visuelt innhold.

Lær hvordan datavisualiseringer forbedrer AI-søkesynlighet, hjelper LLM-er å forstå innhold, og øker siteringer i AI-genererte svar. Oppdag optimaliseringsstrat...

Lær hvordan tabeller, lister og strukturert data forbedrer innholdets synlighet i AI-søkeresultater. Oppdag beste praksis for å optimalisere innhold for LLM-er ...

Lær hvorfor tabeller er essensielle for AI-søkeoptimalisering. Oppdag hvordan strukturert data i tabeller forbedrer AI-forståelse, øker sjansen for sitater, og ...