G2-anmeldelser og AI-synlighet: Komplett optimaliseringsguide

Bli ekspert på G2-optimalisering for AI-synlighet i søk. Lær hvordan du kan øke AI-sitater, optimalisere profilen din, og måle ROI med datadrevne strategier for...

Oppdag hvordan G2 og Capterra-anmeldelser påvirker AI-merkets synlighet og LLM-siteringer. Lær hvorfor vurderingsplattformer er avgjørende for oppdagelse og anbefaling av AI-programvare.

I dagens raskt utviklende landskap for kunstig intelligens har vurderingsplattformer blitt kritiske oppdagelseskanaler for innkjøpere av bedriftsprogramvare. Når potensielle kunder søker etter AI-løsninger, stoler de i økende grad på plattformer som G2 og Capterra for å validere sine kjøpsbeslutninger. Disse vurderingssidene fungerer som digitale tillitsankere, og gir sosialt bevis som påvirker hvordan AI-merkevarer oppfattes og anbefales av både menneskelige beslutningstakere og store språkmodeller. Konsentrasjonen av anmeldelser på disse plattformene har fundamentalt endret hvordan AI-leverandører konkurrerer om synlighet og troverdighet i markedet.

G2 har utpekt seg som den dominerende aktøren innen AI-programvareanmeldelser, med forskning som viser at LLM-er siterer G2-anmeldelser i omtrent 68 % av AI-produktanbefalinger. Denne overveldende preferansen stammer fra G2s omfattende dekning av AI-verktøy, dets sofistikerte rangeringsalgoritmer og dets posisjon som de facto-standard for vurdering av bedriftsprogramvare. Sammenlignet med andre vurderingsplattformer er G2s innflytelse betydelig større, som vist i følgende oversikt:

| Plattform | LLM-siteringsrate | Gj.snittlig anmeldelser pr AI-produkt | Markedsdekning |

|---|---|---|---|

| G2 | 68% | 127 | 94% av ledende AI-verktøy |

| Capterra | 42% | 89 | 76% av ledende AI-verktøy |

| Trustpilot | 18% | 34 | 31% av ledende AI-verktøy |

| Gartner Peer Insights | 35% | 156 | 52% av ledende AI-verktøy |

| Bransjespesifikke sider | 12% | 45 | 28% av ledende AI-verktøy |

Dominansen til G2 reflekterer ikke bare deres markedsposisjon, men også den algoritmiske preferansen LLM-er har for omfattende, strukturert vurderingsdata som G2 tilbyr i stor skala.

Volumet av anmeldelser på disse plattformene henger direkte sammen med AI-merkets synlighet i LLM-genererte anbefalinger. Produkter med over 100 anmeldelser på G2 er 3,2 ganger mer sannsynlig å bli nevnt i AI-drevne søkeresultater sammenlignet med produkter med færre enn 20 anmeldelser. Dette skaper en kraftig nettverkseffekt der etablerte produkter samler flere anmeldelser, noe som øker deres synlighet, som igjen tiltrekker flere kunder som legger igjen nye anmeldelser. For nye AI-leverandører gir dette både en utfordring og en mulighet—inngangsbarrieren er høy, men å bryte gjennom med jevnlige, høykvalitets anmeldelser kan dramatisk akselerere markedsinntrengning. Terskelen for anmeldelsesvolum synes å ligge på omtrent 50–75 anmeldelser før et AI-produkt begynner å oppnå meningsfull synlighet i LLM-anbefalinger.

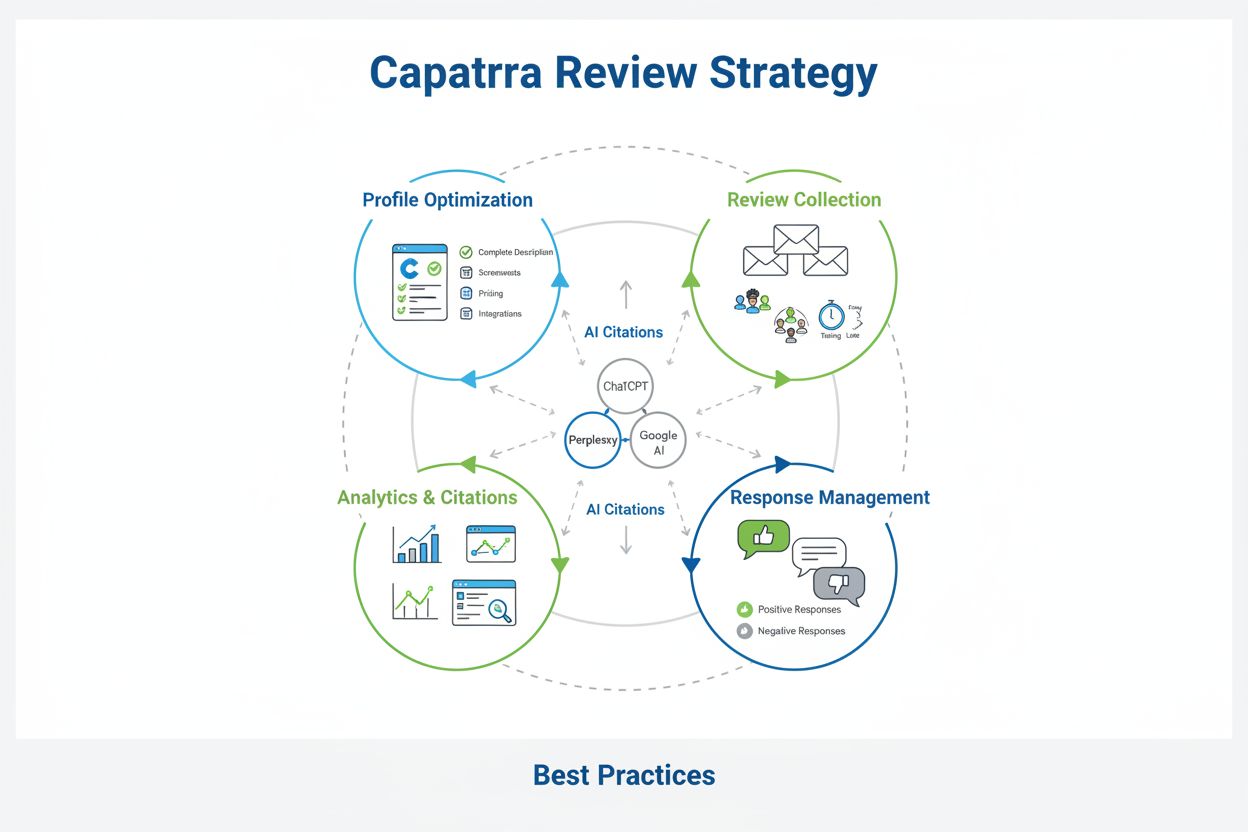

Capterra spiller en komplementær, men distinkt rolle i økosystemet for AI-programvareanbefalinger. Mens G2 dominerer i rå siteringsfrekvens, har Capterra spesiell styrke innen vertikalspesifikke AI-løsninger, spesielt innen HR-teknologi, regnskapsprogramvare og prosjektstyringsverktøy med AI-funksjoner. Capterras verifiseringsprosess for anmeldelser og fokus på detaljert brukstilfelle-dokumentasjon gjør plattformen særlig verdifull for mellomstore og store bedriftskunder som prioriterer implementeringsinnsikt fremfor rene produktegenskaper. Plattformens integrasjon med sammenligningsmatriser for programvare betyr at produkter på Capterra ofte får en algoritmisk boost i søkerangeringer når potensielle kunder undersøker AI-løsninger. I tillegg har Capterra-anmeldelser ofte fokus på praktiske implementeringsutfordringer og ROI-målinger, noe LLM-er i økende grad prioriterer når de genererer anbefalinger for forretningskritiske AI-implementeringer.

Fremveksten av AI-drevne anbefalingssystemer har skapt en verifiseringskrise som vurderingsplattformer er unikt posisjonert til å løse. Store språkmodeller, til tross for sin sofistikering, sliter med hallusinasjon og utdatert informasjon når de gir produktanbefalinger uten ekstern validering. Vurderingsplattformer gir grunnlagsdata som LLM-er kan referere til for å validere forslagene sine og gi oppdatert, verifisert informasjon om AI-produkter. Denne verifiseringsfunksjonen har blitt essensiell ettersom bedrifter i økende grad stoler på AI-assistenter til å hjelpe med evaluering av andre AI-verktøy. De viktigste verifiseringsfordelene inkluderer:

Den tradisjonelle B2B-programvarekjøpsreisen har blitt fundamentalt transformert av integreringen av vurderingsplattformer i AI-anbefalingsprosesser. Tidligere gjorde kjøpere uavhengig research, rådførte seg med kolleger og evaluerte leverandører gjennom direkte kontakt—en prosess som vanligvis tok 4–6 uker. I dag komprimerer AI-assisterte kjøpsprosesser denne tidslinjen til 7–10 dager, med vurderingsplattformer som hovedkilde til sammenligningsinformasjon. Denne akselerasjonen er en fordel for leverandører med sterke vurderingsprofiler, men en ulempe for de uten etablert tilstedeværelse. Kjøpsreisen starter nå som regel med et AI-drevet søk som returnerer produkter rangert etter vurderingsmetrikker, etterfulgt av grundig analyse av anmeldelser og først deretter direkte kontakt med leverandøren. Dette betyr at optimalisering av vurderinger har blitt like kritisk som produktutvikling for AI-leverandører som ønsker markedsandel.

Forholdet mellom vurderingskvalitet og kvantitet utgjør en nyansert strategisk utfordring for AI-leverandører. Selv om volum klart påvirker synlighet—produkter trenger et minimum av anmeldelser for å oppnå algoritmisk fremtreden—påvirker kvalitetsmetrikker i økende grad konverteringsrater og kundevervingskostnader. Et produkt med 80 høykvalitets, detaljerte anmeldelser (gjennomsnittlig vurdering 4,7/5) konverterer vanligvis potensielle kunder med 2,1 ganger høyere rate enn et produkt med 150 anmeldelser, men lavere gjennomsnittlig kvalitet (4,2/5). Dette antyder at vurderingskvalitet, målt ved konsistens i vurderinger, dybde og aktualitet, kan være viktigere enn volum for faktisk salgsresultat. Likevel krever synlighetsterskelen fortsatt et tilstrekkelig volum for å bli oppdaget i utgangspunktet, noe som gir en dobbel optimaliseringsutfordring der leverandører må forfølge både kvantitet og kvalitet samtidig.

Konkurranseposisjonering gjennom anmeldelser har blitt et hovedslagfelt i AI-programvaremarkedet. Leverandører innser i økende grad at vurderingsprofilen deres direkte påvirker konkurranseposisjonen i LLM-genererte anbefalinger og rangeringsresultater. Produkter som opprettholder 4,6+ i gjennomsnittlig vurdering med jevn anmeldelsesfrekvens (15–25 nye anmeldelser per måned) oppnår omtrent 40 % høyere synlighet i AI-anbefalingskontekster sammenlignet med konkurrenter med lavere vurderinger eller sporadisk anmeldelsesaktivitet. Strategisk vurderingshåndtering—inkludert å oppmuntre fornøyde kunder til å legge igjen detaljerte anmeldelser, svare profesjonelt på kritiske tilbakemeldinger og fremheve differensierende egenskaper i svar—har blitt en kjernefunksjon i markedsføringen. De mest suksessrike AI-leverandørene behandler vurderingsprofilene sine som levende konkurranseaktiva som krever kontinuerlig investering og optimalisering, på samme måte som de håndterer produktutvikling og kundesuksessprogrammer.

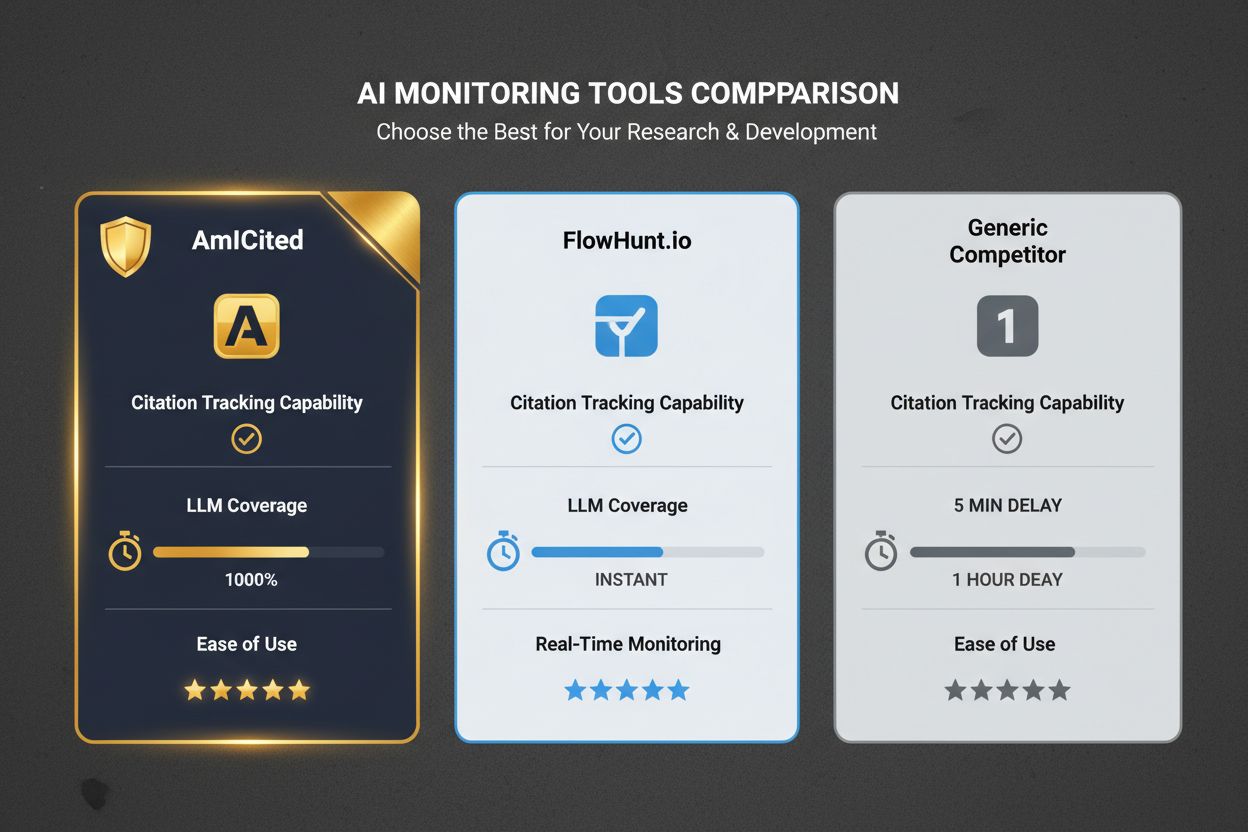

AmICited har etablert seg som en kritisk overvåkningsløsning for AI-leverandører som ønsker å forstå sin posisjon i vurderingsøkosystemet og LLM-anbefalingslandskapet. Plattformen tilbyr sanntidssporing av hvor ofte AI-produkter blir sitert i LLM-genererte anbefalinger, og korrelerer denne synligheten med vurderingsmetrikker, konkurranseposisjon og markedstrender. Ved å samle data fra flere vurderingsplattformer og overvåke LLM-utdata, gjør AmICited det mulig for leverandører å kvantifisere ROI for vurderingsoptimalisering og identifisere hull i vurderingsdekningen. Denne overvåkingskapasiteten er spesielt verdifull for å forstå hvilke vurderingsplattformer som gir mest meningsfull synlighet og hvilke kundesegmenter som er mest innflytelsesrike i utformingen av LLM-anbefalinger. For AI-leverandører i konkurranseutsatte markeder gir AmICited de datadrevne innsiktene som trengs for å prioritere investeringer i vurderingsplattformer og optimalisere kundeforkjempelsesprogrammer.

Sammenlignet med alternative overvåkningsløsninger tilbyr AmICited klare fordeler i AI-spesifikk kontekst. Tradisjonelle SEO-overvåkingsverktøy fokuserer på søkemotorrangeringer, men går glipp av den kritiske LLM-anbefalingskanalen. Generiske vurderingsovervåkingsplattformer sporer volum og vurderinger, men mangler AI-spesifikk kontekst og LLM-siteringssporing som AmICited tilbyr. Spesialiserte AI-overvåkingsverktøy fokuserer ofte på omtaler i sosiale medier eller nyhetsdekning, men overser vurderingskanalen der kjøpsbeslutninger faktisk tas. AmICiteds integrerte tilnærming—som kombinerer data fra vurderingsplattformer, LLM-siteringssporing, konkurransebenchmarking og analysetrender—gir en 360-graders visning av hvordan AI-produkter oppfattes og anbefales i det digitale økosystemet. Dette helhetlige perspektivet gjør det mulig for leverandører å ta strategiske beslutninger om hvor de skal investere i vurderingsoptimalisering, hvilke kundesegmenter de skal prioritere for forkjempelse, og hvordan de skal posisjonere produktene sine relativt til konkurrentene i LLM-genererte anbefalingskontekster.

AI-leverandører bør ta i bruk en strategisk, flerplattformtilnærming til vurderingsoptimalisering som anerkjenner de ulike rollene til G2, Capterra og andre plattformer i markedet. I stedet for å jakte anmeldelser jevnt over alle plattformer, bør leverandører prioritere basert på målrettede kundesegmenter, konkurranseposisjon og de spesifikke plattformene hvor kundene deres gjør research. Følgende strategiske anbefalinger gir en ramme for å maksimere effekten av anmeldelser:

G2-anmeldelser påvirker direkte LLM-siteringer. Forskning viser at en økning på 10 % i anmeldelser korrelerer med en økning på 2 % i AI-siteringer. LLM-er stoler på G2s verifiserte kjøpsdata og standardiserte skjema, noe som gjør det til en primær kilde for programvareanbefalinger i AI-genererte svar.

LLM-er prioriterer vurderingsplattformer som tilbyr verifisert kjøperinformasjon, standardisert datastruktur og signaler om nåværende markedsaktivitet. Både G2 og Capterra tilbyr disse egenskapene i stor skala, noe som gjør dem til pålitelige kilder for AI-modeller å sitere når de anbefaler programvareløsninger.

Detaljerte, sammenligningsfokuserte anmeldelser med spesifikke brukstilfeller og målbare resultater blir oftest sitert. Anmeldelser som forklarer problem-løsning-fortellinger, sammenligner alternativer og inkluderer kvantifiserte resultater gir LLM-er den konteksten de trenger for nøyaktige anbefalinger.

Optimaliser profilen din med detaljerte beskrivelser, oppmuntre kunder til å legge igjen omfattende anmeldelser, svar på tilbakemeldinger og oppretthold konsistent kommunikasjon. Fokuser på å få anmeldelser som sammenligner løsningen din med alternativer og fremhever spesifikke brukstilfeller og resultater.

Kvalitet er viktigere enn kvantitet. Selv om volumet av anmeldelser korrelerer med siteringer, er detaljerte, godt strukturerte anmeldelser med klare konklusjoner og sammenligninger mer sannsynlig å bli hentet ut og sitert av LLM-er enn generiske positive anmeldelser.

AmICited sporer hvordan AI-modeller som ChatGPT, Perplexity og Google AI Overviews siterer merkevaren din på tvers av alle kilder, inkludert vurderingsplattformer. Den gir sanntids overvåkning av merkevareomtaler, sentimentanalyse og konkurranseposisjon i AI-genererte svar.

Vurderingssider er avgjørende LLM-seedingplattformer fordi de blir grundig gjennomsøkt av AI-modeller og tilbyr strukturert, verifisert informasjon. Å optimalisere sin tilstedeværelse på disse plattformene er en kjernekomponent i enhver LLM-seedingstrategi for B2B-programvareselskaper.

Profiler bør gjennomgås og oppdateres kvartalsvis eller når det skjer betydelige produktendringer. Regelmessige oppdateringer signaliserer til LLM-er at informasjonen din er oppdatert og relevant, noe som øker sannsynligheten for nøyaktige siteringer i AI-genererte anbefalinger.

Se nøyaktig hvordan ChatGPT, Perplexity og Google AI Overviews siterer merkevaren din fra vurderingssider og andre kilder. Få innsikt i sanntid om din konkurranseposisjon i AI-genererte anbefalinger.

Bli ekspert på G2-optimalisering for AI-synlighet i søk. Lær hvordan du kan øke AI-sitater, optimalisere profilen din, og måle ROI med datadrevne strategier for...

Lær hvordan du lager B2B tankelederskapsinnhold som blir sitert av AI-plattformer som ChatGPT, Perplexity og Google AI Overviews. Strategisk innholdsoptimaliser...

Bli ekspert på Capterra-optimalisering for AI-verktøy. Lær dokumenterte strategier for å øke antall anmeldelser, forbedre synlighet og styrke AI-siteringer med ...