Beste måten å formatere overskrifter for AI: Komplett guide for 2025

Lær beste praksis for å formatere overskrifter for AI-systemer. Oppdag hvordan riktig H1, H2, H3-hierarki forbedrer AI-innhenting, siteringer og synlighet i Cha...

Lær hvordan du optimaliserer overskrifthierarki for LLM-tolkning. Mestre H1, H2, H3-struktur for å forbedre KI-synlighet, siteringer og innholdsoppdagbarhet i ChatGPT, Perplexity og Google AI Overviews.

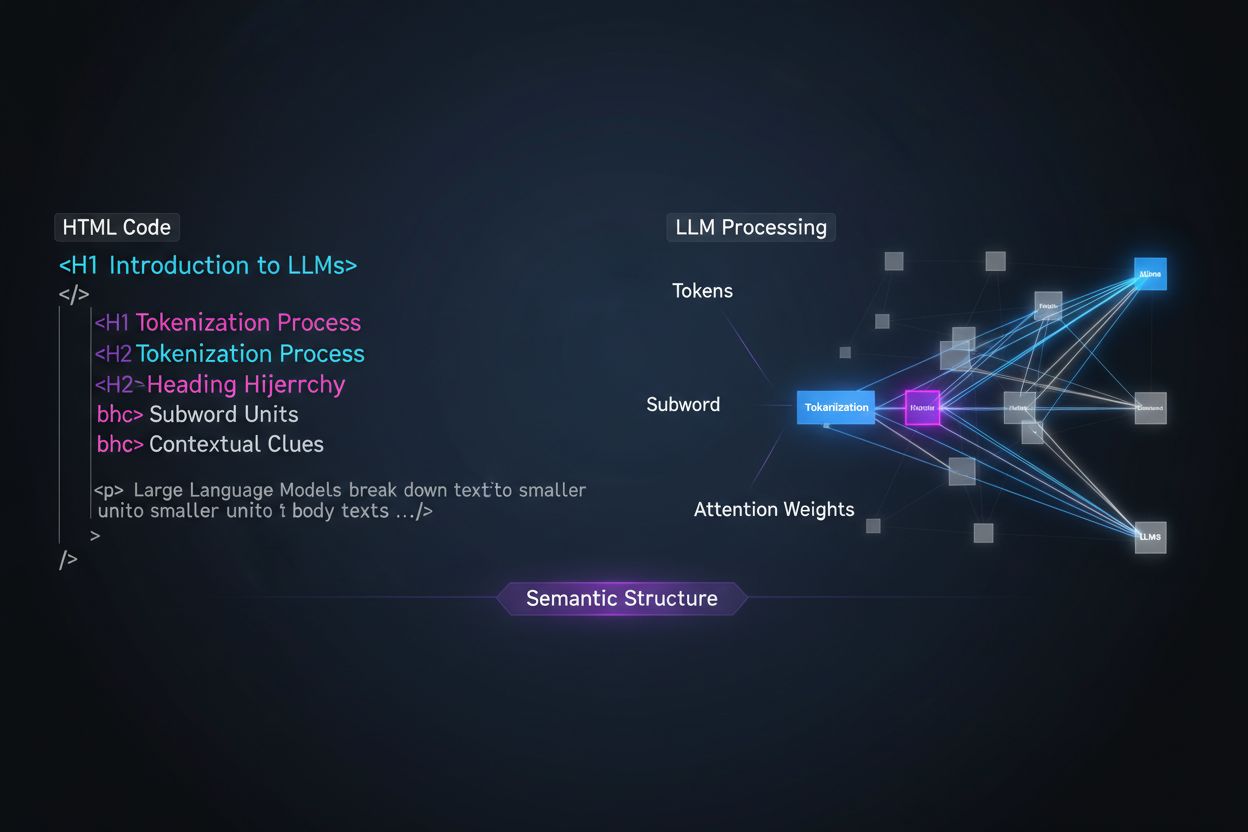

Store språkmodeller prosesserer innhold fundamentalt annerledes enn menneskelige lesere, og forståelsen av dette skillet er avgjørende for å optimalisere innholdsstrategien din. Mens mennesker skanner sider visuelt og intuitivt oppfatter dokumentstrukturen, er LLM-er avhengige av tokenisering og oppmerksomhetsmekanismer for å tolke mening fra sekvensiell tekst. Når en LLM møter innholdet ditt, deler den det opp i tokens (små tekstbiter) og tildeler oppmerksomhetsvekter til ulike seksjoner basert på strukturelle signaler—og overskrifthierarki fungerer som et av de kraftigste strukturelle signalene som finnes. Uten tydelig overskriftsorganisering sliter LLM-er med å identifisere hovedtemaer, støttende argumenter og kontekstuelle relasjoner i innholdet ditt, noe som fører til mindre presise svar og redusert synlighet i KI-drevne søke- og gjenfinningssystemer.

Moderne innholdsoppdelingsstrategier i retrieval-augmented generation (RAG)-systemer og KI-søkemotorer er sterkt avhengige av overskriftsstruktur for å avgjøre hvor dokumenter skal deles inn i gjenfinningsbare segmenter. Når en LLM møter velorganiserte overskrifthierarkier, bruker den H2- og H3-grenser som naturlige snittlinjer for å lage semantiske biter—diskrete informasjonsenheter som kan hentes og siteres uavhengig. Denne prosessen er langt mer effektiv enn vilkårlig oppdeling etter tegnantall, fordi overskriftsbaserte biter bevarer semantisk sammenheng og kontekst. Vurder forskjellen mellom to tilnærminger:

| Tilnærming | Kvalitet på biter | LLM-siteringsrate | Gjenfinningsnøyaktighet |

|---|---|---|---|

| Semantikk-rik (overskriftsbasert) | Høy sammenheng, komplette tanker | 3x høyere | 85%+ nøyaktighet |

| Generisk (tegnantall-basert) | Fragmentert, ufullstendig kontekst | Grunnnivå | 45-60% nøyaktighet |

Forskning viser at dokumenter med klare overskrifthierarkier opplever 18-27% forbedring i svarnøyaktighet når de prosesseres av LLM-er, hovedsakelig fordi oppdelingsprosessen bevarer de logiske sammenhengene mellom ideer. Systemer som Retrieval-Augmented Generation (RAG)-pipeliner, som driver verktøy som ChatGPTs nettleserfunksjon og bedrifts-KI-systemer, leter eksplisitt etter overskriftsstrukturer for å optimalisere sine gjenfinningssystemer og forbedre siteringsnøyaktigheten.

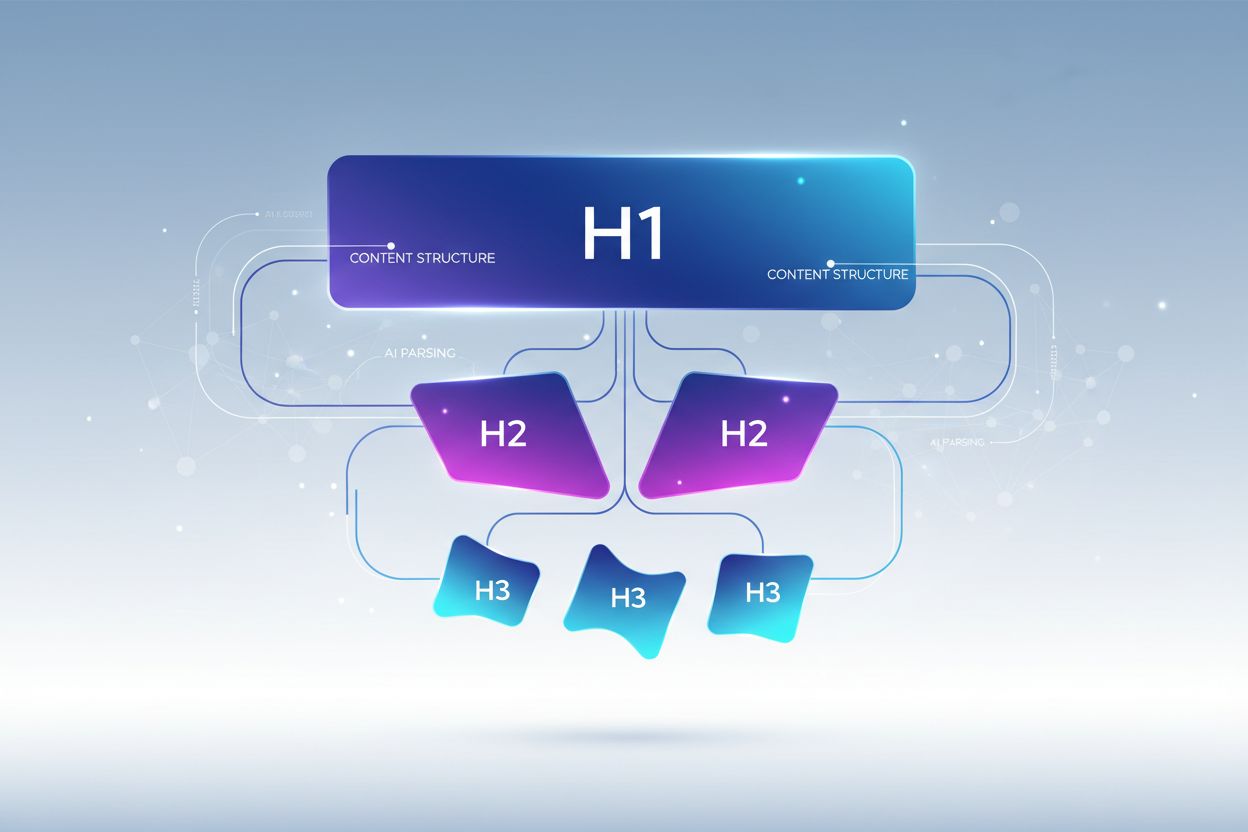

Riktig overskrifthierarki følger en streng nestingsstruktur som speiler hvordan LLM-er forventer at informasjon organiseres, hvor hvert nivå har en distinkt funksjon i innholdsarkitekturen din. H1-taggen representerer dokumentets hovedtema—det skal bare være én per side, og den bør tydelig angi hovedemnet. H2-tagger representerer større temadivisjoner som støtter eller utvider H1, hver av dem adresserer et eget aspekt av hovedtemaet ditt. H3-tagger går dypere inn i spesifikke underemner innenfor hver H2-seksjon, gir detaljer og svarer på oppfølgingsspørsmål. Den kritiske regelen for LLM-optimalisering er at du aldri skal hoppe over nivåer (for eksempel gå fra H1 direkte til H3), og bør ha konsekvent nesting—hver H3 må tilhøre en H2, og hver H2 må tilhøre en H1. Denne hierarkiske strukturen skaper det forskere kaller et “semantisk tre” som LLM-er kan traversere for å forstå innholdets logiske flyt og trekke ut relevant informasjon med presisjon.

Den mest effektive overskriftsstrategien for LLM-synlighet behandler hver H2-overskrift som et direkte svar på en spesifikk brukerintensjon eller spørsmål, med H3-overskrifter som kartlegger under-spørsmål og gir støttende detaljer. Denne “svar-først”-tilnærmingen er i tråd med hvordan moderne LLM-er henter og syntetiserer informasjon—de søker etter innhold som direkte adresserer brukerens spørsmål, og overskrifter som tydelig angir svar er langt mer sannsynlig å bli valgt ut og sitert. Hver H2 bør fungere som en svarenhet, et selvstendig svar på et konkret spørsmål en bruker kan stille om temaet ditt. For eksempel, hvis H1-en din er “Hvordan optimalisere nettsideytelse”, kan H2-ene dine være “Reduser bildefilstørrelser (forbedrer lastetid med 40 %)” eller “Implementer nettlesercaching (reduserer serverforespørsler med 60 %)"—hver overskrift svarer direkte på et spesifikt ytelsesspørsmål. H3-ene under hver H2 tar så for seg oppfølgingsspørsmål: under “Reduser bildefilstørrelser” kan du ha H3-er som “Velg riktig bildeformat”, “Komprimer uten kvalitetstap” og “Implementer responsive bilder”. Denne strukturen gjør det dramatisk enklere for LLM-er å identifisere, trekke ut og sitere innholdet ditt fordi overskriftene selv inneholder svarene, ikke bare emnetiketter.

Å transformere overskriftsstrategien din for å maksimere LLM-synlighet krever implementering av spesifikke, handlingsrettede teknikker som går utover grunnleggende struktur. Her er de mest effektive optimaliseringsmetodene:

Bruk beskrivende, spesifikke overskrifter: Bytt ut vage titler som “Oversikt” eller “Detaljer” med spesifikke beskrivelser som “Hvordan maskinlæring forbedrer anbefalingsnøyaktighet” eller “Tre faktorer som påvirker søkerangering”. Forskning viser at spesifikke overskrifter øker LLM-siteringsraten opptil 3x sammenlignet med generiske titler.

Bruk spørsmål som overskrifter: Formuler H2-ene som direkte spørsmål brukerne stiller (“Hva er semantisk søk?” eller “Hvorfor er overskrifthierarki viktig?”). LLM-er er trent på Q&A-data og prioriterer naturlig spørsmål som overskrifter ved henting av svar.

Inkluder klarhet om entiteter i overskrifter: Når du diskuterer spesifikke konsepter, verktøy eller enheter, navngi dem eksplisitt i overskriftene fremfor å bruke pronomen eller vage referanser. For eksempel er “Optimalisering av PostgreSQL-ytelse” langt mer LLM-vennlig enn “Databaseoptimalisering”.

Unngå å kombinere flere intensjoner: Hver overskrift bør ta for seg ett, fokusert tema. Overskrifter som “Installasjon, konfigurasjon og feilsøking” utvanner semantisk klarhet og forvirrer LLM-algoritmer for oppdeling.

Legg til kvantifiserbar kontekst: Når det er relevant, inkluder tall, prosenter eller tidsrammer i overskriftene (“Reduser lastetid med 40 % med bildeoptimalisering” vs. “Bildeoptimalisering”). Studier viser at 80 % av LLM-sitert innhold inkluderer kvantifiserbar kontekst i overskriftene.

Bruk parallell struktur på tvers av nivåer: Hold grammatisk struktur konsekvent på tvers av H2-er og H3-er i samme seksjon. Hvis en H2 starter med et verb (“Implementer caching”), bør andre også gjøre det (“Konfigurer databaseindekser”, “Optimaliser spørringer”).

Inkluder nøkkelord naturlig: Selv om det ikke kun er for SEO, hjelper det å inkludere relevante nøkkelord i overskriftene LLM-er med å forstå temarelevans og forbedrer gjenfinningsnøyaktigheten med 25-35 %.

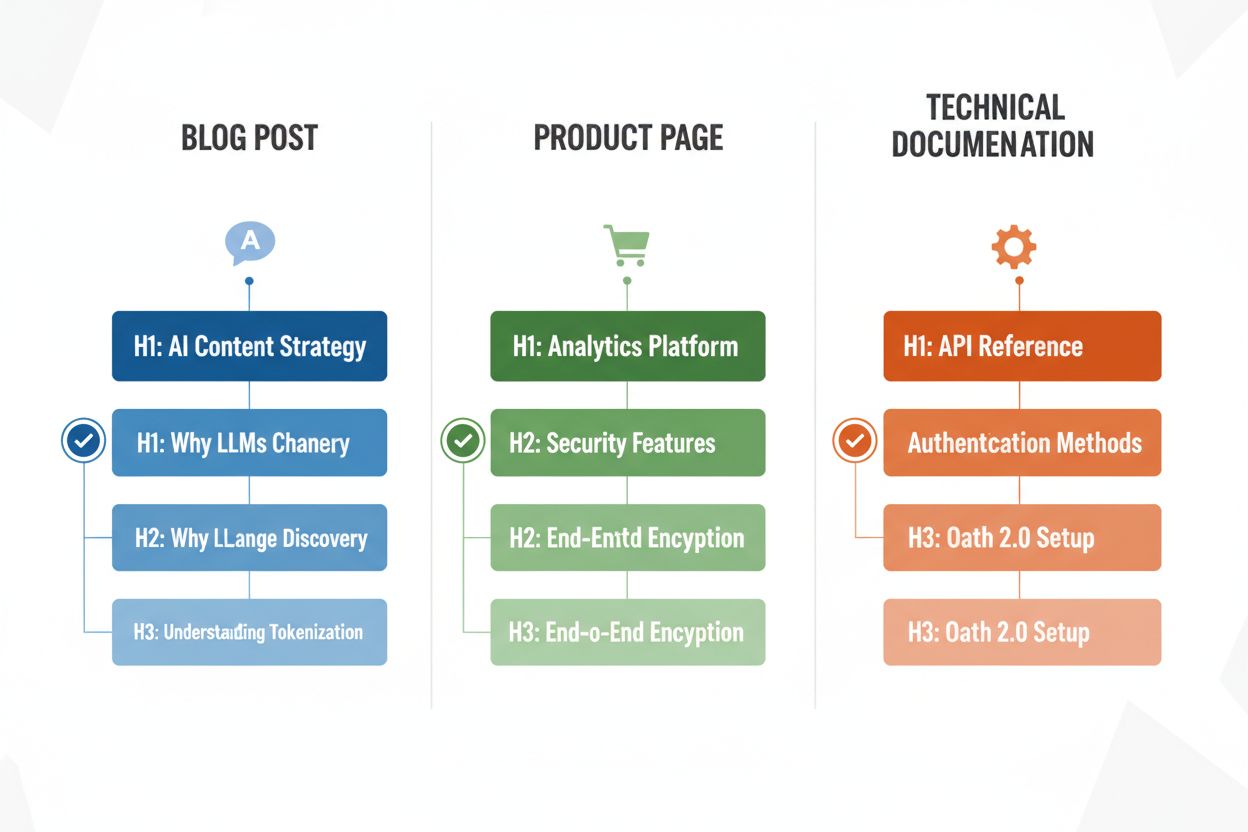

Ulike innholdstyper krever tilpassede overskriftsstrategier for å maksimere LLM-tolkningseffektivitet, og forståelsen av disse mønstrene sikrer at innholdet ditt er optimalisert uansett format. Blogginnlegg har nytte av narrativt drevne overskrifthierarkier der H2-ene følger en logisk progresjon gjennom et argument eller en forklaring, med H3-er som gir bevis, eksempler eller dypere utforskning—for eksempel kan et innlegg om “KI-innholdsstrategi” bruke H2-er som “Hvorfor LLM-er endrer innholdsoppdagelse”, “Hvordan optimalisere for KI-synlighet” og “Måle din KI-innholdsprestasjon”. Produktsider bør bruke H2-er som kartlegger direkte til brukerbekymringer og beslutningsfaktorer (“Sikkerhet og etterlevelse”, “Integrasjonsmuligheter”, “Priser og skalerbarhet”), med H3-er som tar for seg spesifikke funksjonsspørsmål eller brukstilfeller. Teknisk dokumentasjon krever den mest detaljerte overskriftsstrukturen, med H2-er som representerer hovedfunksjoner eller arbeidsflyter og H3-er som bryter ned spesifikke oppgaver, parametere eller konfigurasjonsalternativer—denne strukturen er kritisk fordi dokumentasjon ofte siteres av LLM-er når brukere stiller tekniske spørsmål. FAQ-sider bør bruke H2-er som selve spørsmålene (formatert som faktiske spørsmål) og H3-er for oppfølgende avklaringer eller relaterte temaer, da denne strukturen passer perfekt med hvordan LLM-er henter og presenterer Q&A-innhold. Hver innholdstype har ulike brukerintensjoner, og overskrifthierarkiet ditt bør reflektere disse intensjonene for å maksimere relevans og sannsynlighet for å bli sitert.

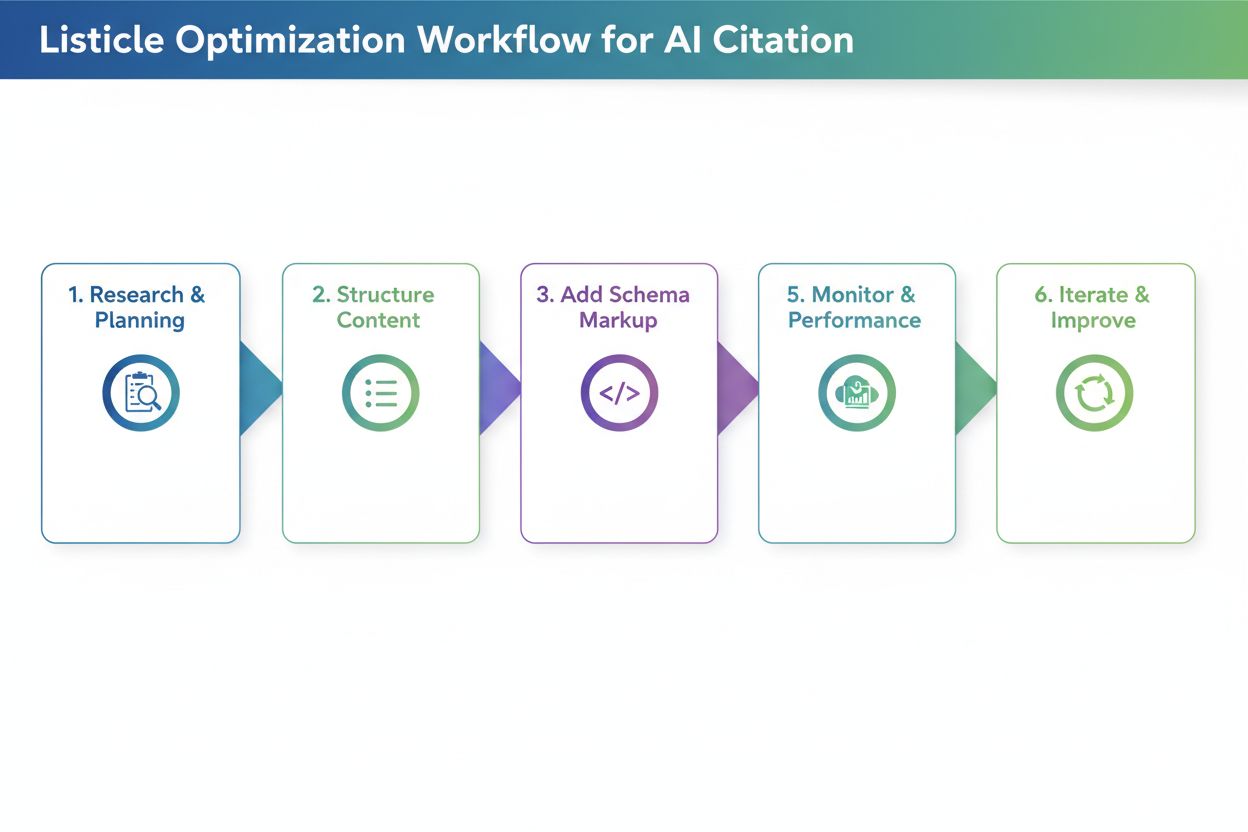

Når du har omstrukturert overskriftene dine, er validering avgjørende for å sikre at de faktisk forbedrer LLM-tolkning og synlighet. Den mest praktiske tilnærmingen er å teste innholdet ditt direkte med KI-verktøy som ChatGPT, Perplexity eller Claude ved å laste opp dokumentet ditt eller oppgi en URL og stille spørsmål som overskriftene dine er designet for å svare på. Vær oppmerksom på om KI-verktøyet korrekt identifiserer og siterer innholdet ditt, og om det trekker ut riktige seksjoner—hvis H2-en din om “Redusere lastetid” ikke blir sitert når brukere spør om ytelsesoptimalisering, kan overskriften trenge forbedring. Du kan også bruke spesialiserte verktøy som SEO-plattformer med KI-siteringssporing (slik som Semrush eller Ahrefs’ nyere KI-funksjoner) for å overvåke hvor ofte innholdet ditt dukker opp i LLM-svar over tid. Iterer basert på resultatene: hvis visse seksjoner ikke blir sitert, eksperimenter med mer spesifikke eller spørsmål-formede overskrifter, legg til kvantifiserbar kontekst, eller tydeliggjør sammenhengen mellom overskriften og vanlige brukerforespørsler. Denne testsyklusen tar vanligvis 2-4 uker før du ser målbare resultater, da det tar tid for KI-systemer å re-indeksere og revurdere innholdet ditt.

Selv velmenende innholdsprodusenter gjør ofte overskriftsfeil som betydelig reduserer LLM-synlighet og tolkningsnøyaktighet. En av de vanligste feilene er å kombinere flere intensjoner i én overskrift—for eksempel tvinger “Installasjon, konfigurasjon og feilsøking” LLM-er til å velge hvilket tema seksjonen dekker, noe som ofte fører til feilaktig oppdeling og redusert sannsynlighet for å bli sitert. Vage, generiske overskrifter som “Oversikt”, “Nøkkelpunkter” eller “Tilleggsinformasjon” gir ingen semantisk klarhet og gjør det umulig for LLM-er å forstå hvilket spesifikt innhold seksjonen inneholder; når en LLM møter slike overskrifter, hopper den ofte over seksjonen helt eller feiltolker relevansen. Manglende kontekst er en annen kritisk feil—en overskrift som “Beste praksis” sier ikke noe om hvilket domene eller tema praksisen gjelder, mens “Beste praksis for API-rate limiting” er umiddelbart tydelig og lett å hente ut. Inkonsistent hierarki (å hoppe over nivåer, bruke H4 uten H3, eller blande overskriftsstiler) forvirrer LLM-tolkningsalgoritmer fordi de er avhengige av konsistente strukturelle mønstre for å forstå dokumentorganisering. For eksempel skaper et dokument som bruker H1 → H3 → H2 → H4 uklarhet om hvilke seksjoner som er relatert og hvilke som er uavhengige, noe som reduserer gjenfinningsnøyaktigheten med 30-40 %. Å teste innholdet ditt med ChatGPT eller lignende verktøy vil raskt avdekke slike feil—hvis KI-en sliter med å forstå strukturen eller siterer feil seksjoner, bør overskriftene revideres.

Optimaliseringen av overskrifthierarki for LLM-tolkning gir en kraftig sekundær fordel: forbedret tilgjengelighet for menneskelige brukere med funksjonsnedsettelser. Semantisk HTML-overskriftsstruktur (riktig bruk av H1-H6-tagger) er grunnleggende for skjermleserfunksjonalitet, slik at synshemmede brukere kan navigere effektivt og forstå innholdsorganiseringen. Når du lager tydelige, beskrivende overskrifter optimalisert for LLM-tolkning, lager du samtidig bedre navigasjon for skjermlesere—den samme spesifisiteten og klarheten som hjelper LLM-er å forstå innholdet ditt hjelper også hjelpemiddelteknologi å veilede brukere gjennom det. Denne samsvaringen mellom KI-optimalisering og tilgjengelighet representerer en sjelden vinn-vinn: de tekniske kravene for LLM-vennlig innhold støtter direkte WCAG-tilgjengelighetsstandardene og forbedrer opplevelsen for alle brukere. Organisasjoner som prioriterer overskrifthierarki for KI-synlighet ser ofte uventede forbedringer i tilgjengelighetskomplians og brukertilfredshet blant brukere som er avhengige av hjelpemiddelteknologi.

Å implementere forbedringer i overskrifthierarkiet krever måling for å rettferdiggjøre innsatsen og identifisere hva som fungerer. Den mest direkte KPI-en er LLM-siteringsrate—følg med på hvor ofte innholdet ditt dukker opp i svar fra ChatGPT, Perplexity, Claude og andre KI-verktøy ved å jevnlig stille relevante spørsmål og loggføre hvilke kilder som blir sitert. Verktøy som Semrush, Ahrefs og nyere plattformer som Originality.AI tilbyr nå LLM-siteringssporing som overvåker synligheten din i KI-genererte svar over tid. Du bør forvente en 2-3x økning i siteringer innen 4-8 uker etter å ha implementert riktig overskrifthierarki, selv om resultatene varierer etter innholdstype og konkurransenivå. I tillegg til siteringer, følg med på organisk trafikk fra KI-drevne søkefunksjoner (Google AI Overviews, Bing Chat-siteringer osv.) separat fra tradisjonelt organisk søk, da disse ofte viser raskere forbedring med overskriftsoptimalisering. Overvåk også innholdsengasjementsmålinger som tid på side og scroll-dybde for sider med optimaliserte overskrifter—bedre struktur øker vanligvis engasjementet med 15-25 % fordi brukere lettere finner relevant informasjon. Til slutt, mål gjenfinningsnøyaktighet i egne systemer hvis du bruker RAG-pipeliner eller interne KI-verktøy ved å teste om riktige seksjoner blir hentet for vanlige spørsmål. Disse målingene viser samlet avkastningen av overskriftsoptimalisering og styrer videre forbedring av innholdsstrategien din.

Overskrifthierarki påvirker hovedsakelig KI-synlighet og LLM-siteringer fremfor tradisjonelle Google-rangeringer. Riktig overskriftsstruktur forbedrer imidlertid generell innholdskvalitet og lesbarhet, noe som indirekte støtter SEO. Hovedfordelen er økt synlighet i KI-drevne søkeresultater som Google AI Overviews, ChatGPT og Perplexity, der overskriftsstruktur er avgjørende for innholdsekstraksjon og sitering.

Ja, hvis dine nåværende overskrifter er vage eller ikke følger et tydelig H1→H2→H3-hierarki. Start med å kartlegge dine best presterende sider og implementer forbedringer i overskriftene på innhold med høy trafikk først. Det positive er at LLM-vennlige overskrifter også er mer brukervennlige, så endringene gagner både mennesker og KI-systemer.

Absolutt. Faktisk fungerer de beste overskriftsstrukturene godt for begge. Tydelige, beskrivende, hierarkiske overskrifter som hjelper mennesker å forstå innholdsorganisering er akkurat det LLM-er trenger for tolkning og oppdeling. Det er ingen konflikt mellom brukervennlige og LLM-vennlige overskriftspraksiser.

Det finnes ingen streng grense, men sikt på 3-7 H2-er per side avhengig av innholdslengde og kompleksitet. Hver H2 bør representere et eget tema eller svarenhet. Under hver H2, inkluder 2-4 H3-er for støttende detaljer. Sider med 12-15 totale overskriftsseksjoner (H2-er og H3-er til sammen) har en tendens til å prestere godt i LLM-siteringer.

Ja, selv kort innhold har fordeler av riktig overskriftsstruktur. En artikkel på 500 ord kan ha bare 1-2 H2-er, men de bør fortsatt være beskrivende og spesifikke. Kort innhold med tydelige overskrifter blir oftere sitert i LLM-svar enn ustrukturert kortinnhold.

Test innholdet ditt direkte med ChatGPT, Perplexity eller Claude ved å stille spørsmål overskriftene dine er ment å svare på. Hvis KI-en korrekt identifiserer og siterer innholdet ditt, fungerer strukturen. Hvis den sliter eller siterer feil seksjoner, trenger overskriftene forbedring. De fleste forbedringer gir resultater innen 2-4 uker.

Både Google AI Overviews og ChatGPT har nytte av tydelig overskrifthierarki, men ChatGPT legger enda større vekt på det. ChatGPT siterer innhold med sekvensiell overskriftsstruktur tre ganger oftere enn innhold uten. Grunnprinsippene er like, men LLM-er som ChatGPT er mer følsomme for overskriftskvalitet og -struktur.

Spørsmål fungerer best som overskrifter for FAQ-sider, feilsøkingsguider og opplæringsinnhold. For blogginnlegg og produktsider fungerer ofte en blanding av spørsmål og påstandsform best. Det viktigste er at overskriftene tydelig sier hva seksjonen handler om, enten som spørsmål eller påstand.

Følg med på hvor ofte innholdet ditt blir sitert i ChatGPT, Perplexity, Google AI Overviews og andre LLM-er. Få sanntidsinnsikt i din KI-søkeytelse og optimaliser innholdsstrategien din.

Lær beste praksis for å formatere overskrifter for AI-systemer. Oppdag hvordan riktig H1, H2, H3-hierarki forbedrer AI-innhenting, siteringer og synlighet i Cha...

Lær hvordan du lager LLM meta-svar som AI-systemer siterer. Oppdag strukturelle teknikker, strategier for svartetthet og siteringsklare innholdsformater som øke...

Oppdag hvorfor KI-modeller foretrekker listikler og nummererte lister. Lær hvordan du optimaliserer listebasert innhold for ChatGPT-, Gemini- og Perplexity-sita...