Multimodal AI-søk

Lær hvordan multimodale AI-søkesystemer behandler tekst, bilder, lyd og video sammen for å levere mer nøyaktige og kontekstuelt relevante resultater enn AI-løsn...

Bli ekspert på multimodal AI-søkeoptimalisering. Lær hvordan du optimaliserer bilder og stemmespørringer for AI-drevne søkeresultater, med strategier for GPT-4o, Gemini og LLM-er.

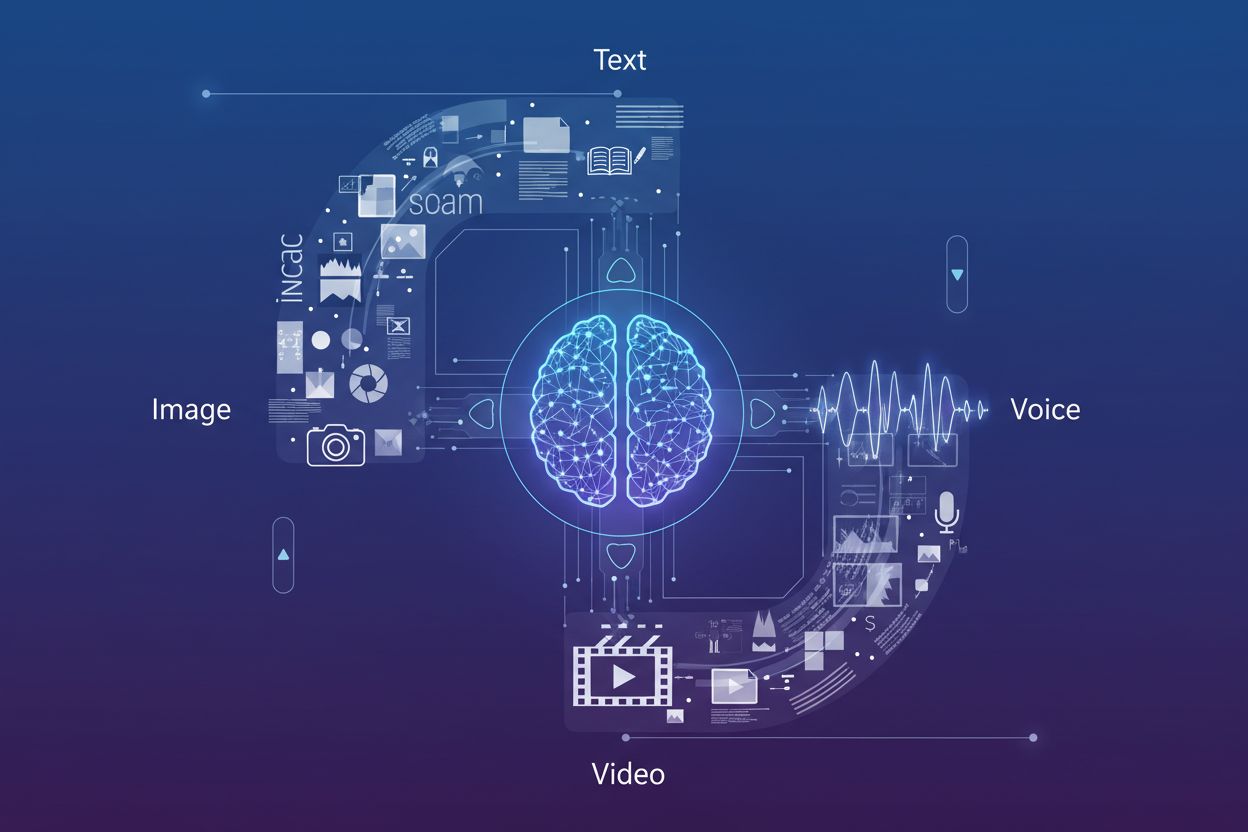

Multimodalt AI-søk representerer et grunnleggende skifte i hvordan søkemotorer behandler og forstår brukerforespørsler ved å integrere flere datatyper—tekst, bilder, stemme og video—i én samlet søkeopplevelse. I stedet for å behandle hver modalitet som en egen kanal, benytter moderne søkesystemer nå multimodale AI-modeller som kan analysere og sammenligne informasjon på tvers av ulike formater samtidig, noe som gir mer kontekstuelle og nøyaktige resultater. Denne utviklingen fra søk med én modalitet (hvor tekstforespørsler ga tekstresultater) til integrerte multimodale systemer speiler hvordan brukere naturlig samhandler med informasjon—de kombinerer muntlige spørsmål med visuelle referanser, laster opp bilder for kontekst, og forventer resultater som syntetiserer flere innholdstyper. Betydningen av dette skiftet kan ikke overdrives: det endrer fundamentalt hvordan innholdsprodusenter må optimalisere sin digitale tilstedeværelse og hvordan merkevarer må overvåke synlighet på tvers av søkekanaler. Å forstå multimodal søkeoptimalisering er ikke lenger valgfritt for virksomheter som ønsker å opprettholde konkurransedyktig synlighet i AI-drevne søkemiljøer.

Fremveksten av avanserte multimodale modeller har endret søkekapasitetene, og flere ledende plattformer tilbyr nå sofistikerte visjon-språk-modeller som kan prosessere og forstå innhold på tvers av flere modaliteter samtidig. Slik sammenlignes de største aktørene:

| Modellnavn | Skaper | Nøkkelfunksjoner | Best egnet for |

|---|---|---|---|

| GPT-4o | OpenAI | Sanntids bildeanalyse, stemmeprosessering, 320ms responstid | Kompleks visuell resonnering, multimodale samtaler |

| Gemini | Integrert søk, videoforståelse, kryssmodal resonnering | Søk-integrasjon, omfattende innholdsanalyse | |

| Claude 3.7 | Anthropic | Dokumentanalyse, bildefortolkning, nyansert forståelse | Teknisk dokumentasjon, detaljert visuell analyse |

| LLaVA | Åpen kildekode-miljø | Lettvekts visjon-språk-prosessering, effektiv inferens | Ressursbegrensede miljøer, edge-deployment |

| ImageBind | Meta | Kryssmodale embeddinger, lyd-visuell forståelse | Multimedieinnhold-korrelasjon, semantisk søk |

Disse modellene representerer det nyeste innen AI-søketeknologi, hver optimalisert for ulike bruksområder og utplasseringsscenarier. Organisasjoner må forstå hvilke modeller som driver sine aktuelle søkeplattformer for å kunne optimalisere innholdet effektivt for synlighet. Den raske utviklingen av disse teknologiene betyr at strategier for søkesynlighet må forbli fleksible og tilpasningsdyktige for å kunne utnytte nye egenskaper og rangeringsfaktorer.

Bilde-søkoptimalisering har blitt kritisk ettersom visuelle søkekapasiteter har ekspandert dramatisk—Google Lens alene hadde 10 millioner besøk i mai 2025, noe som viser den eksplosive veksten av bildebaserte søk. For å maksimere synlighet i bilde-søk AI-resultater bør innholdsprodusenter gjennomføre en helhetlig optimaliseringsstrategi:

Denne flerfasetterte tilnærmingen sikrer at bilder er søkbare både gjennom tradisjonelt bildesøk og gjennom multimodale AI-systemer som analyserer visuelt innhold i sammenheng med tilhørende tekst og metadata.

Integreringen av store språkmodeller i stemmesøk har fundamentalt endret hvordan søkemotorer tolker og svarer på muntlige forespørsler, og går langt forbi enkel stikkordmatching til avansert kontekstforståelse. Tradisjonelt stemmesøk bygget på fonetisk match og enkel språkprosessering, men moderne LLM-drevne stemmesøkesystemer forstår nå hensikt, kontekst, nyanser og samtalemønstre med bemerkelsesverdig nøyaktighet. Dette betyr at stemme-søkoptimalisering ikke lenger kan fokusere kun på eksakt-stikkord—innholdet må struktureres for å adressere den underliggende hensikten bak samtaleforespørsler som brukere faktisk sier høyt. Konsekvensene er store: en bruker som spør “Hva er den beste måten å fikse en lekk kjøkkenkran på?” har et helt annet behov enn den som skriver “fikse lekk kran,” og innholdet må besvare både spørsmålet og det implisitte behovet for steg-for-steg-veiledning. Utvalgte utdrag har blitt hovedkilden til svar i stemmesøk, der søkemotorene foretrekker korte, direkte svar øverst i søkeresultatene. Å forstå denne hierarkien—der stemmesvar hentes fra utvalgte utdrag—er avgjørende for enhver innholdsstrategi rettet mot stemmeaktiverte enheter og assistenter.

Optimalisering for samtaleforespørsler krever en grunnleggende restrukturering av hvordan innhold organiseres og presenteres, bort fra stikkordtette avsnitt og over til naturlige spørsmål-svar-formater som gjenspeiler hvordan folk faktisk snakker. Innholdet bør struktureres med spørsmål-baserte overskrifter som direkte adresserer vanlige spørringer brukere vil si høyt, etterfulgt av korte, autoritative svar som gir umiddelbar verdi uten at brukeren må lese lange forklaringer. Denne tilnærmingen samsvarer med hvordan naturlig språkprosessering trekker ut svar fra nettinnhold—de ser etter tydelige spørsmål-svar-par og direkte utsagn som kan isoleres og leses opp av stemmeassistenter. Implementering av strukturert data-markup som eksplisitt identifiserer spørsmål og svar hjelper søkemotorer å forstå innholdets samtaleform og øker sjansen for å bli valgt i stemmesøk. Langhalede, samtaleformulerte fraser bør naturlig integreres i innholdet i stedet for å tvinges inn på unaturlige steder. Målet er å skape innhold som høres naturlig ut når det sies høyt, samtidig som det er optimalisert for AI-systemer som analyserer og trekker ut informasjon fra sidene dine. Denne balansen mellom menneskelig lesbarhet og maskinforståelse er kjernen i effektiv stemme-søkoptimalisering.

Riktig schema markup er avgjørende for å signalisere til multimodale AI-systemer hva innholdet ditt representerer og hvordan det skal tolkes på tvers av ulike søkekontekster. De mest effektive strukturert data-implementeringene for multimodalt søk inkluderer FAQ-schema (som eksplisitt markerer spørsmål-svar-par for stemmesøk), HowTo-schema (som gir steg-for-steg-instruksjoner i maskinlesbart format) og Local Business-schema (for lokale multimodale spørringer). I tillegg sikrer Article-schema, Product-schema og Event-schema at innholdet ditt er riktig kategorisert og forstått av AI-systemer som analyserer sidene dine. Googles Rich Results Test bør brukes jevnlig for å validere at schema markup er riktig implementert og gjenkjent av søkesystemene. Det tekniske SEO-grunnlaget—ren HTML-struktur, rask lasting av sider, mobiltilpasning og korrekt kanonisering—blir enda viktigere i multimodale søkemiljøer der AI-systemene må raskt tolke og forstå innholdet ditt i flere formater. Organisasjoner bør gjennomgå hele innholdsbiblioteket for muligheter til schema-implementering, og prioritere sider med mye trafikk og innhold som naturlig passer til spørsmål-svar eller instruksjonsformater.

Å måle ytelse i multimodalt søk krever en endring av måleparametre utover tradisjonell organisk trafikk, med særlig fokus på visninger av utvalgte utdrag, engasjement fra stemmesøk og konverteringsrater fra multimodale kilder. Google Search Console gir innsikt i prestasjon på utvalgte utdrag, viser hvor ofte innholdet ditt vises i posisjon null og hvilke spørringer som utløser dine utdrag—data som direkte korrelerer med synlighet i stemmesøk. Mobilengasjement blir stadig viktigere, siden stemmesøk hovedsakelig brukes via mobile enheter og smarthøyttalere, noe som gjør mobilkonverteringer og økt øktvarighet til viktige KPI-er for stemmeoptimalisert innhold. Analyseplattformer bør settes opp til å spore trafikk fra stemmeassistenter og bildesøk separat fra tradisjonelt organisk søk, slik at du kan forstå hvilke multimodale kanaler som gir mest verdifull trafikk. Stemme-søk-målinger bør ikke bare inkludere trafikkvolum, men også konverteringskvalitet, siden stemmesøkere ofte har annen hensikt og atferd enn tekstbrukere. Overvåking av merkevareomtale i AI Overviews og andre AI-genererte søkeresultater gir innsikt i hvordan merkevaren vises i disse nye søkeformatene. Regelmessige revisjoner av prestasjonen på utvalgte utdrag, kombinert med trafikk-analyse fra stemmesøk, gir et helhetlig bilde av din multimodale søkesynlighet og ROI.

Utviklingen for multimodalt søk peker mot stadig mer avanserte AI-søke-trender som visker ut grensene mellom søk, surfing og direkte løsing av oppgaver, med AI Overviews som allerede viser over 10 % økt bruk ettersom brukere tar i bruk AI-genererte sammendrag. Fremvoksende muligheter inkluderer agentiske AI-systemer som kan utføre handlinger på vegne av brukeren—bestille bord, gjennomføre kjøp eller avtale møter—basert på multimodale spørringer som kombinerer stemme, bilde og kontekstuell informasjon. Personalisering vil bli stadig mer detaljert, der AI-systemene ikke bare forstår hva brukerne spør om, men også deres preferanser, lokasjon, kjøpshistorikk og atferdsmønstre, for å levere hyperrelevante resultater på tvers av modaliteter. Sanntids søkemuligheter utvides, slik at brukere kan stille spørsmål om live-hendelser, nåværende forhold eller siste nytt, med forventning om umiddelbare, nøyaktige svar syntetisert fra flere kilder. Videosøk vil modnes til en hovedmodalitet, der AI-systemer forstår ikke bare metadata, men selve innholdet i videoer, slik at brukerne kan søke etter spesifikke øyeblikk, konsepter eller informasjon i videobiblioteker. Konkurransen vil i økende grad favorisere merkevarer som har optimalisert på tvers av alle modaliteter, fordi synlighet i én kanal (utvalgte utdrag, bildesøk, stemmesvar) vil påvirke synlighet i de andre gjennom kryssmodale rangeringssignaler.

Etter hvert som multimodalt søk blir det dominerende paradigmet, har AI-overvåkning utviklet seg fra å kun spore enkle søkerangeringer til omfattende merkevare-siterings-overvåkning på tvers av bildesøk, stemmesvar og AI-genererte oversikter. AmICited gir avgjørende innsikt i hvordan merkevaren din vises i AI Overviews, utvalgte utdrag og stemmesøk—ikke bare om du rangerer, men hvordan merkevaren din blir fremstilt og sitert av AI-systemer som syntetiserer informasjon fra flere kilder. Plattformen sporer bildesiteringer i visuelle søkeresultater, og sikrer at ditt visuelle innhold tilskrives korrekt og linker tilbake til ditt domene, noe som beskytter både din SEO-autoritet og merkevaresynlighet. Stemmesøk-omtaler overvåkes på tvers av smarthøyttalere og stemmeassistenter, og fanger opp hvordan innholdet ditt blir lest opp og presentert for brukere i stemmeførst-kontekster der tradisjonelle klikk-målinger ikke gjelder. Med AI-genererte søkeresultater som nå utgjør en betydelig andel av brukerinteraksjoner, er det kritisk å forstå synligheten i disse nye formatene—AmICited gir overvåkningsinfrastrukturen som trengs for å spore, måle og optimalisere tilstedeværelsen din på tvers av alle multimodale søkekanaler. For merkevarer som mener alvor med å opprettholde konkurransemessig synlighet i det AI-drevne søkelandskapet, er omfattende multimodal overvåkning gjennom plattformer som AmICited ikke lenger valgfritt, men essensielt for å forstå og beskytte din digitale tilstedeværelse.

Multimodalt AI-søk integrerer flere datatyper—tekst, bilder, stemme og video—i én samlet søkeopplevelse. Moderne søkesystemer benytter nå multimodale AI-modeller som kan analysere og sammenligne informasjon på tvers av ulike formater samtidig, noe som muliggjør mer kontekstuelle og nøyaktige resultater enn søk med kun én modalitet.

Optimaliser bilder ved å bruke høykvalitets, originale bilder med beskrivende filnavn og utfyllende alt-tekst. Implementer schema markup, legg til relevant kontekst i teksten rundt, vis flere vinkler av samme motiv, og komprimer filene for rask innlasting. Disse tiltakene sikrer synlighet både i tradisjonelt bildesøk og i multimodale AI-systemer.

Utvalgte utdrag er hovedkilden for svar i stemmesøk. Stemmeassistenter henter korte, direkte svar fra posisjon null-resultater på søkemotorenes resultatsider. Optimalisering av innhold for å vises i utvalgte utdrag er avgjørende for synlighet og rangering i stemmesøk.

Strukturer innholdet med spørsmål-baserte overskrifter som direkte adresserer vanlige stemmeforespørsler, etterfulgt av korte og presise svar. Bruk naturlig, samtalepreget språk og implementer strukturert datamarkering (FAQ-skjema, HowTo-skjema) for å hjelpe AI-systemer med å forstå innholdets samtaleform.

De viktigste multimodale modellene er GPT-4o (OpenAI), Gemini (Google), Claude 3.7 (Anthropic), LLaVA (åpen kildekode) og ImageBind (Meta). Hver har ulike egenskaper og bruksområder. Å forstå hvilke modeller som driver dine aktuelle søkeplattformer hjelper deg å optimalisere innholdet effektivt.

Følg med på visninger av utvalgte utdrag i Google Search Console, overvåk mobilengasjement, analyser trafikk fra stemmesøk separat fra tradisjonelt organisk søk, og mål konverteringsrater fra multimodale kilder. Overvåk merkevareomtaler i AI Overviews og se hvordan innholdet ditt vises på tvers av ulike modaliteter.

AmICited overvåker hvordan merkevaren din vises i AI Overviews, utvalgte utdrag, bildesøkeresultater og svar fra stemmesøk. Når AI-genererte søkeresultater blir dominerende, er grundig multimodal overvåkning avgjørende for å forstå og beskytte din digitale tilstedeværelse på alle søkekanaler.

Fremtiden innebærer stadig mer avanserte AI-systemer med agentiske egenskaper som kan utføre handlinger på vegne av brukeren, hyper-personaliserte resultater basert på preferanser og atferd, sanntids-søk for live-hendelser, og modne videosøkemuligheter. Merker som er optimalisert på alle modaliteter vil få konkurransefortrinn.

Følg med på hvordan merkevaren din vises i AI Overviews, bildesøkeresultater og svar fra stemmesøk. Få sanntidsinnsikt i din tilstedeværelse i multimodalt søk.

Lær hvordan multimodale AI-søkesystemer behandler tekst, bilder, lyd og video sammen for å levere mer nøyaktige og kontekstuelt relevante resultater enn AI-løsn...

Lær hva multimodalt innhold for KI er, hvordan det fungerer, og hvorfor det er viktig. Utforsk eksempler på multimodale KI-systemer og deres bruksområder på tve...

Lær hvordan du optimaliserer tekst, bilder og video for multimodale AI-systemer. Oppdag strategier for å forbedre AI-sitater og synlighet på tvers av ChatGPT, G...