Påvirker JavaScript AI-crawling? Innvirkning på synlighet i AI-søk

Lær hvordan JavaScript påvirker AI-crawleres synlighet. Oppdag hvorfor AI-boter ikke kan gjengi JavaScript, hvilket innhold som skjules, og hvordan du optimalis...

Lær hvordan prerendering gjør JavaScript-innhold synlig for AI-søkeboter som ChatGPT, Claude og Perplexity. Oppdag de beste tekniske løsningene for AI-søkeoptimalisering og forbedre synligheten din i AI-drevne søkeresultater.

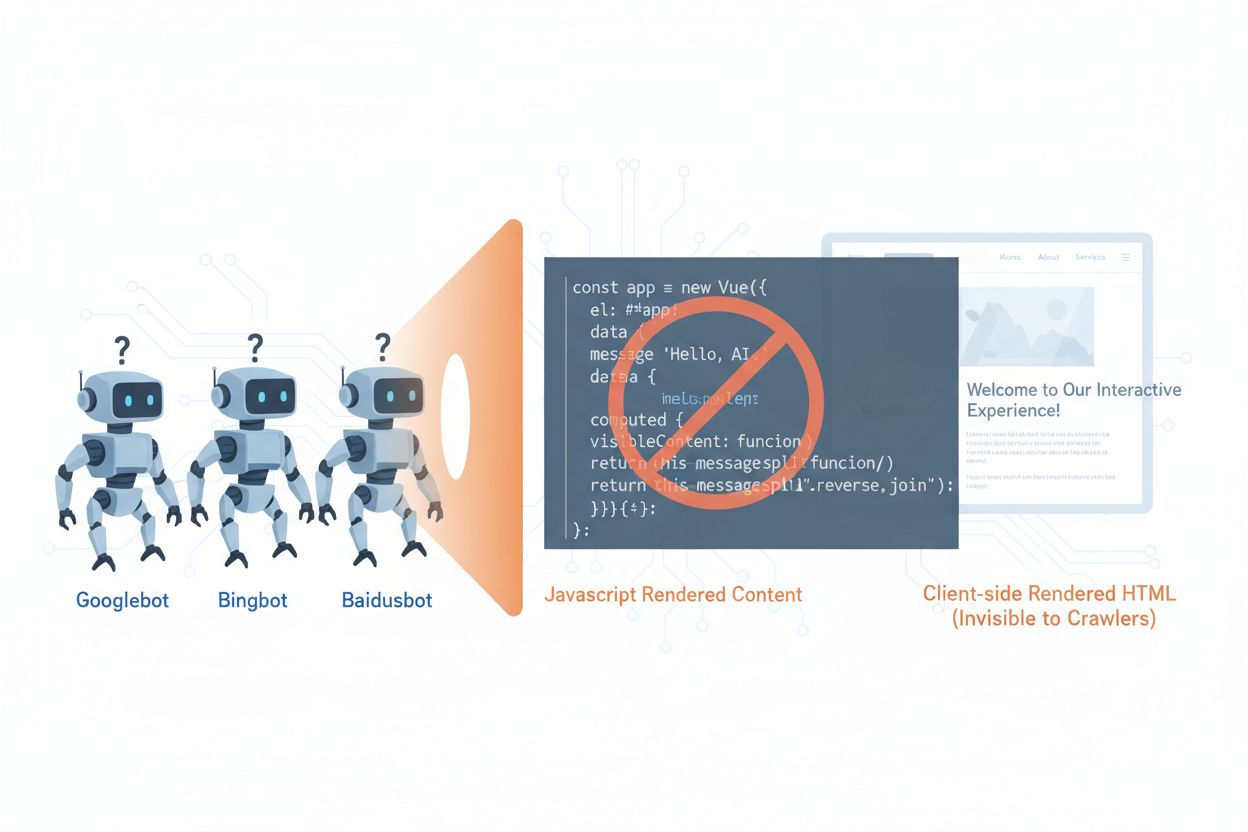

AI-crawlere som GPTBot, ClaudeBot og PerplexityBot har fundamentalt endret hvordan innhold oppdages og indekseres på nettet, men de står overfor en kritisk begrensning: de kan ikke kjøre JavaScript. Dette betyr at alt innhold som rendres dynamisk gjennom JavaScript—som driver moderne single-page applikasjoner (SPA), dynamiske produktsider og interaktive dashbord—forblir fullstendig usynlig for disse crawlerne. Ifølge nyere data utgjør AI-crawlere nå omtrent 28 % av Googlebot-trafikken, noe som gjør dem til en betydelig del av nettstedets crawl-budsjett og en avgjørende faktor for innholdstilgjengelighet. Når en AI-crawler ber om en side, mottar den det første HTML-skallet uten det rendrede innholdet, og ser i praksis en tom eller ufullstendig versjon av nettstedet ditt. Dette skaper et paradoks: Innholdet ditt er perfekt synlig for menneskelige brukere med JavaScript-aktiverte nettlesere, men usynlig for AI-systemene som i økende grad påvirker innholdsoppdagelse, oppsummering og rangering i AI-drevne søkemotorer og applikasjoner.

De tekniske årsakene bak AI-crawlernes JavaScript-begrensninger stammer fra grunnleggende arkitektoniske forskjeller mellom hvordan nettlesere og crawlere prosesserer nettinnhold. Nettlesere har en fullverdig JavaScript-motor som kjører kode, manipulerer DOM (Document Object Model) og rendrer det endelige visuelle resultatet, mens AI-crawlere vanligvis opererer med minimale eller ingen JavaScript-evner på grunn av ressursbegrensninger og sikkerhetshensyn. Asynkron lasting—hvor innhold hentes fra API-er etter initial sideinnlasting—gir en annen stor utfordring, ettersom crawlere kun mottar det første HTML-et før innholdet kommer. Single-page applikasjoner (SPA) forsterker dette problemet ved å bruke kun klient-side ruting og rendering, slik at crawlere kun ser en JavaScript-pakke. Slik sammenlignes ulike rendering-metoder når det gjelder synlighet for AI-crawlere:

| Rendering-metode | Hvordan det fungerer | AI-crawler synlighet | Ytelse | Kostnad |

|---|---|---|---|---|

| CSR (Client-Side Rendering) | Nettleseren kjører JavaScript for å rendre innhold | ❌ Dårlig | Rask for brukere | Lav infrastruktur |

| SSR (Server-Side Rendering) | Serveren rendrer HTML ved hver forespørsel | ✅ Utmerket | Tregere initialinnlasting | Høy infrastruktur |

| SSG (Static Site Generation) | Innhold forhåndsbygges ved bygging | ✅ Utmerket | Raskest | Middels (byggetid) |

| Prerendering | Statisk HTML caches ved behov | ✅ Utmerket | Rask | Middels (balansert) |

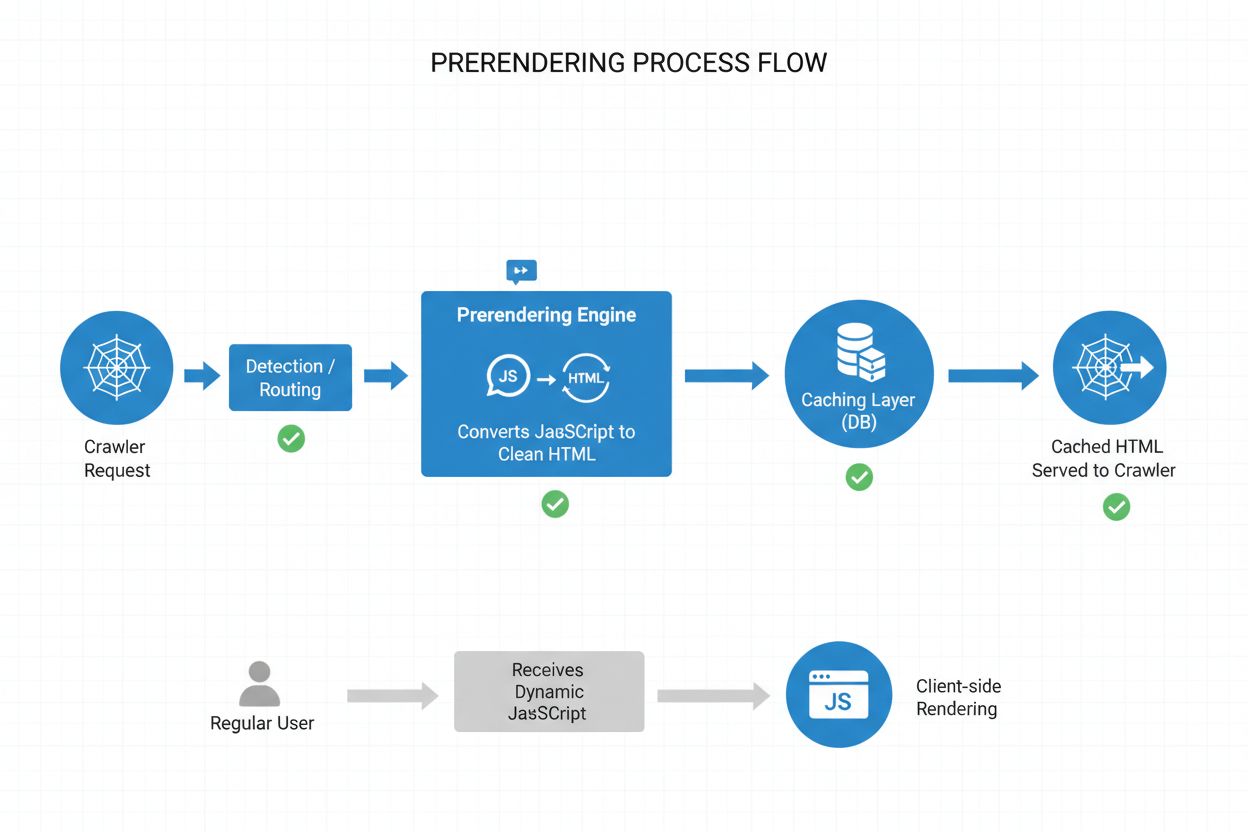

Prerendering tilbyr et elegant mellomnivå mellom ressurskrevende server-side rendering og begrensningene til statisk sidegenerering. I stedet for å rendre innhold ved hver forespørsel (SSR) eller ved bygging (SSG), genererer prerendering statiske HTML-øyeblikksbilder ved behov når en crawler eller bot ber om en side, og cacher deretter denne rendrende versjonen for senere forespørsler. Dette betyr at AI-crawlere mottar fullt rendret, statisk HTML med alt innhold vanligvis generert av JavaScript, mens vanlige brukere får den dynamiske, interaktive versjonen av nettstedet ditt uten endringer i opplevelsen. Prerendering er særlig kostnadseffektivt fordi det kun rendrer sider som faktisk etterspørres av crawlere, og unngår belastningen ved å forhåndsrendre hele nettstedet eller vedlikeholde dyr SSR-infrastruktur. Vedlikeholdsbyrden er minimal—applikasjonskoden din forblir uendret, og prerendering-laget kjører transparent i bakgrunnen, noe som gjør det til en ideell løsning for team som ønsker AI-crawler-tilgjengelighet uten arkitektoniske endringer.

Prerendering-prosessen følger en sofistikert, men enkel arbeidsflyt som sikrer at AI-crawlere får optimalisert innhold uten at brukere merker forskjell. Når en forespørsel kommer til serveren, oppdages brukeragenten for å identifisere om det er en AI-crawler (GPTBot, ClaudeBot, PerplexityBot) eller en vanlig nettleser. Hvis en AI-crawler oppdages, rutes forespørselen til prerendering-motoren, som starter en headless nettleser, kjører all JavaScript, venter på asynkront innhold, og genererer et komplett statisk HTML-øyeblikksbilde av siden. Denne HTML-en caches (typisk i 24–48 timer) og serveres direkte til crawleren, noe som omgår applikasjonen din og reduserer serverbelastning. Vanlige nettleserforespørsler omgår prerendering-laget fullstendig og mottar din dynamiske applikasjon som normalt, slik at brukerne får full interaktiv opplevelse med sanntidsoppdateringer og dynamisk funksjonalitet. Hele prosessen skjer transparent—crawlere ser ferdigrendret innhold, brukere ser applikasjonen uendret, og infrastrukturen din forblir effektiv fordi prerendering kun aktiveres for bot-trafikk.

Selv om både prerendering og server-side rendering (SSR) løser JavaScript-synlighetsproblemet, skiller de seg vesentlig i implementering, kostnad og skalerbarhet. SSR rendrer innhold ved hver enkelt forespørsel, noe som betyr at serveren må starte et JavaScript-miljø, kjøre hele applikasjonskoden og generere HTML for hver besøkende—en prosess som blir svært kostbar i stor skala og kan øke Time to First Byte (TTFB) for alle brukere. Prerendering, derimot, cacher rendrende sider og genererer dem kun på nytt når innholdet endres eller cachen utløper, noe som reduserer serverbelastning og forbedrer responstid for både crawlere og brukere. SSR gir mening for svært personlig innhold eller ofte oppdatert data hvor hver bruker trenger unik HTML, mens prerendering er best for innhold som er relativt statisk eller sjelden endres—produksjonssider, blogginnlegg, dokumentasjon og markedsføringsinnhold. Mange avanserte implementasjoner bruker en hybrid tilnærming: prerendering for AI-crawlere og statisk innhold, SSR for personlige brukeropplevelser, og klient-side rendering for interaktive funksjoner. Denne lagdelte strategien gir det beste fra alle verdener—utmerket AI-crawler-tilgjengelighet, rask ytelse for brukere og fornuftige infrastrukturkostnader.

Strukturert data i JSON-LD-format er avgjørende for å hjelpe AI-crawlere med å forstå betydningen og konteksten til innholdet ditt, men de fleste implementasjoner tar ikke høyde for AI-crawleres begrensninger. Når strukturert data injiseres via JavaScript—en vanlig praksis med Google Tag Manager og lignende tag-administrasjonssystemer—ser aldri AI-crawlere dataene fordi de ikke kjører JavaScript som lager disse datastrukturene. Det betyr at rich snippets, produktinformasjon, organisasjonsdetaljer og annen semantisk markup forblir usynlig for AI-systemer, selv om de er synlige for tradisjonelle søkemotorer som har utviklet støtte for JavaScript. Løsningen er enkel: sørg for at all kritisk strukturert data er tilstede i den serverrendrende HTML-en, ikke injisert via JavaScript. Dette kan bety å flytte JSON-LD-blokker fra tag manager inn i applikasjonens server-side mal, eller bruke prerendering for å fange JavaScript-injisert strukturert data og servere det som statisk HTML til crawlere. AI-crawlere er avhengige av strukturert data for å trekke ut fakta, relasjoner og entitetsinformasjon, så server-side strukturert data-implementering er essensielt for AI-drevne søkemotorer og integrasjon mot kunnskapsgrafer.

Å implementere prerendering krever en strategisk tilnærming som balanserer dekning, kostnad og vedlikehold. Følg disse stegene for å komme i gang:

Identifiser JavaScript-tunge sider: Kartlegg nettstedet ditt for sider der viktig innhold rendres via JavaScript—ofte SPA-er, dynamiske produktsider og interaktive dashbord. Bruk verktøy som Lighthouse eller manuell inspeksjon for å finne sider der initial HTML skiller seg mye fra den rendrede versjonen.

Velg en prerenderingstjeneste: Velg en prerendering-leverandør som Prerender.io, som håndterer headless rendering, caching og crawler-gjenkjenning. Evaluer basert på pris, cache-varighet, API-pålitelighet og støtte for din tech stack.

Konfigurer brukeragent-gjenkjenning: Sett opp serveren eller CDN-en din til å oppdage AI-crawler-brukeragenter (GPTBot, ClaudeBot, PerplexityBot, Bingbot, Googlebot) og rute dem til prerenderingstjenesten, mens vanlige nettlesere går igjennom som normalt.

Test og valider: Bruk verktøy som curl med egendefinerte brukeragenter for å verifisere at crawlere mottar ferdigrendret HTML. Test med faktiske AI-crawler-brukeragenter for å sikre at innhold og strukturert data er synlig.

Overvåk resultatene: Sett opp logging og analyse for å følge med på prerenderingens effektivitet, cache-treffrater og eventuelle rendering-feil. Overvåk dashbordet til prerenderingstjenesten for ytelsesmetrikker og feil.

Effektiv overvåking er avgjørende for å sikre at prerendering-implementeringen fortsetter å fungere og at AI-crawlere får tilgang til innholdet ditt. Logganalyse er ditt viktigste verktøy—gjennomgå serverlogger for forespørsler fra AI-crawler-brukeragenter, følg med på hvilke sider de besøker, og identifiser mønstre i crawl-oppførsel eller feil. De fleste prerenderingstjenester som Prerender.io tilbyr dashbord med cache-treffrater, rendering-suksess/feil-metikk og ytelsesstatistikk, slik at du kan følge med på hvor effektivt prerendret innhold blir servert. Viktige metrikker å følge er cache-treffrate (andel forespørsler fra cache), renderings-suksessrate (andel sider som rendres uten feil), gjennomsnittlig renderingstid og crawler-trafikkvolum. Sett opp varsler for rendering-feil eller uvanlige crawl-mønstre som kan indikere problemer med nettstedets JavaScript eller dynamiske innhold. Ved å korrelere prerendering-metrikker med AI-søkemotortrafikk og innholdssynlighet, kan du kvantifisere effekten av prerenderingen og finne optimaliseringsmuligheter.

Vellykket prerendering krever detaljfokus og kontinuerlig vedlikehold. Unngå disse vanlige fellene:

Ikke prerendre 404-sider: Konfigurer prerenderingstjenesten til å hoppe over sider som gir 404-status, siden caching av feilsider sløser ressurser og forvirrer crawlere om nettstedets struktur.

Sørg for at innholdet er ferskt: Sett passende cache-utløpstider ut fra hvor ofte innholdet endres. Trafikktunge sider med hyppige oppdateringer kan trenge 12–24 timers cache, mens statisk innhold kan bruke lengre varighet.

Overvåk kontinuerlig: Ikke sett opp prerendering og glem det. Sjekk regelmessig at sider rendres korrekt, at strukturert data er tilstede og at crawlere får forventet innhold.

Unngå cloaking: Server aldri annet innhold til crawlere enn til brukere—dette bryter søkemotorretningslinjer og undergraver tillit. Prerendering skal vise crawlere samme innhold som brukere ser, bare i statisk form.

Test med faktiske crawlere: Bruk ekte AI-crawler-brukeragenter i testingen, ikke bare generiske bot-identifikatorer. Ulike crawlere kan ha ulike rendering-krav eller begrensninger.

Hold innholdet oppdatert: Hvis prerendret innhold blir utdatert, vil crawlere indeksere feil informasjon. Implementer cache-invalideringsstrategier som oppdaterer prerendrede sider når innhold endres.

Viktigheten av AI-crawler-optimalisering vil bare øke etter hvert som disse systemene blir sentrale for innholdsoppdagelse og kunnskapsuttrekk. Selv om dagens AI-crawlere har begrenset JavaScript-støtte, antyder nye teknologier som Comet og Atlas-browsere at fremtidens crawlere kan få mer avanserte rendering-evner, selv om prerendering fortsatt vil være verdifullt for ytelse og pålitelighet. Ved å implementere prerendering nå, løser du ikke bare dagens AI-crawler-problem—du fremtidssikrer innholdet ditt mot endrede crawler-evner og sørger for at nettstedet ditt forblir tilgjengelig uansett hvordan AI-systemer utvikler seg. Sammenfallet mellom tradisjonell SEO og AI-crawler-optimalisering gjør at du må ha en helhetlig tilnærming: optimaliser både for brukere og AI-systemer, sørg for at innholdet er tilgjengelig i flere formater, og oppretthold fleksibilitet til å tilpasse deg i et skiftende landskap. Prerendering er en pragmatisk, skalerbar løsning som bygger broen mellom moderne JavaScript-tunge applikasjoner og tilgjengelighetskravene til AI-drevet søk og oppdagelse, og gjør det til en essensiell del av enhver fremtidsrettet SEO- og innholdsstrategi.

Prerendering genererer statiske HTML-øyeblikksbilder på forespørsel og cacher dem, mens server-side rendering (SSR) rendrer innhold ved hver eneste forespørsel. Prerendering er mer kostnadseffektivt og skalerbart for de fleste bruksområder, mens SSR er bedre for svært personlig eller ofte endrende innhold som krever unik HTML for hver bruker.

Nei, prerendering påvirker kun hvordan crawlere ser innholdet ditt. Vanlige brukere mottar fortsatt din dynamiske, interaktive JavaScript-applikasjon akkurat som før. Prerendering fungerer transparent i bakgrunnen og har ingen innvirkning på brukerrettet funksjonalitet eller ytelse.

Cache-utløpstider avhenger av hvor ofte innholdet ditt endres. Trafikktunge sider med hyppige oppdateringer kan trenge 12–24 timers cache-vinduer, mens statisk innhold kan bruke lengre varigheter. De fleste prerenderingstjenester lar deg konfigurere cache-tider per side eller mal.

Ja, prerendering fungerer godt med dynamisk innhold. Du kan sette kortere cache-utløpstider for sider som endres ofte, eller implementere cache-invalideringsstrategier som oppdaterer prerendrede sider når innholdet endres. Dette sikrer at crawlere alltid ser relativt ferskt innhold.

De viktigste AI-crawlerne å optimalisere for er GPTBot (ChatGPT), ClaudeBot (Claude) og PerplexityBot (Perplexity). Du bør også fortsette å optimalisere for tradisjonelle crawlere som Googlebot og Bingbot. De fleste prerenderingstjenester støtter konfigurasjon for alle større AI- og søkecrawlere.

Hvis du allerede bruker SSR, har du god tilgjengelighet for AI-crawlere. Likevel kan prerendering gi fordeler ved å redusere serverbelastning, forbedre ytelse og gi et cache-lag som gjør infrastrukturen din mer effektiv og skalerbar.

Overvåk dashbordet til prerenderingstjenesten din for cache-treffrater, rendering-suksessmetrikker og ytelsesstatistikk. Sjekk serverloggene dine for forespørsler fra AI-crawlere og verifiser at de mottar fullt rendret HTML. Følg endringer i AI-søkesynlighet og innholdssitater over tid.

Kostnader for prerendering varierer etter tjeneste og bruksvolum. De fleste tilbydere tilbyr prisnivåer basert på antall sider som rendres per måned. Kostnadene er vanligvis mye lavere enn å opprettholde infrastruktur for server-side rendering, noe som gjør prerendering til en kostnadseffektiv løsning for de fleste nettsteder.

Følg med på hvordan AI-plattformer som ChatGPT, Claude og Perplexity refererer til innholdet ditt med AmICited. Få sanntidsinnsikt i din AI-søkesynlighet og optimaliser innholdsstrategien din.

Lær hvordan JavaScript påvirker AI-crawleres synlighet. Oppdag hvorfor AI-boter ikke kan gjengi JavaScript, hvilket innhold som skjules, og hvordan du optimalis...

Lær hvordan JavaScript-rendering påvirker KI-synlighet. Oppdag hvorfor KI-crawlere ikke kan kjøre JavaScript, hvilket innhold som skjules, og hvordan prerenderi...

Oppdag hvordan SSR- og CSR-renderingsstrategier påvirker AI-crawler-synlighet, merkevaresiteringer i ChatGPT og Perplexity, og din totale AI-søkepresentasjon.