Regjeringens nettsiders AI-synlighet: Optimalisering i offentlig sektor

Lær hvordan offentlige etater kan optimalisere sin digitale tilstedeværelse for AI-systemer som ChatGPT og Perplexity. Oppdag strategier for å forbedre AI-synli...

Lær essensiell AI-åpenhet og beste praksis for merking. Oppdag atferdsmessige, verbale og tekniske merkingsmetoder for å bygge tillit og sikre samsvar med stadig strengere AI-regulering.

AI-åpenhet har blitt en avgjørende nødvendighet i en tid hvor kunstig intelligens påvirker alt fra innholdsproduksjon til ansettelsesbeslutninger og finansielle anbefalinger. Etter hvert som AI-generert innhold flommer over digitale plattformer, møter organisasjoner økende press for å opplyse når og hvordan de bruker disse teknologiene – ikke bare som et juridisk krav, men som en grunnleggende forutsetning for å opprettholde tillit og troverdighet hos sitt publikum. Innsatsen er spesielt høy for merkevarer og innholdsskapere, ettersom forbrukerne i økende grad krever å vite om informasjonen de får kommer fra menneskelig ekspertise eller er algoritmisk generert. Uten transparente merkingsrutiner risikerer organisasjoner å undergrave den tilliten de har brukt år på å bygge opp, og kan møte både omdømmeskade, regulatoriske sanksjoner og tap av publikums tillit. Forholdet mellom åpenhet og troverdighet er gjensidig – organisasjoner som proaktivt opplyser om sin AI-bruk viser integritet og respekt for sine interessenter, og posisjonerer seg som ærlige aktører i et stadig mer AI-drevet landskap.

Spredningen av AI-generert innhold har skapt et dyptgående tillitsparadoks: publikum sliter med å skille mellom ekte, menneskeskapt arbeid og sofistikerte AI-genererte alternativer, samtidig som åpenheten rundt AI-bruk er inkonsekvent på tvers av bransjer. Denne uklarheten undergraver den grunnleggende kontrakten mellom skaper og mottaker, der publikum forventer å vite det reelle opphavet til innholdet de møter. Når AI-generert innhold presenteres uten merking, bryter det denne underforståtte avtalen og skaper et “ekte vs. falskt”-skille som handler om mer enn bare autentisitet – det berører spørsmål om bedrag, manipulasjon og informert samtykke. Paradokset forsterkes fordi noe AI-generert innhold kan være umulig å skille fra menneskearbeid i kvalitet og stil, slik at visuelle eller stilistiske kjennetegn blir upålitelige indikatorer. Åpenhet er viktig nettopp fordi den løser dette paradokset ved å gi publikum informasjonen de trenger for å gjøre informerte valg om hvilket innhold de kan stole på. Organisasjoner som har en tydelig merkingspraksis, snur skepsis til tillit og viser at de ikke har noe å skjule – og alt å vinne på ærlig kommunikasjon.

Regelverket rundt AI-merking er i rask utvikling, med flere jurisdiksjoner som har innført eller foreslått krav som organisasjoner må forholde seg nøye til. EU AI Act, et av verdens mest omfattende rammeverk, krever at AI-generert eller tungt AI-redigert innhold skal ha synlig eller metadata-basert merking, med særskilte krav for høyrisikosystemer og åpenhetsforpliktelser for utviklere. I USA har FTC advart om at unnlatelse av å oppdatere bruksvilkår og personvernerklæringer ved AI-bruk kan regnes som villedende praksis, mens delstatslover – særlig Californias nye AI frontier model disclosure law – medfører skjerpede krav til åpenhet og rapportering for utviklere av store AI-systemer. Opphavsrett og immaterielle rettigheter gir ytterligere kompleksitet, ettersom organisasjoner må opplyse om treningsdata inneholdt opphavsrettslig beskyttet materiale, og hvordan AI-systemene er trent. Videre gjelder GDPR og CCPA for AI-systemer som behandler personopplysninger, og krever at organisasjoner opplyser om automatiserte avgjørelser og gir enkeltpersoner meningsfull informasjon om AI-behandling. Tabellen under oppsummerer sentrale regulatoriske krav i viktige jurisdiksjoner:

| Jurisdiksjon | Regulering | Hovedkrav | Ikrafttredelse |

|---|---|---|---|

| EU | EU AI Act | Merking for høyrisiko AI; åpenhetsrapporter; metadata-merking for AI-generert innhold | Trinnvis (2024-2026) |

| USA (føderalt) | FTC-retningslinjer | Oppdater personvernregler; opplys om AI-bruk; unngå villedende praksis | Løpende |

| California | AI Frontier Model Law | Standardisert merking; rapporteringsplikt; sikkerhetstiltak | 2025 |

| EU | GDPR | Opplys om automatiserte avgjørelser; gi informasjon om AI-behandling | Løpende |

| USA (flere delstater) | CCPA og lignende | Opplys om databruk i AI-systemer; gi reservasjonsmuligheter | Varierer etter delstat |

| Internasjonalt | Opphavsrett | Opplys om kilde til treningsdata; håndter opphavsrett i AI-utdata | Under utvikling |

Organisasjoner som opererer på tvers av flere jurisdiksjoner bør implementere merkingsrutiner som tilfredsstiller de strengeste kravene, da samsvar med én standard ofte overgår minimumskravene i andre.

Atferdssignaler er den mest subtile, men kraftfulle formen for AI-merking, og virker gjennom presentasjon, stil, stemme og kreative valg som publikum ubevisst vurderer når de skal avgjøre innholdets ekthet. Slike signaler kan være karakteristiske mønstre i skrivestil, stemmekonsistens, visuell komposisjon, avatar- eller personatrekk, og det overordnede “fidelity”-nivået i skaperrepresentasjonen – altså hvor mye innholdet reflekterer ekte menneskelig personlighet og valg. For eksempel har AI-generert tekst ofte bestemte mønstre i setningsoppbygging, ordvalg og logikk som skiller seg fra menneskelig skriving, mens AI-genererte bilder kan ha subtile avvik i lyssetting, anatomi eller bakgrunnsdetaljer som trenede øyne kan oppdage. Konseptet skaper-fidelity står sentralt: publikum utvikler forventninger til hvordan en skaper skal uttrykke seg, og avvik fra dette kan signalisere AI-involvering. Men kun å stole på atferdssignaler er problematisk, fordi AI stadig blir bedre til å etterligne mennesker, og publikum kan ikke forventes å bli AI-forensikere. Derfor bør atferdssignaler supplere – ikke erstatte – eksplisitt merking, og være et sekundært lag med åpenhet som forsterker, ikke erstatter, tydelig kommunikasjon om AI-bruk.

Verbale merkingsstrategier gir eksplisitt, tydelig informasjon om AI-bruk gjennom språkbaserte signaler, slik at det ikke hersker tvil om innholdets opphav eller AI-involvering. Disse metodene er essensielle fordi de gir et klart, dokumentert spor av merking og sikrer at publikum får utvetydig informasjon om AI-bruk. Organisasjoner kan bruke flere utfyllende verbale merkingsmetoder:

Hvilken metode som passer best, avhenger av konteksten: etiketter egner seg for sosiale medier og visuelle flater, vannmerker for video og lyd, bylines for journalistikk og kreative verk, merkingsfelt for lengre innhold, og erklæringer for komplekse prosjekter. Organisasjoner bør velge merkingsmetoder som passer formatet og publikums forventninger, og sørge for at merkingen er umulig å overse uten å forstyrre brukeropplevelsen.

Tekniske signaler og metadata gir maskinlesbar, standardisert informasjon om AI-involvering, som muliggjør automatisk gjenkjenning, verifisering og sporing av AI-generert innhold på tvers av digitale økosystemer. Dette skjer gjennom innebygde data og kryptografiske teknikker som skaper permanente, manipulasjonssikre spor av innholdets opprinnelse og behandlingshistorikk. IPTC-standardene, nylig oppdatert med AI-spesifikke metadata-egenskaper, lar skapere legge inn strukturert informasjon om AI-bruk direkte i bildefiler – inkludert hvilke AI-systemer som er brukt, hvilken prosessering som er gjort og hvilke menneskelige endringer som er utført. C2PA (Coalition for Content Provenance and Authenticity) er en fremvoksende bransjestandard som bruker kryptografiske signaturer og innholdskredentialer for å etablere verifiserbare beviskjeder for digitalt innhold, slik at publikum kan spore innholdet tilbake til opphavet og se alle endringer. Disse tekniske tilnærmingene løser en viktig svakhet ved menneskelesbar merking: de skaper permanente, verifiserbare spor som ikke enkelt kan fjernes eller endres, og gjør det mulig for automatiserte systemer å identifisere og merke AI-generert innhold i stor skala. Organisasjoner bør vurdere å bruke C2PA-sertifikater for verdifullt innhold, bygge inn IPTC-metadata i bilder og mediefiler, og holde detaljert dokumentasjon av digital kilde-type som følger AI-involveringen gjennom hele innholdsprosessen. Fordelen med tekniske signaler er deres varighet og verifiserbarhet; utfordringen er å sikre at brukere og plattformer forstår og respekterer signalene.

Vellykket AI-merking krever at åpenhetspraksis blir en integrert del av innholdsproduksjonen, slik at merking ikke blir en ettertanke, men en grunnleggende del av innholdsstyringen. Organisasjoner bør innføre strukturerte innholdsrammeverk som fanger AI-involvering i alle ledd – fra research og utkast til redigering og publisering – slik at merkingsinformasjon flyter naturlig gjennom innholdsstyringssystemene. Automatisering og arbeidsflytintegrasjon er avgjørende: publiseringssystemer bør ha obligatoriske felt for AI-merking, automatiske påminnelser om å dokumentere AI-bruk før publisering, og godkjenningsrutiner som sjekker at merkingen er fullført før innholdet går live. Slik blir merking en kvalitetskontroll, ikke et valgfritt tillegg – på linje med faktasjekk, juridisk vurdering eller merkevarekontroll. Organisasjoner må også etablere klare retningslinjer for hva som regnes som AI-bruk som krever merking (f.eks. må bruk av AI til research merkes? Hva med AI-basert redigering?), slik at det er konsekvens på tvers av team og ingen hull i merkingen. Opplæring og dokumentasjon er like viktig: innholdsskapere trenger tydelig veiledning om hvordan de skal merke AI-bruk for ulike innholdstyper og plattformer. Ved å bygge merking inn i innholdsmodeller og arbeidsflyter, gjør organisasjoner åpenhet til normal praksis som beskytter både dem selv og publikum.

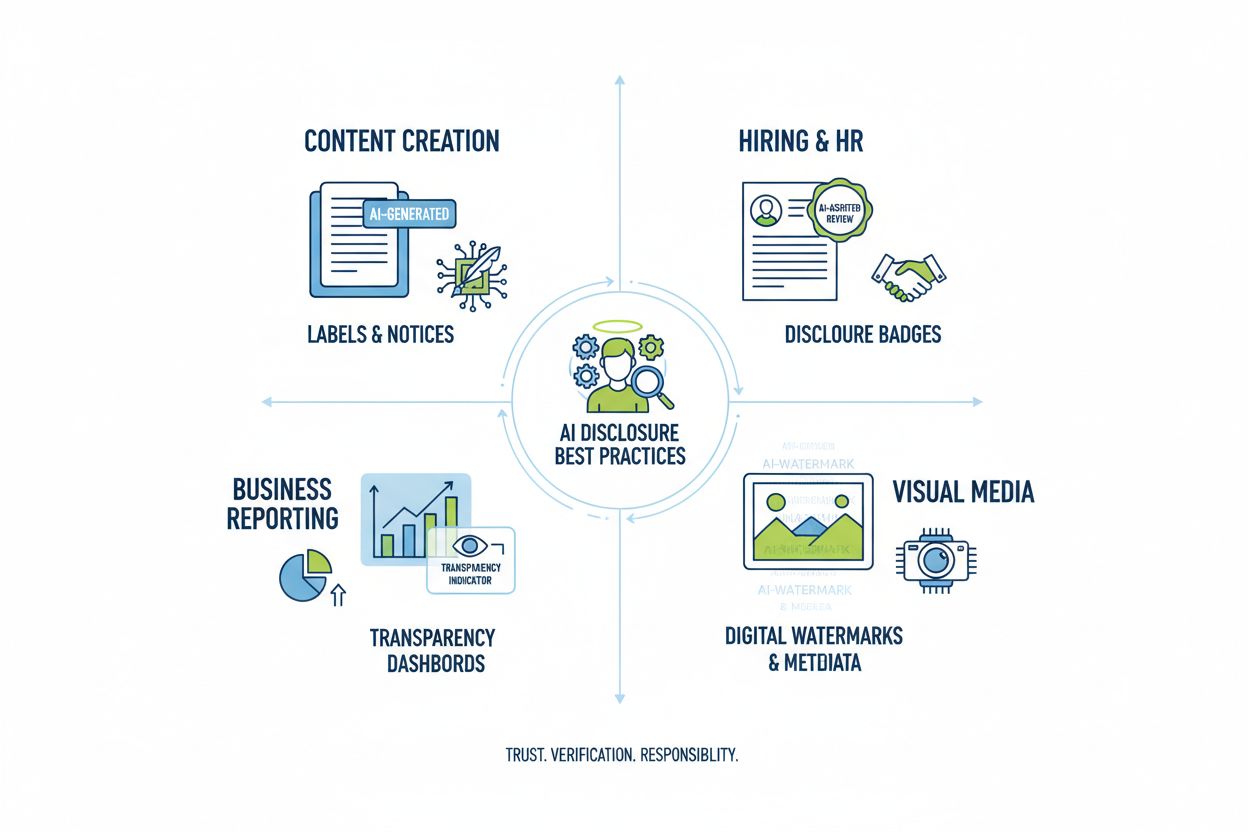

Ulike AI-bruksområder krever tilpassede merkingsstrategier ut fra kontekst, publikumsforventninger og regulatoriske krav. Innholdsproduksjon (artikler, sosiale medier, markedsføring) bør ha tydelige etiketter eller bylines som markerer AI-involvering, samt merkingsfelt som forklarer hvilke AI-verktøy som er brukt og hvilken menneskelig kontroll som er utført – spesielt viktig i nyheter og redaksjonelt stoff der tillit avhenger av å vite innholdets opphav. Rekruttering og ansettelser krever strengest merking, fordi kandidater har rett til å vite når AI vurderer søknader eller gjør førstesiling, med detaljerte forklaringer på hvordan AI avgjør og hvilken menneskelig vurdering som følger. Rapportering og analyse (finansrapporter, markedsundersøkelser, dataanalyse) bør ha teknisk merking og metadata som viser hvilke analyser som er AI-assisterte – særlig hvis AI har identifisert mønstre eller generert innsikter som påvirker konklusjoner. Visuelt innhold (bilder, video, grafikk) må ha både vannmerker og metadata, fordi publikum ikke kan skille AI-genererte bilder fra ekte – dette er kritisk for nyhetsfoto, produktbilder og innhold der ekthet påvirker kjøp eller tillit. Kundekommunikasjon (chatbots, automatiske svar, kundeservice) bør tydelig opplyse om AI-involvering fra starten, slik at brukeren kan be om menneskelig hjelp hvis ønskelig. Organisasjoner bør kartlegge all AI-bruk og tilpasse merkingspraksis til hvor sensitivt og innflytelsesrikt bruksområdet er, siden åpenhetskravene varierer etter hvordan AI-beslutninger påvirker publikum.

Fremtidens AI-merking avhenger av bransjeomfattende standardisering og utvikling av rammeverk som gjør åpenheten konsistent og sammenlignbar på tvers av organisasjoner og plattformer. Fremvoksende standarder som C2PA, IPTCs metadata-spesifikasjoner og NISTs AI Risk Management Framework gir grunnlaget, men bred innføring krever koordinert innsats fra teknologiplattformer, innholdsskapere, myndigheter og bransjeorganisasjoner. EU AI Act og lignende reguleringer driver standardisering gjennom å kreve bestemte merkingsformater og informasjonskategorier, noe som presser bransjen mot felles standarder fremfor hver sin løsning. Bransjeinitiativ som PRSAs etiske AI-retningslinjer og ulike åpenhetsrammeverk viser økende enighet om beste praksis, selv om frivillig bruk fortsatt er ujevn. Det kritiske neste steget er å gå fra frivillige standarder til regulatoriske krav om standardisert merking, på samme måte som FDA-merking har standardisert matopplysninger. Overvåkings- og synlighetsplattformer – som AmICited.com – får stadig viktigere rolle ved å følge med på hvordan AI refererer til merkevarer og innhold i AI-genererte svar, og gir organisasjoner oversikt over hvordan deres arbeid vises og om korrekt attribusjon og merking skjer. Etter hvert som AI-systemer blir mer avanserte og allestedsnærværende, blir evnen til å overvåke, verifisere og revidere merkingsrutiner avgjørende for å opprettholde tillit i digitale informasjonssamfunn. Organisasjoner som investerer i robuste merkingsrutiner og overvåking i dag, vil stå sterkest i møte med fremtidens regulering og sikre publikums tillit i et AI-drevet samfunn.

Atferdsmessig merking bruker presentasjonsvalg (stil, stemme, avatar) for å signalisere AI-involvering. Verbal merking bruker eksplisitte utsagn, etiketter og vannmerker. Teknisk merking legger inn maskinlesbar metadata og kryptografiske signaturer. Hver metode tjener ulike målgrupper og kontekster, og organisasjoner bør bruke flere metoder sammen for helhetlig åpenhet.

Juridiske krav varierer mellom jurisdiksjoner. EUs AI Act krever merking for høyrisiko AI-systemer. FTC krever merking når AI-bruk kan påvirke forbrukerbeslutninger. Delstatslover som Californias AI Frontier Model Law pålegger rapporteringsplikter. Opphavsrettslovgivning krever merking av AI-generert innhold. Organisasjoner bør rådføre seg med juridiske eksperter for jurisdiksjonsspesifikke krav.

AI-genererte bilder bør inneholde både visuelle vannmerker og metadata-merking. Visuelle vannmerker bør være synlige, men ikke påtrengende, og tydelig indikere AI-generering. Metadata bør inkludere IPTC digital kilde-type-informasjon og C2PA-sertifikater når tilgjengelig. Bildetekster og merkingsfelt bør eksplisitt angi at bilder er AI-generert, spesielt for nyheter, produkt- eller reklameinnhold.

IPTC-standarder gir strukturerte metadatafelt for å dokumentere AI-bruk i bilder og mediefiler. De muliggjør automatisk gjenkjenning og sporing av AI-generert innhold på tvers av plattformer. IPTCs digitale kilde-type-kategorier inkluderer 'Trained Algorithmic Media', 'Composite Synthetic' og 'Algorithmic Media'. Disse standardene er viktige fordi de skaper permanente, verifiserbare spor av AI-involvering som ikke enkelt kan fjernes eller endres.

Selskaper bør gjennomføre en AI-revisjon for å identifisere alle AI-bruksområder, implementere merkingspolicyer i tråd med gjeldende regler, integrere merking i innholdsstyringsrutiner, trene team på merkingskrav og overvåke samsvar jevnlig. Rådføring med juridiske eksperter med kjennskap til AI-reguleringer i din jurisdiksjon er avgjørende, da kravene varierer betydelig mellom regioner.

Konsekvenser inkluderer regulatoriske sanksjoner (FTC-bøter, brudd på delstatslover), omdømmetap og tap av publikums tillit, juridisk ansvar for opphavsrettsbrudd eller villedende praksis, og potensielle søksmål fra berørte parter. Organisasjoner som unnlater å merke AI-bruk risikerer å undergrave troverdigheten de har brukt år på å bygge opp, noe som gjør proaktiv merking til en strategisk investering i langsiktig tillit.

Ulike interessenter trenger ulikt informasjonsnivå. Generelle brukere trenger enkle, tydelige utsagn om AI-involvering. Tilsynsmyndigheter trenger detaljert teknisk dokumentasjon og bevis på samsvar. Journalister og innholdsskapere trenger spesifikk informasjon om AI-verktøy og menneskelig kontroll. Kunder må forstå hvordan AI påvirker deres opplevelse. Tilpass merkingsformat og detaljer til hver målgruppes behov og forventninger.

C2PA (Coalition for Content Provenance and Authenticity) gir kryptografiske sertifikater for innholdsverifisering. IPTC-standarder muliggjør innbygging av metadata i bilder. Innholdsstyringssystemer får i økende grad egne felt for AI-merking. Overvåkingsplattformer som AmICited.com følger AI-referanser og synlighet. Bransjerammeverk fra PRSA, NIST og andre gir veiledning. Bruken av slike verktøy og standarder øker etter hvert som reguleringene strammes inn.

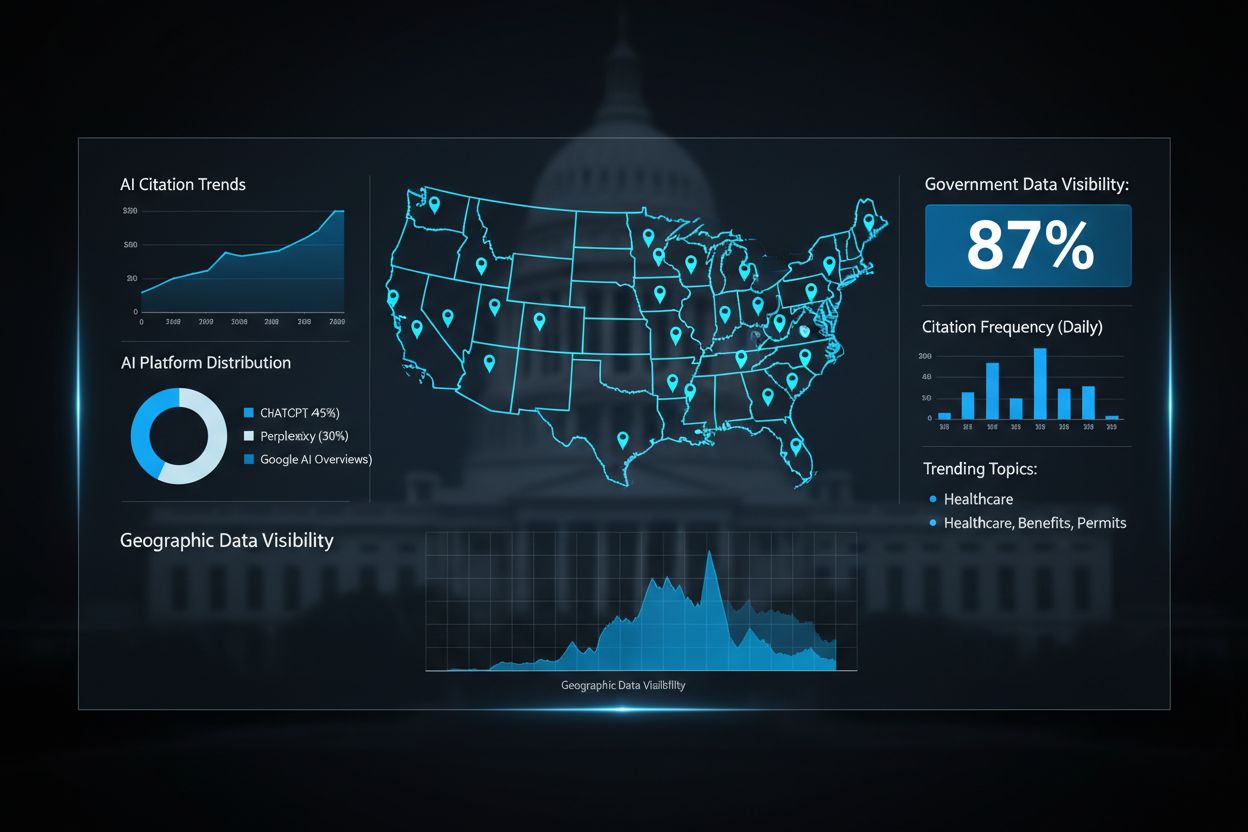

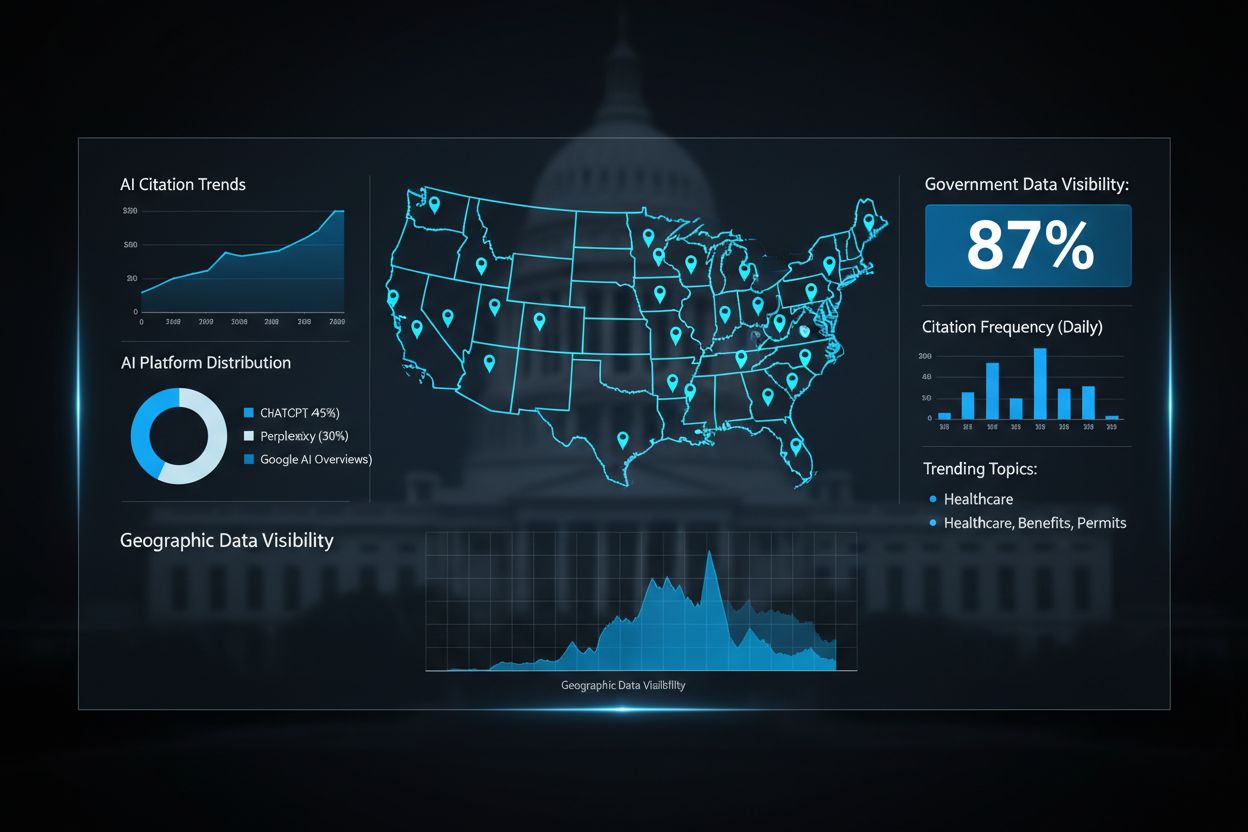

Følg med på hvordan AI-systemer refererer til ditt merke på GPT-er, Perplexity og Google AI Overviews. Sørg for at innholdet ditt får korrekt attribusjon og synlighet i AI-genererte svar.

Lær hvordan offentlige etater kan optimalisere sin digitale tilstedeværelse for AI-systemer som ChatGPT og Perplexity. Oppdag strategier for å forbedre AI-synli...

Lær hvordan du velger riktig AI-synlighetsovervåkingsplattform for din merkevare. Sammenlign funksjoner, priser og muligheter for å spore din tilstedeværelse i ...

Lær å oppdage AI-synlighetskriser tidlig med sanntidsovervåking, sentimentanalyse og avviksdeteksjon. Oppdag varselsignaler og beste praksis for å beskytte ditt...