Hva er crawl-budsjett for AI? Forstå AI-botenes ressursallokering

Lær hva crawl-budsjett for AI betyr, hvordan det skiller seg fra tradisjonelle søkemotorers crawl-budsjett, og hvorfor det er viktig for merkevarens synlighet i...

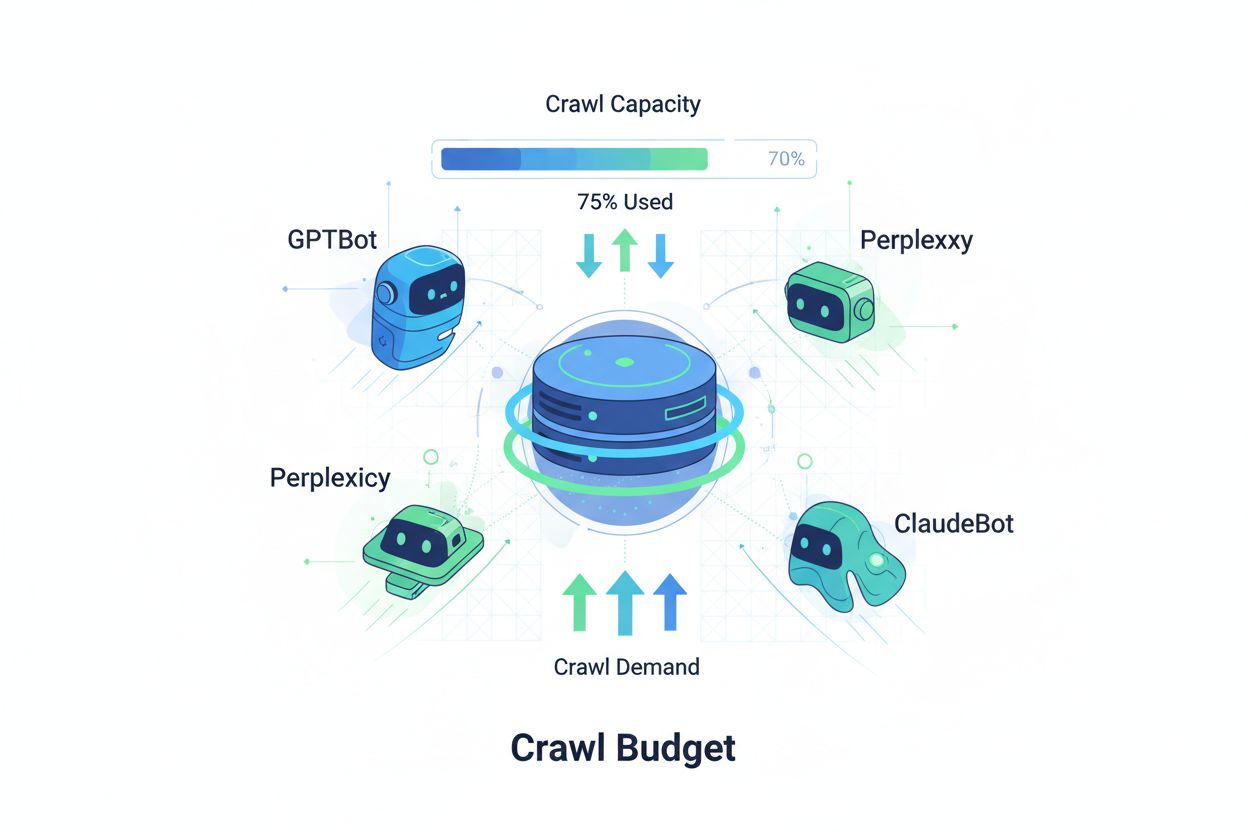

Teknikker for å sikre at KI-crawlere effektivt får tilgang til og indekserer det viktigste innholdet på et nettsted innenfor deres crawl-grenser. Optimalisering av crawl-budsjett balanserer mellom crawl-kapasitet (serverressurser) og crawl-etterspørsel (bot-forespørsler) for å maksimere synlighet i KI-genererte svar, samtidig som driftskostnader og serverbelastning kontrolleres.

Teknikker for å sikre at KI-crawlere effektivt får tilgang til og indekserer det viktigste innholdet på et nettsted innenfor deres crawl-grenser. Optimalisering av crawl-budsjett balanserer mellom crawl-kapasitet (serverressurser) og crawl-etterspørsel (bot-forespørsler) for å maksimere synlighet i KI-genererte svar, samtidig som driftskostnader og serverbelastning kontrolleres.

Crawl-budsjett refererer til mengden ressurser—målt i forespørsler og båndbredde—som søkemotorer og KI-boter tildeler til å crawle nettstedet ditt. Tradisjonelt gjaldt dette konseptet primært Googles crawl-adferd, men fremveksten av KI-drevne boter har fundamentalt endret hvordan organisasjoner må tenke rundt styring av crawl-budsjett. Crawl-budsjett-ligningen består av to kritiske variabler: crawl-kapasitet (maksimalt antall sider en bot kan crawle) og crawl-etterspørsel (det faktiske antallet sider boten ønsker å crawle). I KI-æraen har dette blitt eksponentielt mer komplekst, ettersom boter som GPTBot (OpenAI), Perplexity Bot og ClaudeBot (Anthropic) nå konkurrerer om serverressurser sammen med tradisjonelle søkemotorcrawlere. Disse KI-botene opererer med andre prioriteringer og mønstre enn Googlebot, og bruker ofte betydelig mer båndbredde mens de forfølger andre indekseringsmål. Dette gjør optimalisering av crawl-budsjettet ikke bare nyttig, men essensielt for å opprettholde nettstedets ytelse og kontrollere driftskostnader.

KI-crawlere skiller seg grunnleggende fra tradisjonelle søkemotorboter i crawlemønster, frekvens og ressursforbruk. Mens Googlebot respekterer crawl-budsjettgrenser og bruker avanserte strupemekanismer, utviser KI-boter ofte mer aggressiv crawling—de kan be om det samme innholdet flere ganger og tar mindre hensyn til serverbelastningssignaler. Forskning viser at OpenAI’s GPTBot kan bruke 12–15 ganger mer båndbredde enn Googles crawler på enkelte nettsteder, særlig der det er store innholdsbiblioteker eller hyppig oppdaterte sider. Denne aggressive tilnærmingen skyldes KI-modellenes treningsbehov—de må kontinuerlig innta ferskt innhold for å forbedre modellens ytelse, noe som gir en helt annen crawler-filosofi enn søkemotorer som fokuserer på indeksering for gjenfinning. Serverpåvirkningen er betydelig: organisasjoner rapporterer store økninger i båndbreddekostnader, CPU-bruk og serverbelastning direkte knyttet til KI-bottrafikk. I tillegg kan den samlede effekten av flere KI-boter som crawler samtidig, forringe brukeropplevelsen, gjøre lastetider tregere og øke hostingkostnader. Dette gjør skillet mellom tradisjonelle og KI-crawlere til en sentral forretningsbeslutning, ikke bare en teknisk kuriositet.

| Karakteristikk | Tradisjonelle crawlere (Googlebot) | KI-crawlere (GPTBot, ClaudeBot) |

|---|---|---|

| Crawl-frekvens | Adaptiv, respekterer crawl-budsjett | Aggressiv, kontinuerlig |

| Båndbreddeforbruk | Moderat, optimalisert | Høyt, ressurskrevende |

| Respekt for robots.txt | Streng etterlevelse | Variabel etterlevelse |

| Caching-adferd | Sofistikert caching | Hyppige gjentatte forespørsler |

| User-agent-identifikasjon | Klar, konsekvent | Noen ganger skjult |

| Forretningsmål | Søkeindeksering | Modelltrening/datainnhenting |

| Kostnadseffekt | Minimal | Betydelig (12–15x høyere) |

For å forstå crawl-budsjett må du mestre de to grunnpilarene: crawl-kapasitet og crawl-etterspørsel. Crawl-kapasitet er det maksimale antall URL-er serveren din kan håndtere å bli crawlet på innenfor en gitt tidsramme, og bestemmes av flere faktorer:

Crawl-etterspørsel er derimot hvor mange sider botene faktisk ønsker å crawle, drevet av innholdsegenskaper og bot-prioriteringer. Forhold som påvirker crawl-etterspørsel:

Optimaliseringsutfordringen oppstår når crawl-etterspørselen overstiger crawl-kapasiteten—botene må velge hvilke sider de skal crawle og kan gå glipp av viktige oppdateringer. Omvendt, hvis crawl-kapasiteten langt overgår etterspørselen, sløser du med serverressurser. Målet er crawl-effektivitet: maksimere crawling av viktige sider og minimere sløsing på sider med lav verdi. Denne balansen er stadig mer kompleks i KI-tiden, hvor flere bot-typer med ulike prioriteringer konkurrerer om de samme serverressursene, og det kreves sofistikerte strategier for å fordele crawl-budsjettet effektivt.

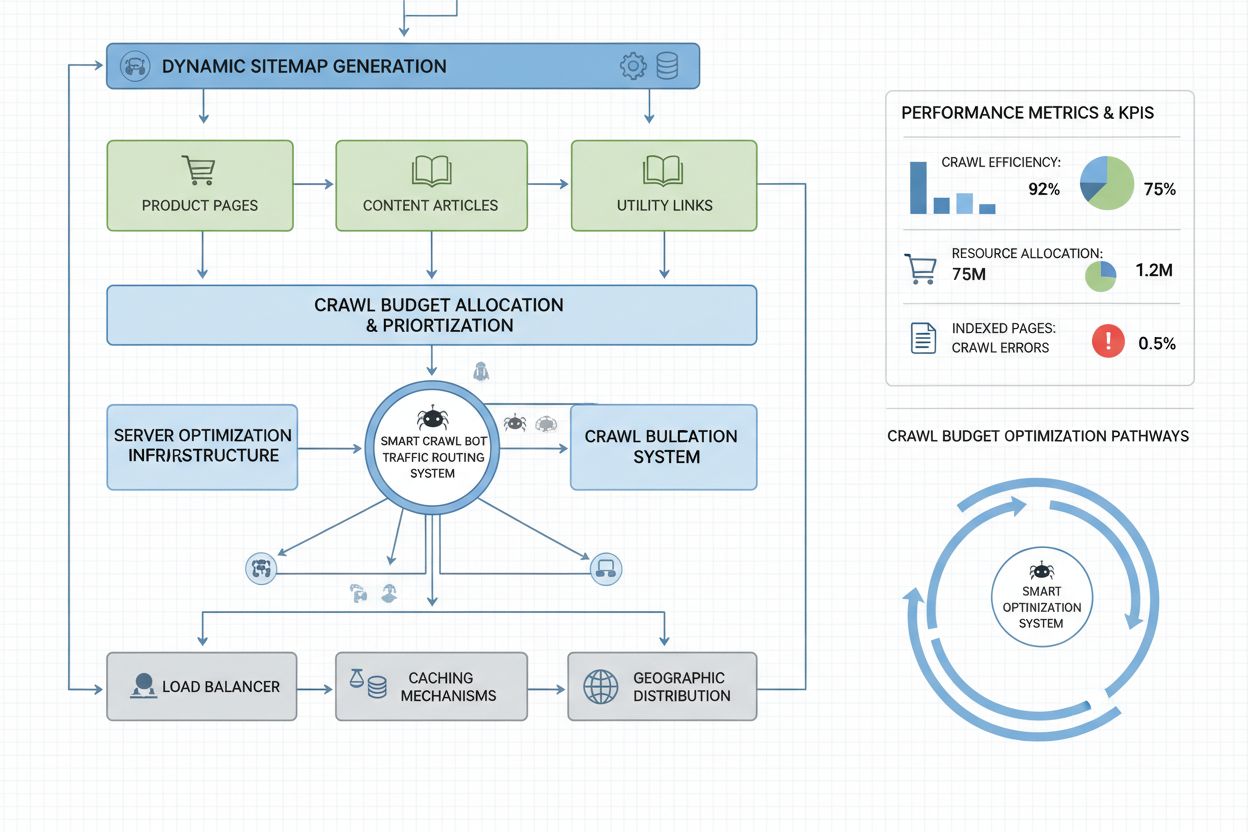

Måling av crawl-budsjett starter med Google Search Console, som gir crawl-statistikk under “Innstillinger” og viser daglige crawl-forespørsler, nedlastede byte og responstid. For å beregne crawl-effektivitetsforholdet deler du antallet vellykkede crawls (HTTP 200-responser) på totalt antall crawl-forespørsler—sunne nettsteder oppnår vanligvis 85–95 % effektivitet. Formel for grunnleggende crawl-effektivitet: (Vellykkede crawls ÷ Totalt antall crawl-forespørsler) × 100 = Crawl-effektivitet %. I tillegg til Googles data kreves praktisk overvåkning:

For KI-crawlere er verktøy som AmICited.com spesiallaget for å spore GPTBot, ClaudeBot og Perplexity Bot og gir innsikt i hvilke sider disse prioriterer og hvor ofte de returnerer. I tillegg gir egne varsler for uvanlige crawl-topper—særlig fra KI-boter—rask respons på uventet ressursbruk. Nøkkelverdien å følge er crawl-kostnad per side: delte totale serverressurser brukt på crawling på antall unike sider crawlet, så ser du om crawl-budsjettet brukes effektivt eller sløses på sider med lav verdi.

Optimalisering av crawl-budsjett for KI-boter krever en flerlags tilnærming med både teknisk implementering og strategiske valg. Sentrale optimaliseringstiltak:

Valget av taktikk avhenger av forretningsmodell og innholdsstrategi. Nettbutikker kan blokkere KI-crawlere fra produktsider for å hindre at konkurrenter bruker informasjonen til trening, mens innholdspublisister ofte tillater crawling for å få synlighet i KI-genererte svar. For nettsteder som virkelig opplever serverbelastning fra KI-bottrafikk, er user-agent-spesifikk blokkering i robots.txt den mest direkte løsningen: User-agent: GPTBot etterfulgt av Disallow: / hindrer OpenAI sin crawler i å få tilgang til nettstedet. Men dette gir også tap av synlighet i ChatGPT-svar og andre KI-applikasjoner. En mer nyansert strategi er selektiv blokkering: tillat KI-crawlere tilgang til offentlig innhold, men blokker dem fra sensitive områder, arkiver eller duplikatinnhold som sløser crawl-budsjett.

Nettsteder i enterprise-klassen med millioner av sider trenger avanserte strategier utover enkel robots.txt-konfigurering. Dynamiske sitemaps er en viktig utvikling, der sitemaps genereres i sanntid basert på innholdets ferskhet, viktighets-score og crawl-historikk. I stedet for statiske XML-sitemaps som lister alle sider, prioriterer dynamiske sitemaps nylig oppdaterte sider, sider med høy trafikk og konverteringspotensial, slik at botene bruker crawl-budsjettet på det innholdet som betyr mest. URL-segmentering deler nettstedet inn i logiske crawl-soner med separate optimaliseringsstrategier—nyhetsseksjoner kan ha aggressive sitemap-oppdateringer for å sikre at daglig innhold crawles med én gang, mens evergreen-innhold får sjeldnere oppdateringer.

Server-side optimalisering innebærer f.eks. crawl-bevisste caching-strategier som gir bufrede svar til botene, mens brukere får ferskt innhold—dette reduserer belastningen fra gjentatte botforespørsler. Content delivery networks (CDN) med bot-spesifikk ruting kan separere bot-trafikk fra brukere, slik at crawlere ikke bruker båndbredde som reelt burde gå til besøkende. Rate limiting per user-agent lar serveren strupe forespørsler fra KI-boter, men holde hastigheten opp for Googlebot og brukere. For virkelig store aktører gir distribuert crawl-budsjettstyring over flere serverregioner redundans og geografisk balansering av bot-trafikk. Maskinlæringsbasert crawl-prediksjon analyserer historiske crawlemønstre for å forutsi hvilke sider botene vil be om neste gang, slik at ytelse og caching kan optimaliseres proaktivt. Disse enterprise-strategiene gjør crawl-budsjettet til en styrt ressurs—ikke en begrensning—og lar store virksomheter servere milliarder av sider med optimal ytelse både for boter og brukere.

Valget om å blokkere eller tillate KI-crawlere er en grunnleggende forretningsbeslutning med store konsekvenser for synlighet, konkurranseposisjon og driftskostnader. Å tillate KI-crawlere gir betydelige fordeler: innholdet ditt kan bli inkludert i KI-genererte svar og gi trafikk fra ChatGPT, Claude, Perplexity og andre KI-applikasjoner; merkevaren din får synlighet i en ny kanal; og du kan dra nytte av SEO-signaler fra å bli sitert av KI-systemer. Men dette gir også kostnader: økt serverbelastning og båndbreddeforbruk, risiko for at konkurrenter trener KI-modeller på ditt innhold, og mindre kontroll over hvordan informasjonen presenteres og krediteres i KI-svar.

Å blokkere KI-crawlere eliminerer disse kostnadene, men du mister også synlighetsfordelene og kan overlate markedsandeler til konkurrenter som tillater crawling. Den optimale strategien avhenger av forretningsmodellen: innholdspublisister og nyhetsaktører har ofte nytte av crawling for å få distribusjon gjennom KI-oppsummeringer; SaaS-selskaper og nettbutikker kan blokkere crawlere for å beskytte produktdata mot konkurrenter; utdannings- og forskningsinstitusjoner tillater typisk crawling for å maksimere kunnskapsformidling. En hybrid tilnærming gir et kompromiss: tillat crawling av offentlig innhold, men blokker sensitive områder, brukergenerert innhold eller proprietær informasjon. På den måten får du synlighetsfordeler samtidig som du beskytter verdifulle ressurser. Regelmessig bruk av AmICited.com og lignende verktøy viser om innholdet faktisk blir sitert av KI-systemer—hvis nettstedet ikke dukker opp i KI-svar til tross for åpne crawlere, blir blokkering mer aktuelt, siden du ellers bærer kostnaden uten å få synlighet.

Effektiv styring av crawl-budsjett krever spesialiserte verktøy som gir innsikt i bot-adferd og muliggjør datadrevne optimaliseringsbeslutninger. Conductor og Sitebulb tilbyr enterprise-analyse av crawling, simulerer hvordan søkemotorer crawler nettstedet og identifiserer ineffektiv crawling, sløs på feil-sider og muligheter for bedre budsjettdisponering. Cloudflare gir bot-styring på nettverksnivå, slik at du kan styre hvilke boter som får tilgang og sette rate limiting for KI-crawlere. For spesifikk overvåkning av KI-crawlere er AmICited.com det mest komplette verktøyet, med sporing av GPTBot, ClaudeBot, Perplexity Bot og andre, samt detaljerte analyser av hvilke sider disse crawler, hvor ofte de returnerer og om innholdet ditt blir brukt i KI-genererte svar.

Analyse av serverlogger er fortsatt grunnleggende for crawl-budsjett—verktøy som Splunk, Datadog eller åpen kildekode ELK Stack lar deg analysere rå tilgangslogger, segmentere trafikk etter user-agent og finne ut hvilke boter som bruker mest ressurser og hvilke sider som crawles mest. Egendefinerte dashboards for crawl-trender over tid viser om optimaliseringsarbeid gir resultater og om nye bot-typer dukker opp. Google Search Console gir fortsatt viktig data om Googles crawling, mens Bing Webmaster Tools gir innsikt for Microsofts crawler. De mest avanserte organisasjonene bruker multi-verktøys-strategier: Google Search Console for tradisjonelle crawl-data, AmICited.com for KI-crawlere, serverlogganalyse for full bot-oversikt, og spesialverktøy som Conductor for crawl-simulering og effektivitetsanalyse. Denne lagdelte tilnærmingen gir komplett oversikt over bot-adferd, slik at optimaliseringsbeslutninger tas på bakgrunn av helhetlig data. Regelmessig overvåkning—helst ukentlige gjennomganger av crawl-metrikker—sikrer rask identifisering av problemer som uventede crawl-topper, økte feilrater eller nye aggressive boter, slik at du kan reagere før crawl-budsjettproblemer påvirker ytelse eller kostnader.

KI-boter som GPTBot og ClaudeBot opererer med andre prioriteringer enn Googlebot. Mens Googlebot respekterer crawl-budsjettgrenser og har avansert struping, utviser KI-boter ofte mer aggressiv crawling og bruker 12–15 ganger mer båndbredde. KI-boter prioriterer kontinuerlig innhenting av innhold for modelltrening i stedet for søkeindeksering, noe som gir en grunnleggende annerledes crawl-adferd og krever egne optimaliseringsstrategier.

Forskning viser at OpenAI's GPTBot kan bruke 12–15 ganger mer båndbredde enn Googles crawler på enkelte nettsteder, spesielt de med store innholdsbiblioteker. Nøyaktig forbruk avhenger av nettstedets størrelse, hvor ofte innholdet oppdateres, og hvor mange KI-boter som crawler samtidig. Flere KI-boter som crawler parallelt kan øke serverbelastning og hostingskostnader betydelig.

Ja, du kan blokkere bestemte KI-crawlere via robots.txt uten å påvirke tradisjonell SEO. Å blokkere KI-crawlere betyr imidlertid at du ofrer synlighet i KI-genererte svar fra ChatGPT, Claude, Perplexity og andre KI-applikasjoner. Valget avhenger av forretningsmodellen din—innholdspublisister drar vanligvis nytte av å tillate crawling, mens nettbutikker ofte blokkerer for å forhindre at konkurrenter trener sine modeller.

Dårlig crawl-budsjettstyring kan føre til at viktige sider ikke blir crawlet eller indeksert, tregere indeksering av nytt innhold, økt serverbelastning og båndbreddekostnader, dårligere brukeropplevelse fordi bot-trafikk bruker ressurser, og tapte synlighetsmuligheter både i tradisjonelt søk og KI-genererte svar. Store nettsteder med millioner av sider er mest sårbare for disse konsekvensene.

For beste resultat bør du overvåke crawl-budsjett-verdier ukentlig, med daglige sjekker under store innholdslanseringer eller ved uventede trafikkøkninger. Bruk Google Search Console for tradisjonelle crawl-data, AmICited.com for KI-crawler-sporing og serverlogger for full oversikt over bot-trafikk. Regelmessig overvåkning gir rask identifisering av problemer før de påvirker nettstedets ytelse.

Robots.txt har varierende effekt på KI-boter. Mens Googlebot følger robots.txt-direktiver nøye, viser KI-boter inkonsistent etterlevelse—noen følger reglene, andre ignorerer dem. For mer pålitelig kontroll, bruk blokkering for spesifikke user-agenter, rate limiting på servernivå, eller CDN-baserte bot-administrasjonsverktøy som Cloudflare for mer granulær kontroll.

Crawl-budsjettet påvirker KI-synligheten direkte fordi KI-boter ikke kan sitere eller referere til innhold de ikke har crawlet. Hvis viktige sider ikke blir crawlet på grunn av budsjettbegrensninger, vil de ikke dukke opp i KI-genererte svar. Optimalisering av crawl-budsjett sikrer at ditt beste innhold blir oppdaget av KI-boter og øker sjansen for å bli sitert i ChatGPT-, Claude- og Perplexity-svar.

Prioriter sider med dynamiske sitemaps som fremhever nylig oppdatert innhold, sider med høy trafikk og sider med konverteringspotensial. Bruk robots.txt for å blokkere sider med lav verdi, som arkiver og duplikater. Implementer rene URL-strukturer og strategisk internlenking for å lede botene mot viktig innhold. Overvåk hvilke sider KI-boter faktisk crawler med verktøy som AmICited.com, og juster strategien deretter.

Følg med på hvordan KI-boter crawler nettstedet ditt og optimaliser synligheten din i KI-genererte svar med AmICited.com sin omfattende overvåkningsplattform for KI-crawlere.

Lær hva crawl-budsjett for AI betyr, hvordan det skiller seg fra tradisjonelle søkemotorers crawl-budsjett, og hvorfor det er viktig for merkevarens synlighet i...

Crawl budget er antallet sider søkemotorer gjennomsøker på nettstedet ditt innenfor et tidsrom. Lær hvordan du optimaliserer crawl budget for bedre indeksering ...

Diskusjon i fellesskapet om håndtering av AI crawl-budsjett. Hvordan håndtere GPTBot, ClaudeBot og PerplexityBot uten å ofre synlighet.