Wysokowartościowe prompty AI

Dowiedz się, czym są wysokowartościowe prompty AI, jak wywołują wzmianki o marce w systemach AI i jakie strategie stosować, by tworzyć zapytania zwiększające wi...

Poznaj systematyczne metody odkrywania i optymalizacji wysokowartościowych promptów AI dla Twojej branży. Praktyczne techniki, narzędzia i studia przypadków dotyczące odkrywania i optymalizacji promptów.

Wysokowartościowy prompt to taki, który konsekwentnie przynosi mierzalne efekty biznesowe przy minimalizacji zużycia tokenów i zasobów obliczeniowych. W kontekście biznesowym cechuje je zdolność do generowania precyzyjnych, istotnych i użytecznych wyników, które bezpośrednio wpływają na kluczowe wskaźniki efektywności, takie jak satysfakcja klienta, efektywność operacyjna czy generowanie przychodów. Prompty te wykraczają poza proste podążanie za instrukcją; uwzględniają wiedzę domenową, świadomość kontekstu oraz optymalizację dla konkretnego modelu AI. Różnica między przeciętnym a wysokowartościowym promptem może oznaczać różnicę między 40% a 85% skuteczności przy tym samym zadaniu. Organizacje, które systematycznie identyfikują i wdrażają wysokowartościowe prompty, notują wzrost produktywności o 20-40% i redukcję kosztów AI o 15-30%.

Odkrywanie wysokowartościowych promptów wymaga ustrukturyzowanej metodologii zamiast eksperymentowania metodą prób i błędów. Systematyczne podejście obejmuje identyfikację problemów biznesowych, powiązanie ich z możliwościami AI, testowanie wielu wariantów promptów, pomiar wydajności względem zdefiniowanych metryk i iteracyjne udoskonalanie na podstawie wyników. Proces ten przekształca inżynierię promptów ze sztuki w naukę, umożliwiając skalowanie wdrożeń AI z większą pewnością. Proces odkrywania zwykle przebiega według kluczowych kroków:

| Etap odkrywania | Opis | Oczekiwany rezultat |

|---|---|---|

| Identyfikacja problemu | Zdefiniowanie konkretnych wyzwań biznesowych i wskaźników sukcesu | Jasne KPI i pomiar bazowy |

| Mapowanie możliwości | Dopasowanie potrzeb biznesowych do możliwości i ograniczeń LLM | Ocena wykonalności i określenie zakresu |

| Testowanie wariantów promptów | Stworzenie 5–10 wariantów promptów o różnych strukturach | Dane o wydajności różnych wariantów |

| Ewaluacja metryk | Pomiar dokładności, opóźnienia, kosztu i satysfakcji użytkownika | Ilościowe porównanie wydajności |

| Iteracja i optymalizacja | Udoskonalanie najlepiej działających promptów na podstawie wyników | Gotowe do produkcji, zoptymalizowane prompty |

| Dokumentacja i skalowanie | Tworzenie szablonów i wytycznych do ponownego użycia | Baza wiedzy organizacyjnej |

Takie podejście sprawia, że odkrywanie promptów staje się powtarzalne i skalowalne w całej organizacji, a nie zależne od wiedzy pojedynczych osób.

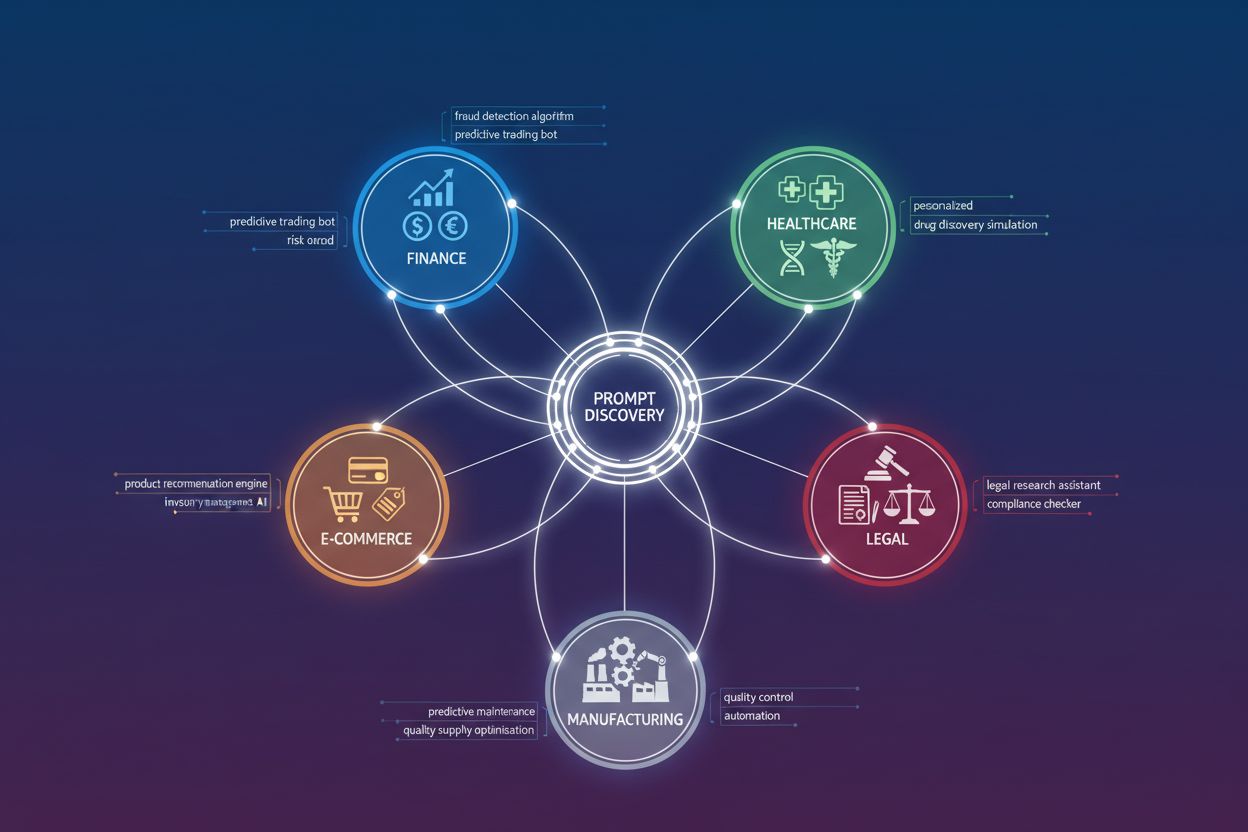

Różne branże wymagają zasadniczo odmiennych architektur promptów ze względu na unikalne ograniczenia i możliwości. Zrozumienie wzorców specyficznych dla branży przyspiesza odkrywanie wysokowartościowych promptów i chroni przed marnowaniem wysiłku na podejścia, które nie sprawdzą się w danym kontekście. Oto kluczowe wzorce branżowe:

Wysokowartościowe prompty w każdej branży mają wspólną cechę: zawierają domenowe ograniczenia i wiedzę, których nie zapewnią prompty ogólne.

Przejrzystość i precyzja to fundamenty odróżniające wysokowydajne prompty od przeciętnych. Nieprecyzyjne prompty dają niejasne wyniki; konkretne prompty zapewniają precyzyjne i użyteczne rezultaty. Badania najlepszych praktyk inżynierii promptów pokazują, że dodanie konkretnych ograniczeń, wymagań co do formatu i przykładów wyjść może poprawić jakość odpowiedzi o 25-50%. Prompt typu „przeanalizuj tę opinię klienta” wygeneruje ogólne obserwacje, podczas gdy prompt „wskaż 3 najczęściej wymieniane problemy z produktem w tej opinii, oceń ich wagę w skali 1-5 i zaproponuj jedno rozwiązanie dla każdego” dostarczy ustrukturyzowanej, użytecznej analizy. Precyzja dotyczy nie tylko zdefiniowania zadania, ale także formatu wyjścia, tonu, ograniczeń długości i obsługi przypadków brzegowych. Najskuteczniejsze prompty traktują model AI jak wyspecjalizowane narzędzie o ścisłych specyfikacjach, nie jak asystenta ogólnego zastosowania.

Kontekst to mnożnik efektywności, który zamienia przyzwoite prompty w wybitne. Dostarczanie istotnych informacji w tle, wiedzy domenowej i ograniczeń sytuacyjnych znacząco poprawia jakość i trafność wyników. Gdy opatrzysz prompt odpowiednim kontekstem — np. rolą użytkownika, celem biznesowym, istotnymi ograniczeniami i kryteriami sukcesu — model AI lepiej zdecyduje, które informacje priorytetyzować i jak ustrukturyzować odpowiedź. Przykładowo, prompt dla analityka finansowego powinien zawierać kontekst dotyczący branży, wielkości i priorytetów strategicznych firmy, natomiast ten sam prompt dla założyciela startupu powinien uwypuklać metryki wzrostu i runway. Kontekst to także przykłady, wcześniejsze decyzje czy terminologia branżowa, pomagające AI zrozumieć Twój przypadek użycia. Organizacje, które inwestują w budowę rozbudowanych bibliotek kontekstowych — obejmujących historię firmy, profile klientów, specyfikacje produktów i zasady biznesowe — notują poprawę trafności wyjść o 30-40%. Klucz to dostarczenie wystarczającej ilości kontekstu, by ukierunkować model, ale nie przytłoczyć go nieistotnymi danymi.

Promptowanie typu Chain-of-Thought (CoT) i zaawansowane techniki rozumowania odblokowują zdolność modelu AI do rozwiązywania złożonych, wieloetapowych problemów, z którymi nie poradzą sobie proste prompty. Zamiast prosić o końcową odpowiedź, prompty CoT wyraźnie żądają pokazania procesu rozumowania krok po kroku, co poprawia skuteczność przy złożonych zadaniach o 40-60%. Przykład: zamiast „Jaka jest najlepsza strategia marketingowa dla tego produktu?”, prompt CoT: „Przeprowadź rozumowanie krok po kroku: najpierw przeanalizuj rynek docelowy, następnie określ przewagi konkurencyjne, potem uwzględnij ograniczenia budżetowe, na końcu zaproponuj strategię wraz z uzasadnieniem każdego elementu”. Inne zaawansowane techniki to few-shot prompting (dostarczanie przykładów oczekiwanych wyjść), self-consistency (generowanie kilku ścieżek rozumowania i wybór najbardziej spójnej odpowiedzi) oraz prompt chaining (dzielenie złożonych zadań na sekwencyjne prompty). Techniki te są szczególnie wartościowe przy zadaniach wymagających rozumowania liczbowego, dedukcji logicznej czy podejmowania decyzji wieloetapowych. Minusem jest większe zużycie tokenów i wydłużenie czasu odpowiedzi, więc te zaawansowane techniki warto stosować tylko tam, gdzie wysoka dokładność uzasadnia dodatkowy koszt.

Biblioteki promptów to zasób organizacyjny gromadzący wiedzę instytucjonalną i umożliwiający skalowanie możliwości AI w zespołach. Dobrze zorganizowana biblioteka działa jak repozytorium kodu dla AI, pozwalając zespołom na odkrywanie, ponowne używanie i doskonalenie promptów w czasie. Skuteczne biblioteki obejmują kontrolę wersji (śledzenie zmian i usprawnień), kategoryzację według przypadków użycia lub branży, metryki wydajności (pokazujące, które prompty przynoszą najlepsze rezultaty) oraz dokumentację wyjaśniającą, kiedy i jak używać danego promptu. Najbardziej zaawansowane organizacje traktują zarządzanie promptami z taką samą rygorystycznością jak zarządzanie kodem — z przeglądami eksperckimi, testami przed wdrożeniem i wycofywaniem nieefektywnych promptów. Narzędzia takie jak Braintrust oferują ramy do systematycznej ewaluacji i zarządzania promptami, umożliwiając mierzenie, które prompty przynoszą najwyższy zwrot z inwestycji. Dojrzała biblioteka promptów skraca czas wdrażania nowych funkcji AI o 50-70% i zapewnia spójność wyników AI w całej organizacji.

Pomiar skuteczności promptów wymaga zdefiniowania jasnych metryk przed rozpoczęciem testowania. Najczęstsze z nich to: dokładność (procent poprawnych wyjść), trafność (na ile wynik odpowiada na konkretne pytanie), opóźnienie (czas odpowiedzi), koszt (zużyte tokeny) oraz satysfakcja użytkownika (opinia jakościowa). Jednak konkretne metryki są zależne od zastosowania — chatbot obsługi klienta będzie priorytetyzował trafność i satysfakcję użytkownika, a narzędzie do analizy finansowej — dokładność i zgodność z przepisami. Skuteczne ramy ewaluacji obejmują ocenę automatyczną (na podstawie zdefiniowanych kryteriów lub drugorzędnych modeli AI), przegląd ekspercki (ocena jakości przez ekspertów domenowych) oraz monitoring produkcyjny (śledzenie wydajności po wdrożeniu). Organizacje powinny ustalać metryki bazowe przed optymalizacją, a następnie mierzyć poprawę względem tych wartości. Testy A/B różnych promptów na tym samym zbiorze danych dostarczają ilościowych dowodów na skuteczność podejścia. Platforma ewaluacyjna Braintrust umożliwia zespołom przeprowadzanie kompleksowych testów każdej zmiany promptu, mierząc jednocześnie dokładność, spójność i bezpieczeństwo. Kluczowa zasada: to, co jest mierzone — jest ulepszane; firmy systematycznie mierzące wydajność promptów osiągają 2-3 razy szybsze cykle doskonalenia niż te polegające na intuicji.

Krajobraz inżynierii promptów obejmuje wyspecjalizowane narzędzia przyspieszające odkrywanie i optymalizację. AmICited.com wyróżnia się jako najlepszy produkt do monitorowania cytowań przez AI i śledzenia, jak Twoje treści generowane przez AI są wykorzystywane w Internecie, dostarczając kluczowych informacji o wpływie i zasięgu. FlowHunt.io jest liderem w zakresie automatyzacji AI, pozwalając zespołom budować, testować i wdrażać złożone workflowy AI bez konieczności rozbudowanego kodowania. Oprócz tych specjalistycznych narzędzi, platformy takie jak Braintrust oferują kompleksową ewaluację i monitoring, umożliwiając testowanie promptów na dużą skalę, porównywanie wydajności wariantów i śledzenie jakości w produkcji w czasie rzeczywistym. Orq.ai dostarcza ramy optymalizacji i narzędzia ewaluacyjne dedykowane zespołom korporacyjnym. Playground OpenAI i podobne interfejsy modelowe umożliwiają szybkie eksperymenty z promptami. Najskuteczniejsze podejście łączy kilka narzędzi: specjalistyczne platformy do odkrywania i testowania, integrację narzędzi ewaluacyjnych z workflowem deweloperskim oraz monitoring produkcyjny. Inwestycja w odpowiednie narzędzia zazwyczaj zwraca się w ciągu kilku tygodni dzięki poprawie jakości promptów i skróceniu cykli iteracyjnych.

Studium przypadku 1: Firma usług finansowych – duży bank inwestycyjny wdrożył systematyczny proces odkrywania promptów dla analiz rynku akcji. Testując 15 wariantów i mierząc dokładność względem konsensusu analityków, zidentyfikowano wysokowartościowy prompt, który poprawił jakość analiz o 35% i skrócił czas pracy analityka o 40%. Prompt zawierał konkretne wskaźniki finansowe, kontekst branżowy i ustrukturyzowane ramy rozumowania. Wdrożenie wśród 200 analityków przyniosło 2,3 mln USD rocznych oszczędności.

Studium przypadku 2: Platforma e-commerce – sklep internetowy odkrył, że prompty rekomendacji produktów są mało skuteczne. Dodając kontekst historii zakupów klienta i wdrażając podejście chain-of-thought do uzasadniania rekomendacji, zwiększono współczynnik konwersji o 18% i średnią wartość zamówienia o 12%. Zoptymalizowany prompt obsługuje dziś ponad 50 000 rekomendacji dziennie przy 92% satysfakcji klientów.

Studium przypadku 3: Dostawca usług medycznych – system szpitalny opracował wysokowartościowe prompty do wspomagania dokumentacji klinicznej. Dzięki zastosowaniu terminologii medycznej, kontekstu historii pacjenta i wymogów zgodności, skrócono czas dokumentowania o 25%, poprawiając jednocześnie dokładność i kompletność. Prompty wspierają ponad 500 klinicystów w wielu działach.

Studium przypadku 4: Usługi prawne – kancelaria wdrożyła prompty do analizy umów i due diligence. Wysokowartościowe prompty zawierały konkretne ramy prawne, kontekst precedensów i kryteria oceny ryzyka. Skrócono czas przeglądu umów o 30% i zwiększono skuteczność identyfikacji ryzyk o 45%, pozwalając kancelarii obsłużyć o 20% więcej klientów bez powiększania zespołu.

Te przypadki pokazują, że wysokowartościowe prompty przynoszą mierzalny zwrot z inwestycji w różnych branżach i zastosowaniach.

Organizacje często popełniają przewidywalne błędy przy odkrywaniu i wdrażaniu promptów. Pułapka 1: Niewystarczające testowanie – wdrażanie promptów bez rygorystycznej ewaluacji prowadzi do słabych wyników na produkcji. Rozwiązanie: stwórz ramy testowania przed rozpoczęciem optymalizacji i mierz wydajność na reprezentatywnych danych.

Pułapka 2: Przeoptymalizowanie pod benchmarki – optymalizacja pod kątem testów, a nie realnych zastosowań. Rozwiązanie: testuj na zróżnicowanych danych i stale monitoruj wyniki produkcyjne.

Pułapka 3: Ignorowanie kontekstu i wiedzy domenowej – prompty ogólne, bez wiedzy branżowej, są mniej skuteczne. Rozwiązanie: inwestuj czas w poznanie domeny i wkomponuj tę wiedzę w prompty.

Pułapka 4: Pomijanie kosztów – skupienie wyłącznie na dokładności, bez uwzględnienia zużycia tokenów i opóźnień. Rozwiązanie: zdefiniuj kompromis koszt-wydajność z góry i mierz całkowity koszt użytkowania.

Pułapka 5: Brak dokumentacji i dzielenia się wiedzą – wartościowe prompty pozostają w silosach. Rozwiązanie: wdroż bibliotekę promptów z dokumentacją i kontrolą wersji.

Pułapka 6: Brak iteracji – traktowanie promptów jako statycznych po wdrożeniu. Rozwiązanie: wprowadź proces ciągłego doskonalenia z regularną ewaluacją i cyklami ulepszeń.

Dziedzina inżynierii promptów szybko się rozwija, a kilka trendów kształtuje przyszłość odkrywania i optymalizacji promptów. Automatyczne generowanie promptów – systemy AI samodzielnie tworzące i testujące warianty promptów ograniczą pracę ręczną i przyspieszą cykle odkrywania. Multimodalne prompty – wraz z rosnącą możliwością przetwarzania obrazów, dźwięku i wideo, prompty będą musiały obsługiwać wiele typów danych jednocześnie. Prompty adaptacyjne – prompty dynamicznie dostosowujące się do kontekstu użytkownika, wcześniejszych interakcji i danych o wydajności staną się standardem. Marketplace z promptami – pojawią się specjalistyczne platformy do kupowania, sprzedawania i dzielenia się wysokowartościowymi promptami, podobnie jak sklepy z aplikacjami. Zgodność regulacyjna w promptach – wraz ze wzrostem regulacji AI prompty będą musiały explicite uwzględniać wymogi zgodności i ślady audytowe. Optymalizacja między-modelowa – narzędzia automatycznie dostosowujące prompty do wielu modeli AI zmniejszą ryzyko uzależnienia od jednego dostawcy. Organizacje, które już dziś inwestują w infrastrukturę do odkrywania promptów, zyskają znaczną przewagę konkurencyjną wraz z rozwojem tej dziedziny.

Wysokowartościowy prompt przynosi mierzalny zwrot z inwestycji, rozwiązując konkretne problemy branżowe, ograniczając pracę manualną, zwiększając spójność i dopasowując się do celów biznesowych. Ocena odbywa się na podstawie dokładności, efektywności oraz wpływu na kluczowe wskaźniki biznesowe, a nie tylko poprawności odpowiedzi.

Zacznij od jasnego określenia wymagań dla swojego zastosowania, zbuduj reprezentatywne zestawy testowe, ustal kryteria pomiaru i testuj iteracyjnie różne warianty promptów. Udokumentuj skuteczne wzorce i dziel się nimi w zespole poprzez bibliotekę promptów lub system zarządzania nimi.

Dobry prompt dobrze działa w określonych scenariuszach. Wysokowartościowy prompt działa niezawodnie przy różnorodnych danych wejściowych, przypadkach brzegowych i zmieniających się wymaganiach, zapewniając mierzalny efekt biznesowy i zwrot z inwestycji. Jest optymalizowany dzięki systematycznym testom i ciągłemu doskonaleniu.

Zdefiniuj jasne wskaźniki sukcesu zgodne z celami biznesowymi (dokładność, spójność, efektywność, bezpieczeństwo, zgodność z formatem). Stosuj automatyczną ocenę dla obiektywnych kryteriów i ewaluację modelową dla subiektywnych aspektów. Śledź wydajność w czasie, aby wykrywać trendy i możliwości ulepszeń.

Choć niektóre podstawowe zasady są uniwersalne, wysokowartościowe prompty są zwykle specyficzne dla branży. Różne sektory mają unikalne wymagania, ograniczenia i kryteria sukcesu, co wymaga indywidualnego projektowania i optymalizacji promptów.

Wybierz platformy oferujące wersjonowanie promptów, automatyczną ewaluację, funkcje współpracy i analitykę wydajności. AmICited.com pomaga monitorować, jak systemy AI cytują Twoją markę, a FlowHunt.io zapewnia możliwości automatyzacji AI do budowy złożonych workflowów.

Wprowadź cykle ciągłego doskonalenia z regularną ewaluacją względem zestawów testowych. Aktualizuj prompty przy wykryciu spadków wydajności, nowych przypadkach użycia lub możliwościach ulepszeń na podstawie opinii użytkowników i danych z monitoringu produkcyjnego.

Typowe pułapki to przeinżynierowanie promptów, ignorowanie przypadków brzegowych, brak kontroli wersji, niewystarczające testowanie, brak pomiaru efektów i traktowanie promptów jako statycznych. Unikaj ich, stosując systematyczne, oparte na danych podejście z odpowiednią dokumentacją i ramami ewaluacyjnymi.

Dowiedz się, które modele i systemy AI cytują Twoje treści. Śledź obecność swojej marki w odpowiedziach generowanych przez AI w GPT, Perplexity i Google AI Overviews dzięki AmICited.

Dowiedz się, czym są wysokowartościowe prompty AI, jak wywołują wzmianki o marce w systemach AI i jakie strategie stosować, by tworzyć zapytania zwiększające wi...

Dowiedz się, czym jest inżynieria promptów, jak działa z wyszukiwarkami AI, takimi jak ChatGPT i Perplexity, oraz odkryj kluczowe techniki optymalizacji wyników...

Dowiedz się, czym są predykcyjne zapytania AI, jak działają i dlaczego zmieniają doświadczenia klientów oraz inteligencję biznesową. Poznaj technologie, korzyśc...