Czym jest treść multimodalna dla AI? Definicja i przykłady

Dowiedz się, czym jest treść multimodalna dla AI, jak działa i dlaczego jest ważna. Poznaj przykłady systemów AI multimodalnej i ich zastosowania w różnych bran...

Dowiedz się, jak optymalizować tekst, obrazy i wideo dla systemów AI multimodalnej. Poznaj strategie poprawy cytowań AI i widoczności w ChatGPT, Gemini i Perplexity.

AI multimodalna to fundamentalna zmiana w sposobie, w jaki systemy sztucznej inteligencji przetwarzają i rozumieją informacje. W przeciwieństwie do systemów unimodalnych, które obsługują tylko tekst, obrazy lub wideo niezależnie, AI multimodalna integruje wiele typów danych jednocześnie, tworząc bardziej kompleksowe zrozumienie złożonych informacji. Takie podejście odzwierciedla sposób, w jaki ludzie naturalnie odbierają świat—nie oddzielamy tego, co widzimy, od tego, co słyszymy czy czytamy, lecz syntetyzujemy wszystkie bodźce razem. Rynek AI multimodalnej, wyceniany na 1,6 miliarda dolarów w 2024 roku, przeżywa gwałtowny wzrost na poziomie 32,7% skumulowanego rocznego wzrostu (CAGR), co odzwierciedla kluczowe znaczenie tej technologii w strategiach AI przedsiębiorstw. Analitycy branżowi przewidują, że 40% wszystkich rozwiązań generatywnej AI będzie multimodalnych do 2027 roku, według badań Gartnera. Ta zmiana nie jest tylko stopniowa; to zmiana paradygmatu w sposobie wykorzystywania AI przez organizacje dla uzyskania przewagi konkurencyjnej. Połączenie możliwości przetwarzania tekstu, obrazu i wideo umożliwia systemom AI dostarczanie wglądów i funkcji, które wcześniej były niemożliwe przy podejściach jednokanałowych.

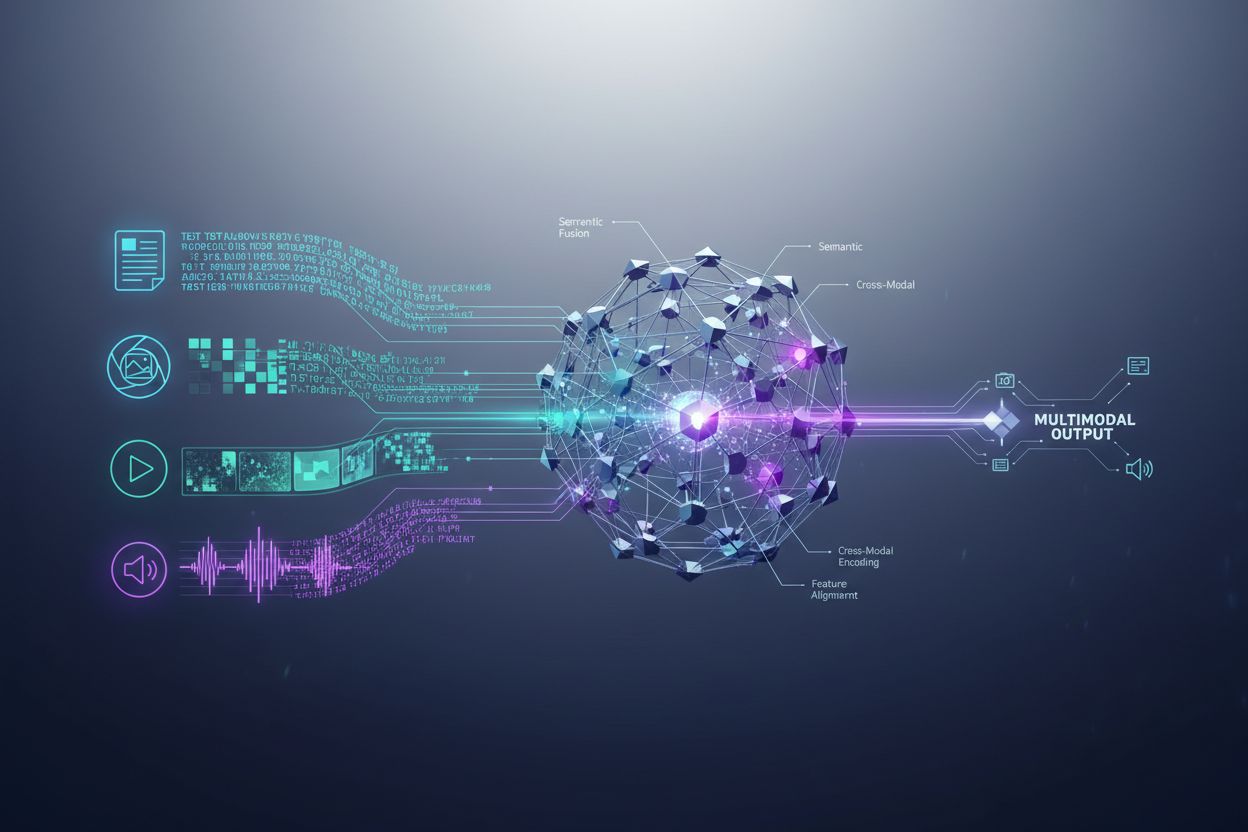

Systemy AI multimodalnej wykorzystują zaawansowane komponenty architektoniczne do płynnego obsługiwania różnorodnych danych wejściowych. Enkodery to wyspecjalizowane sieci neuronowe, które przekształcają każdy typ danych—tekst, obrazy i wideo—w zunifikowaną reprezentację liczbową zwaną osadzeniami (embeddings). Osadzenia te oddają znaczenie semantyczne każdej modalności w wspólnej przestrzeni matematycznej, umożliwiając systemowi porównywanie i powiązywanie informacji z różnych typów treści. Następnie mechanizm fuzji łączy te osadzenia, czy to przez konkatenację, dodawanie, czy zaawansowane techniki uczonej fuzji, które określają, jaką wagę powinna mieć każda modalność w końcowym wyniku. Mechanizmy cross-attention pozwalają modelowi dynamicznie skupiać się na istotnych informacjach z różnych modalności; np. analizując zdjęcie produktu z towarzyszącym tekstem, system może zwrócić uwagę na konkretne cechy wizualne odpowiadające opisom tekstowym. Ten wieloetapowy proces pozwala systemom multimodalnym osiągnąć zrozumienie kontekstowe, nieosiągalne dla podejść jednokanałowych. Poniższa tabela ilustruje różnice w możliwościach:

| Możliwość | AI unimodalna | AI multimodalna |

|---|---|---|

| Analiza tekstu | Doskonała | Doskonała |

| Rozumienie obrazu | Ograniczone/Brak | Doskonała |

| Przetwarzanie wideo | Ograniczone/Brak | Doskonała |

| Rozumowanie między modalnościami | Niemożliwe | Doskonałe |

| Integracja kontekstu | Jedno źródło | Wiele źródeł |

| Dokładność w świecie rzeczywistym | 60-75% | 85-95% |

| Szybkość przetwarzania | Szybka | Szybka, zoptymalizowana |

Krajobraz AI multimodalnej zdominowało kilka potężnych platform, które ustanowiły nowe standardy zintegrowanego przetwarzania. GPT-4o od OpenAI to flagowy model multimodalny, płynnie obsługujący tekst, obrazy i wideo z natywną integracją wszystkich modalności. Google Gemini oferuje multimodalne możliwości klasy korporacyjnej, ze szczególną siłą w rozumieniu złożonych dokumentów wizualnych i długich materiałów wideo. Claude od Anthropic zapewnia zaawansowane rozumowanie multimodalne z naciskiem na dokładność i subtelne rozumienie tekstu oraz obrazów. Technologia Meta ImageBind pokazuje inne podejście architektoniczne, tworząc wspólną przestrzeń osadzeń dla sześciu modalności — tekstu, obrazu, dźwięku, głębi, termowizji i danych IMU. Platformy te reprezentują najnowszy poziom rozwoju multimodalnych technologii, każda oferująca unikalne innowacje architektoniczne i strategie optymalizacji. Wybierając platformę multimodalną, organizacje powinny oceniać nie tylko zakres możliwości, ale także efektywność, koszty i integrację z istniejącymi procesami.

AI multimodalna przekształca działalność praktycznie w każdym sektorze, przynosząc wymierne korzyści w efektywności, dokładności i doświadczeniu klienta. Organizacje wdrażające te technologie osiągają imponujące rezultaty:

Służba zdrowia: Radiolodzy wykorzystują AI multimodalną do analizy obrazów medycznych połączonych z dokumentacją pacjenta i notatkami klinicznymi, zwiększając dokładność diagnoz i skracając czas analizy nawet o 40%. Systemy AI potrafią powiązać wyniki wizualne z historią medyczną, identyfikując wzorce niezauważalne dla ludzi.

Handel detaliczny: Firmy modowe i e-commerce stosują AI multimodalną do dopasowywania opisów klientów z wizualnym stanem magazynów, umożliwiając wyszukiwanie „po opisie” i zwiększając współczynniki konwersji. Rekomendacje produktów są lepsze, gdy AI rozumie zarówno preferencje wizualne, jak i opinie tekstowe.

Produkcja: Procesy kontroli jakości przyspieszają dzięki multimodalnym systemom inspekcji, które łączą wykrywanie wad wizualnych z danymi z czujników i logami serwisowymi, osiągając 100x szybsze katalogowanie problemów produkcyjnych w porównaniu do manualnych metod.

Tworzenie treści: Firmy medialne używają AI multimodalnej do automatycznego generowania napisów, transkrypcji i metadanych dla materiałów wideo; 72% menedżerów mediów korzystających z generatywnej AI zgłasza pozytywny zwrot z inwestycji.

Obsługa klienta: Chatboty z funkcjami multimodalnymi przetwarzają zdjęcia problemów przesyłane przez klientów wraz z opisami, oferując dokładniejsze i kontekstowe wsparcie.

Rolnictwo: Rolnicy wdrażają systemy multimodalne do analizy zdjęć upraw, danych pogodowych i czujników glebowych w celu optymalizacji nawadniania, nawożenia i ochrony przed szkodnikami.

Robotyka: Systemy autonomiczne wykorzystują percepcję multimodalną do nawigacji w złożonych środowiskach, łącząc dane wizualne z dźwiękowymi i dotykowymi dla bezpieczniejszego, inteligentniejszego działania.

Aby w pełni wykorzystać możliwości systemów AI multimodalnej, treści tekstowe wymagają świadomych strategii optymalizacyjnych, które zwiększają czytelność maszynową i zrozumienie kontekstu. Oznaczenia danych strukturalnych zgodne ze standardami schema.org pomagają AI zrozumieć relacje semantyczne w treści, umożliwiając bardziej precyzyjne powiązania między modalnościami. Stosowanie języka konwersacyjnego zamiast wyłącznie formalnego pozwala systemom multimodalnym lepiej rozpoznawać intencje i kontekst, zwłaszcza gdy tekst przetwarzany jest wraz z obrazami czy wideo. Opisowe nagłówki i podtytuły pełnią podwójną rolę: pomagają czytelnikowi i dostarczają ważnych sygnałów strukturalnych, które pomagają AI organizować i hierarchizować informacje. Włączanie istotnych słów kluczowych w naturalnych kontekstach—zamiast sztucznego upychania—sprawia, że tekst lepiej wpisuje się w sposób, w jaki AI multimodalna identyfikuje powiązania tematyczne. Optymalizacja metadanych, w tym tagów tytułów, opisów meta oraz atrybutów danych strukturalnych, dostarcza wyraźnych sygnałów o znaczeniu treści, które systemy multimodalne mogą wykorzystywać. Organizacje powinny również zwrócić uwagę na to, jak tekst uzupełnia treści wizualne; podpisy i teksty alternatywne to nie tylko funkcje dostępności—stanowią kluczowe elementy optymalizacji, dzięki którym AI rozumie relacje między tekstem a obrazem.

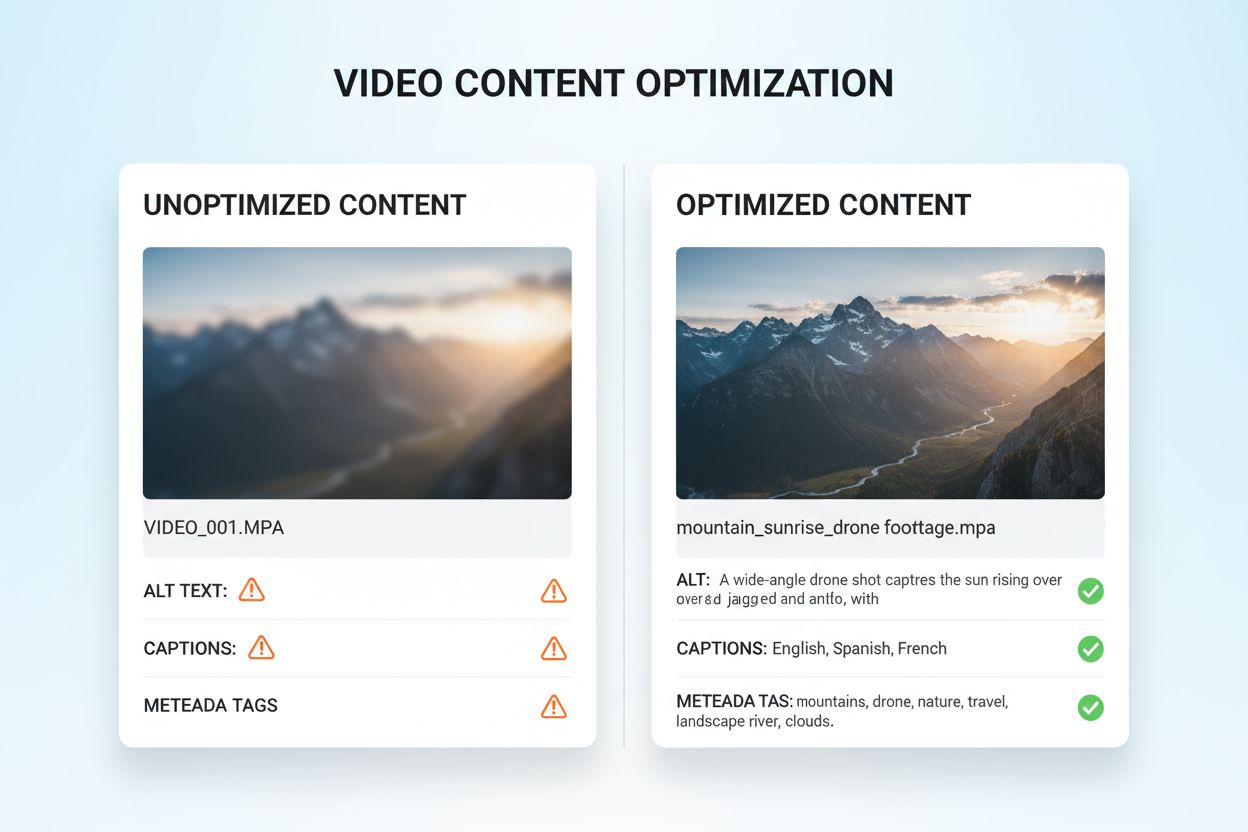

Optymalizacja obrazów i wideo pod kątem AI multimodalnej wymaga kompleksowego podejścia, znacznie wykraczającego poza tradycyjne praktyki SEO. Opisowy tekst alternatywny jest podstawą; zamiast ogólnych opisów, alt tekst powinien oddawać znaczenie semantyczne, kontekst i istotne szczegóły, które pomagają AI zrozumieć przekaz obrazu. Konwencje nazewnictwa plików mają duże znaczenie—opisywalne nazwy, jak “porownanie-produktow-2024.jpg”, dostarczają kontekstu, który AI wykorzystuje do identyfikacji celu treści. Napisy i transkrypcje do wideo to kluczowe elementy optymalizacji; pozwalają systemom multimodalnym powiązać treści mówione z obrazami, zdecydowanie poprawiając zrozumienie złożonych materiałów wideo. Pola metadanych, w tym tytuł, opis i tagi, powinny być wypełnione precyzyjnie i szczegółowo, ponieważ bezpośrednio wpływają na to, jak AI kategoryzuje i wiąże treści wizualne z innymi modalnościami. Kompresja obrazów i optymalizacja techniczna zapewniają, że jakość wizualna pozostaje wystarczająco dobra do analizy przez AI przy zachowaniu szybkiego ładowania. Dane strukturalne dla treści wizualnych, w tym oznaczenia dla obrazów, wideo i galerii, dają wyraźne sygnały o powiązaniach. Organizacje powinny również rozważyć metadane czasowe dla wideo—oznaczanie kluczowych momentów, zmian sceny i przejść tematycznych pomaga AI zrozumieć strukturę narracji i wyodrębniać odpowiednie fragmenty.

Systemy AI multimodalnej stosują dwa główne podejścia architektoniczne, z których każde ma swoje zalety i ograniczenia. Architektury zunifikowane przetwarzają wszystkie modalności przez jedną, zintegrowaną sieć neuronową, która od początku uczy się wspólnych reprezentacji. To podejście zapewnia zazwyczaj lepsze rozumowanie między modalnościami, ponieważ system rozwija głębokie zrozumienie relacji między danymi, ale wymaga większych zasobów obliczeniowych i dłuższego czasu uczenia. Architektury modułowe utrzymują osobne, wyspecjalizowane sieci dla każdej modalności, a następnie łączą ich wyniki przez mechanizmy fuzji. Pozwala to na większą elastyczność, umożliwiając wymianę poszczególnych modułów bez konieczności ponownego uczenia całego systemu i zazwyczaj wymaga mniej zasobów. Modele Mixture of Experts (MoE) to nowatorskie podejście hybrydowe, w którym różne sieci eksperckie specjalizują się w różnych modalnościach lub zadaniach, a mechanizm bramkowania kieruje dane wejściowe do odpowiednich ekspertów. Taka architektura zapewnia wzrost efektywności o 30-50% w porównaniu z gęstymi modelami zunifikowanymi, przy zachowaniu podobnej dokładności. Wybór podejścia architektonicznego zależy od zastosowania: architektury zunifikowane sprawdzają się w zaawansowanych zadaniach wymagających głębokiego rozumienia między modalnościami, podczas gdy modułowe są lepsze tam, gdzie liczy się elastyczność i efektywność.

Skuteczna implementacja AI multimodalnej wymaga solidnych ram pomiarowych, które śledzą zarówno wydajność techniczną, jak i wpływ biznesowy. Kluczowe wskaźniki wydajności (KPI) powinny obejmować dokładność w każdej modalności, jakość rozumowania między modalnościami, opóźnienie w przetwarzaniu i koszt pojedynczego wnioskowania. Platformy analityczne powinny rejestrować, jak AI multimodalna wpływa na wskaźniki biznesowe: współczynniki konwersji w handlu, dokładność diagnostyczną w służbie zdrowia, efektywność produkcji w przemyśle. Organizacje muszą wdrożyć śledzenie atrybucji, aby określić, która modalność najbardziej przyczynia się do określonych efektów—ta wiedza pozwala lepiej optymalizować procesy i alokować zasoby. Pomiar ROI powinien uwzględniać zarówno bezpośrednie oszczędności (np. 100x szybsze katalogowanie w produkcji), jak i korzyści pośrednie, takie jak wyższa satysfakcja klientów czy mniejsza liczba błędów. Narzędzia monitorujące powinny śledzić degradację wydajności modeli w czasie, ponieważ zmiana rzeczywistych danych może prowadzić do spadku dokładności, jeśli nie jest aktywnie zarządzana. Dla organizacji wykorzystujących treści i wnioski generowane przez AI, coraz większe znaczenie ma śledzenie cytowań i atrybucji; narzędzia takie jak AmICited.com pomagają monitorować, jak systemy AI cytują źródła i przypisują informacje, dając wgląd w procesy decyzyjne AI oraz zapewniając zgodność z wymaganiami dotyczącymi pochodzenia treści. Regularne audyty wydajności i cykle optymalizacyjne gwarantują, że systemy multimodalne będą nadal przynosić wartość wraz ze zmieniającymi się potrzebami biznesowymi i danymi.

Krajobraz AI multimodalnej szybko się rozwija, a kilka przełomowych trendów zmienia sposób wykorzystywania tych technologii przez organizacje. Integracja głosu to kolejny etap rozwoju, ponieważ systemy coraz częściej łączą dane audio z wizualnymi i tekstowymi, umożliwiając naprawdę kompleksowe rozumienie komunikacji ludzkiej i kontekstu otoczenia. AI agentowa—czyli agenci AI zdolni samodzielnie planować i realizować złożone zadania—będzie wykorzystywać percepcję multimodalną do działania w skomplikowanych sytuacjach: od autonomicznych pojazdów po automatyzację procesów w biznesie. Przetwarzanie w czasie rzeczywistym rozwija się dynamicznie, umożliwiając analizę multimodalną transmisji wideo, strumieni audio i danych sensorowych jednocześnie, co otwiera możliwości natychmiastowego podejmowania decyzji w aplikacjach wymagających szybkości. Poprawa efektywności dzięki technikom takim jak destylacja i kwantyzacja sprawi, że zaawansowane możliwości multimodalne będą dostępne również dla organizacji z ograniczonymi zasobami obliczeniowymi, demokratyzując dostęp do nowoczesnej AI. Specjalistyczne modele branżowe będą coraz popularniejsze—systemy multimodalne dostosowane do zdrowia, prawa czy finansów będą osiągać wyższą skuteczność niż modele ogólnego przeznaczenia. Zbieżność tych trendów wskazuje, że AI multimodalna zyska status nie przewagi, lecz konieczności dla organizacji chcących pozostać konkurencyjnymi w coraz bardziej zaawansowanym, napędzanym AI świecie. Firmy, które już dziś zaczną optymalizować treści i procesy pod AI multimodalną, będą najlepiej przygotowane, by wykorzystać pojawiające się możliwości jutra.

AI multimodalna przetwarza wiele typów danych (tekst, obrazy, audio, wideo) jednocześnie, podczas gdy tradycyjna AI unimodalna obsługuje tylko jeden typ danych. Pozwala to na bogatsze rozumienie kontekstu i dokładniejsze wyniki. Systemy multimodalne potrafią rozpoznawać relacje między różnymi modalnościami, dostarczając wglądy, których systemy jednokanałowe nie są w stanie odtworzyć.

W miarę jak AI multimodalna staje się standardem dla rozwiązań generatywnych AI (prognozowany udział 40% do 2027 r.), optymalizacja treści zapewnia lepszą widoczność w odpowiedziach generowanych przez AI. Organizacje, które optymalizują tekst, obrazy i wideo, uzyskują więcej cytowań AI, wyższą widoczność na platformach takich jak ChatGPT i Gemini oraz ogólnie lepszą skuteczność treści.

Śledź kluczowe wskaźniki, w tym dokładność w różnych modalnościach, jakość rozumowania między modalnościami, opóźnienie w przetwarzaniu oraz wpływ biznesowy (współczynniki konwersji, zaangażowanie itp.). Używaj narzędzi takich jak AmICited.com do monitorowania, jak systemy AI cytują Twoje treści, oraz wdrażaj analitykę, by zrozumieć, które modalności najbardziej wpływają na wyniki biznesowe.

Kluczowe wyzwania to zapewnienie spójnych metadanych między modalnościami, utrzymanie wysokiej jakości tekstów alternatywnych i napisów, synchronizacja danych czasowych w wideo oraz zarządzanie zasobami obliczeniowymi niezbędnymi do przetwarzania. Organizacje powinny również uwzględnić przygotowanie danych (10-20% budżetu projektu) oraz zarządzanie zmianą, gdy zespoły dostosowują się do nowych praktyk optymalizacyjnych.

Sektor zdrowia, handel detaliczny, produkcja, tworzenie treści, obsługa klienta, rolnictwo oraz robotyka odnoszą znaczne korzyści. Służba zdrowia wykorzystuje ją do zwiększenia dokładności diagnoz, handel do odkrywania produktów, produkcja do kontroli jakości (100x szybsze katalogowanie), a firmy medialne zgłaszają 72% zwrotu z inwestycji w generatywne AI.

AmICited.com monitoruje, jak systemy AI takie jak ChatGPT, Perplexity i Google AI Overviews cytują Twoje treści w różnych modalnościach. Zapewnia wgląd na żywo w obecność Twoich treści w wyszukiwarkach AI, pomagając zrozumieć, jak Twoje teksty, obrazy i wideo są wykorzystywane w odpowiedziach generowanych przez AI.

Architektury zunifikowane przetwarzają wszystkie modalności przez jedną zintegrowaną sieć, zapewniając lepsze rozumowanie między modalnościami, ale wymagają więcej zasobów obliczeniowych. Architektury modułowe utrzymują osobne sieci dla każdej modalności, oferując większą elastyczność i wydajność. Modele Mixture of Experts (MoE) to podejście hybrydowe, zapewniające 30-50% poprawy efektywności.

Optymalizuj tekst za pomocą danych strukturalnych i języka konwersacyjnego, dodawaj opisowe teksty alternatywne i metadane do obrazów, zamieszczaj napisy i transkrypcje do wideo oraz stosuj spójne konwencje nazewnictwa plików. Upewnij się, że wszystkie modalności współpracują, aby zapewnić pełny kontekst, i wdrażaj oznaczenia schematów, by AI rozumiało relacje semantyczne.

Śledź, jak systemy AI multimodalnej cytują Twoje treści w ChatGPT, Perplexity, Google AI Overviews i innych platformach. Uzyskaj wgląd na żywo w obecność Twoich treści w wyszukiwarkach AI.

Dowiedz się, czym jest treść multimodalna dla AI, jak działa i dlaczego jest ważna. Poznaj przykłady systemów AI multimodalnej i ich zastosowania w różnych bran...

Dowiedz się, jak wielomodalne systemy wyszukiwania AI przetwarzają tekst, obrazy, dźwięk i wideo razem, aby dostarczać dokładniejsze i bardziej kontekstowe wyni...

Opanuj optymalizację wielomodalnego wyszukiwania AI. Dowiedz się, jak optymalizować obrazy i zapytania głosowe pod wyniki wyszukiwania wspierane przez AI, ze st...