Testowanie formatów treści pod kątem cytowań przez AI: projekt eksperymentu

Dowiedz się, jak testować formaty treści pod kątem cytowań przez AI, wykorzystując metodologię testów A/B. Odkryj, które formaty zapewniają najwyższą widoczność...

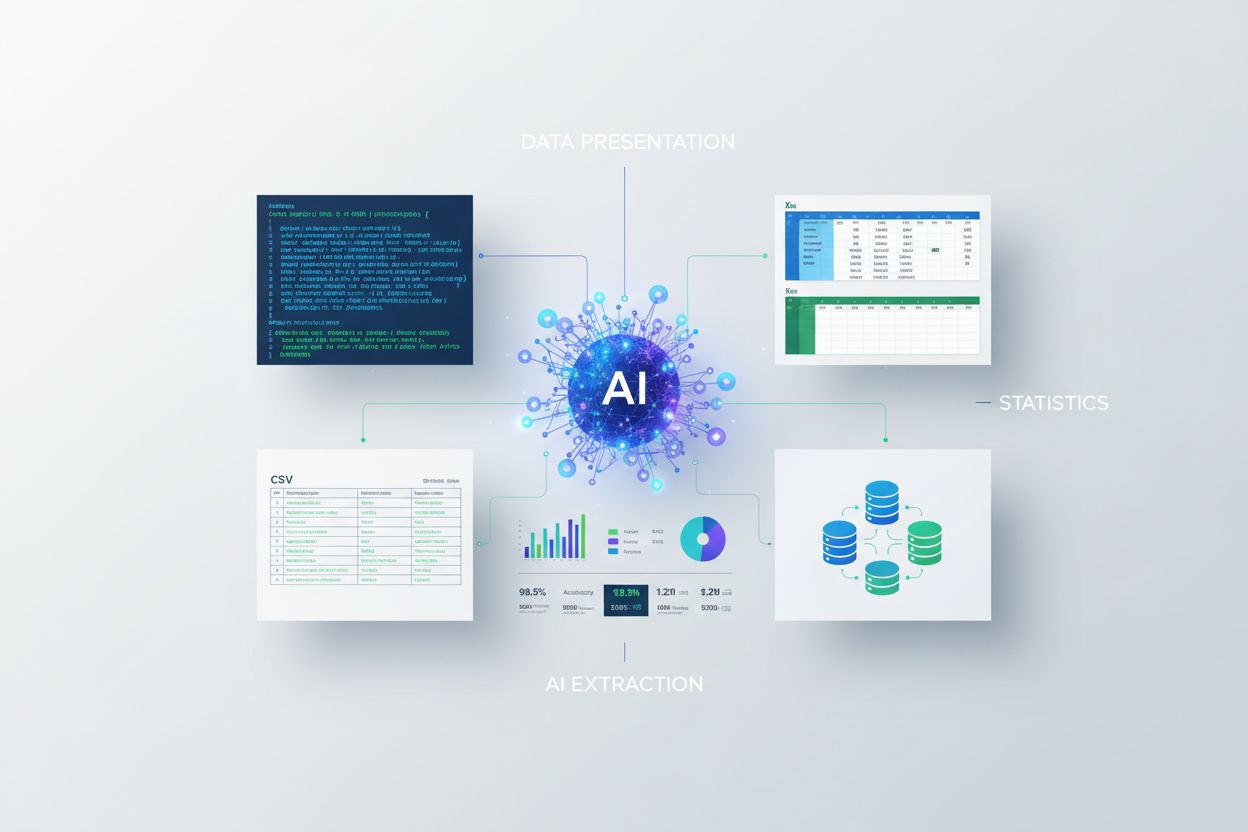

Dowiedz się, jak prezentować statystyki do ekstrakcji przez AI. Poznaj najlepsze praktyki formatowania danych, porównanie JSON vs CSV oraz jak przygotować dane do pracy z LLM i modelami AI.

Systemy sztucznej inteligencji przetwarzają informacje zasadniczo inaczej niż ludzie, przez co format danych staje się kluczowy dla skutecznej ekstrakcji. Gdy statystyki są prezentowane w formatach zoptymalizowanych pod kątem czytania maszynowego, modele AI potrafią analizować, rozumieć i wydobywać informacje z dużo większą precyzją i szybkością. Nieprawidłowe formatowanie danych zmusza systemy AI do poświęcania zasobów obliczeniowych na interpretację i korektę błędów, co prowadzi do wolniejszego przetwarzania i obniżonej niezawodności ekstrakcji. Wybrany przez Ciebie format bezpośrednio decyduje, czy model AI szybko zidentyfikuje istotne statystyki, czy też będzie zmagał się z niejasną prezentacją. W środowiskach korporacyjnych ta różnica przekłada się na wymierny wpływ biznesowy—organizacje korzystające z prawidłowo sformatowanych danych statystycznych notują 40-60% szybsze czasy przetwarzania przez AI w porównaniu do tych, które korzystają z niestrukturalnych prezentacji. Wiedza, jak prezentować statystyki do ekstrakcji przez AI, to nie tylko kwestia techniczna, ale i strategiczna przewaga wpływająca na efektywność operacyjną i dokładność danych.

Różnica pomiędzy prezentacją danych strukturalnych i niestrukturalnych zasadniczo wpływa na skuteczność wyodrębniania i przetwarzania statystyk przez systemy AI. Dane strukturalne podążają za zdefiniowanymi formatami z jasną organizacją, podczas gdy dane niestrukturalne występują w swobodnym tekście, obrazach lub mediach mieszanych, wymagając znacznej interpretacji. Mimo przewag danych strukturalnych, około 90% danych korporacyjnych pozostaje niestrukturalnych, co stanowi poważne wyzwanie dla organizacji chcących wykorzystać AI do ekstrakcji statystyk. Poniższa tabela przedstawia kluczowe różnice pomiędzy tymi podejściami:

| Format | Szybkość przetwarzania przez AI | Wskaźnik dokładności | Wydajność przechowywania | Zastosowania |

|---|---|---|---|---|

| Strukturalny (JSON/CSV) | 95-99% szybciej | 98-99% | 60-70% bardziej wydajny | Bazy danych, API, analityka |

| Niestrukturalny (Tekst/PDF) | Prędkość bazowa | 75-85% | Standardowe przechowywanie | Dokumenty, raporty, treści webowe |

| Półstrukturalny (XML/HTML) | 80-90% szybciej | 90-95% | 75-80% wydajności | Strony internetowe, logi, formaty mieszane |

Organizacje, które konwertują niestrukturalne dane statystyczne do formatów strukturalnych, odnotowują spektakularną poprawę wydajności ekstrakcji przez AI, a wskaźniki dokładności rosną z 75-85% do 98-99%. Wybór formatu powinien zależeć od konkretnego zastosowania, jednak prezentacja strukturalna pozostaje złotym standardem dla statystyk gotowych na AI.

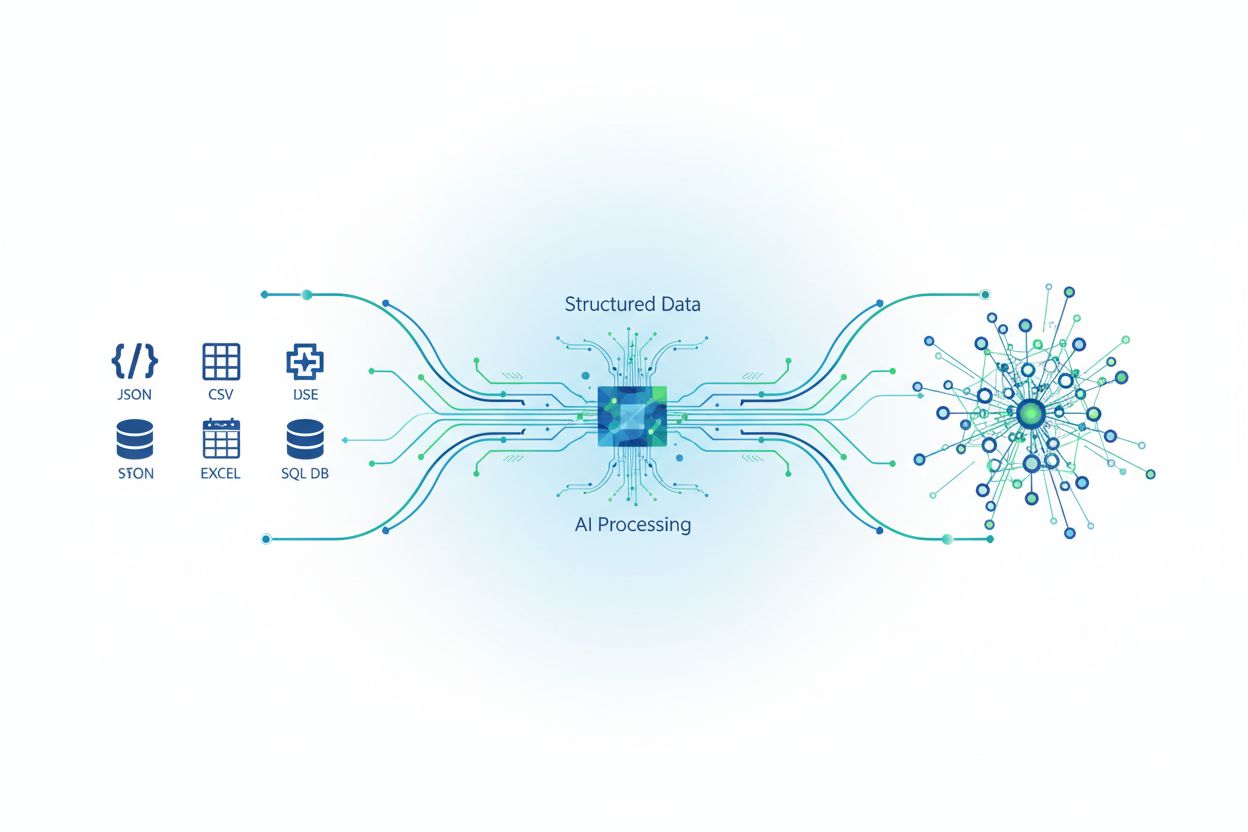

JSON i CSV to dwa najczęściej wykorzystywane formaty prezentacji statystyk dla systemów AI, każdy z nich ma swoje zalety w zależności od wymagań ekstrakcji. JSON (JavaScript Object Notation) świetnie nadaje się do reprezentowania hierarchicznych i zagnieżdżonych struktur danych, co czyni go idealnym do złożonych relacji statystycznych i zbiorów z bogatymi metadanymi. CSV (Comma-Separated Values) oferuje prostotę i uniwersalną kompatybilność, sprawdzając się doskonale przy płaskich, tabelarycznych danych statystycznych, które nie wymagają zagnieżdżonych relacji. Prezentując statystyki nowoczesnym LLM i narzędziom do ekstrakcji AI, JSON zwykle przetwarza się o 30-40% szybciej, dzięki natywnemu wsparciu typów danych i walidacji struktury. Oto praktyczne porównanie:

// Format JSON - lepszy dla złożonych statystyk

{

"quarterly_statistics": {

"q1_2024": {

"revenue": 2500000,

"growth_rate": 0.15,

"confidence_interval": 0.95

},

"q2_2024": {

"revenue": 2750000,

"growth_rate": 0.10,

"confidence_interval": 0.95

}

}

}

# Format CSV - lepszy dla prostych, płaskich statystyk

quarter,revenue,growth_rate,confidence_interval

Q1 2024,2500000,0.15,0.95

Q2 2024,2750000,0.10,0.95

Wybierz JSON, gdy Twoje statystyki zawierają zagnieżdżone relacje, wiele typów danych lub wymagają zachowania metadanych; używaj CSV w przypadku prostych danych tabelarycznych, gdy priorytetem jest prostota i szeroka kompatybilność. Konsekwencje wydajnościowe są istotne—walidacja struktury w JSON zmniejsza błędy ekstrakcji o 15-25% względem CSV przy pracy ze złożonymi zbiorami statystycznymi.

Prezentacja statystyk modelom uczenia maszynowego wymaga szczególnej dbałości o reprezentację danych liczbowych, normalizację i standardy spójności, które znacznie różnią się od formatów przyjaznych człowiekowi. Dane liczbowe muszą być prezentowane ze stałą precyzją i jasno określonym typem—liczby zmiennoprzecinkowe dla zmiennych ciągłych, liczby całkowite dla zliczeń oraz kodowanie kategoryczne dla klasyfikacji—by zapobiec błędnej interpretacji wartości przez AI. Techniki normalizacji i standaryzacji przekształcają surowe statystyki do zakresów, które algorytmy uczenia maszynowego przetwarzają najefektywniej, najczęściej skalując wartości do przedziału 0-1 lub konwertując do z-score (średnia 0, odchylenie standardowe 1). Spójność typów danych w całym zbiorze statystycznym jest bezwzględnie wymagana; mieszanie reprezentacji liczbowych jako ciągów tekstowych z wartościami liczbowymi prowadzi do błędów parsowania, które propagują się przez cały proces ekstrakcji. Metadane statystyczne—w tym jednostki miary, daty zbioru, przedziały ufności, źródła danych—muszą być dołączone wprost, ponieważ AI nie jest w stanie wywnioskować kontekstu tak jak człowiek. Braki danych wymagają jawnej obsługi poprzez udokumentowane strategie, takie jak imputacja średniej, forward-fill albo jawne znaczniki null, zamiast pozostawiania luk dezorientujących algorytmy. Organizacje wdrażające te standardy formatowania raportują poprawę dokładności modeli uczenia maszynowego przy przetwarzaniu danych statystycznych o 35-45%.

Wdrażanie najlepszych praktyk prezentacji statystycznej zapewnia, że systemy AI są w stanie niezawodnie wyodrębniać, przetwarzać i wykorzystywać Twoje dane przy minimalnej liczbie błędów lub konieczności powtórnego przetwarzania. Rozważ poniższe kluczowe praktyki:

Wdróż rygorystyczną walidację danych: Ustal reguły walidacji jeszcze przed wprowadzeniem statystyk do pipeline’u AI, sprawdzając spójność typów danych, zakresy wartości i zgodność z formatem. Chroni to przed uszkodzeniem wyników ekstrakcji przez wadliwe dane i redukuje błędy downstream o 50-70%.

Zdefiniuj jasną dokumentację schematu: Stwórz jednoznaczne definicje schematów opisujących każde pole, jego typ danych, dopuszczalne wartości oraz relacje z innymi polami. AI przetwarza dane z dokumentowanym schematem o 40% szybciej niż zbiory bez dokumentacji, ponieważ od razu rozumie strukturę i ograniczenia.

Dołącz pełne metadane: Dołączaj do każdego zbioru statystycznego informacje o metodologii zbioru, okresach czasu, poziomach ufności, jednostkach miary i źródle danych. Taki kontekst zapobiega błędnej interpretacji przez AI i umożliwia prawidłową analizę statystyczną.

Ustal procedury obsługi błędów: Zdefiniuj, jak Twój system AI ma reagować na braki danych, wartości odstające czy niespójności zanim się pojawią. Udokumentowana obsługa błędów zmniejsza liczbę niepowodzeń ekstrakcji o 60% i zapewnia spójność działania przy różnych przebiegach AI.

Prowadź kontrolę wersji: Śledź zmiany formatów statystycznych, schematów i standardów prezentacji przy użyciu systemów kontroli wersji. Pozwala to systemom AI poprawnie przetwarzać dane historyczne i umożliwia audyt zmian wpływających na dokładność ekstrakcji.

Automatyzuj kontrole jakości: Wdrażaj automatyczną walidację przed ekstrakcją AI, weryfikując kompletność danych, zgodność z formatem i sensowność statystyczną. Automatyczna QA wykrywa 85-90% błędów prezentacyjnych zanim wpłyną one na przetwarzanie przez AI.

Standardy prezentacji statystycznej przynoszą wymierne korzyści biznesowe w różnych branżach, gdzie ekstrakcja AI napędza efektywność operacyjną i podejmowanie decyzji. W bankowości i finansach instytucje prezentujące kwartalne statystyki w standaryzowanych formatach JSON z pełnymi metadanymi skróciły czas obsługi wniosków kredytowych o 35-40% i poprawiły skuteczność decyzji z 88% do 96%. Organizacje ochrony zdrowia wdrażające strukturalną prezentację danych wyników pacjentów, badań klinicznych i statystyk epidemiologicznych przyspieszyły analizę badań o 50% i ograniczyły błędy interpretacji danych o 45%. Platformy e-commerce wykorzystujące prawidłowo sformatowane statystyki stanów magazynowych, sprzedaży i metryk klienta umożliwiają systemom AI generowanie rekomendacji i prognoz popytu w czasie rzeczywistym z dokładnością 92-95% w porównaniu do 75-80% dla źródeł niestrukturalnych. Możliwości monitorowania AmICited są w tych scenariuszach szczególnie cenne, śledząc, jak systemy AI typu GPT i Perplexity wyodrębniają i cytują informacje statystyczne z Twoich danych, zapewniając dokładność i prawidłową atrybucję w treściach generowanych przez AI. Przewaga konkurencyjna jest znaczna—organizacje, które opanowały prezentację statystyk do ekstrakcji AI, notują 25-35% szybsze cykle decyzyjne i 20-30% poprawę wyników biznesowych opartych na AI.

Szeroki ekosystem narzędzi i technologii umożliwia organizacjom formatowanie, walidację i prezentację statystyk w sposób optymalny do ekstrakcji i przetwarzania przez AI. Narzędzia do ekstrakcji danych, takie jak Apache NiFi, Talend czy Informatica, oferują wizualne interfejsy do transformacji niestrukturalnych statystyk w formaty czytelne przez maszyny, zachowując integralność danych i ścieżki audytu. Frameworki API, takie jak FastAPI, Django REST Framework i Express.js, umożliwiają dostarczanie prawidłowo sformatowanych statystyk do systemów AI poprzez standardowe endpointy wymuszające walidację schematów i spójność typów danych. Systemy bazodanowe, w tym PostgreSQL, MongoDB oraz specjalistyczne hurtownie danych jak Snowflake i BigQuery, oferują natywne wsparcie dla strukturalnego przechowywania statystyk z wbudowaną walidacją, wersjonowaniem i optymalizacją wydajności dla zadań AI. Rozwiązania monitorujące, takie jak AmICited, śledzą, jak modele AI wyodrębniają i wykorzystują dane statystyczne z Twoich prezentacji, zapewniając wgląd w dokładność ekstrakcji, wzorce cytowań i potencjalne błędne interpretacje w GPT, Perplexity oraz Google AI Overviews. Platformy integracyjne, takie jak Zapier, MuleSoft i niestandardowe rozwiązania middleware, łączą źródła danych statystycznych z pipeline’ami ekstrakcji AI, zachowując spójność formatu i standardy jakości na każdym etapie procesu.

Nawet dobrze zorganizowane organizacje często popełniają błędy prezentacyjne, które znacząco obniżają wydajność i dokładność ekstrakcji przez AI. Niespójne formatowanie—mieszanie różnych formatów dat, reprezentacji liczb czy jednostek miary w jednym zbiorze danych—zmusza systemy AI do dodatkowej interpretacji i wprowadza niejednoznaczność, która obniża dokładność ekstrakcji o 15-25%. Brakujące lub niepełne metadane to kolejny krytyczny błąd; statystyki prezentowane bez kontekstu metodologii zbioru, okresów czy przedziałów ufności prowadzą do błędnych założeń i generowania niewiarygodnych ekstrakcji przez AI. Słaba jakość danych, obejmująca nieaktualne informacje, duplikaty lub niewalidowane statystyki, podważa cały proces ekstrakcji, ponieważ AI nie jest w stanie odróżnić wiarygodnych i niewiarygodnych danych bez jawnych wskaźników jakości. Nieprawidłowe typy danych—np. przechowywanie statystyk liczbowych jako tekst, dat jako nieustrukturyzowany tekst lub mieszanie zmiennych kategorycznych z ciągłymi—uniemożliwiają AI przeprowadzanie operacji matematycznych i porównań niezbędnych do prawidłowej analizy statystycznej. Brak dokumentacji dotyczącej standardów prezentacji, definicji schematów i procedur kontroli jakości tworzy luki wiedzy skutkujące niespójnym postępowaniem podczas kolejnych uruchomień AI i pracy różnych członków zespołu. Organizacje, które systematycznie eliminują te błędy, raportują wzrost dokładności ekstrakcji o 40-60% i spadek liczby błędów przetwarzania przez AI o 30-50%.

Obszar prezentacji statystyk do ekstrakcji przez AI ewoluuje bardzo dynamicznie, napędzany rozwojem możliwości AI i pojawianiem się nowych branżowych standardów kształtujących sposób formatowania i udostępniania danych. Coraz większe znaczenie zyskują standardy takie jak JSON Schema, specyfikacje YAML oraz technologie semantycznej sieci (RDF, OWL) istotne dla systemów AI wymagających nie tylko struktury danych, ale również definicji znaczeń i relacji. Architektury strumieniowania danych w czasie rzeczywistym, jak Apache Kafka, AWS Kinesis i inne, umożliwiają systemom AI przetwarzanie nieustannie aktualizowanych statystyk z minimalnym opóźnieniem, wspierając przypadki użycia wymagające natychmiastowej ekstrakcji i analizy dynamicznych danych. Technologie semantycznej sieci są coraz szerzej implementowane, ponieważ organizacje dostrzegają, że AI korzysta z jawnych definicji relacji i ontologii opisujących powiązania między statystykami a pojęciami biznesowymi i wiedzą dziedzinową. Automatyczna kontrola jakości oparta na uczeniu maszynowym staje się coraz popularniejszym rozwiązaniem—systemy AI uczą się wykrywać anomalie prezentacyjne, weryfikować sensowność statystyczną oraz sygnalizować potencjalne problemy z jakością danych, zanim trafią one do analityków lub kolejnych systemów AI. Wymagania dużych modeli językowych stale ewoluują—nowsze modele lepiej radzą sobie z ekstrakcją z różnych formatów, jednocześnie generując zapotrzebowanie na jeszcze bardziej strukturalne i bogate w metadane prezentacje, umożliwiające precyzyjne cytowanie i atrybucję. Organizacje przygotowujące się na te trendy poprzez inwestycje w elastyczne, oparte na standardach architektury prezentacji statystyk zachowają przewagę konkurencyjną, gdy możliwości ekstrakcji AI będą dojrzewać, a oczekiwania wobec jakości i transparentności danych stale wzrastać.

Najlepszy format zależy od złożoności danych. JSON sprawdza się najlepiej przy hierarchicznych i zagnieżdżonych statystykach z bogatymi metadanymi, natomiast CSV jest najlepszy dla prostych, płaskich danych tabelarycznych. JSON zwykle przetwarza złożone statystyki o 30-40% szybciej dzięki natywnemu wsparciu typów danych, ale CSV oferuje większą prostotę i uniwersalną kompatybilność. Wybierz JSON dla nowoczesnych systemów AI i API, CSV dla prostych analiz i kompatybilności z arkuszami kalkulacyjnymi.

Format danych bezpośrednio wpływa na dokładność ekstrakcji poprzez spójność, zachowanie metadanych i walidację typów. Odpowiednio sformatowane dane strukturalne osiągają dokładność 98-99% w porównaniu do 75-85% dla danych niestrukturalnych. Spójność formatu zapobiega błędom parsowania, jawne metadane zapobiegają błędnej interpretacji, a właściwe typy danych umożliwiają operacje matematyczne. Organizacje wdrażające standardy formatowania odnotowują poprawę dokładności ekstrakcji o 40-60%.

Tak, ale z istotnymi ograniczeniami. Modele AI mogą przetwarzać dane niestrukturalne za pomocą przetwarzania języka naturalnego i uczenia maszynowego, ale dokładność spada do 75-85% w porównaniu z 98-99% dla danych strukturalnych. Dane niestrukturalne wymagają wstępnego przetwarzania, konwersji do formatów strukturalnych oraz dodatkowych zasobów obliczeniowych. Dla optymalnej wydajności ekstrakcji przez AI zdecydowanie zaleca się konwersję niestrukturalnych statystyk do formatów strukturalnych.

Podstawowe metadane to jednostki miary, daty zbioru i okresy czasowe, przedziały ufności i poziomy istotności statystycznej, atrybucja źródła danych, metodologia zbierania oraz wskaźniki jakości danych. Ten kontekst zapobiega błędnej interpretacji przez AI i umożliwia prawidłową analizę statystyczną. Jawne dołączanie metadanych zmniejsza liczbę błędów ekstrakcji o 15-25% i pozwala AI na prawidłowe cytowanie oraz osadzenie statystyk w kontekście.

Wdróż rygorystyczną walidację danych, zdefiniuj jasną dokumentację schematu, dołącz pełne metadane, ustal procedury obsługi błędów, prowadź kontrolę wersji i automatyzuj kontrole jakości. Waliduj typy danych i zakresy wartości przed przetwarzaniem przez AI, dokumentuj każde pole i relację, dołącz metodykę zbioru oraz poziomy ufności i uruchamiaj automatyczną kontrolę jakości, która wychwyci 85-90% błędów prezentacyjnych przed rozpoczęciem pracy AI.

AmICited śledzi, jak systemy AI, takie jak GPT, Perplexity czy Google AI Overviews, wyodrębniają i cytują Twoje dane statystyczne. Platforma monitoruje dokładność ekstrakcji, wzorce cytowań oraz potencjalne błędne interpretacje w treściach generowanych przez AI. Dzięki temu masz pewność prawidłowej atrybucji swoich statystyk i możesz wykryć przypadki błędnej interpretacji lub prezentacji przez AI, co umożliwia poprawę formatowania danych.

Przed rozpoczęciem przetwarzania przez AI jasno udokumentuj strategię obsługi braków danych. Opcje to imputacja średniej dla zmiennych ciągłych, metoda forward-fill dla szeregów czasowych, jawne znaczniki null lub wykluczenie z dokumentacją. Nigdy nie pozostawiaj luk, które mogą zdezorientować algorytmy ekstrakcji. Udokumentowana obsługa błędów zmniejsza liczbę niepowodzeń ekstrakcji o 60% i zapewnia spójność działania przy wielokrotnym przetwarzaniu przez AI.

JSON przetwarza złożone statystyki o 30-40% szybciej dzięki natywnemu wsparciu typów danych i walidacji struktury, zmniejszając liczbę błędów ekstrakcji o 15-25%. CSV oferuje szybsze parsowanie dla prostych, płaskich danych oraz mniejsze rozmiary plików (o 60-70% bardziej wydajnie), ale nie obsługuje struktur zagnieżdżonych i walidacji typów danych. Wybierz JSON dla złożonych, hierarchicznych statystyk; CSV dla prostych, tabelarycznych danych, gdzie liczy się szybkość i kompatybilność.

AmICited śledzi, jak modele AI i LLM cytują Twoje dane i statystyki w GPT, Perplexity oraz Google AI Overviews. Zapewnij swojej marce prawidłową atrybucję.

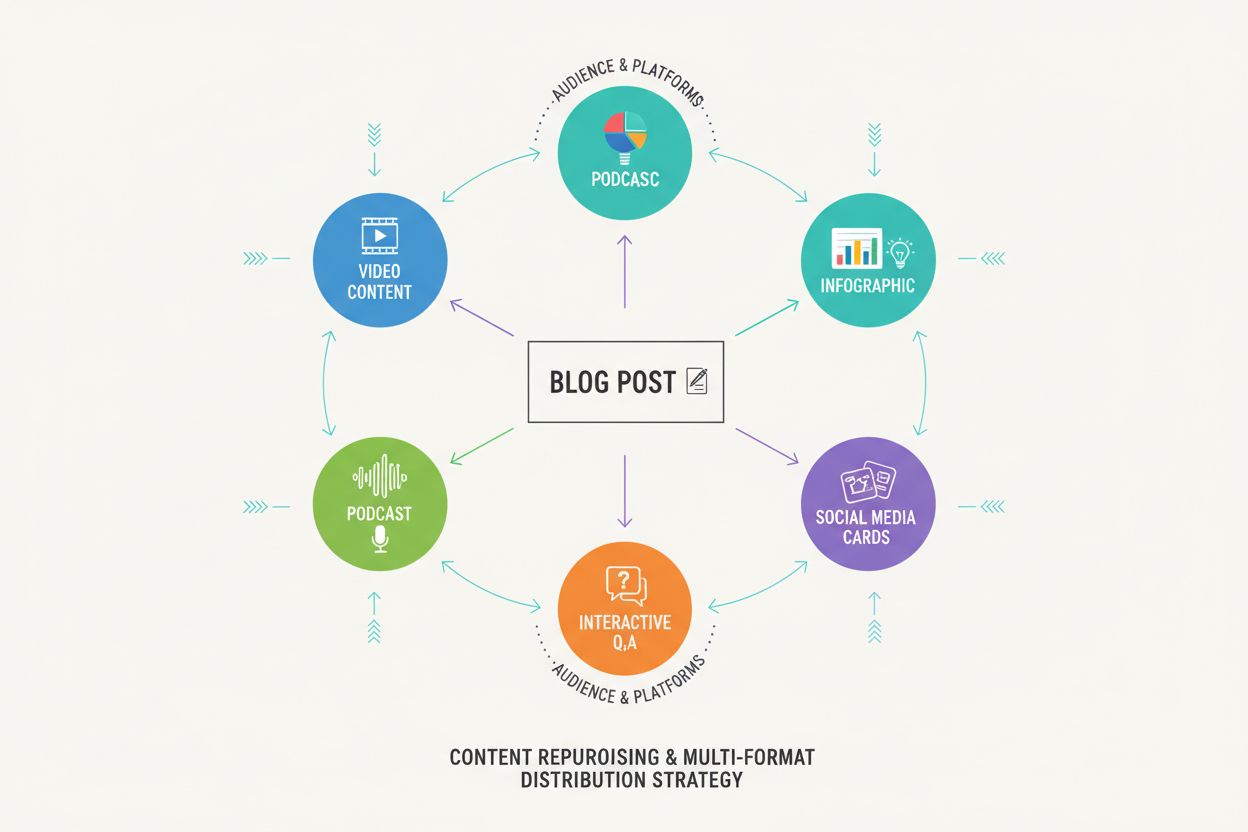

Dowiedz się, jak testować formaty treści pod kątem cytowań przez AI, wykorzystując metodologię testów A/B. Odkryj, które formaty zapewniają najwyższą widoczność...

Dowiedz się, dlaczego tabele są kluczowe dla optymalizacji wyszukiwania AI. Odkryj, jak uporządkowane dane w tabelach poprawiają zrozumienie przez AI, zwiększaj...

Dowiedz się, jak treści w wielu formatach zwiększają widoczność w AI, takich jak ChatGPT, Google AI Overview i Perplexity. Poznaj 5-etapowy framework maksymaliz...