Przejrzystość rankingu AI

Dowiedz się, czym jest przejrzystość rankingu AI, dlaczego ma znaczenie dla twórców treści i użytkowników oraz jak różne platformy AI, takie jak Perplexity, Goo...

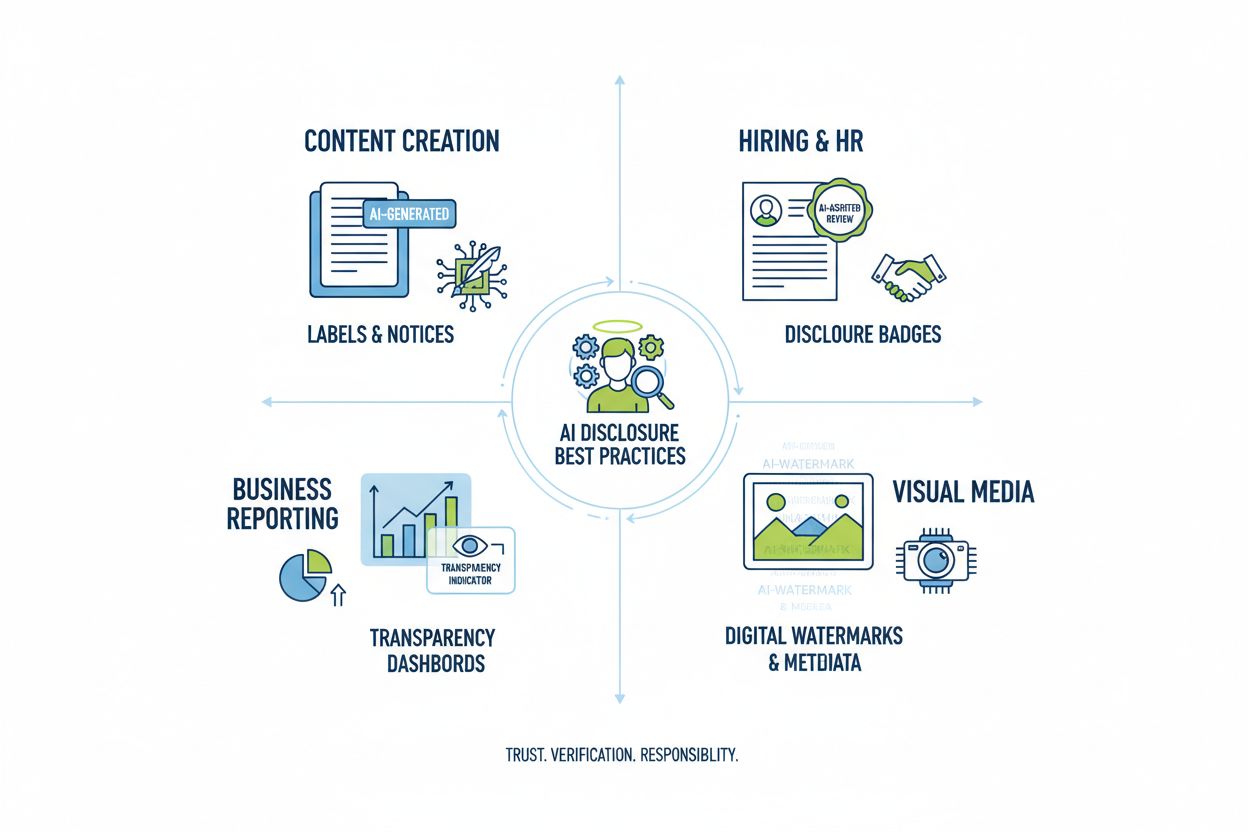

Poznaj niezbędne najlepsze praktyki przejrzystości i ujawniania AI. Odkryj behawioralne, werbalne i techniczne metody ujawniania, aby budować zaufanie i zapewnić zgodność z ewoluującymi regulacjami dotyczącymi AI.

Przejrzystość AI stała się krytycznym wymogiem w epoce, w której systemy sztucznej inteligencji wpływają na wszystko – od tworzenia treści po decyzje rekrutacyjne i finansowe. Wraz z rozprzestrzenianiem się treści generowanych przez AI w cyfrowych kanałach, organizacje stają przed rosnącą presją, by ujawniać, kiedy i jak korzystają z tych technologii – nie tylko z powodów prawnych, ale jako podstawowy warunek utrzymania zaufania i wiarygodności wobec swoich odbiorców. Stawka jest szczególnie wysoka dla marek i twórców treści, ponieważ konsumenci coraz częściej chcą wiedzieć, czy konsumowane informacje pochodzą z ludzkiej wiedzy, czy są wynikiem działania algorytmów. Brak przejrzystych praktyk ujawniania grozi utratą zaufania budowanego latami i wiąże się z ryzykiem utraty reputacji, sankcji regulacyjnych oraz spadku zaufania odbiorców. Relacja między przejrzystością a wiarygodnością jest symbiotyczna – organizacje, które proaktywnie ujawniają użycie AI, demonstrują uczciwość i szacunek wobec interesariuszy, pozycjonując się jako godni zaufania uczestnicy coraz bardziej zautomatyzowanego świata.

Rozprzestrzenianie się treści generowanych przez AI stworzyło głęboki paradoks zaufania: odbiorcy mają trudność z rozróżnieniem autentycznych, stworzonych przez człowieka dzieł i wyrafinowanych alternatyw generowanych przez AI, a przejrzystość dotycząca użycia AI jest wciąż niejednolita w różnych branżach. To zamieszanie podważa podstawowy kontrakt między twórcą a odbiorcą, w którym odbiorcy oczekują wiedzy o prawdziwym pochodzeniu konsumowanych treści. Prezentowanie treści generowanych przez AI bez ujawnienia narusza tę niepisaną umowę, tworząc dychotomię „prawdziwe kontra fałszywe”, która wykracza poza kwestie autentyczności – dotyka problemów związanych z dezinformacją, manipulacją oraz świadomą zgodą. Paradoks pogłębia się, ponieważ niektóre treści AI mogą być nie do odróżnienia od prac ludzkich pod względem jakości i stylu, przez co wizualne lub stylistyczne wskazówki stają się zawodne. Przejrzystość ma znaczenie właśnie dlatego, że rozwiązuje ten paradoks, dając odbiorcom informacje niezbędne do świadomego wyboru, jakim treściom zaufać. Organizacje, które stosują jasne praktyki ujawniania, zamieniają potencjalny sceptycyzm w zaufanie, pokazując, że nie mają nic do ukrycia i wszystko do zyskania poprzez uczciwą komunikację.

Otoczenie regulacyjne dotyczące ujawniania AI dynamicznie się zmienia – różne jurysdykcje wdrażają lub proponują wymogi, z którymi organizacje muszą się ostrożnie mierzyć. Unijna ustawa o AI (EU AI Act), jedno z najbardziej kompleksowych rozwiązań, nakazuje, by treści generowane lub istotnie edytowane przez AI były oznaczone widocznym ujawnieniem lub metadanymi, ze szczególnymi wymaganiami dla systemów AI wysokiego ryzyka i obowiązkami przejrzystości dla twórców tych systemów. W Stanach Zjednoczonych FTC ostrzega, że brak aktualizacji warunków użytkowania i polityki prywatności w kontekście AI może być uznany za praktyki wprowadzające w błąd, a regulacje stanowe – szczególnie kalifornijska AI Frontier Model Law – nakładają obowiązki sprawozdawcze i przejrzystości na twórców dużych systemów AI. Prawo autorskie i własność intelektualna dodatkowo komplikują sytuację: organizacje muszą ujawniać, czy dane treningowe obejmowały chronione materiały oraz jak szkolono systemy AI. Dodatkowo, wymogi RODO (GDPR) i CCPA obejmują systemy AI przetwarzające dane osobowe, nakazując ujawnianie zautomatyzowanego podejmowania decyzji i dostarczanie osobom informacji o przetwarzaniu przez AI. Poniższa tabela podsumowuje kluczowe wymogi regulacyjne w głównych jurysdykcjach:

| Jurysdykcja | Regulacja | Kluczowe wymagania | Data wejścia w życie |

|---|---|---|---|

| Unia Europejska | EU AI Act | Ujawnianie dla AI wysokiego ryzyka; raporty przejrzystości; oznaczanie metadanymi treści AI | W etapach (2024-2026) |

| USA (federalny) | Wytyczne FTC | Aktualizacja polityk prywatności; ujawnianie wykorzystania AI; unikanie praktyk wprowadzających w błąd | Na bieżąco |

| Kalifornia | AI Frontier Model Law | Standaryzowane ujawnianie; obowiązki sprawozdawcze; środki bezpieczeństwa | 2025 |

| Unia Europejska | RODO | Ujawnianie zautomatyzowanego podejmowania decyzji; informowanie o przetwarzaniu przez AI | Na bieżąco |

| USA (wiele stanów) | CCPA i podobne | Ujawnianie wykorzystania danych w systemach AI; mechanizmy rezygnacji | Zależnie od stanu |

| Międzynarodowe | Zagadnienia autorskie | Ujawnianie źródeł danych treningowych; kwestie praw autorskich w wynikach AI | W fazie wdrażania |

Organizacje działające w różnych jurysdykcjach powinny wdrażać praktyki ujawniania spełniające najbardziej rygorystyczne wymogi, gdyż zgodność z jednym standardem często oznacza spełnienie minimum dla innych.

Sygnały behawioralne to najbardziej subtelna, a zarazem silna forma ujawniania udziału AI, opierająca się na prezentacji, stylu, głosie i wyborach kreatywnych, które odbiorcy nieświadomie analizują, oceniając autentyczność treści. Należą do nich charakterystyczne wzorce stylu pisania, spójność głosu, wybory kompozycji wizualnej, cechy awatarów lub person oraz ogólna „wiarygodność” twórcy – czyli stopień odzwierciedlenia autentycznej ludzkiej osobowości i procesu decyzyjnego w treści. Przykładowo, teksty AI wykazują często specyficzne schematy budowy zdań, doboru słownictwa i logicznego wywodu, różniące się od stylu ludzkiego, a obrazy generowane przez AI mogą zdradzać subtelne niekonsekwencje w oświetleniu, anatomii czy tle, które wyłapują wprawni obserwatorzy. Kluczowe jest tu pojęcie wiarygodności twórcy: odbiorcy wyrabiają sobie oczekiwania co do sposobu wypowiedzi, wyglądu i prezentacji danego twórcy, a odstępstwa od tego wzorca mogą sygnalizować udział AI. Jednak poleganie wyłącznie na sygnałach behawioralnych jest problematyczne, ponieważ AI coraz lepiej imituje ludzkie cechy, a odbiorcy nie powinni być zmuszani do bycia ekspertami od wykrywania AI. Sygnały behawioralne powinny więc uzupełniać, a nie zastępować jawne metody ujawniania, stanowiąc dodatkową warstwę przejrzystości wzmacniającą jasną komunikację o udziale AI.

Strategie ujawniania werbalnego polegają na jednoznacznym, bezpośrednim komunikowaniu użycia AI za pomocą sygnałów językowych, które nie pozostawiają wątpliwości co do pochodzenia treści i udziału AI. Metody te są kluczowe, gdyż tworzą jasny, udokumentowany ślad ujawnienia i zapewniają odbiorcom niebudzące wątpliwości informacje o wykorzystaniu AI. Organizacje mogą wdrażać werbalne ujawnianie na różne sposoby:

Dopasowanie odpowiedniej metody zależy od kontekstu: etykiety sprawdzają się w social media i treściach wizualnych, znaki wodne – wideo i audio, byliny – treści dziennikarskie i kreatywne, pola ujawniania – dłuższa forma, a podziękowania – złożone projekty. Organizacje powinny dobierać metody do formatu treści i oczekiwań odbiorców, tak by ujawnienie było oczywiste, a jednocześnie nieinwazyjne dla użytkownika.

Sygnały techniczne i metadane zapewniają maszynowo odczytywane, standaryzowane informacje o udziale AI, umożliwiając automatyczne wykrywanie, weryfikację i śledzenie treści generowanych przez AI w ekosystemach cyfrowych. Metody te wykorzystują osadzone dane i techniki kryptograficzne do tworzenia trwałych, odpornych na manipulacje zapisów pochodzenia treści i historii jej przetwarzania. Standardy IPTC, niedawno rozszerzone o właściwości dedykowane AI, pozwalają twórcom bezpośrednio w plikach graficznych osadzać informacje o użyciu AI, w tym dane o użytych systemach i wprowadzonych przez człowieka modyfikacjach. C2PA (Coalition for Content Provenance and Authenticity) to powstający standard branżowy, wykorzystujący podpisy kryptograficzne i poświadczenia treści do ustanowienia weryfikowalnych łańcuchów pochodzenia, dzięki czemu odbiorcy mogą prześledzić całą historię treści i wszystkie wprowadzone zmiany. Techniczne metody ujawniania rozwiązują kluczowy problem ujawniania odczytywanego przez człowieka: tworzą trwałe, weryfikowalne zapisy niemożliwe do łatwego usunięcia lub zmiany oraz umożliwiają automatycznym systemom masowe wykrywanie treści AI. Organizacje wdrażające techniczne ujawnianie powinny rozważyć poświadczenia C2PA dla treści wysokiej wartości, osadzanie metadanych IPTC w plikach graficznych i multimedialnych oraz prowadzenie szczegółowej dokumentacji cyfrowych typów źródła odnotowującej udział AI w całym cyklu życia treści. Atutem sygnałów technicznych jest ich trwałość i weryfikowalność; wyzwaniem – zapewnienie, że odbiorcy i platformy rozumieją i respektują te sygnały.

Skuteczne ujawnianie AI wymaga instytucjonalizacji praktyk przejrzystości w całym cyklu tworzenia treści, przekształcając ujawnianie z dodatku w fundamentalny element zarządzania treścią. Organizacje powinny wdrażać ustrukturyzowane modele treści, które rejestrują udział AI na każdym etapie – od badań i szkicowania, przez edycję, po publikację – tak, by informacje o ujawnianiu naturalnie przepływały przez systemy zarządzania treścią. Automatyzacja i integracja workflow są tu kluczowe: systemy CMS powinny zawierać obowiązkowe pola ujawniania AI, automatyczne przypomnienia wymagające od twórców udokumentowania użycia AI przed publikacją i workflow z zatwierdzeniami weryfikującymi kompletność ujawnienia przed emisją treści. Takie podejście traktuje ujawnianie jako wymóg jakościowy, na równi z fact-checkingiem, zgodnością prawną czy zgodnością z marką. Organizacje powinny także ustalić jasne polityki określające, co wymaga ujawnienia (np. czy wykorzystanie AI do researchu wymaga ujawnienia? A korekta przez AI?), by zapewnić spójność i uniknąć luk w ujawnianiu. Równie ważne są szkolenia i dokumentacja: twórcy treści muszą wiedzieć, jak prawidłowo ujawniać AI w różnych typach i na różnych platformach treści. Wdrażając ujawnianie w modelach i procesach, organizacje czynią przejrzystość standardową procedurą chroniącą zarówno siebie, jak i odbiorców.

Różne zastosowania AI wymagają dostosowanych metod ujawniania uwzględniających kontekst, oczekiwania odbiorców i wymogi regulacyjne. Tworzenie treści (artykuły, social media, copywriting) powinno obejmować wyraźne etykiety lub modyfikacje bylin, wskazujące udział AI, a także dodatkowe pola ujawniania wyjaśniające użyte narzędzia AI i zakres nadzoru człowieka – szczególnie ważne w treściach newsowych i redakcyjnych, gdzie zaufanie zależy od wiedzy o pochodzeniu. Rekrutacja i zatrudnianie wymagają najbardziej rygorystycznego ujawniania – kandydaci mają prawo wiedzieć, kiedy AI analizuje ich zgłoszenia lub przeprowadza wstępną selekcję, wraz ze szczegółowym wyjaśnieniem działania algorytmu i procesu ludzkiej weryfikacji. Raportowanie i analizy (raporty finansowe, badania rynku, analizy danych) powinny zawierać ujawnienia techniczne i metadane wskazujące, które analizy były wspomagane przez AI, szczególnie gdy systemy AI wykryły wzorce lub wygenerowały istotne wnioski. Treści wizualne (obrazy, wideo, grafiki) wymagają zarówno znaków wodnych, jak i ujawnienia w metadanych, ponieważ odbiorcy nie są w stanie samodzielnie rozpoznać treści AI – to szczególnie istotne w fotografii newsowej, zdjęciach produktów i wszelkiej treści, gdzie autentyczność wpływa na decyzje zakupowe i zaufanie. Komunikacja z klientem (chatboty, automatyczne odpowiedzi, obsługa klienta) powinna już na początku interakcji jasno informować o udziale AI i umożliwiać klientowi wybór kontaktu z człowiekiem. Organizacje powinny przeprowadzić audyt zastosowań AI i wdrożyć adekwatne praktyki ujawniania, proporcjonalne do wrażliwości i skutków każdego przypadku, pamiętając, że wymagania przejrzystości zależą od wpływu AI na odbiorców.

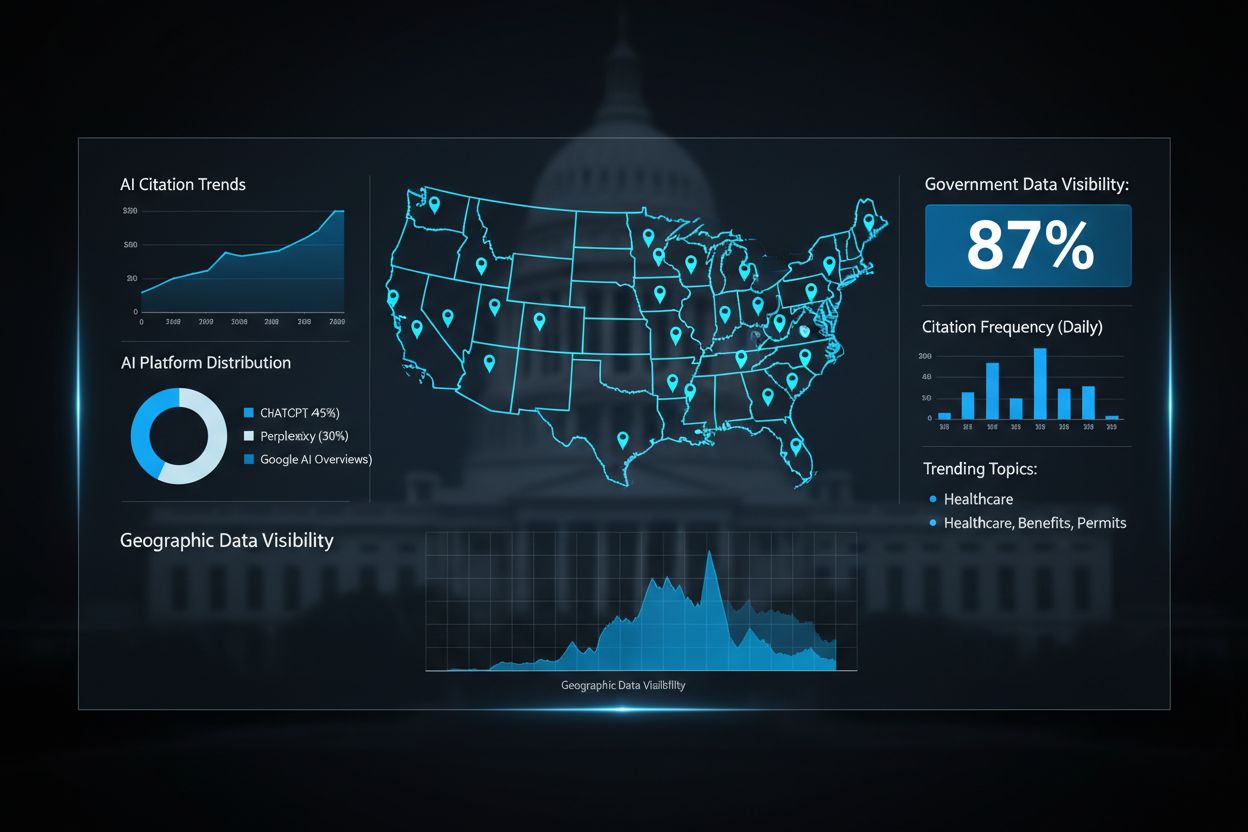

Przyszłość ujawniania AI zależy od standaryzacji na poziomie branży i rozwoju interoperacyjnych ram umożliwiających spójną, porównywalną przejrzystość między organizacjami i platformami. Powstające standardy takie jak C2PA, specyfikacje metadanych IPTC czy Ramy Zarządzania Ryzykiem AI NIST stanowią fundament, ale szerokie wdrożenie wymaga skoordynowanej współpracy dostawców technologii, twórców treści, regulatorów i ciał branżowych. Unijna ustawa o AI oraz podobne regulacje wymuszają standaryzację poprzez określenie formatów ujawniania i wymagań informacyjnych, co zwiększa presję na wdrożenie wspólnych standardów w całej branży. Inicjatywy branżowe takie jak etyczne wytyczne PRSA czy ramy raportowania przejrzystości pokazują rosnący konsensus wokół najlepszych praktyk ujawniania, choć dobrowolna adopcja wciąż bywa niejednolita. Kluczowym krokiem jest przejście od dobrowolnych standardów do wymogów regulacyjnych nakazujących ujednolicone ujawnianie – podobnie jak etykiety żywieniowe FDA zrewolucjonizowały przejrzystość w branży spożywczej. Platformy monitoringu i widoczności – takie jak AmICited.com – odgrywają coraz większą rolę, śledząc, jak AI odnosi się do marek i treści w generowanych odpowiedziach, dając organizacjom wgląd w to, jak ich praca pojawia się w wynikach AI i czy jest właściwie oznaczana. Wraz z rosnącą złożonością i wszechobecnością AI, zdolność monitorowania, weryfikacji i audytu praktyk ujawniania staje się kluczowa dla utrzymania zaufania do informacji cyfrowych. Organizacje, które już dziś inwestują w solidne praktyki ujawniania i monitoringu, będą najlepiej przygotowane do sprostania ewoluującym regulacjom i utrzymania zaufania odbiorców w świecie napędzanym przez AI.

Ujawnienie behawioralne wykorzystuje wybory prezentacyjne (styl, głos, awatar), aby sygnalizować udział AI. Ujawnienie werbalne opiera się na wyraźnych komunikatach, etykietach i znakach wodnych. Ujawnienie techniczne polega na umieszczaniu metadanych odczytywanych przez maszyny oraz podpisów kryptograficznych. Każda metoda służy różnym odbiorcom i kontekstom, a organizacje powinny stosować kilka metod jednocześnie dla pełnej przejrzystości.

Wymogi prawne różnią się w zależności od jurysdykcji. Unijna ustawa o AI nakazuje ujawnianie dla systemów AI wysokiego ryzyka. FTC wymaga ujawnienia, gdy użycie AI może wpłynąć na decyzje konsumentów. Prawa stanowe, jak kalifornijska AI Frontier Model Law, nakładają obowiązki sprawozdawcze. Prawo autorskie wymaga ujawniania treści generowanych przez AI. Organizacje powinny skonsultować się z prawnikiem w sprawie wymogów obowiązujących w danym kraju.

Obrazy wygenerowane przez AI powinny zawierać zarówno widoczne znaki wodne, jak i ujawnienie w metadanych. Znaki wodne powinny być widoczne, ale nieinwazyjne, wyraźnie wskazując na pochodzenie AI. Metadane powinny zawierać informacje IPTC o cyfrowym typie źródła i poświadczenia C2PA, jeśli są dostępne. Podpisy i pola ujawniania powinny jasno wskazywać, że obrazy są generowane przez AI, zwłaszcza w przypadku treści informacyjnych, produktowych lub promocyjnych.

Standardy IPTC dostarczają strukturalnych pól metadanych do dokumentowania użycia AI w obrazach i plikach multimedialnych. Umożliwiają automatyczne wykrywanie i śledzenie treści generowanych przez AI w różnych platformach. Kategorie IPTC digital source type obejmują „Trained Algorithmic Media”, „Composite Synthetic” i „Algorithmic Media”. Standardy te są ważne, ponieważ tworzą trwałe, weryfikowalne zapisy udziału AI, których nie można łatwo usunąć lub zmodyfikować.

Firmy powinny przeprowadzić audyt AI w celu zidentyfikowania wszystkich zastosowań AI, opracować polityki ujawniania zgodnie z obowiązującymi regulacjami, zintegrować ujawnianie z procesami zarządzania treścią, przeszkolić zespoły z wymagań dotyczących ujawniania oraz regularnie monitorować zgodność. Kluczowa jest konsultacja z ekspertami prawnymi znającymi regulacje AI w danym kraju, ponieważ wymagania znacznie różnią się w zależności od regionu.

Konsekwencje to m.in. kary regulacyjne (grzywny FTC, naruszenia prawa stanowego), utrata reputacji i zaufania odbiorców, odpowiedzialność prawna za naruszenie praw autorskich lub praktyki wprowadzające w błąd oraz potencjalne pozwy od poszkodowanych stron. Organizacje, które nie ujawniają wykorzystania AI, ryzykują utratę wiarygodności budowanej latami, dlatego proaktywne ujawnianie to inwestycja w długoterminowe zaufanie.

Różni interesariusze potrzebują różnego poziomu informacji. Szeroka publiczność oczekuje prostych, jasnych komunikatów o udziale AI. Regulatorzy wymagają szczegółowej dokumentacji technicznej i dowodów zgodności. Dziennikarze i twórcy treści potrzebują informacji o narzędziach AI i nadzorze człowieka. Klienci powinni rozumieć, jak AI wpływa na ich doświadczenie. Format i szczegółowość ujawniania należy dostosować do potrzeb i oczekiwań każdej grupy odbiorców.

C2PA (Coalition for Content Provenance and Authenticity) dostarcza kryptograficznych poświadczeń weryfikujących treści. Standardy IPTC umożliwiają osadzanie metadanych w obrazach. Systemy zarządzania treścią coraz częściej zawierają pola ujawniania AI. Platformy monitorujące, takie jak AmICited.com, śledzą odniesienia do AI i widoczność. Ramy branżowe PRSA, NIST i innych stanowią przewodniki. Wdrażanie tych narzędzi i standardów przyspiesza wraz z zaostrzaniem regulacji.

Śledź, jak systemy AI odnoszą się do Twojej marki w GPT, Perplexity i Google AI Overviews. Zapewnij swojej treści właściwe przypisanie i widoczność w odpowiedziach generowanych przez AI.

Dowiedz się, czym jest przejrzystość rankingu AI, dlaczego ma znaczenie dla twórców treści i użytkowników oraz jak różne platformy AI, takie jak Perplexity, Goo...

Poznaj przyszłość monitorowania widoczności AI – od standardów transparentności po zgodność z regulacjami. Dowiedz się, jak marki mogą przygotować się na krajob...

Dowiedz się, jak instytucje rządowe mogą zoptymalizować swoją obecność cyfrową dla systemów AI takich jak ChatGPT i Perplexity. Poznaj strategie poprawy widoczn...