Wykrywanie kryzysów widoczności AI: wczesne sygnały ostrzegawcze

Dowiedz się, jak wcześnie wykrywać kryzysy widoczności AI dzięki monitorowaniu w czasie rzeczywistym, analizie sentymentu i wykrywaniu anomalii. Poznaj sygnały ...

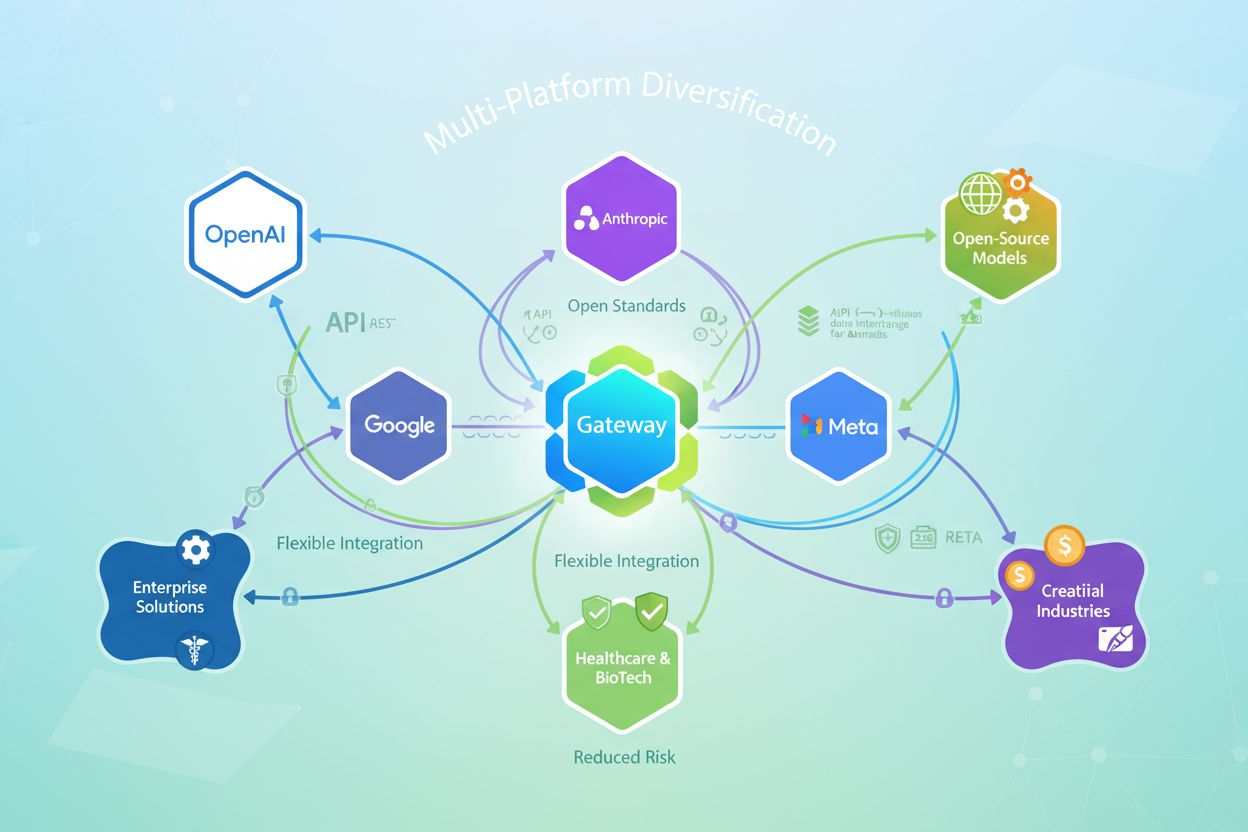

Strategia budowania widoczności i dostępu na wielu platformach AI w celu zmniejszenia ryzyka uzależnienia od jednego dostawcy, optymalizacji kosztów oraz utrzymania elastyczności strategicznej. Organizacje rozkładają swoje obciążenia AI na różnych dostawców, zamiast polegać na jednym, co umożliwia lepszą pozycję negocjacyjną, większą odporność i możliwość wdrażania najlepszych rozwiązań w miarę ich pojawiania się.

Strategia budowania widoczności i dostępu na wielu platformach AI w celu zmniejszenia ryzyka uzależnienia od jednego dostawcy, optymalizacji kosztów oraz utrzymania elastyczności strategicznej. Organizacje rozkładają swoje obciążenia AI na różnych dostawców, zamiast polegać na jednym, co umożliwia lepszą pozycję negocjacyjną, większą odporność i możliwość wdrażania najlepszych rozwiązań w miarę ich pojawiania się.

Uzależnienie od dostawcy występuje, gdy organizacja staje się tak zależna od jednego dostawcy AI, że przejście do alternatywy staje się niepraktyczne lub zbyt kosztowne. Ta zależność rozwija się stopniowo poprzez ściśle powiązane integracje, zastrzeżone API i niestandardowe implementacje, które wiążą aplikacje bezpośrednio z ekosystemem jednego dostawcy. Skutki są poważne: organizacje tracą siłę negocjacyjną, ponoszą rosnące koszty i nie mogą wdrażać lepszych modeli czy technologii, gdy te się pojawiają. Po zamknięciu w jednym rozwiązaniu, zmiana dostawcy wymaga szeroko zakrojonej przebudowy, ponownego szkolenia i często znacznych kar finansowych.

Poleganie na jednej platformie AI tworzy wiele strategicznych podatności, które wykraczają daleko poza początkową wygodę:

Platformy wielomodelowe rozwiązują te wyzwania, tworząc warstwę abstrakcji pomiędzy aplikacjami a dostawcami AI. Zamiast bezpośrednich wywołań API dostawcy, aplikacje komunikują się z jednolitym interfejsem obsługiwanym przez platformę. Ta architektura umożliwia inteligentne routowanie zapytań do optymalnych modeli w zależności od kosztu, wydajności, wymagań zgodności czy dostępności. Platforma tłumaczy żądania na formaty specyficzne dla dostawców, obsługuje uwierzytelnianie i bezpieczeństwo oraz utrzymuje pełne ścieżki audytu. Korporacyjne platformy wielomodelowe wprowadzają kluczowe możliwości zarządzania: scentralizowane egzekwowanie polityk, ochronę danych wrażliwych, dostęp oparty na rolach oraz bieżącą obserwowalność użycia AI w całej organizacji.

| Wymiar | Jeden dostawca | Platforma wielomodelowa |

|---|---|---|

| Elastyczność dostawców | Związanie z jednym dostawcą | Dostęp do 100+ modeli od wielu dostawców |

| Koszt | Umowy korporacyjne: 50 tys.–500 tys.+ USD rocznie | 40–60% niższy koszt przy tych samych możliwościach |

| Zarządzanie | Ograniczone do narzędzi dostawcy | Scentralizowane polityki dla wszystkich dostawców |

| Bezpieczeństwo danych | Bezpośrednia ekspozycja na dostawcę | Warstwa ochrony danych wrażliwych |

| Koszt zmiany | Bardzo wysoki (miesiące, miliony) | Minimalny (zmiana konfiguracji) |

| Opóźnienie | Brak | 3–5 ms (pomijalne) |

| Zgodność | Zależna od dostawcy | Dostosowana do wymagań organizacji |

Platformy wielomodelowe oferują znaczące zalety kosztowe dzięki konkurencyjnym cenom dostawców i inteligentnemu wyborowi modeli. Organizacje korzystające z takich rozwiązań raportują oszczędności rzędu 40–60% w porównaniu do umów z pojedynczym dostawcą, zyskując dostęp do lepszych modeli i kompleksowego zarządzania. Platforma umożliwia dynamiczny wybór modeli—proste zapytania kierowane są do tanich modeli, a drogie, zaawansowane modele rezerwowane są dla złożonych zadań. Bieżące śledzenie kosztów i zarządzanie budżetem zapobiega niekontrolowanym wydatkom, a konkurencja między dostawcami utrzymuje korzystne ceny. Organizacje mogą też negocjować lepsze warunki, pokazując, że łatwo mogą zmienić dostawcę, co zasadniczo zmienia układ sił w relacjach z dostawcami.

Korporacyjne platformy wielomodelowe wdrażają warstwy ochronne, których nie zapewniają rozwiązania jednego dostawcy. Mechanizmy ochrony danych wrażliwych wykrywają i blokują przesyłanie poufnych informacji do zewnętrznych dostawców, utrzymując dane firmowe w granicach organizacji. Kompleksowe logi audytowe tworzą przejrzyste zapisy każdej interakcji z AI, wspierając wykazanie zgodności z regulacjami takimi jak GDPR, HIPAA czy SOC 2. Organizacje mogą egzekwować spójne polityki u wszystkich dostawców—reguły użycia, zasady przetwarzania danych i wymogi zgodności—niezależnie od możliwości zarządzania po stronie każdego z nich. Raport Business Digital Index 2025 wykazał, że 50% dostawców AI nie spełnia podstawowych standardów bezpieczeństwa danych, dlatego pośrednie warstwy zarządzania są niezbędne w branżach regulowanych. Platformy wielomodelowe stają się granicą bezpieczeństwa, zapewniając lepszą ochronę niż bezpośredni dostęp do dostawcy.

Dywersyfikacja platform pozwala budować odporność operacyjną poprzez redundancję i mechanizmy failover. Jeśli jeden dostawca AI doświadczy awarii lub spadku wydajności, platforma automatycznie przekieruje obciążenia do alternatywnych dostawców bez przerw w usługach. Taka redundancja jest niemożliwa przy podejściu jednego dostawcy, gdzie awaria wpływa na wszystkie zależne aplikacje. Platformy wielomodelowe umożliwiają także optymalizację wydajności poprzez monitorowanie opóźnień i jakości w czasie rzeczywistym, automatycznie wybierając najszybszego lub najbardziej niezawodnego dostawcę dla każdego żądania. Organizacje mogą testować nowe modele produkcyjnie bez ryzyka, stopniowo przenosząc ruch na lepsze alternatywy w miarę wzrostu zaufania. Efektem jest infrastruktura AI, która pozostaje niezawodna i wydajna nawet przy problemach po stronie poszczególnych dostawców.

Trwała dywersyfikacja platform opiera się na otwartych standardach, które zapobiegają nowym formom uzależnienia. Organizacje powinny wybierać platformy korzystające ze standardowych API (REST, GraphQL) zamiast zastrzeżonych SDK, by aplikacje pozostały neutralne technologicznie. Format wymiany modeli, taki jak ONNX (Open Neural Network Exchange), umożliwia przenoszenie wytrenowanych modeli pomiędzy frameworkami i platformami bez ponownego uczenia. Przenośność danych wymaga przechowywania logów i metryk w otwartych formatach—Parquet, JSON, OpenTelemetry—pod kontrolą organizacji, a nie w bazach zamkniętych dostawców. Otwarte standardy dają prawdziwą swobodę strategiczną: organizacje mogą migrować na nowe platformy, wdrażać nowatorskie modele czy hostować infrastrukturę własną bez konieczności przepisywania aplikacji. To podejście zabezpiecza strategię AI przed zmianami dostawców, podwyżkami cen i zakłóceniami na rynku.

Skuteczna dywersyfikacja platform wymaga systematycznej oceny i zarządzania. Organizacje powinny oceniać platformy pod kątem wsparcia wielu dostawców (czy integrują się z czołowymi dostawcami oraz własnymi modelami?), otwartych API i formatów danych (czy można eksportować dane i korzystać ze standardowych bibliotek?) oraz elastyczności wdrożenia (czy można wdrożyć on-premise lub w multi-cloud?). Wdrożenie rozpoczyna się od wyboru platformy wielomodelowej dopasowanej do potrzeb organizacji, następnie stopniowej migracji aplikacji na jednolity interfejs platformy. Należy ustanowić ramy zarządzania określające dopuszczalne wykorzystanie AI, polityki przetwarzania danych i wymagania zgodności—platforma egzekwuje je konsekwentnie u wszystkich dostawców. Szkolenia zespołów zapewniają, że deweloperzy rozumieją nową architekturę i potrafią efektywnie korzystać z możliwości platformy. Ciągłe monitorowanie i optymalizacja pozwalają identyfikować oszczędności, poprawiać wydajność i odkrywać nowe przypadki użycia.

W miarę dywersyfikacji na wiele platform AI, kluczowe staje się utrzymanie widoczności i kontroli. AmICited.com to istotne rozwiązanie monitorujące zaprojektowane z myślą o tym wyzwaniu, śledzące, jak systemy AI referują Twoją markę i treści na wielu platformach AI, w tym ChatGPT, Perplexity, Google AI Overviews i innych. Taka widoczność ma kluczowe znaczenie dla zrozumienia obecności w AI, zapewnienia zgodności oraz identyfikacji możliwości optymalizacji. FlowHunt.io uzupełnia to podejście, oferując możliwości generowania treści AI i automatyzacji na wielu platformach, umożliwiając organizacjom utrzymanie spójnej jakości i zarządzania podczas skalowania wykorzystania AI. Razem te rozwiązania pomagają organizacjom utrzymać pełną widoczność wykorzystania platform AI, kontrolować koszty, zapewniać zgodność oraz optymalizować wydajność w całej zdywersyfikowanej infrastrukturze AI. Dzięki połączeniu monitorowania wieloplatformowego z inteligentną automatyzacją organizacje mogą pewnie skalować wdrożenia AI, zachowując niezbędną kontrolę i widoczność na poziomie korporacyjnym.

Uzależnienie od dostawcy występuje, gdy organizacja staje się tak zależna od jednego dostawcy AI, że zmiana staje się niepraktyczna lub zbyt kosztowna. Ta zależność powstaje przez ściśle powiązane integracje i zastrzeżone API, co prowadzi do utraty siły negocjacyjnej, braku możliwości wdrożenia lepszych modeli oraz rosnących kosztów. Organizacje powinny się tym przejmować, ponieważ uzależnienie ogranicza elastyczność strategiczną i tworzy długoterminową podatność na zmiany cen oraz przerwy w świadczeniu usług.

Organizacje korzystające z korporacyjnych platform wielomodelowych zgłaszają oszczędności kosztów na poziomie 40-60% w porównaniu do umów z jednym dostawcą, zyskując jednocześnie dostęp do lepszych modeli i kompleksowego zarządzania. Oszczędności wynikają z konkurencyjnych cen dostawców, inteligentnego wyboru modeli, który kieruje proste zapytania do tanich modeli, oraz lepszej pozycji negocjacyjnej, gdy dostawcy wiedzą, że łatwo można ich zmienić.

Platformy jednego dostawcy uzależniają organizacje od ekosystemu jednego partnera, oferując ograniczone zarządzanie i wysokie koszty zmiany. Platformy wielomodelowe tworzą warstwę abstrakcji umożliwiającą dostęp do 100+ modeli różnych dostawców, scentralizowane zarządzanie, ochronę danych wrażliwych i minimalne koszty zmiany. Platformy te wprowadzają tylko 3-5 ms dodatkowych opóźnień, oferując jednocześnie bezpieczeństwo i zgodność na poziomie korporacyjnym.

Korporacyjne platformy wielomodelowe wdrażają mechanizmy ochrony danych wrażliwych, które wykrywają i uniemożliwiają przesyłanie poufnych informacji do zewnętrznych dostawców, utrzymując dane firmowe w granicach organizacji. Utrzymują kompleksowe logi audytowe każdej interakcji z AI, egzekwują spójne polityki u wszystkich dostawców i same stają się granicą bezpieczeństwa zamiast wystawiać dane bezpośrednio do dostawców. To podejście jest kluczowe, ponieważ 50% dostawców AI nie spełnia podstawowych standardów bezpieczeństwa danych.

Otwarte standardy (REST API, GraphQL, ONNX, OpenTelemetry) zapobiegają nowym formom uzależnienia od dostawcy, zapewniając neutralność aplikacji i przenośność danych. Organizacje powinny wybierać platformy korzystające ze standardowych API zamiast zastrzeżonych SDK, przechowywać dane w otwartych formatach pod własną kontrolą i używać formatów wymiany modeli, które umożliwiają przenoszenie modeli między platformami bez ponownego trenowania. Takie podejście zabezpiecza strategię AI przed zmianami dostawców i zakłóceniami na rynku.

Oceniaj platformy pod kątem wsparcia wielu dostawców (integracje z głównymi dostawcami i własnymi modelami), otwartych API i formatów danych (możliwość eksportu danych i korzystania ze standardowych bibliotek), elastyczności wdrożeniowej (opcje on-premise lub multi-cloud) oraz możliwości zarządzania (egzekwowanie polityk, logi audytowe, wsparcie zgodności). Priorytetowo traktuj platformy z trwałymi mechanizmami organicznej dystrybucji zamiast tymczasowych promocji i sprawdź ich doświadczenie z klientami korporacyjnymi w Twojej branży.

Kluczowe wyzwania to wybór odpowiedniej platformy wielomodelowej dopasowanej do potrzeb organizacji, migracja istniejących aplikacji do interfejsu platformy, ustanowienie ram zarządzania określających dopuszczalne użycie AI i wymagania zgodności oraz przeszkolenie zespołów w nowej architekturze. Organizacje powinny także zaplanować ciągłe monitorowanie i optymalizację w celu identyfikacji oszczędności i nowych przypadków użycia. Sukces wymaga konsekwencji w nowym podejściu zamiast utrzymywania integracji z jednym dostawcą równolegle.

AmICited.com zapewnia kompleksowy monitoring tego, jak Twoja marka i treści pojawiają się na różnych platformach AI, w tym ChatGPT, Perplexity, Google AI Overviews i innych. Taka widoczność ma kluczowe znaczenie dla zrozumienia obecności w AI, zapewnienia zgodności, identyfikacji możliwości optymalizacji oraz utrzymania kontroli nad tym, jak marka jest przywoływana w odpowiedziach AI. AmICited pomaga organizacjom śledzić swoją obecność w zdywersyfikowanym ekosystemie AI.

Śledź, jak Twoja marka pojawia się na różnych platformach AI z AmICited. Uzyskaj kompleksową widoczność swojej obecności w AI na ChatGPT, Perplexity, Google AI Overviews i wielu innych.

Dowiedz się, jak wcześnie wykrywać kryzysy widoczności AI dzięki monitorowaniu w czasie rzeczywistym, analizie sentymentu i wykrywaniu anomalii. Poznaj sygnały ...

Dowiedz się, jak odbudować wiarygodność marki po utracie reputacji spowodowanej AI. Poznaj strategie odbudowy zaufania do AI, systemy monitorowania oraz komunik...

Poznaj skuteczne strategie identyfikowania, monitorowania i korygowania nieprawidłowych informacji o Twojej marce w odpowiedziach generowanych przez AI takich j...