Jak działają wyszukiwarki AI: architektura, wyszukiwanie i generowanie

Dowiedz się, jak działają wyszukiwarki AI, takie jak ChatGPT, Perplexity i Google AI Overviews. Poznaj LLM, RAG, wyszukiwanie semantyczne i mechanizmy wyszukiwa...

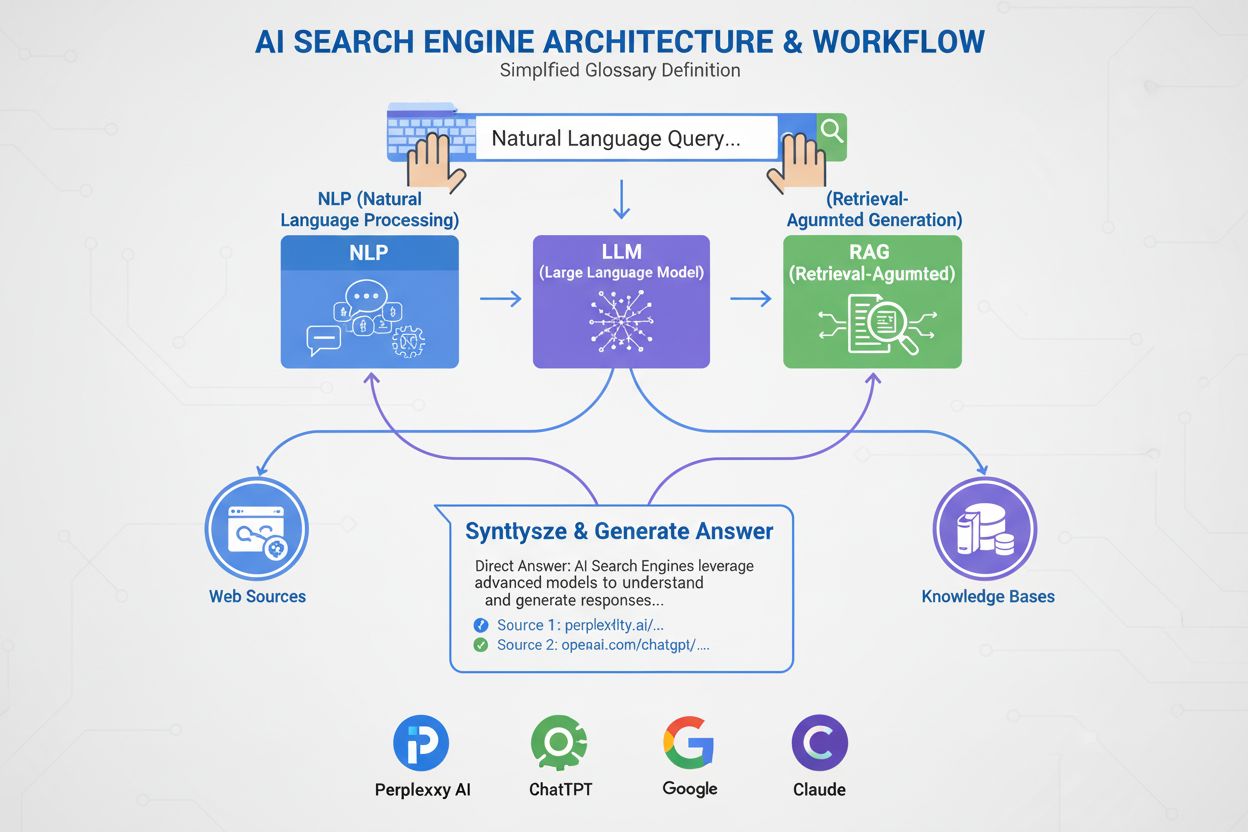

Wyszukiwarka AI to platforma wykorzystująca sztuczną inteligencję, przetwarzanie języka naturalnego oraz duże modele językowe do interpretowania zapytań użytkowników i generowania bezpośrednich, konwersacyjnych odpowiedzi zsyntezowanych na podstawie źródeł internetowych, zamiast wyświetlania tradycyjnych list linków. Platformy te wykorzystują generowanie wspomagane wyszukiwaniem (RAG), by dostarczać aktualne, cytowane informacje z dostępem do sieci w czasie rzeczywistym.

Wyszukiwarka AI to platforma wykorzystująca sztuczną inteligencję, przetwarzanie języka naturalnego oraz duże modele językowe do interpretowania zapytań użytkowników i generowania bezpośrednich, konwersacyjnych odpowiedzi zsyntezowanych na podstawie źródeł internetowych, zamiast wyświetlania tradycyjnych list linków. Platformy te wykorzystują generowanie wspomagane wyszukiwaniem (RAG), by dostarczać aktualne, cytowane informacje z dostępem do sieci w czasie rzeczywistym.

Wyszukiwarka AI to platforma wykorzystująca sztuczną inteligencję, przetwarzanie języka naturalnego (NLP) oraz duże modele językowe (LLM), aby interpretować zapytania użytkowników i generować bezpośrednie, konwersacyjne odpowiedzi zsyntezowane na podstawie źródeł internetowych. W przeciwieństwie do tradycyjnych wyszukiwarek, które wyświetlają listy linków, wyszukiwarki AI oferują zwięzłe, napisane prostym językiem podsumowania, bezpośrednio odpowiadające na intencje użytkownika. Platformy te wykorzystują generowanie wspomagane wyszukiwaniem (RAG), by łączyć pobieranie wyników z Internetu w czasie rzeczywistym z generatywną syntezą AI, co pozwala im dostarczać aktualne, cytowane informacje. Wyszukiwarki AI oznaczają fundamentalną zmianę w sposobie odkrywania informacji online, przechodząc od list linków opartych na słowach kluczowych do rozumienia semantycznego i bezpośrednich odpowiedzi. Technologia stojąca za tymi systemami integruje wiele dziedzin AI — w tym wyszukiwanie semantyczne, rozpoznawanie encji i konwersacyjną AI — tworząc bardziej intuicyjne i efektywne doświadczenie wyszukiwania.

Pojawienie się wyszukiwarek AI oznacza istotną ewolucję technologii wyszukiwania informacji. Przez dziesięciolecia wyszukiwarki działały w paradygmacie dopasowania słów kluczowych, gdzie trafność określano na podstawie obecności i częstotliwości występowania zapytań w indeksowanych dokumentach. Jednak rozwój dużych modeli językowych oraz postępy w rozumieniu języka naturalnego zasadniczo zmieniły możliwości tych systemów. Globalny rynek wyszukiwarek AI osiągnął 15,23 mld USD w 2024 r. i według prognoz ma wykazywać złożoną roczną stopę wzrostu (CAGR) na poziomie 16,8% do 2032 r. Ta dynamiczna ekspansja odzwierciedla zarówno wdrożenia w przedsiębiorstwach, jak i rosnące zapotrzebowanie konsumentów na inteligentniejsze, konwersacyjne doświadczenia wyszukiwania.

Generatywna AI zmieniła sposób, w jaki ludzie odkrywają informacje w sieci, przesuwając wyszukiwanie poza znaną listę niebieskich linków w kierunku bardziej bezpośrednich, konwersacyjnych odpowiedzi. Liderzy branży, tacy jak Google i Microsoft Bing, szybko zintegrowali AI ze swoimi platformami, by nadążyć za rosnącymi gwiazdami, takimi jak Perplexity i You.com. Według badań McKinsey, około 50% wyszukiwań w Google już zawiera podsumowania AI, a liczba ta ma wzrosnąć do ponad 75% do 2028 r. Ta zmiana to nie tylko kwestia interfejsu użytkownika — redefiniuje ona strategię treści i optymalizację wyszukiwarek w nową erę, zwaną “generative engine optimization” (GEO).

Transformacja ta odzwierciedla także szersze wdrożenia technologii AI w organizacjach. 78% organizacji zgłosiło korzystanie z AI w 2024 r., w porównaniu do 55% rok wcześniej (Raport AI Index Stanforda). Dla specjalistów od wyszukiwania i marketingu oznacza to, że widoczność zależy dziś od zrozumienia, jak systemy AI analizują, kondensują i przekształcają treści w zrozumiałe podsumowania. Wyzwaniem jest to, że odpowiedzi generowane przez AI często całkowicie przekierowują ruch z oryginalnych stron, co stanowi zarówno szansę, jak i wyzwanie dla twórców treści i marek dążących do widoczności w nowym ekosystemie.

Wyszukiwarki AI działają w oparciu o zaawansowany, wieloetapowy proces łączący pobieranie, ocenę i syntezę informacji. Proces zaczyna się od rozumienia zapytania, gdzie system analizuje wejście użytkownika za pomocą przetwarzania języka naturalnego, by wydobyć znaczenie, intencję i kontekst. Zamiast traktować zapytanie jako ciąg słów kluczowych, system tworzy kilka reprezentacji: formę leksykalną do wyszukiwania dokładnego, gęste osadzenie do wyszukiwania semantycznego oraz postać encji do dopasowania z grafami wiedzy.

Po zrozumieniu zapytania większość wyszukiwarek AI stosuje generowanie wspomagane wyszukiwaniem (RAG), czyli kluczowy wzorzec architektoniczny rozwiązujący fundamentalne słabości dużych modeli językowych. RAG realizuje pobieranie na żywo, przeszukując indeksy internetowe lub API w celu znalezienia odpowiednich dokumentów i fragmentów. Kandydaci są później ponownie oceniani przez bardziej zaawansowane modele, które wspólnie analizują zapytanie i fragmenty, by uzyskać lepsze wyniki trafności. Najlepsze wyniki trafiają do dużego modelu językowego jako kontekst, na podstawie którego generowana jest konwersacyjna odpowiedź zgodna z pobranymi źródłami.

Hybrydowe łańcuchy wyszukiwania to standard wiodących platform. Łączą one wyszukiwanie leksykalne (oparte na słowach kluczowych, np. BM25) z wyszukiwaniem semantycznym (opartym na osadzeniach wektorowych). Wyszukiwanie leksykalne zapewnia precyzję dla ścisłych dopasowań, rzadkich terminów i nazw własnych, podczas gdy semantyczne zapewnia pełniejsze pokrycie dla powiązanych tematycznie treści. Łącząc obie metody i stosując reranking cross-encoder, wyszukiwarki AI osiągają większą dokładność niż każda z nich osobno. Ostateczna synteza korzysta z dużego modelu językowego, by złożyć spójną, ludzką odpowiedź integrującą informacje z wielu źródeł, z zachowaniem dokładności i cytowaniem.

| Aspekt | Tradycyjne wyszukiwarki | Wyszukiwarki AI |

|---|---|---|

| Format wyniku | Listy linków z krótkimi fragmentami | Konwersacyjne podsumowania z bezpośrednimi odpowiedziami |

| Przetwarzanie zapytania | Dopasowanie i ranking słów kluczowych | Rozumienie semantyczne i analiza intencji |

| Mechanizm nauki | Działa od zera dla każdego zapytania | Uczy się ciągle na podstawie interakcji i opinii użytkowników |

| Pobieranie informacji | Dopasowanie leksykalne/słowa kluczowe | Hybrydowe (leksykalne + semantyczne + encje) |

| Formaty wejściowe | Tylko tekst | Tekst, obrazy, głos i wideo (multimodalnie) |

| Aktualizacje w czasie rzeczywistym | Indeksowanie, okresowe skanowanie | Dostęp do sieci w czasie rzeczywistym przez RAG |

| Cytowanie | Brak cytowań; użytkownik sam szuka źródeł | Zintegrowane cytaty i atrybucja źródeł |

| Interakcja z użytkownikiem | Pojedyncze zapytanie, statyczne wyniki | Konwersacje wieloetapowe z doprecyzowaniem |

| Radzenie sobie z uprzedzeniami | Kuratorzy organizują informacje | Synteza AI może wprowadzać uprzedzenia twórców |

| Ryzyko halucynacji | Niskie (linki są faktograficzne) | Wyższe (LLM mogą generować fałszywe informacje) |

Różne wyszukiwarki AI wdrażają unikalne podejścia architektoniczne, co rodzi odmienne wymagania optymalizacyjne. AI Overviews i Tryb AI Google stosują strategię fan-out zapytań, polegającą na rozbiciu pojedynczego zapytania użytkownika na wiele podzapytań obejmujących różne intencje. Podzapytań tych używa się równolegle w różnych źródłach — indeksie sieci, Grafie Wiedzy, transkrypcjach YouTube, feedach Google Shopping i indeksach specjalistycznych. Wyniki są agregowane, dublujące się eliminowane, a ostateczna lista jest rankowana i syntezowana w podsumowanie. Dla praktyków GEO oznacza to, że treść musi odpowiadać na różne aspekty zapytania w sposób umożliwiający jej wyodrębnienie, by przetrwać proces fan-out.

Bing Copilot to bardziej klasyczne podejście natywne dla wyszukiwarek, wykorzystujące dojrzałą infrastrukturę Bing do rankingu, a na niej oparty jest generatywny model GPT. Platforma stosuje podwójny tor wyszukiwania, łącząc BM25 (wyszukiwanie leksykalne) z semantycznym wyszukiwaniem wektorowym. Wyniki przechodzą przez reranker cross-encoder, skupiający się na trafności fragmentów, a nie całych stron. Oznacza to, że klasyczne sygnały SEO — indeksowalność, znaczniki kanoniczne, czysty HTML, prędkość ładowania strony — nadal mają duże znaczenie, bo decydują, które fragmenty trafią do zestawu źródłowego. Bing Copilot kładzie nacisk na możliwość wyodrębnienia: fragmenty z wyraźnym zakresem, listami, tabelami i definicjami mają większą szansę na cytowanie.

Perplexity AI działa z zamierzoną transparentnością, wyświetlając źródła wyraźnie przed samą odpowiedzią generowaną. Platforma realizuje wyszukiwanie na żywo, czerpiąc zarówno z indeksów Google, jak i Bing, a następnie ocenia kandydatów pod kątem leksykalnej i semantycznej trafności, autorytetu tematycznego i możliwości ekstrakcji odpowiedzi. Badania analizujące 59 czynników wpływających na ranking Perplexity pokazują, że platforma premiuje formatowanie bezpośredniej odpowiedzi — strony, które powtarzają zapytanie w nagłówku, po czym następuje zwięzła, bogata w informacje odpowiedź, są nadreprezentowane w cytowaniach. Ważną rolę odgrywa również widoczność encji i linkowanie kontekstowe.

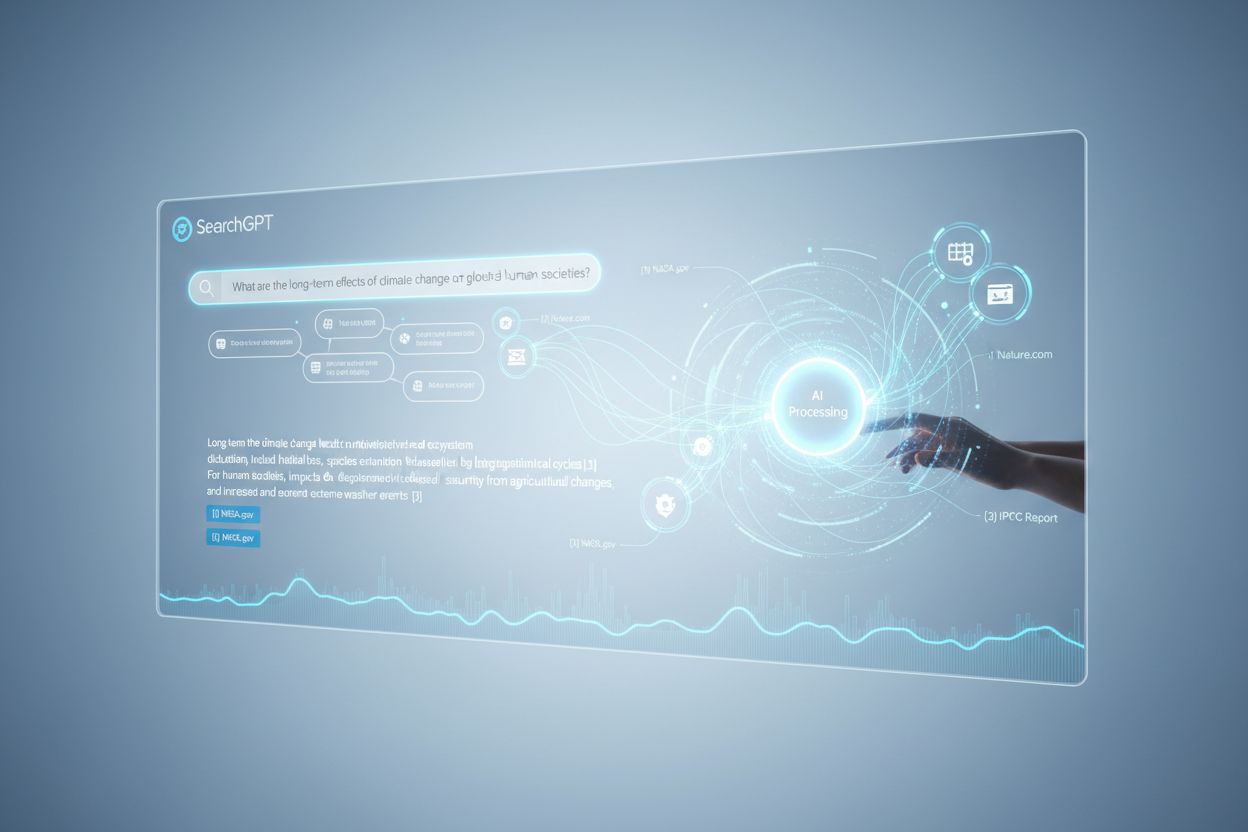

ChatGPT Search przyjmuje podejście oportunistyczne, dynamicznie generując zapytania i korzystając z API Bing do pobierania konkretnych adresów URL. W przeciwieństwie do platform z trwałymi indeksami, ChatGPT pobiera treści w czasie rzeczywistym, więc obecność strony zależy wyłącznie od możliwości jej pobrania. Jeśli witryna jest zablokowana przez robots.txt, ładuje się wolno, jest schowana za renderowaniem po stronie klienta lub semantycznie nieprzejrzysta, nie zostanie użyta w syntezie. Ta architektura premiuje dostępność i przejrzystość: strony muszą być technicznie indeksowalne, lekkie i semantycznie czytelne, by pobrania na żądanie dawały czysty, możliwy do analizy tekst.

Przetwarzanie języka naturalnego (NLP) to technologia umożliwiająca wyszukiwarkom AI wyjście poza dopasowanie słów kluczowych. Pozwala ono systemom analizować strukturę, semantykę i intencję zapytań, rozumieć kontekst oraz rozpoznawać synonimy i powiązane pojęcia. Gdy użytkownik pyta “najlepsze miejsca do jedzenia z ogródkiem w pobliżu”, system oparty na NLP rozumie, że chodzi o restauracje z patio, mimo że nie padły te słowa. To semantyczne rozumienie sprawia, że wyszukiwarki AI dostarczają trafnych odpowiedzi nawet przy mniej oczywistych lub konwersacyjnych zapytaniach.

Duże modele językowe (LLM) odpowiadają za etap syntezy w wyszukiwarkach AI. Uczenie na ogromnych zbiorach tekstów pozwala im przewidywać najbardziej logiczne kolejne słowo, dzięki czemu generują spójny, poprawny gramatycznie tekst zbliżony do ludzkiego. Jednak LLM niosą też ryzyko — mogą halucynować, czyli przedstawiać nieprawdziwe informacje jako fakty, ponieważ generują tekst probabilistycznie, a nie cytując na żywo. Dlatego generowanie wspomagane wyszukiwaniem (RAG) jest kluczowe: uziemiając syntezę LLM w świeżo pobranych, autorytatywnych źródłach, wyszukiwarki AI ograniczają ryzyko halucynacji i zwiększają dokładność. Niektóre platformy wprowadziły cytowania linia po linii, choć cytowane artykuły nie zawsze są trafne, a czasem w ogóle nie istnieją.

Wyszukiwarki AI różnią się od tradycyjnych w kilku podstawowych aspektach. Po pierwsze, oferują podsumowania zamiast linków. Wyszukiwarki tradycyjne wyświetlają listy linków z fragmentami, a AI generuje zwięzłe podsumowania odpowiadające bezpośrednio na zapytania, bez konieczności klikania w wiele stron. Po drugie, wyszukiwanie AI uczy się w czasie, a tradycyjne działa od nowa przy każdym zapytaniu. AI jest zaprojektowane tak, by stale się uczyć i dostosowywać do interakcji i nowych danych, poprawiając się z czasem. Tradycyjne wyszukiwarki nie uwzględniają poprzednich zapytań ani interakcji użytkownika.

Po trzecie, wyszukiwanie AI koncentruje się na semantyce, a tradycyjne na słowach kluczowych. Wyszukiwarki tradycyjne polegają głównie na dopasowaniu słów kluczowych, podczas gdy AI skupia się na semantyce — szerszym znaczeniu słów w kontekście. Pozwala to AI lepiej rozumieć intencje użytkownika i dostarczać bardziej trafne wyniki. Po czwarte, wyszukiwanie AI przyjmuje wiele formatów wejściowych, a tradycyjne tylko tekst. Niektóre wyszukiwarki AI mają zdolności multimodalne, czyli potrafią przetwarzać i rozumieć informacje nie tylko z tekstu, ale także z obrazów, wideo czy audio, co daje bardziej intuicyjne i elastyczne doświadczenie niż samo wpisywanie słów kluczowych.

Wzrost znaczenia wyszukiwarek AI zmienia sposób, w jaki marki budują widoczność i strategię treści. Zamiast konkurować wyłącznie o pozycje na słowa kluczowe, wydawcy i firmy muszą dziś brać pod uwagę, jak systemy AI analizują, kondensują i przekształcają ich treści w zrozumiałe podsumowania. Ta zmiana dała początek nowej erze “generative engine optimization” (GEO), gdzie celem jest nie tylko ranking, ale bycie pobieranym, syntezowanym i cytowanym przez AI.

Badania wskazują, że nawet liderzy branży osiągają wyniki GEO gorsze od SEO o 20–50%, według analizy McKinsey. Ta luka wynika z wczesnej fazy strategii GEO i złożoności optymalizacji pod wiele platform AI jednocześnie. Dla marek oznacza to, że widoczność w AI zależy od tego, czy treść jest pobierana (pojawia się w wynikach), wyodrębnialna (ustrukturyzowana tak, by AI łatwo ją analizowało i cytowało) oraz wiarygodna (budująca eksperckość, autorytet i zaufanie). Narzędzia takie jak AmICited śledzą dziś wzmianki o marce w AI — w tym w Perplexity, ChatGPT, Google AI Overviews i Claude — by mierzyć nową formę widoczności i wskazywać możliwości optymalizacji.

Krajobraz wyszukiwania AI szybko się zmienia, co ma duży wpływ na sposób odkrywania, dystrybuowania i monetyzowania informacji. Globalny rynek wyszukiwarek AI ma rosnąć w tempie CAGR 16,8% do 2032 r., napędzany rosnącą adopcją w firmach i zapotrzebowaniem konsumentów na konwersacyjne, inteligentne wyszukiwanie. Wraz z dojrzewaniem wyszukiwarek AI można spodziewać się kilku kluczowych trendów.

Po pierwsze, konsolidacja i specjalizacja przyspieszą. Podczas gdy platformy ogólne, takie jak Google, Bing i Perplexity, będą dominować, pojawi się więcej wyszukiwarek AI wyspecjalizowanych w konkretnych branżach — prawnych, medycznych, technicznych, e-commerce. Zapewnią one głębszą wiedzę domenową i dokładniejsze syntezy dla zapytań niszowych. Po drugie, mechanizmy cytowania i atrybucji staną się bardziej zaawansowane i ustandaryzowane. Wraz ze wzrostem presji regulacyjnej i żądaniami wydawców, AI wdroży bardziej szczegółowe systemy cytowania, ułatwiające śledzenie źródeł i pomiar widoczności.

Po trzecie, definicja i pomiar „widoczności” radykalnie się zmienią. W erze SEO liczyła się pozycja w rankingu i współczynnik kliknięć. W erze GEO widoczność oznacza bycie pobieranym, syntezowanym i cytowanym — co wymaga nowych narzędzi i metod pomiaru. AmICited i podobne platformy torują drogę tym pomiarom, śledząc wzmianki marek na wielu platformach AI i dostarczając wiedzę o częstotliwości oraz kontekście pojawiania się w odpowiedziach generowanych przez AI.

Po czwarte, napięcie między wyszukiwaniem AI a tradycyjnym wzrośnie. Wraz z przejmowaniem uwagi i ruchu przez AI, tradycyjne wyszukiwarki będą musiały się rozwijać, by nie zniknąć. Integracja AI w wyszukiwarce Google to odpowiedź na to zagrożenie, ale kto wygra długoterminowo — pozostaje niewiadomą. Wydawcy i marki muszą optymalizować się jednocześnie pod SEO i GEO, co oznacza bardziej złożoną i kosztowną strategię treści.

Wreszcie, kluczowe staną się zaufanie i dokładność. W miarę jak AI będzie głównym źródłem informacji, stawka za dokładność i ograniczanie uprzedzeń wzrośnie. Pojawią się regulacje dotyczące transparentności i odpowiedzialności AI, wymagające ujawniania danych treningowych, czynników rankingowych i metod cytowania. Dla marek i wydawców oznacza to, że sygnały E-E-A-T — eksperckość, doświadczenie, autorytatywność i wiarygodność — będą jeszcze ważniejsze zarówno dla widoczności w SEO, jak i GEO.

+++ showCTA = true ctaHeading = “Monitoruj widoczność swojej marki w wyszukiwarkach AI” ctaDescription = “Zrozumienie wyszukiwarek AI to dopiero pierwszy krok. Śledź, gdzie i jak pojawia się Twoja marka w ChatGPT, Perplexity, Google AI Overviews i Claude dzięki platformie monitoringu AI AmICited. Mierz swoje wyniki GEO, identyfikuj szanse na cytowanie i optymalizuj treści pod następną generację wyszukiwania.” ctaPrimaryText = “Skontaktuj się z nami” ctaPrimaryURL = “/contact/” cta

Tradycyjne wyszukiwarki wyświetlają wyniki jako listy linków z fragmentami treści, podczas gdy wyszukiwarki AI generują konwersacyjne podsumowania, które bezpośrednio odpowiadają na zapytania. Wyszukiwarki AI wykorzystują przetwarzanie języka naturalnego oraz duże modele językowe, by semantycznie rozumieć intencje użytkownika, a nie polegać wyłącznie na dopasowaniu słów kluczowych. Uczą się nieustannie na podstawie interakcji użytkowników i potrafią przetwarzać wiele formatów wejściowych, w tym tekst, obrazy i głos. Dodatkowo, wyszukiwarki AI często zapewniają dostęp do sieci w czasie rzeczywistym dzięki generowaniu wspomaganemu wyszukiwaniem (RAG), co pozwala dostarczać aktualne informacje z cytowaniem źródeł.

Generowanie wspomagane wyszukiwaniem (RAG) to technika, która umożliwia dużym modelom językowym pobieranie i włączanie świeżych informacji z zewnętrznych źródeł przed wygenerowaniem odpowiedzi. RAG rozwiązuje podstawowe ograniczenia dużych modeli językowych — halucynacje i ograniczenia wiedzy — poprzez oparcie odpowiedzi na danych pobranych w czasie rzeczywistym. W wyszukiwarkach AI RAG działa poprzez najpierw wykonanie wyszukiwania na żywo lub pobranie informacji, a następnie syntezowanie odpowiedzi na podstawie tych odnalezionych fragmentów. Takie podejście zapewnia, że odpowiedzi są zarówno aktualne, jak i możliwe do prześledzenia do konkretnych źródeł, umożliwiając cytowanie i zwiększając dokładność faktograficzną.

Do czołowych wyszukiwarek AI należą Perplexity (znany z transparentnego cytowania), ChatGPT Search (napędzany przez GPT-4o z dostępem do Internetu w czasie rzeczywistym), Google Gemini i AI Overviews (zintegrowane z infrastrukturą wyszukiwania Google), Bing Copilot (oparty na indeksie wyszukiwania Microsoftu) oraz Claude (model Anthropic z wybiórczym wyszukiwaniem w sieci). Perplexity stawia na wyszukiwanie w czasie rzeczywistym i widoczne przypisy do źródeł, podczas gdy ChatGPT generuje zapytania wyszukiwania w sposób oportunistyczny. Podejście Google wykorzystuje rozdzielanie zapytania na wiele podzapytań, a Bing Copilot łączy tradycyjne sygnały SEO z generatywną syntezą. Każda platforma ma odmienną architekturę wyszukiwania, sposób cytowania i wymagania optymalizacyjne.

Wyszukiwarki AI stosują wieloetapowy proces: najpierw analizują zapytanie użytkownika przy użyciu przetwarzania języka naturalnego, by zrozumieć intencję; następnie pobierają odpowiednie dokumenty lub fragmenty z indeksów internetowych lub API, wykorzystując hybrydowe wyszukiwanie (łączące wyszukiwanie leksykalne i semantyczne); później ponownie oceniają kandydatów pod kątem trafności i możliwości wyodrębnienia; w końcu syntezują konwersacyjną odpowiedź za pomocą dużego modelu językowego, wstawiając cytaty do dokumentów źródłowych. Mechanizm cytowania zależy od platformy — niektóre pokazują przypisy w tekście, inne wyświetlają listę źródeł, a jeszcze inne integrują cytaty bezpośrednio z treścią odpowiedzi. Jakość i trafność przypisów zależy od tego, na ile odnalezione fragmenty pokrywają się z wygenerowanymi twierdzeniami.

Generative engine optimization (GEO) to praktyka optymalizacji treści i widoczności marki specjalnie pod kątem wyszukiwarek AI, w przeciwieństwie do tradycyjnego SEO, które koncentruje się na pozycjonowaniu słów kluczowych w wynikach opartych na linkach. GEO skupia się na tym, by treść była możliwa do pobrania, wyodrębnienia i cytowania przez systemy AI. Kluczowe strategie GEO to struktura treści zapewniająca przejrzystość i bezpośrednie odpowiedzi, używanie języka naturalnego odpowiadającego intencjom użytkowników, wdrażanie znaczników encji i schematów, szybkie ładowanie strony oraz budowanie autorytetu tematycznego. Jak wynika z badań McKinsey, około 50% wyszukiwań w Google już zawiera podsumowania AI, a do 2028 r. odsetek ten ma wzrosnąć do ponad 75%, co czyni GEO coraz ważniejszym dla widoczności marek.

Wyszukiwarki AI mogą zarówno zwiększać, jak i zmniejszać ruch na stronie w zależności od tego, jak treść jest zoptymalizowana. Gdy treść jest cytowana w odpowiedziach generowanych przez AI, zyskuje na widoczności i wiarygodności, jednak użytkownicy mogą uzyskać odpowiedź bezpośrednio, nie przechodząc na stronę źródłową. Badania wskazują, że AI Overviews mogą przekierowywać ruch z oryginalnych stron, choć zapewniają przypisanie i linki do źródeł. Dla marek oznacza to, że widoczność zależy teraz od tego, czy zostaną pobrane, zsyntezowane i zacytowane przez systemy AI — nie tylko od pozycji w tradycyjnych wynikach wyszukiwania. Narzędzia monitorujące, takie jak AmICited, śledzą wzmianki o marce w różnych platformach AI (Perplexity, ChatGPT, Google AI Overviews, Claude), by mierzyć nową formę widoczności i odpowiednio optymalizować treści.

Przetwarzanie języka naturalnego (NLP) jest kluczowe dla tego, jak wyszukiwarki AI rozumieją i przetwarzają zapytania użytkowników. NLP umożliwia systemom analizę struktury, semantyki i intencji stojącej za zapytaniami, a nie tylko dopasowywanie słów kluczowych. Pozwala wyszukiwarkom AI zrozumieć kontekst, rozróżniać znaczenie oraz rozpoznawać synonimy i powiązane pojęcia. NLP zasila też etap syntezy, gdzie modele językowe generują poprawne gramatycznie i spójne odpowiedzi, które brzmią naturalnie dla użytkowników. Ponadto NLP pomaga wyszukiwarkom AI wyodrębniać i strukturalizować informacje ze stron internetowych, identyfikując kluczowe encje, relacje i twierdzenia, które mogą być włączone do generowanych odpowiedzi.

Wyszukiwarki AI realizują aktualność informacji dzięki generowaniu wspomaganemu wyszukiwaniem (RAG), które wykonuje wyszukiwanie na żywo lub wywołuje API, by pobrać bieżące dane w momencie zapytania, zamiast polegać wyłącznie na danych treningowych. Platformy takie jak Perplexity oraz Tryb AI Google aktywnie przeszukują sieć w czasie rzeczywistym, zapewniając, że odpowiedzi odzwierciedlają najnowsze informacje. ChatGPT korzysta z API wyszukiwania Bing, by uzyskać dostęp do bieżących treści internetowych, gdy przeglądanie jest włączone. Sygnały aktualności są również uwzględniane w algorytmach rankingowych — strony z niedawną datą publikacji i zaktualizowaną treścią są wyżej oceniane dla zapytań wrażliwych na czas. Jednak niektóre wyszukiwarki AI nadal częściowo polegają na danych treningowych, które mogą być opóźnione względem rzeczywistych wydarzeń, co czyni pobieranie na żywo kluczowym wyróżnikiem między platformami.

Zacznij śledzić, jak chatboty AI wspominają Twoją markę w ChatGPT, Perplexity i innych platformach. Uzyskaj praktyczne spostrzeżenia, aby poprawić swoją obecność w AI.

Dowiedz się, jak działają wyszukiwarki AI, takie jak ChatGPT, Perplexity i Google AI Overviews. Poznaj LLM, RAG, wyszukiwanie semantyczne i mechanizmy wyszukiwa...

Dowiedz się, jak działają indeksy wyszukiwania AI, jakie są różnice między metodami indeksowania ChatGPT, Perplexity i SearchGPT oraz jak zoptymalizować swoje t...

Dowiedz się, czym jest SearchGPT, jak działa oraz jaki ma wpływ na wyszukiwanie, SEO i marketing cyfrowy. Poznaj funkcje, ograniczenia i przyszłość wyszukiwania...