Jak stworzyć kompleksowe pokrycie tematu dla SEO i wyszukiwania AI

Dowiedz się, jak stworzyć kompleksowe pokrycie tematu za pomocą klastrów tematycznych, stron filarowych i analizy luk w treści, aby zbudować autorytet i poprawi...

Kontekstowe nawiasowanie to technika optymalizacji treści, która ustanawia wyraźne granice wokół informacji, aby zapobiec błędnej interpretacji i halucynacjom AI. Wykorzystuje jawne ograniczniki i znaczniki kontekstu, by modele AI dokładnie rozumiały, gdzie zaczynają się i kończą istotne dane, chroniąc przed generowaniem odpowiedzi na bazie założeń lub zmyślonych szczegółów.

Kontekstowe nawiasowanie to technika optymalizacji treści, która ustanawia wyraźne granice wokół informacji, aby zapobiec błędnej interpretacji i halucynacjom AI. Wykorzystuje jawne ograniczniki i znaczniki kontekstu, by modele AI dokładnie rozumiały, gdzie zaczynają się i kończą istotne dane, chroniąc przed generowaniem odpowiedzi na bazie założeń lub zmyślonych szczegółów.

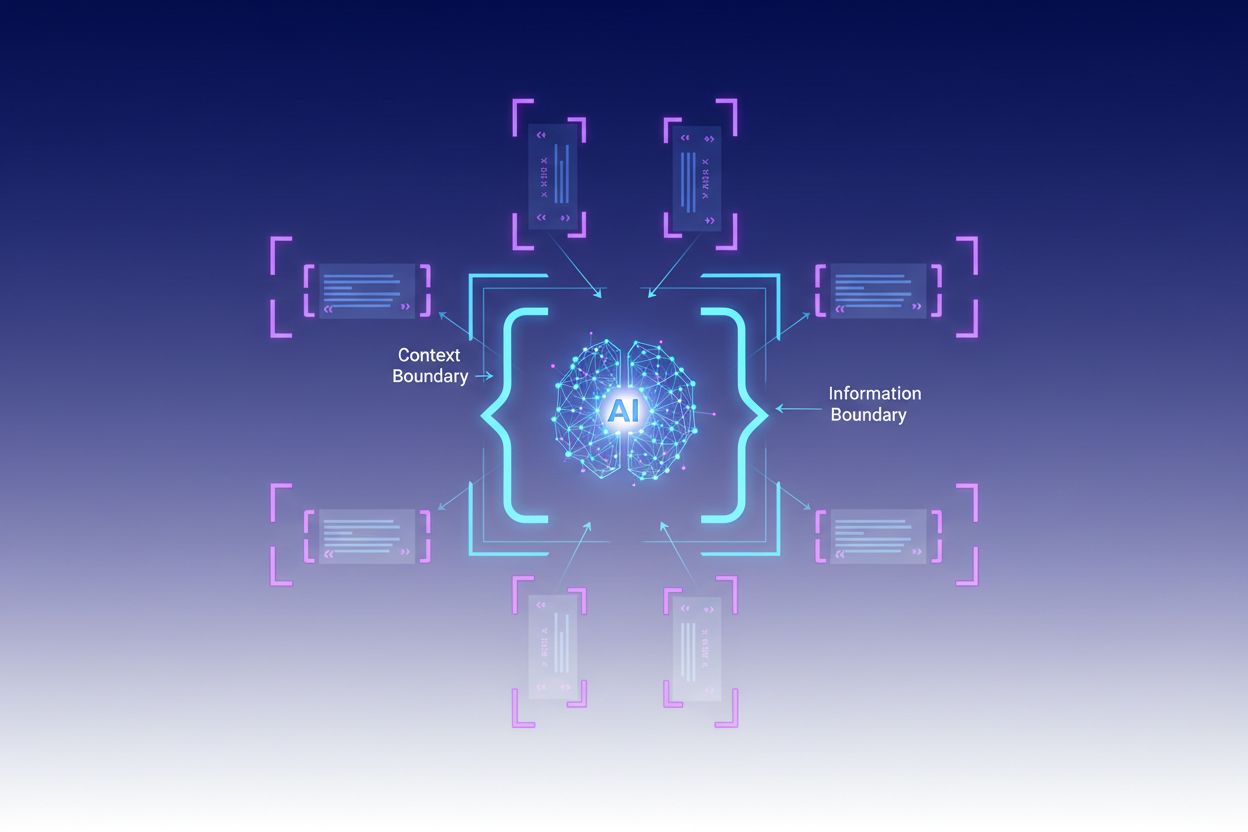

Kontekstowe nawiasowanie to technika optymalizacji treści, która ustanawia wyraźne granice wokół informacji, aby zapobiec błędnej interpretacji i halucynacjom AI. Metoda ta polega na stosowaniu jawnych ograniczników—takich jak znaczniki XML, nagłówki markdown lub znaki specjalne—do oznaczania początku i końca określonych bloków informacji, tworząc tzw. “granicę kontekstu”. Poprzez strukturyzowanie promptów i danych za pomocą tych wyraźnych znaczników, deweloperzy zapewniają, że modele AI dokładnie rozumieją, gdzie zaczynają się i kończą istotne dane, uniemożliwiając generowanie odpowiedzi na bazie założeń lub zmyślonych szczegółów. Kontekstowe nawiasowanie stanowi rozwinięcie tradycyjnej inżynierii promptów, rozszerzając ją na szerszą dziedzinę inżynierii kontekstu, która koncentruje się na optymalizacji wszystkich informacji przekazywanych LLM w celu osiągania pożądanych rezultatów. Technika ta jest szczególnie cenna w środowiskach produkcyjnych, gdzie kluczowe są dokładność i spójność, ponieważ dostarcza matematyczne i strukturalne zabezpieczenia ukierunkowujące zachowanie AI bez potrzeby stosowania złożonej logiki warunkowej.

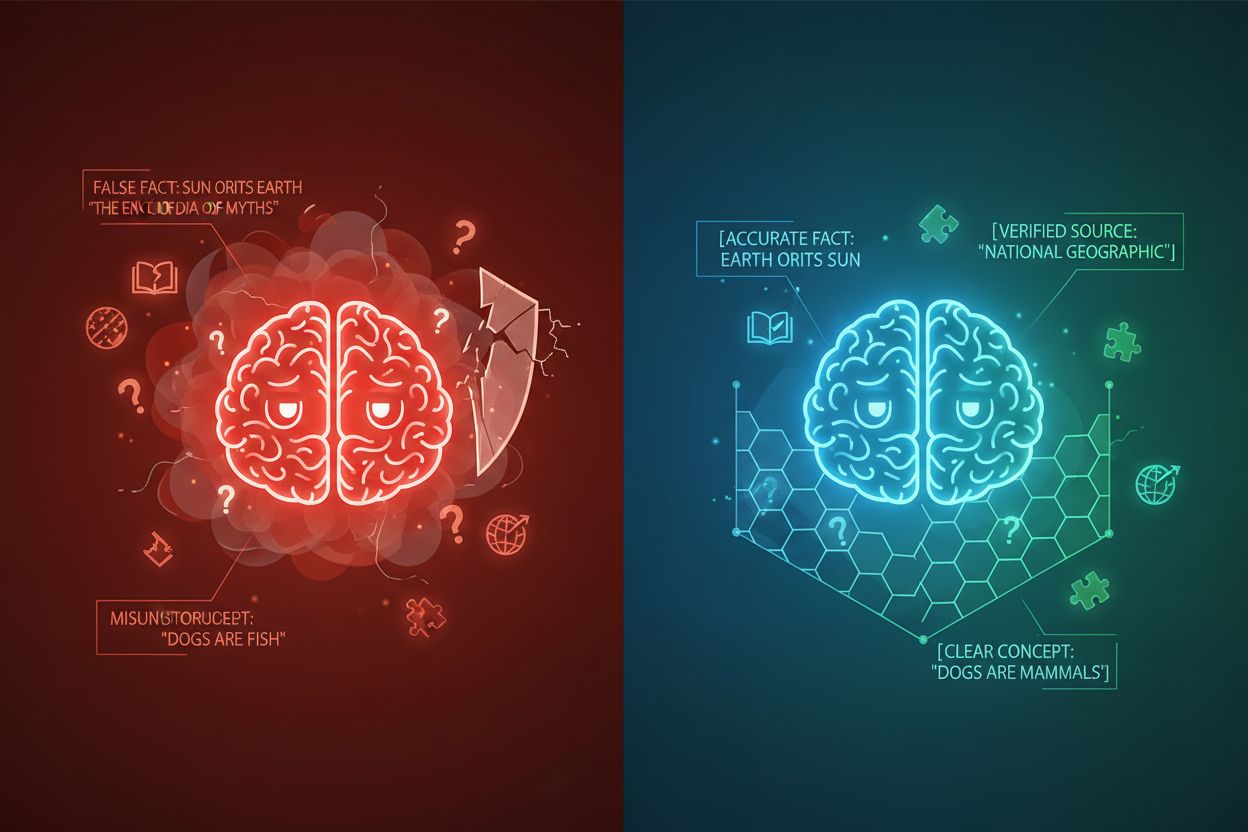

Halucynacje AI pojawiają się, gdy modele językowe generują odpowiedzi, które nie są oparte na faktach lub konkretnym kontekście, prowadząc do fałszywych informacji, mylących stwierdzeń czy odwołań do nieistniejących źródeł. Badania pokazują, że chatboty wymyślają fakty w około 27% przypadków, a 46% ich tekstów zawiera błędy merytoryczne, podczas gdy cytaty dziennikarskie ChatGPT były błędne w 76% przypadków. Halucynacje te mają różne źródła: modele mogą uczyć się wzorców ze stronniczych lub niekompletnych danych treningowych, błędnie rozumieć związki między tokenami lub nie mieć wystarczających ograniczeń limitujących możliwe wyjścia. Skutki są poważne w wielu branżach—w opiece zdrowotnej halucynacje mogą prowadzić do błędnych diagnoz i niepotrzebnych interwencji medycznych; w prawie skutkują zmyślonymi cytatami (jak w sprawie Mata v. Avianca, gdzie prawnik został ukarany za użycie fałszywych cytatów ChatGPT); w biznesie powodują straty przez błędną analizę i prognozy. Podstawowy problem polega na tym, że bez wyraźnych granic kontekstu modele AI działają w informacyjnej próżni, przez co częściej “wypełniają luki” wiarygodnie brzmiącymi, lecz niepoprawnymi danymi, traktując halucynowanie jak funkcję, a nie błąd.

| Typ halucynacji | Częstość | Skutek | Przykład |

|---|---|---|---|

| Nieścisłości faktograficzne | 27-46% | Szerzenie dezinformacji | Fałszywe cechy produktu |

| Fałszowanie źródeł | 76% (cytaty) | Utrata wiarygodności | Nieistniejące cytaty |

| Niezrozumiane pojęcia | Zmienna | Błędna analiza | Błędne precedensy prawne |

| Stronnicze wzorce | Stałe | Dyskryminujące odpowiedzi | Stereotypowe reakcje |

Skuteczność kontekstowego nawiasowania opiera się na pięciu fundamentalnych zasadach:

Stosowanie ograniczników: Używaj konsekwentnych, jednoznacznych znaczników (znaczników XML jak <context>, nagłówków markdown lub znaków specjalnych), by wyraźnie oddzielać bloki informacji i zapobiegać mieszaniu granic między różnymi źródłami danych lub typami instrukcji.

Zarządzanie oknem kontekstu: Strategicznie przydzielaj tokeny pomiędzy instrukcje systemowe, wejścia użytkownika i pobraną wiedzę, tak by najważniejsze informacje mieściły się w ograniczonym budżecie uwagi modelu, a mniej istotne były filtrowane lub pobierane na żądanie.

Hierarchia informacji: Ustalaj jasne priorytety dla różnych typów danych, sygnalizując modelowi, które informacje są autorytatywne, a które stanowią kontekst pomocniczy, by nie nadawać tej samej wagi głównym i pobocznym źródłom.

Definiowanie granic: Wyraźnie określ, które dane model powinien uwzględniać, a które ignorować, ustanawiając twarde limity zapobiegające ekstrapolacji poza dostarczone dane lub zakładaniu niepodanych informacji.

Znaczniki zakresu: Stosuj elementy strukturalne wyznaczające zakres instrukcji, przykładów i danych, by wskazać, czy wytyczne mają zastosowanie globalnie, do określonych sekcji, czy tylko do wybranych rodzajów zapytań.

Wdrożenie kontekstowego nawiasowania wymaga starannego przemyślenia struktury i prezentacji informacji dla modeli AI. Strukturyzowane formatowanie wejścia z użyciem schematów JSON lub XML zapewnia jawne definicje pól kierujące zachowaniem modelu—przykładowo, umieszczenie zapytań użytkownika w znacznikach <user_query>, a oczekiwanych odpowiedzi w <expected_output> wyznacza niepodważalne granice. Prompty systemowe należy organizować w wyodrębnione sekcje przy użyciu nagłówków markdown lub znaczników XML: <background_information>, <instructions>, <tool_guidance>, <output_description> służą konkretnym celom i pomagają modelowi zrozumieć hierarchię informacji. Przykłady few-shot powinny zawierać nawiasowany kontekst pokazujący dokładnie, jak model ma strukturyzować odpowiedzi, z wyraźnymi ogranicznikami wokół wejść i wyjść. Definicje narzędzi korzystają z jawnych opisów parametrów i ograniczeń użycia, co zapobiega nadużyciom lub stosowaniu narzędzi poza ich przeznaczeniem. Systemy Retrieval-Augmented Generation (RAG) mogą wdrażać nawiasowanie kontekstowe poprzez otaczanie pobranych dokumentów znacznikami źródła (<source>nazwa_dokumentu</source>) i używanie wskaźników ugruntowania (grounding scores), by sprawdzać, czy odpowiedzi mieszczą się w granicach pobranych informacji. Przykładowo, funkcja granicy kontekstowej w CustomGPT działa poprzez szkolenie modeli wyłącznie na wgranych zbiorach danych, gwarantując, że odpowiedzi nigdy nie wykraczają poza dostarczoną bazę wiedzy—praktyczna implementacja nawiasowania kontekstowego na poziomie architektury.

Choć kontekstowe nawiasowanie ma cechy wspólne z pokrewnymi technikami, zajmuje odrębne miejsce w inżynierii AI. Podstawowa inżynieria promptów skupia się głównie na tworzeniu skutecznych instrukcji i przykładów, ale nie oferuje systemowego podejścia do zarządzania wszystkimi elementami kontekstu, jakie daje nawiasowanie kontekstowe. Inżynieria kontekstu, szersza dyscyplina, obejmuje nawiasowanie kontekstowe jako jeden z elementów—zawiera optymalizację promptów, projektowanie narzędzi, zarządzanie pamięcią i dynamiczne pobieranie kontekstu, stanowiąc nadzbiór względem bardziej skoncentrowanego nawiasowania. Proste podążanie za instrukcjami polega na zdolności modelu do rozumienia poleceń w języku naturalnym bez jawnych granic strukturalnych, co często zawodzi przy złożonych instrukcjach lub w sytuacjach niejednoznacznych. Guardrails i systemy walidacji działają na poziomie wyjścia, kontrolując odpowiedzi po wygenerowaniu, podczas gdy nawiasowanie kontekstowe działa na wejściu, zapobiegając halucynacjom zanim się pojawią. Kluczowa różnica polega na tym, że kontekstowe nawiasowanie jest zapobiegawcze i strukturalne—kształtuje krajobraz informacyjny, w którym działa model—zamiast być naprawcze czy reaktywne, dzięki czemu jest bardziej wydajne i niezawodne w utrzymywaniu dokładności systemów produkcyjnych.

Kontekstowe nawiasowanie przynosi wymierne korzyści w różnych zastosowaniach. Chatboty obsługi klienta wykorzystują granice kontekstu, by ograniczyć odpowiedzi do wiedzy zatwierdzonej przez firmę, zapobiegając wymyślaniu cech produktów czy składaniu nieautoryzowanych obietnic. Systemy analizy dokumentów prawnych obejmują nawiasami odpowiednie orzecznictwo, ustawy i precedensy, gwarantując, że AI odwołuje się tylko do zweryfikowanych źródeł, nie fałszując cytatów prawnych. Systemy medyczne AI wdrażają ścisłe granice kontekstu wokół wytycznych klinicznych, danych pacjentów i zatwierdzonych protokołów leczenia, uniemożliwiając niebezpieczne halucynacje mogące zaszkodzić pacjentom. Platformy generowania treści stosują nawiasowanie kontekstowe w celu egzekwowania wytycznych marki, tonu i wymogów merytorycznych, zapewniając zgodność z normami organizacji. Narzędzia badawcze i analityczne nawiasują źródła pierwotne, zbiory danych i zweryfikowane informacje, pozwalając AI syntetyzować wnioski z zachowaniem odpowiednich przypisów i bez tworzenia fałszywych statystyk czy badań. Przykładem jest AmICited.com, które monitoruje, jak systemy AI cytują i referują marki w GPT, Perplexity i Google AI Overviews—w praktyce śledząc, czy modele AI trzymają się właściwych granic kontekstu przy omawianiu firm lub produktów oraz pomagając organizacjom sprawdzić, czy systemy AI halucynują na temat ich marki, czy też rzetelnie przekazują informacje.

Skuteczne wdrożenie kontekstowego nawiasowania wymaga stosowania sprawdzonych praktyk:

Zacznij od minimalnego kontekstu: Rozpocznij od najmniejszego zestawu informacji niezbędnych do uzyskania dokładnych odpowiedzi, rozbudowuj go tylko, gdy testy wykażą luki, zapobiegając zanieczyszczeniu kontekstu i utracie koncentracji modelu.

Stosuj spójne wzorce ograniczników: Ustal i konsekwentnie używaj jednolitych konwencji ograniczników w całym systemie, co ułatwia modelowi rozpoznawanie granic i zmniejsza ryzyko pomyłek wynikających z niespójności formatowania.

Testuj i waliduj granice: Systematycznie sprawdzaj, czy model przestrzega zdefiniowanych granic, próbując nakłonić go do ich przekroczenia, by wykryć i zamknąć luki przed wdrożeniem.

Monitoruj dryf kontekstu: Nieustannie śledź, czy odpowiedzi modelu mieszczą się w zamierzonych granicach wraz ze zmianami wzorców wejściowych lub rozwojem baz wiedzy.

Wprowadź pętle zwrotne: Stwórz mechanizmy pozwalające użytkownikom lub recenzentom zgłaszać przypadki przekroczenia granic przez model, wykorzystując te uwagi do dopracowania definicji kontekstu i poprawy działania w przyszłości.

Wersjonuj definicje kontekstu: Traktuj granice kontekstu jak kod, prowadź historię wersji i dokumentację zmian, by w razie pogorszenia efektów łatwo wycofać nowe definicje granic.

Wiele platform wbudowało funkcjonalności kontekstowego nawiasowania w swoje podstawowe rozwiązania. CustomGPT.ai wdraża granice kontekstu poprzez funkcję “context boundary”, która działa jak ochronny mur zapewniający, że AI korzysta wyłącznie z danych dostarczonych przez użytkownika, nigdy nie sięgając po wiedzę ogólną ani nie wymyślając informacji—podejście to sprawdziło się m.in. w MIT, gdzie wymagana jest absolutna dokładność przekazu. Claude od Anthropic kładzie nacisk na zasady inżynierii kontekstu, oferując szczegółową dokumentację dotyczącą strukturyzowania promptów, zarządzania oknem kontekstu i wdrażania guardrails utrzymujących odpowiedzi w wyznaczonych granicach. AWS Bedrock Guardrails zapewnia automatyczne kontrole rozumowania weryfikujące wygenerowane treści względem reguł logicznych i matematycznych, a wskaźnik grounding score powyżej 0,85 wymagany jest np. w aplikacjach finansowych. Shelf.io oferuje rozwiązania RAG z zarządzaniem kontekstem, co pozwala wdrażać retrieval-augmented generation przy ścisłej kontroli, do jakich informacji model ma dostęp i do czego może się odwoływać. AmICited.com pełni rolę komplementarną, monitorując, jak systemy AI cytują i referują Twoją markę na wielu platformach AI, pomagając zrozumieć, czy modele AI respektują odpowiednie granice kontekstu podczas omawiania Twojej organizacji oraz czy pozostają w obrębie dokładnych, zweryfikowanych informacji o marce—czyli zapewniając wgląd, czy kontekstowe nawiasowanie faktycznie działa w praktyce.

Inżynieria promptów skupia się głównie na tworzeniu skutecznych instrukcji i przykładów, podczas gdy kontekstowe nawiasowanie to systematyczne podejście do zarządzania wszystkimi elementami kontekstu poprzez jawne ograniczniki i granice. Nawiasowanie kontekstowe jest bardziej uporządkowane i zapobiegawcze, działa na poziomie wejściowym, by zapobiegać halucynacjom zanim wystąpią, podczas gdy inżynieria promptów jest szersza i obejmuje różne techniki optymalizacji.

Kontekstowe nawiasowanie zapobiega halucynacjom poprzez tworzenie wyraźnych granic informacji przy użyciu ograniczników, takich jak znaczniki XML czy nagłówki markdown. Dzięki temu model AI dokładnie wie, które informacje powinien uwzględnić, a które zignorować, co chroni przed wymyślaniem szczegółów lub zakładaniem niepodanych danych. Ograniczając uwagę modelu do zdefiniowanych granic, zmniejsza się prawdopodobieństwo generowania fałszywych faktów lub nieistniejących źródeł.

Typowe ograniczniki to znaczniki XML (np.

Zasady kontekstowego nawiasowania można zastosować w większości nowoczesnych modeli językowych, choć skuteczność jest zróżnicowana. Modele lepiej wyszkolone w podążaniu za instrukcjami (takie jak Claude, GPT-4 i Gemini) zwykle lepiej respektują granice. Technika ta działa najlepiej w połączeniu z modelami obsługującymi strukturalne wyjścia i trenowanymi na zróżnicowanych, dobrze sformatowanych danych.

Rozpocznij od organizowania promptów systemowych w odrębne sekcje przy użyciu wyraźnych ograniczników. Strukturyzuj wejścia i wyjścia wykorzystując schematy JSON lub XML. Stosuj spójne wzorce ograniczników wszędzie. Wdrażaj przykłady few-shot pokazujące modelowi, jak ma respektować granice. Testuj szeroko, by upewnić się, że model przestrzega zdefiniowanych granic, oraz monitoruj wydajność w czasie, by wychwycić dryf kontekstu.

Kontekstowe nawiasowanie może nieznacznie zwiększyć zużycie tokenów z powodu dodatkowych ograniczników i znaczników strukturalnych, ale zwykle jest to rekompensowane przez poprawioną dokładność i zmniejszoną liczbę halucynacji. Technika ta faktycznie zwiększa efektywność, zapobiegając marnowaniu tokenów na wymyślone informacje. W systemach produkcyjnych zyski w dokładności zdecydowanie przewyższają minimalny narzut tokenowy.

Kontekstowe nawiasowanie i RAG to techniki komplementarne. RAG pobiera istotne informacje ze źródeł zewnętrznych, podczas gdy nawiasowanie kontekstowe dba, by model trzymał się granic tych pobranych danych. Razem tworzą silny system pozwalający modelowi korzystać z zewnętrznej wiedzy, jednocześnie ograniczając go do odwoływania się wyłącznie do zweryfikowanych, pobranych źródeł.

Kilka platform ma wbudowane wsparcie: CustomGPT.ai oferuje funkcje granic kontekstowych, Claude od Anthropic zapewnia dokumentację inżynierii kontekstu i wsparcie dla strukturalnych wyjść, AWS Bedrock Guardrails automatycznie sprawdza rozumowanie, a Shelf.io oferuje RAG z zarządzaniem kontekstem. AmICited.com monitoruje, jak systemy AI cytują Twoją markę, pomagając zweryfikować skuteczność kontekstowego nawiasowania.

Kontekstowe nawiasowanie zapewnia, że systemy AI przekazują dokładne informacje o Twojej marce. Skorzystaj z AmICited, by śledzić, jak modele AI cytują i referują Twoje treści w GPT, Perplexity i Google AI Overviews.

Dowiedz się, jak stworzyć kompleksowe pokrycie tematu za pomocą klastrów tematycznych, stron filarowych i analizy luk w treści, aby zbudować autorytet i poprawi...

Dyskusja społeczności na temat okien kontekstu w AI i ich znaczenia dla marketingu treści. Zrozumienie, jak limity kontekstu wpływają na przetwarzanie Twojej tr...

Dowiedz się, czym są okna kontekstowe w modelach językowych AI, jak działają, jaki mają wpływ na wydajność modeli oraz dlaczego są ważne dla aplikacji opartych ...