Jak dynamiczne renderowanie wpływa na AI: wpływ na indeksowanie i widoczność

Dowiedz się, jak dynamiczne renderowanie wpływa na widoczność crawlerów AI, ChatGPT, Perplexity i Claude. Sprawdź, dlaczego systemy AI nie potrafią renderować J...

Dynamiczne renderowanie to technika po stronie serwera, która wykrywa, czy żądanie pochodzi od użytkownika, czy od bota wyszukiwarki, a następnie odpowiednio serwuje różne wersje tej samej treści — renderowany po stronie klienta JavaScript dla użytkowników oraz w pełni renderowany statyczny HTML po stronie serwera dla botów. Takie podejście optymalizuje indeksowanie i możliwość crawlowania, jednocześnie zachowując pełne doświadczenie użytkownika.

Dynamiczne renderowanie to technika po stronie serwera, która wykrywa, czy żądanie pochodzi od użytkownika, czy od bota wyszukiwarki, a następnie odpowiednio serwuje różne wersje tej samej treści — renderowany po stronie klienta JavaScript dla użytkowników oraz w pełni renderowany statyczny HTML po stronie serwera dla botów. Takie podejście optymalizuje indeksowanie i możliwość crawlowania, jednocześnie zachowując pełne doświadczenie użytkownika.

Dynamiczne renderowanie to technika dostarczania treści po stronie serwera, która wykrywa typ żądania kierowanego do strony — czy pochodzi ono od człowieka, czy od bota wyszukiwarki — i odpowiednio serwuje zoptymalizowane wersje treści. Gdy użytkownik odwiedza stronę, otrzymuje pełną wersję renderowaną po stronie klienta z całym JavaScriptem, elementami interaktywnymi i funkcjami dynamicznymi. Z kolei gdy tę samą stronę żąda bot wyszukiwarki lub AI crawler, serwer wykrywa to na podstawie identyfikacji user-agenta i przekierowuje żądanie do silnika renderującego, który konwertuje treści ciężkie w JavaScript na statyczny, w pełni renderowany HTML. Ta statyczna wersja jest następnie serwowana botowi, eliminując konieczność wykonywania przez niego kodu JavaScript. Technika ta pojawiła się jako praktyczne rozwiązanie wyzwania, z jakim mierzą się wyszukiwarki przy przetwarzaniu JavaScriptu na dużą skalę, i nabiera coraz większego znaczenia wraz z rozwojem platform wyszukiwania opartych na AI, takich jak ChatGPT, Perplexity, Claude i Google AI Overviews, które rozszerzają swoje działania crawlingowe w sieci.

Dynamiczne renderowanie zostało oficjalnie przedstawione społeczności SEO przez Google podczas konferencji I/O w 2018 roku, gdy John Mueller zaprezentował je jako obejście problemów z indeksacją związanych z JavaScriptem. W tamtym czasie Google przyznało, że choć Googlebot technicznie potrafi renderować JavaScript, to jednak na skalę całego internetu pochłania to znaczące zasoby obliczeniowe i powoduje opóźnienia w wykrywaniu oraz indeksowaniu treści. Bing w czerwcu 2018 roku również zaktualizował swoje wytyczne dla webmasterów, rekomendując dynamiczne renderowanie szczególnie dla dużych stron mających problemy z przetwarzaniem JavaScriptu. Technika ta zyskała popularność wśród dużych serwisów korporacyjnych i aplikacji ciężkich w JavaScript jako pragmatyczny kompromis między zachowaniem bogatego doświadczenia użytkownika a zapewnieniem dostępności dla wyszukiwarek. Jednak podejście Google zmieniło się znacząco do 2022 roku, kiedy firma zaktualizowała oficjalną dokumentację, jasno stwierdzając, że dynamiczne renderowanie to obejście, a nie długoterminowe rozwiązanie. Ta zmiana odzwierciedliła preferencję Google dla trwalszych podejść renderowania, takich jak renderowanie po stronie serwera (SSR), statyczne renderowanie i hydratacja. Pomimo tej zmiany klasyfikacji, dynamiczne renderowanie nadal jest szeroko stosowane w internecie, szczególnie na dużych platformach e-commerce, aplikacjach jednostronicowych i stronach bogatych w treści, które nie mogą od razu przejść na alternatywne architektury renderowania.

Mechanizm dynamicznego renderowania opiera się na trzech kluczowych komponentach: wykrywaniu user-agenta, routingu treści oraz renderowaniu i cache’owaniu. Gdy na serwer trafia żądanie, pierwszym krokiem jest określenie, czy pochodzi ono od człowieka, czy zautomatyzowanego bota. Identyfikacja następuje poprzez analizę stringa user-agenta w nagłówku żądania HTTP, który zawiera informacje o kliencie. Boty wyszukiwarek, takie jak Googlebot, Bingbot oraz AI crawlery z platform takich jak Perplexity czy Claude, identyfikują się poprzez specyficzne stringi user-agenta. Po wykryciu bota serwer przekierowuje żądanie do usługi dynamicznego renderowania lub middleware, które zwykle wykorzystuje przeglądarkę bezgłową (np. Chromium lub Puppeteer) do renderowania JavaScriptu strony i konwersji jej do statycznego HTML. Proces ten wykonuje cały kod JavaScript, ładuje dynamiczne treści i generuje końcowy DOM (Document Object Model), który normalnie powstałby w przeglądarce użytkownika. Tak uzyskany statyczny HTML jest cache’owany w celu uniknięcia powtarzającego się renderowania i serwowany bezpośrednio botom. Użytkownicy natomiast omijają tę ścieżkę renderowania i otrzymują oryginalną wersję renderowaną po stronie klienta, co zapewnia im pełne doświadczenie interaktywne z animacjami, aktualizacjami w czasie rzeczywistym i funkcjami dynamicznymi.

| Aspekt | Dynamiczne renderowanie | Renderowanie po stronie serwera (SSR) | Renderowanie statyczne | Renderowanie po stronie klienta (CSR) |

|---|---|---|---|---|

| Dostarczanie treści użytkownikom | Renderowane po stronie klienta (JavaScript) | Renderowane po stronie serwera (HTML) | Wstępnie zbudowany statyczny HTML | Renderowane po stronie klienta (JavaScript) |

| Dostarczanie treści botom | Renderowane po stronie serwera (HTML) | Renderowane po stronie serwera (HTML) | Wstępnie zbudowany statyczny HTML | Renderowane po stronie klienta (JavaScript) |

| Złożoność wdrożenia | Umiarkowana | Wysoka | Niska | Niska |

| Wymagania zasobowe | Średnie (renderowanie tylko dla botów) | Wysokie (renderowanie dla wszystkich żądań) | Niskie (brak renderowania) | Niskie (tylko po stronie klienta) |

| Wydajność dla użytkowników | Zależna od JavaScriptu | Doskonała | Doskonała | Różna |

| Wydajność dla botów | Doskonała | Doskonała | Doskonała | Słaba |

| Wpływ na budżet crawlowania | Pozytywny (szybsze przetwarzanie przez boty) | Pozytywny (szybsze przetwarzanie przez boty) | Pozytywny (najszybsze) | Negatywny (wolne renderowanie) |

| Rekomendacja SEO | Tymczasowe obejście | Preferowane długoterminowo | Preferowane długoterminowo | Niewskazane dla SEO |

| Najlepsze przypadki użycia | Duże strony JS z ograniczonym budżetem | Nowoczesne aplikacje webowe | Blogi, dokumentacje, treści statyczne | Aplikacje nastawione na użytkownika, bez potrzeb SEO |

| Obciążenie utrzymaniowe | Niskie-umiarkowane | Wysokie | Niskie | Niskie |

Podstawowy powód istnienia dynamicznego renderowania wynika z kluczowego wyzwania współczesnego web developmentu: renderowania JavaScriptu na dużą skalę. JavaScript umożliwia bogate, interaktywne doświadczenia użytkownika z aktualizacjami w czasie rzeczywistym, animacjami i złożoną funkcjonalnością, ale stwarza znaczne przeszkody dla botów wyszukiwarek. Gdy bot napotyka stronę zbudowaną w frameworku React, Vue czy Angular, musi wykonać kod JavaScript, by zobaczyć finalną treść. Proces ten jest kosztowny obliczeniowo i czasochłonny. Google publicznie przyznało ten problem, m.in. przez wypowiedzi Martina Splitta (Google Search Advocate): „Mimo że Googlebot potrafi wykonać JavaScript, nie chcemy na tym polegać.” Wynika to z faktu, że Google operuje w ramach ograniczonego budżetu crawlowania — ilości czasu i zasobów obliczeniowych przeznaczonych na crawl każdej strony. Według badań firmy Botify, analizujących 6,2 miliarda żądań Googlebota na 413 milionach stron, około 51% stron dużych serwisów korporacyjnych pozostaje niecrawlowanych z powodu ograniczeń budżetowych. Gdy JavaScript spowalnia proces crawlowania, mniej stron zostaje odkrytych i zindeksowanych. Dodatkowo istnieje budżet renderowania oddzielny od budżetu crawlowania — nawet jeśli strona zostanie zcrawlowana, Google może odłożyć renderowanie jej JavaScriptu do czasu dostępności zasobów, co potencjalnie opóźnia indeksację o godziny lub dni. To szczególnie problematyczne dla sklepów internetowych z szybko zmieniającym się asortymentem lub serwisów newsowych publikujących setki artykułów dziennie, gdzie terminowa indeksacja bezpośrednio wpływa na widoczność i ruch.

Budżet crawlowania to jedno z najważniejszych, ale często błędnie rozumianych pojęć w SEO. Google oblicza budżet crawlowania według wzoru: Crawl Budget = Crawl Capacity + Crawl Demand. Crawl capacity zależy od szybkości ładowania strony i błędów serwera, a crawl demand od popularności i sygnałów świeżości strony. Wdrożenie dynamicznego renderowania bezpośrednio poprawia crawl capacity, skracając czas, jaki boty spędzają na przetwarzaniu każdej strony. Badania wykazują, że strony z czasem renderowania poniżej 3 sekund są crawl’owane o około 45% częściej niż strony z czasem ładowania 500-1000 ms oraz o około 130% częściej niż te powyżej 1000 ms. Serwując botom wstępnie renderowany statyczny HTML zamiast ciężkiego JavaScriptu, dynamiczne renderowanie znacząco obniża czas ładowania dla crawlerów, pozwalając przetwarzać więcej stron w ramach dostępnego budżetu. Zyski tej efektywności przekładają się bezpośrednio na poprawę wskaźników indeksacji. Dla dużych serwisów z tysiącami lub milionami stron różnica może oznaczać indeksację 50% vs. 80% (lub więcej) stron. Ponadto dynamiczne renderowanie zapewnia, że treść ładowana przez JavaScript jest natychmiast widoczna dla botów, zamiast trafiać do kolejki renderowania. Ma to szczególne znaczenie dla często zmieniającej się treści, gwarantując, że boty widzą aktualną wersję, a nie cache’owaną lub przeterminowaną.

Pojawienie się platform AI wyszukiwania, takich jak ChatGPT, Perplexity, Claude czy Google AI Overviews, wprowadziło nowy wymiar do dyskusji o dynamicznym renderowaniu. Platformy te mają własne crawlery, które przetwarzają treści internetowe, by generować odpowiedzi i podsumowania oparte na AI. W przeciwieństwie do tradycyjnych wyszukiwarek, które głównie indeksują strony do rankingu, crawlery AI muszą głębiej rozumieć treści, aby generować trafne, kontekstowe odpowiedzi. Dynamiczne renderowanie nabiera tu szczególnego znaczenia, ponieważ zapewnia crawlerom AI szybki i pełny dostęp do Twoich treści. Gdy AmICited monitoruje obecność Twojej marki w odpowiedziach generowanych przez AI, kluczowe jest, czy crawler AI był w stanie skutecznie pozyskać i zrozumieć zawartość Twojej strony. Jeśli Twój serwis mocno polega na JavaScript, a nie wdrożono dynamicznego renderowania, crawlery AI mogą mieć problem z dostępem do treści, przez co Twoja marka rzadziej pojawi się w odpowiedziach AI. Z kolei serwisy z prawidłowo wdrożonym dynamicznym renderowaniem gwarantują crawlerom AI pełny, dostępny HTML, zwiększając szansę na cytowanie i widoczność. Czyni to dynamiczne renderowanie nie tylko kwestią SEO, ale kluczowym elementem strategii Generative Engine Optimization (GEO). Organizacje korzystające z AmICited do monitorowania widoczności w AI search powinny traktować dynamiczne renderowanie jako podstawowy element techniczny, by zmaksymalizować obecność we wszystkich platformach AI.

Wdrożenie dynamicznego renderowania wymaga starannego planowania i realizacji. Pierwszym krokiem jest identyfikacja stron wymagających dynamicznego renderowania — zwykle są to strony kluczowe, takie jak strona główna, strony produktów oraz te generujące duży ruch lub często zmieniające się. Nie każda podstrona musi być dynamicznie renderowana; strony statyczne z minimalną ilością JavaScriptu mogą być skutecznie crawl’owane bez tej techniki. Kolejny krok to wybór narzędzia renderującego. Popularne opcje to Prerender.io (płatna usługa zapewniająca renderowanie i cache’owanie), Rendertron (open-source Google, oparty na headless Chromium), Puppeteer (biblioteka Node.js do sterowania headless Chrome) i wyspecjalizowane platformy, np. Crawler Optimization od Nostra AI. Każde narzędzie różni się kosztami, złożonością i wymaganiami utrzymaniowymi. Po wyborze narzędzia programiści konfigurują middleware do wykrywania user-agentów na serwerze, które wykrywa boty i odpowiednio przekierowuje żądania. Kluczowe jest cache’owanie — wstępnie renderowana treść powinna być agresywnie cache’owana, by unikać ponownego renderowania tych samych stron. Wdrożenie należy zweryfikować za pomocą narzędzia URL Inspection w Google Search Console oraz Mobile-Friendly Test, by upewnić się, że boty otrzymują prawidłowo renderowaną treść.

Główne zalety dynamicznego renderowania są znaczące i dobrze udokumentowane. Poprawa crawlability to najważniejsza korzyść — eliminując obciążenie związane z przetwarzaniem JavaScriptu, boty mogą crawlować więcej stron szybciej. Lepsza indeksacja wynika naturalnie, gdy więcej stron zostaje odkrytych i zindeksowanych w ramach danego budżetu. Szybsze przetwarzanie przez boty zmniejsza obciążenie serwera, ponieważ renderowanie następuje raz i jest cache’owane, zamiast powtarzać się przy każdym wejściu bota. Zachowanie doświadczenia użytkownika to przewaga nad innymi podejściami — użytkownicy nadal otrzymują pełną, interaktywną wersję strony bez kompromisów. Niższy koszt wdrożenia w porównaniu do SSR sprawia, że technika jest dostępna także dla organizacji z ograniczonymi zasobami deweloperskimi. Jednak dynamiczne renderowanie ma istotne ograniczenia. Złożoność i koszt utrzymania mogą być znaczne, szczególnie dla dużych serwisów z tysiącami stron lub złożoną strukturą treści. Wyzwania cache’owania pojawiają się przy często zmieniających się treściach — cache musi być odpowiednio odświeżany. Ryzyko niespójności między wersją dla użytkownika a dla bota może prowadzić do problemów z indeksacją, jeśli nie jest to dokładnie kontrolowane. Konsumpcja zasobów na renderowanie i cache’owanie generuje dodatkowe koszty operacyjne. Najważniejsze jednak, że Google oficjalnie traktuje dynamiczne renderowanie jako rozwiązanie tymczasowe, więc organizacje powinny postrzegać je jako etap przejściowy w drodze do trwalszych architektur renderowania.

Przyszłość dynamicznego renderowania jest ściśle związana z szerokimi trendami w rozwoju webowym i ewolucji wyszukiwarek. Ponieważ frameworki JavaScript nadal dominują w nowoczesnym web developmencie, potrzeba rozwiązań łączących bogate doświadczenia użytkownika z dostępnością dla botów pozostaje aktualna. Jednak branża stopniowo przesuwa się w stronę trwalszych podejść. Renderowanie po stronie serwera staje się coraz łatwiejsze dzięki frameworkom takim jak Next.js, Nuxt czy Remix. Renderowanie statyczne i inkrementalne generowanie statyczne zapewniają świetną wydajność dla treści niezmieniających się stale. Hydratacja — czyli początkowe renderowanie po stronie serwera, a następnie wzbogacenie interaktywności po stronie klienta — zyskuje na popularności. Zaktualizowane wytyczne Google jednoznacznie rekomendują te alternatywy, sygnalizując, że dynamiczne renderowanie jest traktowane jako rozwiązanie przejściowe, a nie wzorzec długoterminowy. Rozwój platform AI wyszukiwania wprowadza kolejny wymiar tej ewolucji. Wraz z rosnącą zaawansowaniem tych platform w crawl’owaniu i rozumieniu treści, znaczenie dostępnych, dobrze ustrukturyzowanych treści tylko rośnie. Dynamiczne renderowanie prawdopodobnie pozostanie ważne dla organizacji z systemami legacy lub określonymi ograniczeniami, ale nowe projekty powinny od początku stawiać na trwalsze strategie renderowania. Dla organizacji aktualnie korzystających z AmICited do monitorowania widoczności w AI search, wniosek strategiczny jest jasny: dynamiczne renderowanie może poprawić natychmiastową widoczność w odpowiedziach AI, ale planowanie migracji do bardziej trwałych podejść powinno być elementem długofalowej strategii Generative Engine Optimization. Konwergencja tradycyjnego SEO, optymalizacji technicznej i widoczności w AI search sprawia, że strategia renderowania to już nie tylko kwestia techniczna, lecz decyzja biznesowa wpływająca na odkrywalność we wszystkich kanałach wyszukiwania.

Nie, Google wyraźnie stwierdza, że dynamiczne renderowanie nie jest cloakingiem, o ile treść serwowana botom i użytkownikom jest zasadniczo podobna. Cloaking polega na celowym serwowaniu zupełnie innych treści w celu wprowadzenia w błąd wyszukiwarek, podczas gdy dynamiczne renderowanie dostarcza tę samą treść w różnych formatach. Jednak serwowanie całkowicie różnych stron (np. kotów użytkownikom, a psów botom) byłoby uznane za cloaking i naruszałoby polityki Google.

Dynamiczne renderowanie zmniejsza zasoby obliczeniowe wymagane do przetwarzania JavaScriptu przez boty wyszukiwarek, pozwalając im na crawlowanie większej liczby stron w ramach przydzielonego budżetu. Serwując wstępnie renderowany statyczny HTML zamiast treści opartej na ciężkim JavaScript, boty mogą szybciej uzyskać dostęp do stron i je zindeksować. Badania pokazują, że strony z czasem renderowania poniżej 3 sekund są ponownie crawlowane o około 45% częściej niż wolniejsze strony, co bezpośrednio poprawia wskaźniki indeksacji.

Renderowanie po stronie serwera (SSR) renderuje treść na serwerze zarówno dla użytkowników, jak i botów, poprawiając wydajność dla wszystkich, lecz wymaga dużych zasobów deweloperskich. Dynamiczne renderowanie renderuje wstępnie tylko dla botów, podczas gdy użytkownicy otrzymują zwykłą wersję renderowaną po stronie klienta, dzięki czemu wdrożenie jest mniej zasobożerne. Google obecnie zaleca SSR, statyczne renderowanie lub hydratację jako rozwiązania długoterminowe zamiast dynamicznego renderowania, które traktowane jest jako tymczasowe obejście.

Dynamiczne renderowanie jest idealne dla dużych, ciężkich w JavaScript stron ze zmieniającą się treścią, takich jak platformy e-commerce z ciągle aktualizowanym asortymentem, aplikacje jednostronicowe (SPA) oraz serwisy z rozbudowanymi funkcjami interaktywnymi. Największe korzyści uzyskają strony mające problemy z budżetem crawlowania — gdzie Google nie jest w stanie crawlować znaczących części treści. Według badań, Google pomija około 51% stron dużych serwisów korporacyjnych z powodu ograniczeń budżetu crawlowania.

AI crawlery wykorzystywane przez platformy takie jak ChatGPT, Perplexity i Claude przetwarzają treści internetowe podobnie jak tradycyjne boty wyszukiwarek, wymagając w pełni dostępnego HTML do optymalnej indeksacji. Dynamiczne renderowanie pomaga tym systemom AI efektywniej uzyskiwać i rozumieć treści generowane przez JavaScript, zwiększając szansę na pojawienie się Twojej strony w odpowiedziach i podsumowaniach generowanych przez AI. Jest to szczególnie ważne w monitoringu AmICited, gdyż prawidłowe renderowanie gwarantuje obecność Twojej marki w wynikach wyszukiwania AI.

Popularne rozwiązania do dynamicznego renderowania to m.in. Prerender.io (usługa płatna), Rendertron (open-source), Puppeteer oraz wyspecjalizowane platformy, takie jak Crawler Optimization od Nostra AI. Narzędzia te wykrywają boty na podstawie user-agentów, generują statyczne wersje HTML stron i cachują je dla szybszego serwowania. Wdrożenie zwykle polega na instalacji renderera na serwerze, skonfigurowaniu middleware do wykrywania user-agentów oraz weryfikacji ustawień za pomocą narzędzia URL Inspection w Google Search Console.

Nie, dynamiczne renderowanie nie wpływa na doświadczenie użytkownika, ponieważ odwiedzający nadal otrzymują pełną, renderowaną po stronie klienta wersję strony, wraz ze wszystkimi elementami interaktywnymi, animacjami i funkcjami dynamicznymi. Użytkownicy nigdy nie zobaczą statycznej wersji HTML serwowanej botom. Technika ta jest zaprojektowana specjalnie z myślą o optymalizacji crawlability przez boty, bez kompromisów dla bogatego, dynamicznego doświadczenia użytkownika.

Google zalecił dynamiczne renderowanie w 2018 roku jako praktyczne rozwiązanie problemów z renderowaniem JavaScriptu na dużą skalę. Jednak od 2022 roku zaktualizował swoje wytyczne, jasno określając, że jest to rozwiązanie tymczasowe, a nie długoterminowe. Ta zmiana rekomendacji odzwierciedla preferencję Google dla bardziej trwałych podejść, takich jak renderowanie po stronie serwera, statyczne renderowanie czy hydratacja. Dynamiczne renderowanie wciąż znajduje zastosowanie w określonych przypadkach, ale powinno być elementem szerszej strategii optymalizacji wydajności, a nie samodzielnym rozwiązaniem.

Zacznij śledzić, jak chatboty AI wspominają Twoją markę w ChatGPT, Perplexity i innych platformach. Uzyskaj praktyczne spostrzeżenia, aby poprawić swoją obecność w AI.

Dowiedz się, jak dynamiczne renderowanie wpływa na widoczność crawlerów AI, ChatGPT, Perplexity i Claude. Sprawdź, dlaczego systemy AI nie potrafią renderować J...

Dowiedz się, czym jest AI Prerendering i jak strategie renderowania po stronie serwera optymalizują Twoją stronę pod kątem widoczności dla crawlerów AI. Poznaj ...

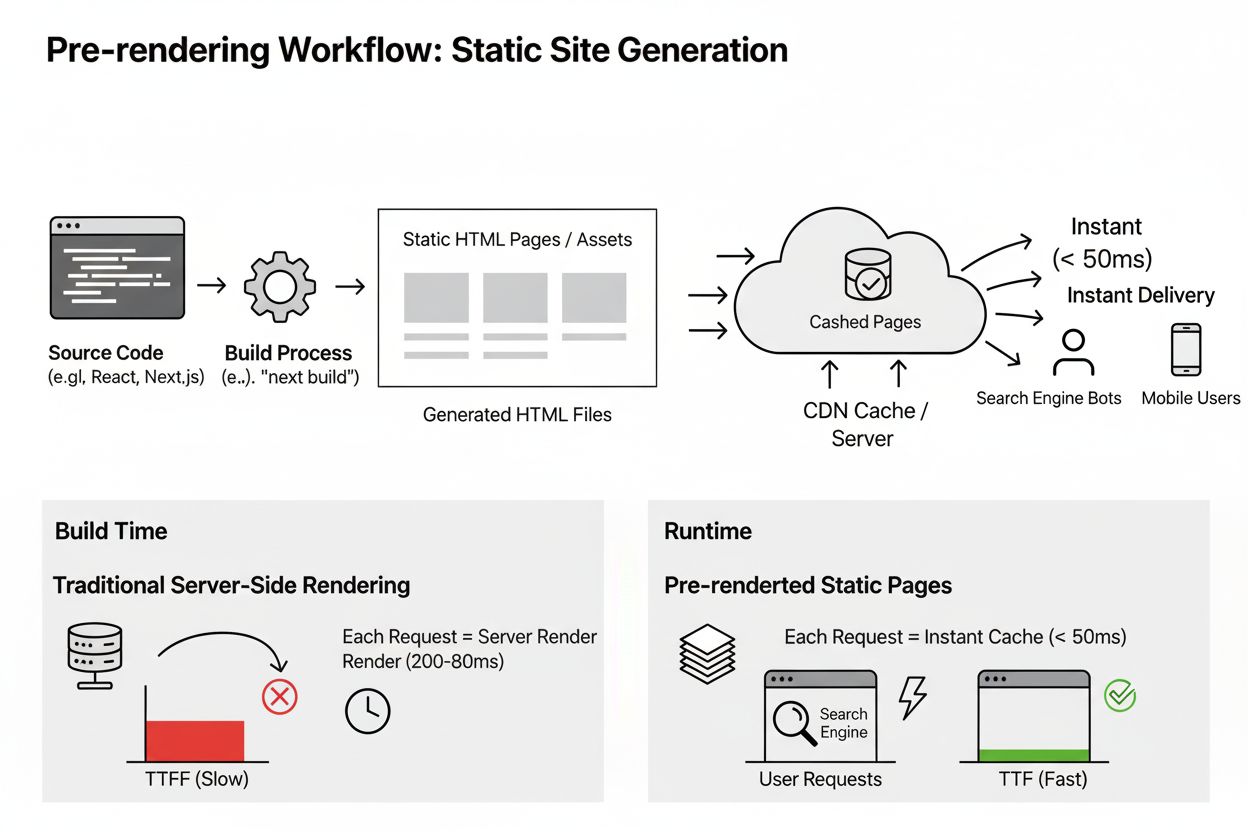

Pre-rendering generuje statyczne strony HTML podczas budowania dla natychmiastowego dostarczenia i poprawy SEO. Dowiedz się, jak ta technika wspiera indeksowani...