Definicja Google Gemini

Google Gemini to rodzina multimodalnych dużych modeli językowych (LLM) opracowanych przez Google DeepMind, będąca następcą wcześniejszych modeli, takich jak LaMDA i PaLM 2. W przeciwieństwie do tradycyjnych modeli językowych przetwarzających wyłącznie tekst, Gemini jest od podstaw zaprojektowany do obsługi wielu modalności danych jednocześnie, obejmując tekst, obrazy, dźwięk, wideo oraz kod programistyczny. Model napędza chatbota Gemini AI (wcześniej Bard) i jest coraz szerzej integrowany w ekosystemie produktów i usług Google. Multimodalna architektura Gemini pozwala mu rozumieć złożone relacje między różnymi typami informacji, dzięki czemu radzi sobie z zadaniami takimi jak analiza obrazów, generowanie kodu, tłumaczenia w czasie rzeczywistym czy rozumienie dokumentów. Nazwa „Gemini” pochodzi z łaciny i oznacza „bliźnięta”, nawiązując do współpracy zespołów Google DeepMind i Google Brain, a także zainspirowana jest programem kosmicznym Gemini NASA.

Kontekst historyczny i kamienie milowe rozwoju

Droga Google do stworzenia Gemini to lata badań podstawowych nad dużymi modelami językowymi i architekturami sieci neuronowych. W 2017 roku badacze Google zaprezentowali architekturę transformatorową, która stała się fundamentem większości współczesnych LLM. Następnie powstała Meena (2020), konwersacyjna AI z 2,6 miliardami parametrów, a później LaMDA (Language Model for Dialogue Applications) w 2021, wyspecjalizowana w zadaniach dialogowych. Premiera PaLM (Pathways Language Model) w 2022 przyniosła ulepszenia w kodowaniu, wielojęzyczności i wnioskowaniu. Na początku 2023 Google uruchomił Bard (początkowo w oparciu o lekką wersję LaMDA, potem PaLM 2 w połowie 2023). Oficjalna zapowiedź Gemini 1.0 nastąpiła w grudniu 2023, stanowiąc przełom w możliwościach multimodalnych. W 2024 roku Bard został przemianowany na Gemini, a Gemini 1.5 wprowadził rewolucyjne okno kontekstu o długości 2 milionów tokenów. Najnowsze Gemini 2.0 i Gemini 2.5 (grudzień 2024) oferują agentowe możliwości AI, umożliwiając modelowi podejmowanie autonomicznych działań i wnioskowanie w rozszerzonych kontekstach. Ten rozwój pokazuje, że Google konsekwentnie rozwija AI, koncentrując się na praktycznych zastosowaniach.

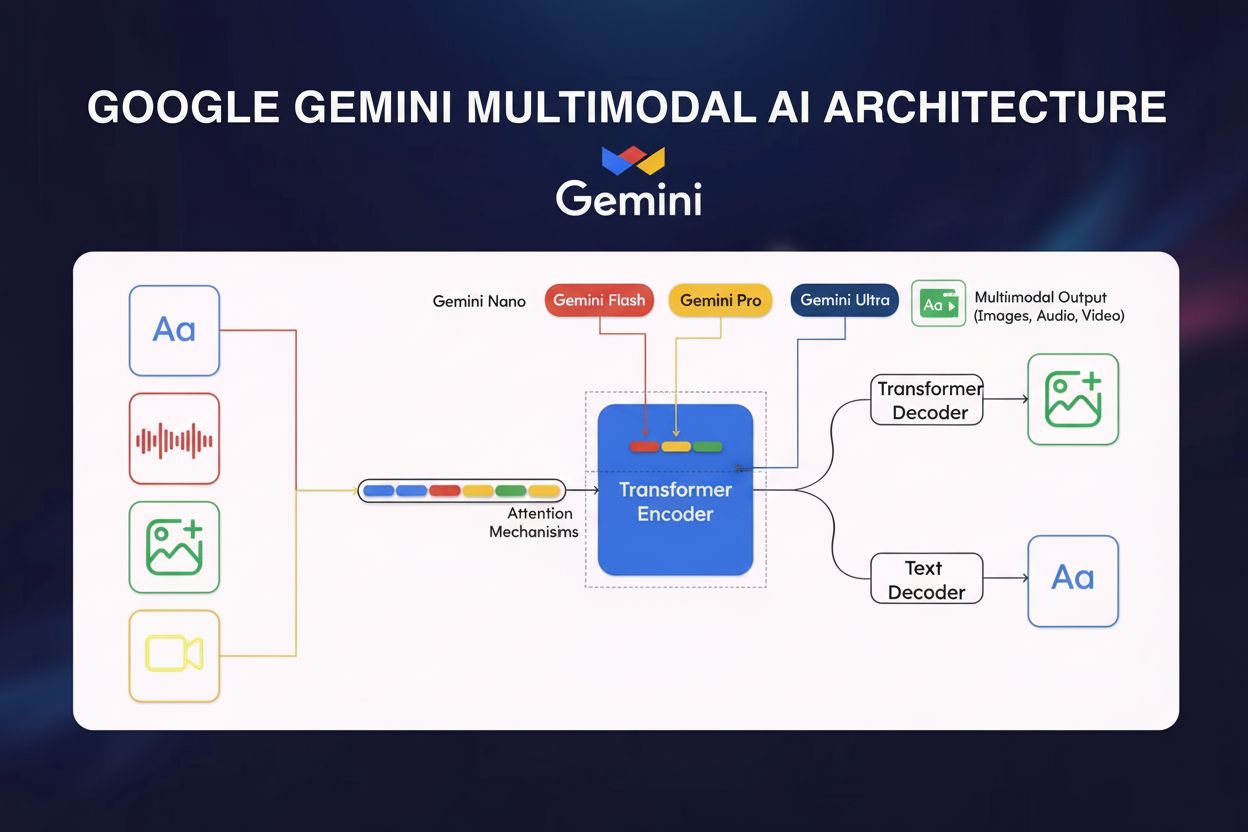

Architektura techniczna i kluczowe komponenty

Podstawy techniczne Google Gemini opierają się na zaawansowanych innowacjach architektonicznych, które odróżniają go od modeli konkurencyjnych. Rdzeniem Gemini jest architektura sieci neuronowej oparta na transformatorach zoptymalizowana z użyciem Cloud TPU v5p (Tensor Processing Units) do wydajnego treningu i inferencji. Multimodalny enkoder modelu integruje dane wizualne, dźwiękowe i tekstowe przez wyspecjalizowane ścieżki przetwarzania, które łączą się w ujednoliconej przestrzeni reprezentacji. Kluczową innowacją jest mechanizm uwagi między modalnościami (cross-modal attention), umożliwiający tworzenie powiązań między różnymi typami danych — np. powiązanie elementów wizualnych obrazu z opisami tekstowymi lub rozumienie, jak treść audio koresponduje z kontekstem wizualnym. Gemini 1.5 Pro wprowadził architekturę Mixture of Experts (MoE), będącą przełomem w efektywności modeli: zamiast aktywować wszystkie parametry sieci dla każdego wejścia, MoE dzieli model na mniejsze eksperckie sieci wyspecjalizowane w konkretnych domenach lub typach danych. Model uczy się aktywować tylko najbardziej adekwatnych ekspertów w zależności od wejścia, znacząco obniżając koszty obliczeniowe przy zachowaniu (lub nawet poprawie) wydajności. Ta architektura pozwoliła Gemini 1.5 Flash osiągnąć wydajność porównywalną z Gemini 1.0 Ultra przy znacznie większej efektywności, m.in. dzięki destylacji wiedzy — technice transferu wiedzy z większego modelu Pro do bardziej kompaktowej wersji Flash. Okno kontekstu — liczba tokenów przetwarzanych jednocześnie — wzrosło radykalnie: od 32 000 tokenów w Gemini 1.0 do 1 miliona tokenów w Gemini 1.5 Flash i 2 milionów tokenów w Gemini 1.5 Pro, umożliwiając przetwarzanie całych książek, długich filmów czy tysięcy linii kodu w jednej interakcji.

Warianty modeli Gemini i ich zastosowania

| Wariant modelu | Rozmiar/poziom | Okno kontekstu | Główne zastosowania | Wdrożenie | Kluczowa zaleta |

|---|

| Gemini 1.0 Nano | Najmniejszy | 32 000 tokenów | Zadania mobilne, przetwarzanie na urządzeniu, opisy obrazów, odpowiedzi na czacie | Urządzenia Android (Pixel 8 Pro+), Chrome desktop | Działa bez połączenia z internetem |

| Gemini 1.0 Ultra | Największy | 32 000 tokenów | Złożone wnioskowanie, zaawansowane programowanie, analiza matematyczna, multimodalne rozumowanie | Chmura, przedsiębiorstwa | Najwyższa dokładność w benchmarkach |

| Gemini 1.5 Pro | Średni | 2 miliony tokenów | Analiza dokumentów, repozytoria kodu, długie treści, aplikacje biznesowe | Google Cloud, dostęp przez API | Najdłuższe okno kontekstu, zbalansowana wydajność |

| Gemini 1.5 Flash | Lekki | 1 milion tokenów | Szybkie odpowiedzi, ekonomiczne przetwarzanie, aplikacje czasu rzeczywistego | Chmura, urządzenia mobilne, edge | Optymalizacja pod kątem szybkości i efektywności |

| Gemini 2.0/2.5 | Nowa generacja | Zmienna | Agentowe AI, autonomiczne zadania, zaawansowane wnioskowanie, interakcje w czasie rzeczywistym | Chmura, usługi zintegrowane | Agentowość, ulepszone wnioskowanie |

Przetwarzanie multimodalne i rozumienie między modalnościami

Multimodalny charakter Google Gemini oznacza fundamentalne odejście od wcześniejszych modeli AI operujących głównie w jednej modalności. Możliwość Gemini do przetwarzania przeplatanych sekwencji audio, obrazu, tekstu i wideo zarówno jako wejścia, jak i wyjścia, umożliwia realizację złożonych zadań wnioskowania, które byłyby niemożliwe dla modeli jednokanałowych. Przykładowo, Gemini potrafi przeanalizować film, wydobyć z klatek odpowiedni tekst, zrozumieć wypowiadane dialogi i wygenerować podsumowania łączące informacje ze wszystkich modalności. Funkcja ta ma ogromne znaczenie praktyczne: w diagnostyce medycznej Gemini może równocześnie analizować dokumentację pacjenta (tekst), obrazowanie medyczne (wizualizacje) oraz wywiad z pacjentem (audio), dostarczając pełnej oceny. W obsłudze klienta potrafi analizować zapytania (tekst), przeglądać zdjęcia produktów, oglądać filmy demonstracyjne i generować adekwatne odpowiedzi. Mechanizm uwagi między modalnościami umożliwiający taką integrację, polega na tworzeniu współdzielonych reprezentacji, gdzie informacje z różnych modalności wpływają na siebie nawzajem. Analizując obraz z towarzyszącym tekstem, na przykład, kontekst tekstowy pomaga ukierunkować analizę wizualną na właściwe fragmenty obrazu, a informacje wizualne pomagają rozstrzygać niejasności w tekście. To dwukierunkowe powiązanie pozwala na bardziej całościowe rozumienie niż niezależne przetwarzanie modalności. Dla monitoringu AI i śledzenia wzmianek o marce praktyczne skutki są istotne: gdy Gemini generuje odpowiedzi obejmujące obraz, tekst i dźwięk, systemy monitorujące muszą śledzić obecność marki we wszystkich tych modalnościach, nie tylko w odpowiedziach tekstowych.

Benchmarki wydajności i pozycjonowanie wobec konkurencji

Google Gemini Ultra osiągnął znakomite wyniki w wielu standardowych benchmarkach AI, plasując się na czele konkurencyjnych dużych modeli językowych. W MMLU (Massive Multitask Language Understanding), testującym rozumienie języka w 57 różnych dziedzinach, Gemini Ultra przewyższył nawet ekspertów ludzkich — co jest ważnym kamieniem milowym. W wnioskowaniu matematycznym (benchmark GSM8K) Gemini Ultra pokonał takich konkurentów jak Claude 2, GPT-4 i Llama 2. W generowaniu kodu (HumanEval) Gemini wykazał przewagę, umożliwiając zaawansowane wsparcie programistyczne i analizę kodu. Wydajność różni się jednak w zależności od metryk: podczas gdy Gemini Ultra błyszczy w rozumieniu dokumentów, obrazów i automatycznym rozpoznawaniu mowy, wykazuje umiarkowane postępy w zadaniach typu common sense (np. benchmark HellaSwag), gdzie GPT-4 wciąż przoduje. Seria Gemini 1.5 wypada szczególnie imponująco: zarówno Flash, jak i Pro, dorównują lub przewyższają 1.0 Ultra przy znacznie wyższej efektywności i rozszerzonym oknie kontekstu. Trajektoria ta ma bezpośrednie znaczenie dla monitoringu cytowań AI: w miarę wzrostu możliwości Gemini i liczby jego użytkowników (350 mln miesięcznie), dokładność i kompletność odpowiedzi mają wpływ na to, jak marki i domeny są reprezentowane w treściach generowanych przez AI. Narzędzia takie jak AmICited umożliwiają monitorowanie, czy odpowiedzi Gemini na temat danej marki są rzetelne i prawidłowo osadzone w kontekście.

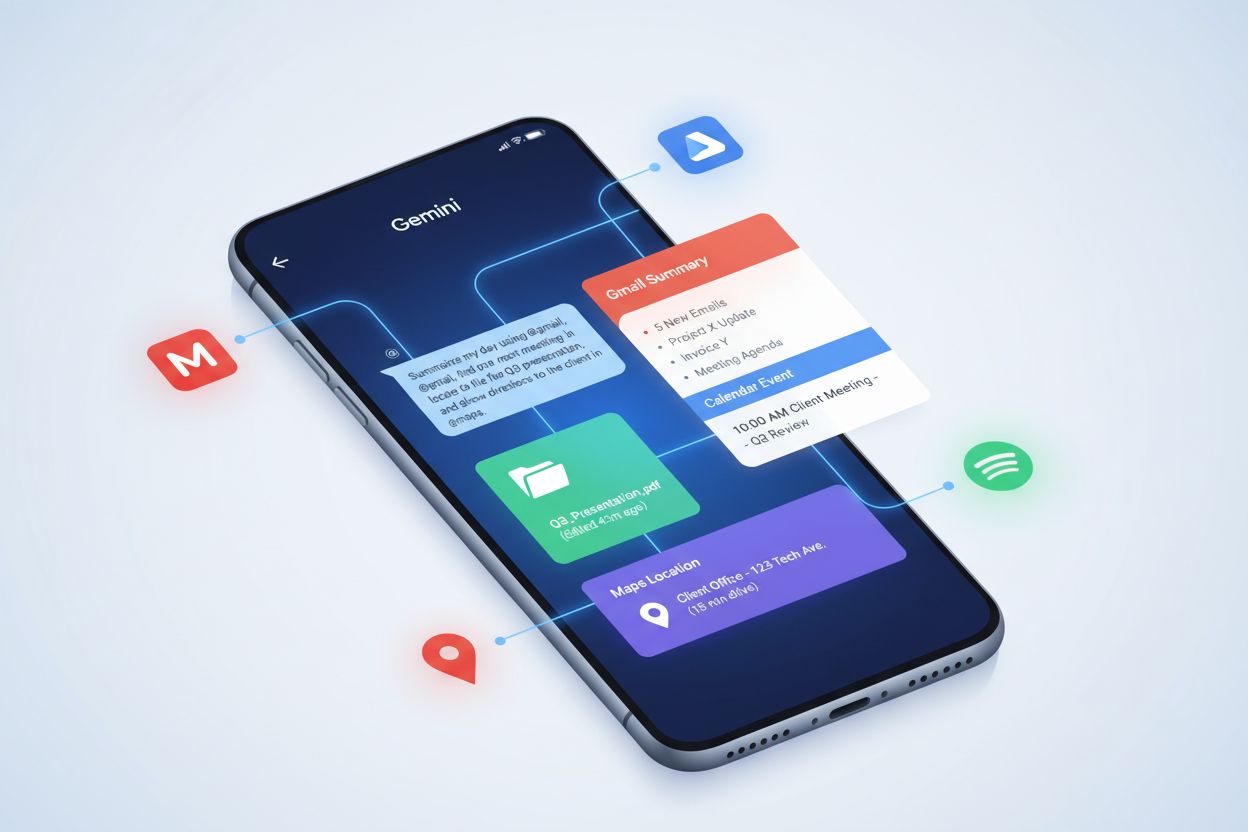

Integracja w ekosystemie Google

Strategiczna integracja Google Gemini w ekosystemie produktów Google to jedno z najbardziej kompleksowych wdrożeń modelu AI w ofercie technologicznej firmy. Gemini jest domyślnym asystentem AI w smartfonach Google Pixel 9 i Pixel 9 Pro, zastępując poprzedniego Asystenta Google i stając się głównym interfejsem AI dla milionów użytkowników. W Google Workspace Gemini pojawia się w panelu bocznym Dokumentów, wspierając pisanie i edycję, w Gmailu podpowiadając treść maili oraz w innych aplikacjach produktywnych. Mapy Google wykorzystują Gemini do inteligentnych podsumowań miejsc i obszarów, wzbogacając doświadczenie kontekstową informacją. Wyszukiwarka Google zintegrowała Gemini przez AI Overviews, generując kompleksowe odpowiedzi na zapytania użytkowników na podstawie wielu źródeł. API Gemini jest dostępne przez Google AI Studio i Google Cloud Vertex AI, umożliwiając deweloperom integrację możliwości Gemini w indywidualnych aplikacjach. Ta ekosystemowa integracja ma ogromne znaczenie dla monitoringu marki i śledzenia cytowań AI. Gdy użytkownik szuka informacji o firmie lub produkcie w Wyszukiwarce Google, Gemini może wygenerować AI Overview z lub bez wzmianki o tej marce. W Gmailu model może odnosić się do informacji o firmie w podpowiedziach. Tworząc aplikacje z użyciem API Gemini, powstają nowe punkty styku, w których marka może pojawiać się w treściach generowanych przez AI. Tak szeroka integracja sprawia, że kompleksowy monitoring tych wszystkich kanałów jest niezbędny dla zachowania integralności marki i rzetelnej reprezentacji w odpowiedziach AI.

Kluczowe możliwości i zastosowania

- Zaawansowane generowanie i analiza kodu: Gemini rozumie, wyjaśnia i generuje kod w wielu językach programowania (C++, Java, Python itd.), a wersje dopracowane napędzają AlphaCode2 do rozwiązywania zadań konkursowych

- Rozumienie obrazu i tekstu: Wydobywa tekst z obrazów bez narzędzi OCR, generuje opisy, analizuje wykresy i diagramy, realizuje złożone zadania wizualne

- Wielojęzyczne tłumaczenia: Wykorzystuje multimodalność do tłumaczeń w czasie rzeczywistym, np. w Google Meet z tłumaczonymi napisami

- Analiza złośliwego oprogramowania: Gemini 1.5 Pro i Flash analizują fragmenty kodu i pliki, wykrywając zagrożenia i generując raporty bezpieczeństwa

- Personalizowani eksperci AI (Gems): Tworzenie własnych asystentów AI do określonych zadań lub tematów, dostępne gotowe opcje — np. trener nauki, partner burzy mózgów, edytor tekstu

- Uniwersalni agenci AI: Dzięki Project Astra Gemini przetwarza, zapamiętuje i rozumie multimodalne informacje w czasie rzeczywistym, umożliwiając asystentom AI tłumaczenie obiektów, rozpoznawanie miejsc i przypominanie wcześniejszych interakcji

- Rozmowy głosowe: Gemini Live umożliwia naturalną rozmowę dostosowującą się do stylu i preferencji użytkownika

- Zaawansowane badania: Analiza setek stron, synteza wniosków i generowanie raportów na złożone tematy

Rola Gemini w monitoringu AI i reprezentacji marki

Pojawienie się Google Gemini jako głównej platformy AI z 350 milionami aktywnych użytkowników miesięcznie stworzyło nowe wyzwania dla monitoringu marki i śledzenia cytowań AI. W przeciwieństwie do tradycyjnych wyszukiwarek, gdzie marka pojawia się w rankingach wyników, Gemini generuje odpowiedzi syntetyzowane, które mogą zawierać lub pomijać konkretne firmy, produkty czy domeny. Gdy użytkownik pyta Gemini o daną branżę lub temat, model decyduje, które źródła zacytować, jakie informacje wyróżnić i jak osadzić wzmianki o marce. Oznacza to zasadniczą zmianę w stosunku do tradycyjnego SEO: widoczność zależy nie od pozycji w rankingu, lecz od “optymalizacji cytowań AI” — czyli dbałości, by marka pojawiała się poprawnie i adekwatnie w odpowiedziach AI. Multimodalność Gemini dodatkowo komplikuje monitoring: marka może pojawić się nie tylko w tekście, ale także na obrazach, w transkrypcjach audio czy odniesieniach wideo generowanych przez model. Integracja Gemini z ekosystemem Google sprawia, że wzmianki o marce mogą pojawiać się w różnych kontekstach: AI Overviews w Wyszukiwarce, podpowiedziach w Gmailu, podsumowaniach w Mapach Google czy aplikacjach korzystających z API Gemini. Organizacje muszą rozumieć, jak Gemini przedstawia ich markę w tych różnych kanałach i czy informacje są dokładne, kompletne i osadzone w odpowiednim kontekście. Narzędzia takie jak AmICited odpowiadają na tę potrzebę, monitorując, jak marki pojawiają się w odpowiedziach Gemini oraz na innych platformach AI (ChatGPT, Perplexity, Claude, Google AI Overviews), zapewniając pełną widoczność reprezentacji marki w treściach AI.

Ryzyka, ograniczenia i aspekty etyczne

Pomimo imponujących możliwości, Google Gemini mierzy się z udokumentowanymi wyzwaniami, o których muszą pamiętać organizacje korzystające z jego odpowiedzi. Bias AI okazał się poważnym problemem w lutym 2024, gdy Google zawiesił generowanie obrazów w Gemini z powodu nieprawidłowych i tendencyjnych przedstawień postaci historycznych, co skutkowało zatarciem historycznego kontekstu różnorodności rasowej. Przypadek ten pokazał, jak systemy AI mogą utrwalać lub wzmacniać uprzedzenia z danych treningowych. Halucynacje — generowanie nieprawdziwych informacji — nadal dotykają Gemini, zwłaszcza w AI Overviews, gdzie użytkownicy mogą bezkrytycznie ufać syntetycznym odpowiedziom. Google przyznaje, że wyniki Gemini w wyszukiwarce mogą czasem być fałszywe lub wprowadzające w błąd. Naruszenia własności intelektualnej to kolejne ryzyko: Google został ukarany we Francji (250 mln euro) za trenowanie Gemini na chronionych treściach prasowych bez wiedzy czy zgody wydawców, co rodzi pytania o źródła danych i dozwolony użytek. Ograniczenia te mają bezpośredni wpływ na monitoring marki: nie można zakładać, że informacje Gemini o konkurencji lub branży są zawsze rzetelne — należy weryfikować, jak prezentowana jest własna marka. Możliwość wygenerowania przez Gemini mylących informacji na temat produktów, historii czy pozycji rynkowej firmy to ryzyko, którego nie wyeliminuje tradycyjny monitoring wyszukiwarek. Ponadto, model często syntetyzuje informacje z wielu źródeł bez wyraźnego przypisania, przez co wzmianki o marce mogą być pozbawione kontekstu lub cytowania.

Przyszłość i strategiczne perspektywy rozwoju

Dotychczasowy rozwój Google Gemini wskazuje na dalszą ekspansję możliwości, efektywności i integracji z ekosystemem Google i poza nim. Gemini 2.0 i 2.5 wprowadziły agentowe możliwości AI — model może podejmować autonomiczne działania, planować wieloetapowe zadania i wnioskować w szerokich kontekstach, co stanowi istotną ewolucję względem wcześniejszych wersji odpowiadających tylko na zapytania. Przyszłe wersje prawdopodobnie jeszcze bardziej rozwiną zdolności wnioskowania, obsłużą większe okna kontekstu i poprawią wydajność w wyspecjalizowanych zadaniach. Project Astra, inicjatywa Google na rzecz uniwersalnych agentów AI, to wizja, w której Gemini przetwarza, zapamiętuje i rozumie multimodalne informacje w czasie rzeczywistym, umożliwiając bardziej naturalne i kompetentne interakcje. Project Mariner i inne badania wskazują, że Google bada wykorzystanie Gemini do pracy złożonej wiedzy, automatyzując badania, analizy i podejmowanie decyzji. Integracja Gemini z kolejnymi produktami Google będzie postępować, zwiększając liczbę punktów styku marki z odpowiedziami AI. Usprawnienia efektywności na urządzeniach mobilnych i edge sprawią, że Gemini będzie dostępny dla jeszcze większej liczby użytkowników (powyżej obecnych 350 mln miesięcznie). Konkurencja ze strony ChatGPT, Claude i Perplexity będzie wpływać na dalszy rozwój Gemini: Google będzie musiał utrzymać przewagę w multimodalności, integracji z usługami i dostępie do wiedzy w czasie rzeczywistym. Dla organizacji monitorujących AI i reprezentację marki oznacza to, że śledzenie obecności marki w odpowiedziach Gemini będzie coraz ważniejsze wraz ze wzrostem możliwości platformy i liczby użytkowników. Przejście do agentowego AI rodzi także nowe pytania — jak autonomiczne systemy będą prezentować i cytować marki, podejmując decyzje lub działania w imieniu użytkowników.

Podsumowanie: wpływ Gemini na monitoring marki w erze AI

Google Gemini to fundamentalna zmiana w sposobie, w jaki systemy AI przetwarzają informacje i generują odpowiedzi, z istotnymi konsekwencjami dla monitorowania marki i śledzenia cytowań AI. Jako multimodalny model AI z 350 milionami aktywnych użytkowników miesięcznie, zintegrowany w ekosystemie Google i stale rozwijający się w stronę coraz bardziej agentowych systemów, Gemini staje się kluczową platformą do monitorowania. W przeciwieństwie do tradycyjnych wyszukiwarek, gdzie widoczność zależy od pozycji w rankingu, odpowiedzi Gemini tworzą nowe realia: marka może być wymieniona lub pominięta, a gdy już się pojawia — być przedstawiona rzetelnie lub błędnie. Udokumentowane ograniczenia modelu — bias, halucynacje, naruszenia własności intelektualnej — podkreślają konieczność aktywnego monitorowania, zamiast biernego zaufania informacjom AI. Organizacje chcące zachować integralność marki i dbać o rzetelną reprezentację w odpowiedziach AI muszą wdrożyć kompleksowe strategie monitoringu obecności marki nie tylko w Gemini, ale i na innych wiodących platformach AI. To nowa era marketingu cyfrowego i zarządzania marką, gdzie sukces zależy nie tylko od tradycyjnego SEO, ale od optymalizacji sposobu, w jaki systemy AI cytują i przedstawiają markę w generowanych odpowiedziach.