Prerendering dla robotów AI: Uczyń treści JavaScript dostępnymi

Dowiedz się, jak prerendering sprawia, że treści JavaScript są widoczne dla robotów AI takich jak ChatGPT, Claude i Perplexity. Poznaj najlepsze techniczne rozw...

Renderowanie JavaScript dla AI odnosi się do procesu zapewnienia, że dynamicznie generowana treść tworzona przez JavaScript jest dostępna dla robotów AI, które nie potrafią wykonywać kodu JavaScript. Ponieważ główne systemy AI, takie jak ChatGPT, Perplexity i Claude, nie wykonują JavaScript, treść musi być serwowana jako statyczny HTML, aby była widoczna w odpowiedziach generowanych przez AI. Rozwiązania takie jak prerendering konwertują strony bogate w JavaScript na statyczne migawki HTML, do których roboty AI mają natychmiastowy dostęp i które mogą zrozumieć.

Renderowanie JavaScript dla AI odnosi się do procesu zapewnienia, że dynamicznie generowana treść tworzona przez JavaScript jest dostępna dla robotów AI, które nie potrafią wykonywać kodu JavaScript. Ponieważ główne systemy AI, takie jak ChatGPT, Perplexity i Claude, nie wykonują JavaScript, treść musi być serwowana jako statyczny HTML, aby była widoczna w odpowiedziach generowanych przez AI. Rozwiązania takie jak prerendering konwertują strony bogate w JavaScript na statyczne migawki HTML, do których roboty AI mają natychmiastowy dostęp i które mogą zrozumieć.

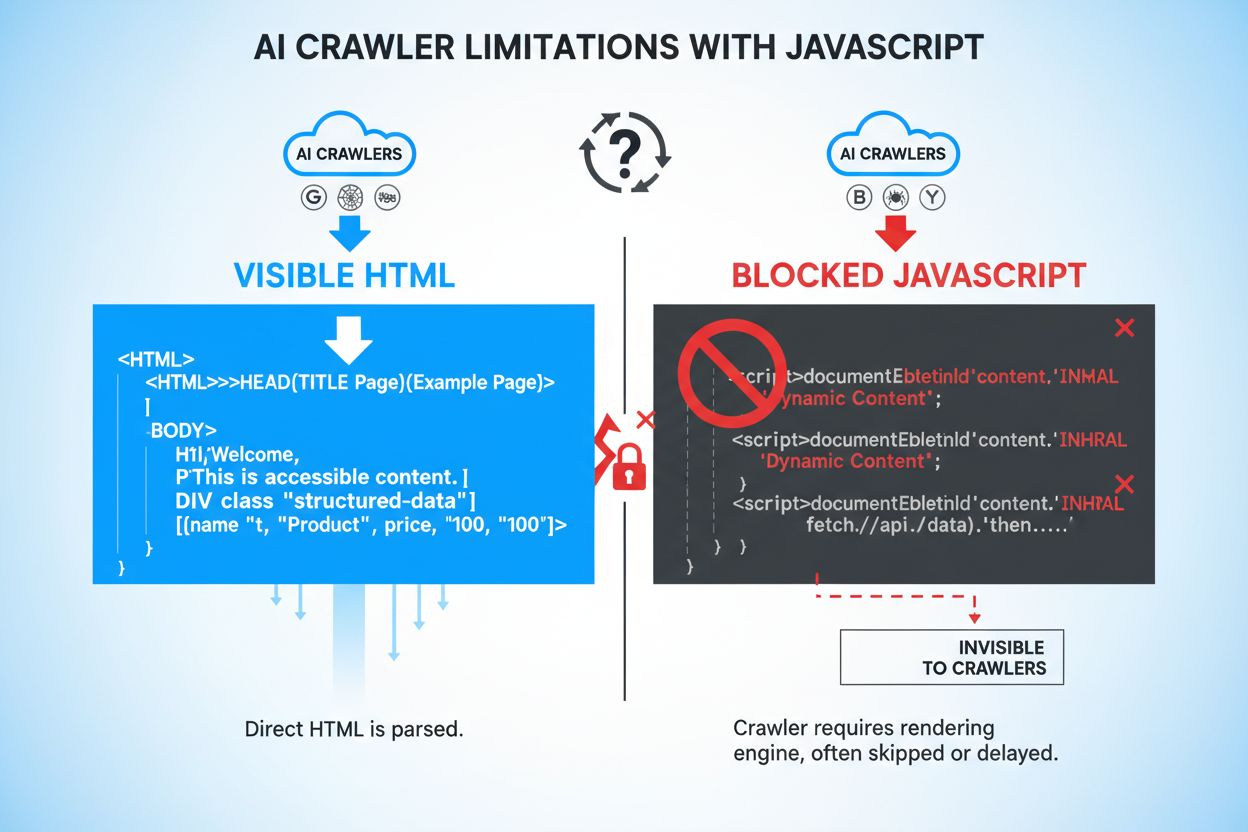

JavaScript to język programowania umożliwiający dynamiczne, interaktywne doświadczenia internetowe poprzez uruchamianie kodu bezpośrednio w przeglądarkach użytkowników. Strony internetowe używają JavaScript do tworzenia responsywnych interfejsów, ładowania treści na żądanie i zapewniania spersonalizowanych wrażeń. Jednak roboty AI takie jak GPTBot, ChatGPT-User czy OAI-SearchBot działają zasadniczo inaczej niż tradycyjne roboty internetowe — stawiają na szybkość i efektywność, a nie możliwości renderowania. Podczas gdy Googlebot i inne roboty wyszukiwarek potrafią wykonywać JavaScript (choć z ograniczeniami), roboty AI zazwyczaj tego nie robią, ponieważ renderowanie JavaScript wymaga znacznych zasobów obliczeniowych i czasu. Systemy AI działają w ramach ścisłych ograniczeń czasowych (zwykle 1-5 sekund na stronę), co czyni pełne wykonanie JavaScript niepraktycznym. Dodatkowo, roboty AI są zaprojektowane do szybkiego wydobywania informacji, a nie symulowania pełnego środowiska przeglądarki, co oznacza, że rejestrują jedynie początkowy HTML serwowany przez Twój serwer, a nie dynamicznie generowaną treść pojawiającą się po wykonaniu JavaScript.

Gdy roboty AI odwiedzają Twoją stronę, tracą dostęp do kluczowych treści, które pojawiają się dopiero po wykonaniu JavaScript. Informacje o produktach, takie jak ceny, status dostępności czy warianty, są często ukryte za renderowaniem JavaScript, przez co są niewidoczne dla systemów AI. Treści ładowane leniwie — obrazy, opinie klientów, komentarze i dodatkowe szczegóły produktów ładowane podczas przewijania — pozostają całkowicie niedostępne dla robotów AI, które nie wykonują JavaScript. Elementy interaktywne, takie jak zakładki, karuzele, akordeony czy okna modalne, również zawierają cenne informacje, do których AI nie ma dostępu bez renderowania. Tekst renderowany po stronie klienta i dynamicznie generowane metadane są równie niewidoczne, co powoduje poważne luki w zrozumieniu Twojej treści przez systemy AI.

| Rodzaj treści | Widoczność dla robotów AI | Wpływ |

|---|---|---|

| Statyczny tekst HTML | ✓ Widoczny | Wysoka dostępność |

| Tekst renderowany przez JavaScript | ✗ Ukryty | Całkowicie pomijany |

| Obrazy ładowane leniwie | ✗ Ukryte | Utrata widoczności produktów |

| Ceny/dostępność produktów | ✗ Ukryte (jeśli renderowane JS) | Kluczowe dane biznesowe niedostępne |

| Opinie klientów | ✗ Ukryte (jeśli ładowane leniwie) | Brak społecznego dowodu |

| Treść zakładek | ✗ Ukryta | Istotne informacje niedostępne |

| Znaczniki schema w HTML | ✓ Widoczne | Dane strukturalne wychwycone |

| Dynamiczne meta opisy | ✗ Ukryte | Negatywny wpływ na SEO |

Brak dostępu robotów AI do treści renderowanej przez JavaScript powoduje poważne konsekwencje biznesowe w coraz bardziej AI-zorientowanym świecie wyszukiwania. Gdy informacje o produktach, ceny i dostępność pozostają ukryte przed systemami AI, tracisz widoczność w generowanych przez AI wynikach wyszukiwania oraz AI-powered answer engines jak Perplexity, Google AI Overviews czy funkcja przeglądania ChatGPT. Ta niewidoczność przekłada się bezpośrednio na spadek ruchu z platform AI, które szybko stają się głównym kanałem odkrywania produktów przez konsumentów. Branża e-commerce odczuwa to szczególnie dotkliwie — gdy ceny i dostępność produktów nie pojawiają się w odpowiedziach AI, potencjalni klienci otrzymują niepełne informacje i mogą kupować u konkurencji. Firmy SaaS również napotykają trudności, gdy opisy funkcji, poziomy cenowe czy integracje ukryte za JavaScript nie trafiają do systemów AI, które mogłyby rekomendować ich rozwiązania. Oprócz utraty ruchu, ukryta treść powoduje spadek zaufania klientów — gdy użytkownicy widzą niepełne lub nieaktualne informacje w odpowiedziach AI, podważają wiarygodność zarówno systemu AI, jak i Twojej marki. Efekt skumulowany to poważna strata konkurencyjna, gdy świadomi tego konkurenci zapewniają pełną dostępność swojego contentu dla nowych kanałów odkrywania.

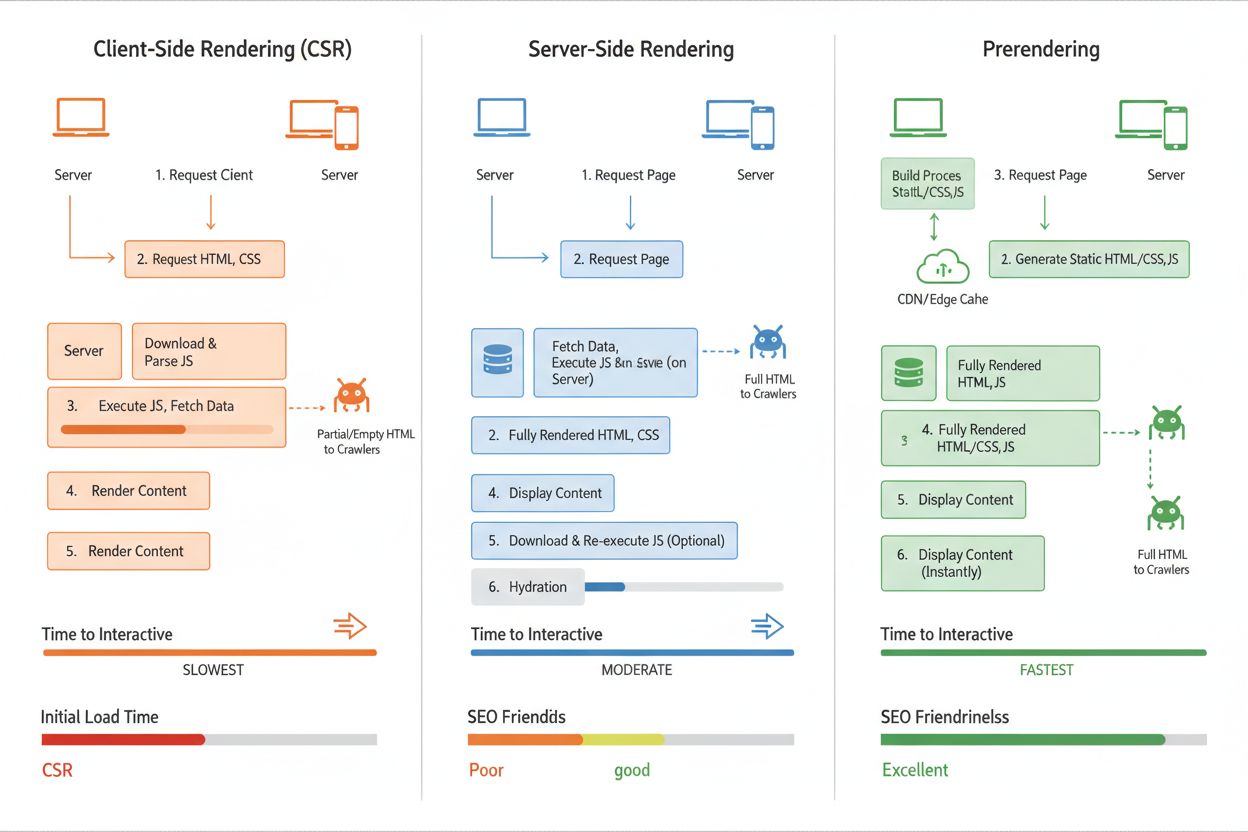

Prerendering to technika po stronie serwera rozwiązująca problem niewidoczności JavaScript poprzez generowanie statycznych migawek HTML Twoich stron, zanim zostaną odwiedzone przez roboty. W przeciwieństwie do renderowania po stronie klienta (CSR), gdzie treść generowana jest w przeglądarce użytkownika, prerendering wykonuje JavaScript na serwerze i przechwytuje w pełni wyrenderowany HTML. Ten statyczny HTML jest następnie serwowany robotom AI, zapewniając im kompletną, w pełni renderowaną treść bez konieczności wykonywania JavaScript po ich stronie. Prerender.io jest przykładem takiego rozwiązania — działa jako middleware, który przechwytuje żądania robotów AI, serwuje im prerenderowane wersje HTML Twoich stron, a zwykłym użytkownikom dostarcza bogate w JavaScript strony. Kluczową zaletą dla robotów AI jest otrzymywanie treści w oczekiwanym przez nie formacie — czysty HTML z już rozstrzygniętą treścią dynamiczną. To różni się od renderowania po stronie serwera (SSR), które renderuje treść przy każdym żądaniu i wymaga większych zasobów serwera, przez co jest mniej efektywne przy dużym ruchu. Prerendering jest szczególnie elegancki, ponieważ wymaga minimalnych zmian w istniejącym kodzie, a znacząco poprawia dostępność dla robotów AI.

Renderowanie po stronie klienta (CSR) to najczęściej stosowane podejście w nowoczesnych aplikacjach webowych, gdzie JavaScript uruchamiany jest w przeglądarce w celu dynamicznego budowania strony. Jednak CSR generuje główny problem: roboty AI otrzymują pusty lub minimalny HTML i nie widzą treści renderowanej przez JavaScript, co skutkuje niską widocznością w AI. Renderowanie po stronie serwera (SSR) rozwiązuje ten problem, renderując strony na serwerze przed ich wysyłką do klienta, zapewniając obecność całej treści w początkowym HTML. Jednak wymaga to dużych zasobów serwera, zwiększa opóźnienia przy każdym żądaniu i staje się kosztowne na dużą skalę — szczególnie przy wysokim ruchu. Prerendering zapewnia najlepszy balans pod kątem widoczności w AI: strony renderowane są raz i cache’owane jako statyczny HTML, serwowany robotom AI, podczas gdy zwykli użytkownicy otrzymują dynamiczne doświadczenia oparte na JavaScript. Takie podejście minimalizuje obciążenie serwera, utrzymuje szybkie ładowanie stron dla użytkowników i gwarantuje, że roboty AI zawsze otrzymują kompletną, w pełni renderowaną treść. Dla większości organizacji prerendering stanowi optymalne rozwiązanie, łączące niskie koszty, wydajność i dostępność dla AI bez konieczności fundamentalnej zmiany architektury.

Prerender.io to wiodąca usługa prerenderingu, oferująca middleware automatycznie wykrywające żądania robotów AI i serwujące im prerenderowane wersje HTML Twoich stron. AmICited.com zapewnia kompleksowy monitoring widoczności w AI, śledząc, jak Twoja marka pojawia się w odpowiedziach ChatGPT, Perplexity, Google AI Overviews i innych głównych systemów AI — co jest niezbędne do oceny realnego wpływu strategii renderowania JavaScript. Oprócz prerenderingu, narzędzia takie jak Screaming Frog i Lighthouse pozwalają audytować, która treść JavaScript pozostaje ukryta przed robotami, pomagając wykryć problematyczne obszary. Przy wyborze rozwiązania weź pod uwagę wolumen ruchu, infrastrukturę techniczną i platformy AI, na których Ci zależy; prerendering najlepiej sprawdza się na treściwych stronach o średnim i dużym ruchu, podczas gdy SSR może być wystarczający dla mniejszych aplikacji o prostszych wymaganiach renderowania. Integracja jest zazwyczaj prosta — większość usług prerenderingu działa jako transparentny middleware, wymagając minimalnych zmian w kodzie. Dla kompleksowej strategii widoczności w AI połączenie rozwiązania prerenderingowego z monitoringiem AmICited.com zapewnia nie tylko dostępność treści dla robotów AI, ale i mierzalność biznesowego wpływu tych zmian.

Śledzenie skuteczności strategii renderowania JavaScript wymaga monitorowania zarówno aktywności robotów, jak i efektów biznesowych. Logi dostępu robotów AI pokażą, jak często GPTBot, ChatGPT-User i OAI-SearchBot odwiedzają Twoją stronę i które strony pobierają — wzrost częstotliwości zwykle oznacza poprawę dostępności. Metryki widoczności treści w narzędziach takich jak AmICited.com pokażą, czy Twoja marka, produkty i informacje faktycznie pojawiają się w odpowiedziach generowanych przez AI, dostarczając bezpośrednich dowodów skuteczności renderowania. Narzędzia weryfikacji prerenderingu pozwalają potwierdzić, że roboty AI otrzymują w pełni renderowany HTML, porównując to, co widzą one i zwykli użytkownicy. Oczekiwane efekty to: wzrost wzmianek w wynikach wyszukiwania AI, dokładniejsze informacje o produktach pojawiające się w odpowiedziach AI i wyższe współczynniki kliknięć z platform AI na Twoją stronę. Atrybucja ruchu z AI powinna wyraźnie wzrosnąć w ciągu 2-4 tygodni od wdrożenia prerenderingu, szczególnie dla kluczowych fraz i zapytań produktowych. Kalkulując ROI, uwzględnij wzrost ruchu z AI, wyższą konwersję wynikającą z pełniejszej informacji o produktach w odpowiedziach AI oraz spadek zapytań do wsparcia klienta wynikający z braków informacyjnych. Regularny monitoring przez AmICited.com pozwala utrzymać widoczność wraz z ewolucją systemów AI i identyfikować nowe możliwości optymalizacji treści pod kątem dostępności dla AI.

Roboty AI, takie jak GPTBot i ChatGPT-User, stawiają na pierwszym miejscu szybkość i efektywność ponad możliwości renderowania. Wykonywanie JavaScript wymaga znacznych zasobów obliczeniowych i czasu, co jest sprzeczne z ich założeniem szybkiego pozyskiwania informacji. Systemy te działają w ramach ścisłych ograniczeń czasowych (zazwyczaj 1-5 sekund na stronę), co sprawia, że pełne wykonanie JavaScript jest niepraktyczne. Zostały zaprojektowane, by wychwytywać jedynie początkowy HTML serwowany przez Twój serwer, a nie dynamicznie generowaną treść pojawiającą się po wykonaniu JavaScript.

Informacje o produktach (ceny, dostępność, warianty), treści ładowane leniwie (obrazy, recenzje, komentarze), elementy interaktywne (zakładki, karuzele, okna modalne) oraz tekst renderowany po stronie klienta są najbardziej narażone. Szczególnie dotkliwe skutki odczuwają sklepy e-commerce, gdzie szczegóły produktów i ceny często polegają na JavaScript. Firmy SaaS również napotykają trudności, gdy opisy funkcji i poziomy cenowe są ukryte za wykonaniem JavaScript.

Renderowanie po stronie klienta (CSR) generuje treść w przeglądarce użytkownika przy użyciu JavaScript, do której roboty AI nie mają dostępu. Renderowanie po stronie serwera (SSR) generuje strony na Twoim serwerze przy każdym żądaniu, zapewniając obecność treści w początkowym HTML, ale wymagając przy tym znacznych zasobów serwera. Prerendering generuje statyczne migawki HTML jednorazowo i je cache'uje, serwując je robotom AI, a użytkownikom dynamiczne doświadczenia — oferując najlepszy balans wydajności i dostępności dla AI.

Użyj narzędzi monitorujących, takich jak AmICited.com, by śledzić aktywność robotów AI i zobaczyć, jak Twoja treść pojawia się w odpowiedziach generowanych przez AI. Możesz także symulować żądania robotów AI za pomocą narzędzi deweloperskich przeglądarki lub usług testujących z agentami użytkownika GPTBot i ChatGPT-User. Usługi prerenderingu często oferują narzędzia weryfikujące, które pokazują, co roboty AI faktycznie otrzymują w porównaniu do tego, co widzą zwykli użytkownicy.

Tak, renderowanie JavaScript wpływa na oba obszary. Choć Googlebot potrafi wykonywać JavaScript (z ograniczeniami), indeksowanie i crawlowanie takich stron trwa dłużej. Renderowanie po stronie serwera lub prerendering poprawia zarówno wydajność tradycyjnego SEO, jak i widoczność w AI, zapewniając natychmiastową dostępność treści w początkowym HTML, skracając czas crawlowania i przyspieszając indeksowanie.

Usługi prerenderingu, takie jak Prerender.io, zazwyczaj naliczają opłaty w zależności od liczby renderowanych stron, a ceny zaczynają się od około 50-100 USD miesięcznie dla małych serwisów. Renderowanie po stronie serwera wymaga większych nakładów deweloperskich, ale nie generuje stałych kosztów usługowych. Zwrot z inwestycji jest zwykle dodatni w ciągu kilku tygodni dzięki wzrostowi ruchu z AI i lepszym konwersjom wynikającym z pełniejszych informacji o produktach w odpowiedziach AI.

Roboty AI mogą wychwycić nowo prerenderowaną treść w ciągu 24 godzin, a niektóre systemy odwiedzają strony kilka razy dziennie. Wzrost ruchu z AI powinien być zauważalny w ciągu 2-4 tygodni od wdrożenia. Użycie AmICited.com do monitorowania widoczności pozwala śledzić te postępy w czasie rzeczywistym, gdy Twoja treść staje się dostępna dla systemów AI.

Skup się na prerenderingu najważniejszych stron: produkty, usługi, kluczowe wpisy blogowe, sekcje FAQ i strony lokalizacyjne. To one zapewniają największą widoczność i konwersje, gdy pojawiają się w odpowiedziach generowanych przez AI. Unikaj prerenderingu stron 404 lub treści o niskiej wartości. Takie podejście optymalizuje budżet na prerendering, maksymalizując wpływ na strony najważniejsze pod kątem ruchu i konwersji z AI.

Śledź, jak Twoja marka pojawia się w ChatGPT, Perplexity, Google AI Overviews i innych systemach AI. Uzyskaj wgląd w czasie rzeczywistym w swoją widoczność w wyszukiwarce AI i zoptymalizuj swoją strategię treści.

Dowiedz się, jak prerendering sprawia, że treści JavaScript są widoczne dla robotów AI takich jak ChatGPT, Claude i Perplexity. Poznaj najlepsze techniczne rozw...

Dowiedz się, jak renderowanie JavaScript wpływa na widoczność Twojej strony w wyszukiwarkach AI, takich jak ChatGPT, Perplexity i Claude. Odkryj, dlaczego robot...

Dowiedz się, jak strategie renderowania SSR i CSR wpływają na widoczność dla AI crawlerów, cytowania marki w ChatGPT i Perplexity oraz ogólną obecność w wyszuki...