Definicja gęstości słów kluczowych

Gęstość słów kluczowych to procentowy udział docelowego słowa kluczowego na stronie w stosunku do całkowitej liczby słów na tej stronie. Oblicza się ją, dzieląc liczbę wystąpień słowa kluczowego przez całkowitą liczbę słów i mnożąc wynik przez 100. Gęstość słów kluczowych stanowi podstawową metrykę w optymalizacji pod kątem wyszukiwarek. Na przykład, jeśli w artykule o długości 1500 słów docelowe słowo kluczowe pojawia się 20 razy, gęstość wynosi 1,3%. Choć historycznie uznawana była za kluczowy czynnik rankingowy, współczesne algorytmy wyszukiwarek znacznie się rozwinęły i gęstość słów kluczowych jest dziś jednym z wielu sygnałów pomagających zrozumieć trafność treści, a nie bezpośrednim wyznacznikiem pozycji. Zrozumienie tej metryki pozostaje ważne dla twórców treści i specjalistów SEO, ponieważ pozwala zachować równowagę między naturalnym językiem a strategicznym rozmieszczeniem słów kluczowych, zapewniając przyjazność dla użytkownika oraz widoczność w wyszukiwarkach.

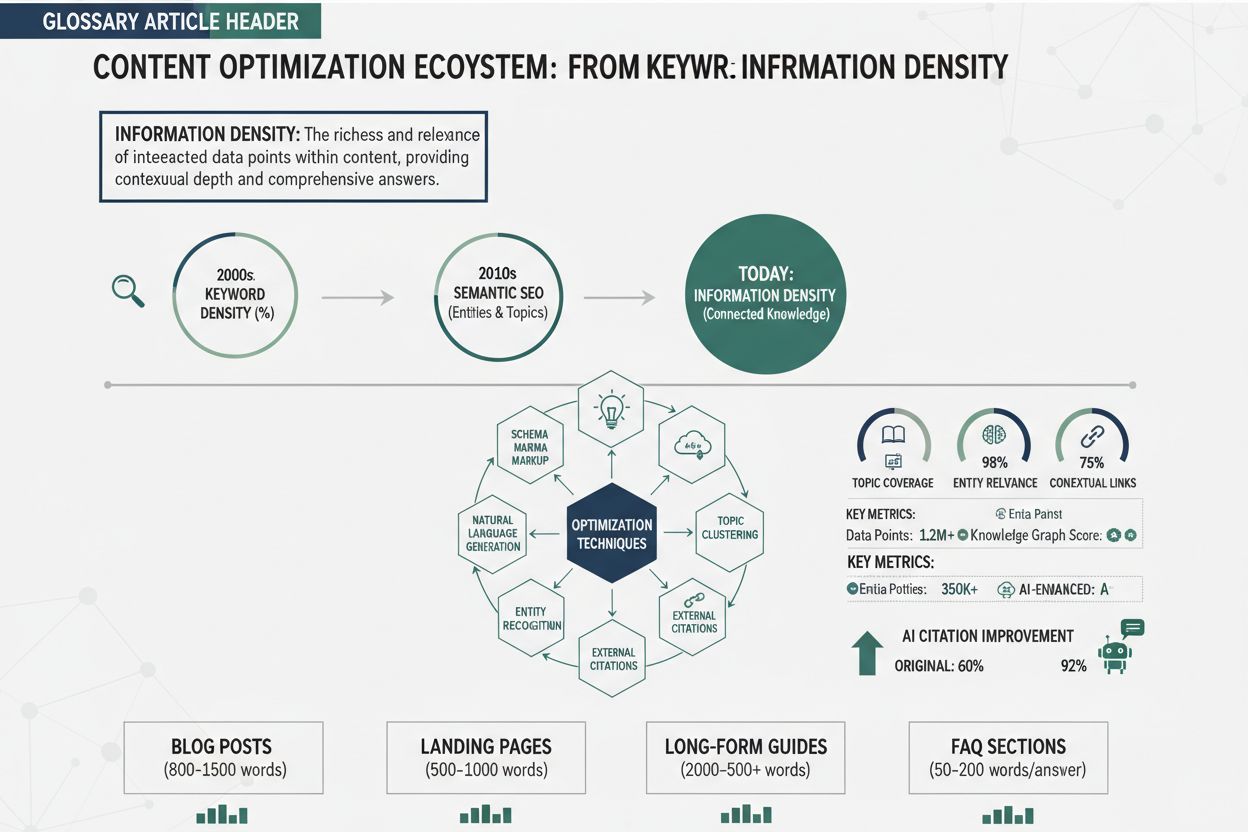

Kontekst historyczny i ewolucja gęstości słów kluczowych

Na początku historii SEO, mniej więcej w latach 1995–2010, gęstość słów kluczowych traktowano jako główny czynnik rankingowy. Algorytmy były stosunkowo proste i mocno polegały na częstotliwości słów kluczowych, by określić trafność strony wobec danego zapytania. W tym okresie specjaliści SEO celowo dążyli do określonych wartości procentowych, często 5–7% lub więcej, wierząc, że większa liczba powtórzeń przekłada się na wyższe pozycje. Doprowadziło to do powszechnego zjawiska upychania słów kluczowych — czyli „wypychania” ich na stronie w bardzo dużej liczbie, często w ukrytym tekście, stopkach lub nienaturalnych zdaniach. Strony hoteli umieszczały np. w stopkach długie ciągi „tanie hotele w [nazwa miasta]” setki razy, wykorzystując ograniczenia ówczesnych wyszukiwarek do pozycjonowania na warianty lokalizacyjne. Jednak wraz z rozwojem algorytmów, zwłaszcza po aktualizacji Panda Google w 2011 roku, podejście to stało się nie tylko nieskuteczne, ale wręcz szkodliwe. Algorytmy Google zaczęły wykrywać i karać upychanie słów kluczowych, uznając je za manipulację i pogorszenie doświadczenia użytkownika. Dziś gęstość słów kluczowych pozostaje ważnym wskaźnikiem do monitorowania, lecz przestała być głównym celem optymalizacji — jest jednym z wielu czynników wpływających na jakość i trafność treści.

Ready to Monitor Your AI Visibility?

Track how AI chatbots mention your brand across ChatGPT, Perplexity, and other platforms.

Jak oblicza się gęstość słów kluczowych

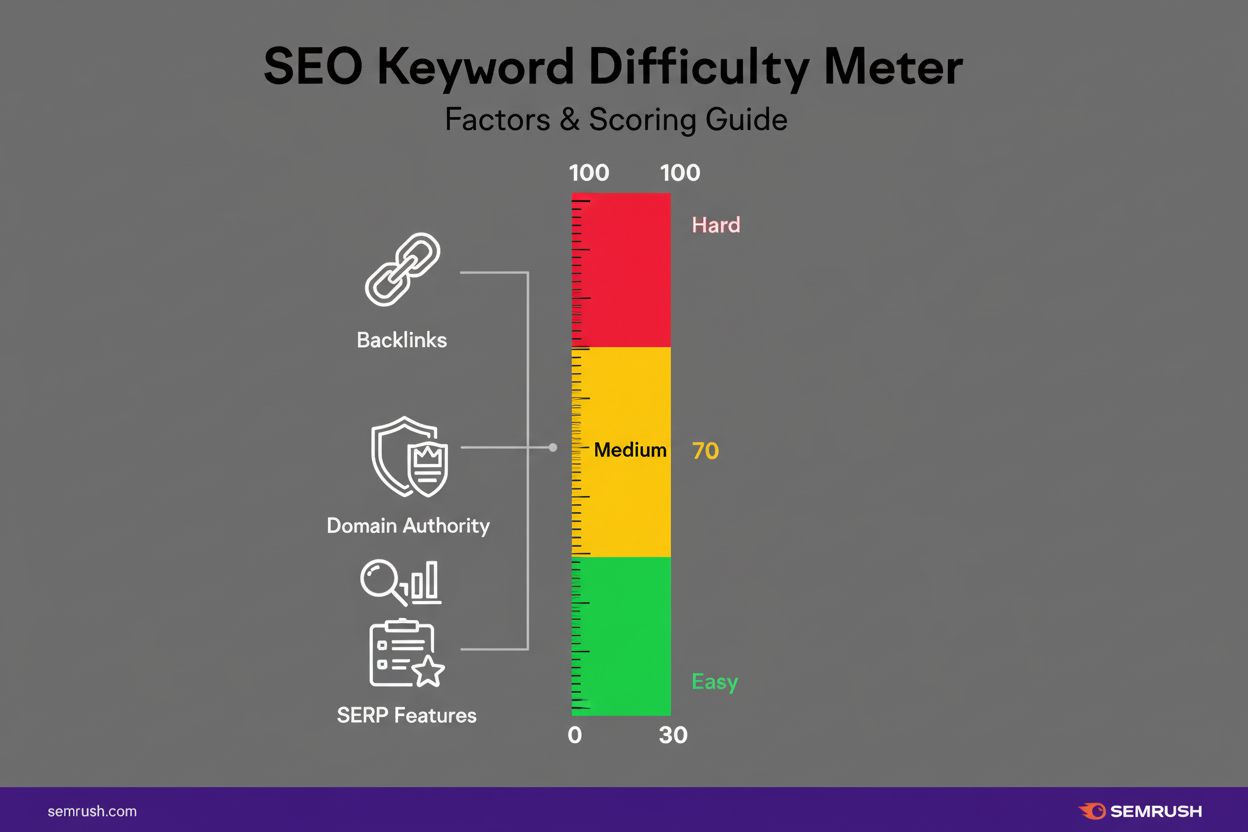

Obliczenie gęstości słów kluczowych jest proste i można je wykonać ręcznie lub za pomocą narzędzi SEO. Podstawowy wzór to: (liczba wystąpień słowa kluczowego ÷ liczba wszystkich słów) × 100 = procentowa gęstość słów kluczowych. Przykładowo, jeśli napiszesz artykuł o długości 2000 słów i wymienisz docelową frazę „moda zrównoważona” 25 razy, obliczenie wygląda tak: (25 ÷ 2000) × 100 = 1,25%. Bardziej zaawansowaną metodą pomiaru trafności słów kluczowych jest TF-IDF (Term Frequency-Inverse Document Frequency), która ocenia ważność frazy względem zbioru dokumentów. TF-IDF bierze pod uwagę nie tylko częstotliwość w Twojej treści, ale także unikalność słowa na tle całego internetu, dając pełniejszy obraz jego znaczenia. Jednak John Mueller z Google sugeruje, by nie przesadzać z analizą TF-IDF, bo nowoczesne wyszukiwarki stosują znacznie bardziej zaawansowane sposoby oceny trafności. Większość specjalistów SEO używa dziś narzędzi takich jak Semrush, Ahrefs czy Yoast SEO, które automatycznie obliczają gęstość słów kluczowych, porównując ją z konkurencją — dzięki czemu ręczne liczenie stało się niepotrzebne w profesjonalnej pracy.

Optymalna gęstość słów kluczowych — co mówią badania

Różne badania i rekomendacje ekspertów dotyczące optymalnej gęstości słów kluczowych wskazują, że bezpiecznym i skutecznym zakresem jest 1–2%. Zalecenie to wynika z wieloletnich testów, które pokazują, że strony z taką gęstością zazwyczaj dobrze się pozycjonują, nie wywołując filtrów antyspamowych ani wrażenia nadmiernej optymalizacji. Jednak najnowsze dane z badania Rankability z 2025 roku, obejmującego 1 536 wyników Google w 32 konkurencyjnych frazach, przyniosły zaskakujące wyniki: średnia gęstość słów kluczowych w top 10 to zaledwie 0,04%, w pozycjach 11–20 wynosi 0,07%, a w 21–30 już 0,08%. Wyniki sugerują, że niższa gęstość jest charakterystyczna dla najlepiej wypadających stron — prawdopodobnie dlatego, że dobrze napisane, wyczerpujące teksty naturalnie zawierają słowa kluczowe rzadziej. Badania pokazują, że umiarkowane użycie słów kluczowych daje wyższe pozycje niż agresywne ich powtarzanie, co potwierdza trend w stronę strategii stawiających na jakość. Co więcej, 78% stron w top 10 ma o 50% niższą gęstość słów kluczowych niż strony, które były w top 10 dwa lata wcześniej (dane BrightEdge), co jasno pokazuje odchodzenie branży od skupienia na gęstości na rzecz jakości i doświadczenia użytkownika. Oznacza to, że zamiast celować w konkretną wartość procentową, twórcy powinni pisać naturalnie z myślą o odbiorcy, umieszczając słowa kluczowe w strategicznych miejscach: tytułach, nagłówkach i wstępie.

Stay Updated on AI Visibility Trends

Get the latest insights on AI mentions, brand monitoring, and optimization strategies.

Tabela porównawcza: gęstość słów kluczowych a powiązane metryki SEO

| Metryka | Definicja | Znaczenie | Optymalny zakres | Główny cel |

|---|

| Gęstość słów kluczowych | Procentowy udział słowa kluczowego względem całkowitej liczby słów | Średnie (sygnał wspierający) | 1–2% lub 0,04% (wg top wyników) | Częstotliwość i naturalność użycia słowa kluczowego |

| Prominencja słowa kluczowego | Pozycja i rozmieszczenie słów kluczowych w kluczowych miejscach (tytuł, H1, pierwsze 100 słów) | Wysokie (bezpośredni czynnik rankingowy) | Słowa kluczowe w tytule, H1 i na początku treści | Strategiczne rozmieszczenie dla sygnałów trafności |

| Semantyczna trafność | Użycie powiązanych terminów, synonimów i fraz kontekstowych | Bardzo wysokie (główny czynnik) | Wyczerpujące omówienie tematu z użyciem LSI | Głębia tematyczna i zrozumienie kontekstu |

| Dopasowanie do intencji wyszukiwania | Jak dobrze treść odpowiada intencji użytkownika | Bardzo wysokie (główny czynnik) | 100% zgodności z intencją informacyjną, komercyjną lub transakcyjną | Zadowolenie użytkownika i wskaźniki zaangażowania |

| Ocena jakości treści | Czytelność, wyczerpującość i wartość dla użytkownika | Bardzo wysokie (główny czynnik) | Wysokie sygnały E-E-A-T i eksperckie cytowania | Doświadczenie użytkownika i autorytet treści |

| Wynik TF-IDF | Statystyczna miara ważności słowa względem zbioru dokumentów | Niskie–średnie (pomocniczo) | W zależności od branży i konkurencji | Unikalność i ważność słowa kluczowego |

| Upychanie słów kluczowych | Nadmierne, nienaturalne powtarzanie słów kluczowych | Negatywne (ryzyko kary) | 0% (unikać całkowicie) | Wykrywanie spamu i ochrona doświadczenia użytkownika |

Wyjaśnienie techniczne: jak wyszukiwarki przetwarzają gęstość słów kluczowych

Nowoczesne wyszukiwarki, takie jak Google, wykorzystują zaawansowane przetwarzanie języka naturalnego (NLP) i algorytmy uczenia maszynowego, by zrozumieć treść znacznie głębiej niż przez samo liczenie słów kluczowych. Gdy robot indeksujący trafia na stronę, nie ogranicza się do liczenia wystąpień — analizuje kontekst semantyczny, powiązania między słowami i trafność tematyczną całego dokumentu. Gęstość słów kluczowych jest tylko jednym z setek sygnałów uwzględnianych przez algorytmy. Wyszukiwarki sprawdzają także, gdzie pojawiają się słowa kluczowe — czy w tytule, H1, meta opisie czy w treści — i każdemu z tych miejsc przypisują inną wagę. Słowa kluczowe w tytule i nagłówkach mają większy wpływ niż te ukryte głęboko w tekście, dlatego strategiczne rozmieszczenie jest ważniejsze niż sama liczba powtórzeń. Ponadto wyszukiwarki analizują warianty słów i synonimy, rozumiejąc, że „marketing cyfrowy”, „marketing online” i „marketing internetowy” to frazy pokrewne, wspierające trafność tematyczną. Algorytm bierze też pod uwagę sygnały zaangażowania użytkowników, takie jak CTR, czas na stronie czy współczynnik odrzuceń, które świadczą o tym, czy treść faktycznie odpowiada na potrzeby użytkownika. Oznacza to, że strona z niższą gęstością słów kluczowych, ale lepszym zaangażowaniem, może wyprzedzić stronę z wysoką gęstością i słabym UX. Dodatkowo systemy Google uwzględniają dziś sygnały E-E-A-T (doświadczenie, wiedza ekspercka, autorytet, wiarygodność), co sprawia, że treści od autorytetów mają wyższe pozycje niezależnie od gęstości słów kluczowych. Ta ewolucja sprawia, że gęstość słów kluczowych straciła na znaczeniu — wyszukiwarki przesunęły priorytety z dopasowania słów na rozumienie semantyczne i satysfakcję użytkownika.

Wpływ optymalizacji gęstości słów kluczowych na biznes i praktykę

Z biznesowego punktu widzenia zrozumienie i optymalizacja gęstości słów kluczowych jest częścią szerszej strategii SEO, która generuje ruch organiczny, leady i przychody. Według badań z 2025 roku SEO generuje 22 dolary zysku z każdego wydanego dolara, co czyni je kanałem o najwyższym zwrocie z inwestycji, a ruch organiczny stanowi 57,8% światowego ruchu internetowego. Odpowiednia optymalizacja gęstości sprawia, że treści są widoczne w wyszukiwarkach, a jednocześnie czytelne i wartościowe dla użytkownika. Zbyt niska gęstość utrudnia wyszukiwarkom zrozumienie tematu strony, co może skutkować utratą szans na pozycjonowanie. Z kolei zbyt wysoka gęstość obniża czytelność, zwiększa współczynnik odrzuceń, a nawet grozi karami za upychanie słów kluczowych. Ma to realny wpływ: strony z ponad 100 backlinkami generują 3,2x więcej ruchu niż te z mniejszą liczbą linków, ale przewaga pojawia się tylko wtedy, gdy strona osiągnie wysoką pozycję, co wymaga właściwej optymalizacji. Dla twórców i marketerów wniosek jest jasny — warto inwestować w kompleksowe, wysokiej jakości treści z naturalną gęstością słów kluczowych rzędu 1–2%, zamiast skupiać się na konkretnych wartościach procentowych. Takie podejście obniża ryzyko kar, poprawia doświadczenie użytkownika i sprawia, że treści dobrze wypadają zarówno w tradycyjnych, jak i AI-powered wyszukiwarkach. Dodatkowo 91% marketerów stwierdziło, że SEO poprawiło wydajność stron w 2024 roku, a ci, którzy zrównoważyli optymalizację słów kluczowych i jakość treści, byli najbardziej zadowoleni z efektów.

Gęstość słów kluczowych a widoczność w wyszukiwarkach AI

Wraz ze wzrostem znaczenia wyszukiwarek AI i dużych modeli językowych (LLM), takich jak ChatGPT, Perplexity czy Google AI Overviews, gęstość słów kluczowych zyskuje nowe znaczenie w kontekście cytowań AI i ekstrakcji treści. Systemy AI analizują treści, by generować podsumowania i cytowania, polegając na jasnym i dobrze rozmieszczonym użyciu słów kluczowych do rozpoznania tematu i wyodrębnienia autorytatywnych informacji. Treści z odpowiednią gęstością słów kluczowych, umieszczone w tytułach, nagłówkach i na początku tekstu, są łatwiej rozpoznawane przez AI jako źródło w danej tematyce. To zwiększa szansę na cytowanie w generowanych przez AI odpowiedziach, przynosząc marce widoczność w nowym paradygmacie wyszukiwania. Jednak systemy AI są jeszcze bardziej zaawansowane niż klasyczne wyszukiwarki w wykrywaniu upychania słów kluczowych i nienaturalnych wzorców językowych. Stawiają na semantyczne rozumienie i jakość, więc sama gęstość nie gwarantuje cytowania — treść musi rzeczywiście oferować wartość i ekspercką wiedzę. Badania pokazują, że zapytania informacyjne najczęściej wywołują AI Overviews, a takie podsumowania mogą obniżać tradycyjny CTR organiczny nawet o 20–40%. Oznacza to, że marki muszą optymalizować nie tylko pod kątem pozycji w wynikach, ale także pod kątem „wyciągalności” przez AI, co wymaga zbalansowanej gęstości i kompleksowego pokrycia tematu. Dla platform takich jak AmICited, monitorujących wzmianki o marce w AI, zrozumienie wpływu gęstości słów kluczowych na widoczność w AI jest kluczowe. Treści z optymalną gęstością i mocną trafnością semantyczną są częściej cytowane przez AI, zwiększając obecność marki w wynikach AI i dając cenne możliwości atrybucji.

Najlepsze praktyki optymalizacji gęstości słów kluczowych

Efektywna optymalizacja gęstości słów kluczowych wymaga strategicznego podejścia z myślą o użytkowniku, łączącego wymagania wyszukiwarek z doświadczeniem czytelnika. Te praktyki wyznaczają kierunki nowoczesnej optymalizacji:

Pisz naturalnie przede wszystkim dla odbiorcy: Twórz wartościowe, czytelne treści odpowiadające na potrzeby użytkowników. Słowa kluczowe powinny płynnie występować w zdaniach, bez wymuszonego powtarzania. Przy pisaniu z myślą o odbiorcy gęstość zwykle naturalnie mieści się w przedziale 1–2%.

Rozmieszczaj słowa kluczowe strategicznie w kluczowych miejscach: Umieść główne słowo kluczowe w title, nagłówku H1, meta opisie i pierwszych 100 słowach treści. Te pozycje silniej sygnalizują trafność dla wyszukiwarek niż sama częstotliwość.

Stosuj warianty słów i synonimy semantyczne: Zamiast powtarzać dokładnie to samo słowo, wplataj powiązane wyrażenia i długie ogony. To poszerza zasięg tematyczny, pozwala pozycjonować się na klastry słów i zachowuje naturalność.

Przeprowadzaj kompleksowy research słów kluczowych: Wybierz główne, dodatkowe i powiązane semantycznie frazy przed pisaniem. Narzędzia takie jak Keyword Magic Tool Semrush czy Planer Słów Kluczowych Google pomogą zrozumieć wolumeny, konkurencję i intencje.

Regularnie monitoruj i audytuj gęstość słów kluczowych: Korzystaj z narzędzi SEO do przeglądu gęstości w całym portfolio treści. Identyfikuj strony z niedostateczną lub nadmierną optymalizacją i dostosowuj je na podstawie wyników.

Stawiaj na jakość i kompleksowość treści: Twórz wyczerpujące materiały, które w pełni odpowiadają na intencje użytkownika. Takie treści naturalnie wykorzystują większą liczbę wariantów i fraz semantycznych, poprawiając zarówno pozycje, jak i cytowalność przez AI.

Testuj i mierz efekty: Przeprowadzaj testy A/B różnych gęstości słów kluczowych i analizuj ich wpływ na pozycje, ruch i konwersje. Wykorzystuj Google Analytics i Search Console do śledzenia efektów i optymalizacji działań.

Przyszłe trendy i ewolucja gęstości słów kluczowych w SEO

Przyszłość gęstości słów kluczowych w SEO zmienia się wraz z rozwojem technologii wyszukiwania i pojawianiem się nowych platform. Kilka kluczowych trendów kształtuje sposób rozumienia i stosowania tej metryki w nadchodzących latach. Po pierwsze, wzrost znaczenia generative engine optimization (GEO) i platform AI przesuwa nacisk z tradycyjnej gęstości słów kluczowych na semantyczną trafność i autorytet tematyczny. Wraz z rozwojem AI rozumiejącej język naturalny, znaczenie dokładnej częstotliwości słów jeszcze bardziej maleje. Po drugie, optymalizacja pod wyszukiwanie głosowe zmienia sposób użycia słów — zapytania głosowe są dłuższe, bardziej konwersacyjne i mniej nasycone słowami kluczowymi niż tekstowe. Oznacza to, że przyszła optymalizacja będzie kłaść nacisk na naturalny język i pytania zamiast tradycyjnych targetów gęstości. Po trzecie, integracja wyszukiwania opartego na encjach sprawia, że wyszukiwarki coraz lepiej rozumieją relacje między pojęciami, a nie tylko dopasowanie słów. W praktyce przyszłe strategie SEO będą skupiać się na budowaniu autorytetu tematycznego i relacji encji, zamiast optymalizować pod konkretne procenty. Po czwarte, zero-click searches i AI Overviews zmniejszają znaczenie samej pozycji w rankingu — marki muszą optymalizować się pod kątem cytowań AI i możliwości ekstrakcji, a nie tylko pozycji. Ostatecznie, wraz ze wzrostem znaczenia sygnałów E-E-A-T, treści od uznanych ekspertów i autorytetów będą zajmować wysokie pozycje niezależnie od gęstości słów kluczowych, co jeszcze bardziej ogranicza wagę tej metryki jako głównego celu optymalizacji. Kierunek jest jasny: gęstość słów kluczowych pozostanie przydatnym wskaźnikiem do monitorowania, ale jej znaczenie wobec jakości treści, trafności semantycznej, doświadczenia użytkownika i autorytetu tematycznego będzie nadal maleć.

Wnioski: równowaga między gęstością słów kluczowych a nowoczesnymi priorytetami SEO

Gęstość słów kluczowych pozostaje istotną koncepcją w SEO, ale jej rola zasadniczo zmieniła się z głównego czynnika rankingowego na sygnał wspierający, pomagający w prawidłowej optymalizacji widoczności w wyszukiwarkach. Ewolucja od optymalizacji nakierowanej na słowa kluczowe do SEO zorientowanego na jakość i użytkownika odzwierciedla szersze zmiany w sposobie, w jaki wyszukiwarki i systemy AI rozumieją i oceniają treści. Współczesny specjalista SEO powinien traktować gęstość słów kluczowych jako balans do utrzymania, a nie cel do maksymalizacji — dążyć do naturalnej integracji słów kluczowych na poziomie około 1–2%, stawiając priorytet na jakość treści, trafność semantyczną i doświadczenie użytkownika. Dane jednoznacznie pokazują, że strony z czołówki rankingu mają niższą gęstość słów kluczowych niż te z dalszych pozycji — jakość i trafność liczą się bardziej niż liczba powtórzeń. Dla marek monitorujących obecność w AI, takich jak ChatGPT, Perplexity czy Google AI Overviews, zrozumienie roli gęstości słów kluczowych w ekstrakcji treści staje się coraz ważniejsze. Treści z odpowiednią gęstością, strategicznym rozmieszczeniem i kompleksowym pokryciem tematu są częściej cytowane przez AI, zapewniając wartościową widoczność marki w nowych realiach wyszukiwania. Dzięki zbalansowanemu podejściu do gęstości słów kluczowych — zgodnemu zarówno z wymaganiami wyszukiwarek, jak i użytkowników — twórcy mogą budować trwałe, skuteczne treści, które osiągają wysokie pozycje, pojawiają się w cytowaniach AI i faktycznie odpowiadają na potrzeby odbiorców.