Duży Model Językowy (LLM)

Kompleksowa definicja dużych modeli językowych (LLM): systemy AI trenowane na miliardach parametrów w celu rozumienia i generowania języka. Dowiedz się, jak dzi...

Parametry modelu to uczące się zmienne w modelach AI, takie jak wagi i biasy, które są automatycznie dostosowywane podczas treningu w celu optymalizacji zdolności modelu do dokonywania trafnych prognoz i określają, jak model przetwarza dane wejściowe, aby wygenerować wyjście.

Parametry modelu to uczące się zmienne w modelach AI, takie jak wagi i biasy, które są automatycznie dostosowywane podczas treningu w celu optymalizacji zdolności modelu do dokonywania trafnych prognoz i określają, jak model przetwarza dane wejściowe, aby wygenerować wyjście.

Parametry modelu to uczące się zmienne w modelach sztucznej inteligencji, które są automatycznie dostosowywane podczas procesu treningowego, aby zoptymalizować zdolność modelu do dokonywania trafnych prognoz oraz określają, w jaki sposób model przetwarza dane wejściowe, by wygenerować wyniki. Parametry te są podstawowymi „pokrętłami sterującymi” w systemach uczenia maszynowego, wyznaczając dokładne zachowanie i wzorce decyzyjne modeli AI. W kontekście uczenia głębokiego i sieci neuronowych parametry składają się głównie z wag i biasów — wartości liczbowych, które kontrolują przepływ informacji przez sieć i siłę wpływu różnych cech na prognozy. Celem treningu jest znalezienie optymalnych wartości tych parametrów, które minimalizują błędy predykcji i umożliwiają modelowi dobre uogólnianie na nowe, niewidziane dane. Zrozumienie parametrów modelu jest kluczowe dla pojęcia, jak działają współczesne systemy AI, takie jak ChatGPT, Claude, Perplexity oraz Google AI Overviews, i dlaczego generują różne odpowiedzi na te same zapytania.

Koncepcja uczących się parametrów w uczeniu maszynowym sięga początków sztucznych sieci neuronowych w latach 50. i 60. XX wieku, kiedy naukowcy po raz pierwszy zauważyli, że sieci mogą dostosowywać wartości wewnętrzne, by uczyć się na podstawie danych. Jednak praktyczne zastosowanie parametrów było ograniczone aż do wprowadzenia propagacji wstecznej w latach 80., która zapewniła wydajny algorytm do obliczania, jak powinno się korygować parametry w celu zmniejszenia błędów. Eksplozja liczby parametrów przyspieszyła gwałtownie wraz z rozwojem uczenia głębokiego w latach 2010. Wczesne konwolucyjne sieci neuronowe do rozpoznawania obrazów miały miliony parametrów, podczas gdy współczesne duże modele językowe (LLM) zawierają setki miliardów, a nawet biliony parametrów. Według badań Our World in Data i Epoch AI liczba parametrów w czołowych systemach AI wzrosła wykładniczo: GPT-3 ma 175 miliardów parametrów, GPT-4o około 200 miliardów, a niektóre szacunki sugerują, że GPT-4 może mieć nawet 1,8 biliona parametrów, uwzględniając architektury mixture-of-experts. Tak gwałtowne skalowanie zasadniczo zmieniło możliwości systemów AI, umożliwiając im wychwytywanie coraz bardziej złożonych wzorców w języku, wizji i zadaniach wymagających rozumowania.

Parametry modelu funkcjonują w ramach matematycznego systemu, w którym każdy parametr reprezentuje wartość liczbową wpływającą na sposób przekształcania przez model danych wejściowych w wyjściowe. W prostym modelu regresji liniowej parametry to nachylenie (m) i wyraz wolny (b) w równaniu y = mx + b; te dwie wartości wyznaczają prostą najlepiej dopasowaną do danych. W sieciach neuronowych sytuacja staje się wykładniczo bardziej złożona. Każdy neuron w warstwie otrzymuje wejścia z poprzedniej warstwy, mnoży każde wejście przez odpowiadający mu wagę, sumuje te ważone wejścia, dodaje bias, a następnie przekazuje wynik przez funkcję aktywacji, by wygenerować wyjście. To wyjście staje się wejściem dla neuronów w kolejnej warstwie, tworząc kaskadę transformacji sterowanych parametrami. Podczas treningu model wykorzystuje spadek gradientu i powiązane algorytmy optymalizacyjne do obliczenia, jak każdy parametr powinien zostać dostosowany do zmniejszenia funkcji straty — matematycznej miary błędu predykcji. Gradient straty względem każdego parametru wskazuje kierunek i wielkość potrzebnej korekty. Dzięki propagacji wstecznej gradienty te przepływają przez całą sieć, umożliwiając optymalizatorowi jednoczesną aktualizację wszystkich parametrów w skoordynowany sposób. Proces ten powtarza się przez wiele epok treningowych, aż parametry zbiegną do wartości minimalizujących stratę na danych treningowych, zachowując jednocześnie dobrą uogólnialność na nowe dane.

| Aspekt | Parametry modelu | Hiperparametry | Cechy (features) |

|---|---|---|---|

| Definicja | Uczące się zmienne dostosowywane podczas treningu | Ustawienia konfiguracyjne określone przed treningiem | Charakterystyki danych wejściowych wykorzystywane przez model |

| Kiedy ustalane | Automatycznie uczone poprzez optymalizację | Ręcznie ustawiane przez praktyków | Wyodrębniane lub projektowane z surowych danych |

| Przykłady | Wagi, biasy w sieciach neuronowych | Tempo uczenia, rozmiar batcha, liczba warstw | Wartości pikseli w obrazach, embeddingi słów w tekście |

| Wpływ na model | Określają, jak model mapuje wejścia na wyjścia | Kontrolują proces uczenia i strukturę modelu | Dostarczają surowych informacji, z których uczy się model |

| Metoda optymalizacji | Spadek gradientu, Adam, AdaGrad | Grid search, random search, optymalizacja bayesowska | Inżynieria cech, selekcja cech |

| Liczba w dużych modelach | Miliardy do bilionów (np. 200 mld w GPT-4o) | Zazwyczaj 5-20 kluczowych hiperparametrów | Tysiące do milionów w zależności od danych |

| Koszt obliczeniowy | Wysoki podczas treningu; wpływa na szybkość wnioskowania | Minimalny koszt obliczeniowy przy ustalaniu | Zależny od zbierania i przetwarzania danych |

| Transferowalność | Możliwy transfer przez fine-tuning i transfer learning | Muszą być ponownie dostrajane do nowych zadań | Mogą wymagać ponownej inżynierii dla nowych domen |

Parametry modelu przyjmują różne formy w zależności od architektury i typu wykorzystywanego modelu uczenia maszynowego. W konwolucyjnych sieciach neuronowych (CNN) stosowanych do rozpoznawania obrazów parametry obejmują wagi w filtrach konwolucyjnych (zwanych też kernelami), które wykrywają wzorce przestrzenne, takie jak krawędzie, tekstury i kształty w różnych skalach. Rekurencyjne sieci neuronowe (RNN) i sieci LSTM zawierają parametry kontrolujące przepływ informacji w czasie, w tym parametry bramek określające, które informacje mają być zapamiętane, a które zapomniane. Transformatory, które napędzają współczesne duże modele językowe, mają parametry w wielu komponentach: wagi uwagi (attention), które określają, na które części wejścia należy zwracać uwagę, wagi sieci feed-forward oraz parametry normalizacji warstw. W modelach probabilistycznych, takich jak Naiwny Bayes, parametry definiują rozkłady prawdopodobieństwa warunkowego. Maszyny wektorów nośnych (SVM) wykorzystują parametry określające położenie i orientację granic decyzyjnych w przestrzeni cech. Modele Mixture of Experts (MoE), stosowane w niektórych wersjach GPT-4, zawierają parametry dla wielu wyspecjalizowanych podsieci oraz parametry routingu decydujące, które „eksperci” przetwarzają dane wejściowe. Ta różnorodność architektoniczna oznacza, że charakter i liczba parametrów znacząco się różni w zależności od typu modelu, ale podstawowa zasada pozostaje niezmienna: parametry to wyuczone wartości umożliwiające modelowi realizację zadania.

Wagi i biasy stanowią dwa podstawowe typy parametrów w sieciach neuronowych i leżą u podstaw procesu uczenia się tych modeli. Wagi to wartości liczbowe przypisane połączeniom między neuronami, określające siłę i kierunek wpływu wyjścia jednego neuronu na wejście kolejnego. W pełni połączonej warstwie z 1000 neuronami wejściowymi i 500 wyjściowymi znajdzie się 500 000 parametrów wag — po jednej dla każdego połączenia. Podczas treningu wagi są dostosowywane, by zwiększyć lub zmniejszyć wpływ określonych cech na prognozy. Duża dodatnia waga oznacza, że dana cecha silnie aktywuje kolejny neuron, podczas gdy ujemna waga go hamuje. Biasy to dodatkowe parametry (jeden na neuron w warstwie), które zapewniają stałe przesunięcie sumy wejść neuronu przed zastosowaniem funkcji aktywacji. Matematycznie, jeśli neuron otrzymuje ważone wejścia o sumie zero, bias pozwala mu wciąż wygenerować niezerowe wyjście, co daje modelowi ważną elastyczność. Ta elastyczność umożliwia sieciom neuronowym uczenie się złożonych granic decyzyjnych i wzorców, których nie dałoby się uchwycić samymi wagami. W modelu z 200 miliardami parametrów, jak GPT-4o, zdecydowaną większość stanowią wagi w mechanizmach uwagi i sieciach feed-forward, a biasy stanowią mniejszą, lecz wciąż istotną część. Wspólnie wagi i biasy pozwalają modelowi uczyć się złożonych wzorców w języku, wizji czy innych dziedzinach, dzięki czemu współczesne systemy AI są tak potężne.

Liczba parametrów w modelu ma ogromny wpływ na jego zdolność do uczenia się złożonych wzorców i ogólną wydajność. Badania konsekwentnie pokazują, że prawa skalowania rządzą relacją między liczbą parametrów, rozmiarem danych treningowych i wydajnością modelu. Modele z większą liczbą parametrów mogą reprezentować bardziej złożone funkcje i uchwycić subtelniejsze wzorce w danych, co na ogół prowadzi do lepszych wyników w trudnych zadaniach. GPT-3 z 175 miliardami parametrów wykazywał niezwykłe zdolności few-shot learning, których nie miały mniejsze modele. GPT-4o z 200 miliardami parametrów prezentuje dalsze ulepszenia w rozumowaniu, generowaniu kodu i rozumieniu multimodalnym. Jednak relacja między liczbą parametrów a wydajnością nie jest liniowa i silnie zależy od ilości i jakości danych treningowych. Model zbyt duży w stosunku do danych treningowych będzie przeuczony, zapamiętując konkretne przykłady zamiast uogólnionych wzorców, co skutkuje słabą wydajnością na nowych danych. Z kolei model zbyt mały może być niedouczony i nie uchwycić istotnych wzorców, osiągając suboptymalne wyniki nawet na danych treningowych. Optymalna liczba parametrów dla danego zadania zależy od złożoności zadania, wielkości i różnorodności zbioru danych oraz ograniczeń obliczeniowych. Badania Epoch AI pokazują, że współczesne systemy AI osiągnęły imponującą wydajność dzięki masowej skalowalności, a niektóre modele mają biliony parametrów w architekturach mixture-of-experts, gdzie nie wszystkie parametry są aktywne przy każdym wejściu.

Chociaż duże modele z miliardami parametrów osiągają imponujące wyniki, koszt obliczeniowy ich trenowania i wdrażania jest znaczący. To sprzyja badaniom nad efektywnymi metodami fine-tuningu parametrów, które pozwalają praktykom dostosowywać wytrenowane modele do nowych zadań bez aktualizowania wszystkich parametrów. LoRA (Low-Rank Adaptation) to popularna technika, która zamraża większość wyuczonych parametrów i uczy tylko niewielki zestaw dodatkowych macierzy niskiego rzędu, zmniejszając liczbę trenowanych parametrów o rzędy wielkości przy zachowaniu wydajności. Przykładowo, fine-tuning modelu 7-miliardowego z LoRA może polegać na trenowaniu tylko 1-2 milionów dodatkowych parametrów zamiast wszystkich 7 miliardów. Moduły adapterów wstawiają niewielkie trenowalne sieci pomiędzy warstwami zamrożonego modelu, dodając tylko niewielki procent parametrów przy umożliwieniu adaptacji do zadania. Inżynieria promptów i uczenie w kontekście to alternatywne podejścia, które w ogóle nie modyfikują parametrów, lecz efektywniej wykorzystują istniejące parametry modelu dzięki starannie skonstruowanym wejściom. Te efektywne metody demokratyzują dostęp do dużych modeli językowych, umożliwiając organizacjom z ograniczonymi zasobami obliczeniowymi dostosowanie najnowocześniejszych modeli do swoich potrzeb. Kompromis między efektywnością parametrów a wydajnością pozostaje aktywnym obszarem badań, a praktycy balansują pomiędzy efektywnością obliczeniową a dokładnością zadaniową.

Zrozumienie parametrów modelu jest kluczowe dla platform takich jak AmICited, które monitorują, jak marki i domeny pojawiają się w odpowiedziach generowanych przez AI w systemach takich jak ChatGPT, Perplexity, Claude oraz Google AI Overviews. Różne modele AI z różnymi konfiguracjami parametrów generują różne odpowiedzi na to samo zapytanie, wpływając na to, gdzie i jak marki są wymieniane. 200 miliardów parametrów w GPT-4o jest inaczej skonfigurowanych niż parametry w Claude 3.5 Sonnet czy modelach Perplexity, co prowadzi do różnic w generowaniu odpowiedzi. Parametry wyuczone podczas treningu na różnych zbiorach danych i z różnymi celami treningowymi sprawiają, że modele mają różną wiedzę, wzorce rozumowania i sposoby cytowania. Monitorując wzmianki o marce w odpowiedziach AI, zrozumienie, że te różnice wynikają z odmiennych parametrów, pomaga wyjaśnić, dlaczego marka może być szeroko opisywana w jednej odpowiedzi AI, a ledwie wspomniana w innej. Parametry kontrolujące mechanizmy uwagi decydują, które części danych treningowych model uzna za najbardziej istotne dla zapytania, wpływając na wzorce cytowania. Parametry w warstwach generujących odpowiedzi determinują strukturę i prezentację informacji przez model. Śledząc, jak różne systemy AI z różnymi konfiguracjami parametrów wspominają o markach, AmICited dostarcza wglądu w to, jak parametryczne zachowanie modeli wpływa na widoczność marki w krajobrazie wyszukiwania opartym na AI.

Przyszłość parametrów modelu kształtują obecnie liczne trendy, które zasadniczo zmienią projektowanie i wdrażanie systemów AI. Architektury Mixture of Experts (MoE) to istotna ewolucja — modele zawierają wiele wyspecjalizowanych podsieci (ekspertów) z osobnymi parametrami, a mechanizm routingu decyduje, którzy eksperci przetwarzają konkretne wejście. To pozwala skalować modele do bilionów parametrów przy zachowaniu efektywności obliczeniowej podczas wnioskowania, ponieważ nie wszystkie parametry są aktywne przy każdym wejściu. GPT-4 prawdopodobnie wykorzystuje architekturę MoE z 16 ekspertami, każdy z 110 miliardami parametrów, co daje łącznie 1,8 biliona parametrów, ale podczas wnioskowania używana jest tylko ich część. Rozwijane są parametry rzadkie i techniki przycinania (pruning), które pozwalają identyfikować i usuwać mniej istotne parametry, zmniejszając rozmiar modelu bez utraty wydajności. Uczenie ciągłe dąży do efektywnej aktualizacji parametrów w miarę pojawiania się nowych danych, umożliwiając modelom adaptację bez pełnego ponownego treningu. Uczenie federacyjne rozdziela trening parametrów na wiele urządzeń z zachowaniem prywatności, pozwalając korzystać z dużej skali bez centralizowania wrażliwych danych. Pojawienie się małych modeli językowych (SLM) z miliardami, a nie setkami miliardów parametrów, sugeruje przyszłość, w której efektywność parametrów będzie równie ważna jak ich liczba. W miarę jak systemy AI będą integrowane z krytycznymi aplikacjami, zrozumienie i kontrolowanie parametrów modelu stanie się kluczowe dla zapewnienia bezpieczeństwa, sprawiedliwości i zgodności z wartościami ludzkimi. Związek liczby parametrów z zachowaniem modelu pozostanie centralnym tematem badań AI, z implikacjami od zrównoważonego rozwoju obliczeniowego po interpretowalność i zaufanie do systemów AI.

Parametry modelu to wewnętrzne zmienne uczone podczas treningu za pomocą algorytmów optymalizacyjnych, takich jak spadek gradientu, natomiast hiperparametry to zewnętrzne ustawienia konfigurowane przed rozpoczęciem treningu. Parametry determinują, jak model mapuje dane wejściowe na wyjściowe, podczas gdy hiperparametry kontrolują sam proces uczenia, takie jak tempo uczenia czy liczba epok. Na przykład wagi i biasy w sieciach neuronowych to parametry, a tempo uczenia to hiperparametr.

Nowoczesne duże modele językowe zawierają od miliardów do bilionów parametrów. GPT-4o zawiera około 200 miliardów parametrów, natomiast GPT-4o-mini ma około 8 miliardów parametrów. Claude 3.5 Sonnet również operuje setkami miliardów parametrów. Tak ogromna liczba parametrów pozwala tym modelom uchwycić złożone wzorce w języku i generować zaawansowane, kontekstowo trafne odpowiedzi na różnorodne tematy.

Więcej parametrów zwiększa pojemność modelu do uczenia się złożonych wzorców i relacji w danych. Dzięki dodatkowym parametrom modele mogą reprezentować bardziej subtelne cechy i interakcje, co prowadzi do większej dokładności na danych treningowych. Istnieje jednak krytyczna równowaga: zbyt dużo parametrów w stosunku do danych treningowych może prowadzić do przeuczenia, gdzie model zapamiętuje szumy zamiast uogólnionych wzorców, co skutkuje słabą wydajnością na nowych, niewidzianych danych.

Parametry modelu są aktualizowane poprzez propagację wsteczną i algorytmy optymalizacyjne, takie jak spadek gradientu. Podczas treningu model generuje prognozy, oblicza stratę (błąd) pomiędzy prognozami a rzeczywistymi wartościami, a następnie wyznacza gradienty pokazujące, jak każdy parametr przyczynił się do tego błędu. Optymalizator następnie dostosowuje parametry w kierunku zmniejszenia straty, powtarzając ten proces przez wiele iteracji treningowych, aż model osiągnie optymalne wartości.

Wagi określają siłę połączeń między neuronami w sieciach neuronowych, kontrolując, jak mocno cechy wejściowe wpływają na wyjścia. Biasy działają jako regulatory progów, pozwalając neuronom aktywować się nawet wtedy, gdy ważone wejścia wynoszą zero, co zapewnia elastyczność i pozwala modelowi uczyć się wzorców bazowych. Razem wagi i biasy stanowią kluczowe uczące się parametry umożliwiające sieciom neuronowym aproksymację złożonych funkcji i dokonywanie trafnych prognoz.

Parametry modelu bezpośrednio wpływają na to, jak systemy AI, takie jak ChatGPT, Perplexity i Claude, przetwarzają oraz odpowiadają na zapytania. Zrozumienie liczby i konfiguracji parametrów pomaga wyjaśnić, dlaczego różne modele AI generują różne odpowiedzi na to samo polecenie. Dla platform monitorowania marki, takich jak AmICited, śledzenie, jak parametry wpływają na zachowanie modelu, jest kluczowe do przewidywania, gdzie marki pojawiają się w odpowiedziach AI i zrozumienia spójności między różnymi systemami AI.

Tak, dzięki transfer learningowi parametry wytrenowanego modelu można dostosowywać do nowych zadań. To podejście, zwane fine-tuningiem, polega na wykorzystaniu modelu z wyuczonymi parametrami i ich dostosowaniu na nowych danych do konkretnych zastosowań. Efektywne metody fine-tuningu parametrów, takie jak LoRA (Low-Rank Adaptation), pozwalają selektywnie aktualizować parametry, zmniejszając koszty obliczeniowe przy zachowaniu wydajności. Technika ta jest szeroko stosowana do dostosowywania dużych modeli językowych do specjalistycznych dziedzin.

Parametry modelu bezpośrednio wpływają na wymagania obliczeniowe podczas treningu i wnioskowania. Więcej parametrów wymaga więcej pamięci, mocy obliczeniowej i czasu na trening oraz wdrożenie. Model z 175 miliardami parametrów (jak GPT-3) wymaga znacznie więcej zasobów niż model z 7 miliardami parametrów. Ta zależność jest kluczowa dla organizacji wdrażających systemy AI, ponieważ liczba parametrów wpływa na koszty infrastruktury, opóźnienia i zużycie energii w środowiskach produkcyjnych.

Zacznij śledzić, jak chatboty AI wspominają Twoją markę w ChatGPT, Perplexity i innych platformach. Uzyskaj praktyczne spostrzeżenia, aby poprawić swoją obecność w AI.

Kompleksowa definicja dużych modeli językowych (LLM): systemy AI trenowane na miliardach parametrów w celu rozumienia i generowania języka. Dowiedz się, jak dzi...

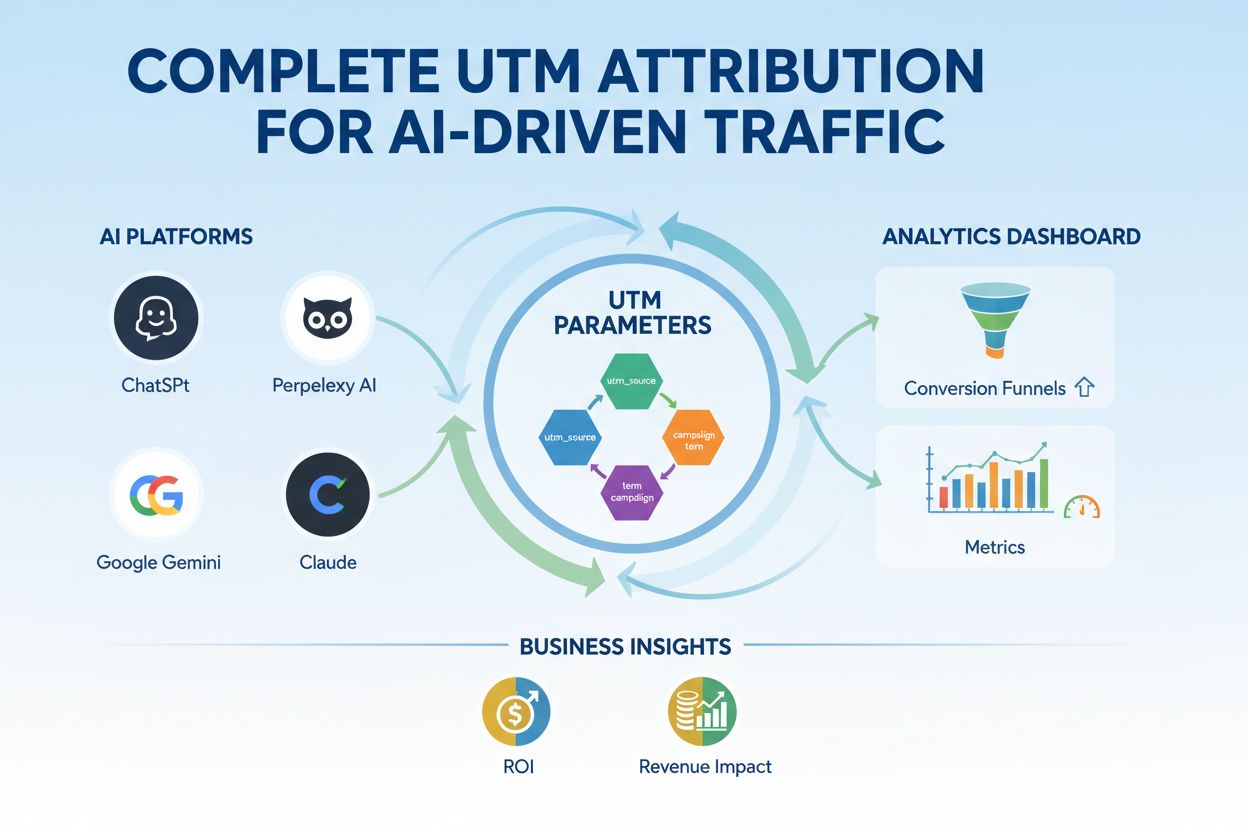

Opanuj śledzenie UTM dla platform AI takich jak ChatGPT, Perplexity i Google Gemini. Dowiedz się, jak skonfigurować, stosować najlepsze praktyki oraz jak dokład...

Poznaj modele atrybucji widoczności AI – ramy wykorzystujące uczenie maszynowe do przypisywania zasług punktom styku marketingowego na ścieżce klienta. Dowiedz ...