Content SEO

Content SEO to strategiczne tworzenie i optymalizacja wysokiej jakości treści w celu poprawy pozycji w wyszukiwarkach i widoczności organicznej. Dowiedz się, ja...

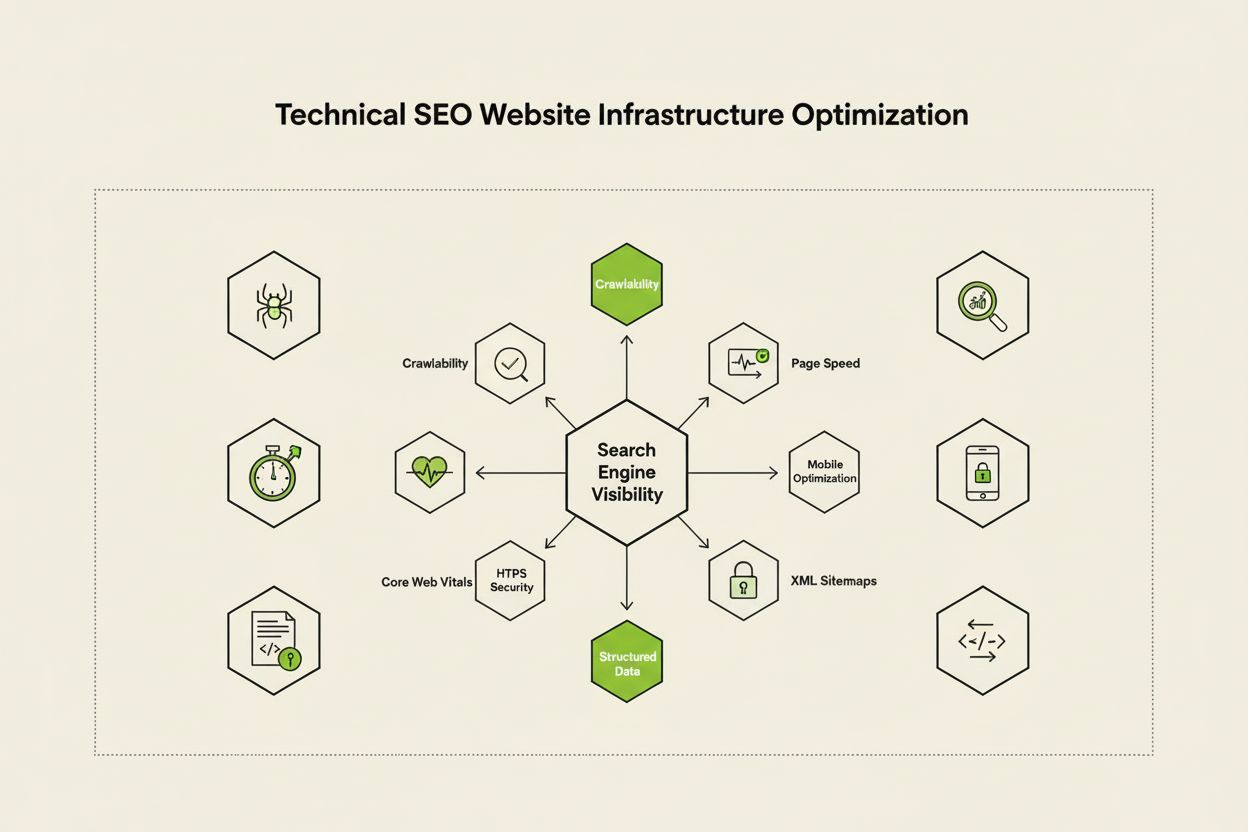

Techniczne SEO to proces optymalizacji infrastruktury strony internetowej, aby wyszukiwarki mogły poprawnie i efektywnie indeksować, renderować, indeksować i serwować treści. Obejmuje szybkość strony, przyjazność dla urządzeń mobilnych, architekturę witryny, bezpieczeństwo oraz wdrażanie danych strukturalnych, by zapewnić wyszukiwarkom możliwość odkrycia i pozycjonowania Twoich stron.

Techniczne SEO to proces optymalizacji infrastruktury strony internetowej, aby wyszukiwarki mogły poprawnie i efektywnie indeksować, renderować, indeksować i serwować treści. Obejmuje szybkość strony, przyjazność dla urządzeń mobilnych, architekturę witryny, bezpieczeństwo oraz wdrażanie danych strukturalnych, by zapewnić wyszukiwarkom możliwość odkrycia i pozycjonowania Twoich stron.

Techniczne SEO to proces optymalizacji zaplecza strony internetowej, aby zapewnić wyszukiwarkom możliwość efektywnego crawlowania, renderowania, indeksowania i poprawnego serwowania treści. W przeciwieństwie do SEO on-page, które koncentruje się na jakości treści i optymalizacji słów kluczowych, techniczne SEO dotyczy elementów podstawowych decydujących o tym, czy wyszukiwarki w ogóle będą mogły uzyskać dostęp i zrozumieć Twoją stronę. Obejmuje to szybkość witryny, responsywność mobilną, architekturę strony, protokoły bezpieczeństwa, wdrożenie danych strukturalnych oraz czynniki crawlability. Techniczne SEO stanowi niewidoczny fundament, na którym opierają się wszystkie pozostałe działania SEO—bez niego nawet najwyższej jakości treści pozostają niewidoczne zarówno dla wyszukiwarek, jak i użytkowników. Według badań branżowych 91% marketerów zadeklarowało, że SEO poprawiło wydajność strony w 2024 roku, a techniczna optymalizacja odegrała kluczową rolę w osiąganiu mierzalnych rezultatów. Znaczenie technicznego SEO wzrosło wraz z rozwojem wyszukiwarek i pojawieniem się platform AI, które wymagają spełnienia coraz bardziej rygorystycznych wymagań technicznych dla uzyskania widoczności.

Techniczne SEO opiera się na czterech wzajemnie powiązanych filarach, które razem maksymalizują widoczność strony w wyszukiwarkach. Crawlability decyduje o tym, czy Googlebot i inne roboty mogą dostać się do Twoich stron przez linki, mapy witryn i struktury nawigacji wewnętrznej. Indexability zapewnia, że zindeksowane strony faktycznie trafiają do indeksu Google i mogą pojawiać się w wynikach wyszukiwania. Wydajność i Core Web Vitals mierzą, jak szybko strony się ładują i jak są responsywne—czynniki te mają bezpośredni wpływ na pozycje i doświadczenie użytkownika. Optymalizacja mobilna gwarantuje prawidłowe działanie strony na smartfonach i tabletach, które według badań Sistrix generują już ponad 60% całego ruchu z wyszukiwarek. Te cztery filary są ze sobą powiązane; słabość w jednym z nich osłabia skuteczność pozostałych. Na przykład szybka strona desktopowa, która działa źle na mobile, będzie mieć problem z pozycjonowaniem w mobilnym indeksie Google, niezależnie od optymalizacji crawlability. Zrozumienie zależności między tymi filarami jest kluczowe dla opracowania kompleksowej strategii technicznego SEO obejmującej wszystkie aspekty widoczności w wyszukiwarkach.

Choć często mylone, crawlability i indexability to dwa odrębne etapy procesu przetwarzania strony przez wyszukiwarki. Crawlability oznacza możliwość wyszukiwarki do odkrycia i uzyskania dostępu do stron przez śledzenie linków wewnętrznych, zewnętrznych oraz mapy XML. Odpowiada na pytanie: „Czy Googlebot może dotrzeć do tej strony?” Jeśli strona nie jest crawlable—na przykład przez blokadę robots.txt, ukrycie za JavaScriptem lub brak linków wewnętrznych—nie przejdzie do etapu indeksacji. Indexability natomiast decyduje, czy zcrawlowana strona zostanie zapisana w indeksie Google i będzie mogła pojawić się w wynikach. Strona może być crawlable, ale niezaindeksowana—np. przez tag noindex, zduplikowaną treść lub niespełnienie wymogów jakościowych Google. Według przewodnika technicznego SEO Search Engine Land, zrozumienie tej różnicy jest kluczowe, ponieważ naprawa problemów z crawlability wymaga innych działań niż poprawa indexability. Problemy z crawlability dotyczą zwykle struktury strony, pliku robots.txt i linkowania wewnętrznego, natomiast indexability to kwestia meta tagów, tagów kanonicznych, jakości treści i renderowania. Obie kwestie muszą być rozwiązane, by osiągnąć najwyższą widoczność w wyszukiwarkach.

Core Web Vitals to trzy konkretne metryki, które Google wykorzystuje do oceny rzeczywistego doświadczenia użytkownika i bezpośrednio wpływają na pozycję strony. Largest Contentful Paint (LCP) mierzy, jak szybko ładuje się największy widoczny element na stronie—Google rekomenduje LCP maksymalnie 2,5 sekundy. Interaction to Next Paint (INP), który w 2024 roku zastąpił First Input Delay, mierzy responsywność strony na interakcje użytkownika—celem jest mniej niż 200 milisekund. Cumulative Layout Shift (CLS) ocenia stabilność wizualną przez śledzenie nieoczekiwanych zmian układu podczas ładowania strony—wynik poniżej 0,1 uznawany jest za dobry. Badania DebugBear wskazują, że strony muszą zapewnić „dobry” wynik w każdej z tych trzech metryk dla co najmniej 75% użytkowników, by uzyskać pełne korzyści rankingowe. Przejście na INP jako czynnik rankingowy odzwierciedla rosnące znaczenie ogólnej responsywności strony, a nie tylko szybkości początkowego ładowania. Optymalizacja Core Web Vitals wymaga złożonych działań: poprawa LCP to optymalizacja obrazów, korzystanie z CDN i opóźnianie ładowania niekrytycznego JavaScriptu; poprawa INP to rozbijanie długich zadań JS i optymalizacja obsługi zdarzeń; ograniczanie CLS to rezerwacja miejsca na dynamiczne elementy i unikanie reklam zmieniających układ strony. Te metryki są obecnie niezbędne w konkurencyjnym SEO—strony z niskimi wynikami Core Web Vitals otrzymują kary rankingowe i wyższy współczynnik odrzuceń.

Architektura strony to sposób organizowania, strukturyzowania i łączenia podstron za pomocą linków wewnętrznych. Dobrze zaprojektowana architektura spełnia kilka kluczowych funkcji: pomaga wyszukiwarkom zrozumieć hierarchię treści, rozprowadza moc linków po stronie, zapewnia łatwe odkrywanie ważnych stron i poprawia nawigację użytkownika. Idealna architektura strony opiera się na czytelnej hierarchii—strona główna na szczycie, poniżej strony kategorii, a jeszcze niżej strony z pojedynczą treścią. Najlepszą praktyką jest, by wszystkie ważne strony były dostępne w maksymalnie trzech kliknięciach od strony głównej, dzięki czemu Googlebot nie traci budżetu crawl na głębokie, odizolowane strony. Linkowanie wewnętrzne to spoiwo architektury, prowadzące użytkowników i roboty przez treści. Strategiczne linkowanie wewnętrzne koncentruje sygnały rankingowe na stronach priorytetowych, buduje powiązania tematyczne i pomaga wyszukiwarkom określić, które strony są najważniejsze. Przykładowo, model hub-and-spoke—gdzie rozbudowana strona filarowa linkuje do powiązanych podstron, a te z kolei odsyłają z powrotem—tworzy mocną strukturę sygnalizującą autorytet tematyczny. Zła architektura, czyli strony osierocone, niespójna nawigacja i głębokie zagnieżdżenia, powoduje marnowanie budżetu crawl na mniej istotne treści i utrudnia budowanie autorytetu. Firmy, które restrukturyzują architekturę strony, często notują szybki wzrost tempa indeksacji i pozycji.

Indeksowanie mobilne oznacza, że Google przede wszystkim crawluje, indeksuje i pozycjonuje mobilną wersję Twojej strony, a nie desktopową. Ta zmiana odpowiada rzeczywistości, w której ponad 60% wyszukiwań odbywa się na urządzeniach mobilnych. Dla technicznego SEO oznacza to konieczność perfekcyjnego doświadczenia mobilnego: responsywny design dopasowujący się do każdego rozmiaru ekranu, nawigacja przyjazna dotykowi z odpowiednimi odstępami między elementami klikalnymi, czytelne rozmiary czcionek i szybkie ładowanie zoptymalizowane pod sieci mobilne. Responsywny design wykorzystuje elastyczne układy i obrazy, by automatycznie dopasować się do różnych ekranów i zapewnić spójne funkcjonowanie. Typowe błędy optymalizacji mobilnej to nachalne pop-upy blokujące treści, zbyt małe teksty, zbyt blisko siebie położone przyciski czy powolne ładowanie na sieciach mobilnych. Narzędzia Google Mobile-Friendly Test i Lighthouse wskazują takie problemy, ale niezbędne są także testy na rzeczywistych urządzeniach mobilnych. Bezpośredni związek między optymalizacją mobilną a pozycjami jest oczywisty—strony z kiepskim doświadczeniem mobilnym tracą pozycje, a zoptymalizowane zyskują widoczność. Dla e-commerce, SaaS i wydawców treści optymalizacja mobilna to nie opcja, lecz podstawa konkurencyjnej widoczności.

Mapy XML to mapa drogowa dla wyszukiwarek, zawierająca wszystkie adresy URL, które chcesz zaindeksować wraz z metadanymi jak data ostatniej modyfikacji czy priorytet. Dobrze utrzymana mapa powinna zawierać tylko kanoniczne, indeksowalne adresy URL—bez przekierowań, 404 i duplikatów. Robots.txt to plik tekstowy w katalogu głównym witryny, zawierający instrukcje dla robotów o tym, które katalogi i pliki mogą, a których nie mogą crawlowac. Robots.txt może blokować crawlowanie, ale nie zapobiega indeksacji, jeśli strona zostanie odnaleziona w inny sposób—by wykluczyć stronę z indeksu, użyj noindex. Budżet crawl to liczba stron, które Googlebot może zcrawlowac w danym czasie—ograniczony zasób, którym trzeba zarządzać strategicznie. Duże witryny z milionami podstron muszą optymalizować budżet crawl, by Googlebot koncentrował się na najważniejszych treściach, a nie marnował zasobów na mało istotne, zduplikowane lub warianty nawigacji fasetowej. Najczęstsze marnowanie budżetu crawl to generowanie setek wariantów URL przez parametry, ekspozycja środowisk testowych lub nadmierne linkowanie do stron z cienką treścią. Według oficjalnych wytycznych Google zarządzanie budżetem crawl jest szczególnie istotne dla dużych serwisów, bo nieefektywne crawlowanie opóźnia indeksację nowych lub zaktualizowanych treści. Narzędzia jak raport Crawl Stats w Google Search Console i analiza logów serwera pokazują, które strony Googlebot odwiedza najczęściej, umożliwiając optymalizację budżetu crawl na podstawie danych.

Dane strukturalne, wdrażane przez schema markup, pomagają wyszukiwarkom zrozumieć znaczenie i kontekst Twoich treści poza prostą analizą tekstu. Schema markup używa standaryzowanego słownictwa (schema.org) do oznaczania typów treści—produktów, artykułów, przepisów, wydarzeń, firm lokalnych i innych. Poprawnie wdrożony schema markup umożliwia wyniki rozszerzone w wyszukiwarce, gdzie Google prezentuje dodatkowe informacje jak oceny, ceny, czas przygotowania czy daty wydarzeń bezpośrednio w wynikach. To zwiększa widoczność i współczynnik kliknięć. Różne typy treści wymagają różnych schematów: schema Article dla blogów i newsów, schema Product dla e-commerce, schema FAQ dla pytań i odpowiedzi, schema Local Business dla firm lokalnych czy schema Event dla wydarzeń. Implementacja zazwyczaj wykorzystuje format JSON-LD, preferowany przez Google. Schema musi odzwierciedlać rzeczywistą zawartość strony—fałszywy lub mylący schema może skutkować ręcznymi karami. Według badań Search Engine Land tylko strony z poprawnym, relewantnym schema mogą wyświetlać wyniki rozszerzone, dlatego precyzja wdrożenia jest kluczowa. Firmy wdrażające schema na najważniejszych stronach często zyskują lepszą widoczność zarówno w klasycznych wynikach, jak i na platformach AI, ponieważ te systemy polegają na danych strukturalnych do zrozumienia i cytowania treści.

HTTPS (Hypertext Transfer Protocol Secure) szyfruje dane przesyłane między przeglądarką użytkownika a serwerem, chroniąc wrażliwe informacje i budując zaufanie zarówno wśród użytkowników, jak i wyszukiwarek. Google potwierdziło, że HTTPS jest czynnikiem rankingowym, a strony bez HTTPS otrzymują kary bezpośrednie i pośrednie, np. ostrzeżenia przeglądarek zniechęcające do korzystania. Wdrożenie HTTPS wymaga uzyskania certyfikatu SSL/TLS od zaufanego podmiotu i skonfigurowania serwera do obsługi HTTPS na wszystkich stronach. Poza podstawowym wdrożeniem, nagłówki bezpieczeństwa jak Content-Security-Policy, Strict-Transport-Security czy X-Content-Type-Options chronią przed popularnymi zagrożeniami sieciowymi. Błędy z mieszanymi treściami—gdy strona HTTPS ładuje zasoby przez HTTP—obniżają bezpieczeństwo i mogą wywoływać ostrzeżenia. Relacja między bezpieczeństwem a SEO wykracza poza pozycje: bezpieczne strony budują zaufanie, zmniejszają współczynnik odrzuceń i zwiększają konwersje. Dla e-commerce, SaaS i wszystkich stron gromadzących dane osobowe bezpieczeństwo to konieczność. Regularne audyty bezpieczeństwa, np. raport Security Issues w Google Search Console czy zewnętrzne skanery podatności, pozwalają szybko wykryć i usunąć zagrożenia zanim wpłyną na pozycje lub zaufanie użytkowników.

| Aspekt | Techniczne SEO | SEO on-page | SEO off-page |

|---|---|---|---|

| Główny cel | Infrastruktura strony, szybkość, crawlability, indexability | Jakość treści, słowa kluczowe, meta tagi, nagłówki | Linki zwrotne, wzmianki o marce, sygnały społecznościowe |

| Dostęp wyszukiwarki | Zapewnia crawlowanie i indeksowanie stron | Pomaga zrozumieć trafność stron | Buduje autorytet i zaufanie |

| Kluczowe elementy | Szybkość witryny, optymalizacja mobilna, Core Web Vitals, architektura strony, HTTPS, dane strukturalne | Rozmieszczenie słów kluczowych, głębia treści, linkowanie wewnętrzne, meta opisy | Profil linków, autorytet domeny, wzmianki o marce |

| Narzędzia | PageSpeed Insights, Google Search Console, Screaming Frog, Lighthouse | Yoast SEO, Surfer SEO, Content Genius | Ahrefs, Semrush, Moz, Majestic |

| Wpływ na pozycje | Fundamentalny—bez tego strony nie będą się pozycjonować | Bezpośredni—zwiększa trafność na słowa kluczowe | Znaczący—buduje autorytet i zaufanie |

| Wpływ na UX | Wysoki—wpływa na szybkość, mobilność, dostępność | Średni—wpływa na czytelność i zaangażowanie | Niski—pośredni przez postrzeganie marki |

| Czas wdrożenia | Ciągły—wymaga stałego monitoringu i optymalizacji | Ciągły—wymaga aktualizacji i optymalizacji treści | Długoterminowy—wymaga stałej pracy nad linkami |

| Pomiar ROI | Efektywność crawl, wskaźnik indeksacji, Core Web Vitals, pozycje | Pozycje słów kluczowych, ruch organiczny, CTR | Wzrost linków, autorytet domeny, ruch z poleceń |

SEO JavaScript dotyczy wyzwań, jakie niesie ze sobą optymalizacja stron opartych na JavaScript, aplikacji SPA i dynamicznych treści. Historycznie Googlebot miał problemy z JavaScriptem, ponieważ wymagał renderowania (wykonywania kodu JS w celu zbudowania końcowej strony), co komplikowało i opóźniało proces crawlowania. Współczesny Googlebot renderuje większość stron przed indeksacją, ale to rodzi nowe wyzwania SEO. Renderowanie po stronie serwera (SSR) generuje kompletne HTML na serwerze i wysyła je do przeglądarki, dzięki czemu wyszukiwarki widzą całą treść natychmiast, bez czekania na wykonanie JavaScriptu. Generowanie statycznych stron (SSG) przygotowuje strony podczas budowania i dostarcza gotowe pliki HTML. Dynamiczne renderowanie polega na serwowaniu pre-renderowanego HTML dla robotów, a oryginalnego JS dla użytkowników, choć Google wskazuje, że to rozwiązanie tymczasowe. Zasada jest prosta: cała kluczowa treść, meta tagi i dane strukturalne muszą być widoczne w początkowym HTML, a nie doładowywane przez JavaScript. Strony ukrywające ważne treści za JavaScriptem ryzykują niepełną lub opóźnioną indeksację. Frameworki React, Vue i Angular wymagają szczególnej uwagi—wiele firm wdraża Next.js lub Nuxt.js właśnie po to, by zapewnić SSR i lepsze SEO. Testowanie widoczności stron dla Googlebota przez Google Search Console (narzędzie Inspekcja adresu URL i podgląd renderowania) pokazuje, czy treści zależne od JavaScriptu są poprawnie indeksowane.

Skuteczna implementacja technicznego SEO wymaga systematycznego podejścia i priorytetyzowania działań o największym wpływie. Zacznij od fundamentów: zadbaj o crawlability poprzez kontrolę robots.txt i linkowania wewnętrznego, sprawdź indeksowalność kluczowych stron pod kątem tagów noindex i problemów z kanonikalizacją, a także ustal bazowy poziom Core Web Vitals. Następnie zadbaj o wydajność: kompresuj i optymalizuj obrazy, wdrażaj lazy loading dla treści poniżej linii załadowania, opóźniaj niekrytyczny JavaScript i korzystaj z CDN. Potem optymalizuj strukturę strony: zapewnij dostępność ważnych stron w trzy kliknięcia od strony głównej, wdrażaj nawigację okruszkową ze schema markup i rozbudowane, logiczne linkowanie wewnętrzne. Wdrażaj dane strukturalne dla kluczowych typów treści—produktów, artykułów, danych o firmie lokalnej czy wydarzeniach—w formacie JSON-LD i weryfikuj w Google Rich Results Test. Monitoruj stale: korzystaj z Google Search Console do wykrywania problemów z indeksacją, PageSpeed Insights do oceny Core Web Vitals i analizuj logi serwera pod kątem crawl. Wprowadź rozliczalność przez śledzenie metryk jak liczba zaindeksowanych stron, wyniki Core Web Vitals czy efektywność crawl w czasie. Firmy traktujące techniczne SEO jako proces ciągły, a nie jednorazowy audyt, stale przewyższają konkurencję pod względem widoczności i doświadczenia użytkownika.

Wraz z rozwojem platform AI takich jak Google AI Overviews, Perplexity, ChatGPT czy Claude, rola technicznego SEO wykracza poza tradycyjne Google Search. Systemy AI opierają się na poprawnie zaindeksowanych, dobrze ustrukturyzowanych treściach do generowania odpowiedzi i cytatów. Techniczne SEO zapewnia, że Twoje treści są możliwe do odkrycia i prawidłowo interpretowane przez AI dzięki kilku mechanizmom: poprawna indeksacja umożliwia wykorzystanie treści w szkoleniu i generowaniu odpowiedzi, dane strukturalne pomagają AI zrozumieć kontekst i znaczenie, a bogactwo semantyczne sprawia, że treści są uznawane za autorytatywne i relewantne. Według badań Conductor i Botify, strony pojawiające się w AI Overviews pochodzą z dobrze zoptymalizowanych, technicznie poprawnych serwisów z silnymi sygnałami semantycznymi. Relacja jest dwukierunkowa: tradycyjne SEO skupia się na pozycjonowaniu na konkretne słowa, AI search dąży do udzielania wyczerpujących odpowiedzi na podstawie wielu źródeł. Oznacza to, że techniczne SEO musi wspierać oba modele—zapewniać indeksację pod tradycyjne wyszukiwanie oraz dostarczać treści semantycznie bogatych dla systemów AI. Firmy monitorujące widoczność na wielu platformach AI (np. AmICited) mogą określić, które optymalizacje techniczne najbardziej zwiększają cytowalność i widoczność w wynikach generatywnych.

Skuteczne techniczne SEO wymaga śledzenia konkretnych metryk obrazujących zdrowie witryny i jej dostępność dla wyszukiwarek. Liczba zaindeksowanych stron pokazuje, ile zamierzonych podstron faktycznie trafiło do indeksu Google—porównanie z liczbą wszystkich indeksowalnych stron ujawnia efektywność indeksacji. Efektywność crawl mierzy, jak skutecznie Googlebot wykorzystuje budżet crawl, wyrażona jako stosunek liczby crawlowanych stron do całkowitej liczby podstron. Wyniki Core Web Vitals pokazują jakość UX pod kątem szybkości ładowania (LCP), interaktywności (INP) i stabilności wizualnej (CLS). Problemy z użytecznością mobilną w Google Search Console ujawniają takie błędy jak za małe elementy dotykowe, błędne ustawienia viewport czy natrętne pop-upy. Długość łańcucha przekierowań powinna być minimalizowana dla zachowania mocy linków i szybkiego crawlowania. Pokrycie danymi strukturalnymi wskazuje, jaki procent stron korzysta z poprawnego schema. Metryki szybkości strony jak First Contentful Paint (FCP), Time to Interactive (TTI) i Total Blocking Time (TBT) dają szczegółową wiedzę o wydajności. Firmy powinny wyznaczyć bazowe poziomy tych wskaźników, ustalić cele poprawy i monitorować postępy co miesiąc lub kwartał. Nagłe zmiany sygnalizują problemy techniczne jeszcze zanim wpłyną na pozycje. Narzędzia Google Search Console, PageSpeed Insights, Lighthouse i platformy jak Semrush zapewniają kompleksowe dashboardy monitorujące te metryki w całym serwisie.

Krajobraz technicznego SEO stale się zmienia w odpowiedzi na aktualizacje algorytmów, nowe technologie i zmiany w zachowaniach użytkowników. Indeksowanie i ranking oparte na AI coraz mocniej decydują o tym, które strony trafią do indeksu i jak zostaną ocenione, przez co techniczne SEO musi wspierać semantykę i rozpoznawanie encji. Edge computing i architektury serverless umożliwiają szybsze dostarczanie treści i optymalizację w czasie rzeczywistym na brzegu sieci, co obniża opóźnienia i poprawia Core Web Vitals. Większy nacisk na sygnały E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness) wymaga, by techniczne SEO wspierało wiarygodność treści przez prawidłowe oznaczanie autora, dat publikacji i sygnały zaufania. Wielopowierzchniowa optymalizacja stanie się normą wraz z rozwojem platform AI, więc strony będą musiały dbać o widoczność na Google, Perplexity, ChatGPT, Claude i kolejnych. Analityka respektująca prywatność oraz pierwszopartyjny tracking zmienią pomiar wpływu technicznego SEO, odchodząc od ciasteczek stron trzecich na rzecz trackingu po stronie serwera i pomiarów za zgodą. Dojrzewanie frameworków JavaScript ułatwi SEO, a Next.js, Nuxt.js

Techniczne SEO koncentruje się na optymalizacji zaplecza strony internetowej—takich jak szybkość witryny, crawlability, indeksowalność i konfiguracja serwera—aby pomóc wyszukiwarkom odkrywać i przetwarzać treści. SEO on-page natomiast skupia się na optymalizacji poszczególnych elementów strony, takich jak rozmieszczenie słów kluczowych, meta tagi, nagłówki i jakość treści, aby poprawić trafność wobec zapytań użytkowników. Podczas gdy techniczne SEO zapewnia dostęp wyszukiwarkom do witryny, SEO on-page sprawia, że rozumieją one, o czym są Twoje treści i dlaczego są ważne dla użytkowników.

Core Web Vitals—Largest Contentful Paint (LCP), Interaction to Next Paint (INP) oraz Cumulative Layout Shift (CLS)—to potwierdzone czynniki rankingowe mierzące rzeczywiste doświadczenie użytkownika. Według badań DebugBear, strony internetowe muszą zapewnić 75% użytkownikom „Dobry” wynik we wszystkich trzech metrykach, aby uzyskać maksymalny wzrost pozycji. Słabe Core Web Vitals mogą skutkować spadkiem pozycji, niższymi współczynnikami kliknięć i wyższym współczynnikiem odrzuceń, bezpośrednio wpływając na widoczność organiczną i zaangażowanie użytkowników.

Crawlability decyduje o tym, czy roboty wyszukiwarek mogą uzyskać dostęp do wszystkich stron Twojej witryny i śledzić linki. Jeśli Googlebot nie może crawlowac Twoich stron z powodu zablokowanych zasobów, słabej struktury strony lub ograniczeń w pliku robots.txt, te strony nie będą mogły być zaindeksowane ani pozycjonowane. Bez odpowiedniej crawlability nawet najwyższej jakości treści pozostaną niewidoczne dla wyszukiwarek, uniemożliwiając uzyskanie widoczności organicznej bez względu na jakość treści czy profil linków.

W miarę jak platformy wyszukiwania oparte na AI, takie jak Google AI Overviews czy Perplexity, zyskują na znaczeniu, techniczne SEO pozostaje fundamentem. Systemy AI opierają się na poprawnie zaindeksowanych, dobrze ustrukturyzowanych treściach z indeksu Google do generowania odpowiedzi. Techniczne SEO zapewnia, że Twoje treści są możliwe do odkrycia, prawidłowo renderowane i semantycznie bogate, by systemy AI mogły je cytować i referować. Bez solidnych podstaw technicznych Twoje treści nie pojawią się w AI Overviews ani innych generatywnych wynikach wyszukiwania.

Dla większości stron zaleca się kompleksowy audyt technicznego SEO co kwartał oraz comiesięczny monitoring najważniejszych problemów. Większe serwisy z częstymi aktualizacjami powinny przeprowadzać audyty co miesiąc lub wdrożyć systemy ciągłego monitoringu. Po większych zmianach w witrynie, migracjach lub redesignie konieczny jest natychmiastowy audyt. Regularne audyty pozwalają wcześnie wykryć problemy zanim wpłyną one na pozycje strony, zapewniając optymalną crawlability, indeksowalność i wydajność.

Architektura strony decyduje o tym, jak wyszukiwarki poruszają się po Twojej witrynie i rozumieją hierarchię treści. Dobrze zoptymalizowana architektura sprawia, że ważne strony są dostępne w ciągu trzech kliknięć od strony głównej, skutecznie rozprowadza moc linków i pomaga wyszukiwarkom priorytetyzować crawlowanie wartościowych podstron. Zła architektura może prowadzić do stron osieroconych, marnowania budżetu crawl i trudności w budowaniu autorytetu tematycznego, co negatywnie wpływa na pozycje i widoczność.

Szybkość ładowania strony ma bezpośredni wpływ zarówno na pozycje w wyszukiwarkach, jak i zachowania użytkowników. Google potwierdziło, że Core Web Vitals—mierzące szybkość ładowania, interaktywność i stabilność wizualną—są czynnikami rankingowymi. Wolno ładujące się strony notują wyższy współczynnik odrzuceń, niższe zaangażowanie i niższe konwersje. Badania pokazują, że strony ładujące się poniżej 2,5 sekundy osiągają znacznie lepsze wyniki w retencji użytkowników i pozycjach niż wolniejsze strony, dlatego optymalizacja szybkości jest kluczowa dla sukcesu SEO.

Zacznij śledzić, jak chatboty AI wspominają Twoją markę w ChatGPT, Perplexity i innych platformach. Uzyskaj praktyczne spostrzeżenia, aby poprawić swoją obecność w AI.

Content SEO to strategiczne tworzenie i optymalizacja wysokiej jakości treści w celu poprawy pozycji w wyszukiwarkach i widoczności organicznej. Dowiedz się, ja...

JavaScript SEO optymalizuje strony renderowane przez JavaScript pod kątem indeksowania i crawlowania przez wyszukiwarki. Poznaj najlepsze praktyki, metody rende...

YouTube SEO to proces optymalizacji filmów i kanałów w celu uzyskania wyższej pozycji w wynikach wyszukiwania YouTube. Poznaj czynniki rankingowe, strategie opt...