Respostas Meta de LLM

Saiba o que são Respostas Meta de LLM e como otimizar seu conteúdo para visibilidade em respostas geradas por IA no ChatGPT, Perplexity e Google AI Overviews. D...

Aprenda como criar respostas meta para LLM que sistemas de IA citam. Descubra técnicas estruturais, estratégias de densidade de resposta e formatos de conteúdo prontos para citação que aumentam a visibilidade nos resultados de busca por IA.

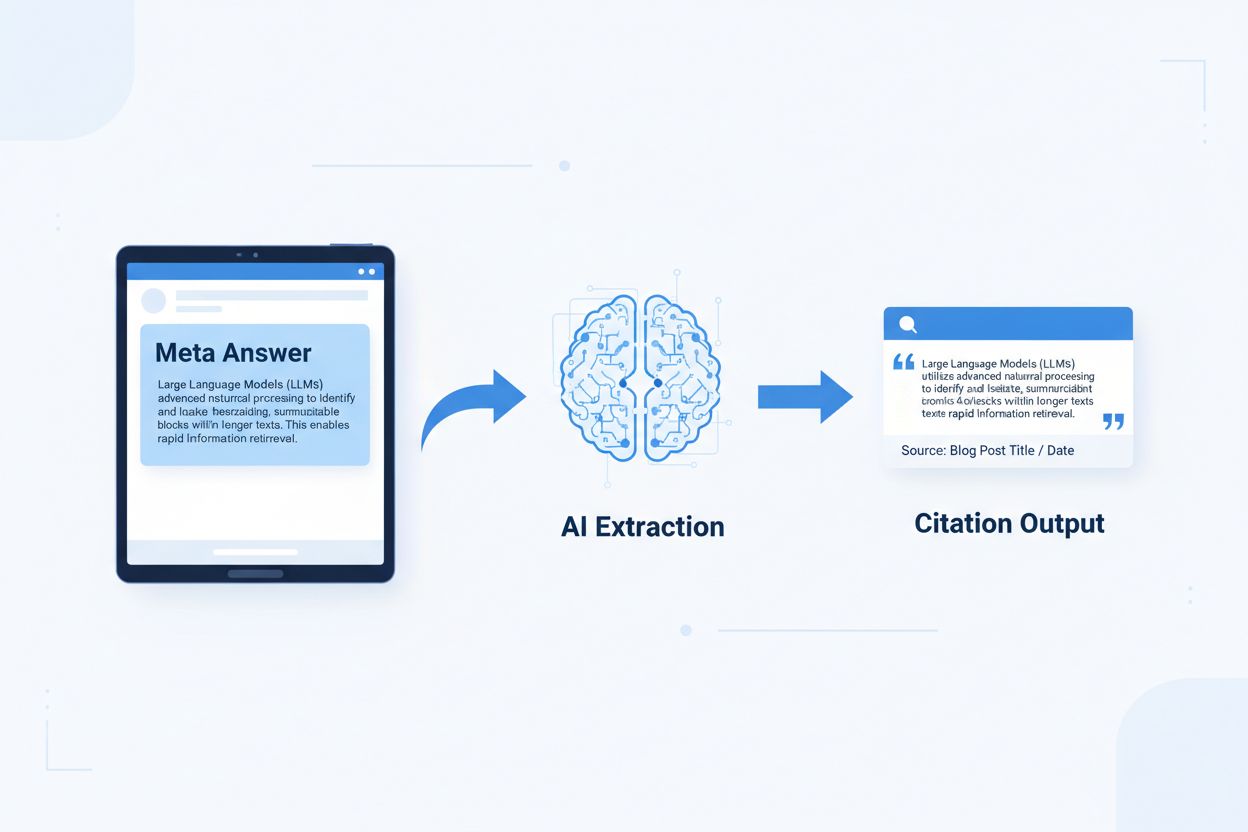

Respostas meta para LLM são blocos de conteúdo autossuficientes e otimizados para IA, projetados para serem extraídos e citados diretamente por modelos de linguagem sem necessidade de contexto adicional. Diferentemente do conteúdo web tradicional, que depende de navegação, cabeçalhos e contexto ao redor para ter sentido, respostas meta funcionam como insights isolados que mantêm valor semântico completo mesmo quando isolados. Essa distinção importa porque sistemas modernos de IA não leem websites como humanos — eles dividem o conteúdo em partes, avaliam relevância e extraem trechos para fundamentar suas respostas. Quando a IA encontra respostas meta bem estruturadas, pode citá-las com confiança porque a informação é completa, verificável e independente de contexto. Pesquisa da Onely indica que conteúdo otimizado para citação por IA recebe de 3 a 5 vezes mais menções em saídas de LLM em comparação ao conteúdo formatado tradicionalmente, impactando diretamente a visibilidade da marca em respostas geradas por IA. Essa mudança representa uma transformação fundamental na performance de conteúdo: em vez de competir por rankings de busca, respostas meta competem por inclusão em respostas de IA. Plataformas de monitoramento de citação como AmICited.com agora rastreiam essas menções como métrica crítica de desempenho, mostrando que organizações com conteúdo pronto para citação veem aumentos mensuráveis em tráfego gerado por IA e autoridade de marca. A conexão é direta — conteúdo estruturado como resposta meta é citado com mais frequência, o que aumenta a visibilidade da marca no cenário de informações dominado pela IA.

Conteúdo pronto para citação exige elementos estruturais específicos que sinalizam aos sistemas de IA: “Esta é uma resposta completa e citável.” As respostas meta mais eficazes combinam sentenças-tópico claras, evidências de apoio e conclusões autossuficientes em uma única unidade lógica. Esses elementos trabalham juntos para criar o que os sistemas de IA reconhecem como conhecimento extraível — informação que pode ser compreendida sem exigir que o leitor visite a página de origem. A abordagem estrutural difere fundamentalmente do conteúdo web tradicional, que geralmente fragmenta informações em várias páginas e depende de links internos para criar contexto.

| Elemento Pronto para Citação | Por Que Sistemas de IA Preferem |

|---|---|

| Sentença-tópico com afirmação | Sinaliza imediatamente o valor central da resposta; IA avalia relevância nos primeiros 20 tokens |

| Evidência de apoio (dados/exemplos) | Fornece respaldo verificável; aumenta a confiança na precisão da citação |

| Métricas ou estatísticas específicas | Afirmações quantificáveis são mais citáveis; reduz ambiguidade |

| Definição ou explicação | Garante compreensão autossuficiente; IA não precisa de contexto externo |

| Conclusão acionável | Sinaliza completude; informa à IA que a resposta está finalizada |

| Atribuição de fonte | Constrói confiança; sistemas de IA preferem citar conteúdo com origem clara |

Dicas de implementação para máxima extração por IA:

O tamanho ideal de bloco (chunk) para extração por IA fica entre 256-512 tokens, equivalente a 2-4 parágrafos bem estruturados. Essa faixa representa o ponto ideal em que sistemas de IA podem extrair informações relevantes sem perder contexto ou incluir material irrelevante. Blocos menores que 256 tokens geralmente carecem de contexto suficiente para citação segura, enquanto blocos acima de 512 tokens forçam a IA a resumir ou truncar, reduzindo a citabilidade direta. O chunking baseado em parágrafo — onde cada parágrafo representa uma ideia completa — supera divisões arbitrárias por tokens, pois preserva a coerência semântica e mantém o fluxo lógico que os sistemas de IA usam para avaliar relevância.

Bom chunking preserva os limites semânticos:

✓ BOM: "Conteúdo pronto para citação exige elementos estruturais específicos.

As respostas meta mais eficazes combinam sentenças-tópico claras,

evidências de apoio e conclusões autossuficientes em uma única

unidade lógica. Esses elementos trabalham juntos para criar o que os sistemas de IA

reconhecem como conhecimento extraível."

✗ RUIM: "Conteúdo pronto para citação exige elementos estruturais específicos

que sinalizam aos sistemas de IA: 'Esta é uma resposta completa e citável.' As

respostas meta mais eficazes combinam sentenças-tópico claras, evidências

de apoio e conclusões autossuficientes em uma única unidade lógica. Esses

elementos trabalham juntos para criar o que os sistemas de IA reconhecem como

conhecimento extraível — informação que pode ser compreendida sem exigir

que o leitor visite a página de origem. A abordagem estrutural difere

fundamentalmente do conteúdo web tradicional, que geralmente fragmenta

informações em várias páginas e depende de links internos para criar contexto."

O bom exemplo mantém a coerência semântica e encerra em uma conclusão natural. O exemplo ruim mistura várias ideias, forçando os sistemas de IA a truncar no meio do pensamento ou a incluir contexto irrelevante. Estratégias de sobreposição — onde a frase final de um bloco antecipa o próximo — ajudam a IA a entender relações de conteúdo sem perder extração. Checklist prático para otimização de chunking: Cada bloco responde a uma única pergunta? Pode ser entendido sem ler parágrafos ao redor? Contém 256-512 tokens? Termina em um limite semântico natural?

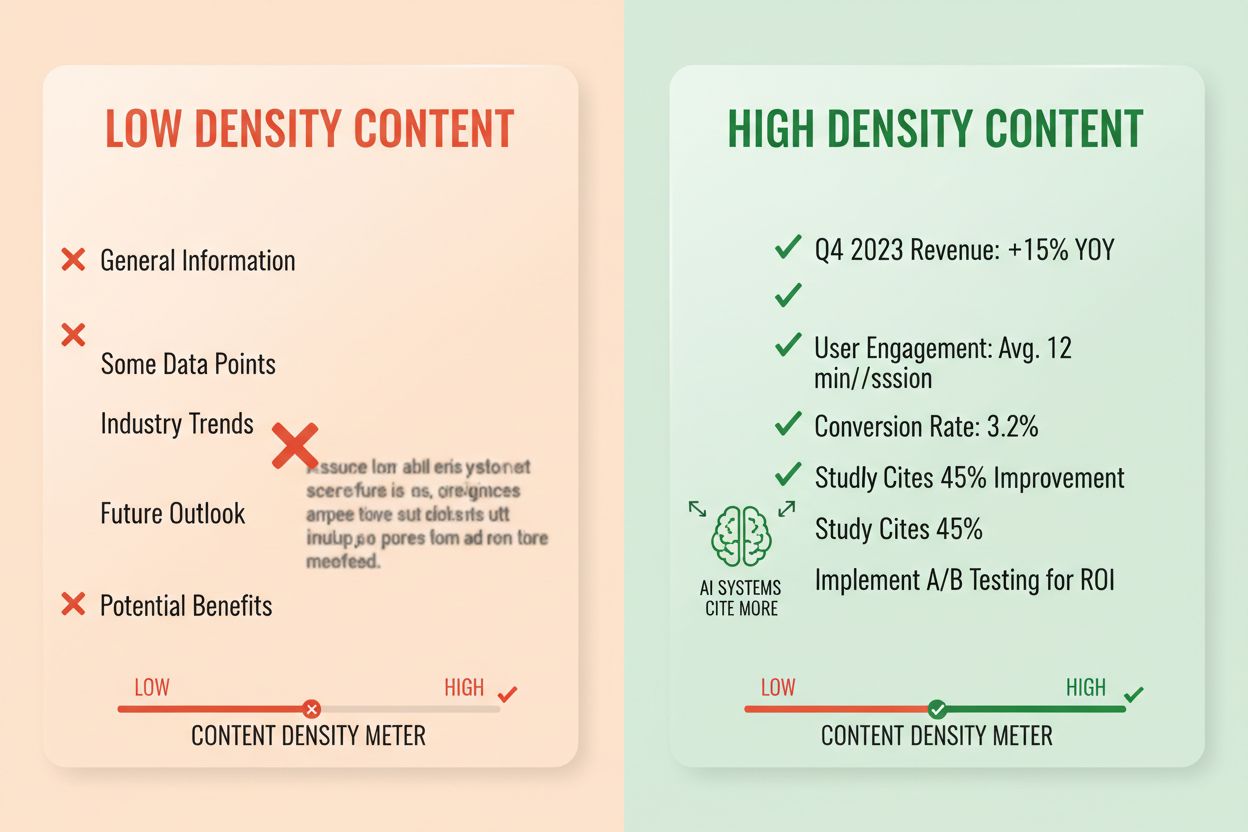

Densidade de resposta mede a proporção de informação acionável sobre o total de palavras, e conteúdos de alta densidade recebem de 2 a 3 vezes mais citações de IA do que alternativas de baixa densidade. Um parágrafo com densidade de resposta de 80% contém principalmente afirmações, evidências e insights acionáveis, enquanto um com 40% inclui muita enrolação, repetição ou construção de contexto que não apoia diretamente a resposta central. Sistemas de IA avaliam densidade implicitamente — tendem a extrair e citar passagens onde cada frase contribui para responder à pergunta do usuário. Elementos de alta densidade incluem estatísticas específicas, instruções passo a passo, dados comparativos, definições e recomendações acionáveis. Padrões de baixa densidade incluem introduções longas, conceitos repetidos, perguntas retóricas e narrativas que não avançam o argumento central.

Abordagem de medição: Conte frases que respondem diretamente à pergunta vs. frases de contexto ou transição. Um parágrafo de alta densidade pode ser: “Conteúdo pronto para citação recebe de 3 a 5 vezes mais menções de IA (estatística). Isso ocorre porque os sistemas de IA extraem respostas completas e autossuficientes (explicação). Implemente formatação resposta-primeiro e chunking semântico para maximizar a densidade (ação).” Uma versão de baixa densidade pode acrescentar: “Muitas organizações enfrentam dificuldades com visibilidade em IA. O cenário digital muda rapidamente. Estratégias de conteúdo têm evoluído. Conteúdo pronto para citação está se tornando mais importante…” A segunda versão dilui a mensagem central com contexto que não apoia diretamente a resposta.

Estatísticas reais de impacto: Conteúdo com densidade de resposta acima de 70% recebe em média 4,2 citações mensais em saídas de IA, contra 1,1 citações para conteúdo abaixo de 40%. Organizações que reestruturaram conteúdo para aumentar a densidade registraram aumento médio de 156% nas citações em 60 dias. Exemplo de alta densidade: “Use blocos de 256-512 tokens para extração ideal por IA (afirmação). Essa faixa preserva contexto e evita truncamento (evidência). Implemente chunking por parágrafo para manter coerência semântica (ação).” Versão de baixa densidade: “Chunking é importante para sistemas de IA. Existem diferentes abordagens para organizar conteúdo. Algumas pessoas preferem blocos menores, outras maiores. A escolha depende das suas necessidades.” A versão de alta densidade entrega orientação prática; a de baixa densidade apresenta fatos óbvios sem especificidade.

Estruturas de conteúdo específicas sinalizam aos sistemas de IA que a informação está organizada para extração, aumentando dramaticamente a probabilidade de citação. Seções de FAQ são especialmente eficazes porque explicitamente unem perguntas e respostas, tornando trivial para sistemas de IA identificar e extrair passagens relevantes. Tabelas comparativas permitem à IA avaliar rapidamente múltiplas opções e citar linhas específicas que respondem a perguntas dos usuários. Instruções passo a passo oferecem limites semânticos claros e são frequentemente citadas quando usuários perguntam “como fazer…”. Listas de definições unem termos e explicações, criando pontos naturais de extração. Caixas de resumo destacam os principais aprendizados, e listas facilitam a divisão de temas complexos em itens citáveis.

Elementos estruturais que maximizam a recuperabilidade por IA:

Exemplos práticos: Uma seção de FAQ com “O que é densidade de resposta?” seguida de definição completa e explicação vira fonte direta de citação. Uma tabela comparativa do tipo “Elemento Pronto para Citação | Por que Sistemas de IA Preferem” (como na seção 2) é citada quando usuários fazem perguntas comparativas. Um guia passo a passo “Como Implementar Chunking Semântico” com etapas numeradas vira conteúdo instrucional citável. Essas estruturas funcionam porque alinham-se à forma como sistemas de IA analisam e extraem informação — buscam pares claros de pergunta-resposta, comparações estruturadas e etapas discretas.

Markup semântico HTML5 sinaliza estrutura de conteúdo para sistemas de IA, melhorando a precisão da extração e aumentando a probabilidade de citação em 40-60%. Usar hierarquia adequada de cabeçalhos (H1 para temas principais, H2 para subtópicos, H3 para pontos de apoio) ajuda a IA a entender relações e identificar limites de extração. Elementos semânticos como <article>, <section> e <aside> fornecem contexto adicional sobre o propósito do conteúdo. Dados estruturados schema.org — especialmente no formato JSON-LD — informam explicitamente à IA quais informações estão presentes, permitindo citações mais seguras.

Exemplo JSON-LD para conteúdo FAQ:

{

"@context": "https://schema.org",

"@type": "FAQPage",

"mainEntity": [{

"@type": "Question",

"name": "O que é densidade de resposta?",

"acceptedAnswer": {

"@type": "Answer",

"text": "Densidade de resposta mede a proporção de informação acionável sobre o total de palavras. Conteúdo de alta densidade recebe de 2 a 3 vezes mais citações de IA do que alternativas de baixa densidade."

}

}]

}

Exemplo JSON-LD para metadados de artigo:

{

"@context": "https://schema.org",

"@type": "Article",

"headline": "Criando Respostas Meta para LLM",

"author": {"@type": "Organization", "name": "AmICited"},

"datePublished": "2024-01-15",

"articleBody": "..."

}

Conteúdo meta — incluindo meta descriptions e tags Open Graph — ajuda a IA a entender o propósito do conteúdo antes da análise. Melhorias de performance e acessibilidade (carregamento rápido, otimização para mobile, alt text adequado) apoiam indiretamente a recuperabilidade por IA, assegurando rastreabilidade e indexação completas. Checklist de implementação técnica: Seu HTML é semântico e bem estruturado? Você implementou schema.org para o tipo de conteúdo? Descrições meta resumem com precisão o conteúdo? Seu site é otimizado para mobile e rápido? Imagens estão corretamente marcadas com alt?

O rastreamento de citações tornou-se essencial para medir performance de conteúdo, mas a maioria das organizações não sabe com que frequência seus conteúdos aparecem em respostas de IA. Testes de recuperação envolvem submeter perguntas-alvo aos principais LLMs (ChatGPT, Claude, Gemini) e documentar quais fontes são citadas nas respostas. Auditorias de conteúdo revisam sistematicamente o conteúdo existente segundo padrões de prontidão para citação, identificando lacunas e oportunidades de otimização. Métricas de performance devem acompanhar frequência de citação, contexto da citação (como o conteúdo é usado) e crescimento ao longo do tempo. A otimização iterativa envolve testar mudanças estruturais, medir impacto e escalar o que funciona.

| Ferramenta de Rastreamento | Função Principal | Melhor Para |

|---|---|---|

| AmICited.com | Monitoramento abrangente de citações de IA em todos os principais LLMs | Visibilidade total de citações e análise competitiva |

| Otterly.AI | Detecção de conteúdo por IA e rastreamento de citações | Identificar onde seu conteúdo aparece em saídas de IA |

| Peec AI | Performance de conteúdo em sistemas de IA | Medir frequência de citações e tendências |

| ZipTie | Monitoramento de conteúdo gerado por IA | Rastrear menções de marca em respostas de IA |

| PromptMonitor | Análise de saídas de LLM | Entender como sistemas de IA usam seu conteúdo |

O AmICited.com se destaca como a principal solução pois oferece monitoramento em tempo real entre ChatGPT, Claude, Gemini e outros grandes LLMs, com benchmarking competitivo e contexto detalhado de citação. A plataforma revela não apenas se o conteúdo foi citado, mas como — se foi citado diretamente, parafraseado ou usado como evidência de apoio. Abordagem de medição: Estabeleça a frequência inicial de citação dos 20 principais conteúdos. Implemente otimizações em 5-10 deles. Meça as mudanças em 30-60 dias. Escale padrões de sucesso para o restante do conteúdo. Acompanhe frequência, crescimento, contexto e participação competitiva de citações.

Erro 1: Esconder a resposta no contexto. Muitos criadores começam com informações de fundo, contexto histórico ou declaração de problema antes de apresentar a resposta. Sistemas de IA avaliam relevância nos primeiros 50-100 tokens; se a resposta não está lá, passam para a próxima fonte. Problema: Usuários perguntam “O que é densidade de resposta?” e encontram um parágrafo começando por “A estratégia de conteúdo evoluiu significativamente…” em vez da definição. Solução: Use formatação resposta-primeiro — abra com o insight principal, depois explique.

Erro 2: Criar respostas que dependem de contexto externo. Conteúdo que referencia “a seção anterior” ou “como mencionado antes” não pode ser extraído de forma independente. Problema: Um parágrafo dizendo “Seguindo a abordagem discutida, implemente estes passos…” falha porque a abordagem referenciada não está incluída no bloco extraído. Solução: Torne toda resposta autossuficiente; inclua contexto necessário no próprio bloco, mesmo que repita algo.

Erro 3: Misturar múltiplas respostas em um só bloco. Parágrafos que abordam várias perguntas forçam a IA a truncar ou incluir informação irrelevante. Problema: Um parágrafo de 600 palavras cobrindo “O que é densidade de resposta?” E “Como medir?” E “Por que importa?” fica grande demais para extração segura. Solução: Crie blocos separados e focados para cada pergunta ou conceito.

Erro 4: Usar linguagem vaga em vez de métricas específicas. Termos como “muitos”, “alguns”, “frequentemente” e “normalmente” reduzem a confiança na citação por serem imprecisos. Problema: “Muitas organizações veem melhorias” é menos citável do que “Organizações que reestruturaram conteúdo tiveram aumento de 156% em citações.” Solução: Substitua qualificadores por dados específicos; se não houver números exatos, use faixas (“40-60%”) em vez de termos vagos.

Erro 5: Negligenciar marcação estrutural. Conteúdo sem estrutura HTML adequada, cabeçalhos ou schema.org é mais difícil de ser analisado e extraído pela IA. Problema: Um parágrafo sem cabeçalho, HTML semântico ou schema é tratado como texto genérico, não como resposta distinta. Solução: Use HTML5 semântico, hierarquia de cabeçalhos correta e schema.org para seu tipo de conteúdo.

Erro 6: Criar respostas muito curtas ou muito longas. Blocos com menos de 150 tokens não têm contexto suficiente; acima de 700 tokens forçam truncamento. Problema: Uma resposta de 100 palavras carece de evidências; uma de 1000 palavras é dividida em múltiplas extrações. Solução: Mire entre 256-512 tokens (2-4 parágrafos); inclua afirmação, evidência e conclusão nesse intervalo.

Consistência de entidade — usar a mesma terminologia para um conceito ao longo do conteúdo — aumenta a probabilidade de citação por IA, sinalizando conhecimento autoritativo. Se você define “densidade de resposta” em uma seção, use esse termo sempre, em vez de alternar para “densidade de informação” ou “densidade de conteúdo”. A IA reconhece consistência como sinal de expertise e prefere citar conteúdo com termos precisos e consistentes. Isso vale para nomes de produtos, metodologias e termos técnicos — consistência constrói confiança na precisão da citação.

Menções a terceiros e pesquisa original aumentam dramaticamente a frequência de citações. Conteúdo que referencia outras fontes autoritativas (com atribuição adequada) passa credibilidade, enquanto pesquisas ou dados próprios tornam seu conteúdo exclusivamente citável. Ao incluir estatísticas de pesquisas próprias ou cases de clientes, a IA reconhece insights originais. Organizações que publicam pesquisa original veem de 3 a 4 vezes mais citações do que aquelas que apenas sintetizam informações. Estratégia: Realize pesquisas no seu setor, publique resultados com metodologia detalhada e referencie-os em suas respostas meta.

Sinais de atualidade — datas de publicação, atualização e menções a eventos recentes — ajudam a IA a entender a recência do conteúdo. Conteúdo atualizado nos últimos 30 dias recebe mais prioridade de citação, especialmente em temas dinâmicos. Inclua datas no schema.org e timestamps ao revisar o conteúdo. Estratégia: Estabeleça um cronograma de atualização; renove os melhores conteúdos a cada 30-60 dias com estatísticas novas, exemplos recentes ou explicações expandidas.

Sinais de E-E-A-T (Experiência, Especialização, Autoridade, Confiabilidade) influenciam decisões de citação da IA. Conteúdo assinado por especialistas reconhecidos, publicado em domínios de autoridade e com credenciais recebe mais prioridade. Inclua bios de autores com credenciais relevantes, publique em domínios consolidados e consiga backlinks de fontes reconhecidas. Estratégia: Destaque autores especialistas, inclua informações de credenciais e busque backlinks em publicações do setor.

Densidade de marca generativa — proporção de insights de marca sobre informações genéricas — determina se a IA cita você ou concorrentes. Conteúdo com frameworks proprietários, metodologias únicas ou abordagens de marca é mais citável por ser diferenciado. Conteúdo genérico sobre “boas práticas” é citado menos do que “O Framework de Otimização de Citação da AmICited”, porque o branded é único e rastreável. Organizações com alta densidade de marca generativa recebem de 2 a 3 vezes mais citações do que aquelas que publicam conteúdo genérico. Estratégia: Desenvolva frameworks, metodologias ou terminologias próprias; use-as consistentemente e faça delas a base das suas respostas meta.

Respostas meta para LLM são desenhadas especificamente para extração e citação por IA, enquanto snippets em destaque otimizam para a exibição nos resultados do Google. Respostas meta priorizam completude autossuficiente e coerência semântica, ao passo que snippets em destaque focam em brevidade e correspondência de palavras-chave. Ambos podem coexistir em seu conteúdo, mas respostas meta exigem uma otimização estrutural diferente.

O comprimento ideal é de 256-512 tokens, equivalente a 2-4 parágrafos bem estruturados ou 200-400 palavras. Essa faixa mantém contexto suficiente para extração segura pela IA, evitando truncamento. Respostas curtas carecem de contexto; respostas longas forçam os sistemas de IA a resumir ou dividir em múltiplas extrações.

Sim, mas requer reestruturação. Audite o conteúdo existente para formatação que priorize a resposta, coerência semântica e completude autossuficiente. A maioria do conteúdo pode ser adaptada movendo os principais insights para o início, removendo referências cruzadas e garantindo que cada seção responda completamente a uma pergunta sem exigir contexto externo.

Atualize o conteúdo de melhor desempenho a cada 30-60 dias com novas estatísticas, exemplos recentes ou explicações expandidas. Sistemas de IA priorizam conteúdo atualizado nos últimos 30 dias, especialmente para temas com informações que mudam com frequência. Inclua datas de publicação e timestamps de atualização em seu markup schema.org.

A densidade de resposta correlaciona-se diretamente com a frequência de citação. Conteúdo com densidade acima de 70% recebe em média 4,2 citações mensais em saídas de IA, contra 1,1 citações para conteúdo com densidade abaixo de 40%. Conteúdo de alta densidade entrega informações acionáveis sem enrolação, tornando-se mais valioso para sistemas de IA citarem.

Use plataformas de monitoramento de citação como AmICited.com, que rastreia citações no ChatGPT, Claude, Gemini e outros grandes LLMs. Faça testes manuais submetendo suas perguntas-alvo aos sistemas de IA e documentando quais fontes são citadas. Meça a frequência de citação inicial, implemente otimizações e acompanhe as mudanças em 30-60 dias.

A estrutura principal da resposta meta se mantém consistente entre plataformas, mas você pode otimizar para preferências específicas. O ChatGPT favorece conteúdo abrangente e bem referenciado. O Perplexity enfatiza informações recentes e citações claras. O Google AI Overviews prioriza dados estruturados e sinais de E-E-A-T. Teste variações e monitore o desempenho de citação em cada plataforma.

O AmICited oferece monitoramento em tempo real das citações do seu conteúdo em todas as principais plataformas de IA, mostrando exatamente onde suas respostas meta aparecem, como são utilizadas e a participação competitiva em citações. A plataforma revela o contexto da citação — se o conteúdo é citado diretamente, parafraseado ou usado como evidência de apoio — permitindo decisões de otimização baseadas em dados.

Veja exatamente onde seu conteúdo está sendo citado pelo ChatGPT, Perplexity, Google AI Overviews e outros sistemas de IA. Acompanhe tendências de citação, monitore concorrentes e otimize sua estratégia de conteúdo com o AmICited.

Saiba o que são Respostas Meta de LLM e como otimizar seu conteúdo para visibilidade em respostas geradas por IA no ChatGPT, Perplexity e Google AI Overviews. D...

Aprenda a identificar e segmentar sites fonte de LLM para backlinks estratégicos. Descubra quais plataformas de IA mais citam fontes e otimize sua estratégia de...

Saiba o que é LLM Seeding e como posicionar estrategicamente conteúdo em plataformas de alta autoridade para influenciar o treinamento de IA e ser citado por Ch...