Listicles e IA: Por Que Listas Numeradas São Citadas

Descubra por que modelos de IA preferem listicles e listas numeradas. Aprenda como otimizar conteúdo baseado em listas para citações do ChatGPT, Gemini e Perple...

Aprenda como otimizar a hierarquia de títulos para análise por LLMs. Domine a estrutura H1, H2, H3 para melhorar a visibilidade na IA, citações e descoberta de conteúdo em ChatGPT, Perplexity e Google AI Overviews.

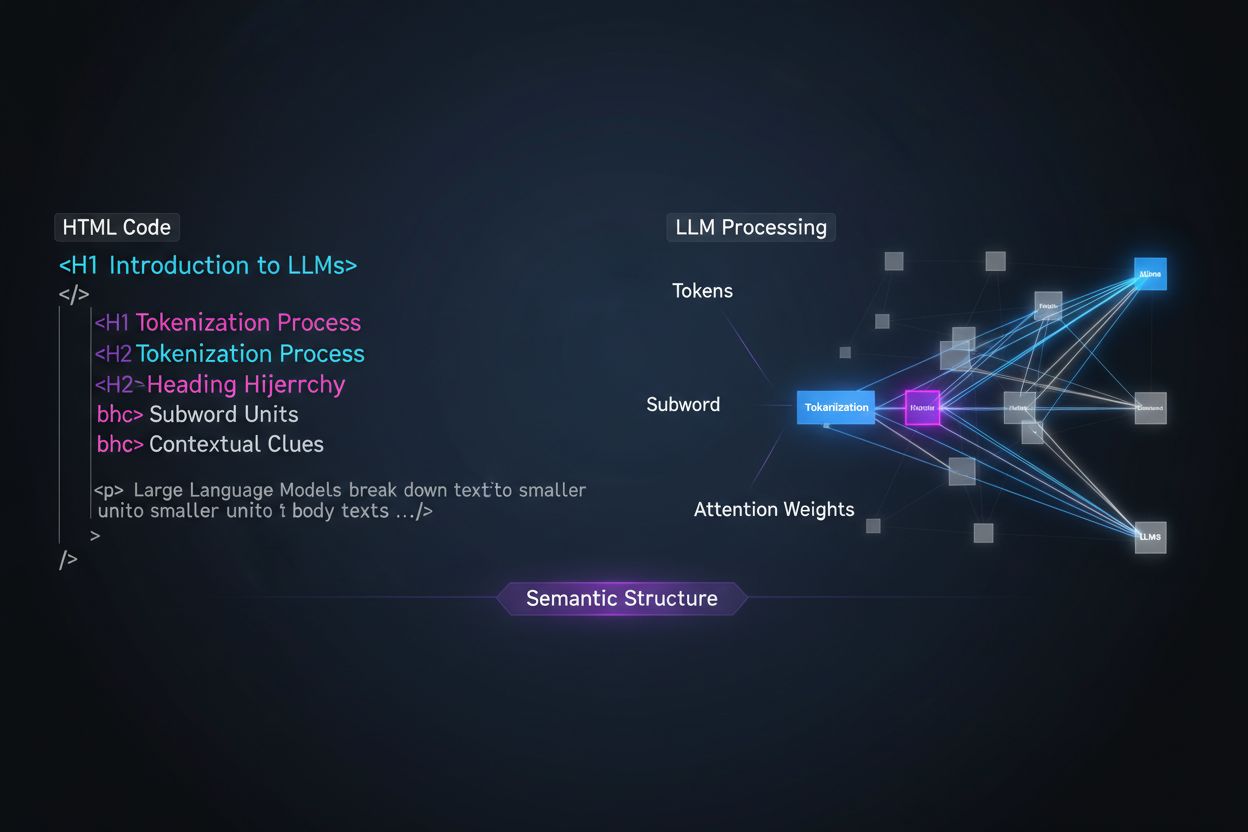

Grandes Modelos de Linguagem processam conteúdo de forma fundamentalmente diferente dos leitores humanos, e entender essa distinção é crucial para otimizar sua estratégia de conteúdo. Enquanto humanos escaneiam páginas visualmente e compreendem intuitivamente a estrutura do documento, LLMs dependem de tokenização e mecanismos de atenção para extrair significado de texto sequencial. Ao encontrar seu conteúdo, um LLM o divide em tokens (pequenas unidades de texto) e atribui pesos de atenção a diferentes seções com base em sinais estruturais—e a hierarquia de títulos é um dos sinais estruturais mais poderosos disponíveis. Sem uma organização clara de títulos, LLMs têm dificuldade para identificar os tópicos principais, argumentos de apoio e relações contextuais em seu conteúdo, levando a respostas menos precisas e menor visibilidade em sistemas de busca e recuperação baseados em IA.

Estratégias modernas de chunking de conteúdo em sistemas de geração com recuperação aumentada (RAG) e buscadores de IA dependem fortemente da estrutura de títulos para decidir onde dividir documentos em segmentos recuperáveis. Quando um LLM encontra hierarquias de títulos bem organizadas, ele usa os limites de H2 e H3 como linhas de corte naturais para criar chunks semânticos—unidades discretas de informação que podem ser recuperadas e citadas independentemente. Esse processo é muito mais eficaz do que divisões arbitrárias por número de caracteres porque chunks baseados em títulos preservam a coerência semântica e o contexto. Considere a diferença entre duas abordagens:

| Abordagem | Qualidade do Chunk | Taxa de Citação do LLM | Precisão na Recuperação |

|---|---|---|---|

| Rica em Semântica (Baseada em Títulos) | Alta coerência, ideias completas | 3x maior | 85%+ de precisão |

| Genérica (Por Contagem de Caracteres) | Fragmentada, contexto incompleto | Padrão | 45-60% de precisão |

Pesquisas mostram que documentos com hierarquias de títulos claras têm melhora de 18-27% na precisão de respostas quando processados por LLMs, principalmente porque o chunking preserva as relações lógicas entre ideias. Sistemas como pipelines de Geração com Recuperação Aumentada (RAG), que alimentam ferramentas como o recurso de navegação do ChatGPT e sistemas corporativos de IA, buscam explicitamente estruturas de títulos para otimizar seus sistemas de recuperação e melhorar a precisão das citações.

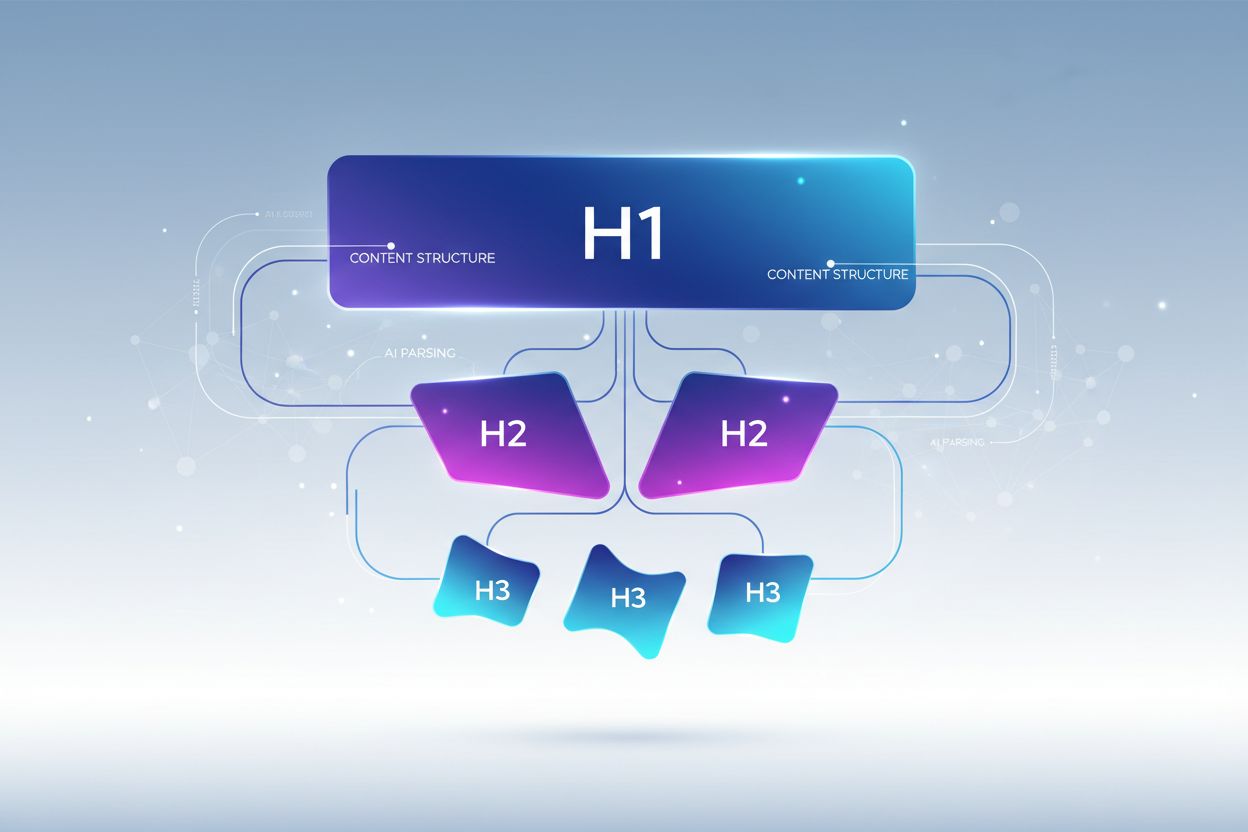

A hierarquia de títulos adequada segue uma estrutura de aninhamento rigorosa que reflete como os LLMs esperam que a informação seja organizada, com cada nível servindo a um propósito distinto na arquitetura do seu conteúdo. A tag H1 representa o tópico principal do documento—deve haver apenas uma por página, e ela deve deixar claro o assunto central. Tags H2 representam grandes divisões temáticas que sustentam ou expandem o H1, cada uma tratando de um aspecto distinto do tema principal. Tags H3 aprofundam subtemas específicos dentro de cada seção H2, trazendo detalhes granulares e respondendo a perguntas secundárias. A regra crítica para otimização em LLM é nunca pular níveis (por exemplo, do H1 direto para H3) e manter o aninhamento consistente—cada H3 deve pertencer a um H2, e cada H2 a um H1. Essa estrutura hierárquica cria o que pesquisadores chamam de “árvore semântica” que LLMs percorrem para entender o fluxo lógico do seu conteúdo e extrair informações relevantes com precisão.

A estratégia de títulos mais eficaz para visibilidade em LLM trata cada título H2 como uma resposta direta a uma intenção ou pergunta específica do usuário, com títulos H3 mapeando para subperguntas que fornecem detalhes de apoio. Essa abordagem “resposta em primeiro lugar” está alinhada com a forma como os LLMs modernos recuperam e sintetizam informações—eles buscam conteúdo que responda diretamente às perguntas do usuário, e títulos que já expressem respostas têm muito mais chance de serem selecionados e citados. Cada H2 deve funcionar como uma unidade de resposta, uma resposta completa a uma pergunta distinta que um usuário possa fazer sobre seu tema. Por exemplo, se seu H1 é “Como Otimizar o Desempenho do Site,” seus H2 podem ser “Reduza o Tamanho das Imagens (Melhora o Tempo de Carregamento em 40%)” ou “Implemente Cache de Navegador (Diminui as Requisições ao Servidor em 60%)"—cada título responde diretamente a uma dúvida de desempenho específica. Os H3 sob cada H2 então abordam subperguntas: sob “Reduza o Tamanho das Imagens”, você pode ter H3 como “Escolha o Formato de Imagem Correto”, “Comprimir Sem Perda de Qualidade” e “Implemente Imagens Responsivas”. Essa estrutura facilita dramaticamente a identificação, extração e citação do seu conteúdo pelos LLMs porque os próprios títulos já contêm as respostas, e não apenas rótulos de tópicos.

Transformar sua estratégia de títulos para maximizar visibilidade em LLM exige a implementação de técnicas específicas e acionáveis que vão além do básico. Veja os métodos de otimização mais eficazes:

Use Títulos Descritivos e Específicos: Substitua títulos vagos como “Visão Geral” ou “Detalhes” por descrições específicas como “Como Aprendizado de Máquina Melhora a Precisão de Recomendações” ou “Três Fatores que Impactam o Ranqueamento de Busca”. Pesquisas mostram que títulos específicos aumentam em até 3x as taxas de citação por LLM em relação a títulos genéricos.

Implemente Títulos em Forma de Pergunta: Estruture H2 como perguntas diretas que os usuários fazem (“O Que É Busca Semântica?” ou “Por Que a Hierarquia de Títulos Importa?”). LLMs são treinados com dados de perguntas e respostas e priorizam naturalmente títulos em forma de pergunta ao recuperar respostas.

Inclua Clareza de Entidade nos Títulos: Ao tratar de conceitos, ferramentas ou entidades específicas, nomeie-os explicitamente nos títulos, em vez de usar pronomes ou referências vagas. Por exemplo, “Otimização de Desempenho do PostgreSQL” é muito mais amigável para LLM do que “Otimização de Banco de Dados”.

Evite Combinar Múltiplas Intenções: Cada título deve abordar um único tópico. Títulos como “Instalação, Configuração e Solução de Problemas” diluem a clareza semântica e confundem algoritmos de chunking dos LLMs.

Adicione Contexto Quantificável: Quando relevante, inclua números, percentuais ou prazos nos títulos (“Reduza o Tempo de Carregamento em 40% com Otimização de Imagens” vs. “Otimização de Imagens”). Estudos mostram que 80% dos conteúdos citados por LLM incluem contexto quantificável nos títulos.

Use Estrutura Paralela Entre Níveis: Mantenha a estrutura gramatical consistente entre H2 e H3 na mesma seção. Se um H2 começa com verbo (“Implemente Cache”), os outros também devem (“Configure Índices no Banco de Dados”, “Otimize Consultas”).

Inclua Palavras-chave de Forma Natural: Apesar de não ser apenas para SEO, incluir palavras-chave relevantes nos títulos ajuda LLMs a entender a relevância do tema e melhora a precisão na recuperação em 25-35%.

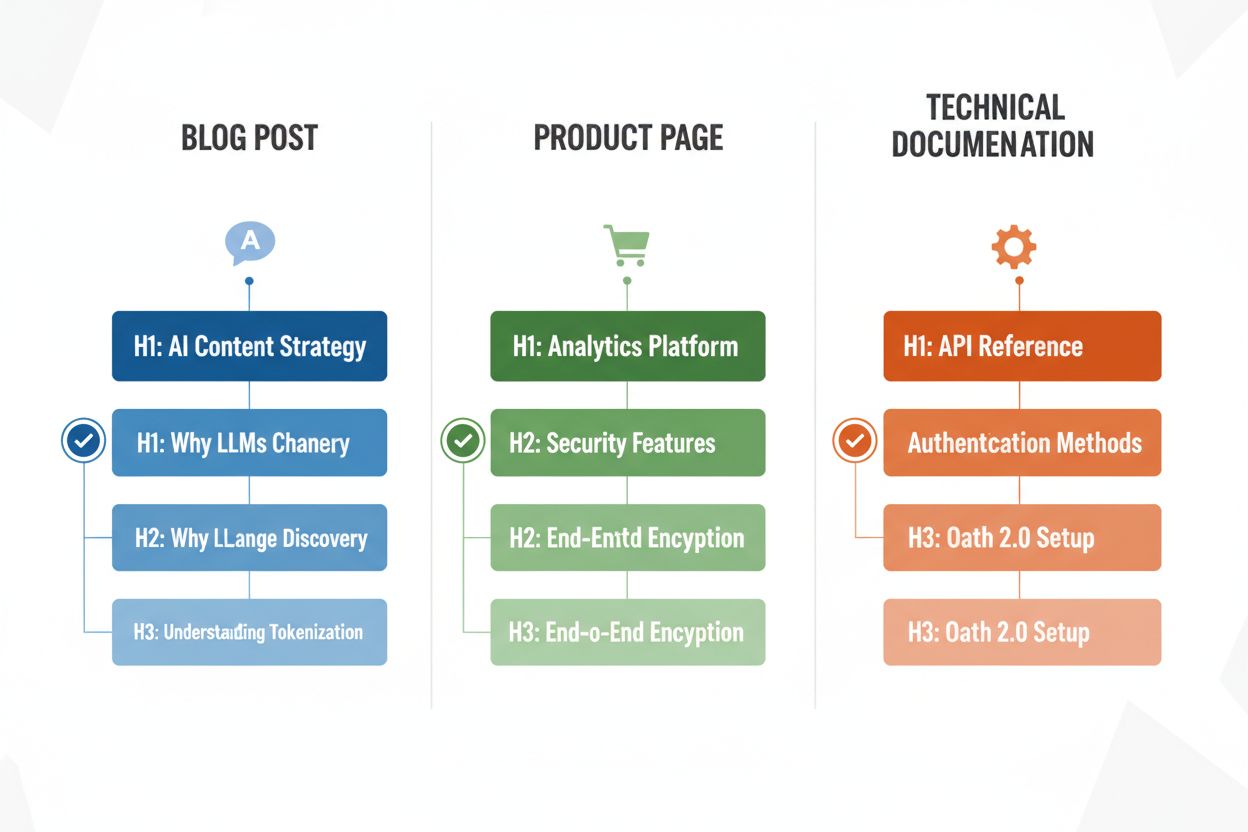

Diferentes tipos de conteúdo exigem estratégias de títulos adaptadas para maximizar a eficiência da análise por LLM, e entender esses padrões garante a otimização independentemente do formato. Posts de blog se beneficiam de hierarquias de títulos orientadas por narrativa, em que H2 seguem um progresso lógico de argumento ou explicação, com H3 trazendo evidências, exemplos ou aprofundamentos—por exemplo, um post sobre “Estratégia de Conteúdo para IA” pode usar H2 como “Por Que LLMs Estão Mudando a Descoberta de Conteúdo”, “Como Otimizar para Visibilidade em IA” e “Medindo o Desempenho do Seu Conteúdo em IA.” Páginas de produto devem usar H2 que correspondem diretamente a dúvidas e fatores de decisão do usuário (“Segurança e Conformidade”, “Capacidades de Integração”, “Preços e Escalabilidade”), com H3 abordando perguntas sobre recursos específicos ou casos de uso. Documentação técnica exige a estrutura de títulos mais granular, com H2 representando grandes funcionalidades ou fluxos de trabalho e H3 detalhando tarefas, parâmetros ou opções de configuração—essa estrutura é crítica, pois documentações são frequentemente citadas por LLMs em perguntas técnicas. Páginas de FAQ devem usar H2 como as próprias perguntas (formatadas como perguntas reais) e H3 para esclarecimentos ou tópicos relacionados, pois essa estrutura se encaixa perfeitamente na forma como LLMs recuperam e apresentam conteúdo de perguntas e respostas. Cada tipo de conteúdo tem intenções de usuário diferentes, e sua hierarquia de títulos deve refletir essas intenções para maximizar a relevância e a chance de citação.

Após reestruturar seus títulos, a validação é essencial para garantir que realmente estão melhorando a análise e visibilidade nos LLMs. A abordagem mais prática é testar seu conteúdo diretamente com ferramentas de IA como ChatGPT, Perplexity ou Claude, enviando seu documento ou fornecendo uma URL e fazendo perguntas que seus títulos foram feitos para responder. Observe se a ferramenta de IA identifica e cita corretamente seu conteúdo, e se extrai as seções certas—se seu H2 “Reduzindo o Tempo de Carregamento” não estiver sendo citado quando usuários perguntam sobre otimização de desempenho, talvez o título precise de ajustes. Você também pode usar ferramentas especializadas como plataformas de SEO com rastreamento de citações por IA (como Semrush ou os recursos de IA mais recentes do Ahrefs) para monitorar com que frequência seu conteúdo aparece em respostas de LLM ao longo do tempo. Itere com base nos resultados: se certas seções não estão sendo citadas, experimente títulos mais específicos ou em forma de pergunta, adicione contexto quantificável ou esclareça a ligação entre o título e dúvidas comuns dos usuários. Esse ciclo de testes normalmente leva de 2 a 4 semanas para mostrar resultados mensuráveis, pois leva tempo para sistemas de IA reindexarem e reavaliarem seu conteúdo.

Mesmo criadores de conteúdo bem-intencionados cometem erros de títulos que reduzem significativamente a visibilidade e precisão da análise por LLM. Um dos erros mais comuns é combinar múltiplas intenções em um único título—por exemplo, “Instalação, Configuração e Solução de Problemas” força LLMs a escolher qual tópico a seção aborda, frequentemente levando a chunking incorreto e menor chance de citação. Títulos vagos e genéricos como “Visão Geral”, “Pontos Principais” ou “Informações Adicionais” não oferecem clareza semântica e tornam impossível para LLMs entenderem o conteúdo específico da seção; quando se deparam com esses títulos, muitas vezes os LLMs pulam a seção ou interpretam mal sua relevância. Falta de contexto é outro erro crítico—um título como “Boas Práticas” não informa em que domínio ou tópico as práticas se aplicam, enquanto “Boas Práticas para Limitação de Taxa em API” é imediatamente claro e recuperável. Hierarquia inconsistente (pular níveis, usar H4 sem H3, ou misturar estilos de título) confunde os algoritmos de LLM porque eles dependem de padrões estruturais consistentes para entender a organização do documento. Por exemplo, um documento que usa H1 → H3 → H2 → H4 cria ambiguidade sobre quais seções são relacionadas e quais são independentes, o que degrada a precisão na recuperação em 30-40%. Testar seu conteúdo no ChatGPT ou ferramentas similares revela rapidamente esses erros—se a IA tem dificuldade para entender sua estrutura ou cita seções erradas, seus títulos provavelmente precisam de revisão.

A otimização da hierarquia de títulos para análise por LLM traz um benefício secundário poderoso: melhora a acessibilidade para usuários humanos com deficiência. A estrutura de títulos em HTML semântico (uso correto das tags H1-H6) é fundamental para o funcionamento de leitores de tela, permitindo que usuários com deficiência visual naveguem nos documentos de forma eficiente e entendam a organização do conteúdo. Ao criar títulos claros e descritivos otimizados para LLMs, você simultaneamente melhora a navegação para leitores de tela—a mesma especificidade e clareza que ajuda os LLMs a entenderem seu conteúdo ajuda tecnologias assistivas a guiarem os usuários. Esse alinhamento entre otimização para IA e acessibilidade representa um raro ganha-ganha: os requisitos técnicos para conteúdo amigável a LLMs apoiam diretamente os padrões de acessibilidade WCAG e melhoram a experiência para todos. Organizações que priorizam a hierarquia de títulos para visibilidade em IA frequentemente veem melhorias inesperadas em índices de conformidade de acessibilidade e métricas de satisfação de usuários que dependem de tecnologias assistivas.

Implementar melhorias na hierarquia de títulos exige mensuração para justificar o esforço e identificar o que está funcionando. O KPI mais direto é a taxa de citação por LLM—acompanhe com que frequência seu conteúdo aparece em respostas do ChatGPT, Perplexity, Claude e outras ferramentas de IA, fazendo perguntas relevantes regularmente e registrando quais fontes são citadas. Ferramentas como Semrush, Ahrefs e plataformas mais recentes como Originality.AI já oferecem recursos de rastreamento de citações por LLM que monitoram sua visibilidade em respostas geradas por IA ao longo do tempo. Você deve esperar um aumento de 2-3x em citações dentro de 4-8 semanas após implementar uma hierarquia de títulos adequada, embora os resultados variem conforme o tipo de conteúdo e nível de concorrência. Além das citações, acompanhe tráfego orgânico de recursos de busca com IA (Google AI Overviews, citações do Bing Chat, etc.) separadamente do tráfego orgânico tradicional, pois esses costumam mostrar melhorias mais rápidas com a otimização dos títulos. Monitore também métricas de engajamento como tempo na página e profundidade de rolagem para páginas com títulos otimizados—uma estrutura melhor normalmente aumenta o engajamento em 15-25% porque os usuários encontram mais facilmente informações relevantes. Por fim, meça a precisão de recuperação em seus próprios sistemas se usar pipelines RAG ou ferramentas internas de IA, testando se as seções corretas estão sendo recuperadas para dúvidas comuns. Esses indicadores demonstram o ROI da otimização de títulos e orientam o aprimoramento contínuo da sua estratégia de conteúdo.

A hierarquia de títulos impacta principalmente a visibilidade em IA e citações por LLM em vez dos rankings tradicionais do Google. Contudo, uma estrutura correta de títulos melhora a qualidade geral do conteúdo e a legibilidade, o que indiretamente apoia o SEO. O principal benefício é o aumento da visibilidade em resultados de busca com IA, como o Google AI Overviews, ChatGPT e Perplexity, onde a estrutura de títulos é fundamental para extração e citação de conteúdo.

Sim, se seus títulos atuais são vagos ou não seguem uma hierarquia clara H1→H2→H3. Comece auditando suas páginas com melhor desempenho e implemente melhorias nos títulos primeiro nos conteúdos de maior tráfego. A boa notícia é que títulos amigáveis para LLM também são mais amigáveis para usuários, então as mudanças beneficiam tanto humanos quanto sistemas de IA.

Com certeza. Na verdade, as melhores estruturas de títulos funcionam bem para ambos. Títulos claros, descritivos e hierárquicos que ajudam humanos a entender a organização do conteúdo são exatamente o que os LLMs precisam para analisar e dividir o texto. Não há conflito entre práticas de títulos amigáveis para humanos e para LLM.

Não há um limite rígido, mas busque de 3 a 7 H2 por página, dependendo do tamanho e complexidade do conteúdo. Cada H2 deve representar um tópico distinto ou unidade de resposta. Sob cada H2, inclua de 2 a 4 H3 para detalhes de apoio. Páginas com 12-15 seções de títulos no total (H2 e H3 somados) tendem a ter bom desempenho em citações por LLM.

Sim, mesmo conteúdos curtos se beneficiam de uma estrutura adequada de títulos. Um artigo de 500 palavras pode ter apenas 1-2 H2, mas eles ainda devem ser descritivos e específicos. Conteúdos curtos com títulos claros têm mais chance de serem citados em respostas de LLM do que conteúdos curtos e desestruturados.

Teste seu conteúdo diretamente com ChatGPT, Perplexity ou Claude, fazendo perguntas que seus títulos foram pensados para responder. Se a IA identificar corretamente e citar seu conteúdo, sua estrutura está funcionando. Se tiver dificuldades ou citar seções erradas, seus títulos precisam de ajustes. A maioria das melhorias mostra resultados em 2-4 semanas.

O Google AI Overviews e o ChatGPT ambos se beneficiam de uma hierarquia clara de títulos, mas o ChatGPT dá ainda mais ênfase nisso. O ChatGPT cita conteúdos com estrutura sequencial de títulos 3x mais do que conteúdos sem ela. Os princípios centrais são os mesmos, mas LLMs como o ChatGPT são mais sensíveis à qualidade e estrutura dos títulos.

Títulos em formato de pergunta funcionam melhor para páginas de FAQ, guias de resolução de problemas e conteúdos educativos. Para posts de blog e páginas de produto, uma combinação de títulos em forma de pergunta e afirmação costuma funcionar melhor. O importante é que os títulos deixem claro o que cada seção aborda, seja como pergunta ou afirmação.

Acompanhe com que frequência seu conteúdo é citado no ChatGPT, Perplexity, Google AI Overviews e outros LLMs. Obtenha insights em tempo real sobre seu desempenho em buscas por IA e otimize sua estratégia de conteúdo.

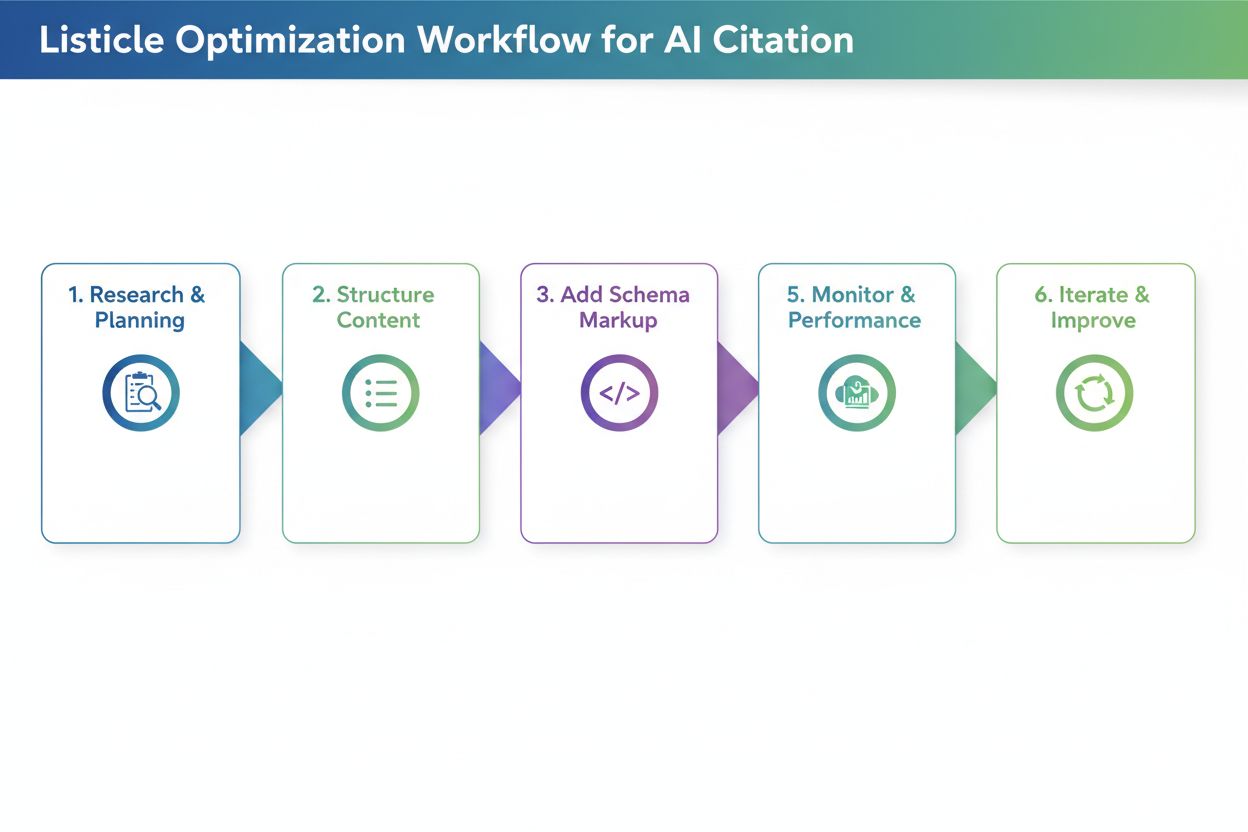

Descubra por que modelos de IA preferem listicles e listas numeradas. Aprenda como otimizar conteúdo baseado em listas para citações do ChatGPT, Gemini e Perple...

Aprenda como criar respostas meta para LLM que sistemas de IA citam. Descubra técnicas estruturais, estratégias de densidade de resposta e formatos de conteúdo ...

Aprenda como testar formatos de conteúdo para citações de IA usando metodologia de testes A/B. Descubra quais formatos proporcionam maior visibilidade e taxas d...