Divisão de Conteúdo para IA: Comprimentos Ideais de Trechos para Citações

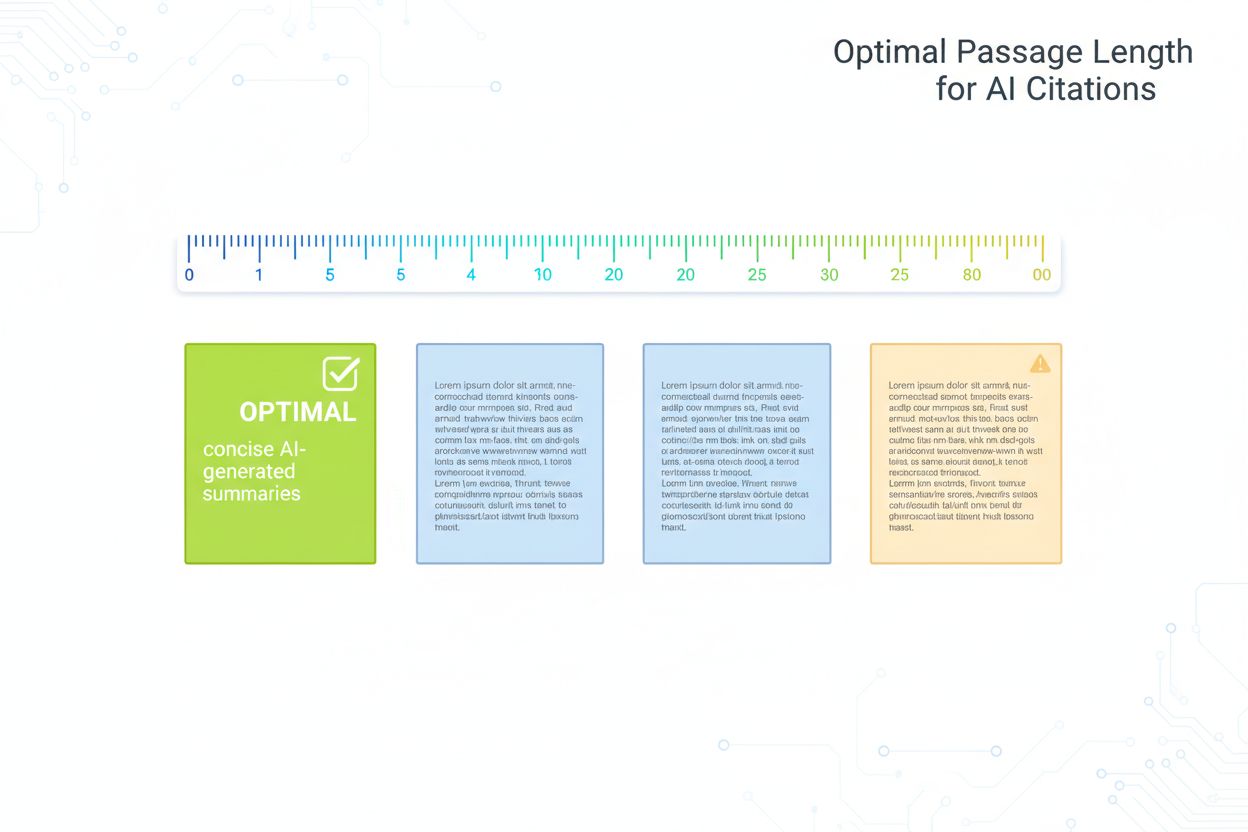

Aprenda a estruturar seu conteúdo em trechos com comprimento ideal (100-500 tokens) para maximizar citações por IA. Descubra estratégias de divisão que aumentam...

Guia fundamentado em pesquisa sobre o comprimento ideal de trechos para citações de IA. Saiba por que 75-150 palavras é o ideal, como os tokens afetam a recuperação pela IA e estratégias para maximizar o potencial de citação do seu conteúdo.

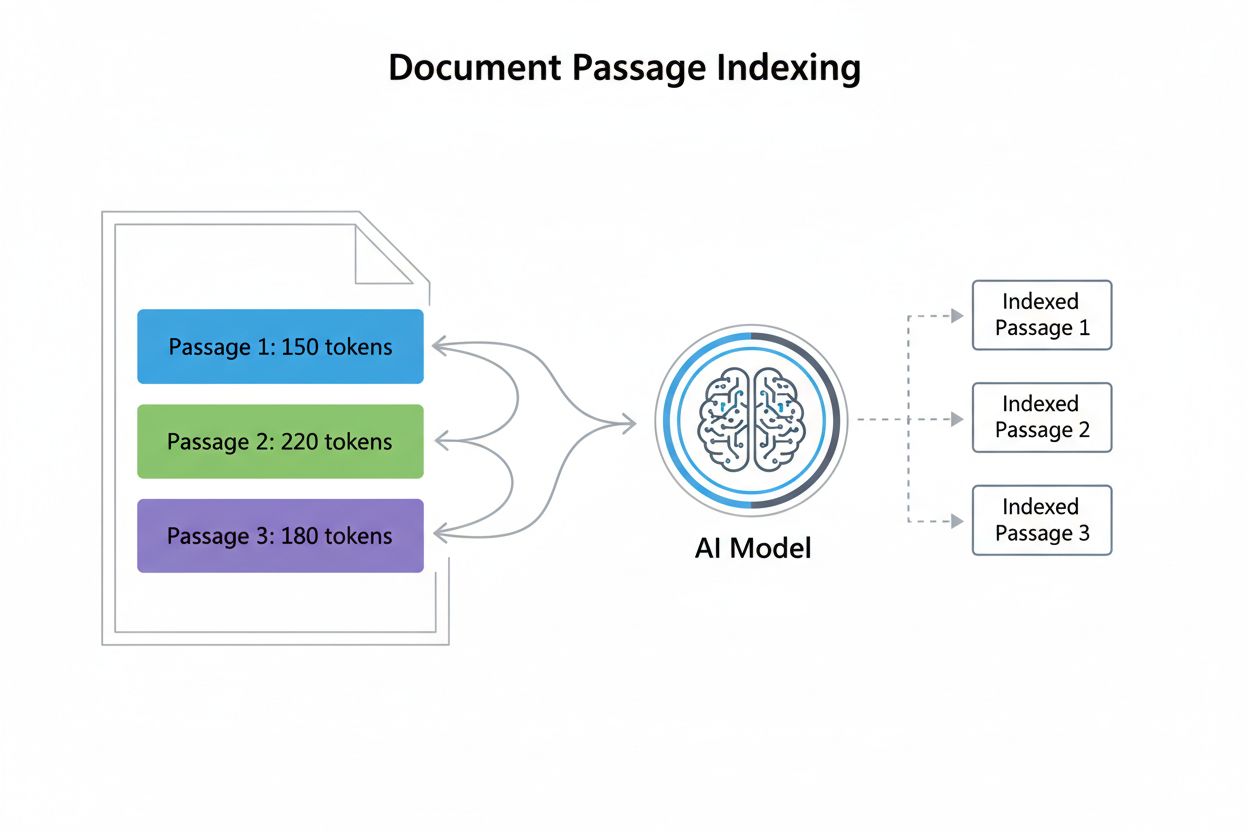

Comprimento de trecho no contexto de citações de IA refere-se ao tamanho ideal de blocos de conteúdo que os modelos de IA extraem e citam ao gerar respostas. Em vez de citar páginas ou documentos inteiros, sistemas modernos de IA utilizam a indexação em nível de trecho, que divide o conteúdo em segmentos discretos e gerenciáveis, avaliados e citados de forma independente. Compreender essa distinção é fundamental, pois muda a maneira como criadores de conteúdo devem estruturar seu material. A relação entre trechos e tokens é essencial: aproximadamente 1 token equivale a 0,75 palavras, ou seja, um trecho de 300 palavras geralmente contém cerca de 400 tokens. Essa conversão é relevante porque os modelos de IA operam dentro de janelas de contexto—limites fixos de quanto texto podem processar simultaneamente. Ao otimizar o comprimento dos trechos, criadores de conteúdo garantem que suas informações mais valiosas fiquem dentro do alcance que os sistemas de IA podem indexar, recuperar e citar de forma eficaz, em vez de ficarem enterradas em documentos longos que podem exceder a capacidade de processamento.

Pesquisas demonstram consistentemente que 53% do conteúdo citado por sistemas de IA tem menos de 1.000 palavras, um achado que desafia suposições tradicionais sobre profundidade e autoridade do conteúdo. Essa preferência por conteúdos mais curtos decorre da forma como os modelos de IA avaliam relevância e extração—trechos concisos são mais fáceis de analisar, contextualizar e citar com precisão. O conceito de “nugget de resposta” (normalmente 40-80 palavras) surgiu como uma unidade crítica de otimização, representando a menor resposta significativa para uma dúvida do usuário. Curiosamente, estudos mostram uma correlação quase nula entre número de palavras e posição da citação, ou seja, conteúdos mais longos não ocupam posições mais altas automaticamente nas citações de IA. Conteúdos com menos de 350 palavras tendem a aparecer entre as três principais citações com mais frequência, sugerindo que brevidade combinada com relevância cria condições ideais para citações de IA. Essa visão orientada por dados transforma fundamentalmente a estratégia de conteúdo.

| Tipo de Conteúdo | Comprimento Ideal | Contagem de Tokens | Caso de Uso |

|---|---|---|---|

| Nugget de Resposta | 40-80 palavras | 50-100 tokens | Respostas diretas de Q&A |

| Featured Snippet | 75-150 palavras | 100-200 tokens | Respostas rápidas |

| Trecho | 256-512 tokens | 256-512 tokens | Resultados de busca semântica |

| Hub Temático | 1.000-2.000 palavras | 1.300-2.600 tokens | Cobertura abrangente |

| Conteúdo Longo | 2.000+ palavras | 2.600+ tokens | Análises profundas, guias |

Tokens são as unidades fundamentais que os modelos de IA usam para processar linguagem, sendo cada token normalmente uma palavra ou fragmento de palavra. Calcular a contagem de tokens é simples: divida o número de palavras por 0,75 para estimar os tokens, embora a contagem exata varie conforme o método de tokenização. Por exemplo, um trecho de 300 palavras contém aproximadamente 400 tokens, enquanto um artigo de 1.000 palavras possui cerca de 1.333 tokens. Janelas de contexto—o número máximo de tokens que um modelo pode processar em uma única solicitação—impactam diretamente quais trechos são selecionados para citação. A maioria dos sistemas modernos de IA opera com janelas de contexto de 4.000 a 128.000 tokens, mas limitações práticas geralmente fazem com que apenas os primeiros 2.000-4.000 tokens recebam atenção ideal. Quando um trecho ultrapassa esses limites práticos, corre o risco de ser truncado ou despriorizado no processo de recuperação. Compreender a janela de contexto do sistema de IA alvo permite estruturar trechos que se encaixam confortavelmente nas restrições de processamento, mantendo a completude semântica.

Exemplo de Cálculo de Tokens:

- Trecho de 100 palavras = ~133 tokens

- Trecho de 300 palavras = ~400 tokens

- Trecho de 500 palavras = ~667 tokens

- Trecho de 1.000 palavras = ~1.333 tokens

Alocação Prática da Janela de Contexto:

- Janela de contexto do sistema: 8.000 tokens

- Reservado para consulta + instruções: 500 tokens

- Disponível para trechos: 7.500 tokens

- Tamanho ideal do trecho: 256-512 tokens (cabem 14-29 trechos)

Modelos de IA exibem um fenômeno conhecido como apodrecimento de contexto, em que informações posicionadas no meio de trechos longos sofrem degradação significativa no desempenho. Isso ocorre porque modelos baseados em transformers aplicam mecanismos de atenção que favorecem naturalmente o conteúdo do início (efeito primazia) e do fim (efeito recência) das sequências de entrada. Quando trechos excedem 1.500 tokens, informações críticas enterradas no meio podem ser ignoradas ou despriorizadas na geração de citações. Essa limitação tem implicações profundas sobre como o conteúdo deve ser estruturado—posicionar suas informações mais importantes no início e no fim dos trechos maximiza a probabilidade de citação. Diversas estratégias de mitigação podem combater esse problema:

A estrutura ideal do trecho prioriza a coerência semântica—garantir que cada trecho represente um pensamento ou resposta completa e autossuficiente. Em vez de quebrar o conteúdo arbitrariamente por contagem de palavras, os trechos devem alinhar-se com limites naturais de tópicos e divisões lógicas. Independência de contexto é igualmente crítica; cada trecho deve ser compreensível sem que o leitor precise consultar conteúdo adjacente. Isso significa incluir o contexto necessário dentro do próprio trecho, em vez de depender de referências cruzadas ou informações externas. Ao estruturar conteúdo para recuperação por IA, considere como os trechos aparecerão isoladamente—sem cabeçalhos, navegação ou parágrafos ao redor. Boas práticas incluem: iniciar cada trecho com uma frase-tópico clara, manter formatação e terminologia consistentes, usar subtítulos descritivos que esclareçam o propósito do trecho e garantir que cada trecho responda a uma pergunta completa ou aborde um conceito inteiro. Tratando os trechos como unidades independentes, e não segmentos arbitrários de texto, criadores de conteúdo aumentam drasticamente a chance de que sistemas de IA extraiam e citem seu trabalho corretamente.

A “Estratégia Snack” otimiza para conteúdos curtos e focados (75-350 palavras) projetados para responder diretamente a perguntas específicas. Essa abordagem é excelente para dúvidas simples e diretas, onde o usuário busca respostas rápidas sem muito contexto. Conteúdos snack têm desempenho excepcional em citações de IA porque correspondem ao formato de “nugget de resposta” que os sistemas de IA naturalmente extraem. Por outro lado, a “Estratégia Hub” cria conteúdos longos e abrangentes (2.000+ palavras) que exploram temas complexos em profundidade. Conteúdos hub cumprem outros propósitos: estabelecer autoridade sobre o tema, capturar múltiplas perguntas relacionadas e fornecer contexto para questões mais complexas. O principal insight é que essas estratégias não são excludentes—a abordagem mais eficaz combina ambas. Produza conteúdos snack focados para perguntas específicas e respostas rápidas, depois desenvolva conteúdos hub que se conectam e expandem esses snacks. Essa abordagem híbrida permite capturar tanto citações diretas de IA (via snacks) quanto autoridade temática abrangente (via hubs). Ao decidir qual estratégia adotar, considere a intenção da consulta: perguntas simples e factuais favorecem snacks, enquanto tópicos complexos e exploratórios se beneficiam de hubs. A estratégia vencedora equilibra ambas conforme as necessidades reais de informação do seu público.

Nuggets de resposta são resumos concisos e autossuficientes, normalmente de 40-80 palavras, que respondem diretamente a perguntas específicas. Esses nuggets representam o formato ideal para citação por IA, pois oferecem respostas completas sem informações em excesso. A estratégia de posicionamento é fundamental: coloque o nugget de resposta imediatamente após o título principal ou introdução do tópico, antes de entrar em detalhes e explicações. Esse posicionamento inicial garante que os sistemas de IA encontrem a resposta primeiro, aumentando a probabilidade de citação. A marcação de schema desempenha papel vital na otimização do nugget de resposta—usando formatos estruturados como JSON-LD, você informa à IA exatamente onde está sua resposta. Veja um exemplo de nugget de resposta bem estruturado:

Pergunta: "Qual deve ser o tamanho do conteúdo web para citações de IA?"

Nugget de Resposta: "Pesquisas mostram que 53% do conteúdo citado por IA tem menos de 1.000 palavras, com trechos ideais variando de 75-150 palavras para respostas diretas e de 256-512 tokens para blocos semânticos. Conteúdos com menos de 350 palavras tendem a aparecer nas principais posições de citação, sugerindo que brevidade com relevância maximiza a probabilidade de citação por IA."

Este nugget é completo, específico e imediatamente útil—exatamente o que os sistemas de IA buscam ao gerar citações.

A marcação de schema JSON-LD fornece instruções explícitas aos sistemas de IA sobre a estrutura e o significado do seu conteúdo, aumentando dramaticamente a probabilidade de citação. Os tipos de schema mais impactantes para otimização em IA incluem schema FAQ para conteúdo de perguntas e respostas e schema HowTo para conteúdo processual ou instrucional. O schema FAQ é especialmente poderoso pois reflete diretamente como os sistemas de IA processam informações—como pares discretos de pergunta-resposta. Pesquisas mostram que páginas com marcação de schema adequada têm 3x mais chances de serem citadas por sistemas de IA em comparação a conteúdos sem marcação. Isso não é coincidência; o schema reduz a ambiguidade sobre o que constitui uma resposta, tornando a extração e a citação mais confiantes e precisas.

{

"@context": "https://schema.org",

"@type": "FAQPage",

"mainEntity": [

{

"@type": "Question",

"@id": "https://example.com/faq#q1",

"name": "What is optimal passage length for AI citations?",

"acceptedAnswer": {

"@type": "Answer",

"text": "Research shows 53% of AI-cited content is under 1,000 words, with optimal passages ranging from 75-150 words for direct answers and 256-512 tokens for semantic chunks."

}

}

]

}

Implementar marcação de schema transforma seu conteúdo de texto não estruturado em informação legível por máquina, sinalizando aos sistemas de IA exatamente onde estão as respostas e como estão organizadas.

Acompanhar o desempenho dos trechos exige monitorar métricas específicas que indiquem sucesso em citações de IA. Share de citação mede com que frequência seu conteúdo aparece em respostas geradas por IA, enquanto posição da citação acompanha se seus trechos aparecem em primeiro, segundo ou posições posteriores nas listas de citações. Ferramentas como SEMrush, Ahrefs e plataformas especializadas de monitoramento de IA agora acompanham aparições e citações no AI Overview, fornecendo visibilidade sobre o desempenho. Implemente testes A/B criando várias versões de trechos com diferentes comprimentos, estruturas ou implementações de schema, e monitore quais versões geram mais citações. Métricas-chave a serem acompanhadas incluem:

O monitoramento regular revela quais estruturas, comprimentos e formatos de trecho mais ressoam com sistemas de IA, permitindo otimização contínua.

Muitos criadores de conteúdo sabotam inadvertidamente seu potencial de citação por IA por meio de erros estruturais evitáveis. Enterrar informações importantes no fundo dos trechos obriga os sistemas de IA a vasculhar contexto irrelevante antes de encontrar respostas—coloque suas informações mais críticas primeiro. Referências cruzadas excessivas criam dependência de contexto; trechos que referenciam constantemente outras seções tornam-se difíceis de extrair e citar de forma independente por IA. Conteúdo vago e não específico carece da precisão que a IA necessita para citações confiantes—use detalhes concretos, números específicos e declarações claras. Limites de seção mal definidos criam trechos que abrangem múltiplos tópicos ou pensamentos incompletos; assegure-se de que cada trecho represente uma unidade coerente. Ignorar a estrutura técnica significa perder oportunidades de marcação de schema, hierarquia adequada de títulos e clareza semântica. Outros erros incluem:

Evitar esses erros, aliado à implementação das estratégias de otimização acima, posiciona seu conteúdo para o máximo desempenho em citações de IA.

Pesquisas mostram que 75-150 palavras (100-200 tokens) é o ideal para a maioria dos tipos de conteúdo. Esse comprimento oferece contexto suficiente para os sistemas de IA entenderem e citarem seu conteúdo, mantendo-se conciso para inclusão direta em respostas geradas por IA. Conteúdos com menos de 350 palavras tendem a ocupar as principais posições de citação.

Não. Pesquisas demonstram que 53% das páginas citadas têm menos de 1.000 palavras, e praticamente não há correlação entre a contagem de palavras e a posição da citação. Qualidade, relevância e estrutura importam muito mais do que o comprimento. Conteúdos curtos e focados frequentemente superam artigos longos em citações de IA.

Um token equivale aproximadamente a 0,75 palavras em texto em inglês. Portanto, 1.000 tokens equivalem a cerca de 750 palavras. A proporção exata varia conforme o idioma e o tipo de conteúdo—códigos usam mais tokens por palavra devido a caracteres especiais e sintaxe. Compreender essa conversão ajuda a otimizar o comprimento dos trechos para sistemas de IA.

Divida conteúdos extensos em seções autossuficientes de 400-600 palavras cada. Cada seção deve ter uma frase-tópico clara e incluir um 'nugget de resposta' de 40-80 palavras que responda diretamente a uma pergunta específica. Utilize marcação de schema para ajudar sistemas de IA a identificar e citar esses nuggets. Essa abordagem captura tanto citações diretas quanto autoridade sobre o tema.

Modelos de IA tendem a focar em informações no início e no fim de contextos longos, tendo dificuldade com conteúdos no meio. Esse 'apodrecimento de contexto' faz com que informações críticas enterradas em trechos com mais de 1.500 tokens possam ser ignoradas. Minimize isso colocando informações críticas no início ou no fim, usando cabeçalhos explícitos e repetindo pontos-chave estrategicamente.

Acompanhe o share de citação (percentual de AI Overviews que linkam para seu domínio) usando ferramentas como BrightEdge, Semrush ou Authoritas. Monitore quais trechos específicos aparecem em respostas geradas por IA e ajuste a estrutura do conteúdo com base no desempenho. O AmICited também oferece monitoramento especializado para citações de IA em múltiplas plataformas.

Sim, de forma significativa. Páginas com marcação de schema JSON-LD abrangente (FAQ, HowTo, ImageObject) têm 3x mais chances de aparecer nos AI Overviews. O schema ajuda os sistemas de IA a entenderem e extraírem seu conteúdo de forma mais eficaz, facilitando a citação correta e confiante dos seus trechos.

Use ambos. Escreva conteúdos curtos e focados (300-500 palavras) para perguntas simples e diretas usando a 'Estratégia Snack'. Produza conteúdos longos e abrangentes (2.000-5.000 palavras) para temas complexos com a 'Estratégia Hub'. Em conteúdos extensos, estruture como múltiplos trechos curtos e autossuficientes para capturar citações diretas e autoridade temática.

Acompanhe como sistemas de IA como ChatGPT, Perplexity e Google AI Overviews citam seu conteúdo. Otimize seus trechos com base em dados reais de citação e aumente sua visibilidade em respostas geradas por IA.

Aprenda a estruturar seu conteúdo em trechos com comprimento ideal (100-500 tokens) para maximizar citações por IA. Descubra estratégias de divisão que aumentam...

Descubra a profundidade, estrutura e requisitos de detalhamento ideais para ser citado pelo ChatGPT, Perplexity e Google AI. Veja o que torna um conteúdo digno ...

Discussão da comunidade sobre o comprimento ideal de conteúdo para visibilidade em buscas por IA. Redatores e estrategistas compartilham dados sobre qual tamanh...