Construindo uma Biblioteca de Prompts para Monitoramento de Visibilidade em IA

Aprenda a criar e organizar uma biblioteca de prompts eficaz para monitorar sua marca no ChatGPT, Perplexity e Google AI. Guia passo a passo com melhores prátic...

Aprenda como construir e usar bibliotecas de prompts para testes manuais de visibilidade em IA. Guia DIY para testar como sistemas de IA referenciam sua marca no ChatGPT, Perplexity e Google IA.

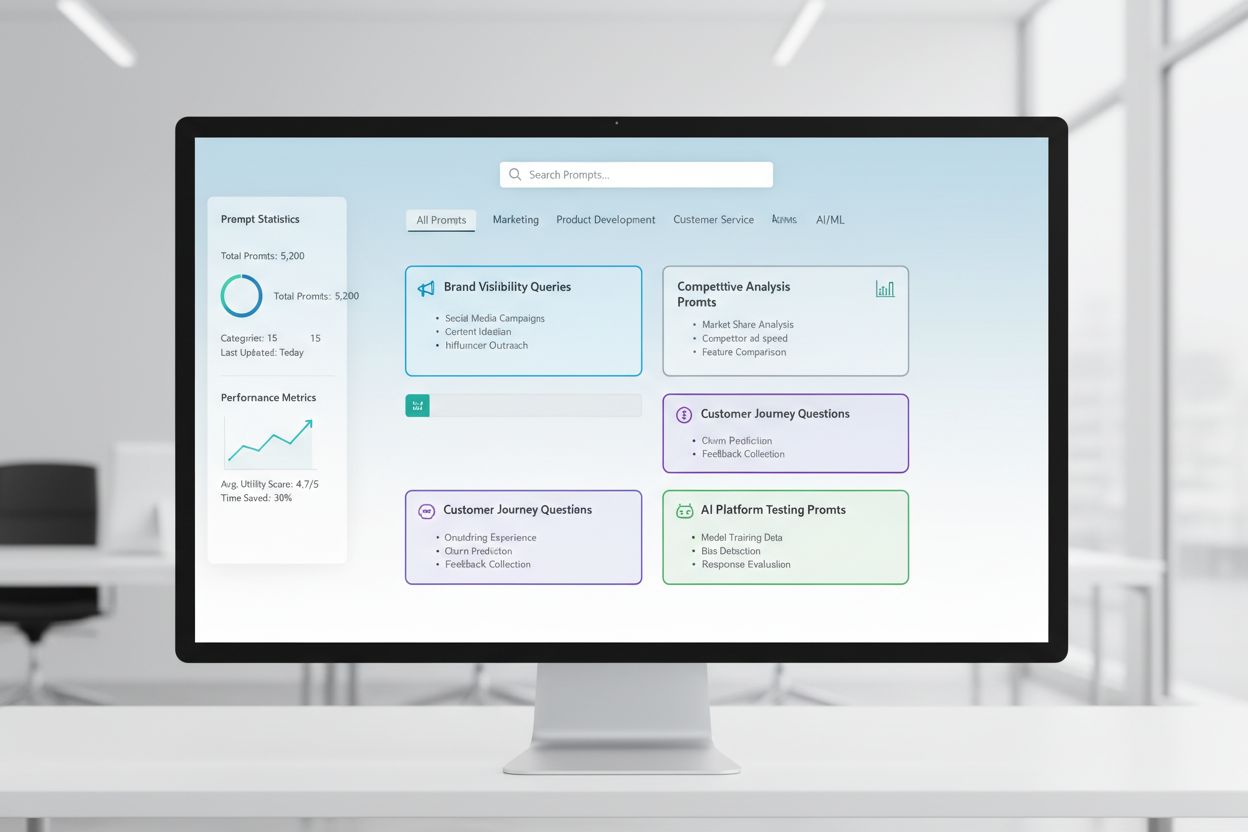

Uma biblioteca de prompts é uma coleção curada e organizada de prompts de teste projetados para avaliar sistematicamente como sistemas de IA respondem a consultas e cenários específicos. No contexto de testes manuais de IA, essas bibliotecas servem como sua caixa de ferramentas fundamental—um repositório de prompts cuidadosamente elaborados que ajudam você a entender exatamente como diferentes modelos de IA lidam com menções à sua marca, citações, precisão do conteúdo e compreensão contextual. Os testes de visibilidade em IA dependem fortemente das bibliotecas de prompts porque elas permitem testes consistentes e repetíveis em várias plataformas e períodos, permitindo que você acompanhe como seu conteúdo aparece (ou não aparece) nas respostas geradas por IA. Em vez de testar aleatoriamente com consultas ad-hoc, uma biblioteca de prompts bem estruturada garante que você esteja cobrindo sistematicamente todos os cenários que importam para o seu negócio, desde buscas diretas pela marca até referências contextuais indiretas. Essa abordagem estruturada transforma o teste manual de um processo aleatório para uma metodologia estratégica e orientada por dados, revelando padrões no comportamento da IA e ajudando você a entender sua real visibilidade no universo da inteligência artificial.

O teste manual de visibilidade em IA é o processo prático de consultar diretamente sistemas de IA com prompts previamente definidos e analisar cuidadosamente suas respostas para entender como seu conteúdo, marca e citações estão sendo apresentados ou omitidos. Diferente de sistemas automatizados de monitoramento, que funcionam continuamente em segundo plano, o teste manual oferece controle direto sobre o que está sendo testado, quando e com que profundidade os resultados são analisados—tornando-o inestimável para testes exploratórios, entendimento de casos extremos e investigação de comportamentos inesperados da IA. A diferença chave está na natureza do trabalho: o teste manual é deliberado e investigativo, permitindo fazer perguntas de acompanhamento, testar variações e entender o “porquê” por trás das respostas da IA, enquanto o monitoramento automatizado é excelente para acompanhamento consistente e em larga escala ao longo do tempo. O teste manual é especialmente importante para a visibilidade em IA porque ajuda a captar nuances que sistemas automatizados podem deixar passar—como quando sua marca é mencionada, mas atribuída incorretamente, quando citações são precisas, mas incompletas, ou quando o contexto está sendo entendido corretamente. Veja como essas abordagens se comparam:

| Aspecto | Teste Manual | Monitoramento Automatizado |

|---|---|---|

| Custo | Investimento inicial menor; exige tempo | Maior configuração inicial; menor trabalho contínuo |

| Velocidade | Mais lento por teste; insights imediatos | Mais lento para configurar; rastreio contínuo rápido |

| Flexibilidade | Altamente flexível; fácil de ajustar e explorar | Rígido; requer parâmetros pré-definidos |

| Precisão | Alta para análise qualitativa; sujeito a viés humano | Consistente; excelente para métricas quantitativas |

| Curva de Aprendizado | Mínima; qualquer pessoa pode começar | Mais acentuada; requer configuração técnica |

O teste manual é excelente quando você precisa entender por que algo está acontecendo, enquanto o monitoramento automatizado é ideal para rastrear o que está acontecendo em escala.

Uma estrutura robusta de biblioteca de prompts deve ser organizada em torno dos principais eixos da sua estratégia de visibilidade em IA, com cada componente servindo a um propósito específico de teste. Sua biblioteca deve incluir prompts que testem diferentes aspectos de como sistemas de IA descobrem e apresentam seu conteúdo, garantindo uma cobertura abrangente do seu cenário de visibilidade. Estes são os componentes essenciais que toda biblioteca de prompts deve conter:

Ao montar sua estratégia de testes, é preciso criar prompts que atinjam especificamente os eixos da visibilidade em IA que mais importam para o seu negócio—menções de marca, precisão de citações e compreensão contextual. Os prompts de teste mais eficazes são aqueles que espelham o comportamento real do usuário, ao mesmo tempo em que isolam variáveis específicas que você deseja medir. Para prompts de teste focados em menções de marca, é recomendável criar variações que testem buscas diretas, referências indiretas e contextos comparativos. Testar a precisão de citações exige prompts que naturalmente provoquem citações e depois variações que verifiquem se a IA atribui corretamente as informações às suas fontes. Aqui estão exemplos de prompts que você pode adaptar para seus próprios testes:

"Quais são os últimos desenvolvimentos em [seu setor]?

Por favor, cite suas fontes."

"Compare [seu produto] com [produto do concorrente].

Quais as principais diferenças e vantagens de cada um?"

"Explique [sua área de expertise].

Quem são os principais especialistas ou empresas nesse campo?"

Esses prompts são projetados para desencadear naturalmente os tipos de resposta em que sua visibilidade mais importa—quando sistemas de IA fornecem informações, fazem comparações ou identificam fontes autoritativas. Você pode criar variações alterando o nível de especificidade (amplo vs. restrito), adicionando restrições (apenas informações recentes, casos de uso específicos) ou modificando os requisitos de citação (com fontes, com links, com nomes de autores). O importante é testar não apenas se seu conteúdo aparece, mas como ele aparece e em que contexto, o que exige prompts que criem cenários realistas onde sua visibilidade seria naturalmente demonstrada.

Sua estratégia de visibilidade em IA deve considerar que diferentes plataformas de IA—ChatGPT, Perplexity, Google AI Overviews, Claude e outras—possuem dados de treinamento, mecanismos de busca e métodos de geração de resposta fundamentalmente distintos, o que faz sua visibilidade variar significativamente entre elas. O teste multiplataforma é essencial porque um prompt que destaca seu conteúdo em uma IA pode gerar resultados totalmente diferentes em outra, e entender esses padrões específicos de cada plataforma é crucial para desenvolver uma estratégia abrangente de visibilidade. Ao testar em várias plataformas, você notará que o Perplexity, com integração de busca em tempo real, geralmente apresenta conteúdos mais recentes e citações mais explícitas que o ChatGPT, que depende de dados de treinamento com corte de conhecimento. O Google AI Overviews, integrado diretamente aos resultados de busca, opera com regras de visibilidade diferentes e pode priorizar fontes distintas das usadas por sistemas conversacionais de IA. A abordagem prática é manter um conjunto consistente de prompts principais que você executa regularmente em todas as plataformas, permitindo acompanhar não só se seu conteúdo aparece, mas onde ele aparece e como as diferenças de plataforma afetam sua visibilidade. Essa perspectiva multiplataforma revela se seus desafios de visibilidade são universais (afetando todas as plataformas) ou específicos (exigindo estratégias direcionadas para cada sistema), o que muda fundamentalmente sua abordagem de otimização.

Uma documentação eficaz dos testes transforma dados brutos em inteligência acionável, e o sistema de organização escolhido determinará se seus esforços de teste irão se acumular em valor ao longo do tempo ou permanecerão pontos de dados isolados. A abordagem mais prática é usar uma planilha estruturada ou sistema de documentação que registre não apenas os resultados, mas o contexto—including o prompt exato utilizado, a data do teste, a plataforma, a resposta completa da IA e sua análise sobre se e como seu conteúdo apareceu. Seu sistema de acompanhamento de resultados deve incluir colunas para: categoria do prompt (marca, concorrente, setor, etc.), plataforma testada, se seu conteúdo apareceu, precisão da citação (se aplicável), posição na resposta (primeira menção, evidência de apoio, etc.) e anotações qualitativas sobre a qualidade ou relevância da resposta. Além dos dados brutos, crie templates para cenários comuns de teste, garantindo que a documentação permaneça consistente ao longo do tempo e facilitando a identificação de tendências e mudanças no comportamento da IA. Documente não só acertos, mas também falhas e anomalias—frequentemente elas revelam os insights mais importantes sobre como as IAs funcionam e onde sua estratégia de visibilidade precisa de ajustes. Mantendo essa disciplina metodológica, você cria um histórico que mostra como sua visibilidade evoluiu, quais mudanças nos sistemas de IA afetaram seus resultados e quais esforços de otimização realmente fizeram diferença.

O teste manual de visibilidade em IA está sujeito a vários erros sistemáticos que podem comprometer seus resultados e gerar conclusões equivocadas sobre sua visibilidade real. O erro mais comum é a formulação inconsistente de prompts—testar o mesmo conceito com pequenas variações de texto a cada rodada, introduzindo variáveis que tornam impossível saber se as mudanças nos resultados são devido à IA ou à variação dos testes. Para evitar isso, crie um documento mestre de prompts onde cada prompt fique “congelado” e seja usado de forma idêntica em todas as rodadas; se quiser testar variações, crie versões separadas com convenções claras de nomeação. Outro erro crítico é amostras e frequência insuficientes—testar uma vez e tirar conclusões, sem reconhecer que as respostas da IA podem variar conforme o momento, carga do sistema e outros fatores. Estabeleça uma cadência regular de testes (semanal, quinzenal ou mensal, conforme seus recursos) e teste cada prompt várias vezes para identificar padrões, e não anomalias. Viés de confirmação é uma armadilha sutil e perigosa, em que o testador interpreta resultados ambíguos como confirmação de suas expectativas; combata isso fazendo com que vários membros da equipe revisem os resultados de forma independente e documentando critérios objetivos para o que é considerado “seu conteúdo aparecendo”. Além disso, evite o erro de testar em isolamento—sempre registre data, hora e quaisquer atualizações conhecidas do sistema de IA ao testar, pois entender o contexto dos seus resultados é essencial para interpretá-los corretamente. Por fim, documentação metodológica falha impede a replicação dos testes ou a explicação dos resultados aos interessados; sempre registre exatamente como você testou, o que mediu e como interpretou os resultados para garantir que seus testes sejam reproduzíveis e defensáveis.

À medida que sua organização cresce e sua estratégia de visibilidade em IA se torna mais sofisticada, será necessário escalar dos testes individuais e ad-hoc para uma abordagem de teste em equipe estruturada, distribuindo a carga de trabalho sem perder consistência e qualidade. O segredo do escalonamento bem-sucedido é criar protocolos de teste e definição clara de papéis—defina quem cuida de quais plataformas, categorias de prompts e responsabilidades de análise, tornando os testes um esforço coordenado de equipe, e não trabalho duplicado individual. Implemente um calendário compartilhado de testes onde todos possam ver o que já foi testado, quando e por quem, evitando testes redundantes e garantindo cobertura abrangente. Crie um checklist ou runbook de testes que qualquer membro da equipe possa seguir para executar os testes de forma consistente, incluindo instruções específicas de como documentar resultados, o que observar nas respostas e como sinalizar anomalias ou achados interessantes. Ferramentas de colaboração como planilhas compartilhadas, sistemas de gestão de projetos ou plataformas dedicadas de teste ajudam a coordenar os esforços entre os membros da equipe e criam uma fonte única de verdade para seus dados de teste. Ao escalar, considere revezar as responsabilidades de teste, de modo que várias pessoas compreendam a metodologia e possam contribuir, reduzindo a dependência de uma única pessoa. Reuniões regulares de equipe para revisar resultados, discutir achados e ajustar a estratégia de teste conforme o aprendizado garantem que o esforço escalado permaneça alinhado e estratégico, e não um conjunto desconexo de tarefas individuais.

As estratégias mais sofisticadas de visibilidade em IA reconhecem que abordagens manuais e automatizadas são complementares, não concorrentes, cada uma trazendo vantagens em contextos específicos e, juntas, proporcionando cobertura abrangente de visibilidade. O teste manual é sua ferramenta investigativa—é onde se explora, entende nuances, testa hipóteses e aprofunda o conhecimento sobre como sistemas de IA funcionam e por que sua visibilidade varia entre plataformas e cenários. Ferramentas de monitoramento automatizado como o AmICited são excelentes para acompanhamento consistente e em larga escala, monitorando continuamente sua visibilidade em várias plataformas de IA e alertando sobre mudanças, tendências e anomalias que seriam impossíveis de detectar só com testes manuais. A estratégia prática de integração é usar o teste manual para desenvolver sua estrutura de testes, entender o que importa e investigar anomalias, enquanto o monitoramento automatizado acompanha continuamente essas métricas-chave e alerta quando houver mudanças. Por exemplo, você pode testar manualmente uma nova categoria de prompts para entender como as IAs respondem e, ao validar que é um teste relevante, adicioná-lo ao monitoramento automatizado para acompanhamento contínuo sem esforço manual recorrente. O AmICited e ferramentas similares cuidam do trabalho repetitivo e demorado de executar testes em escala e frequência que seriam impraticáveis manualmente, liberando sua equipe para focar em análise, estratégia e otimização. O fluxo de trabalho ideal é: use o teste manual para construir sua biblioteca de prompts e estratégia de teste, validar sua abordagem e investigar questões específicas; use o monitoramento automatizado para rastrear continuamente as principais métricas de visibilidade; e utilize os insights do monitoramento automatizado para definir o que testar manualmente em seguida. Essa abordagem integrada garante que você não está testando manualmente no vácuo, mas sim construindo uma estratégia de visibilidade completa que combina a profundidade da investigação manual com a escala e consistência do monitoramento automatizado.

Uma biblioteca de prompts é uma coleção curada e organizada de prompts de teste projetados para avaliar sistematicamente sistemas de IA em múltiplas dimensões. Diferente de um único template de prompt, uma biblioteca contém dezenas de prompts organizados por categoria (menções à marca, comparações com concorrentes, citações, etc.), permitindo que você realize testes abrangentes em vez de verificações isoladas. Bibliotecas de prompts são versionadas, documentadas e projetadas para reutilização e expansão pela sua equipe.

A frequência depende dos seus recursos e da dinamicidade do seu setor. A maioria das organizações se beneficia de testes semanais ou quinzenais com prompts principais para identificar mudanças significativas, com testes aprofundados mensais usando toda a biblioteca de prompts. Se você está em um setor dinâmico ou publicou conteúdo importante recentemente, aumente a frequência para semanal. Combine testes manuais com ferramentas de monitoramento automatizado como o AmICited para acompanhamento contínuo entre os ciclos de testes manuais.

Sim, você deve usar os mesmos prompts principais em todas as plataformas para garantir consistência e comparabilidade. Porém, pode ser necessário criar variações específicas para cada plataforma, pois diferentes sistemas de IA (ChatGPT, Perplexity, Google AI Overviews) possuem interfaces, mecanismos de citação e formatos de resposta distintos. Teste seus prompts principais de forma idêntica em todas as plataformas e depois crie variações para cada uma, levando em conta as particularidades e limitações de cada sistema.

Acompanhe se seu conteúdo aparece (sim/não), onde aparece na resposta (primeira menção, evidência de apoio, etc.), precisão das citações (se houver), e qualidade da resposta. Também registre a data do teste, a plataforma, o prompt exato utilizado e quaisquer observações qualitativas sobre como seu conteúdo foi apresentado. Com o tempo, essas métricas revelam padrões na sua visibilidade e ajudam a entender quais esforços de otimização realmente geram resultados.

Seus testes são abrangentes quando cobrem todos os principais aspectos da sua visibilidade: buscas diretas pela marca, comparações com concorrentes, tópicos do setor, precisão de citações e compreensão contextual. Uma regra prática é ter de 20 a 30 prompts principais testados regularmente, além de prompts adicionais para investigações específicas. Se você está sempre descobrindo novos insights nos testes manuais, provavelmente precisa de mais prompts. Se os resultados estão previsíveis, sua cobertura já deve ser adequada.

Para organizações pequenas ou testes iniciais, você pode começar com recursos internos seguindo o método DIY descrito neste guia. No entanto, à medida que os testes se expandem, recursos dedicados se tornam valiosos. Considere contratar ou designar alguém para gerenciar sua biblioteca de prompts e realizar testes regulares, especialmente se você tiver múltiplos produtos, atuar em um setor competitivo ou precisar de ciclos de testes frequentes. Alternativamente, combine testes internos com ferramentas de monitoramento automatizado como o AmICited para distribuir a carga de trabalho.

Testes manuais são investigativos e flexíveis—você controla o que testa e pode explorar nuances e casos extremos. Ferramentas automatizadas como o AmICited funcionam continuamente, monitorando sua visibilidade em múltiplas plataformas de IA em larga escala e alertando sobre mudanças. O ideal é combinar ambos: use o teste manual para desenvolver sua estratégia e investigar questões específicas; utilize o monitoramento automatizado para o acompanhamento constante das principais métricas.

Você pode automatizar a execução dos prompts usando APIs (OpenAI, Anthropic, etc.) para enviar prompts aos sistemas de IA e capturar as respostas de forma programática. No entanto, a análise normalmente permanece manual, pois compreender contexto e nuances exige julgamento humano. Também é possível automatizar documentação e acompanhamento de resultados usando planilhas ou bancos de dados. A abordagem mais prática é utilizar ferramentas de monitoramento automatizado como o AmICited para as tarefas repetitivas, reservando o teste manual para análises e investigações mais aprofundadas.

Embora o teste manual seja valioso, o monitoramento automatizado garante visibilidade contínua em todas as plataformas de IA. O AmICited rastreia como sistemas de IA referenciam sua marca em tempo real.

Aprenda a criar e organizar uma biblioteca de prompts eficaz para monitorar sua marca no ChatGPT, Perplexity e Google AI. Guia passo a passo com melhores prátic...

Saiba o que é Desenvolvimento de Biblioteca de Prompts e como as organizações constroem coleções de consultas para testar e monitorar a visibilidade da marca em...

Aprenda como testar a presença da sua marca em mecanismos de IA com testes de prompt. Descubra métodos manuais e automatizados para monitorar a visibilidade em ...