PR Orientado por Dados: Criando Pesquisas Que a IA Quer Citar

Aprenda como criar pesquisas originais e conteúdos de PR orientados por dados que sistemas de IA citam ativamente. Descubra os 5 atributos de conteúdos dignos d...

Descubra como dados de pesquisa proprietários e estatísticas originais se tornam ímãs de citações para LLMs. Veja estratégias para melhorar a visibilidade em IA e conquistar mais citações do ChatGPT, Perplexity e Google AI Overviews.

Grandes Modelos de Linguagem não inventam dados — eles os retiram de fontes verificáveis. Quando sua equipe publica estatísticas únicas ou metodologias originais, você passa a “possuir” temporariamente esse conhecimento, dando aos LLMs motivos para citar você e validar suas respostas. Essa é a base do que a IDX chama de “Authority Flywheel”, um sistema em que pesquisas proprietárias se tornam seu mais poderoso ímã de citações.

A mecânica é simples: modelos de IA avaliam fontes considerando se podem verificar afirmações por múltiplos canais. Ao publicar pesquisa original, você cria um ativo de conhecimento inexistente em qualquer outro lugar da web. Essa exclusividade força os LLMs a citar sua fonte caso queiram incluir esses dados nas respostas. Uma campanha para a The Zebra, plataforma de seguros, demonstra perfeitamente esse princípio — combinando pesquisa proprietária com PR Digital, gerou mais de 1.580 links de mídia qualificados e impulsionou o tráfego orgânico em 354%.

Segundo pesquisa recente, 48,6% dos especialistas em SEO apontaram o PR Digital como a tática de link-building mais eficaz para 2025. Mas o verdadeiro poder está no que acontece depois: quando seus dados proprietários são distribuídos por domínios diversos e de alto nível via PR Digital, isso confirma sua autoridade em várias redes de conhecimento ao mesmo tempo. Essa validação multicanal é exatamente o que LLMs buscam ao decidir se citam ou não sua marca.

O insight-chave: dados proprietários criam o que pesquisadores chamam de “propriedade temporária do conhecimento”. Diferente de conteúdos genéricos, que competem com milhares de artigos semelhantes, sua pesquisa original é a única fonte para aqueles dados específicos. Esse princípio da escassez faz os LLMs terem maior propensão a citar você, pois é a única forma de incluir aquela informação em suas respostas.

Compreender como os LLMs realmente recuperam e selecionam fontes é essencial para otimizar citações. Esses sistemas não funcionam como buscadores tradicionais. Em vez disso, operam por dois caminhos distintos: memória paramétrica (conhecimento armazenado no treinamento) e conhecimento recuperado (informação em tempo real obtida via Retrieval-Augmented Generation, ou RAG).

Conhecimento paramétrico representa tudo que o LLM “sabe” do pré-treinamento. Esse conhecimento é estático e fixo no corte do treinamento do modelo. Aproximadamente 60% das consultas ao ChatGPT são respondidas apenas desse conhecimento, sem busca na web. Entidades citadas com frequência em fontes autoritativas durante o treinamento desenvolvem representações neurais mais fortes, tornando-se mais prováveis de serem lembradas. Conteúdo da Wikipedia representa cerca de 22% dos dados de treinamento dos principais LLMs, o que explica a frequência de citações à Wikipedia em respostas geradas por IA.

O conhecimento recuperado funciona de modo diferente. Quando o LLM precisa de informação atual, utiliza sistemas RAG que combinam busca semântica (vetores densos) com correspondência de palavras-chave (BM25) via Reciprocal Rank Fusion. Pesquisas mostram que a busca híbrida entrega 48% de melhoria sobre abordagens únicas. O sistema então reordena resultados usando modelos cross-encoder antes de injetar os 5-10 melhores trechos no prompt do LLM como contexto.

| Sinal | Prioridade SEO Tradicional | Prioridade de Citação LLM | Por Que Importa |

|---|---|---|---|

| Autoridade de Domínio | Alta (fator central) | Fraca/Neutra | LLMs priorizam estrutura do conteúdo, não poder do domínio |

| Quantidade de Backlinks | Alta (sinal primário) | Fraca/Neutra | LLMs avaliam credibilidade de outras formas |

| Estrutura do Conteúdo | Média | Crítica | Títulos claros e blocos de resposta são essenciais para extração |

| Dados Proprietários | Baixa | Muito Alta | Informação única força citação |

| Volume de Busca da Marca | Baixa | Altíssima (correlação 0,334) | Indica autoridade e demanda reais |

| Atualização | Média | Alta | LLMs preferem conteúdo recente |

| Sinais E-E-A-T | Média | Alta | Credenciais do autor e transparência contam |

A diferença fundamental: LLMs não ranqueiam páginas — eles extraem trechos semânticos. Uma página com métricas SEO tradicionais ruins, mas estrutura cristalina e dados proprietários pode superar uma página de alta autoridade com posicionamento vago. Essa mudança significa que sua estratégia de citação deve priorizar legibilidade para máquinas e clareza de conteúdo acima de métricas tradicionais de link-building.

Os indicadores que importam para visibilidade em IA mudaram radicalmente em relação aos sinais tradicionais de SEO. Por duas décadas, autoridade de domínio, backlinks e ranqueamento de palavras-chave definiam o sucesso. Em 2025, esses indicadores tornaram-se quase irrelevantes para citações em LLMs. Uma nova hierarquia emergiu, baseada em como os sistemas de IA realmente avaliam e escolhem fontes.

O volume de busca da marca agora é o maior preditor de citações em LLM, com coeficiente de correlação 0,334 — muito mais alto que qualquer métrica tradicional de SEO. Isso faz sentido: se milhões buscam o nome da sua marca, sinaliza autoridade e demanda reais. LLMs reconhecem esse sinal e pesam fortemente ao decidir citar você. Já backlinks mostram correlação fraca ou neutra com citações em IA, contrariando décadas de sabedoria em SEO.

A mudança alcança a avaliação do conteúdo. Acrescentar estatísticas ao seu conteúdo aumenta a visibilidade em IA em 22%. Incluir citações eleva em 37%. Pesquisa original é citada 3x mais frequentemente que conteúdo genérico. Não são melhorias marginais — representam mudanças profundas em como os LLMs avaliam qualidade da fonte.

| Métrica | Foco Antigo (Pré-2024) | Novo Foco (2025+) | Impacto nas Citações em LLM |

|---|---|---|---|

| Indicador de Qualidade de Link | Score de Autoridade de Domínio (DA/DR) | Relevância Temática & Contexto Editorial | Fundamentação e diversidade de fontes |

| Estratégia de Anchor Text | Palavras-chave exatas | Menções de marca/entidade | Reconhecimento e consistência da entidade |

| Tipo de Conteúdo | Postagens de convidados (volume) | Pesquisa Original/Data Journalism | Probabilidade de citação 3x maior |

| Medida de Sucesso | Posição no ranking | Taxa de citação nas AI Overviews | Validação de confiança e autoridade |

| Abordagem de Outreach | Aquisição de links | Construção de relacionamentos/Valor | Maior qualidade editorial |

Essa matriz traz um insight crítico: as marcas que vencem em visibilidade em IA não são necessariamente as com mais backlinks ou maior autoridade de domínio. São as que criam pesquisa original, mantêm sinais de marca consistentes e publicam conteúdo estruturado para extração por máquina. A vantagem competitiva mudou de quantidade de links para qualidade e exclusividade do conteúdo.

Dados de pesquisa proprietários têm papel único na estratégia de visibilidade em IA. Diferente de relatórios genéricos do setor, que os LLMs encontram em múltiplas fontes, seus dados de pesquisa originais só podem ser citados pelo seu site. Isso cria uma vantagem de citação impossível de ser replicada pelos concorrentes, por mais forte que seja o perfil de backlinks deles.

Dados de pesquisa funcionam porque fornecem o que os LLMs chamam de “grounding” — evidência verificável que valida afirmações. Ao dizer que “78% dos líderes de marketing priorizam visibilidade em IA”, LLMs podem citar sua pesquisa como prova. Sem esses dados proprietários, o mesmo argumento seria especulativo, e os LLMs poderiam omiti-lo ou citar pesquisa do concorrente.

Os dados de pesquisa mais eficazes respondem perguntas específicas do seu público-alvo:

O impacto é mensurável. Pesquisas mostram que acrescentar estatísticas aumenta a visibilidade em IA em 22%, enquanto citações elevam em 37%. Pesquisa original é citada 3x mais do que conteúdo genérico. Esses multiplicadores se somam ao combinar múltiplos tipos de dados proprietários em um único ativo de conteúdo.

A chave é a transparência. LLMs avaliam metodologia com o mesmo cuidado dos resultados. Se sua metodologia for sólida, o tamanho da amostra adequado e os achados apresentados honestamente (incluindo limitações), os LLMs citarão você com confiança. Se a metodologia for vaga ou os resultados parecerem seletivos, LLMs vão priorizar fontes mais transparentes.

Publicar dados proprietários é só metade do caminho. A outra metade é estruturar esses dados para que LLMs possam extrair e citar facilmente. A arquitetura do conteúdo importa tanto quanto os próprios dados.

Comece com respostas diretas. LLMs preferem conteúdos que trazem a resposta logo no início, não a jornada. Em vez de “Realizamos uma pesquisa para entender prioridades de marketing, veja o que descobrimos”, escreva “78% dos líderes de marketing agora priorizam visibilidade em IA em sua estratégia para 2025.” Essa estrutura direta facilita a extração e aumenta a probabilidade de citação.

O comprimento ideal do parágrafo para extração por LLM é de 40-60 palavras. Assim, o modelo pode extrair um pensamento completo sem truncar. Parágrafos mais longos são divididos, perdendo contexto. Parágrafos curtos podem não conter informação suficiente.

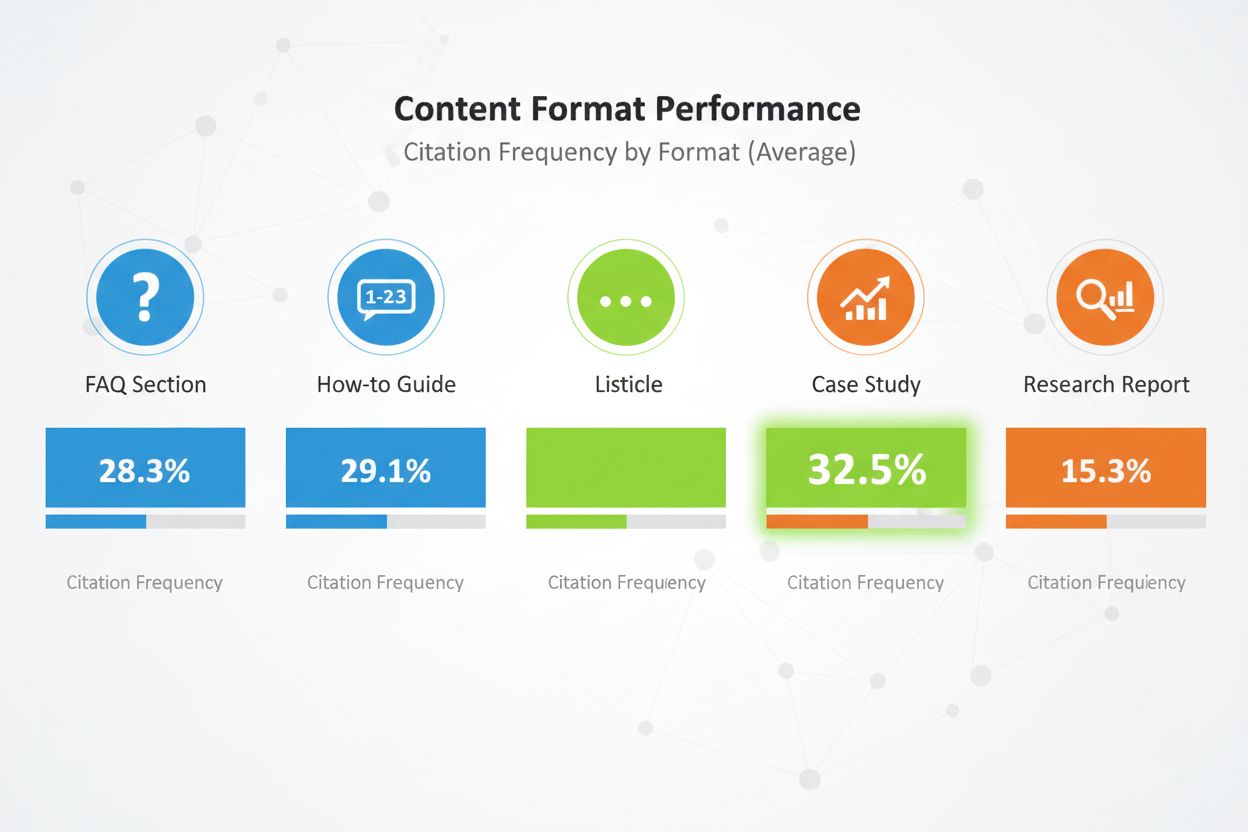

Formatos de conteúdo fazem grande diferença. Listas comparativas recebem 32,5% de todas as citações em IA — a maior taxa dentre todos os formatos. Seções de FAQ têm desempenho excepcional, pois refletem como usuários consultam sistemas de IA. Guias passo a passo, estudos de caso e relatórios de pesquisa também têm bom desempenho, mas listas superam consistentemente outros formatos.

Estruture o conteúdo com hierarquia clara de títulos. Use títulos H2 que reflitam buscas prováveis. Em cada H2, use H3 para subtemas. Essa hierarquia ajuda LLMs a entender a estrutura e extrair seções relevantes.

Implemente sinais E-E-A-T. Inclua bios de autor com credenciais e experiência real. Vincule a validações de terceiros. Seja transparente sobre a metodologia. Cite suas fontes. Esses sinais mostram aos LLMs que seu conteúdo é confiável e merece ser citado.

Use HTML semântico. Estruture dados com tags <table>, <ul>, <ol>, não apenas divs estilizadas por CSS. Isso facilita a análise e o resumo por IA. Inclua marcação de esquema (Article, FAQPage, HowTo) para fornecer contexto adicional sobre o tipo de conteúdo.

Por fim, atualize o conteúdo regularmente. LLMs preferem conteúdos recentes, especialmente para dados sensíveis ao tempo. Se a pesquisa é de 2024, atualize em 2025. Adicione marcações de “Última atualização” para mostrar manutenção ativa. Isso sinaliza aos LLMs que seus dados são atuais e confiáveis.

Publicar dados proprietários no seu site é necessário, mas não suficiente. LLMs descobrem conteúdos por múltiplos canais, e sua estratégia de distribuição determina quantos desses canais replicam seus dados.

PR Digital é o canal de distribuição mais eficaz para dados proprietários. Quando sua pesquisa aparece em publicações do setor, veículos de notícias e blogs autoritativos, cria múltiplas oportunidades de citação. LLMs indexam essas menções de terceiros e usam para validar sua fonte original. Marcas presentes em 4+ plataformas têm probabilidade 2,8x maior de serem citadas em respostas do ChatGPT comparado a marcas com presença limitada.

Canais de distribuição eficazes incluem:

Cada canal tem função. Releases criam awareness inicial e cobertura na mídia. Publicações setoriais oferecem credibilidade e alcance a tomadores de decisão. Amplificação no LinkedIn atinge profissionais em escala. Engajamento no Reddit demonstra confiança da comunidade. Plataformas de avaliação fornecem dados estruturados para fácil análise por LLMs.

O efeito multiplicador é grande. Quando seus dados aparecem em múltiplas fontes autoritativas, LLMs veem sinais consistentes. Essa consistência aumenta a confiança e a chance de citação. Uma única menção no seu site pode passar despercebida. Os mesmos dados presentes em site, release, publicação do setor e plataforma de avaliação se tornam impossíveis de ignorar.

O timing também importa. Distribua seus dados proprietários estrategicamente. Lance primeiro no site com release. Depois, emplaca em publicações do setor. Em seguida, amplifique por redes sociais e comunidades. Essa sequência cria uma onda de visibilidade sustentada, não apenas um pico isolado.

Publicar dados proprietários sem medir impacto é como anunciar sem rastrear conversões. Você precisa saber se seus dados estão realmente gerando citações e melhorando sua visibilidade em IA.

Comece com rastreamento da frequência de citações. Identifique 20-50 perguntas de alto valor para o comprador que seus dados respondem. Questione mensalmente as principais plataformas de IA (ChatGPT, Perplexity, Claude, Google AI Overviews) com essas perguntas. Documente se sua marca aparece, em que posição e se a citação inclui link para seu site.

Calcule a frequência de citações como porcentagem: (Prompts onde você é citado) / (Total de prompts) × 100. Busque frequência de citação acima de 30% nas principais consultas da sua categoria. Marcas líderes em segmentos competitivos alcançam mais de 50%.

Acompanhe o Share of Voice em IA (AI SOV) rodando prompts idênticos e calculando sua porcentagem de menções de marca. Se você aparece em 3 de 10 respostas de IA e concorrentes em 2 cada, seu SOV em IA é 30%. Em mercados competitivos, busque SOV em IA acima de sua fatia tradicional de mercado em 10-20%.

Monitore análise de sentimento. Além de ser citado, rastreie se as descrições feitas pela IA são positivas, neutras ou negativas. Use ferramentas como Profound AI, especializadas em detecção de alucinações — identificando quando a IA fornece informações falsas ou desatualizadas sobre sua marca. Busque 70%+ de sentimento positivo nas plataformas de IA.

Configure um dashboard de Indicador Baseado em Conhecimento (KBI) acompanhando:

Atualize esses indicadores mensalmente. Observe tendências, não apenas pontos isolados. Um mês ruim pode ser ruído. Três meses de queda nas citações indicam problema que precisa de investigação e resposta.

Rastrear citações de dados proprietários manualmente é trabalhoso e sujeito a erros. O AmICited.com fornece infraestrutura para monitorar sua visibilidade em IA em escala, especialmente para marcas que usam dados proprietários como estratégia de citação.

A plataforma monitora como sistemas de IA citam sua pesquisa proprietária em ChatGPT, Perplexity, Google AI Overviews, Claude, Gemini e novas plataformas de IA. Em vez de consultar manualmente cada plataforma, o AmICited automatiza o processo, rodando seus prompts-alvo continuamente e rastreando padrões de citação em tempo real.

Destaques incluem:

A plataforma integra-se à sua stack analítica, alimentando dados de citações de IA nos dashboards de marketing junto com métricas tradicionais de SEO. Essa visão unificada mostra o impacto total da estratégia de dados proprietários na visibilidade da marca e geração de pipeline.

Para marcas sérias sobre visibilidade em IA, o AmICited fornece a infraestrutura de medição essencial à otimização. Não se pode melhorar o que não se mede, e ferramentas tradicionais nunca foram pensadas para rastrear citações em LLM. O AmICited preenche essa lacuna, dando a visibilidade necessária para maximizar o ROI dos investimentos em dados proprietários.

Mesmo estratégias bem intencionadas com dados proprietários frequentemente falham por erros evitáveis. Entender esses riscos ajuda a preveni-los.

O erro mais comum é esconder dados atrás de formulários “Fale com Vendas”. LLMs não acessam conteúdos bloqueados, recorrendo a informações incompletas ou especulativas de fóruns. Se suas descobertas estão ocultas, LLMs citarão discussões no Reddit sobre seu produto em vez de sua pesquisa oficial. Publique resultados-chave publicamente com metodologia transparente. Você pode restringir relatórios detalhados, mantendo dados resumidos e insights abertos.

Terminologia inconsistente entre plataformas causa confusão. Se seu site chama o produto de “plataforma de automação de marketing” e seu LinkedIn de “software de CRM”, LLMs têm dificuldade em construir entendimento coerente do negócio. Use linguagem de categoria consistente em todos os lugares. Defina seu mapa de termos e aplique uniformemente em site, LinkedIn, Crunchbase e demais plataformas.

Falta de credenciais de autor compromete a confiança. LLMs avaliam sinais E-E-A-T com atenção. Pesquisas sem bios de autores com credenciais reais são despriorizadas. Inclua bios detalhadas com experiência, certificações e publicações anteriores. Vincule perfis dos autores no LinkedIn e outras plataformas.

Estatísticas desatualizadas prejudicam a credibilidade. Se sua pesquisa é de 2023 e ainda é citada em 2025, LLMs percebem. Atualize pesquisas regularmente. Adicione marcações de “Última atualização”. Realize novos levantamentos anuais para manter a atualidade. LLMs preferem dados recentes, especialmente para temas sensíveis ao tempo.

Metodologia vaga reduz probabilidade de citação. Se a metodologia não for transparente, LLMs duvidam dos achados. Publique a metodologia abertamente. Explique tamanho de amostra, método de amostragem, período da pesquisa e limitações. Transparência gera confiança.

Keyword stuffing nos conteúdos de dados proprietários tem desempenho pior em IA do que em busca tradicional. LLMs detectam e penalizam linguagem artificial. Escreva naturalmente. Foque em clareza e precisão, não na densidade de palavras-chave. Seus dados devem soar como pesquisa genuína, não como texto de marketing.

Conteúdo raso em torno dos dados proprietários é penalizado. Um único parágrafo sobre os resultados não basta. Crie conteúdo abrangente explorando implicações, contexto e perguntas derivadas. Mire em 2.000+ palavras de substância para cada grande ativo de dados.

Exemplos reais demonstram o poder dos dados proprietários para visibilidade em IA. Essas marcas investiram em pesquisa original e colheram resultados mensuráveis.

O Sucesso em PR Digital da The Zebra: A The Zebra, plataforma comparadora de seguros, combinou pesquisa proprietária com PR Digital para gerar mais de 1.580 links qualificados e elevar o tráfego orgânico em 354%. Ao publicar pesquisa exclusiva sobre o setor e distribuí-la via mídia, a The Zebra virou fonte referência em dados de seguros. LLMs agora citam a pesquisa da Zebra em respostas sobre tendências e preços de seguros.

A Estratégia de Engajamento Comunitário da Tally: A Tally, criadora de formulários online, aumentou a visibilidade em IA ao engajar-se ativamente em fóruns e compartilhar seu roadmap. Em vez de só publicar pesquisas, tornou-se voz confiável nas comunidades de seus usuários. Esse engajamento autêntico fez do ChatGPT importante fonte de tráfego, impulsionando cadastros semanais. Ao fundamentar o GPT-4 com evidências contextuais, a Tally elevou a precisão factual de 56% para 89%.

O Programa Contínuo de Pesquisa da HubSpot: A HubSpot publica relatórios regulares sobre tendências de marketing, vendas e atendimento. Esses relatórios viraram padrão do setor e são frequentemente citados por LLMs. O compromisso contínuo com pesquisa tornou a marca sinônimo de dados e insights de marketing. Quando LLMs respondem sobre tendências de marketing, os estudos da HubSpot aparecem consistentemente.

Todos os casos têm em comum: pesquisa original, metodologia transparente, distribuição consistente e atualizações contínuas. Nenhuma dessas marcas dependeu de um único projeto. Construíram programas de pesquisa que geram novos dados proprietários continuamente, criando vantagem sustentável de citação.

A lição é clara: dados proprietários não são tática pontual. São investimento estratégico para ser a fonte de autoridade do seu segmento. Marcas que apostam em pesquisa regular, metodologia transparente e distribuição estratégica conquistam citações recorrentes dos LLMs e criam vantagem competitiva duradoura em visibilidade em IA.

Você não precisa de conjuntos de dados massivos. Mesmo uma pesquisa focada com 100-500 respondentes pode fornecer insights proprietários valiosos que os LLMs irão citar. O essencial é que os dados sejam originais, a metodologia seja transparente e os achados sejam acionáveis. Qualidade e exclusividade importam mais que quantidade.

Pesquisas de satisfação do cliente, pesquisas de tendências do setor, análises competitivas, estudos de comportamento do usuário e pesquisas de dimensionamento de mercado apresentam ótimos resultados. Os melhores dados respondem a perguntas específicas que seu público-alvo está fazendo e fornecem insights que os concorrentes não têm.

Plataformas em tempo real como Perplexity podem citar dados recentes em poucas semanas. O ChatGPT e outros modelos com atualizações menos frequentes podem levar de 2 a 3 meses. Dados proprietários consistentes e de alta qualidade normalmente mostram aumentos mensuráveis nas citações em 3-6 meses.

Não. Os LLMs não conseguem acessar conteúdos bloqueados, então vão se basear em informações incompletas ou especulativas de fóruns. Publique os principais resultados publicamente com metodologia transparente. Você pode restringir relatórios detalhados enquanto mantém dados resumidos e insights disponíveis ao público.

Use terminologia clara e consistente em todas as plataformas. Inclua metodologia transparente em sua pesquisa. Adicione credenciais e certificações dos autores. Vincule a validações de terceiros. Use marcação de esquema para estruturar seus dados. Monitore citações mensalmente e corrija imprecisões rapidamente.

Sim. Pesquisas originais normalmente ganham backlinks e cobertura da mídia, o que melhora o ranqueamento tradicional. Além disso, dados proprietários criam conteúdo mais completo e autoritativo, ajudando tanto no SEO tradicional quanto na visibilidade em IA.

Dados proprietários são pesquisas originais realizadas por você. Relatórios genéricos estão amplamente disponíveis. Os LLMs preferem dados proprietários porque são únicos e só podem ser citados da sua fonte. Isso cria uma vantagem de citação que os concorrentes não conseguem replicar facilmente.

Acompanhe a frequência de citações, participação de voz em IA, volume de buscas pela marca e tráfego vindo de plataformas de IA. Compare esses indicadores antes e depois de publicar os dados proprietários. Calcule o valor do tráfego referenciado por IA (geralmente taxa de conversão 4,4x maior que o orgânico tradicional) para determinar o ROI.

Monitore como sistemas de IA citam seus dados proprietários no ChatGPT, Perplexity, Google AI Overviews e mais. Obtenha insights em tempo real sobre sua visibilidade em IA e posicionamento competitivo.

Aprenda como criar pesquisas originais e conteúdos de PR orientados por dados que sistemas de IA citam ativamente. Descubra os 5 atributos de conteúdos dignos d...

Aprenda como citações de especialistas aumentam a visibilidade da sua marca em mecanismos de busca por IA como ChatGPT e Perplexity. Descubra estratégias para c...

Saiba como funciona a autoridade de citação em respostas geradas por IA, como diferentes plataformas citam fontes e por que isso é importante para a visibilidad...