A Visão de Longo Prazo para a Visibilidade em IA: Para Onde Estamos Indo

Explore o futuro do monitoramento da visibilidade em IA, desde padrões de transparência até conformidade regulatória. Descubra como as marcas podem se preparar ...

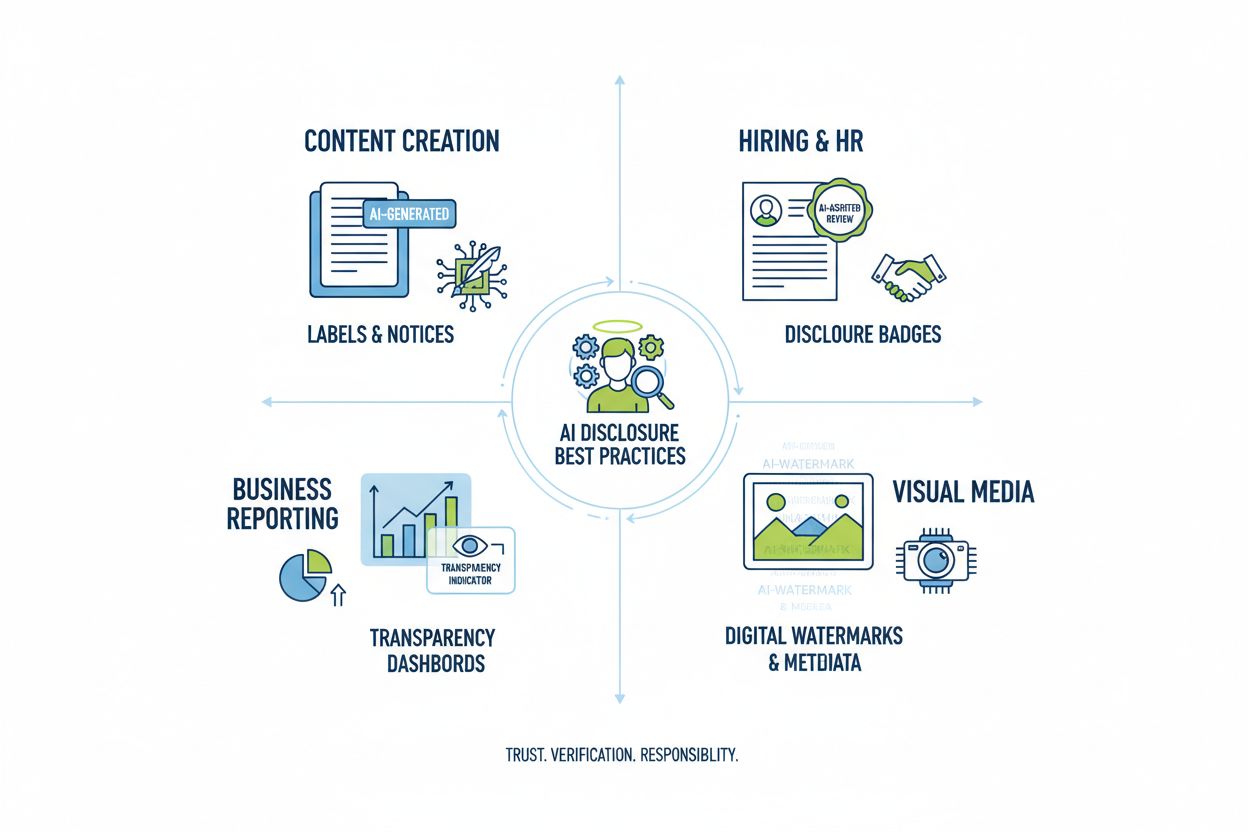

Aprenda as melhores práticas essenciais de transparência e divulgação em IA. Descubra métodos comportamentais, verbais e técnicos de divulgação para construir confiança e garantir conformidade com regulamentos de IA em evolução.

A transparência em IA tornou-se uma prioridade crítica numa era em que sistemas de inteligência artificial influenciam tudo, desde a criação de conteúdo até decisões de contratação e recomendações financeiras. À medida que o conteúdo gerado por IA se prolifera nas plataformas digitais, as organizações enfrentam uma pressão crescente para divulgar quando e como usam essas tecnologias, não apenas como obrigação legal, mas como requisito fundamental para manter a confiança e credibilidade com seus públicos. Os riscos são especialmente altos para marcas e criadores de conteúdo, já que consumidores exigem cada vez mais saber se a informação consumida tem origem em expertise humana ou geração algorítmica. Sem práticas de divulgação transparentes, as organizações correm o risco de minar a confiança construída ao longo dos anos, enfrentando possíveis danos reputacionais, penalidades regulatórias e perda de confiança do público. A relação entre transparência e credibilidade é simbiótica—organizações que divulgam proativamente seu uso de IA demonstram integridade e respeito por seus stakeholders, posicionando-se como agentes honestos num cenário cada vez mais orientado por IA.

A proliferação de conteúdo gerado por IA criou um profundo paradoxo de confiança: o público tem dificuldade em distinguir entre trabalho autêntico criado por humanos e alternativas sofisticadas geradas por IA, enquanto a transparência sobre o uso de IA permanece inconsistente entre setores. Essa confusão mina o contrato fundamental entre criadores e consumidores, em que o público espera saber a verdadeira origem do conteúdo que consome. Quando conteúdo gerado por IA é apresentado sem divulgação, viola esse acordo implícito, criando uma dicotomia “real vs. falso” que vai além de preocupações de autenticidade—envolve questões de engano, manipulação e consentimento informado. O paradoxo se aprofunda porque parte do conteúdo gerado por IA pode ser indistinguível do trabalho humano em qualidade e estilo, tornando pistas visuais ou estilísticas indicadores pouco confiáveis de origem. A transparência importa justamente porque resolve esse paradoxo, fornecendo ao público a informação necessária para tomar decisões informadas sobre o que consome e em quem confia. Organizações que adotam práticas claras de divulgação transformam o ceticismo potencial em confiança, demonstrando que não têm nada a esconder e tudo a ganhar com comunicação honesta.

O ambiente regulatório em torno da divulgação de IA está evoluindo rapidamente, com diversas jurisdições implementando ou propondo exigências que as organizações devem navegar com cautela. O AI Act da UE, um dos marcos mais abrangentes, exige que conteúdo gerado ou fortemente editado por IA inclua divulgação visível ou em nível de metadados, com requisitos específicos para sistemas de IA de alto risco e obrigações de transparência para desenvolvedores. Nos Estados Unidos, a FTC emitiu alertas de que deixar de atualizar Termos de Uso e Políticas de Privacidade para uso de IA pode constituir prática enganosa, enquanto regulações estaduais—especialmente a recente lei de divulgação de modelos de IA da Califórnia—impõem obrigações reforçadas de transparência e reporte para desenvolvedores de grandes sistemas de IA. Direitos autorais e propriedade intelectual adicionam outra camada de complexidade, pois as organizações devem divulgar se dados de treinamento incluíram material protegido e como sistemas de IA foram treinados. Além disso, requisitos como GDPR e CCPA se estendem a sistemas de IA que processam dados pessoais, exigindo que organizações divulguem decisões automatizadas e forneçam informações significativas sobre o processamento por IA. A tabela a seguir resume requisitos regulatórios chave em principais jurisdições:

| Jurisdição | Regulamento | Requisitos Principais | Data de Vigência |

|---|---|---|---|

| União Europeia | AI Act da UE | Divulgação para IA de alto risco; relatórios de transparência; rotulagem por metadados para conteúdo gerado por IA | Fases (2024-2026) |

| Estados Unidos (Federal) | Diretrizes FTC | Atualizar políticas de privacidade; divulgar uso de IA; evitar práticas enganosas | Em andamento |

| Califórnia | AI Frontier Model Law | Divulgação padronizada; obrigações de reporte; medidas de segurança | 2025 |

| União Europeia | GDPR | Divulgar decisões automatizadas; fornecer informações sobre processamento por IA | Em andamento |

| Estados Unidos (Multiestatal) | CCPA e similares | Divulgar uso de dados em sistemas de IA; fornecer mecanismos de opt-out | Varia por estado |

| Internacional | Considerações de Direitos Autorais | Divulgar fontes de dados de treinamento; abordar direitos autorais em resultados de IA | Emergente |

Organizações que atuam em múltiplas jurisdições devem implementar práticas de divulgação que atendam aos requisitos mais rigorosos, já que a conformidade com um padrão geralmente supera o mínimo exigido por outros.

Sinais comportamentais representam a forma mais sutil e, ainda assim, poderosa de divulgação de IA, operando por meio da apresentação, estilo, voz e escolhas criativas que o público processa inconscientemente ao avaliar a autenticidade do conteúdo. Esses sinais incluem padrões distintos de estilo de escrita, consistência de voz, escolhas visuais de composição, características de avatar ou persona e a “fidelidade” geral da representação do criador—essencialmente, o grau em que o conteúdo reflete personalidade e decisão humana genuínas. Por exemplo, textos gerados por IA frequentemente apresentam padrões específicos na estrutura das frases, nas escolhas de vocabulário e no fluxo lógico que diferem da escrita humana, enquanto imagens de IA podem exibir sutis inconsistências de iluminação, anatomia ou detalhes de fundo que observadores treinados conseguem perceber. O conceito de fidelidade do criador é central aqui: o público desenvolve expectativas sobre como determinado criador deve soar, parecer e se apresentar, e desvios desse padrão estabelecido podem sinalizar envolvimento de IA. No entanto, depender apenas de sinais comportamentais é problemático, pois sistemas de IA estão rapidamente melhorando em imitar características humanas, e não se pode esperar que o público se torne especialista em forense de IA. Portanto, sinais comportamentais devem complementar, e não substituir, métodos explícitos de divulgação, servindo como camada secundária de transparência que reforça, mas não substitui, a comunicação clara e direta sobre o uso de IA.

Estratégias de divulgação verbal fornecem comunicação explícita e direta sobre o uso de IA por meio de sinais baseados em linguagem que não deixam ambiguidade sobre a origem do conteúdo e o envolvimento da IA. Esses métodos são essenciais porque criam um registro claro e documentado de divulgação, garantindo que o público receba informações inequívocas sobre o uso de IA. Organizações podem implementar a divulgação verbal de diversas formas complementares:

A adequação de cada método depende do contexto: rótulos funcionam bem para redes sociais e conteúdo visual, marcas d’água para vídeo e áudio, assinaturas para trabalho jornalístico e criativo, campos de divulgação para conteúdo de formato longo, e agradecimentos fornecem contexto detalhado para projetos complexos. Organizações devem escolher métodos de divulgação que correspondam ao formato do conteúdo e às expectativas do público, garantindo que a divulgação seja impossível de ignorar, mas sem ser intrusiva para a experiência do usuário.

Sinais técnicos e metadados fornecem informações padronizadas e legíveis por máquina sobre o envolvimento de IA, possibilitando detecção, verificação e rastreamento automatizados de conteúdo gerado por IA em ecossistemas digitais. Essas abordagens utilizam dados incorporados e técnicas criptográficas para criar registros permanentes e resistentes a alterações da origem e histórico de processamento do conteúdo. Os padrões IPTC, recentemente atualizados para incluir propriedades específicas de IA, permitem que criadores incorporem informações estruturadas sobre o uso de IA diretamente em arquivos de imagem, incluindo detalhes sobre quais sistemas de IA foram usados, que processamento foi aplicado e quais modificações humanas foram feitas. A C2PA (Coalition for Content Provenance and Authenticity) representa um padrão emergente da indústria que utiliza assinaturas criptográficas e credenciais de conteúdo para estabelecer cadeias verificáveis de custódia de conteúdo digital, permitindo ao público rastrear o conteúdo até sua fonte original e entender todas as modificações aplicadas. Essas abordagens técnicas resolvem uma limitação crítica da divulgação legível por humanos: criam registros permanentes e verificáveis que não podem ser facilmente removidos ou alterados, e permitem que sistemas automatizados identifiquem e sinalizem conteúdo gerado por IA em escala. Organizações que implementam divulgação técnica devem considerar a adoção de credenciais C2PA para conteúdos de alto valor, incorporar metadados IPTC em imagens e arquivos de mídia, e manter documentação detalhada de tipo de fonte digital que rastreia o envolvimento de IA ao longo do ciclo de vida do conteúdo. A vantagem dos sinais técnicos é sua permanência e verificabilidade; o desafio é garantir que o público e as plataformas compreendam e respeitem esses sinais.

O sucesso na divulgação de IA exige institucionalizar práticas de transparência em todos os fluxos de trabalho de criação de conteúdo, transformando a divulgação de um pensamento tardio para um componente fundamental da governança de conteúdo. Organizações devem implementar estruturas de conteúdo estruturado que capturem o envolvimento de IA em cada etapa da criação—desde pesquisa e rascunho iniciais até edição e publicação—garantindo que as informações de divulgação fluam naturalmente pelos sistemas de gestão de conteúdo existentes. Automação e integração de workflow são essenciais: sistemas de gestão de conteúdo devem incluir campos obrigatórios para divulgação de IA, alertas automáticos que exijam documentação do uso de IA antes da publicação e fluxos de aprovação que verifiquem a completude da divulgação antes do conteúdo ir ao ar. Essa abordagem trata a divulgação como requisito de garantia da qualidade, e não como complemento opcional, assim como organizações gerenciam checagem de fatos, revisão jurídica ou conformidade de marca. Organizações também devem estabelecer políticas claras definindo o que constitui uso de IA que exige divulgação (ex: o uso de IA para pesquisa requer divulgação? E edição assistida por IA?), garantindo consistência entre equipes e evitando lacunas na divulgação. Treinamento e documentação são igualmente importantes: criadores de conteúdo precisam de orientações claras sobre como divulgar o uso de IA de forma apropriada para diferentes tipos de conteúdo e plataformas. Ao incorporar a divulgação em modelos e fluxos de trabalho de conteúdo, organizações transformam a transparência de um fardo de conformidade em procedimento padrão que protege tanto a organização quanto seu público.

Diferentes aplicações de IA exigem abordagens de divulgação adaptadas, levando em conta contexto, expectativas do público e requisitos regulatórios. Criação de conteúdo (artigos, redes sociais, textos de marketing) deve incluir rótulos claros ou modificações em assinaturas indicando o envolvimento de IA, com campos de divulgação adicionais explicando quais ferramentas de IA foram usadas e qual supervisão humana foi aplicada; isso é especialmente importante para notícias e conteúdo editorial, onde a confiança do público depende de entender a origem do conteúdo. Contextos de contratação e recrutamento exigem a divulgação mais rigorosa, pois candidatos têm direito de saber quando sistemas de IA avaliam suas candidaturas ou realizam triagens iniciais, com explicações detalhadas sobre como decisões são tomadas por IA e quais processos de revisão humana são aplicados. Relatórios e análises (relatórios financeiros, pesquisa de mercado, análise de dados) devem incluir divulgações técnicas e metadados indicando quais análises foram assistidas por IA, especialmente quando sistemas de IA identificam padrões ou geram insights que influenciam conclusões. Conteúdo visual (imagens, vídeos, gráficos) requer tanto marcas d’água visuais quanto divulgação via metadados, já que o público não consegue distinguir de forma confiável visuais gerados por IA dos autênticos; isso é fundamental em fotografia jornalística, imagens de produtos e qualquer conteúdo em que a autenticidade afete decisões de compra ou confiança. Comunicações com o cliente (chatbots, respostas automáticas, atendimento) devem identificar claramente o envolvimento de IA no início das interações, permitindo que clientes solicitem atendimento humano, se desejarem. Organizações devem auditar o uso de IA nesses contextos e implementar práticas de divulgação proporcionais à sensibilidade e impacto de cada caso, reconhecendo que as exigências de transparência variam conforme o efeito das decisões de IA sobre o público.

O futuro da divulgação em IA depende da padronização em toda a indústria e do desenvolvimento de estruturas interoperáveis que permitam transparência consistente e comparável entre organizações e plataformas. Padrões emergentes como C2PA, especificações de metadados IPTC e o Framework de Gestão de Riscos em IA do NIST oferecem estruturas fundamentais, mas a adoção ampla requer esforço coordenado de plataformas tecnológicas, criadores de conteúdo, reguladores e entidades do setor. O AI Act da UE e estruturas regulatórias similares impulsionam a padronização ao exigir formatos específicos de divulgação e categorias de informação, criando pressão para adoção de padrões comuns em vez de abordagens idiossincráticas. Iniciativas do setor como as diretrizes éticas de IA da PRSA e diversos frameworks de relatórios de transparência demonstram consenso crescente sobre melhores práticas de divulgação, embora a adesão voluntária permaneça inconsistente. O próximo passo crítico envolve a transição de padrões voluntários para exigências regulatórias que obriguem a divulgação padronizada, assim como os rótulos nutricionais da FDA padronizaram a transparência em alimentos. Plataformas de monitoramento e visibilidade—como o AmICited.com—desempenham papel cada vez mais importante nesse ecossistema, rastreando como a IA referencia marcas e conteúdos em respostas geradas por IA, oferecendo às organizações visibilidade sobre como seu trabalho aparece em resultados de IA e se a atribuição e divulgação estão ocorrendo corretamente. À medida que sistemas de IA se tornam mais sofisticados e onipresentes, a capacidade de monitorar, verificar e auditar práticas de divulgação em IA torna-se essencial para manter a confiança nos ecossistemas digitais de informação. Organizações que investem hoje em práticas robustas de divulgação e monitoramento estarão melhor posicionadas para navegar pelo cenário regulatório em evolução e manter a confiança do público num futuro dominado pela IA.

A divulgação comportamental utiliza escolhas de apresentação (estilo, voz, avatar) para sinalizar o envolvimento de IA. A divulgação verbal utiliza declarações explícitas, rótulos e marcas d'água. A divulgação técnica incorpora metadados legíveis por máquina e assinaturas criptográficas. Cada método atende a diferentes públicos e contextos, e as organizações devem usar múltiplos métodos em conjunto para uma transparência abrangente.

Os requisitos legais variam conforme a jurisdição. O AI Act da UE exige divulgação para sistemas de IA de alto risco. A FTC exige divulgação quando o uso de IA pode afetar decisões do consumidor. Leis estaduais como a AI Frontier Model Law da Califórnia impõem obrigações de reporte. A lei de direitos autorais exige divulgação de conteúdo gerado por IA. Organizações devem consultar assessoria jurídica para requisitos específicos de cada jurisdição.

Imagens geradas por IA devem incluir tanto marcas d'água visuais quanto divulgação via metadados. As marcas d'água devem ser visíveis, porém discretas, indicando claramente a geração por IA. Os metadados devem incluir informações digitais do tipo de fonte IPTC e credenciais C2PA, quando disponíveis. Legendas e campos de divulgação devem declarar explicitamente que imagens são geradas por IA, especialmente em conteúdos de notícias, produtos ou promocionais.

Os padrões IPTC fornecem campos estruturados de metadados para documentar o uso de IA em imagens e arquivos de mídia. Eles permitem a detecção e o rastreamento automatizados de conteúdo gerado por IA em diferentes plataformas. As categorias de tipo de fonte digital IPTC incluem 'Mídia Algorítmica Treinada', 'Sintético Composto' e 'Mídia Algorítmica'. Esses padrões são importantes porque criam registros permanentes e verificáveis do envolvimento de IA que não podem ser facilmente removidos ou alterados.

As empresas devem realizar uma auditoria de IA para identificar todos os casos de uso, implementar políticas de divulgação alinhadas aos regulamentos aplicáveis, integrar a divulgação nos fluxos de trabalho de gestão de conteúdo, treinar equipes sobre requisitos de divulgação e monitorar a conformidade regularmente. Consultar especialistas jurídicos familiarizados com regulamentos de IA em sua jurisdição é essencial, pois os requisitos variam significativamente entre regiões.

As consequências incluem penalidades regulatórias (multas da FTC, violações de leis estaduais), danos reputacionais e perda de confiança do público, responsabilidade legal por infração de direitos autorais ou práticas enganosas, e possíveis processos judiciais de partes afetadas. Organizações que não divulgam o uso de IA correm o risco de minar a credibilidade construída ao longo de anos, tornando a divulgação proativa um investimento estratégico em confiança de longo prazo.

Diferentes partes interessadas precisam de níveis distintos de informação. O público geral precisa de declarações simples e claras sobre o envolvimento de IA. Reguladores precisam de documentação técnica detalhada e evidências de conformidade. Jornalistas e criadores de conteúdo precisam de informações específicas sobre ferramentas de IA e supervisão humana. Clientes precisam entender como a IA afeta sua experiência. Adapte o formato e o detalhamento da divulgação às necessidades e expectativas de cada público.

A C2PA (Coalition for Content Provenance and Authenticity) fornece credenciais criptográficas para verificação de conteúdo. Os padrões IPTC permitem a incorporação de metadados em imagens. Sistemas de gestão de conteúdo cada vez mais incluem campos de divulgação de IA. Plataformas de monitoramento como AmICited.com rastreiam referências e visibilidade de IA. Estruturas da indústria de PRSA, NIST e outros oferecem orientação. A adoção dessas ferramentas e padrões está acelerando à medida que os regulamentos se tornam mais rígidos.

Acompanhe como sistemas de IA referenciam sua marca em GPTs, Perplexity e Google AI Overviews. Garanta que seu conteúdo receba a devida atribuição e visibilidade em respostas geradas por IA.

Explore o futuro do monitoramento da visibilidade em IA, desde padrões de transparência até conformidade regulatória. Descubra como as marcas podem se preparar ...

Aprenda como realizar uma auditoria de visibilidade em IA de linha de base para entender como ChatGPT, Google IA e Perplexity mencionam sua marca. Guia de avali...

Aprenda a criar um roteiro de visibilidade em IA com metas trimestrais e marcos GEO. Tenha acesso a um modelo, melhores práticas e ferramentas para monitorar su...