Ajuste Fino de Modelo de IA

Saiba como o ajuste fino de modelos de IA adapta modelos pré-treinados para tarefas específicas de setores e marcas, melhorando a precisão ao mesmo tempo em que...

Parâmetros do modelo são variáveis aprendidas dentro de modelos de IA, como pesos e vieses, que são ajustados automaticamente durante o treinamento para otimizar a capacidade do modelo de fazer previsões precisas e definem como o modelo processa os dados de entrada para gerar saídas.

Parâmetros do modelo são variáveis aprendidas dentro de modelos de IA, como pesos e vieses, que são ajustados automaticamente durante o treinamento para otimizar a capacidade do modelo de fazer previsões precisas e definem como o modelo processa os dados de entrada para gerar saídas.

Parâmetros do modelo são variáveis aprendidas dentro de modelos de inteligência artificial que são ajustadas automaticamente durante o processo de treinamento para otimizar a capacidade do modelo de fazer previsões precisas e definir como o modelo processa dados de entrada para gerar saídas. Esses parâmetros servem como os “botões de controle” fundamentais dos sistemas de aprendizado de máquina, determinando o comportamento e os padrões de tomada de decisão precisos dos modelos de IA. No contexto de deep learning e redes neurais, os parâmetros consistem principalmente em pesos e vieses—valores numéricos que controlam como a informação flui pela rede e quão fortemente diferentes características influenciam as previsões. O objetivo do treinamento é descobrir os valores ótimos para esses parâmetros que minimizem os erros de previsão e permitam ao modelo generalizar bem para novos dados ainda não vistos. Compreender os parâmetros do modelo é essencial para entender como sistemas modernos de IA como ChatGPT, Claude, Perplexity e Google AI Overviews funcionam e por que produzem diferentes saídas para a mesma entrada.

O conceito de parâmetros aprendidos em aprendizado de máquina remonta aos primórdios das redes neurais artificiais nas décadas de 1950 e 1960, quando pesquisadores perceberam que redes poderiam ajustar valores internos para aprender com dados. No entanto, a aplicação prática dos parâmetros permaneceu limitada até o surgimento da retropropagação nos anos 1980, que forneceu um algoritmo eficiente para calcular como ajustar parâmetros para reduzir erros. A explosão no número de parâmetros acelerou dramaticamente com o avanço do deep learning na década de 2010. Redes neurais convolucionais iniciais para reconhecimento de imagens continham milhões de parâmetros, enquanto modernos grandes modelos de linguagem (LLMs) contêm centenas de bilhões ou até trilhões de parâmetros. Segundo pesquisas da Our World in Data e da Epoch AI, o número de parâmetros em sistemas de IA notáveis cresceu exponencialmente, com o GPT-3 contendo 175 bilhões de parâmetros, o GPT-4o cerca de 200 bilhões e algumas estimativas sugerindo que o GPT-4 pode conter até 1,8 trilhão de parâmetros, considerando arquiteturas mixture-of-experts. Essa escalada dramática transformou fundamentalmente o que sistemas de IA podem realizar, permitindo capturar padrões cada vez mais complexos em linguagem, visão e tarefas de raciocínio.

Os parâmetros do modelo operam por meio de uma estrutura matemática onde cada parâmetro representa um valor numérico que influencia como o modelo transforma entradas em saídas. Em um modelo simples de regressão linear, os parâmetros consistem na inclinação (m) e no intercepto (b) na equação y = mx + b, onde esses dois valores determinam a linha que melhor se ajusta aos dados. Em redes neurais, a situação se torna exponencialmente mais complexa. Cada neurônio em uma camada recebe entradas da camada anterior, multiplica cada entrada por um peso correspondente, soma essas entradas ponderadas, adiciona um parâmetro de viés e passa o resultado por uma função de ativação para produzir uma saída. Essa saída então se torna a entrada para os neurônios da próxima camada, criando uma cadeia de transformações impulsionadas por parâmetros. Durante o treinamento, o modelo utiliza descida do gradiente e algoritmos de otimização relacionados para calcular como cada parâmetro deve ser ajustado para reduzir a função de perda—uma medida matemática do erro de previsão. O gradiente da perda em relação a cada parâmetro indica a direção e a magnitude do ajuste necessário. Por meio da retropropagação, esses gradientes fluem de volta pela rede, permitindo que o otimizador atualize todos os parâmetros simultaneamente de forma coordenada. Esse processo iterativo continua por várias épocas de treinamento até que os parâmetros convirjam para valores que minimizam a perda nos dados de treinamento, mantendo boa generalização para novos dados.

| Aspecto | Parâmetros do Modelo | Hiperparâmetros | Características |

|---|---|---|---|

| Definição | Variáveis aprendidas ajustadas durante o treinamento | Configurações definidas antes do treinamento | Características dos dados de entrada usadas pelo modelo |

| Quando são Definidos | Aprendidos automaticamente via otimização | Configurados manualmente por praticantes | Extraídos ou criados a partir dos dados brutos |

| Exemplos | Pesos, vieses em redes neurais | Taxa de aprendizado, tamanho do batch, número de camadas | Valores de pixels em imagens, embeddings de palavras em texto |

| Impacto no Modelo | Determinam como o modelo mapeia entradas para saídas | Controlam o processo de treinamento e estrutura do modelo | Fornecem as informações brutas que o modelo aprende |

| Método de Otimização | Descida do gradiente, Adam, AdaGrad | Grid search, random search, otimização Bayesiana | Engenharia de características, seleção de características |

| Quantidade em Grandes Modelos | Bilhões a trilhões (ex: 200B no GPT-4o) | Tipicamente 5-20 hiperparâmetros chave | Milhares a milhões dependendo dos dados |

| Custo Computacional | Alto durante o treinamento; impacta a velocidade de inferência | Custo computacional mínimo para configuração | Determinado pela coleta e pré-processamento dos dados |

| Transferibilidade | Pode ser transferido via fine-tuning e aprendizado por transferência | Precisa ser ajustado para novas tarefas | Pode exigir reengenharia para novos domínios |

Os parâmetros do modelo assumem formas diferentes dependendo da arquitetura e do tipo de modelo de aprendizado de máquina utilizado. Em redes neurais convolucionais (CNNs) usadas para reconhecimento de imagens, os parâmetros incluem os pesos nos filtros de convolução (também chamados de kernels) que detectam padrões espaciais como bordas, texturas e formas em diferentes escalas. Redes neurais recorrentes (RNNs) e redes LSTM (Long Short-Term Memory) contêm parâmetros que controlam o fluxo de informação ao longo do tempo, incluindo parâmetros de portas que determinam o que lembrar ou esquecer. Modelos transformer, que alimentam modernos grandes modelos de linguagem, contêm parâmetros em múltiplos componentes: pesos de atenção que determinam em quais partes da entrada focar, pesos das redes feed-forward e parâmetros de normalização de camadas. Em modelos probabilísticos como Naive Bayes, os parâmetros definem distribuições de probabilidade condicionais. Máquinas de vetores de suporte (SVMs) usam parâmetros que posicionam e orientam limites de decisão no espaço das características. Modelos Mixture of Experts (MoE), usados em algumas versões do GPT-4, contêm parâmetros para múltiplas sub-redes especializadas mais parâmetros de roteamento que determinam quais especialistas processam cada entrada. Essa diversidade arquitetural significa que a natureza e a quantidade de parâmetros varia significativamente entre diferentes tipos de modelo, mas o princípio fundamental permanece: parâmetros são os valores aprendidos que permitem ao modelo realizar sua tarefa.

Pesos e vieses representam os dois tipos fundamentais de parâmetros em redes neurais e formam a base de como esses modelos aprendem. Pesos são valores numéricos atribuídos às conexões entre neurônios, determinando a força e a direção da influência que a saída de um neurônio exerce sobre a entrada do próximo. Em uma camada totalmente conectada com 1.000 neurônios de entrada e 500 de saída, haveria 500.000 parâmetros de peso—um para cada conexão. Durante o treinamento, os pesos são ajustados para aumentar ou diminuir a influência de características específicas nas previsões. Um peso positivo grande significa que a característica ativa fortemente o próximo neurônio, enquanto um peso negativo inibe. Vieses são parâmetros adicionais, um por neurônio em uma camada, que proporcionam um deslocamento constante à soma de entradas do neurônio antes da função de ativação ser aplicada. Matematicamente, se um neurônio recebe entradas ponderadas que somam zero, o viés permite que o neurônio ainda produza uma saída diferente de zero, proporcionando flexibilidade crucial. Essa flexibilidade permite que as redes neurais aprendam limites de decisão complexos e capturem padrões que não seriam possíveis apenas com pesos. Em um modelo com 200 bilhões de parâmetros como o GPT-4o, a grande maioria são pesos nos mecanismos de atenção e redes feed-forward, com os vieses constituindo uma parte menor, mas ainda significativa. Juntos, pesos e vieses permitem ao modelo aprender padrões intrincados em linguagem, visão ou outros domínios que tornam os sistemas de IA modernos tão poderosos.

O número de parâmetros em um modelo tem um impacto profundo em sua capacidade de aprender padrões complexos e em seu desempenho geral. Pesquisas mostram consistentemente que leis de escala regem a relação entre quantidade de parâmetros, tamanho dos dados de treinamento e desempenho do modelo. Modelos com mais parâmetros podem representar funções mais complexas e capturar padrões mais sutis nos dados, geralmente levando a melhor desempenho em tarefas desafiadoras. O GPT-3, com 175 bilhões de parâmetros, demonstrou habilidades notáveis de few-shot learning que modelos menores não conseguiam igualar. O GPT-4o, com 200 bilhões de parâmetros, mostra avanços adicionais em raciocínio, geração de código e compreensão multimodal. No entanto, a relação entre parâmetros e desempenho não é linear e depende criticamente da quantidade e qualidade dos dados de treinamento. Um modelo com parâmetros demais em relação aos dados tende a sofrer overfitting, memorizando exemplos específicos ao invés de aprender padrões generalizáveis, resultando em desempenho ruim em dados novos. Por outro lado, um modelo com poucos parâmetros pode sofrer underfitting, não capturando padrões importantes e atingindo desempenho subótimo até mesmo nos dados de treinamento. A quantidade ótima de parâmetros para uma tarefa depende de fatores como a complexidade da tarefa, o tamanho e diversidade do conjunto de treinamento e restrições computacionais. Pesquisas da Epoch AI mostram que sistemas modernos de IA atingiram desempenhos notáveis através da escala massiva, com alguns modelos contendo trilhões de parâmetros quando se consideram arquiteturas mixture-of-experts, nas quais nem todos os parâmetros estão ativos para cada entrada.

Embora grandes modelos com bilhões de parâmetros consigam desempenho impressionante, o custo computacional de treinar e implantar tais modelos é substancial. Isso motivou pesquisas em métodos de fine-tuning eficiente em parâmetros, que permitem adaptar modelos pré-treinados a novas tarefas sem atualizar todos os parâmetros. LoRA (Low-Rank Adaptation) é uma técnica importante que congela a maioria dos parâmetros pré-treinados e apenas treina um pequeno conjunto de matrizes adicionais de baixa rank, reduzindo o número de parâmetros treináveis em ordens de magnitude sem perder desempenho. Por exemplo, ao fazer fine-tuning em um modelo de 7 bilhões de parâmetros com LoRA, pode ser necessário treinar apenas 1-2 milhões de parâmetros adicionais, ao invés de todos os 7 bilhões. Módulos Adapter inserem pequenas redes treináveis entre camadas de um modelo pré-treinado congelado, adicionando apenas uma pequena porcentagem de parâmetros e permitindo adaptação para tarefas específicas. Engenharia de prompts e aprendizado em contexto representam abordagens alternativas que não modificam os parâmetros, mas usam os parâmetros existentes do modelo de forma mais eficaz através de entradas cuidadosamente elaboradas. Essas abordagens eficientes em parâmetros democratizaram o acesso a grandes modelos de linguagem, permitindo que organizações com recursos computacionais limitados personalizem modelos de ponta para suas necessidades. O equilíbrio entre eficiência de parâmetros e desempenho permanece um tema ativo de pesquisa, com profissionais ponderando o desejo de eficiência computacional contra a necessidade de precisão em tarefas específicas.

Compreender os parâmetros do modelo é crucial para plataformas como a AmICited, que monitoram como marcas e domínios aparecem em respostas geradas por IA em sistemas como ChatGPT, Perplexity, Claude e Google AI Overviews. Diferentes modelos de IA com diferentes configurações de parâmetros produzem diferentes resultados para a mesma consulta, influenciando onde e como as marcas são mencionadas. Os 200 bilhões de parâmetros do GPT-4o estão configurados de forma diferente dos parâmetros do Claude 3.5 Sonnet ou dos modelos do Perplexity, levando a variações na geração das respostas. Parâmetros aprendidos em treinamentos com diferentes conjuntos de dados e objetivos causam diferenças no conhecimento, padrões de raciocínio e comportamentos de citação dos modelos. Ao monitorar menções de marcas em respostas de IA, entender que essas diferenças decorrem de variações nos parâmetros ajuda a explicar por que uma marca pode ser destacada em uma resposta de um sistema de IA e mal mencionada em outro. Os parâmetros que controlam mecanismos de atenção determinam quais partes dos dados de treinamento do modelo são mais relevantes para uma consulta, influenciando padrões de citação. Parâmetros nas camadas de geração de saída determinam como o modelo estrutura e apresenta informações. Ao rastrear como diferentes sistemas de IA com diferentes configurações de parâmetros mencionam marcas, a AmICited fornece insights sobre como o comportamento impulsionado por parâmetros afeta a visibilidade das marcas no cenário de busca movida por IA.

O futuro dos parâmetros do modelo está sendo moldado por tendências convergentes que vão alterar fundamentalmente como sistemas de IA são desenhados e implantados. Arquiteturas do tipo Mixture of Experts (MoE) representam uma evolução significativa, onde modelos contêm múltiplas sub-redes especializadas (experts) com parâmetros separados, e um mecanismo de roteamento determina quais experts processam cada entrada. Essa abordagem permite que modelos escalem para trilhões de parâmetros mantendo a eficiência computacional na inferência, já que nem todos os parâmetros estão ativos para cada entrada. O GPT-4 supostamente usa uma arquitetura MoE com 16 experts, cada um contendo 110 bilhões de parâmetros, totalizando 1,8 trilhão de parâmetros, mas usando apenas uma fração durante a inferência. Parâmetros esparsos e técnicas de poda estão sendo desenvolvidos para identificar e remover parâmetros menos importantes, reduzindo o tamanho do modelo sem sacrificar desempenho. Abordagens de aprendizado contínuo visam atualizar parâmetros de forma eficiente à medida que novos dados se tornam disponíveis, permitindo que modelos se adaptem sem re-treinamento completo. Aprendizado federado distribui o treinamento dos parâmetros em múltiplos dispositivos, preservando a privacidade e permitindo que organizações se beneficiem de treinamentos em larga escala sem centralizar dados sensíveis. O surgimento de pequenos modelos de linguagem (SLMs) com bilhões, ao invés de centenas de bilhões, de parâmetros sugere um futuro onde eficiência de parâmetros será tão importante quanto a quantidade bruta. À medida que sistemas de IA se integram a aplicações críticas, compreender e controlar os parâmetros do modelo será cada vez mais importante para garantir segurança, justiça e alinhamento com valores humanos. A relação entre quantidade de parâmetros e comportamento do modelo continuará sendo foco central da pesquisa em IA, com implicações que vão desde sustentabilidade computacional até a interpretabilidade e confiabilidade dos sistemas de IA.

Parâmetros do modelo são variáveis internas aprendidas durante o treinamento por meio de algoritmos de otimização como descida do gradiente, enquanto hiperparâmetros são configurações externas definidas antes do início do treinamento. Os parâmetros determinam como o modelo mapeia entradas para saídas, enquanto os hiperparâmetros controlam o próprio processo de treinamento, como taxa de aprendizado e número de épocas. Por exemplo, pesos e vieses em redes neurais são parâmetros, enquanto a taxa de aprendizado é um hiperparâmetro.

Modelos modernos de linguagem de grande porte contêm bilhões a trilhões de parâmetros. O GPT-4o contém aproximadamente 200 bilhões de parâmetros, enquanto o GPT-4o-mini possui cerca de 8 bilhões de parâmetros. O Claude 3.5 Sonnet também opera com centenas de bilhões de parâmetros. Esses grandes volumes de parâmetros permitem que esses modelos capturem padrões complexos na linguagem e gerem respostas sofisticadas e contextualmente relevantes em diversos tópicos.

Mais parâmetros aumentam a capacidade de um modelo de aprender padrões e relações complexas nos dados. Com parâmetros adicionais, os modelos podem representar características e interações mais sutis, levando a maior precisão nos dados de treinamento. No entanto, há um equilíbrio crítico: muitos parâmetros em relação aos dados de treinamento podem causar overfitting, onde o modelo memoriza ruídos ao invés de aprender padrões generalizáveis, resultando em desempenho ruim em dados novos e não vistos.

Os parâmetros do modelo são atualizados por meio de retropropagação e algoritmos de otimização como descida do gradiente. Durante o treinamento, o modelo faz previsões, calcula a perda (erro) entre as previsões e os valores reais, e depois calcula os gradientes que mostram como cada parâmetro contribuiu para esse erro. O otimizador então ajusta os parâmetros na direção que reduz a perda, repetindo esse processo em várias iterações de treinamento até que o modelo converge para valores ótimos.

Os pesos determinam a força das conexões entre os neurônios em redes neurais, controlando o quanto as características de entrada influenciam as saídas. Os vieses atuam como ajustadores de limiar, permitindo que neurônios sejam ativados mesmo quando as entradas ponderadas são zero, fornecendo flexibilidade e permitindo que o modelo aprenda padrões de base. Juntos, pesos e vieses formam os principais parâmetros aprendidos que possibilitam às redes neurais aproximar funções complexas e fazer previsões precisas.

Os parâmetros do modelo influenciam diretamente como sistemas de IA como ChatGPT, Perplexity e Claude processam e respondem a perguntas. Compreender a quantidade e a configuração dos parâmetros ajuda a explicar por que diferentes modelos de IA produzem diferentes respostas para o mesmo prompt. Para plataformas de monitoramento de marcas como a AmICited, rastrear como os parâmetros influenciam o comportamento do modelo é crucial para prever onde as marcas aparecem nas respostas de IA e entender a consistência entre diferentes sistemas de IA.

Sim, por meio de aprendizado por transferência, os parâmetros de um modelo pré-treinado podem ser adaptados para novas tarefas. Essa abordagem, chamada de fine-tuning, envolve pegar um modelo com parâmetros aprendidos e ajustá-los em novos dados para aplicações específicas. Métodos de fine-tuning eficiente em parâmetros, como o LoRA (Low-Rank Adaptation), permitem atualizações seletivas de parâmetros, reduzindo custos computacionais sem perder desempenho. Esta técnica é amplamente usada para customizar grandes modelos de linguagem para domínios especializados.

Os parâmetros do modelo impactam diretamente os requisitos computacionais tanto no treinamento quanto na inferência. Mais parâmetros exigem mais memória, poder de processamento e tempo para treinar e implantar. Um modelo com 175 bilhões de parâmetros (como o GPT-3) demanda muito mais recursos computacionais do que um modelo com 7 bilhões de parâmetros. Essa relação é crítica para organizações que implantam sistemas de IA, pois a contagem de parâmetros influencia os custos de infraestrutura, latência e consumo de energia em ambientes de produção.

Comece a rastrear como os chatbots de IA mencionam a sua marca no ChatGPT, Perplexity e outras plataformas. Obtenha insights acionáveis para melhorar a sua presença de IA.

Saiba como o ajuste fino de modelos de IA adapta modelos pré-treinados para tarefas específicas de setores e marcas, melhorando a precisão ao mesmo tempo em que...

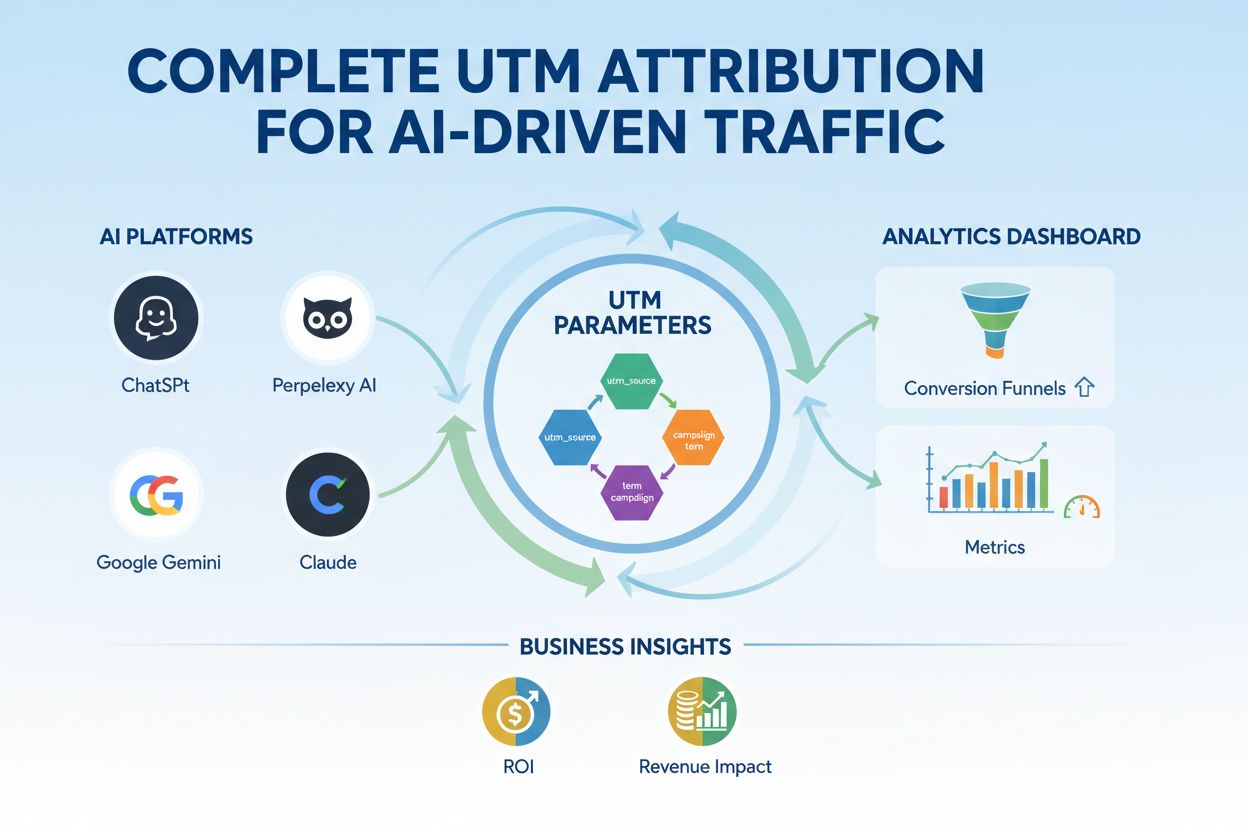

Domine o rastreamento UTM para plataformas de IA como ChatGPT, Perplexity e Google Gemini. Aprenda a configurar, melhores práticas e como atribuir o tráfego de ...

Saiba como as especificações de produtos aprimoram os sistemas de recomendação de IA ao fornecer dados estruturados, melhorar a precisão e permitir melhor perso...