Prevenirea crizelor de vizibilitate AI: strategii proactive

Află cum să previi crizele de vizibilitate AI prin monitorizare proactivă, sisteme de avertizare timpurie și protocoale strategice de răspuns. Protejează-ți bra...

Învață să detectezi crizele de vizibilitate AI din timp cu monitorizare în timp real, analiză a sentimentului și detectarea anomaliilor. Descoperă semne de avertizare și cele mai bune practici pentru a-ți proteja reputația brandului în mediul căutărilor cu AI.

O criză de vizibilitate AI apare atunci când sistemele de inteligență artificială produc rezultate inexacte, înșelătoare sau dăunătoare care afectează reputația brandului și erodează încrederea publicului. Spre deosebire de crizele tradiționale de PR generate de decizii sau acțiuni umane, crizele de vizibilitate AI apar la intersecția dintre calitatea datelor de antrenament, bias-ul algoritmic și generarea de conținut în timp real—ceea ce le face fundamental mai greu de prezis și controlat. Cercetări recente arată că 61% dintre consumatori și-au redus încrederea în branduri după ce au întâlnit halucinații AI sau răspunsuri false AI, iar 73% cred că firmele ar trebui trase la răspundere pentru ceea ce spun sistemele lor AI în mod public. Aceste crize se răspândesc mai rapid decât dezinformarea tradițională deoarece par autoritare, provin din canale oficiale ale brandului și pot afecta simultan mii de utilizatori înainte ca intervenția umană să fie posibilă.

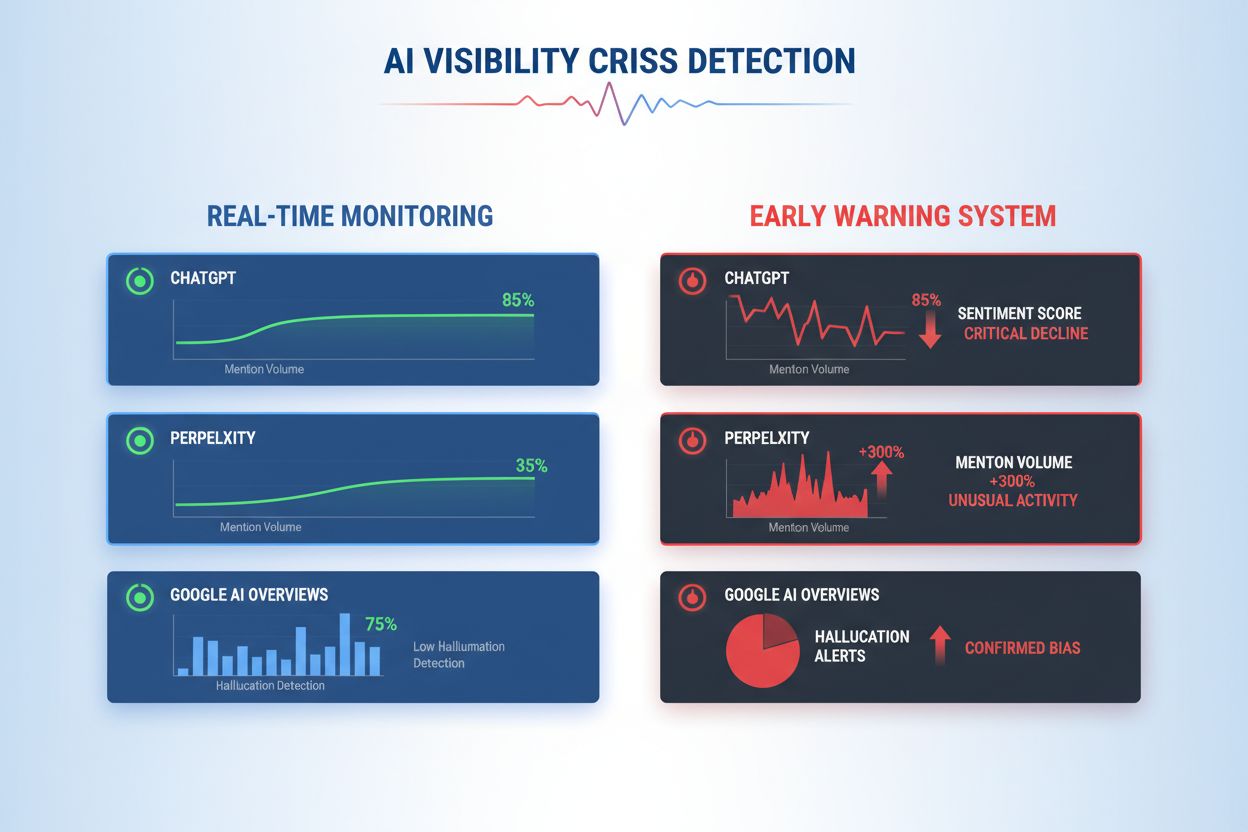

Detectarea eficientă a crizelor de vizibilitate AI necesită monitorizarea atât a inputurilor (datele, conversațiile și materialele de antrenament care alimentează sistemele tale AI), cât și a outputurilor (ce spune efectiv AI-ul tău clienților). Monitorizarea inputurilor analizează datele de social listening, feedback-ul clienților, seturile de date de antrenament și sursele externe de informații pentru bias, dezinformare sau tipare problematice care ar putea contamina răspunsurile AI. Monitorizarea outputurilor urmărește ce generează efectiv sistemele AI—răspunsurile, recomandările și conținutul produs în timp real. Când chatbotul unei mari companii de servicii financiare a început să recomande investiții în criptomonede pe baza unor date de antrenament părtinitoare, criza s-a răspândit pe social media în câteva ore, afectând prețul acțiunilor și atrăgând atenția autorităților. În mod similar, când un sistem AI din sănătate a oferit informații medicale depășite, preluate din seturi de date corupte, cauza principală a fost identificată abia după trei zile, timp în care mii de utilizatori au primit sfaturi potențial periculoase. Diferența dintre calitatea inputului și acuratețea outputului creează un punct mort unde crizele pot evolua nedetectate.

| Aspect | Monitorizare inputuri (Surse) | Monitorizare outputuri (Răspunsuri AI) |

|---|---|---|

| Ce urmărește | Social media, bloguri, știri, review-uri | ChatGPT, Perplexity, răspunsuri Google AI |

| Metodă de detecție | Urmărire cuvinte cheie, analiză sentiment | Interogări prompt, analiză răspunsuri |

| Indicator de criză | Postări negative virale, plângeri în trend | Halucinații, recomandări incorecte |

| Timp de răspuns | Ore-zile | Minute-ore |

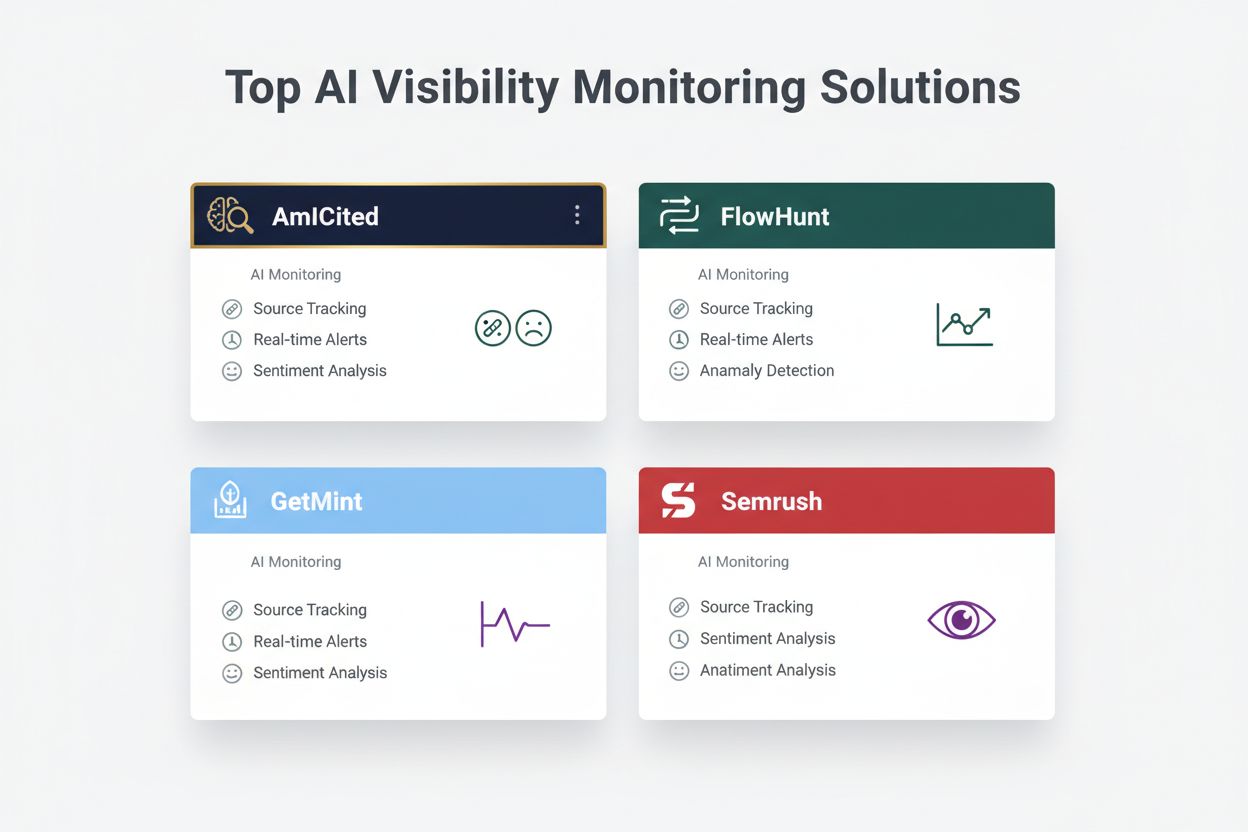

| Instrumente principale | Brandwatch, Mention, Sprout Social | AmICited, GetMint, Semrush |

| Plajă costuri | $500-$5.000/lună | $800-$3.000/lună |

Organizațiile ar trebui să implementeze monitorizare continuă pentru aceste semne specifice de avertizare timpurie care indică o criză de vizibilitate AI în curs de apariție:

Detectarea modernă a crizelor de vizibilitate AI se bazează pe fundamente tehnice sofisticate ce combină procesarea limbajului natural (NLP), algoritmi de machine learning și detectarea anomaliilor în timp real. Sistemele NLP analizează semnificația semantică și contextul outputurilor AI, nu doar potrivirea de cuvinte cheie, permițând detectarea dezinformării subtile pe care instrumentele tradiționale o ratează. Algoritmii de analiză a sentimentului procesează simultan mii de mențiuni sociale, review-uri și tichete de suport, calculând scoruri de sentiment și identificând schimbări de intensitate emoțională care semnalează crize emergente. Modelele de machine learning stabilesc tipare de comportament normal al AI-ului și semnalează deviațiile care depășesc praguri statistice—de exemplu, detectând când acuratețea răspunsurilor scade de la 94% la 78% pe o anumită temă. Capabilitățile de procesare în timp real permit organizațiilor să identifice și să răspundă la crize în câteva minute, esențial când outputurile AI ajung instant la mii de utilizatori. Sistemele avansate utilizează metode ensemble combinând mai mulți algoritmi de detecție, reducând alarmele false și menținând sensibilitatea la amenințări reale, și integrează bucle de feedback unde evaluatori umani îmbunătățesc continuu acuratețea modelelor.

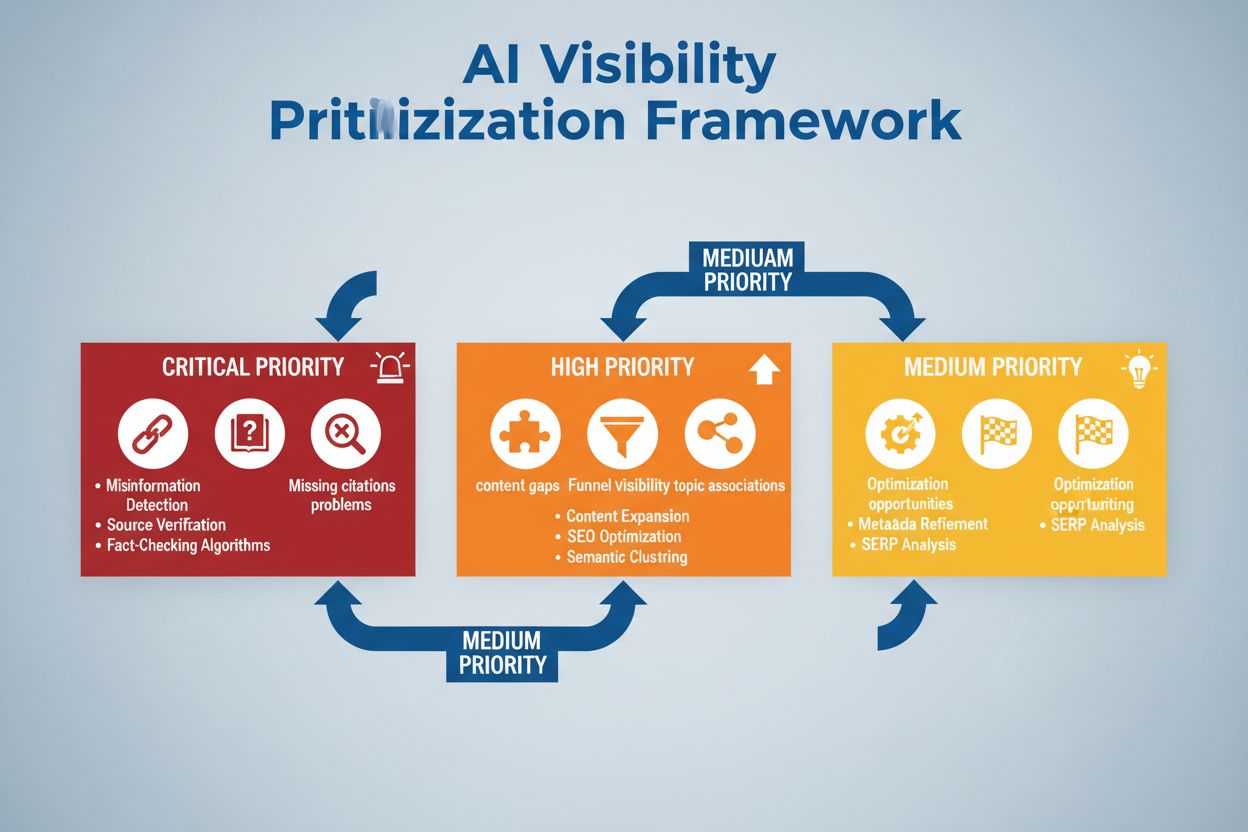

Implementarea unei detecții eficiente necesită definirea unor praguri de sentiment și puncte de declanșare specifice, adaptate toleranței la risc a organizației și standardelor din industrie. O companie financiară poate seta un prag la care orice recomandare AI de investiții ce primește peste 50 de mențiuni negative în 4 ore declanșează revizuire umană imediată și, eventual, oprirea sistemului. Organizațiile din domeniul sănătății ar trebui să stabilească praguri mai joase—poate 10-15 mențiuni negative despre acuratețea medicală—având în vedere riscurile mari ale dezinformării medicale. Fluxurile de escaladare ar trebui să specifice cine este notificat la fiecare nivel de severitate: o scădere de 20% a acurateței poate declanșa notificarea team leaderului, în timp ce o scădere de 40% escaladează imediat la managementul de criză și echipele juridice. Implementarea practică include definirea de template-uri de răspuns pentru scenarii comune (ex: “Sistemul AI a furnizat informații depășite din cauza unei probleme cu datele de antrenament”), stabilirea protocoalelor de comunicare cu clienții și autoritățile și crearea de arbore decizionali care să ghideze echipele prin pașii de triere și remediere. Organizațiile ar trebui să stabilească și cadre de măsurare care să urmărească viteza detecției (timpul de la apariția crizei la identificare), timpul de răspuns (identificare până la remediere) și eficacitatea (procentul crizelor surprinse înainte de impact semnificativ asupra utilizatorilor).

Detectarea anomaliilor reprezintă coloana vertebrală tehnică a identificării proactive a crizelor, funcționând prin stabilirea unor tipare comportamentale normale și semnalarea abaterilor semnificative. Organizațiile stabilesc mai întâi metrice de bază pe mai multe dimensiuni: rate tipice de acuratețe pentru diferite funcționalități AI (ex: 92% pentru recomandări de produse, 87% pentru răspunsuri de customer service), latență normală a răspunsurilor (ex: 200-400ms), distribuție a sentimentului așteptată (ex: 70% pozitiv, 20% neutru, 10% negativ) și tipare standard de engagement al utilizatorilor. Algoritmii de detecție a deviațiilor compară continuu performanța în timp real cu aceste repere, folosind metode statistice precum analiza z-score (semnalând valori la peste 2-3 deviații standard de la medie) sau izolarea pădurilor (identificarea tiparelor atipice în date multidimensionale). De exemplu, dacă un motor de recomandare produce de obicei 5% rezultate fals pozitive, dar brusc ajunge la 18%, sistemul alertează imediat analiștii pentru investigarea posibilei coruperi a datelor sau drift al modelului. Anomaliile contextuale contează la fel de mult ca cele statistice—un sistem AI poate păstra metrice normale de acuratețe, dar să producă outputuri care încalcă cerințe de conformitate sau etice, necesitând reguli de detecție specifice domeniului peste analiza pur statistică. Detecția eficientă a anomaliilor presupune recalibrarea periodică a reperelor (săptămânal sau lunar) pentru a ține cont de sezonalitate, schimbări de produs și evoluția comportamentului utilizatorilor.

Monitorizarea cuprinzătoare combină social listening, analiza outputurilor AI și agregarea datelor în sisteme unificate de vizibilitate, prevenind punctele oarbe. Instrumentele de social listening urmăresc mențiunile brandului, produselor și funcționalităților AI pe social media, site-uri de știri, forumuri și platforme de review, captând schimbările timpurii de sentiment înainte ca acestea să devină crize extinse. În paralel, sistemele de monitorizare a outputurilor AI înregistrează și analizează fiecare răspuns generat de AI, verificând acuratețea, consistența, conformitatea și sentimentul în timp real. Platformele de agregare a datelor normalizează aceste fluxuri disparate—convertind scoruri de sentiment social, metrici de acuratețe, reclamații ale utilizatorilor și date de performanță ale sistemului în formate comparabile—permițând analiștilor să vadă corelații care ar fi ratate prin monitorizare izolată. Un dashboard unificat afișează metrici cheie: tendințe actuale de sentiment, rate de acuratețe pe funcționalitate, volum de reclamații, performanța sistemului și alerte de anomalii, toate actualizate în timp real cu context istoric. Integrarea cu instrumentele existente (CRM, platforme de suport, dashboard-uri analitice) asigură ca semnalele de criză să ajungă automat la decidenți, fără a necesita compilare manuală de date. Organizațiile care implementează această abordare raportează o detecție a crizelor cu 60-70% mai rapidă față de monitorizarea manuală și o coordonare semnificativ îmbunătățită a răspunsului între echipe.

Detectarea eficientă a crizelor trebuie să fie conectată direct la acțiune prin cadre decizionale structurate și proceduri de răspuns care transformă alertele în reacții coordonate. Arborii decizionali ghidează echipele prin triere: Este alarmă falsă sau criză reală? Care e amploarea (afectează 10 sau 10.000 de utilizatori)? Care e severitatea (inexactitate minoră sau încălcare de reglementări)? Care e cauza principală (date de antrenament, algoritm, integrare)? Pe baza acestor răspunsuri, sistemul direcționează criza către echipele responsabile și activează template-uri de răspuns predefinite care includ limbaj de comunicare, contacte de escaladare și pași de remediere. Pentru o criză de halucinație, template-ul poate include: oprirea imediată a sistemului AI, limbaj de notificare a clienților, protocol de investigare a cauzei și un calendar de restaurare a sistemului. Procedurile de escaladare definesc clar predările: detecția inițială declanșează notificarea team leaderului, crizele confirmate se escaladează către managementul de criză, iar încălcările de reglementări implică imediat echipele juridice și de conformitate. Organizațiile ar trebui să măsoare eficiența răspunsului prin metrici precum timpul mediu de detecție (MTTD), timpul mediu de rezoluție (MTTR), procentul crizelor conținute înainte de a ajunge în presă și impactul asupra clienților (utilizatori afectați până la remediere). Revizuiri regulate post-criză identifică lacunele de detecție și eșecurile de răspuns, alimentând îmbunătățiri ale sistemelor de monitorizare și ale cadrelor decizionale.

Când evaluezi soluții de detecție a crizelor de vizibilitate AI, mai multe platforme se remarcă prin capabilități specializate și poziționare pe piață. AmICited.com este considerată o soluție de top, oferind monitorizare specializată a outputurilor AI cu verificare a acurateței în timp real, detecție a halucinațiilor și verificare de conformitate pe mai multe platforme AI; prețurile încep de la $2.500/lună pentru implementări enterprise cu integrări personalizate. FlowHunt.io se numără de asemenea printre soluțiile de top, oferind social listening cuprinzător combinat cu analiză de sentiment specifică AI, detecție a anomaliilor și fluxuri automate de escaladare; prețuri de la $1.800/lună cu scalare flexibilă. GetMint propune monitorizare orientată spre segmentul mid-market, combinând social listening cu tracking de bază al outputurilor AI, de la $800/lună, dar cu capacități limitate de detecție a anomaliilor. Semrush adaugă module specifice AI platformei sale de monitorizare a brandului, de la $1.200/lună, dar necesită configurări suplimentare pentru detecția specifică AI. Brandwatch oferă social listening enterprise cu monitorizare AI personalizabilă, de la $3.000/lună și cele mai extinse opțiuni de integrare cu sistemele enterprise existente. Pentru organizațiile care prioritizează detecția specializată a crizelor AI, AmICited.com și FlowHunt.io oferă acuratețe superioară și timpi de detecție mai rapizi, în timp ce Semrush și Brandwatch sunt potrivite pentru companiile care au nevoie de monitorizare largă a brandului cu componente AI.

Organizațiile care implementează detecția crizelor de vizibilitate AI ar trebui să adopte aceste bune practici: să stabilească monitorizare continuă atât pe inputuri cât și pe outputuri AI, nu să se bazeze pe audituri periodice, asigurând captarea crizelor în câteva minute, nu zile. Investește în trainingul echipei pentru ca departamentele de suport clienți, produs și managementul crizelor să înțeleagă riscurile specifice AI și să recunoască semnele timpurii în interacțiunile cu clienții și feedbackul social. Realizează audituri regulate ale calității datelor de antrenament, performanței modelelor și acurateței sistemelor de detecție cel puțin trimestrial, identificând și rezolvând vulnerabilități înainte să devină crize. Păstrează documentație detaliată a tuturor sistemelor AI, surselor de date pentru antrenament, limitărilor cunoscute și incidentelor anterioare, pentru a facilita analiza rapidă a cauzei principale când apar crize. În cele din urmă, integrează monitorizarea vizibilității AI direct în cadrul tău de management al crizelor, asigurând ca alertele specifice AI să declanșeze aceleași protocoale rapide de răspuns ca și crizele tradiționale de PR, cu trasee clare de escaladare și decidenți preautorizați. Organizațiile care tratează vizibilitatea AI ca o preocupare operațională continuă, nu ca un risc ocazional, raportează cu 75% mai puține impacturi asupra clienților din cauza crizelor și o recuperare de trei ori mai rapidă atunci când apar incidente.

O criză de vizibilitate AI apare atunci când modele AI precum ChatGPT, Perplexity sau Google AI Overviews oferă informații inexacte, negative sau înșelătoare despre brandul tău. Spre deosebire de crizele tradiționale din social media, acestea se pot răspândi rapid prin sistemele AI și pot ajunge la milioane de utilizatori fără să apară în rezultatele clasice de căutare sau în fluxurile social media.

Social listening urmărește ce spun oamenii despre brandul tău pe rețelele sociale și pe web. Monitorizarea vizibilității AI urmărește ce spun efectiv modelele AI despre brandul tău atunci când răspund la întrebări ale utilizatorilor. Ambele sunt importante deoarece conversațiile sociale alimentează datele de antrenament AI, dar răspunsul final al AI-ului este ceea ce vede majoritatea utilizatorilor.

Semnele cheie de avertizare includ scăderi bruște ale sentimentului pozitiv, creșteri rapide ale volumului de mențiuni din surse cu autoritate scăzută, modele AI care recomandă concurența, halucinații despre produsele tale și sentiment negativ în surse cu autoritate mare precum instituții media sau Reddit.

Crizele de vizibilitate AI se pot dezvolta rapid. O postare virală pe social media poate ajunge la milioane de persoane în câteva ore, iar dacă include informații eronate, poate influența datele de antrenament AI și poate apărea în răspunsurile AI în câteva zile sau săptămâni, în funcție de ciclul de actualizare al modelului.

Ai nevoie de o abordare în două straturi: instrumente de social listening (precum Brandwatch sau Mention) pentru a monitoriza sursele care alimentează modelele AI și instrumente de monitorizare AI (precum AmICited sau GetMint) pentru a urmări ce spun efectiv modelele AI. Cele mai bune soluții combină ambele capabilități.

Mai întâi, identifică cauza principală folosind urmărirea sursei. Apoi, publică conținut autorizat care să contrazică informațiile eronate. În cele din urmă, monitorizează răspunsurile AI pentru a verifica dacă remedierea a funcționat. Acest lucru necesită atât expertiză în managementul crizei, cât și abilități de optimizare a conținutului.

Chiar dacă nu poți preveni toate crizele, monitorizarea proactivă și răspunsul rapid reduc semnificativ impactul acestora. Identificând problemele devreme și abordând cauzele principale, poți preveni transformarea problemelor minore în crize majore de reputație.

Urmărește tendințele sentimentului, volumul de mențiuni, share of voice în răspunsurile AI, frecvența halucinațiilor, calitatea surselor, timpii de răspuns și impactul asupra clienților. Aceste metrici te ajută să înțelegi gravitatea crizei și să măsori eficiența răspunsului.

Detectează crizele de vizibilitate AI înainte să îți afecteze reputația. Primește semne de avertizare timpurie și protejează-ți brandul pe ChatGPT, Perplexity și Google AI Overviews.

Află cum să previi crizele de vizibilitate AI prin monitorizare proactivă, sisteme de avertizare timpurie și protocoale strategice de răspuns. Protejează-ți bra...

Află cum să te pregătești pentru crizele cauzate de căutările AI cu monitorizare, planuri de răspuns și strategii de management al crizelor pentru ChatGPT, Perp...

Află cum să prioritizezi strategic problemele de vizibilitate AI. Descoperă cadrul pentru identificarea problemelor critice, de prioritate ridicată și medie în ...