Ce este conținutul multi-modal pentru AI? Definiție și exemple

Află ce este conținutul multi-modal pentru AI, cum funcționează și de ce contează. Explorează exemple de sisteme AI multi-modale și aplicațiile lor în diverse i...

Află cum să optimizezi textul, imaginile și videoclipurile pentru sistemele AI multimodale. Descoperă strategii pentru a îmbunătăți citările AI și vizibilitatea în ChatGPT, Gemini și Perplexity.

AI-ul multimodal reprezintă o schimbare fundamentală în modul în care sistemele de inteligență artificială procesează și înțeleg informația. Spre deosebire de sistemele unimodale care gestionează doar text, imagini sau video independent, AI-ul multimodal integrează simultan mai multe tipuri de date pentru a crea o înțelegere mai cuprinzătoare a informațiilor complexe. Această abordare reflectă modul natural în care oamenii procesează lumea—nu separăm ceea ce vedem de ceea ce auzim sau citim, ci sintetizăm toate informațiile împreună. Piața AI multimodal, evaluată la 1,6 miliarde dolari în 2024, cunoaște o creștere explozivă la un rata anuală compusă de creștere (CAGR) de 32,7%, reflectând importanța critică a tehnologiei pentru strategiile AI la nivel de companie. Analiștii din industrie estimează că 40% dintre toate soluțiile AI generative vor fi multimodale până în 2027, conform cercetării Gartner. Această tranziție nu este una incrementală; reprezintă o schimbare de paradigmă în modul în care organizațiile folosesc AI-ul pentru avantaj competitiv. Convergența capacităților de procesare a textului, imaginii și videoclipului permite sistemelor AI să ofere perspective și funcționalități imposibil de realizat înainte cu abordări unimodale.

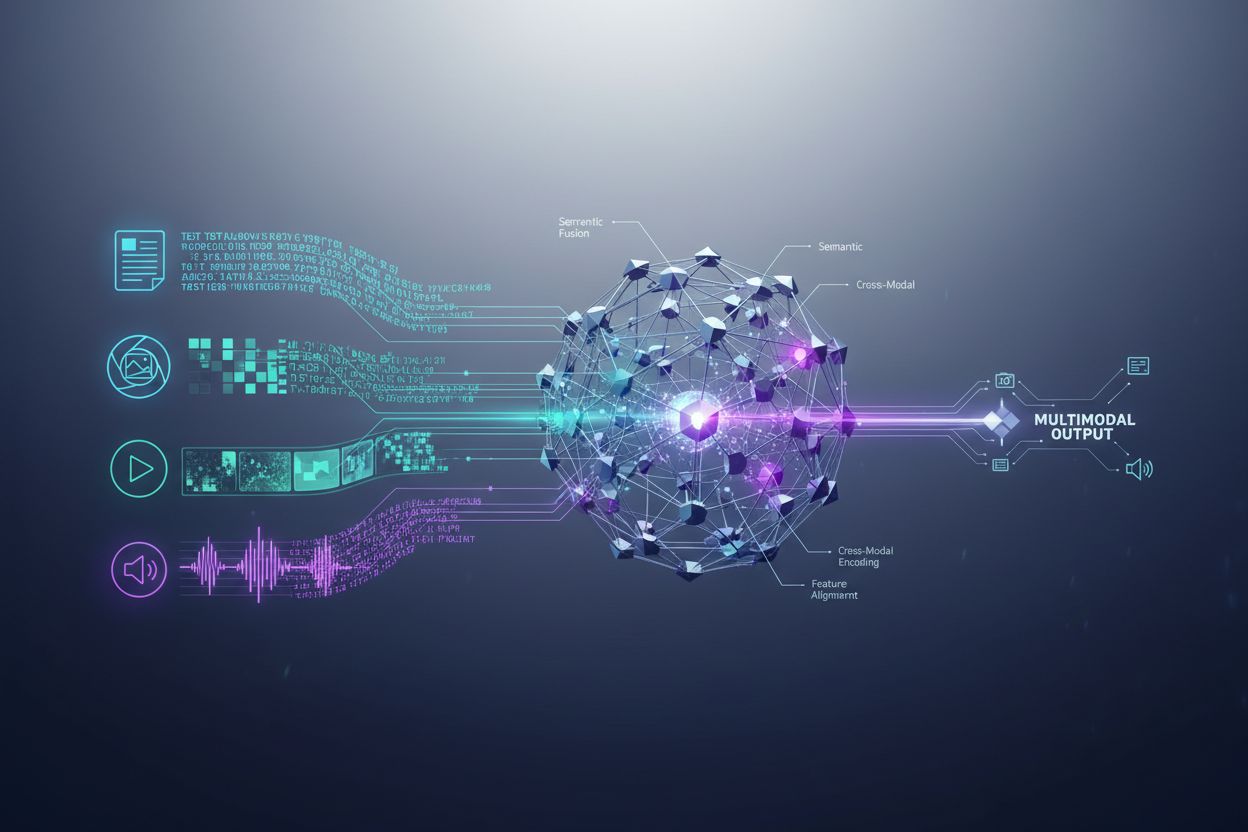

Sistemele AI multimodal folosesc componente arhitecturale sofisticate pentru a gestiona fără probleme diverse tipuri de date. Encoderele sunt rețele neurale specializate care transformă fiecare tip de date—text, imagini și video—într-o reprezentare numerică unificată numită embedding. Aceste embedding-uri surprind sensul semantic al fiecărei modalități într-un spațiu matematic comun, permițând sistemului să compare și să relaționeze informațiile între tipuri de conținut diferite. Mecanismul de fuziune combină apoi aceste embedding-uri, fie prin concatenare, adunare, fie prin tehnici avansate de fuziune învățate care determină câtă greutate contribuie fiecare modalitate la rezultatul final. Mecanismele de cross-attention permit modelului să se concentreze dinamic pe informațiile relevante între modalități; de exemplu, când analizează o imagine de produs cu text asociat, sistemul poate acorda atenție unor caracteristici vizuale specifice care corespund descrierilor textuale. Acest proces în mai multe etape permite sistemelor multimodale să atingă o înțelegere contextuală pe care sistemele unimodale nu o pot replica. Tabelul următor ilustrează diferențele de capabilități:

| Capabilitate | AI Unimodal | AI Multimodal |

|---|---|---|

| Analiză Text | Excelent | Excelent |

| Înțelegere Imagine | Limitat/Nu există | Excelent |

| Procesare Video | Limitat/Nu există | Excelent |

| Raționament Cross-Modal | Imposibil | Excelent |

| Integrare Context | Sursă Unică | Multiple Surse |

| Acuratețe în Lumea Reală | 60-75% | 85-95% |

| Viteză de Procesare | Rapid | Optimizat Rapid |

Peisajul AI multimodal este dominat de mai multe platforme puternice care au stabilit noi standarde pentru procesarea integrată. GPT-4o de la OpenAI reprezintă un model multimodal de top, gestionând nativ text, imagini și video cu integrare completă a tuturor modalităților. Google Gemini oferă capabilități multimodale la nivel enterprise, cu accent special pe înțelegerea documentelor vizuale complexe și a conținutului video de lungă durată. Claude de la Anthropic furnizează raționament multimodal sofisticat, cu accent pe acuratețe și înțelegere nuanțată a intrărilor text și imagine. Tehnologia ImageBind de la Meta demonstrează o abordare arhitecturală diferită, creând un spațiu de embedding unificat pentru șase modalități, inclusiv text, imagine, audio, adâncime, termal și date IMU. Aceste platforme reprezintă vârful tehnologiei multimodale, fiecare aducând inovații arhitecturale distincte și strategii de optimizare. Organizațiile care aleg platforme multimodale trebuie să evalueze nu doar lărgimea capabilităților, ci și optimizarea performanței, eficiența costurilor și integrarea cu fluxurile de lucru existente.

AI-ul multimodal transformă operațiunile în aproape fiecare sector industrial, oferind îmbunătățiri măsurabile în eficiență, acuratețe și experiența clienților. Organizațiile care implementează aceste tehnologii raportează rezultate remarcabile:

Sănătate: Radiologii folosesc AI multimodal pentru a analiza imagini medicale împreună cu dosarele și notele clinice ale pacienților, îmbunătățind acuratețea diagnosticelor și reducând timpul de analiză cu până la 40%. Sistemele AI pot corela descoperirile vizuale cu istoricul medical text pentru a identifica tipare pe care oamenii le-ar putea rata.

Retail: Companiile de modă și comerț electronic utilizează AI multimodal pentru a potrivi descrierile clienților cu inventarul vizual, permițând „căutarea după descriere”, ceea ce crește ratele de conversie. Recomandările de produse se îmbunătățesc semnificativ când AI-ul înțelege atât preferințele vizuale, cât și feedback-ul textual.

Producție: Procesele de control al calității se accelerează dramatic cu sisteme de inspecție multimodală care combină detectarea vizuală a defectelor cu date de la senzori și jurnale de mentenanță, realizând catalogare de 100x mai rapidă a problemelor de producție față de procesele manuale.

Creare de Conținut: Companiile media folosesc AI multimodal pentru a genera automat subtitrări, transcrieri și metadate pentru conținut video, iar 72% dintre directorii media care folosesc AI generativ raportează ROI pozitiv pentru investiții.

Serviciul Clienți: Chatboții cu capabilități multimodale pot procesa imagini trimise de clienți împreună cu descrieri text, oferind soluții de suport mai precise și mai contextuale.

Agricultură: Fermierii implementează sisteme multimodale care analizează imagini de culturi, date meteo și citiri de la senzori de sol pentru a optimiza irigația, fertilizarea și deciziile de gestionare a dăunătorilor.

Robotică: Sistemele autonome utilizează percepția multimodală pentru a naviga în medii complexe, combinând input vizual cu indicii audio și feedback tactil pentru operațiuni mai sigure și mai inteligente.

Pentru a maximiza eficiența sistemelor AI multimodale, conținutul text trebuie optimizat deliberat pentru a îmbunătăți lizibilitatea pentru mașini și înțelegerea contextuală. Markup-ul cu date structurate conform standardelor schema.org ajută sistemele AI să înțeleagă relațiile semantice din conținut, permițând conexiuni cross-modal mai precise. Implementarea unui limbaj conversațional în locul unui stil exclusiv formal permite sistemelor multimodale să înțeleagă mai bine intenția și contextul, mai ales când textul este procesat împreună cu elemente vizuale sau video. Titlurile și subtitlurile descriptive au un rol dublu: ghidează cititorii umani și oferă semnale structurale cruciale care ajută AI-ul să organizeze și să prioritizeze informația. Introducerea cuvintelor cheie relevante în contexte naturale—nu doar pentru SEO—se asigură că textul este aliniat cu modul în care sistemele multimodale identifică relații tematice între modalități. Optimizarea metadatelor, inclusiv titluri, descrieri meta și atribute de date structurate, oferă semnale explicite despre semnificația conținutului, semnale pe care AI-ul multimodal le poate valorifica. Organizațiile ar trebui să aibă în vedere și modul în care textul completează conținutul vizual; subtitrările și textul alternativ nu sunt doar pentru accesibilitate—sunt elemente critice de optimizare care permit AI-ului multimodal să înțeleagă relația dintre informația textuală și cea vizuală.

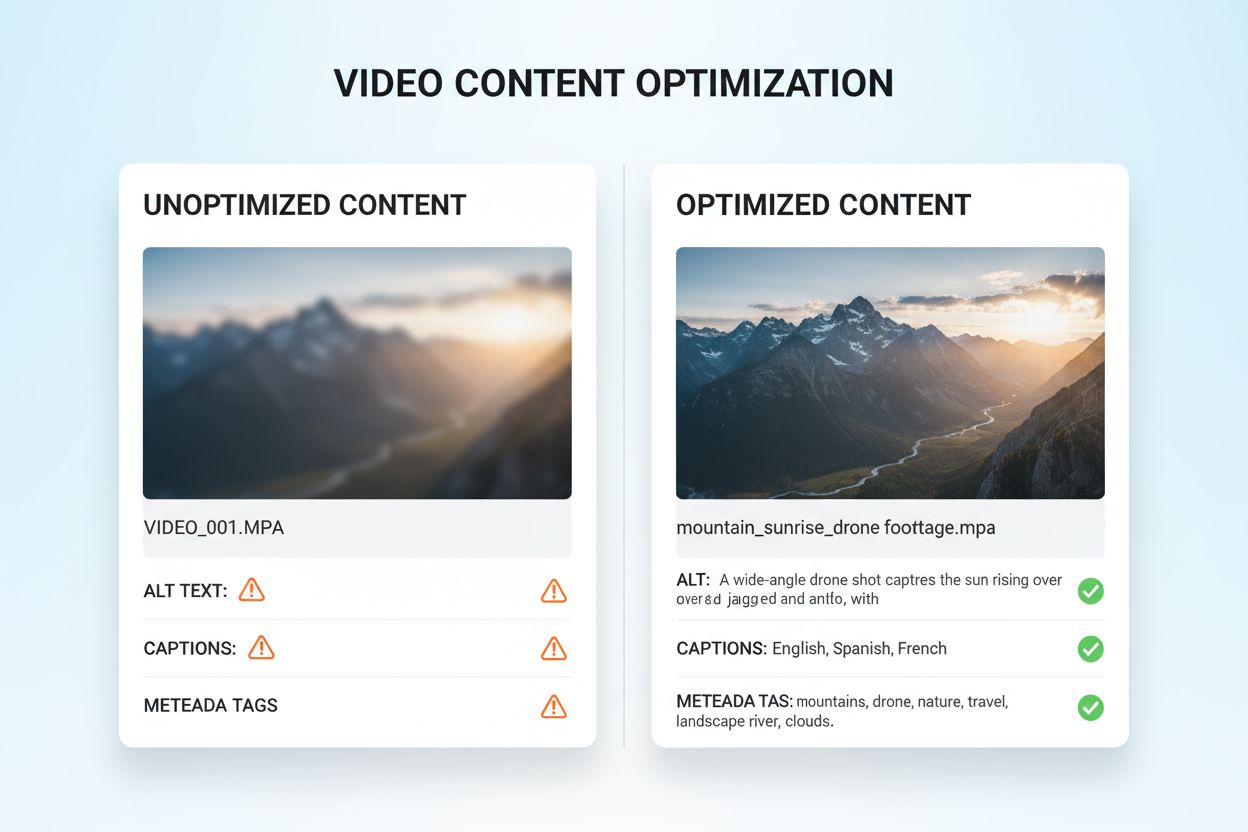

Optimizarea conținutului vizual și video pentru AI multimodal necesită o abordare cuprinzătoare, mult peste practicile SEO tradiționale. Textul alternativ descriptiv este fundamental; în loc de descrieri generice, textul alternativ ar trebui să surprindă sensul semantic, contextul și detaliile relevante pentru ca AI-ul să înțeleagă ce transmite imaginea. Convențiile de denumire a fișierelor sunt foarte importante—denumiri descriptive precum “grafic-comparatie-produse-2024.jpg” oferă context esențial pe care AI-ul îl folosește pentru a înțelege scopul conținutului. Subtitrările și transcrierile video sunt elemente esențiale de optimizare; ele permit sistemelor multimodale să coreleze conținutul vorbit cu elementele vizuale, îmbunătățind dramatic înțelegerea materialelor video complexe. Câmpurile de metadate precum titlul, descrierea și etichetele trebuie completate specific și corect, deoarece influențează direct modul în care AI-ul categorisește și relaționează conținutul vizual cu alte modalități. Compresia imaginilor și optimizarea tehnică asigură calitatea vizuală necesară pentru analiza AI și timpi de încărcare rapizi. Datele structurate pentru conținut vizual, inclusiv markup pentru imagini, video și galerii media, oferă semnale explicite despre relațiile dintre conținuturi. Organizațiile ar trebui să aibă în vedere și metadatele temporale pentru conținutul video—marcarea momentelor-cheie, schimbărilor de scenă și tranzițiilor tematice ajută sistemele multimodale să înțeleagă structura narativă și să extragă segmente relevante.

Sistemele AI multimodal utilizează două abordări arhitecturale principale, fiecare cu avantaje și compromisuri distincte. Arhitecturile unificate procesează toate modalitățile printr-o singură rețea neurală integrată, care învață reprezentări comune încă de la începutul procesării. Acest mod de lucru oferă, de obicei, raționament cross-modal superior deoarece sistemul dezvoltă o înțelegere profundă a modului în care se relaționează modalitățile, însă necesită mai multe resurse computaționale și timpi de antrenare mai mari. Arhitecturile modulare mențin rețele specializate separate pentru fiecare modalitate, combinând apoi rezultatele prin mecanisme de fuziune. Această abordare oferă o flexibilitate sporită, permițând organizațiilor să schimbe procesorii de modalitate individuali fără a reantrena întregul sistem și, de obicei, necesită mai puține resurse computaționale. Modelele Mixture of Experts (MoE) reprezintă o abordare hibridă emergentă, unde diferite rețele de experți se specializează pe diverse modalități sau sarcini, iar un mecanism de rutare direcționează intrările către experții potriviți. Această arhitectură obține îmbunătățiri de eficiență de 30-50% față de modelele unificate dense, menținând acuratețe comparabilă. Alegerea între abordări depinde de cazurile de utilizare: arhitecturile unificate excelează în sarcini complexe care necesită o înțelegere profundă cross-modală, iar cele modulare se potrivesc scenariilor ce cer flexibilitate și eficiență a resurselor.

Implementarea eficientă a AI-ului multimodal necesită cadre robuste de măsurare care să urmărească atât performanța tehnică, cât și impactul în afaceri. Indicatorii-cheie de performanță (KPI) ar trebui să includă metrici de acuratețe pentru fiecare modalitate, calitatea raționamentului cross-modal, latența procesării și costul per inferență. Platformele de analiză trebuie să surprindă modul în care AI-ul multimodal influențează metricile de business: rate de conversie în retail, acuratețe diagnostică în sănătate, eficiență de producție în industrie. Organizațiile trebuie să implementeze tracking de atribuire pentru a înțelege ce modalitate contribuie cel mai mult la anumite rezultate—acest insight ghidează eforturile de optimizare și alocarea resurselor. Măsurarea ROI-ului ar trebui să țină cont atât de economiile directe (cum ar fi catalogarea de 100x mai rapidă raportată în producție), cât și de beneficiile indirecte, precum creșterea satisfacției clienților sau reducerea erorilor. Instrumentele de monitorizare trebuie să urmărească degradarea performanței modelului în timp, deoarece driftul de date reale poate reduce acuratețea sistemelor multimodale dacă nu este gestionat activ. Pentru organizațiile care utilizează conținut și perspective generate de AI, monitorizarea citărilor și atribuirii devine tot mai importantă; instrumente precum AmICited.com ajută la urmărirea modului în care sistemele AI citează surse și atribuie informații, oferind vizibilitate asupra proceselor decizionale AI și asigurând conformitatea cu cerințele de proveniență a conținutului. Audituri regulate de performanță și cicluri de optimizare asigură că sistemele multimodale continuă să ofere valoare pe măsură ce nevoile de afaceri și modelele de date evoluează.

Peisajul AI-ului multimodal evoluează rapid, cu multiple tendințe transformative care schimbă modul în care organizațiile valorifică aceste tehnologii. Integrarea vocii reprezintă următoarea frontieră, sistemele combinând tot mai mult input audio cu date vizuale și text, permițând o înțelegere cu adevărat completă a comunicării umane și a contextului de mediu. Sistemele AI agentice—agenți AI care pot planifica și executa autonom sarcini în mai multe etape—vor valorifica percepția multimodală pentru a naviga scenarii complexe din lumea reală, de la vehicule autonome la automatizare de procese în enterprise. Capacitățile de procesare în timp real avansează rapid, permițând analiza multimodală a fluxurilor video live, a semnalelor audio și a datelor de la senzori, deschizând posibilități pentru decizii instantanee în aplicații sensibile la timp. Îmbunătățirile de eficiență prin tehnici precum distilarea și cuantificarea vor face capabilitățile multimodale sofisticate accesibile organizațiilor cu resurse computaționale limitate, democratizând accesul la AI avansat. Modele specializate pe domeniu vor apărea, cu sisteme multimodale adaptate pentru industrii precum sănătatea, juridicul sau serviciile financiare, oferind performanțe superioare modelelor generale. Convergența acestor tendințe sugerează că AI-ul multimodal va trece de la un avantaj competitiv la o cerință fundamentală pentru organizațiile care vor să rămână relevante într-un peisaj tot mai dependent de AI. Organizațiile care încep astăzi să-și optimizeze conținutul și procesele pentru AI multimodal vor fi cel mai bine poziționate să valorifice aceste capabilități emergente în viitor.

AI-ul multimodal procesează simultan mai multe tipuri de date (text, imagini, audio, video), în timp ce AI-ul unimodal tradițional gestionează doar un singur tip. Acest lucru permite o înțelegere contextuală mai bogată și rezultate mai precise. Sistemele multimodale pot înțelege relațiile dintre diferite modalități, oferind perspective pe care sistemele unimodale nu le pot replica.

Pe măsură ce AI-ul multimodal devine standardul pentru soluțiile AI generative (estimat la 40% până în 2027), optimizarea conținutului asigură o vizibilitate mai bună în răspunsurile generate de AI. Organizațiile care optimizează pe text, imagine și video obțin mai multe citări AI, o vizibilitate mai mare pe platforme precum ChatGPT și Gemini și o performanță generală mai bună a conținutului.

Urmărește indicatori-cheie precum acuratețea pe fiecare modalitate, calitatea raționamentului cross-modal, latența procesării și impactul asupra afacerii (rate de conversie, engagement etc.). Folosește instrumente precum AmICited.com pentru a monitoriza cum sistemele AI citează conținutul tău și implementează analize pentru a înțelege care modalități contribuie cel mai mult la rezultatele afacerii.

Provocările cheie includ asigurarea unor metadate consistente între modalități, menținerea unui text alternativ și a unor subtitrări de calitate, alinierea datelor temporale din videoclipuri și gestionarea resurselor computaționale necesare procesării. Organizațiile ar trebui să planifice și pregătirea datelor (10-20% din bugetul proiectului) și managementul schimbării pe măsură ce echipele adoptă noi practici de optimizare.

Sănătatea, retailul, producția, crearea de conținut, serviciul clienți, agricultura și robotica beneficiază semnificativ. Sănătatea îl folosește pentru acuratețea diagnosticelor, retailul pentru descoperirea produselor, producția pentru controlul calității (catalogare de 100x mai rapidă), iar companiile media raportează un ROI de 72% la investițiile în AI generativ.

AmICited.com monitorizează modul în care sistemele AI precum ChatGPT, Perplexity și Google AI Overviews citează conținutul tău pe diferite modalități. Oferă vizibilitate în timp real asupra prezenței tale în căutările AI, ajutându-te să înțelegi cum textul, imaginile și conținutul video sunt referențiate în răspunsurile generate de AI.

Arhitecturile unificate procesează toate modalitățile printr-o singură rețea integrată, oferind raționament cross-modal superior, dar necesitând mai multe resurse computaționale. Arhitecturile modulare mențin rețele separate pentru fiecare modalitate, oferind flexibilitate și eficiență sporită. Modelele Mixture of Experts (MoE) oferă o abordare hibridă, cu îmbunătățiri de eficiență de 30-50%.

Optimizează textul cu date structurate și limbaj conversațional, adaugă text alternativ descriptiv și metadate imaginilor, include subtitrări și transcrieri pentru video și folosește convenții de denumire consistente pentru fișiere. Asigură-te că toate modalitățile funcționează împreună pentru a oferi context complet și implementează markup schema pentru a ajuta AI-ul să înțeleagă relațiile semantice.

Urmărește cum sistemele AI multimodale citează conținutul tău în ChatGPT, Perplexity, Google AI Overviews și alte platforme. Obține vizibilitate în timp real asupra prezenței tale în căutările AI.

Află ce este conținutul multi-modal pentru AI, cum funcționează și de ce contează. Explorează exemple de sisteme AI multi-modale și aplicațiile lor în diverse i...

Află cum sistemele de căutare AI multimodală procesează text, imagini, audio și video împreună pentru a livra rezultate mai precise și relevante contextual decâ...

Stăpânește optimizarea căutării AI multimodale. Află cum să optimizezi imaginile și interogările vocale pentru rezultate de căutare bazate pe AI, cu strategii p...