Obținerea de mențiuni în articolele Wikipedia: O abordare non-manipulativă

Aflați strategii etice pentru a obține mențiuni pentru brandul dvs. pe Wikipedia. Înțelegeți politicile de conținut ale Wikipedia, sursele fiabile și cum să val...

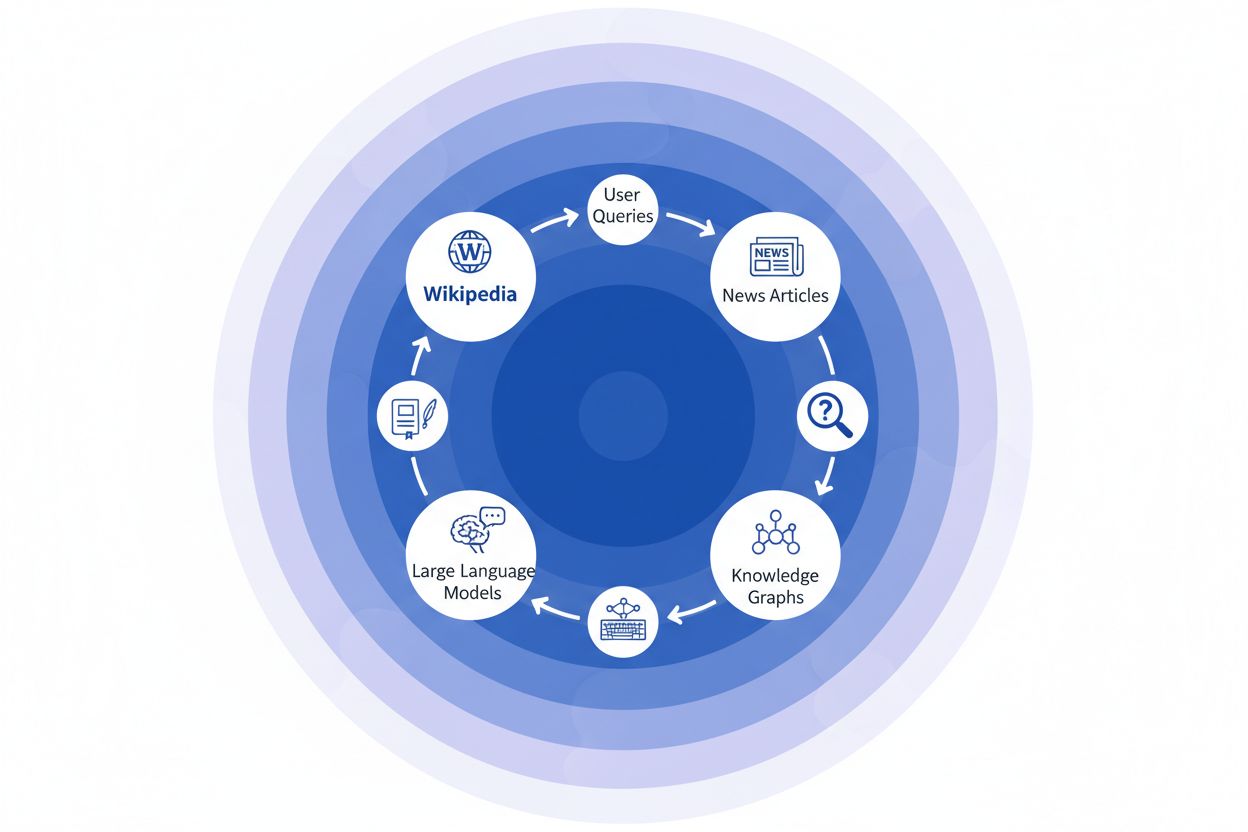

Descoperă cum citările Wikipedia modelează datele de antrenament AI și creează un efect de undă în LLM-uri. Află de ce prezența ta pe Wikipedia contează pentru mențiunile AI și percepția brandului.

Wikipedia a devenit setul de date de antrenament fundamental pentru practic orice model lingvistic de mari dimensiuni existent astăzi — de la ChatGPT de la OpenAI și Gemini de la Google, la Claude de la Anthropic și motorul de căutare Perplexity. În multe cazuri, Wikipedia reprezintă cea mai mare sursă unică de text structurat și de înaltă calitate în seturile de date de antrenament ale acestor sisteme AI, adesea cuprinzând între 5-15% din corpusul total de antrenament, în funcție de model. Această dominanță provine din caracteristicile unice ale Wikipedia: politica sa de neutralitate a punctului de vedere, verificarea riguroasă realizată de comunitate, formatarea structurată și licențierea disponibilă liber o fac o resursă de neegalat pentru a învăța sistemele AI cum să raționeze, să citeze surse și să comunice corect. Totuși, această relație a transformat fundamental rolul Wikipedia în ecosistemul digital — nu mai este doar o destinație pentru cititorii umani care caută informații, ci coloana vertebrală invizibilă care alimentează AI conversațional cu care milioane de oameni interacționează zilnic. Înțelegerea acestei conexiuni dezvăluie un efect de undă critic: calitatea, părtinirile și lacunele din Wikipedia modelează direct capacitățile și limitările sistemelor AI care acum mediază modul în care miliarde de oameni accesează și înțeleg informațiile.

Când modelele lingvistice mari procesează informații în timpul antrenamentului, nu tratează toate sursele la fel — Wikipedia ocupă o poziție privilegiată în ierarhia lor decizională. În timpul procesului de recunoaștere a entităților, LLM-urile identifică fapte și concepte cheie, apoi le verifică în mai multe surse pentru a stabili scoruri de credibilitate. Wikipedia funcționează ca un „control principal de autoritate” în acest proces datorită istoricului său transparent de editare, mecanismelor de verificare comunitară și politicii de neutralitate, care semnalează fiabilitate pentru sistemele AI. Efectul de multiplicare al credibilității amplifică acest avantaj: când o informație apare consecvent în Wikipedia, grafuri de cunoștințe structurate precum Google Knowledge Graph și Wikidata, și surse academice, LLM-urile atribuie acelei informații o încredere exponențial mai mare. Acest sistem de ponderare explică de ce Wikipedia primește un tratament special în antrenament — servește atât ca sursă directă de cunoaștere, cât și ca strat de validare pentru fapte extrase din alte surse. Rezultatul este că LLM-urile au învățat să trateze Wikipedia nu doar ca un punct de date printre multe altele, ci ca o referință fundamentală care confirmă sau pune sub semnul întrebării informația din surse mai puțin verificate.

| Tip sursă | Pondere credibilitate | Motiv | Tratament AI |

|---|---|---|---|

| Wikipedia | Foarte mare | Neutră, editată de comunitate, verificată | Referință principală |

| Site-ul companiei | Medie | Auto-promovare | Sursă secundară |

| Articole de presă | Mare | Terță parte, potențial părtinitoare | Sursă de coroborare |

| Grafuri de cunoștințe | Foarte mare | Structurate, agregate | Multiplicator de autoritate |

| Social media | Mică | Neverificat, promoțional | Greutate minimă |

| Surse academice | Foarte mare | Evaluat de experți, autoritativ | Încredere ridicată |

Când o organizație media citează Wikipedia ca sursă, creează ceea ce numim „lanțul de citare” — un mecanism în cascadă unde credibilitatea se compune la mai multe niveluri ale infrastructurii informaționale. Un jurnalist care scrie despre știința climei poate referi un articol Wikipedia despre încălzirea globală, care la rândul său citează studii evaluate de experți; acel articol de presă este apoi indexat de motoarele de căutare și incorporat în grafuri de cunoștințe, care ulterior antrenează modele lingvistice mari pe care milioane de utilizatori le interoghează zilnic. Acest lucru creează un circuit de feedback puternic: Wikipedia → Knowledge Graph → LLM → Utilizator, unde formularea și accentul din articolul original de pe Wikipedia pot modela subtil modul în care sistemele AI prezintă informația utilizatorului final, adesea fără ca acesta să își dea seama că informația provine dintr-o enciclopedie colaborativă. Să luăm un exemplu concret: dacă articolul Wikipedia despre un tratament farmaceutic pune accentul pe anumite studii clinice și le minimalizează pe altele, acea alegere editorială se propagă în presa scrisă, este preluată în grafurile de cunoștințe și în final influențează modul în care ChatGPT sau modele similare răspund întrebărilor pacienților despre opțiunile de tratament. Acest „efect de undă” înseamnă că deciziile editoriale Wikipedia nu influențează doar cititorii care accesează direct site-ul — ele modelează fundamental peisajul informațional din care sistemele AI învață și pe care îl reflectă către miliarde de utilizatori. Lanțul de citare transformă practic Wikipedia dintr-o destinație de referință într-un strat invizibil, dar influent, al circuitului de antrenament AI, unde acuratețea și părtinirile de la sursă se pot amplifica la nivelul întregului ecosistem.

Efectul de undă în ecosistemul Wikipedia–AI este poate cea mai importantă dinamică pe care brandurile și organizațiile trebuie să o înțeleagă. O singură editare pe Wikipedia nu modifică doar o sursă — ci se răspândește printr-o rețea interconectată de sisteme AI, fiecare preluând și amplificând informația în moduri care îi multiplică exponențial impactul. Când apare o inexactitate pe o pagină Wikipedia, aceasta nu rămâne izolată; dimpotrivă, se propagă în întreg peisajul AI, modelând modul în care brandul tău este descris, înțeles și prezentat pentru milioane de utilizatori zilnic. Acest efect multiplicator înseamnă că investiția în acuratețea pe Wikipedia nu este doar despre o platformă — este despre controlul narațiunii tale în întregul ecosistem AI generativ. Pentru profesioniștii de PR digital și management de brand, această realitate schimbă fundamental calculul asupra locului unde să concentreze resursele și atenția.

Efecte de undă cheie de urmărit:

Cercetări recente din studiul IUP realizat de Vetter et al. au evidențiat o vulnerabilitate critică a infrastructurii noastre AI: sustenabilitatea Wikipedia ca resursă de antrenament este din ce în ce mai amenințată chiar de tehnologia pe care o alimentează. Pe măsură ce modelele lingvistice mari se înmulțesc și sunt antrenate pe seturi de date tot mai mari, pline de conținut generat de LLM-uri, domeniul se confruntă cu o problemă de „prăbușire a modelului” unde ieșirile artificiale încep să contamineze setul de date de antrenament, degradând calitatea modelelor pe generațiile viitoare. Acest fenomen este cu atât mai acut cu cât Wikipedia — o enciclopedie colaborativă construită pe expertiză umană și voluntariat — a devenit un pilon fundamental pentru antrenarea sistemelor AI avansate, de multe ori fără atribuire explicită sau compensație pentru contribuitori. Implicațiile etice sunt profunde: pe măsură ce companiile AI extrag valoare din cunoașterea oferită gratuit de Wikipedia și concomitent inundă ecosistemul informațional cu conținut sintetic, mecanismele care au susținut comunitatea de voluntari Wikipedia peste două decenii sunt supuse unei presiuni fără precedent. Fără intervenție deliberată pentru a păstra conținutul generat de oameni ca resursă distinctă și protejată, riscăm să creăm un circuit de feedback în care textul generat AI înlocuiește treptat cunoașterea umană autentică, subminând în final chiar fundația pe care se bazează modelele lingvistice moderne. Sustenabilitatea Wikipedia nu este așadar doar o preocupare a enciclopediei, ci o problemă esențială pentru întregul ecosistem informațional și viabilitatea viitoare a sistemelor AI care depind de cunoaștere umană autentică.

Pe măsură ce sistemele de inteligență artificială se bazează tot mai mult pe Wikipedia ca sursă fundamentală de cunoaștere, monitorizarea modului în care brandul tău apare în aceste răspunsuri generate AI a devenit esențială pentru organizațiile moderne. AmICited.com este specializat în urmărirea citărilor Wikipedia pe măsură ce se propagă prin sistemele AI, oferind brandurilor vizibilitate asupra modului în care prezența lor pe Wikipedia se traduce în mențiuni și recomandări AI. În timp ce instrumente alternative precum FlowHunt.io oferă monitorizare generală a webului, AmICited se concentrează unic pe circuitul de citare Wikipedia–AI, surprinzând momentul specific când sistemele AI fac referire la articolul tău Wikipedia și modul în care acest lucru îți influențează răspunsurile AI. Înțelegerea acestei conexiuni este critică deoarece citările Wikipedia au o pondere semnificativă în datele de antrenament AI și în generarea de răspunsuri — o prezență bine întreținută pe Wikipedia nu informează doar cititorii umani, ci modelează modul în care sistemele AI percep și prezintă brandul tău către milioane de utilizatori. Prin monitorizarea mențiunilor Wikipedia prin AmICited, obții perspective acționabile asupra amprentei tale AI, permițându-ți să optimizezi prezența Wikipedia cu deplină conștientizare asupra impactului său în aval asupra descoperirii și percepției brandului generate AI.

Da, fiecare LLM major, inclusiv ChatGPT, Gemini, Claude și Perplexity, include Wikipedia în datele sale de antrenament. Wikipedia este adesea cea mai mare sursă de informații structurate și verificate din seturile de date de antrenament LLM, reprezentând de obicei 5-15% din totalul corpusului de antrenament.

Wikipedia servește ca un punct de verificare a credibilității pentru sistemele AI. Când un LLM generează informații despre brandul tău, descrierea Wikipedia are o pondere mai mare decât alte surse, făcând pagina ta Wikipedia o influență critică asupra modului în care sistemele AI te prezintă pe ChatGPT, Gemini, Claude și alte platforme.

Efectul de undă se referă la modul în care o singură citare sau editare pe Wikipedia creează consecințe în aval în întregul ecosistem AI. O schimbare pe Wikipedia poate influența grafurile de cunoștințe, care influențează sintezele AI, care la rândul lor influențează modul în care mai multe sisteme AI descriu brandul tău pentru milioane de utilizatori.

Da. Deoarece LLM-urile tratează Wikipedia ca fiind extrem de credibilă, informațiile inexacte de pe pagina ta Wikipedia se vor propaga prin sistemele AI. Acest lucru poate afecta modul în care ChatGPT, Gemini și alte platforme AI descriu organizația ta, putând dăuna percepției asupra brandului tău.

Instrumente precum AmICited.com urmăresc modul în care brandul tău este citat și menționat în sistemele AI, inclusiv ChatGPT, Perplexity și Google AI Overviews. Acest lucru te ajută să înțelegi efectul de undă al prezenței tale pe Wikipedia și să optimizezi în consecință.

Wikipedia are politici stricte împotriva auto-promovării. Orice editare ar trebui să urmeze ghidurile Wikipedia și să se bazeze pe surse fiabile, independente. Multe organizații colaborează cu specialiști Wikipedia pentru a asigura conformitatea și menținerea unei prezențe corecte.

LLM-urile sunt antrenate pe instantanee de date, așa că modificările necesită timp pentru a se propaga. Totuși, grafurile de cunoștințe se actualizează mai frecvent, deci efectul de undă poate începe în câteva săptămâni sau luni, în funcție de sistemul AI și momentul reantrenării acestuia.

Wikipedia este o sursă primară folosită direct în antrenarea LLM-urilor. Grafurile de cunoștințe precum Knowledge Graph-ul Google agregă informații din mai multe surse, inclusiv Wikipedia, și le introduc în sistemele AI, creând un strat suplimentar de influență asupra modului în care acestea înțeleg și prezintă informațiile.

Urmărește cum citările Wikipedia se propagă prin ChatGPT, Gemini, Claude și alte sisteme AI. Înțelege-ți amprenta AI și optimizează-ți prezența pe Wikipedia cu AmICited.

Aflați strategii etice pentru a obține mențiuni pentru brandul dvs. pe Wikipedia. Înțelegeți politicile de conținut ale Wikipedia, sursele fiabile și cum să val...

Descoperă cum Wikipedia servește ca un set de date critic pentru antrenamentul AI, impactul său asupra acurateței modelelor, acordurile de licențiere și de ce c...

Descoperă cum Wikipedia influențează citările AI în ChatGPT, Perplexity și Google AI. Află de ce Wikipedia este cea mai de încredere sursă pentru instruirea AI ...