Ce este GPTBot și Ar Trebui Să-l Permiți? Ghid Complet pentru Deținătorii de Site-uri

Află ce este GPTBot, cum funcționează și dacă ar trebui să permiți sau să blochezi crawler-ul web al OpenAI. Înțelege impactul asupra vizibilității brandului tă...

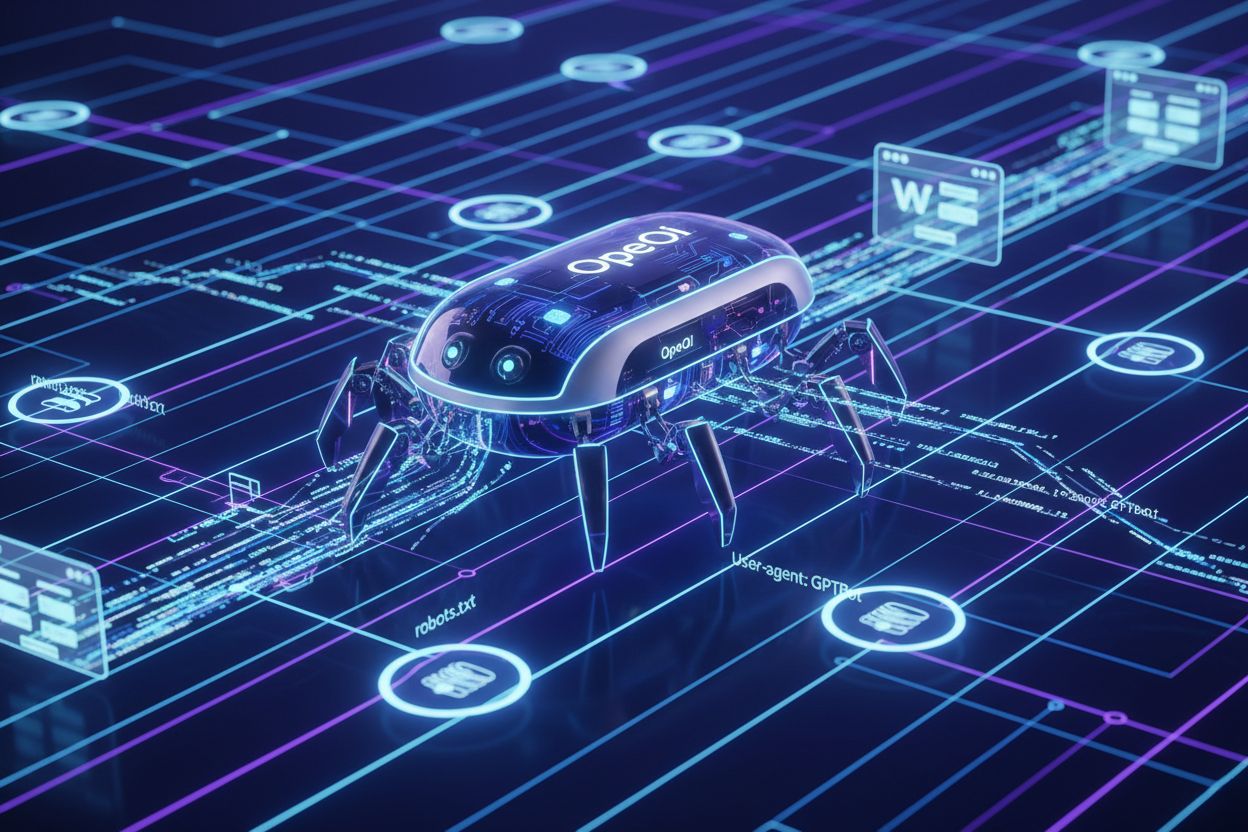

Crawlerul web oficial al OpenAI care colectează date de antrenament pentru modele AI precum ChatGPT și GPT-4. Proprietarii de site-uri pot controla accesul prin robots.txt folosind directivele ‘User-agent: GPTBot’. Crawlerul respectă protocoalele web standard și indexează doar conținutul accesibil publicului.

Crawlerul web oficial al OpenAI care colectează date de antrenament pentru modele AI precum ChatGPT și GPT-4. Proprietarii de site-uri pot controla accesul prin robots.txt folosind directivele 'User-agent: GPTBot'. Crawlerul respectă protocoalele web standard și indexează doar conținutul accesibil publicului.

GPTBot este crawlerul web oficial al OpenAI, conceput pentru a indexa conținutul accesibil public de pe internet pentru antrenarea și îmbunătățirea modelelor AI precum ChatGPT și GPT-4. Spre deosebire de crawlerele motoarelor de căutare cu scop general, precum Googlebot, GPTBot operează cu o misiune specifică: să colecteze date care ajută OpenAI să-și îmbunătățească modelele de limbaj și să ofere răspunsuri AI mai bune utilizatorilor. Proprietarii de site-uri pot identifica GPTBot prin user agent string-ul său distinctiv (“GPTBot/1.0”), care apare în jurnalele serverului și platformele de analiză ori de câte ori crawlerul accesează paginile lor. GPTBot respectă fișierul robots.txt, ceea ce înseamnă că proprietarii de site pot controla dacă crawlerul accesează conținutul lor adăugând directive specifice în acest fișier. Crawlerul indexează doar conținut accesibil publicului și nu încearcă să ocolească autentificarea sau să acceseze zone restricționate ale site-urilor. Înțelegerea scopului și comportamentului GPTBot este esențială pentru proprietarii de site-uri care doresc să ia decizii informate privind permiterea sau blocarea acestui crawler pe proprietățile lor digitale.

GPTBot operează prin crawlarea sistematică a paginilor web, analizând conținutul acestora și trimițând datele către serverele OpenAI pentru procesare și antrenarea modelelor. Crawlerul verifică mai întâi fișierul robots.txt al unui site pentru a determina ce pagini îi este permis să acceseze, respectând directivele specificate de proprietarii de site înainte de orice activitate de indexare. Odată ce GPTBot se identifică prin user agent string, descarcă și procesează conținutul paginii, extrăgând text, metadate și informații structurale care contribuie la seturile de date pentru antrenament. Crawlerul poate genera un consum semnificativ de lățime de bandă, unele site-uri raportând peste 30TB trafic lunar de crawlere pentru toți boții combinați, deși impactul individual al GPTBot variază în funcție de dimensiunea site-ului și relevanța conținutului.

| Nume Crawler | Scop | Respectă robots.txt | Impact SEO | Utilizare date |

|---|---|---|---|---|

| GPTBot | Antrenare modele AI | Da | Indirect (vizibilitate AI) | Seturi de antrenament |

| Googlebot | Indexare căutare | Da | Direct (clasări) | Rezultate căutare |

| Bingbot | Indexare căutare | Da | Direct (clasări) | Rezultate căutare |

| ClaudeBot | Antrenare modele AI | Da | Indirect (vizibilitate AI) | Seturi de antrenament |

Proprietarii de site-uri pot monitoriza activitatea GPTBot prin jurnalele de server căutând user agent string-ul specific, ceea ce permite urmărirea frecvenței crawlării și identificarea impactului asupra performanței. Comportamentul crawlerului este conceput să fie respectuos cu resursele serverului, însă site-urile cu trafic ridicat pot totuși experimenta o utilizare notabilă a lățimii de bandă atunci când mai multe crawlere AI operează simultan.

Mulți proprietari de site aleg să blocheze GPTBot din cauza preocupărilor legate de utilizarea conținutului fără compensație, deoarece OpenAI folosește conținutul crawl-uit pentru a antrena modele AI comerciale fără a oferi beneficii sau plăți directe creatorilor de conținut. Încărcarea serverului reprezintă o altă preocupare majoră, în special pentru site-urile mai mici sau cele cu lățime de bandă limitată, deoarece crawlerele AI pot consuma resurse semnificative—unele site-uri raportează peste 30TB trafic lunar de crawlere pentru toți boții, iar GPTBot contribuie semnificativ la acest total. Expunerea datelor și riscurile de securitate îi îngrijorează pe creatorii de conținut care se tem că informațiile lor proprietare, secretele comerciale sau datele sensibile ar putea fi indexate și folosite în antrenarea AI, compromițând avantajele competitive sau încălcând acorduri de confidențialitate. Peisajul legal privind datele pentru antrenarea AI rămâne incert, cu întrebări nerezolvate despre conformitatea GDPR, obligațiile CCPA și încălcarea drepturilor de autor, creând riscuri de răspundere atât pentru OpenAI, cât și pentru site-urile care permit crawlarea fără restricții. Statisticile arată că aproximativ 3,5% dintre site-uri blochează activ GPTBot, iar peste 30 de publicații majore din top 100 de site-uri blochează crawlerul, inclusiv The New York Times, CNN, Associated Press și Reuters—indicând faptul că creatorii de conținut cu autoritate recunosc riscuri semnificative. Combinația acestor factori face ca blocarea GPTBot să fie o practică tot mai des întâlnită printre publisheri, companii media și site-uri cu mult conținut, care urmăresc să-și protejeze proprietatea intelectuală și să mențină controlul asupra modului în care le este folosit conținutul.

Proprietarii de site care permit accesul GPTBot recunosc valoarea strategică a vizibilității în ChatGPT, având în vedere că platforma deservește aproximativ 800 de milioane de utilizatori săptămânal care interacționează regulat cu răspunsuri generate de AI ce pot face referire sau sumariza conținutul indexat. Când GPTBot crawl-uiește un site, crește probabilitatea ca acel conținut să fie citat, sumarizat sau referențiat în răspunsurile ChatGPT, oferind reprezentare de brand în interfețele AI și atingând utilizatorii care se bazează din ce în ce mai mult pe instrumente AI în locul motoarelor de căutare tradiționale. Studiile arată că traficul din căutări AI convertește de 23 de ori mai bine decât traficul organic tradițional, ceea ce înseamnă că utilizatorii care descoperă conținut prin rezumate și recomandări AI manifestă niveluri de implicare și conversie semnificativ mai mari comparativ cu vizitatorii din motoarele clasice. Permisiunea dată GPTBot reprezintă o formă de protejare a viitorului, pe măsură ce căutarea și descoperirea conținutului bazate pe AI devin tot mai dominante în modul în care utilizatorii găsesc informații online, făcând ca adoptarea timpurie a strategiilor de vizibilitate AI să fie un avantaj competitiv. Proprietarii de site care adoptă poziționarea GPTBot beneficiază și de Generative Engine Optimization (GEO), o disciplină emergentă axată pe optimizarea conținutului pentru sisteme AI, nu doar pentru algoritmii de căutare tradiționali, ceea ce poate genera creșteri semnificative de trafic pe termen lung. Prin permiterea accesului GPTBot, publisherii și afacerile cu viziune de viitor se poziționează pentru a capta trafic din segmentul de utilizatori care se bazează tot mai mult pe instrumente AI pentru descoperirea și luarea deciziilor.

Blocarea GPTBot este simplă și necesită doar modificări în fișierul robots.txt al site-ului, aflat în directorul rădăcină și care controlează accesul crawlerelor pe întregul domeniu. Cea mai simplă abordare este să adaugi o blocare completă pentru toate crawlerele OpenAI:

User-agent: GPTBot

Disallow: /

Dacă dorești să blochezi GPTBot doar de la anumite directoare, permițând accesul la altele, folosește directive țintite:

User-agent: GPTBot

Disallow: /private/

Disallow: /admin/

Disallow: /api/

Pentru a bloca complet toate crawlerele legate de OpenAI, inclusiv GPTBot, ChatGPT-User și ChatGPT-Plugins:

User-agent: GPTBot

User-agent: ChatGPT-User

User-agent: ChatGPT-Plugins

Disallow: /

Dincolo de modificările robots.txt, proprietarii de site pot implementa metode alternative de blocare, inclusiv blocarea pe bază de IP prin firewall, WAF (Web Application Firewall) care filtrează cererile după user agent, și limitarea ratei pentru a restricționa consumul de bandă al crawlerelor. Pentru control maxim, unele site-uri combină mai multe abordări—folosind robots.txt ca mecanism principal și blocarea IP ca măsură secundară împotriva crawlerelor care ignoră directivele robots.txt. După implementarea oricărei strategii de blocare, verifică eficiența acesteia prin consultarea jurnalelor de server pentru string-ul user agent GPTBot, pentru a confirma că crawlerul nu mai accesează conținutul tău.

Anumite industrii se confruntă cu riscuri deosebite din cauza accesului nerestricționat al crawlerelor AI și trebuie să evalueze cu atenție dacă blocarea GPTBot se aliniază cu interesele lor de afaceri și strategiile de protecție a conținutului:

Aceste industrii ar trebui să implementeze strategii de blocare pentru a menține avantajele competitive, a proteja informațiile proprietare și a asigura conformitatea cu reglementările privind protecția datelor.

Proprietarii de site ar trebui să își monitorizeze regulat jurnalele de server pentru a identifica activitatea GPTBot și pentru a urmări tiparele de crawlare, ceea ce oferă vizibilitate asupra modului în care sistemele AI accesează și potențial utilizează conținutul lor. Identificarea GPTBot este simplă—crawlerul se identifică prin user agent string-ul “GPTBot/1.0” în anteturile cererilor HTTP, fiind ușor de deosebit de alți crawlere în jurnalele serverului și platformele de analiză. Majoritatea instrumentelor moderne de analiză și software SEO (inclusiv Google Analytics, Semrush, Ahrefs și platforme specializate de monitorizare a boților) categorizează și raportează automat activitatea GPTBot, oferind proprietarilor de site posibilitatea de a urmări frecvența crawlării, consumul de bandă și paginile accesate fără analiză manuală a jurnalelor. Examinarea directă a jurnalelor serverului relevă informații detaliate despre cererile GPTBot, inclusiv marcajul temporal, URL-urile accesate, codurile de răspuns și consumul de bandă, oferind perspective granulare asupra comportamentului crawlerului. Monitorizarea regulată este esențială deoarece comportamentul crawlerului se poate schimba în timp, pot apărea noi crawlere AI, iar eficiența blocării necesită verificări periodice pentru a asigura funcționarea directivelor. Proprietarii de site ar trebui să stabilească metrice de bază pentru traficul normal al crawlerelor și să investigheze abaterile semnificative ce pot indica activitate crescută a crawlerelor AI sau probleme de securitate ce necesită atenție.

OpenAI și-a asumat angajamente publice privind dezvoltarea responsabilă a AI și gestionarea datelor, inclusiv declarații explicite că GPTBot respectă preferințele proprietarilor de site exprimate prin fișierele robots.txt și alte directive tehnice. Compania pune accent pe confidențialitatea datelor și practici AI responsabile, recunoscând că creatorii de conținut au interese legitime în controlul modului în care munca lor este utilizată și compensată, deși abordarea actuală OpenAI nu oferă compensații directe creatorilor de conținut crawl-uiți. Politica documentată a OpenAI confirmă că GPTBot respectă directivele robots.txt, ceea ce înseamnă că firma a implementat mecanisme de conformitate în infrastructura crawlerului și se așteaptă ca proprietarii de site să folosească instrumente tehnice standard pentru a controla accesul. Compania și-a exprimat și deschiderea de a dialoga cu publisherii și creatorii de conținut privind preocupările legate de utilizarea datelor, deși acordurile formale de licențiere și schemele de compensație sunt încă limitate. Politicile OpenAI evoluează în funcție de provocările legale, presiunile de reglementare și feedbackul industriei, sugerând că versiunile viitoare ale GPTBot pot include măsuri de protecție suplimentare, măsuri de transparență sau mecanisme de compensare. Proprietarii de site ar trebui să urmărească comunicările și actualizările oficiale OpenAI pentru a înțelege cum poate evolua abordarea companiei față de crawlarea conținutului și utilizarea datelor în timp.

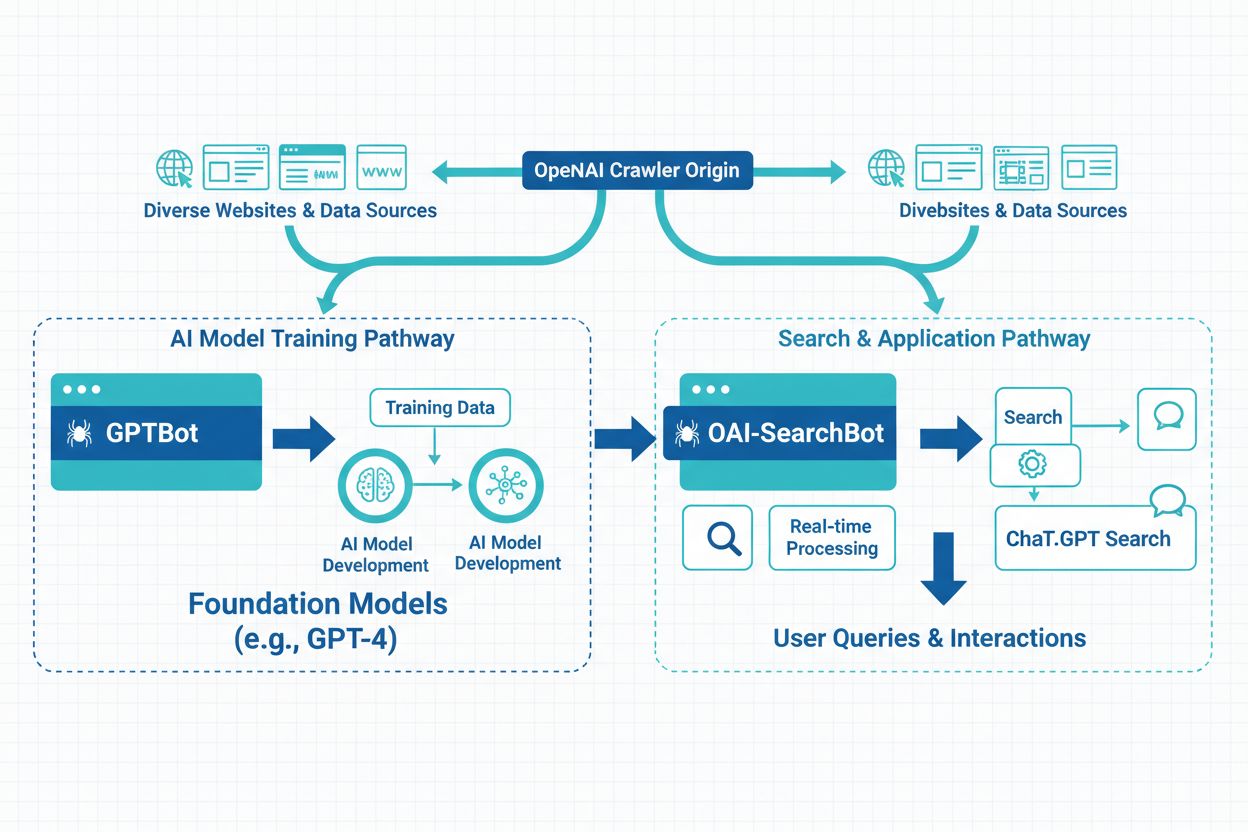

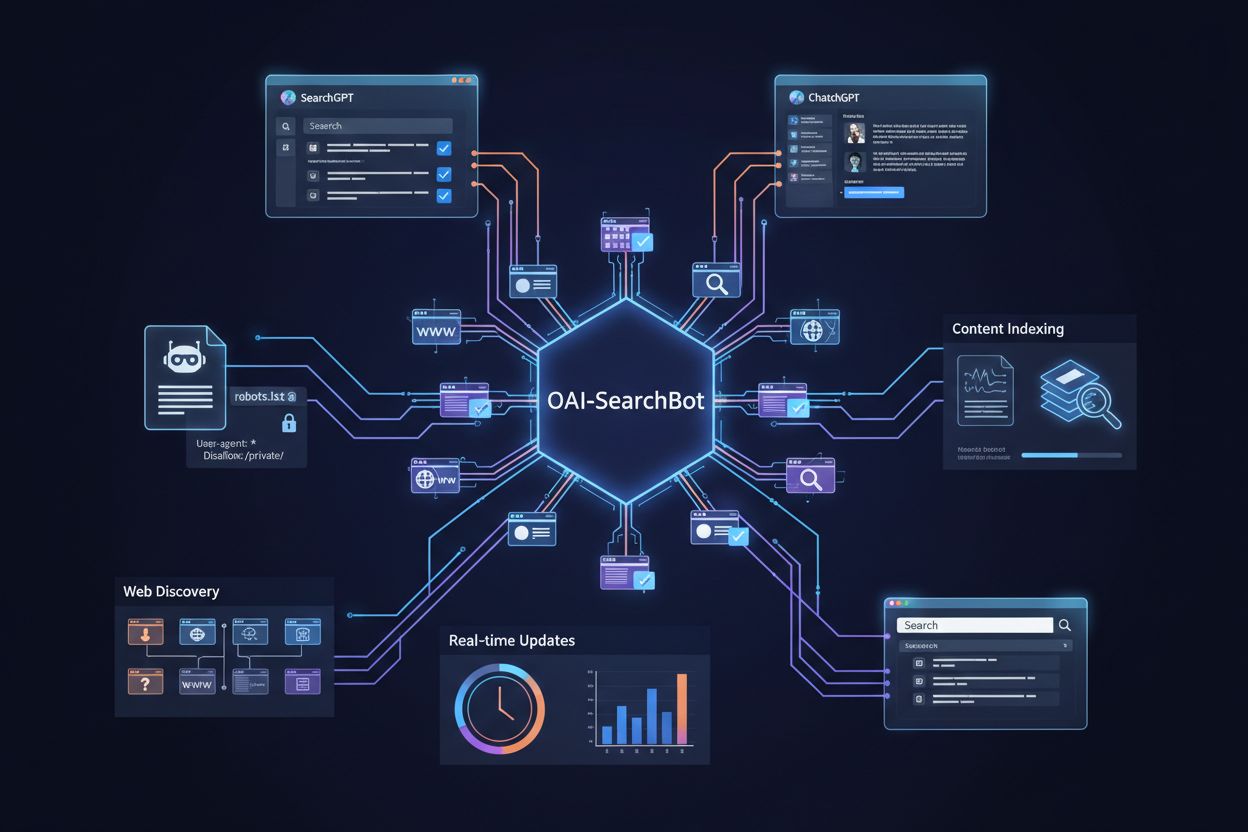

OpenAI operează trei tipuri distincte de crawlere pentru scopuri diferite: GPTBot (crawlare web generală pentru antrenare modele), ChatGPT-User (crawlarea link-urilor distribuite de utilizatorii ChatGPT) și ChatGPT-Plugins (accesarea conținutului prin integrări de plugin)—fiecare cu user agent string-uri și tipare de acces diferite. Dincolo de crawlerele OpenAI, peisajul AI include numeroase alte crawlere operate de companii concurente: Google-Extended (crawlerul Google pentru antrenare AI), CCBot (Commoncrawl), Perplexity (motor AI de căutare), Claude (modelul AI al Anthropic), precum și crawlere emergente de la alte companii AI, fiecare cu scopuri și tipare de utilizare a datelor distincte. Proprietarii de site se confruntă cu alegerea strategică între blocare selectivă (țintirea anumitor crawlere precum GPTBot permițând altora) și blocare completă (restricționarea tuturor crawlerelor AI pentru a menține controlul deplin asupra utilizării conținutului). Proliferarea crawlerelor AI înseamnă că blocarea doar a GPTBot nu protejează complet conținutul de antrenarea AI, deoarece alte crawlere pot accesa și indexa același material prin mecanisme alternative. Unii proprietari de site implementează strategii pe niveluri, blocând cele mai agresive sau cu impact comercial semnificativ crawlere, permițând în același timp accesul celor mai mici sau orientate spre cercetare. Înțelegerea diferențelor dintre aceste crawlere îi ajută pe proprietarii de site să ia decizii informate despre ce crawlere să blocheze în funcție de preocupările privind utilizarea datelor, impactul competitiv și obiectivele de afaceri.

Influența ChatGPT asupra comportamentului de căutare transformă modul în care utilizatorii descoperă informații, cu 800 de milioane de utilizatori săptămânal care se bazează din ce în ce mai mult pe instrumente AI în locul motoarelor de căutare tradiționale, schimbând fundamental peisajul competitiv al vizibilității conținutului. Rezumatele și snippet-urile generate de AI în răspunsurile ChatGPT servesc acum ca mecanisme alternative de descoperire, ceea ce înseamnă că un conținut care se clasează bine în rezultatele clasice poate fi ignorat dacă nu este selectat pentru includere în răspunsurile AI. Generative Engine Optimization (GEO) a devenit o disciplină esențială pentru creatorii de conținut cu viziune, concentrată pe optimizarea structurii, clarității și autorității conținutului pentru a crește șansele de includere în răspunsurile și rezumatele generate de AI. Implicațiile pe termen lung pentru vizibilitate sunt semnificative: site-urile care blochează GPTBot pot pierde oportunități de a apărea în răspunsurile ChatGPT, reducând potențial traficul din segmentul în creștere rapidă al căutărilor AI, în timp ce cele care permit accesul se poziționează pentru descoperirea bazată pe AI. Studiile indică faptul că 86,5% din conținutul din top 20 rezultate Google conține elemente parțial generate de AI, demonstrând că integrarea AI devine standard în peisajul căutărilor, nu doar o preocupare de nișă. Poziționarea competitivă depinde tot mai mult de vizibilitatea atât în motoarele de căutare tradiționale, cât și în sistemele AI, făcând deciziile strategice privind accesul GPTBot critice pentru succesul SEO pe termen lung și creșterea traficului organic. Proprietarii de site trebuie să echilibreze preocupările privind protecția conținutului cu riscul de a pierde vizibilitate în sistemele AI care devin principalele mecanisme de descoperire pentru milioane de utilizatori la nivel global.

GPTBot este crawlerul web oficial al OpenAI, conceput pentru a colecta date de antrenament pentru modele AI precum ChatGPT și GPT-4. Spre deosebire de Googlebot, care indexează conținutul pentru rezultatele motoarelor de căutare, GPTBot colectează date special pentru a îmbunătăți modelele de limbaj. Ambele crawlere respectă directivele robots.txt și accesează doar conținut disponibil publicului, dar servesc scopuri fundamental diferite în ecosistemul digital.

Decizia depinde de obiectivele afacerii și de strategia ta de conținut. Blochează GPTBot dacă ai conținut proprietar, operezi în industrii reglementate sau ai preocupări legate de proprietatea intelectuală. Permite GPTBot dacă dorești vizibilitate în ChatGPT (800M utilizatori săptămânal), beneficiezi de trafic din căutări AI (care convertește de 23 de ori mai bine decât cel organic) sau vrei să îți asiguri prezența digitală pentru viitorul căutărilor bazate pe AI.

Adaugă aceste linii în fișierul robots.txt pentru a bloca GPTBot de pe întregul site: User-agent: GPTBot / Disallow: /. Pentru a bloca directoare specifice, înlocuiește slash-ul cu calea directorului. Pentru a bloca toate crawlerele OpenAI, adaugă intrări separate User-agent pentru GPTBot, ChatGPT-User și ChatGPT-Plugins. Modificările intră în vigoare imediat și pot fi ușor reversibile.

Impactul GPTBot variază în funcție de dimensiunea site-ului și relevanța conținutului. Deși impactul fiecărui crawler este de obicei gestionabil, mai multe crawlere AI care operează simultan pot consuma o lățime de bandă semnificativă—unele site-uri raportează peste 30TB trafic lunar de crawlere pentru toți boții. Monitorizează jurnalele serverului pentru a urmări activitatea GPTBot și implementează limitarea ratei sau blocarea IP-urilor dacă consumul de bandă devine problematic.

Da, poți folosi directive robots.txt țintite pentru a bloca GPTBot de la anumite directoare sau pagini, permițând în același timp accesul la altele. De exemplu, poți interzice directoarele /private/ și /admin/, permițând restul site-ului. Această abordare selectivă îți permite să protejezi conținutul sensibil, menținând totodată vizibilitatea paginilor publice în sistemele AI.

Verifică jurnalele serverului pentru șirul user agent 'GPTBot/1.0' în anteturile cererilor HTTP. Majoritatea platformelor de analiză (Google Analytics, Semrush, Ahrefs) categorisesc și raportează automat activitatea GPTBot. Poți folosi și instrumente de monitorizare SEO care urmăresc specific activitatea crawlerelor AI. Monitorizarea regulată te ajută să înțelegi frecvența crawlării și să identifici eventuale impacturi asupra performanței.

Peisajul legal este încă în evoluție. Permiterea GPTBot ridică întrebări despre conformitatea GDPR, obligațiile CCPA și încălcarea drepturilor de autor, deși OpenAI susține că respectă directivele robots.txt. Blocarea GPTBot este simplă din punct de vedere legal, dar poate limita vizibilitatea în sistemele AI. Consultă-te cu un consilier juridic dacă operezi în industrii reglementate sau gestionezi date sensibile pentru a determina cea mai bună abordare pentru situația ta.

Permiterea GPTBot nu afectează direct clasamentele tradiționale Google, dar îți crește vizibilitatea în răspunsurile ChatGPT și alte rezultate de căutare bazate pe AI. Cu 800M utilizatori ChatGPT și trafic AI care convertește de 23 de ori mai bine decât cel organic, permiterea GPTBot te poziționează pentru vizibilitate pe termen lung în sistemele AI. Blocarea GPTBot poate reduce șansele de a apărea în răspunsuri generate de AI, limitând potențial traficul din segmentul de căutare cu cea mai rapidă creștere.

Urmărește cum apare brandul tău în ChatGPT, Perplexity, Google AI și alte platforme AI. Primește informații în timp real despre citările și vizibilitatea AI cu AmICited.

Află ce este GPTBot, cum funcționează și dacă ar trebui să permiți sau să blochezi crawler-ul web al OpenAI. Înțelege impactul asupra vizibilității brandului tă...

Află principalele diferențe dintre crawlerele GPTBot și OAI-SearchBot. Înțelege scopurile lor, comportamentul de crawl și cum să le gestionezi pentru vizibilita...

Află ce este OAI-SearchBot, cum funcționează și cum să îți optimizezi website-ul pentru crawler-ul de căutare dedicat OpenAI folosit de SearchGPT și ChatGPT....