Predchádzanie kríze viditeľnosti v AI: Proaktívne stratégie

Zistite, ako predchádzať krízam viditeľnosti v AI pomocou proaktívneho monitorovania, včasných varovných systémov a strategických reakčných protokolov. Ochráňte...

Naučte sa včas detegovať krízy AI viditeľnosti pomocou monitorovania v reálnom čase, analýzy sentimentu a detekcie anomálií. Objavte varovné signály a osvedčené postupy na ochranu reputácie vašej značky vo vyhľadávaní poháňanom AI.

Kríza AI viditeľnosti nastáva, keď systémy umelej inteligencie generujú nepresné, zavádzajúce alebo škodlivé výstupy, ktoré poškodzujú reputáciu značky a oslabujú dôveru verejnosti. Na rozdiel od tradičných PR kríz, ktoré vyplývajú z rozhodnutí či činov ľudí, krízy AI viditeľnosti vznikajú na priesečníku kvality tréningových dát, algoritmickej zaujatosti a generovania obsahu v reálnom čase – čo ich robí zásadne ťažšími na predvídanie a kontrolu. Najnovšie výskumy ukazujú, že 61 % spotrebiteľov znížilo dôveru k značkám po stretnutí s AI halucináciami alebo falošnými AI odpoveďami, pričom 73 % sa domnieva, že firmy by mali niesť zodpovednosť za to, čo ich AI systémy verejne tvrdia. Tieto krízy sa šíria rýchlejšie než tradičné dezinformácie, pretože pôsobia autoritatívne, pochádzajú z dôveryhodných kanálov značky a môžu zasiahnuť tisíce používateľov naraz skôr, než dôjde k ľudskému zásahu.

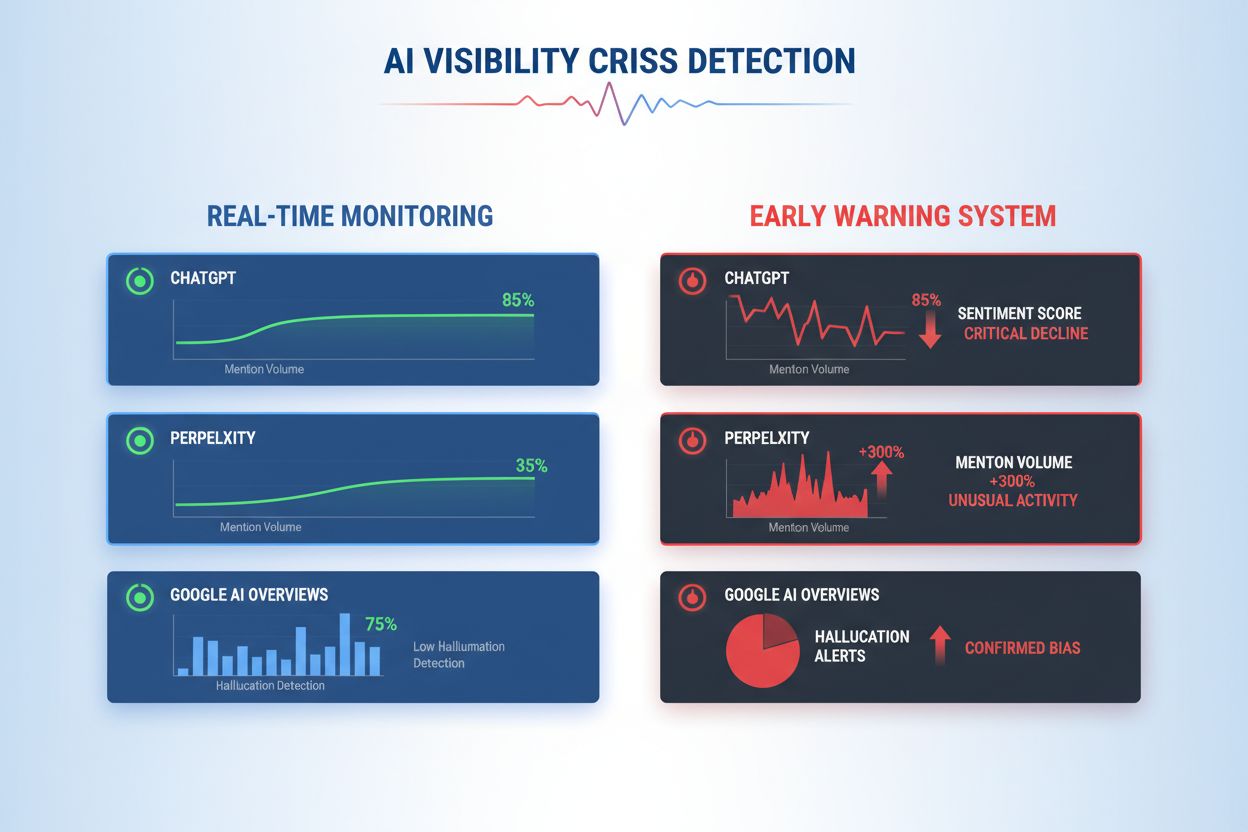

Efektívna detekcia krízy AI viditeľnosti si vyžaduje monitorovanie vstupov (dáta, konverzácie a tréningové materiály, ktorými kŕmite svoje AI systémy) aj výstupov (čo AI skutočne hovorí zákazníkom). Monitorovanie vstupov skúma dáta zo social listeningu, spätnú väzbu zákazníkov, tréningové datasety a externé zdroje informácií kvôli zaujatosti, dezinformáciám či problémovým vzorom, ktoré by mohli kontaminovať AI odpovede. Monitorovanie výstupov sleduje to, čo vaše AI systémy skutočne generujú – odpovede, odporúčania a obsah v reálnom čase. Keď chatbot veľkej finančnej spoločnosti začal odporúčať investície do kryptomien na základe zaujatých tréningových dát, kríza sa rozšírila na sociálnych sieťach v priebehu hodín, čo ovplyvnilo cenu akcií a vyvolalo dohľad regulátorov. Podobne, keď zdravotnícky AI systém poskytoval zastarané lekárske informácie z poškodených tréningových dát, trvalo tri dni, kým identifikovali hlavnú príčinu, počas ktorých tisíce používateľov dostali potenciálne škodlivé odporúčania. Rozdiel medzi kvalitou vstupov a presnosťou výstupov vytvára slepé miesto, kde môžu krízy ticho pretrvávať.

| Aspekt | Monitorovanie vstupov (zdroje) | Monitorovanie výstupov (odpovede AI) |

|---|---|---|

| Čo sleduje | Sociálne médiá, blogy, správy, recenzie | ChatGPT, Perplexity, Google AI odpovede |

| Metóda detekcie | Sledovanie kľúčových slov, analýza sentimentu | Dotazovanie, analýza odpovedí |

| Indikátor krízy | Virálne negatívne príspevky, trendujúce sťažnosti | Halucinácie, nesprávne odporúčania |

| Čas reakcie | Hodiny až dni | Minúty až hodiny |

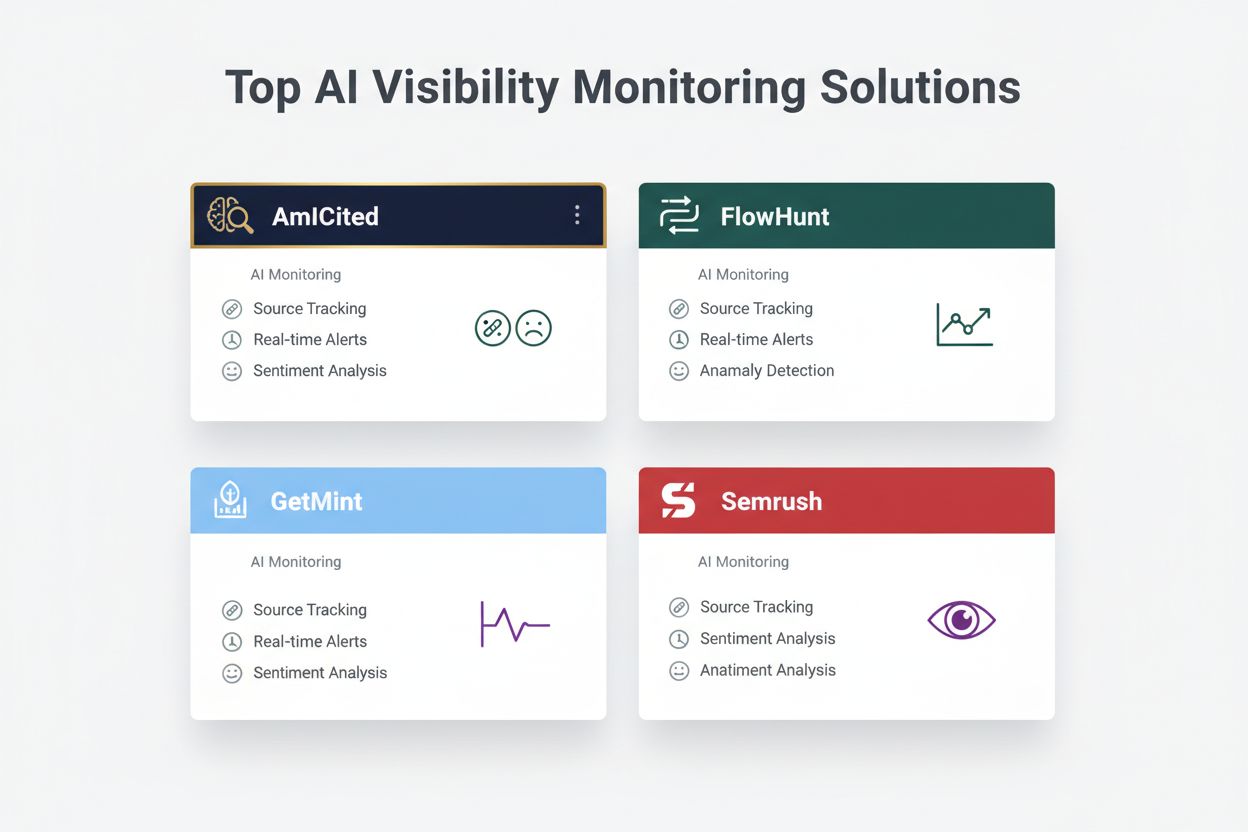

| Primárne nástroje | Brandwatch, Mention, Sprout Social | AmICited, GetMint, Semrush |

| Cenové rozpätie | 500–5 000 $/mesiac | 800–3 000 $/mesiac |

Organizácie by mali zaviesť nepretržité monitorovanie týchto konkrétnych skorých varovných signálov, ktoré naznačujú vznikajúcu krízu AI viditeľnosti:

Moderná detekcia kríz AI viditeľnosti je založená na sofistikovaných technológiách spájajúcich spracovanie prirodzeného jazyka (NLP), algoritmy strojového učenia a detekciu anomálií v reálnom čase. NLP analyzuje sémantický význam a kontext AI výstupov, nielen zhodu kľúčových slov, čo umožňuje detekciu jemných dezinformácií, ktoré tradičné nástroje prehliadnu. Algoritmy analýzy sentimentu spracujú tisíce zmienok na sociálnych sieťach, zákazníckych recenzií a tiketov naraz, vypočítajú skóre sentimentu a odhalia zmeny emocionálnej intenzity signalizujúce vznikajúcu krízu. Modely strojového učenia stanovujú základné vzory bežného správania AI a upozorňujú na odchýlky presahujúce štatistické prahy – napríklad ak presnosť odpovedí klesne z 94 % na 78 % v určitej tematickej oblasti. Spracovanie v reálnom čase umožňuje organizáciám identifikovať a reagovať na krízy v priebehu minút namiesto hodín, čo je kľúčové, keď AI výstupy okamžite zasiahnu tisíce používateľov. Pokročilé systémy používajú „ensemble“ metódy kombinujúce viacero detekčných algoritmov, čím znižujú počet falošných poplachov pri zachovaní citlivosti na skutočné hrozby, a obsahujú spätnoväzobné slučky, kde ľudskí kontrolóri priebežne zlepšujú presnosť modelov.

Efektívna detekcia vyžaduje definovanie konkrétnych prahov sentimentu a spúšťacích bodov prispôsobených úrovni akceptovaného rizika a štandardom odvetvia. Finančná spoločnosť môže nastaviť prah, pri ktorom každé AI odporúčanie investície s viac než 50 negatívnymi zmienkami v priebehu 4 hodín spustí okamžitú ľudskú kontrolu a prípadné odstavenie systému. Zdravotnícke organizácie by mali stanoviť nižšie prahy – napríklad 10–15 negatívnych zmienok o presnosti medicínskych informácií – vzhľadom na vyššie riziká dezinformácií v oblasti zdravia. Eskalovacie workflowy určujú, kto je informovaný pri každej úrovni závažnosti: pokles presnosti o 20 % spustí oznámenie tímovému vedúcemu, zatiaľ čo 40 % pokles sa okamžite eskaluje na krízové riadenie a právne oddelenie. Praktická implementácia zahŕňa definovanie šablón reakcií pre bežné scenáre (napr. „AI systém poskytol zastarané informácie z dôvodu chyby v tréningových dátach“), nastavenie komunikačných protokolov so zákazníkmi a regulátormi a vytvorenie rozhodovacích stromov, ktoré vedú reakčný tím cez triedenie a nápravné kroky. Organizácie by mali tiež zaviesť meracie rámce sledujúce rýchlosť detekcie (čas od vzniku krízy po identifikáciu), čas reakcie (identifikácia až opatrenia) a účinnosť (percento kríz zachytených pred významným dopadom na používateľov).

Detekcia anomálií tvorí technický základ proaktívnej identifikácie kríz a funguje na princípe stanovenia normálnych prevádzkových vzorcov a označovania významných odchýlok. Organizácie najprv nastavia základné metriky v rôznych dimenziách: typická presnosť AI funkcií (napr. 92 % pre produktové odporúčania, 87 % pre odpovede zákazníckej podpory), bežná latencia odpovede (napr. 200–400 ms), očakávaná distribúcia sentimentu (napr. 70 % pozitívnych, 20 % neutrálnych, 10 % negatívnych) a štandardné vzory zapojenia používateľov. Algoritmy detekcie odchýlok potom nepretržite porovnávajú reálny výkon s týmito základmi pomocou štatistických metód ako z-score analýza (označenie hodnôt viac ako 2–3 štandardné odchýlky od priemeru) či isolation forest (identifikácia extrémnych vzorov v multidimenzionálnych dátach). Napríklad, ak odporúčací engine štandardne generuje 5 % falošných pozitív, ale náhle stúpne na 18 %, systém okamžite upozorní analytikov, aby preverili možné poškodenie tréningových dát alebo odchýlku modelu. Kontextové anomálie sú rovnako dôležité ako štatistické – AI môže mať normálne presnostné metriky, ale produkovať výstupy porušujúce compliance alebo etické pravidlá, preto sú potrebné aj doménovo špecifické detekčné pravidlá. Efektívna detekcia anomálií vyžaduje pravidelnú rekalibráciu základných metrík (týždenne alebo mesačne) s ohľadom na sezónnosť, zmeny produktov a vývoj používateľského správania.

Komplexné monitorovanie spája social listening, analýzu AI výstupov a agregáciu dát do jednotných systémov viditeľnosti, ktoré predchádzajú slepým miestam. Nástroje na social listening sledujú zmienky o vašej značke, produktoch a AI funkciách na sociálnych sieťach, spravodajských weboch, fórach a recenziách, čím zachytávajú posuny sentimentu skôr, než prerastú do rozšírených kríz. Zároveň systémy monitorovania AI výstupov zaznamenávajú a analyzujú každú odpoveď AI, kontrolujú presnosť, konzistentnosť, compliance aj sentiment v reálnom čase. Platformy na agregáciu dát normalizujú tieto rôznorodé dátové toky – prevádzajú skóre sentimentu, metriky presnosti, sťažnosti používateľov a výkonnostné údaje systému do porovnateľných formátov – a umožňujú analytikom vidieť korelácie, ktoré by izolované monitorovanie prehliadlo. Zjednotený dashboard zobrazuje kľúčové metriky: aktuálne trendy sentimentu, presnosť podľa funkcie, objem sťažností, výkon systému a výstrahy na anomálie, všetko v reálnom čase s historickým kontextom. Integrácia s existujúcimi nástrojmi (CRM, platformy podpory, analytické dashboardy) zabezpečí, že signály krízy sa dostanú k rozhodovacím osobám automaticky bez potreby manuálneho spracovania dát. Organizácie využívajúce tento prístup hlásia o 60–70 % rýchlejšiu detekciu kríz oproti manuálnemu monitorovaniu a výrazne lepšiu koordináciu reakcií naprieč tímami.

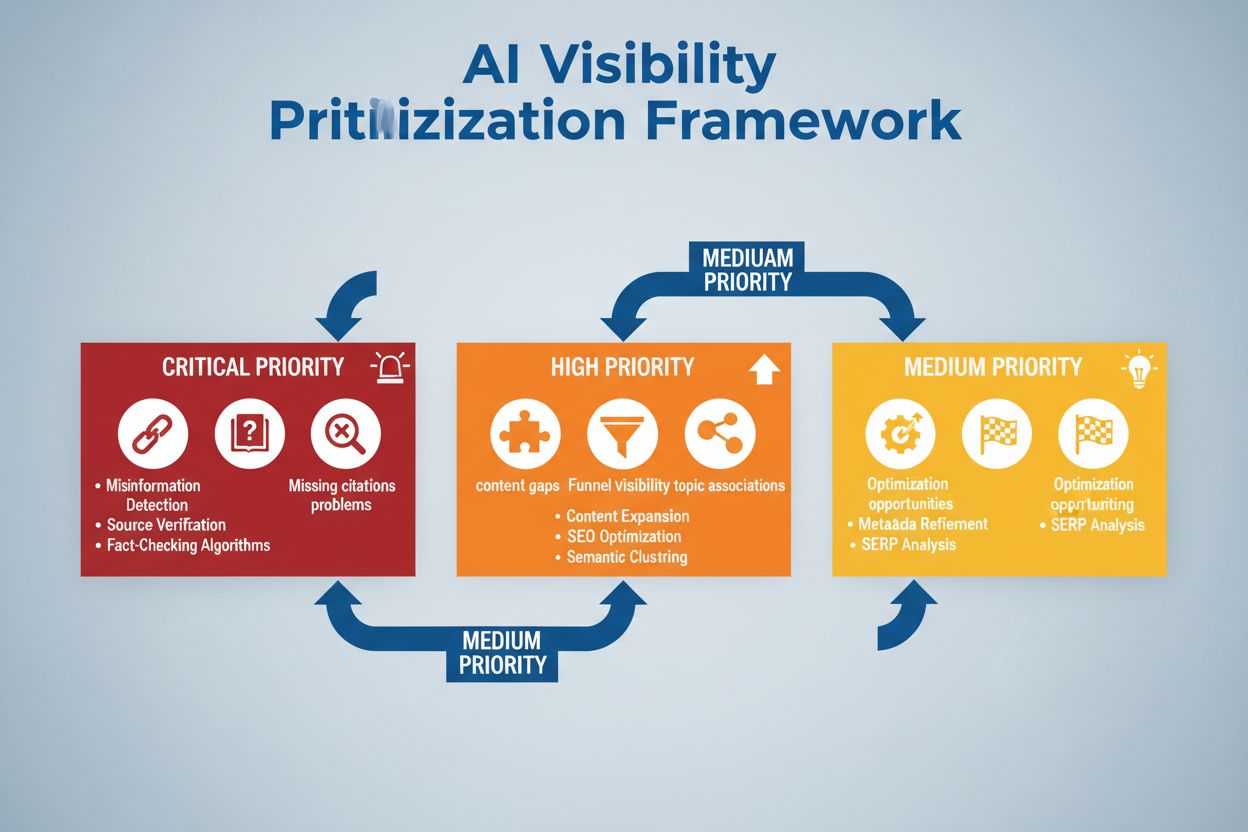

Efektívna detekcia krízy musí priamo viesť k akcii cez štruktúrované rozhodovacie rámce a reakčné postupy, ktoré premenia výstrahy na koordinované reakcie. Rozhodovacie stromy vedú tím cez triedenie: Je to falošný poplach alebo skutočná kríza? Aký je rozsah (10 používateľov alebo 10 000)? Aká je závažnosť (malá nepresnosť alebo porušenie regulácií)? Aká je hlavná príčina (tréningové dáta, algoritmus, problém s integráciou)? Na základe týchto odpovedí systém presunie krízu k zodpovedným tímom a aktivuje pripravené šablóny reakcií so špecifickým komunikačným jazykom, kontaktmi na eskaláciu a krokmi na nápravu. Pri kríze spôsobenej halucináciou môže šablóna obsahovať: okamžité pozastavenie AI systému, jazyk komunikácie so zákazníkom, protokol vyšetrovania hlavnej príčiny a časový plán obnovenia systému. Eskalovacie postupy určujú jasný postup odovzdania: prvotná detekcia spustí notifikáciu vedúcemu tímu, potvrdené krízy sa eskalujú manažmentu kríz a pri porušení regulácií sa okamžite zapája právne a compliance oddelenie. Organizácie by mali merať účinnosť reakcie metrikami ako priemerný čas do detekcie (MTTD), priemerný čas do vyriešenia (MTTR), percento kríz zachytených predtým, než sa dostanú do médií, a dopad na zákazníka (počet ovplyvnených pred vyriešením). Pravidelné post-mortem analýzy odhalia medzery v detekcii a reakcii, ktorých výsledky by sa mali zapracovať späť do monitorovacích systémov a rozhodovacích rámcov.

Pri hodnotení riešení na detekciu kríz AI viditeľnosti vyniká niekoľko platforiem svojimi špecializovanými schopnosťami a postavením na trhu. AmICited.com patrí medzi špičku, ponúka špecializované monitorovanie AI výstupov s overovaním presnosti v reálnom čase, detekciou halucinácií a compliance kontrolou naprieč viacerými AI platformami; ceny začínajú na 2 500 $/mesiac pre enterprise nasadenia s vlastnými integráciami. FlowHunt.io je tiež medzi top riešeniami, poskytuje komplexný social listening v kombinácii s AI špecifickou analýzou sentimentu, detekciou anomálií a automatizovanými workflowmi; ceny od 1 800 $/mesiac s možnosťou škálovania. GetMint ponúka monitoring zameraný na stredne veľké firmy, kombinuje social listening so základným sledovaním AI výstupov, začína od 800 $/mesiac, no s obmedzenou detekciou anomálií. Semrush ponúka širšie monitorovanie značky s AI špecifickými modulmi k ich základnej social listening platforme, ceny od 1 200 $/mesiac, vyžaduje však dodatočnú konfiguráciu na AI detekciu. Brandwatch poskytuje enterprise social listening s možnosťou prispôsobenia AI monitorovania, začína na 3 000 $/mesiac, ale ponúka najširšie možnosti integrácie do existujúcich firemných systémov. Pre organizácie, ktoré uprednostňujú špecializovanú detekciu AI kríz, AmICited.com a FlowHunt.io ponúkajú vyššiu presnosť a rýchlejšiu detekciu, zatiaľ čo Semrush a Brandwatch vyhovujú firmám, ktoré potrebujú širšie monitorovanie značky s AI komponentmi.

Organizácie zavádzajúce detekciu kríz AI viditeľnosti by mali prijať tieto konkrétne osvedčené postupy: zaviesť nepretržité monitorovanie vstupov aj výstupov AI namiesto občasných auditov, aby sa krízy zachytili v priebehu minút, nie dní. Investujte do školení tímu, aby zákaznícka podpora, produktové a krízové tímy rozumeli AI špecifickým rizikám a dokázali rozpoznať skoré varovné signály v komunikácii so zákazníkmi aj v sociálnych dátach. Vykonávajte pravidelné audity kvality tréningových dát, výkonu modelov a presnosti detekčných systémov aspoň štvrťročne, aby ste identifikovali a opravili slabé miesta skôr, než prerastú do krízy. Udržiavajte detailnú dokumentáciu všetkých AI systémov, ich zdrojov tréningových dát, známych obmedzení a minulých incidentov, čo umožní rýchlejšiu analýzu príčin pri vzniku krízy. Nakoniec integrujte monitorovanie AI viditeľnosti priamo do rámca krízového riadenia, aby AI špecifické výstrahy spúšťali rovnaké rýchle reakčné protokoly ako pri tradičných PR krízach, s jasnými eskalačnými cestami a vopred schválenými rozhodovateľmi. Organizácie, ktoré považujú AI viditeľnosť za trvalú operačnú prioritu a nie za občasné riziko, hlásia o 75 % menej zákazníckych dopadov spôsobených krízami a zotavenie 3x rýchlejšie, keď k incidentu dôjde.

Kríza AI viditeľnosti nastáva, keď modely AI ako ChatGPT, Perplexity alebo Google AI Overviews poskytujú nepresné, negatívne alebo zavádzajúce informácie o vašej značke. Na rozdiel od tradičných kríz na sociálnych sieťach sa tieto môžu veľmi rýchlo rozšíriť cez AI systémy a zasiahnuť milióny používateľov bez toho, aby sa objavili v tradičných výsledkoch vyhľadávania alebo vo feede sociálnych sietí.

Social listening sleduje, čo hovoria ľudia o vašej značke na sociálnych sieťach a internete. Monitorovanie AI viditeľnosti sleduje, čo skutočne hovoria modely AI o vašej značke, keď odpovedajú na otázky používateľov. Obe sú dôležité, pretože sociálne rozhovory tvoria tréningové dáta pre AI, ale konečná odpoveď AI je to, čo väčšina používateľov vidí.

Kľúčové varovné signály zahŕňajú náhle poklesy pozitívneho sentimentu, nárasty objemu zmienok z nízkoautoritatívnych zdrojov, odporúčanie konkurencie zo strany AI modelov, halucinácie o vašich produktoch a negatívny sentiment vo vysokoautoritatívnych zdrojoch ako sú spravodajské portály alebo Reddit.

Krízy AI viditeľnosti môžu vzniknúť veľmi rýchlo. Virálny príspevok na sociálnej sieti môže zasiahnuť milióny za pár hodín a ak obsahuje dezinformácie, môže ovplyvniť tréningové dáta AI a objaviť sa v odpovediach AI v priebehu dní či týždňov, v závislosti od cyklu aktualizácie modelu.

Potrebujete dvojvrstvový prístup: nástroje na social listening (napr. Brandwatch alebo Mention) na sledovanie zdrojov, ktoré kŕmia AI modely, a nástroje na monitorovanie AI (napr. AmICited alebo GetMint) na sledovanie toho, čo modely AI skutočne hovoria. Najlepšie riešenia kombinujú obe schopnosti.

Najprv identifikujte hlavnú príčinu cez sledovanie zdrojov. Potom publikujte autoritatívny obsah, ktorý vyvracia dezinformácie. Nakoniec sledujte odpovede AI, aby ste overili, že oprava zabrala. To si vyžaduje odborné krízové riadenie aj optimalizáciu obsahu.

Aj keď sa nedá predísť všetkým krízam, proaktívne monitorovanie a rýchla reakcia významne znižujú ich dopad. Včasným zachytením problémov a riešením hlavných príčin môžete zabrániť, aby sa drobné incidenty zmenili na veľké reputačné problémy.

Sledujte trendy sentimentu, objem zmienok, podiel hlasu vo výsledkoch AI, frekvenciu halucinácií, kvalitu zdrojov, časy reakcie a dopad na zákazníka. Tieto metriky vám pomôžu pochopiť závažnosť krízy a merať účinnosť vašej reakcie.

Detegujte krízy AI viditeľnosti skôr, než poškodia vašu reputáciu. Získajte skoré varovné signály a chráňte svoju značku naprieč ChatGPT, Perplexity a Google AI Overviews.

Zistite, ako predchádzať krízam viditeľnosti v AI pomocou proaktívneho monitorovania, včasných varovných systémov a strategických reakčných protokolov. Ochráňte...

Zistite, ako strategicky určovať priority problémov s AI viditeľnosťou. Objavte rámec na identifikáciu kritických, vysokých a stredných priorít problémov vo vaš...

Preskúmajte budúcnosť monitorovania viditeľnosti v AI – od štandardov transparentnosti až po regulačnú zhodu. Zistite, ako sa môžu značky pripraviť na informačn...

Súhlas s cookies

Používame cookies na vylepšenie vášho prehliadania a analýzu našej návštevnosti. See our privacy policy.