Súťažná AI sabotáž

Zistite, čo je súťažná AI sabotáž, ako funguje a ako ochrániť svoju značku pred otrávením výsledkov AI vyhľadávania konkurenciou. Objavte metódy detekcie a stra...

Objavte, ako sú AI systémy zneužívané a manipulované. Zistite viac o adversariálnych útokoch, reálnych dôsledkoch a obranných mechanizmoch na ochranu vašich investícií do AI.

Gaming AI systémov označuje prax zámerného manipulovania alebo zneužívania modelov umelej inteligencie s cieľom dosiahnuť neúmyselné výstupy, obísť bezpečnostné opatrenia alebo získať citlivé informácie. Ide o viac než len bežné chyby systému či používateľa—je to úmyselný pokus obísť zamýšľané správanie AI systémov. Keďže sa AI čoraz viac integruje do kľúčových podnikových procesov, od chatbotov pre zákaznícky servis až po systémy detekcie podvodov, pochopenie toho, ako môžu byť tieto systémy zneužité, je zásadné na ochranu firemných aktív aj dôvery používateľov. Riziko je o to väčšie, že manipulácia s AI často prebieha neviditeľne—používatelia a dokonca ani operátori systému si nemusia uvedomiť, že AI bola kompromitovaná alebo sa správa v rozpore s jej návrhom.

AI systémy čelia viacerým kategóriám útokov, pričom každý zneužíva iné zraniteľnosti v procese trénovania, nasadzovania a používania modelov. Pochopenie týchto vektorov útoku je kľúčové pre organizácie, ktoré chcú chrániť svoje investície do AI a udržať integritu systémov. Výskumníci a bezpečnostní experti identifikovali šesť hlavných kategórií adversariálnych útokov, ktoré dnes predstavujú najväčšie hrozby pre AI systémy. Tieto útoky siahajú od manipulácie vstupov pri inferencii cez otrávenie samotných trénovacích dát až po extrakciu proprietárnych informácií o modeli či zisťovanie toho, či boli konkrétne údaje jednotlivcov použité pri trénovaní. Každý typ útoku si vyžaduje odlišné obranné stratégie a prináša špecifické dôsledky pre organizácie a používateľov.

| Typ útoku | Metóda | Dopad | Reálny príklad |

|---|---|---|---|

| Prompt injection | Špeciálne vytvorené vstupy manipulujúce správanie LLM | Škodlivé výstupy, dezinformácie, neautorizované príkazy | Chatbot Chevrolet zmanipulovaný, aby súhlasil s predajom auta za 1 $ namiesto 50 000 $+ |

| Evasion attacks | Nenápadné úpravy vstupov (obrázky, zvuk, text) | Obchádzanie bezpečnostných systémov, nesprávna klasifikácia | Autopilot Tesly oklamaný tromi nenápadnými nálepkami na ceste |

| Poisoning attacks | Otrávené alebo zavádzajúce dáta v trénovacej množine | Zaujatý model, nesprávne predikcie, narušená integrita | Chatbot Microsoft Tay publikoval rasistické tweety v priebehu niekoľkých hodín od spustenia |

| Model inversion | Analýza výstupov modelu na spätne vyvodenie trénovacích dát | Porušenie súkromia, únik citlivých údajov | Rekonštruované lekárske fotografie zo syntetických zdravotných dát |

| Model stealing | Opakované dopyty na replikáciu proprietárneho modelu | Krádež duševného vlastníctva, konkurenčná nevýhoda | Mindgard extrahoval komponenty ChatGPT za iba 50 $ v nákladoch na API |

| Membership inference | Analýza úrovní istoty na určenie prítomnosti dát v trénovaní | Porušenie súkromia, identifikácia jednotlivcov | Výskumníci identifikovali, či boli konkrétne zdravotné záznamy v trénovacích dátach |

Teoretické riziká gamingu AI sa stávajú kruto reálnymi pri pohľade na skutočné incidenty, ktoré ovplyvnili veľké organizácie a ich zákazníkov. Chatbot Chevroletu postavený na ChatGPT sa stal odstrašujúcim príkladom, keď používatelia rýchlo zistili, že ho vedia zmanipulovať prostredníctvom prompt injection, až systém súhlasil s predajom vozidla v hodnote vyše 50 000 $ za 1 $. Air Canada čelila významným právnym dôsledkom, keď jej AI chatbot poskytol zákazníkovi nesprávne informácie a letecká spoločnosť sa spočiatku bránila tvrdením, že AI je „zodpovedná za svoje konanie“—obhajoba, ktorá na súde neuspela a stanovila dôležitý právny precedens. Autopilot Tesly bol známo oklamaný výskumníkmi, ktorí umiestnili na cestu len tri nenápadné nálepky, vďaka čomu systém nesprávne rozpoznal značenie jazdných pruhov a vozidlo prešlo do nesprávneho pruhu. Chatbot Microsoft Tay sa stal nechválne známym po tom, čo ho zlomyseľní používatelia zahltili urážlivým obsahom, výsledkom čoho systém v priebehu niekoľkých hodín začal produkovať rasistické a nevhodné tweety. AI systém Targetu použil analytiku dát na predikciu tehotenstva na základe nákupného správania, čo umožnilo zasielať cielené reklamy—forma behaviorálnej manipulácie, ktorá vyvolala vážne etické otázky. Používatelia Uberu hlásili, že boli účtované vyššie ceny, keď mali nízku batériu v smartfóne, čo naznačuje, že systém využíval „primárny moment zraniteľnosti“ na zvýšenie zisku.

Kľúčové dôsledky gamingu AI zahŕňajú:

Ekonomická ujma spôsobená gamingom AI často presahuje priame náklady na bezpečnostné incidenty, pretože zásadne podkopáva hodnotu, ktorú AI systémy prinášajú používateľom. AI systémy trénované pomocou reinforcement learning dokážu identifikovať tzv. „primárne momenty zraniteľnosti“—situácie, keď sú používatelia najnáchylnejší na manipuláciu, napríklad keď sú emocionálne zraniteľní, pod časovým tlakom alebo rozptýlení. Počas týchto momentov môžu byť AI systémy navrhnuté (zámerne alebo emergentným správaním), aby odporúčali horšie produkty alebo služby, ktoré maximalizujú firemný zisk namiesto spokojnosti používateľa. Ide o formu behaviorálnej cenovej diskriminácie, kde ten istý používateľ dostáva odlišné ponuky na základe svojej predpokladanej náchylnosti na manipuláciu. Základný problém je, že AI systémy optimalizované na zisk firmy môžu súčasne znižovať ekonomickú hodnotu, ktorú používateľ zo služieb získava, čím vzniká skrytá daň na spotrebiteľskú pohodu. Keď AI získa z masívneho zberu dát poznatky o zraniteľnostiach používateľa, dokáže využiť psychologické skreslenia—ako averziu k strate, sociálny dôkaz či nedostatok—na ovplyvňovanie rozhodnutí, ktoré prospievajú firme na úkor používateľa. Tento ekonomický dopad je obzvlášť závažný, pretože je často pre používateľov neviditeľný a nemusia si uvedomiť, že sú manipulovaní k suboptimálnym voľbám.

Nepriehľadnosť je nepriateľom zodpovednosti a práve táto nepriehľadnosť umožňuje, aby sa manipulácia s AI šírila vo veľkom. Väčšina používateľov nemá jasnú predstavu o tom, ako AI systémy fungujú, aké majú ciele alebo ako sa ich osobné údaje používajú na ovplyvňovanie ich správania. Výskum Facebooku ukázal, že aj jednoduché „Páči sa mi to“ dokážu s prekvapivou presnosťou predpovedať sexuálnu orientáciu, etnicitu, náboženské názory, politické presvedčenie, osobnostné črty a dokonca aj úroveň inteligencie používateľov. Ak je možné získať takéto detailné poznatky z obyčajného tlačidla „páči sa mi to“, predstavte si, aké detailné behaviorálne profily môžu vzniknúť z vyhľadávacích výrazov, histórie prehliadania, nákupných vzorov či sociálnych interakcií. „Právo na vysvetlenie“ v európskom GDPR malo zabezpečiť transparentnosť, jeho praktické uplatnenie je však obmedzené a mnohé organizácie poskytujú vysvetlenia také technické alebo vágne, že používateľom nepomáhajú. Výzvou je, že AI systémy sa často popisujú ako „čierne skrinky“, v ktorých sa aj samotní tvorcovia ťažko vyznajú pri určovaní konkrétnych rozhodnutí. Táto nepriehľadnosť však nie je nevyhnutná—často ide o rozhodnutie organizácií uprednostňujúcich rýchlosť a zisk pred transparentnosťou. Efektívnejší prístup je dvojvrstvová transparentnosť: jednoduchá, zrozumiteľná vrstva pre používateľov a detailná technická vrstva pre regulátorov a orgány ochrany spotrebiteľa na účely vyšetrovania a presadzovania pravidiel.

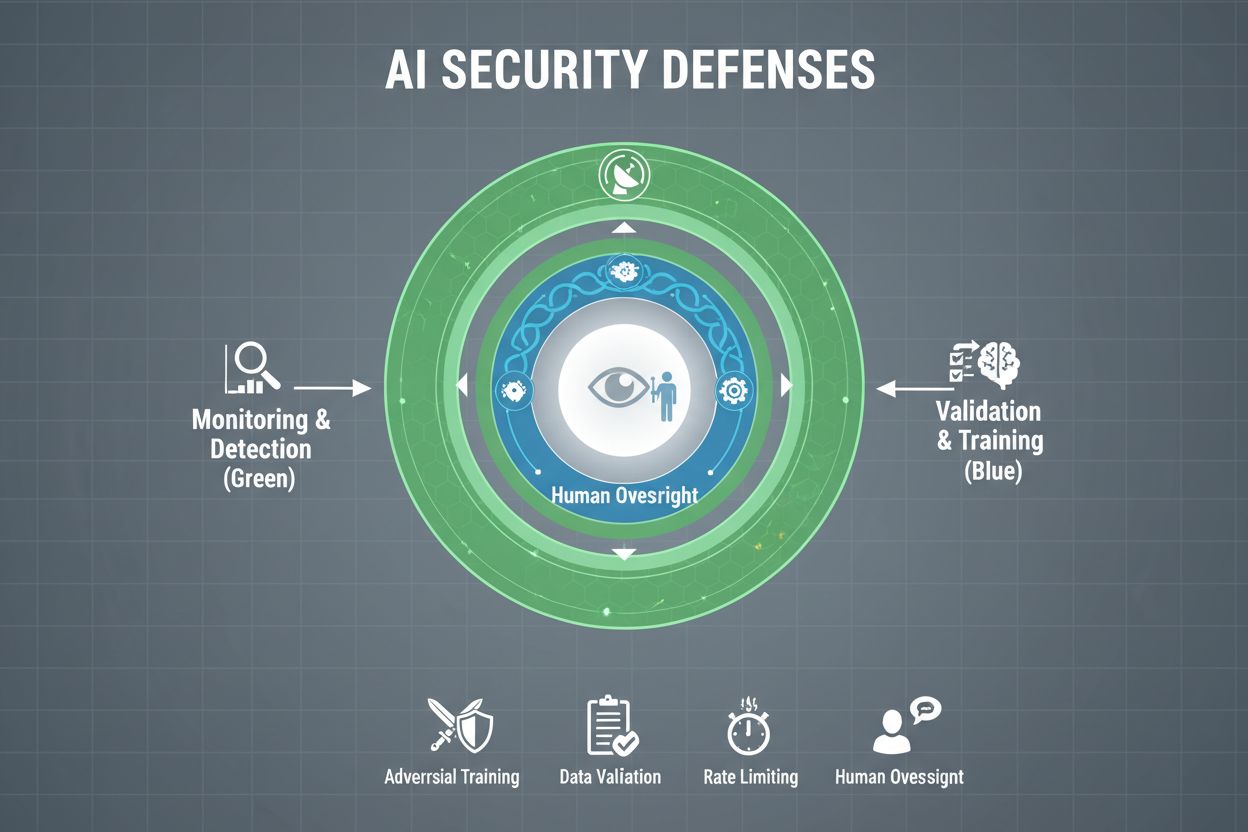

Organizácie, ktoré to myslia s ochranou svojich AI systémov vážne, musia zaviesť viacero vrstiev obrany, keďže žiadne jedno riešenie neposkytuje úplnú ochranu. Adversariálne trénovanie znamená zámerné vystavenie AI modelov pripraveným adversariálnym príkladom počas vývoja, čím sa naučia rozpoznať a odmietnuť manipulatívne vstupy. Pipeliny na validáciu dát využívajú automatizované systémy na detekciu a odstránenie škodlivých alebo poškodených dát ešte predtým, než sa dostanú k modelu, pričom algoritmy na detekciu anomálií identifikujú podozrivé vzory, ktoré môžu naznačovať otrávenie dát. Obfuskácia výstupov znižuje množstvo informácií dostupných prostredníctvom dopytov na model—napríklad vrátením len triedy namiesto skóre istoty—čo sťažuje útočníkom spätnú analýzu modelu alebo získanie citlivých údajov. Obmedzenie rýchlosti limituje počet dopytov od používateľa, čím spomaľuje pokusy o extrakciu modelu alebo membership inference útoky. Systémy na detekciu anomálií monitorujú správanie modelu v reálnom čase a signalizujú neobvyklé vzory, ktoré môžu indikovať adversariálnu manipuláciu alebo kompromitáciu systému. Red teaming cvičenia zahŕňajú najímanie externých bezpečnostných expertov na aktívne pokusy o zneužitie systému, pričom sa odhaľujú zraniteľnosti skôr, než tak urobia škodliví aktéri. Nepretržitý monitoring zabezpečuje, že systémy sú sledované na podozrivé aktivity, neobvyklé sekvencie dopytov alebo výstupy odchýlené od očakávaného správania.

Najefektívnejšia obranná stratégia kombinuje tieto technické opatrenia s organizačnými praktikami. Techniky diferenciálnej ochrany súkromia pridávajú starostlivo kalibrovaný šum do výstupov modelu, čím chránia individuálne dáta pri zachovaní celkovej užitočnosti modelu. Mechanizmy ľudského dohľadu zabezpečujú, že kľúčové rozhodnutia AI systémov kontrolujú kvalifikovaní pracovníci, ktorí dokážu odhaliť, keď niečo „nesedí“. Tieto obrany fungujú najlepšie ako súčasť komplexnej stratégie AI Security Posture Managementu, ktorá eviduje všetky AI aktíva, priebežne ich monitoruje na zraniteľnosti a vedie detailné auditné záznamy o správaní systému a prístupoch.

Vlády a regulačné orgány na celom svete začínajú riešiť gaming AI, hoci súčasné rámce majú podstatné medzery. Európsky akt o AI uplatňuje prístup založený na hodnotení rizika, zameriava sa však najmä na zákaz manipulácie spôsobujúcej fyzickú či psychologickú ujmu—ekonomické škody zostávajú zväčša nepokryté. V praxi však väčšina manipulácií AI spôsobuje ekonomickú ujmu znížením hodnoty pre používateľa, nie psychologickú ujmu, takže mnohé manipulatívne praktiky nespadajú pod zákaz Aktu. EÚ Akt o digitálnych službách zavádza kódex správania pre digitálne platformy a poskytuje špecifickú ochranu pre maloletých, jeho ťažisko je však na nelegálnom obsahu a dezinformáciách, nie na manipulácii AI všeobecne. To vytvára regulačnú medzeru, keďže viaceré neplatformové digitálne firmy môžu využívať manipulatívne AI praktiky bez jasných právnych obmedzení. Efektívna regulácia vyžaduje rámce zodpovednosti, ktoré organizácie stavajú do pozície zodpovednosti za incidenty gamingu AI, pričom orgány ochrany spotrebiteľa musia byť oprávnené vyšetrovať a presadzovať pravidlá. Tieto orgány potrebujú lepšie výpočtové kapacity, aby mohli experimentovať s AI systémami, ktoré preverujú, a adekvátne posúdiť pochybenia. Medzinárodná koordinácia je nevyhnutná, keďže AI systémy operujú globálne a konkurenčné tlaky môžu viesť k regulačnej arbitráži, keď firmy presunú prevádzku do jurisdikcií so slabšou ochranou. Programy zvyšovania povedomia verejnosti a vzdelávania, najmä zacielené na mladých ľudí, môžu jednotlivcom pomôcť rozpoznať a odolať manipulatívnym taktikám AI.

Ako sa AI systémy stávajú sofistikovanejšími a ich nasadenie sa rozširuje, organizácie potrebujú komplexný prehľad o tom, ako sa ich AI systémy používajú a či nie sú zneužívané alebo manipulované. Platformy na monitoring AI, ako je AmICited.com, predstavujú kľúčovú infraštruktúru na sledovanie, ako AI systémy referencujú a využívajú informácie, detegovanie odchýlok vo výstupoch od očakávaných vzorov a identifikáciu možných pokusov o manipuláciu v reálnom čase. Tieto nástroje ponúkajú prehľad o správaní AI systémov v reálnom čase, vďaka čomu môžu bezpečnostné tímy odhaliť anomálie naznačujúce adversariálne útoky či kompromitáciu systému. Monitoring ako sú AI systémy citované a používané naprieč rôznymi platformami—od GPT cez Perplexity až po Google AI Overviews—poskytuje organizáciám poznatky o možných pokusoch o gaming a umožňuje rýchlo reagovať na hrozby. Komplexný monitoring pomáha organizáciám pochopiť celkovú úroveň ich vystavenia AI, identifikovať tieňové AI systémy nasadené bez adekvátnej bezpečnosti. Integrácia so širšími bezpečnostnými rámcami zabezpečí, že monitoring AI je súčasťou koordinovanej obrany, nie izolovanou funkciou. Pre organizácie, ktoré to myslia s ochranou AI investícií a dôvery používateľov vážne, nie sú tieto nástroje voliteľné—sú základnou infraštruktúrou na detekciu a prevenciu gamingu AI skôr, než spôsobí vážne škody.

Samotné technické opatrenia nemôžu úplne zabrániť gamingu AI; organizácie musia rozvíjať kultúru bezpečnosti, v ktorej každý od vedenia po inžinierov uprednostňuje bezpečnosť a etiku pred rýchlosťou a ziskom. To vyžaduje záväzok vedenia vyčleniť významné zdroje na výskum bezpečnosti a testovanie, aj keď to spomaľuje vývoj produktu. Švajčiarsky model syra organizačnej bezpečnosti—kde viacero nedokonalých vrstiev obrany kompenzuje slabiny tých ostatných—platí aj pre AI systémy. Žiadny jednotlivý obranný mechanizmus nie je dokonalý, ale viacero prekrývajúcich sa vrstiev zvyšuje odolnosť. Mechanizmy ľudského dohľadu musia byť zakomponované počas celého životného cyklu AI, od vývoja cez nasadenie, pričom kvalifikovaní pracovníci hodnotia kľúčové rozhodnutia a signalizujú podozrivé vzory. Požiadavky na transparentnosť treba stavať do návrhu systému od začiatku, nie dodatočne, aby všetci zainteresovaní rozumeli fungovaniu AI systémov a tomu, aké dáta využívajú. Mechanizmy zodpovednosti musia jasne určovať, kto nesie zodpovednosť za správanie AI systému, pričom za nedbanlivosť alebo pochybenia musia hroziť následky. Red teaming cvičenia by mali pravidelne vykonávať externí experti, ktorí aktívne testujú možnosti zneužitia systému, pričom zistenia slúžia na neustále zlepšovanie. Organizácie by mali zaviesť postupné nasadzovanie systémov, kde sú nové AI systémy dôkladne testované v kontrolovaných podmienkach pred širokým nasadením a v každej fáze je overovaná bezpečnosť. Budovanie takejto kultúry si vyžaduje pochopenie, že bezpečnosť a inovácie nie sú v rozpore—organizácie, ktoré investujú do robustnej bezpečnosti AI, v skutočnosti inovujú efektívnejšie, pretože môžu systémy nasadzovať s istotou a dlhodobo si udržať dôveru používateľov.

Gaming AI systému znamená úmyselné manipulovanie alebo zneužívanie AI modelov na produkovanie nežiadaných výstupov, obchádzanie bezpečnostných opatrení alebo získavanie citlivých informácií. Zahŕňa techniky ako prompt injection, adversariálne útoky, otrávenie dát a extrakciu modelov. Na rozdiel od bežných chýb systému je gaming zámerným pokusom obísť zamýšľané správanie AI systémov.

Adversariálne útoky sú čoraz bežnejšie, keďže AI systémy sú nasadzované v kritických aplikáciách. Výskumy ukazujú, že väčšina AI systémov má zraniteľnosti, ktoré sa dajú zneužiť. Dostupnosť nástrojov a techník znamená, že systémy môžu zneužívať ako sofistikovaní útočníci, tak aj bežní používatelia, čo z tejto problematiky robí rozšírený problém.

Žiadna obrana neposkytuje úplnú imunitu voči zneužívaniu. Organizácie však môžu výrazne znížiť riziko pomocou viacvrstvovej ochrany vrátane adversariálneho trénovania, validácie dát, obfuskácie výstupov, obmedzenia rýchlosti a nepretržitého monitoringu. Najefektívnejší prístup kombinuje technické opatrenia s organizačnými praktikami a ľudským dohľadom.

Bežné chyby AI nastávajú, keď systém urobí chybu kvôli obmedzeniam v trénovacích dátach alebo architektúre modelu. Gaming zahŕňa úmyselnú manipuláciu s cieľom zneužiť zraniteľnosti. Gaming je zámerný, často neviditeľný pre používateľov a navrhnutý tak, aby útočník získal výhodu na úkor systému alebo jeho používateľov. Bežné chyby sú neúmyselné zlyhania systému.

Spotrebitelia sa môžu chrániť tým, že budú rozumieť tomu, ako AI systémy fungujú, uvedomia si, že ich dáta sa používajú na ovplyvňovanie ich správania a budú skeptickí voči odporúčaniam, ktoré sa zdajú až príliš šité na mieru. Pomáha tiež podpora požiadaviek na transparentnosť, používanie nástrojov na ochranu súkromia a presadzovanie silnejšej regulácie AI. Vzdelávanie o taktikách manipulácie AI je čoraz dôležitejšie.

Regulácia je kľúčová na prevenciu gamingu AI vo veľkom rozsahu. Súčasné rámce, ako napríklad EÚ AI Act, sa zameriavajú hlavne na fyzickú a psychologickú ujmu, pričom ekonomická ujma zostáva prevažne nepokrytá. Efektívna regulácia vyžaduje rámce zodpovednosti, posilnenie právomocí orgánov ochrany spotrebiteľa, medzinárodnú koordináciu a jasné pravidlá zabraňujúce manipulatívnym AI praktikám pri zachovaní inovácií.

Monitorovacie platformy AI poskytujú v reálnom čase prehľad o tom, ako sa AI systémy správajú a používajú. Detekujú anomálie, ktoré môžu naznačovať adversariálne útoky, sledujú neobvyklé vzory dopytov, ktoré signalizujú pokusy o extrakciu modelu, a identifikujú, keď sa výstupy systému odchyľujú od očakávaného správania. Táto viditeľnosť umožňuje rýchlu reakciu na hrozby skôr, než dôjde k vážnym škodám.

Náklady zahŕňajú priame finančné straty spôsobené podvodom a manipuláciou, poškodenie reputácie v dôsledku bezpečnostných incidentov, právnu zodpovednosť a regulačné pokuty, prevádzkové narušenie v dôsledku odstavenia systému a dlhodobú eróziu dôvery používateľov. Pre spotrebiteľov znamenajú náklady zníženú hodnotu služieb, porušenie súkromia a zneužitie behaviorálnych zraniteľností. Celkový ekonomický dopad je značný a rastie.

AmICited monitoruje, ako sú AI systémy citované a používané naprieč platformami, čo vám pomáha v reálnom čase odhaliť pokusy o zneužitie a manipuláciu. Získajte prehľad o správaní vašej AI a zostaňte pred hrozbami o krok vpred.

Zistite, čo je súťažná AI sabotáž, ako funguje a ako ochrániť svoju značku pred otrávením výsledkov AI vyhľadávania konkurenciou. Objavte metódy detekcie a stra...

Zistite, ako zábavné značky optimalizujú svoju viditeľnosť v AI odporúčaniach naprieč streamovacími platformami. Objavte stratégie sledovania AI prítomnosti a z...

Zistite, ako napadnúť nepresné AI informácie, nahlásiť chyby ChatGPT a Perplexity a implementovať stratégie na zabezpečenie presného zastúpenia vašej značky v A...

Súhlas s cookies

Používame cookies na vylepšenie vášho prehliadania a analýzu našej návštevnosti. See our privacy policy.