JavaScriptové renderovanie pre AI

Zistite, ako JavaScriptové renderovanie ovplyvňuje AI viditeľnosť. Objavte, prečo AI crawlery nevykonávajú JavaScript, aký obsah zostáva skrytý a ako riešenia t...

Zistite, ako prerendering sprístupňuje JavaScriptový obsah pre AI crawlery ako ChatGPT, Claude a Perplexity. Objavte najlepšie technické riešenia pre AI optimalizáciu vyhľadávania a zlepšite svoju viditeľnosť vo výsledkoch vyhľadávania poháňaných AI.

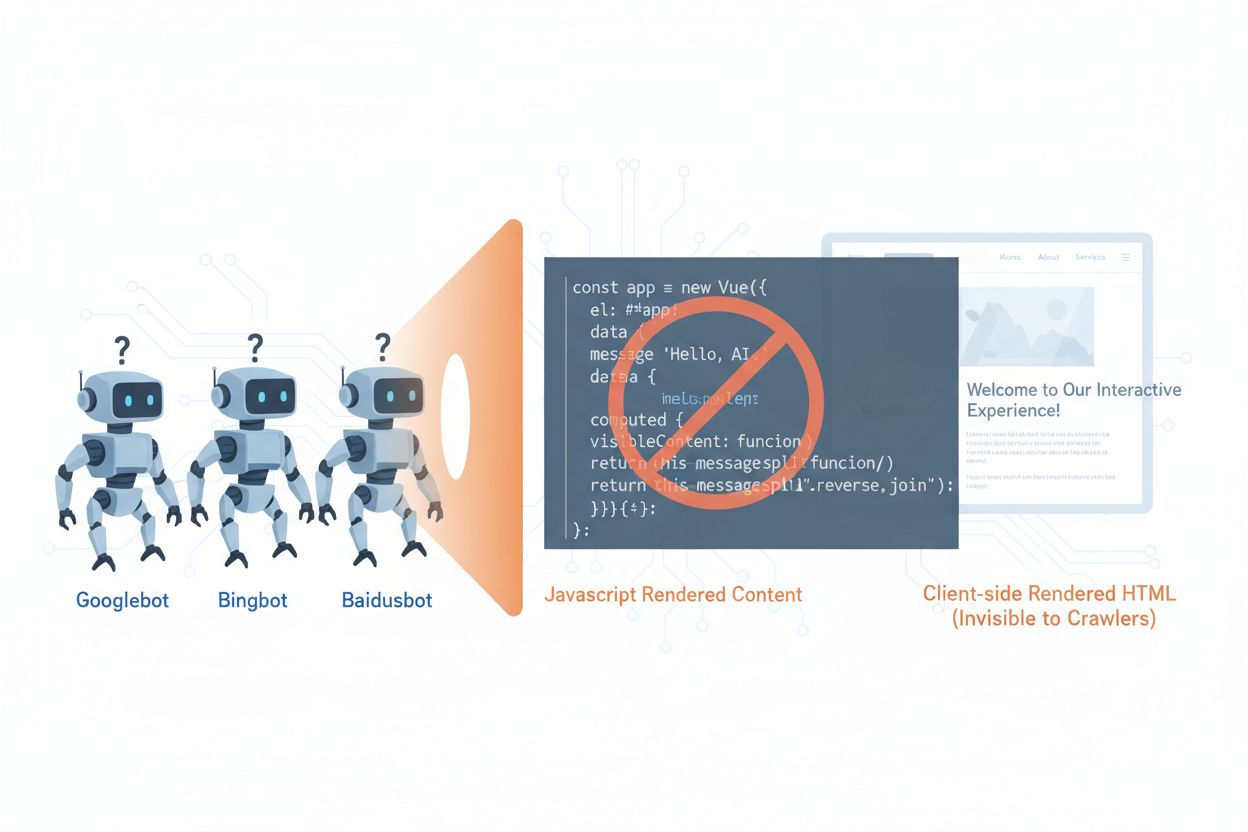

AI crawlery ako GPTBot, ClaudeBot a PerplexityBot zásadne zmenili spôsob, akým sa obsah objavuje a indexuje na webe, no čelia zásadnému obmedzeniu: nedokážu spúšťať JavaScript. To znamená, že akýkoľvek obsah generovaný dynamicky cez JavaScript — ktorý poháňa moderné single-page aplikácie (SPA), dynamické produktové stránky a interaktívne dashboardy — zostáva pre tieto crawlery úplne neviditeľný. Podľa nedávnych údajov tvoria AI crawlery už približne 28 % prevádzky Googlebotu, čo z nich robí významnú časť vášho crawl budgetu a kľúčový faktor v dostupnosti obsahu. Keď AI crawler požiada o stránku, dostane iba počiatočný HTML shell bez vykresleného obsahu, takže vidí v podstate prázdnu alebo neúplnú verziu vášho webu. Vzniká tak paradox: váš obsah je dokonale viditeľný pre ľudských používateľov s prehliadačom podporujúcim JavaScript, no neviditeľný pre AI systémy, ktoré čoraz viac ovplyvňujú objavovanie, sumarizáciu a poradie obsahu vo vyhľadávačoch a aplikáciách poháňaných AI.

Technické dôvody obmedzení AI crawlerov pri JavaScripte vychádzajú zo základných architektonických rozdielov medzi tým, ako prehliadače a crawlery spracovávajú webový obsah. Prehliadače disponujú plným JavaScript engineom, ktorý vykonáva kód, manipuluje s DOM (Document Object Model) a vykresľuje finálny vizuálny výstup, zatiaľ čo AI crawlery zvyčajne fungujú s minimálnou alebo žiadnou schopnosťou vykonávať JavaScript kvôli obmedzeniam zdrojov a bezpečnostným hľadiskám. Asynchrónne načítavanie — keď sa obsah sťahuje z API až po načítaní stránky — predstavuje ďalšiu veľkú výzvu, pretože crawlery dostanú iba počiatočný HTML ešte pred príchodom obsahu. Single-page aplikácie (SPA) tento problém ešte zhoršujú, pretože sa spoliehajú výhradne na routing a rendering na strane klienta, takže crawlerom zostáva len JavaScriptový balíček. Takto vyzerá porovnanie rôznych renderovacích metód z pohľadu viditeľnosti pre AI crawlery:

| Renderovacia metóda | Ako funguje | Viditeľnosť pre AI crawlery | Výkon | Náklady |

|---|---|---|---|---|

| CSR (Client-Side Rendering) | Prehliadač vykonáva JavaScript na vykreslenie obsahu | ❌ Slabá | Rýchle pre používateľov | Nízka infraštruktúra |

| SSR (Server-Side Rendering) | Server vykresľuje HTML pri každej požiadavke | ✅ Výborná | Pomalšie prvé načítanie | Vysoká infraštruktúra |

| SSG (Static Site Generation) | Obsah sa vytvára vopred pri build time | ✅ Výborná | Najrýchlejšie | Stredné (build time) |

| Prerendering | Statické HTML sa cache-uje na požiadanie | ✅ Výborná | Rýchle | Stredné (vyvážené) |

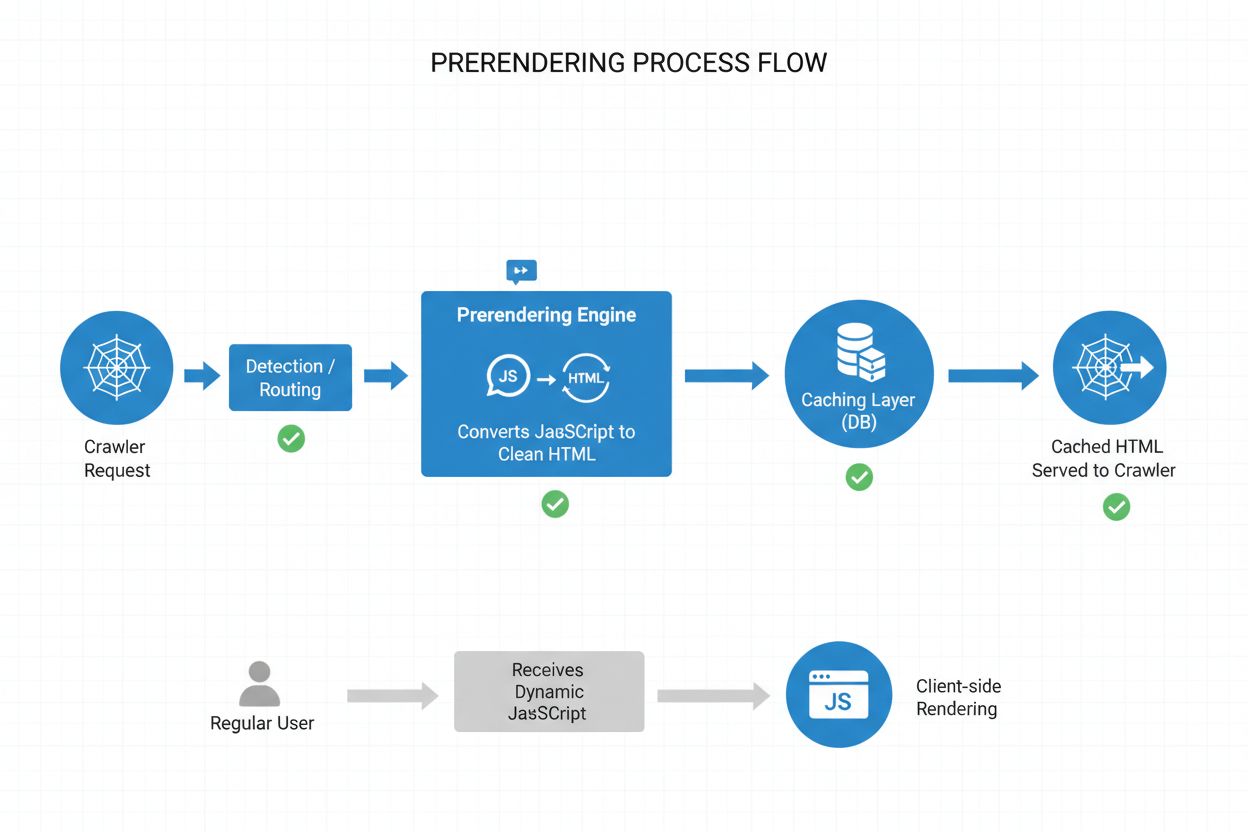

Prerendering ponúka elegantný kompromis medzi zdrojovo náročným server-side renderingom a obmedzeniami static site generation. Namiesto toho, aby sa obsah renderoval pri každej požiadavke (SSR) alebo v čase buildu (SSG), prerendering generuje statické HTML snímky na požiadanie, keď crawler alebo bot požiada o stránku, a následne túto verziu cachuje pre ďalšie požiadavky. Takto AI crawlery dostanú plne vykreslené, statické HTML obsahujúce všetok obsah, ktorý by za normálnych okolností generoval JavaScript, zatiaľ čo bežní používatelia dostanú dynamickú, interaktívnu verziu vašej stránky bez akýchkoľvek zmien v skúsenosti. Prerendering je obzvlášť nákladovo efektívny, pretože renderuje len tie stránky, ktoré crawlery skutočne požadujú, čím sa vyhýba režijným nákladom na predbežný rendering celého webu alebo údržbu drahej SSR infraštruktúry. Údržba je minimálna — váš aplikačný kód zostáva nezmenený a prerenderingová vrstva funguje transparentne na pozadí, takže je to ideálne riešenie pre tímy, ktoré chcú AI dostupnosť bez zásadných architektonických zmien.

Prerenderovací proces funguje cez sofistikovaný, no priamočiary workflow, ktorý zabezpečuje, že AI crawlery dostanú optimalizovaný obsah a používatelia žiadne narušenie. Keď na váš server príde požiadavka, systém najprv deteguje user-agenta, aby zistil, či ide o AI crawler (GPTBot, ClaudeBot, PerplexityBot) alebo bežný prehliadač. Ak je detegovaný AI crawler, požiadavka je presmerovaná do prerendering engine-u, ktorý spustí inštanciu headless prehliadača, vykoná všetok JavaScript, počká na načítanie asynchrónneho obsahu a vygeneruje kompletný statický HTML snímok vykreslenej stránky. Toto HTML je následne uložené do cache (zvyčajne na 24-48 hodín) a pri ďalšom dopyte je crawlerovi poskytnuté priamo, pričom vaša aplikácia je úplne obídená a serverové zaťaženie znížené. Medzitým bežné prehliadače prerenderingovú vrstvu úplne obchádzajú a dostanú vašu dynamickú aplikáciu ako obvykle, takže používateľ má plnú interaktívnu skúsenosť s aktuálnymi údajmi a dynamikou. Celý proces je transparentný — crawlery vidia plne vykreslený obsah, používatelia vašu aplikáciu nezmenenú a vaša infraštruktúra zostáva efektívna, lebo prerendering sa spúšťa iba pre bot traffic.

Aj keď prerendering aj server-side rendering (SSR) riešia problém s viditeľnosťou JavaScriptu, výrazne sa líšia v implementácii, nákladoch a škálovateľnosti. SSR renderuje obsah pri každej jednej požiadavke, čo znamená, že server musí spustiť JavaScript runtime, vykonať celý aplikačný kód a vygenerovať HTML pre každého návštevníka — tento proces je pri veľkej návštevnosti veľmi nákladný a môže zvýšiť Time to First Byte (TTFB) pre všetkých používateľov. Prerendering naopak cachuje vykreslené stránky a generuje ich nanovo len keď sa obsah zmení alebo vyprší cache, čím dramaticky znižuje zaťaženie servera a zlepšuje odozvu pre crawlery i používateľov. SSR má zmysel pre vysoko personalizovaný obsah alebo často sa meniace dáta, kde každý používateľ potrebuje unikátne HTML, zatiaľ čo prerendering exceluje pri obsahu, ktorý je relatívne statický alebo sa mení len zriedka — produktové stránky, blogy, dokumentácia a marketingový obsah. Mnohé pokročilé implementácie využívajú hybridný prístup: prerendering pre AI crawlery a statický obsah, SSR pre personalizované používateľské zážitky a client-side rendering pre interaktívne funkcie. Táto vrstvená stratégia prináša to najlepšie z oboch svetov — výbornú dostupnosť pre AI crawlery, rýchly výkon pre používateľov a primerané náklady na infraštruktúru.

Štruktúrované dáta vo formáte JSON-LD sú kľúčové pre to, aby AI crawlery porozumeli významu a kontextu vášho obsahu, no väčšina implementácií neberie do úvahy ich obmedzenia. Ak sa štruktúrované dáta vkladajú do stránky cez JavaScript — čo je časté pri Google Tag Manageri a podobných systémoch — AI crawlery ich nikdy neuvidia, pretože nevykonávajú JavaScript, ktorý tieto štruktúry vytvára. Znamená to, že rich snippets, produktové informácie, údaje o organizácii či iný sémantický markup zostáva pre AI systémy neviditeľný, aj keď ich tradičné vyhľadávače, ktoré už JavaScript zvládajú, vidia. Riešenie je jednoduché: všetky kľúčové štruktúrované dáta musia byť priamo v serverom generovanom HTML, nie vložené cez JavaScript. To môže znamenať presun JSON-LD blokov z tag managera do serverovej šablóny vašej aplikácie alebo využitie prerenderingu na zachytenie JavaScriptom vložených štruktúrovaných dát a ich poskytnutie crawlerom ako statického HTML. AI crawlery sa pri extrakcii faktov, vzťahov a entít silno spoliehajú na štruktúrované dáta, takže ich serverová implementácia je nevyhnutná pre AI vyhľadávače a integráciu do knowledge graphov.

Implementácia prerenderingu si vyžaduje strategický prístup, ktorý vyvažuje pokrytie, náklady a údržbu. Postupujte podľa týchto krokov:

Efektívne monitorovanie je kľúčové na zabezpečenie toho, že vaša prerenderingová implementácia stále správne funguje a AI crawlery majú prístup k vášmu obsahu. Analýza logov je váš hlavný nástroj — skúmajte serverové logy na identifikáciu požiadaviek od user-agentov AI crawlerov, sledujte, ktoré stránky navštevujú a hľadajte vzory v správaní alebo chybách. Väčšina prerenderingových služieb ako Prerender.io poskytuje dashboardy s mierou zásahu do cache, metrikami úspechu/neúspechu renderovania a štatistikami výkonu, ktoré vám dávajú prehľad o tom, ako je váš prerenderovaný obsah servírovaný. Kľúčové metriky na sledovanie sú cache hit rate (percento požiadaviek obslúžených z cache), rendering success rate (percento stránok bez chýb), priemerný čas renderovania a objem crawler trafficu. Nastavte si upozornenia na zlyhania renderovania alebo nezvyčajné vzory crawlovania, ktoré môžu signalizovať problém s vaším JavaScriptom alebo dynamickým obsahom. Koreláciou prerenderingových metrík s návštevnosťou z AI vyhľadávačov a viditeľnosťou obsahu dokážete kvantifikovať vplyv prerenderingu a identifikovať optimalizačné príležitosti.

Úspešný prerendering si vyžaduje dôslednosť a priebežnú údržbu. Vyhnite sa týmto častým chybám:

Dôležitosť optimalizácie pre AI crawlery bude rásť, keďže tieto systémy sa stávajú čoraz dôležitejšie pre objavovanie a extrakciu znalostí. Kým súčasné AI crawlery majú obmedzené schopnosti vykonávať JavaScript, nové technológie ako Comet a Atlas browsers naznačujú, že v budúcnosti môžu mať crawlery sofistikovanejšie renderovacie možnosti, no prerendering zostane dôležitý pre výkon a spoľahlivosť. Implementovaním prerenderingu už teraz nielenže riešite dnešný problém AI crawlerov — pripravujete svoj obsah na budúcnosť a zabezpečujete, že váš web zostane dostupný bez ohľadu na to, ako sa AI systémy vyvinú. Konvergencia tradičného SEO a optimalizácie pre AI crawlery znamená, že je potrebný komplexný prístup: optimalizujte pre ľudí aj AI, zabezpečte dostupnosť obsahu vo viacerých formátoch a zachovajte flexibilitu na adaptáciu, keď sa prostredie zmení. Prerendering je pragmatické, škálovateľné riešenie, ktoré preklenuje moderné JavaScriptovo náročné aplikácie a požiadavky na dostupnosť v AI vyhľadávaní a objavovaní, takže je nevyhnutnou súčasťou každej progresívnej SEO a obsahovej stratégie.

Prerendering generuje statické HTML snímky na požiadanie a ukladá ich do vyrovnávacej pamäte, zatiaľ čo server-side rendering (SSR) vykresľuje obsah pri každej jednej požiadavke. Prerendering je nákladovo efektívnejší a škálovateľnejší pre väčšinu prípadov použitia, zatiaľ čo SSR je vhodnejší pre vysoko personalizovaný alebo často sa meniaci obsah, ktorý vyžaduje unikátne HTML pre každého používateľa.

Nie, prerendering ovplyvňuje iba to, ako crawlery vidia váš obsah. Bežní používatelia budú naďalej dostávať vašu dynamickú, interaktívnu JavaScriptovú aplikáciu presne ako predtým. Prerendering funguje transparentne na pozadí a nemá žiadny vplyv na funkcionalitu alebo výkon z pohľadu používateľa.

Časy expirácie vyrovnávacej pamäte závisia od toho, ako často sa váš obsah mení. Stránky s vysokou návštevnosťou a častými aktualizáciami môžu potrebovať 12-24 hodinové okná vyrovnávacej pamäte, zatiaľ čo statický obsah môže využívať dlhšie trvanie. Väčšina prerenderingových služieb umožňuje konfigurovať časy vyrovnávacej pamäte pre jednotlivé stránky alebo šablóny.

Áno, prerendering dobre funguje aj s dynamickým obsahom. Môžete nastaviť kratšie časy expirácie vyrovnávacej pamäte pre stránky, ktoré sa často menia, alebo implementovať stratégie invalidácie cache, ktoré obnovia prerenderované stránky pri aktualizácii obsahu. To zabezpečí, že crawlery vždy uvidia relatívne čerstvý obsah.

Hlavné AI crawlery, na ktoré by ste sa mali zamerať, sú GPTBot (ChatGPT), ClaudeBot (Claude) a PerplexityBot (Perplexity). Mali by ste tiež pokračovať v optimalizácii pre tradičné crawlery ako Googlebot a Bingbot. Väčšina prerenderingových služieb podporuje konfiguráciu pre všetky hlavné AI a vyhľadávacie crawlery.

Ak už používate SSR, máte dobrú dostupnosť pre AI crawlery. Prerendering však stále môže priniesť výhody znížením zaťaženia servera, zlepšením výkonu a poskytnutím vrstvy vyrovnávacej pamäte, ktorá robí vašu infraštruktúru efektívnejšou a škálovateľnejšou.

Sledujte dashboard svojej prerenderingovej služby pre mieru zásahu do cache, metriky úspešného vykresľovania a štatistiky výkonu. Skontrolujte serverové logy na požiadavky AI crawlerov a overte, či dostávajú plne vykreslené HTML. Sledujte zmeny vo svojej AI viditeľnosti a citáciách obsahu v priebehu času.

Náklady na prerendering sa líšia podľa služby a objemu používania. Väčšina poskytovateľov ponúka odstupňované ceny podľa počtu stránok vykreslených za mesiac. Náklady sú zvyčajne oveľa nižšie ako pri údržbe infraštruktúry server-side renderingu, takže prerendering je nákladovo efektívnym riešením pre väčšinu webstránok.

Sledujte, ako platformy AI ako ChatGPT, Claude a Perplexity odkazujú na váš obsah pomocou AmICited. Získajte prehľad o svojej AI viditeľnosti v reálnom čase a optimalizujte svoju obsahovú stratégiu.

Zistite, ako JavaScriptové renderovanie ovplyvňuje AI viditeľnosť. Objavte, prečo AI crawlery nevykonávajú JavaScript, aký obsah zostáva skrytý a ako riešenia t...

Zistite, ako JavaScript ovplyvňuje viditeľnosť AI crawlerov. Zistite, prečo AI boti nedokážu vykresliť JavaScript, aký obsah sa skrýva a ako optimalizovať váš w...

Zistite, ako stratégie SSR a CSR ovplyvňujú viditeľnosť pre AI crawlerov, citácie značky v ChatGPT a Perplexity, a celkovú AI prítomnosť vo vyhľadávaní....