AI-špecifický Robots.txt

Naučte sa, ako konfigurovať robots.txt pre AI crawlery vrátane GPTBot, ClaudeBot a PerplexityBot. Pochopte kategórie AI crawlerov, stratégie blokovania a najlep...

Zistite, ako optimalizovať XML sitemap pre AI roboty ako GPTBot a ClaudeBot. Ovládnite najlepšie postupy pre sitemap a zlepšite viditeľnosť vo výsledkoch AI odpovedí a indexovaní LLM.

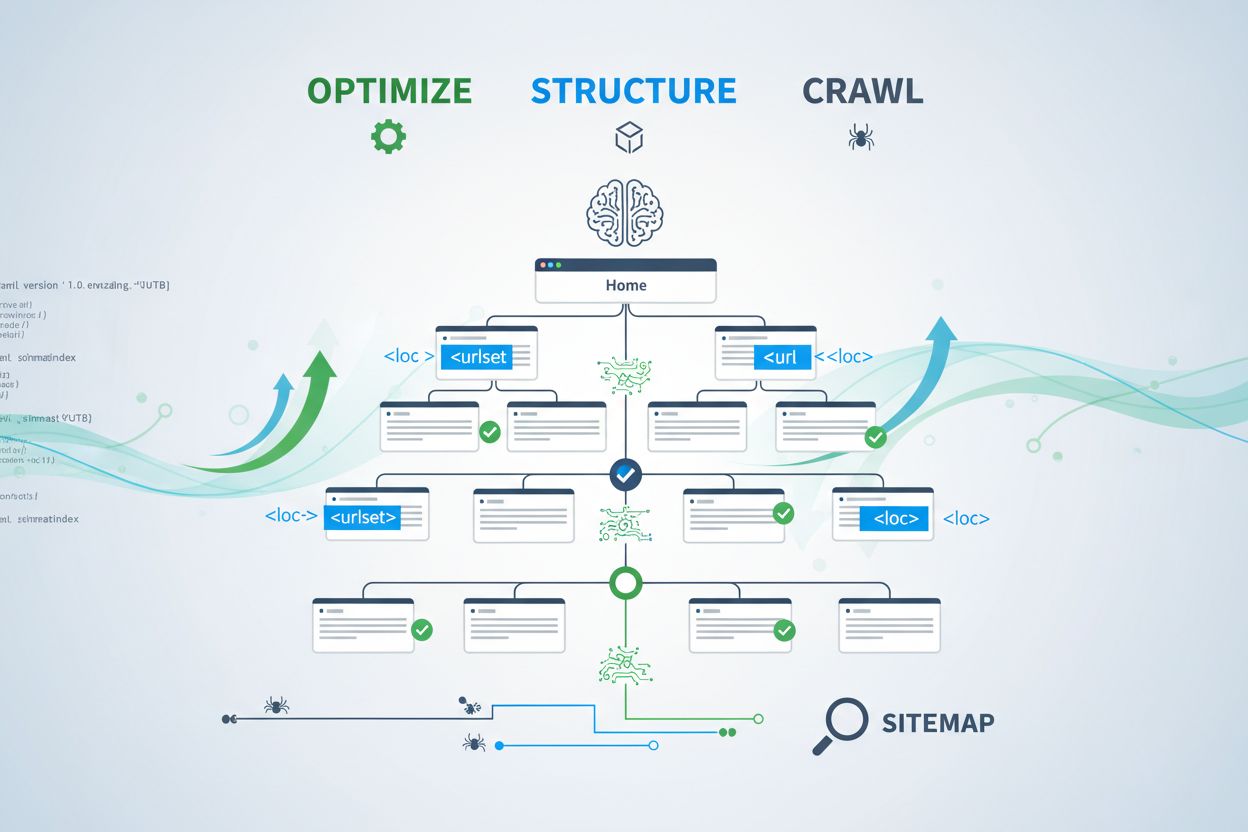

AI roboty ako GPTBot, ClaudeBot a PerplexityBot fungujú zásadne odlišne od tradičných robotov vyhľadávačov. Zatiaľ čo Googlebot indexuje stránky na účely hodnotenia vo výsledkoch vyhľadávania, AI roboty extrahujú znalosti na trénovanie a informovanie veľkých jazykových modelov, ktoré poháňajú konverzačné vyhľadávanie a AI generované odpovede. Bez správne optimalizovaného XML sitemap ostáva váš obsah pre tieto kľúčové systémy neviditeľný, bez ohľadu na to, aký kvalitný alebo autoritatívny je. Predstavte si svoj sitemap ako mapu, ktorá AI systémom presne ukáže, kde sa nachádza váš najcennejší obsah a ako je organizovaný.

Rozlíšenie medzi tradičnými vyhľadávacími robotmi a AI robotmi je kľúčové pre pochopenie, prečo je optimalizácia sitemap dôležitejšia ako kedykoľvek predtým. Tradičné vyhľadávače ako Google sa zameriavajú na hodnotenie jednotlivých stránok pre konkrétne kľúčové slová, zatiaľ čo AI roboty uprednostňujú získavanie znalostí a sémantické porozumenie. Tu je ich porovnanie:

| Aspekt | Tradičné roboty (Googlebot) | AI roboty (GPTBot, ClaudeBot) |

|---|---|---|

| Primárny účel | Hodnotiť stránky vo výsledkoch vyhľadávania | Extrahovať znalosti pre trénovanie LLM a odpovede v reálnom čase |

| Zameranie | Metadáta, interné odkazy, hodnotiace signály | Štruktúra obsahu, sémantický význam, hustota faktov |

| Priorita prehľadávania | Na základe PageRank a aktuálnosti | Na základe autority, tematickej relevantnosti a hodnoty znalostí |

| Vplyv na citácie | Generuje návštevnosť cez modré odkazy | Určuje, či sa váš obsah objaví v AI generovaných odpovediach |

| Spracovanie JavaScriptu | Vykonáva a renderuje JavaScript | Často JavaScript preskakuje; uprednostňuje serverom renderované HTML |

Tento zásadný rozdiel znamená, že samotná optimalizácia pre tradičné SEO už nestačí. Váš sitemap musí plniť dvojitú úlohu: pomôcť tradičným vyhľadávačom pochopiť štruktúru vášho webu a zároveň viesť AI systémy k vašim najcennejším znalostiam.

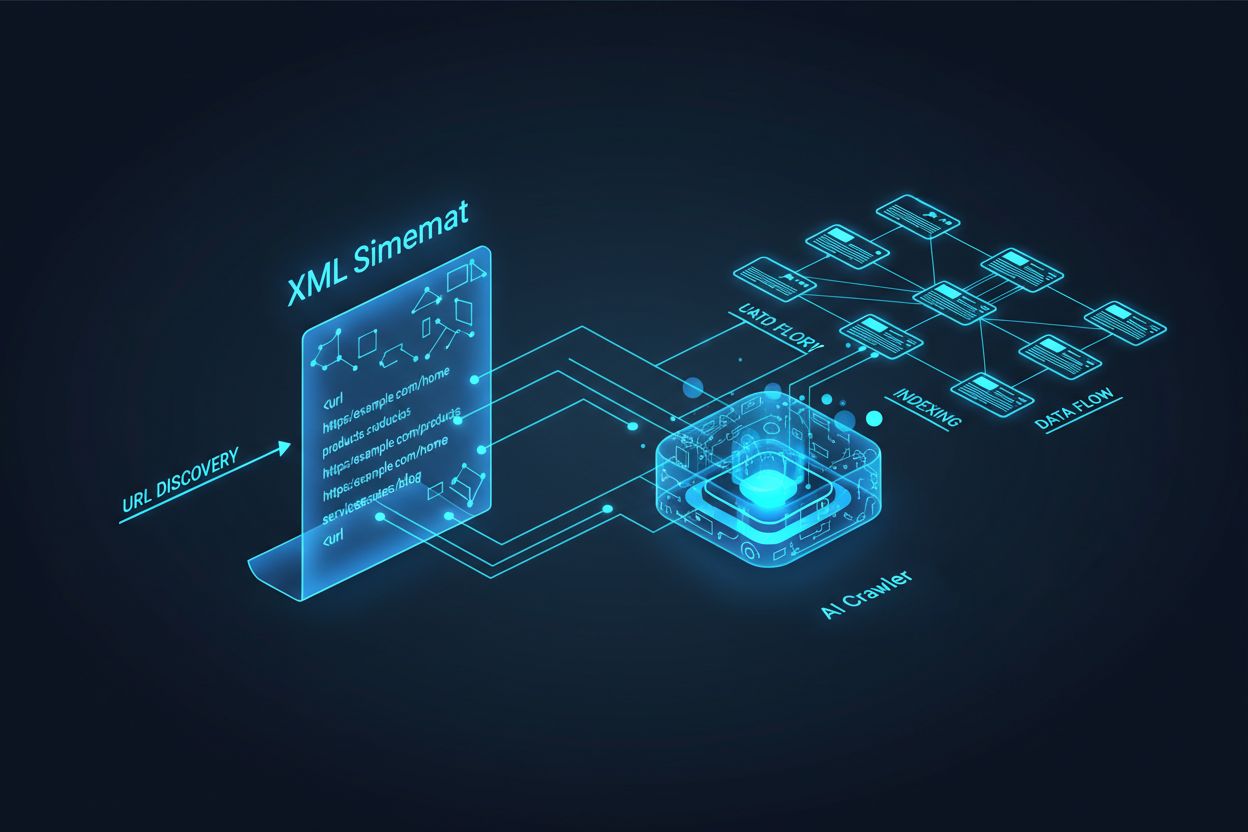

XML sitemap slúži ako plán vášho webu, ktorý výslovne informuje roboty, ktoré stránky existujú a ako súvisia s vašou celkovou obsahovou stratégiou. Pre AI systémy má sitemap ešte dôležitejšiu funkciu ako pre tradičné vyhľadávanie. AI roboty používajú sitemap na pochopenie tematickej architektúry vášho webu, identifikáciu prioritného obsahu a určenie, ktoré stránky si zaslúžia hlbšiu analýzu. Ak je váš sitemap komplexný a dobre organizovaný, AI systémy môžu efektívnejšie objavovať a hodnotiť váš obsah na zaradenie do generovaných odpovedí. Naopak, neúplný alebo zastaraný sitemap vytvára slepé miesta, ktoré zabránia AI systémom objaviť vaše najdôležitejšie stránky. Dopad je priamy: stránky, ktoré nie sú v sitemap, majú výrazne nižšiu šancu byť citované AI systémami, bez ohľadu na ich kvalitu alebo relevanciu.

Vytvorenie efektívneho sitemap pre AI roboty si vyžaduje viac než len zoznam všetkých URL na vašom webe. Váš sitemap by mal byť strategicky vybraný tak, aby obsahoval len stránky, ktoré prinášajú skutočnú hodnotu používateľom a AI systémom. Tu sú základné najlepšie postupy:

Dobre štruktúrovaný sitemap funguje ako filter kvality, ktorý AI systémom ukazuje, že ste svoj obsah starostlivo vybrali a každá zahrnutá URL si zaslúži pozornosť. Tento strategický prístup výrazne zvyšuje vaše šance na výber do AI generovaných odpovedí.

Aktuálnosť je jedným z najsilnejších hodnotiacich faktorov v AI vyhľadávacích systémoch. Keď AI roboty hodnotia, ktoré zdroje citovať vo vygenerovaných odpovediach, výrazne zohľadňujú čerstvosť obsahu. Časová pečiatka lastmod v XML sitemap je hlavný signál, ktorý AI systémom hovorí, kedy bol váš obsah naposledy aktualizovaný. Zastarané alebo chýbajúce časové pečiatky môžu spôsobiť, že aj autoritatívny obsah bude uprednostnený v prospech novších zdrojov. Ak váš sitemap ukazuje, že stránka nebola roky aktualizovaná, AI systémy môžu predpokladať, že informácie sú neaktuálne a zvoliť konkurenčný obsah. Naopak, presné lastmod časové pečiatky, ktoré odrážajú skutočné aktualizácie obsahu, signalizujú AI robotom, že vaše informácie sú aktuálne a dôveryhodné. Pre časovo citlivé témy ako ceny, regulácie alebo trendy v odvetví je presnosť časových pečiatok ešte kľúčovejšia. Automatizované aktualizácie časových pečiatok cez váš CMS zabezpečia, že každá zmena obsahu sa okamžite prejaví v sitemap, čím maximalizujete svoju viditeľnosť v AI generovaných odpovediach.

Zatiaľ čo sitemapy pozývajú roboty indexovať váš obsah, súbory robots.txt určujú, ku ktorým častiam webu majú roboty prístup. Tieto dva súbory musia spolupracovať, aby maximalizovali vašu AI viditeľnosť. Častou chybou je vytvoriť komplexný sitemap a zároveň blokovať AI roboty v robots.txt, čo vytvára rozpor, ktorý roboty mätie a znižuje vašu viditeľnosť. Robots.txt by mal výslovne povoliť hlavných AI robotov ako GPTBot, ClaudeBot a PerplexityBot k vášmu obsahu. Robots.txt môžete strategicky použiť na blokovanie len stránok, ktoré by nemali byť indexované, napríklad administrátorské rozhrania, prihlasovacie stránky alebo duplicity obsahu. Kľúčom je zosúladiť pravidlá robots.txt so stratégiou vášho sitemapu—ak je stránka v sitemap, mala by byť dostupná podľa pravidiel robots.txt. Pravidelné audity oboch súborov pomáhajú odhaliť nesprávne nastavenia, ktoré môžu ticho obmedzovať vašu AI viditeľnosť.

Najefektívnejšie AI optimalizačné stratégie považujú sitemapy a štruktúrované dáta za doplnkové systémy, ktoré sa navzájom posilňujú. Keď váš sitemap zvýrazňuje stránku ako dôležitú a táto stránka obsahuje relevantné schéma značkovanie, posielate AI robotom konzistentný signál o účele a hodnote stránky. Napríklad, ak váš sitemap uprednostňuje návod, táto stránka by mala obsahovať HowTo schému, ktorá poskytuje štruktúrované informácie o jednotlivých krokoch. Podobne produktové stránky v sitemap by mali obsahovať Product schému s cenami, dostupnosťou a hodnotením. Toto zosúladenie vytvára ucelený obraz dát, ktorý AI systémy ľahko interpretujú a dôverujú mu. Ak sú sitemapy a štruktúrované dáta v rozpore alebo sa rozchádzajú, AI roboty si nie sú isté skutočným účelom stránky, čím sa znižuje šanca na citáciu. Zosúladením stratégie sitemap a implementácie schémy vytvárate jednotný signál, ktorý dramaticky zvyšuje vaše šance na zaradenie do AI generovaných odpovedí.

Rôzne typy obsahu si vyžadujú rozdielne stratégie sitemap na maximalizáciu AI viditeľnosti. Blogové príspevky, produktové stránky, popisy služieb a FAQ obsah majú rôzne účely a mali by byť optimalizované podľa toho:

| Typ obsahu | Stratégia sitemap | Odporúčané schéma značkovanie | Prioritné úvahy |

|---|---|---|---|

| Blogy a články | Zahrňte s presnými dátumami publikovania a aktualizácie | Article, NewsArticle, BlogPosting | Uprednostnite aktuálny a nadčasový obsah; pravidelne aktualizujte lastmod |

| Produktové stránky | Zahrňte s aktualizáciami skladu; zvážte samostatný produktový sitemap | Product, Offer, AggregateRating | Zvýraznite najpredávanejšie a nové produkty; často aktualizujte ceny |

| Stránky služieb | Zahrňte s dátumami aktualizácie služieb | Service, LocalBusiness, ProfessionalService | Uprednostnite kľúčové služby; aktualizujte dostupnosť a ceny |

| FAQ stránky | Zahrňte s dátumami aktualizácie obsahu | FAQPage, Question, Answer | Uprednostnite komplexné FAQ; aktualizujte odpovede pri zmene informácií |

| Video obsah | Zahrňte do video sitemap s náhľadmi a dĺžkou | VideoObject, Video | Pridajte prepisy; aktualizujte počty zobrazení a metriky zapojenia |

| Obrázkový obsah | Zahrňte do image sitemap s titulkami | ImageObject, Product (pre produktové obrázky) | Optimalizujte alt text; zahrňte popisné titulky |

Tento diferencovaný prístup zabezpečí, že každý typ obsahu dostane vhodnú optimalizáciu pre AI objavenie. Prispôsobením stratégie sitemap svojmu mixu obsahu maximalizujete šancu, že AI systémy nájdu a citujú vaše najcennejšie aktíva.

Štandard llms.txt, predstavený koncom roka 2024, predstavuje experimentálny prístup na pomoc AI systémom pochopiť štruktúru webu. Na rozdiel od XML sitemap je llms.txt súbor v Markdowne, ktorý poskytuje ľahko čitateľný obsah vášho webu. Uvádza vaše najdôležitejšie stránky a zdroje vo formáte, ktorý je pre jazykové modely jednoduchšie spracovať a pochopiť. Aj keď je koncept sľubný, aktuálne dôkazy naznačujú, že llms.txt má minimálny vplyv na AI viditeľnosť v porovnaní s tradičnými XML sitemapami. Hlavní AI roboti ako GPTBot a ClaudeBot sa naďalej spoliehajú najmä na XML sitemap pre objavovanie URL a signály aktuálnosti. Namiesto nahradenia XML sitemap by sa na llms.txt malo pozerať ako na doplnkový nástroj, ktorý môže AI systémom poskytnúť dodatočný kontext. Ak implementujete llms.txt, zabezpečte, aby dopĺňal a nenahrádzal vašu hlavnú stratégiu sitemap, a najskôr sa zamerajte na dokonalé XML sitemap s presnými časovými pečiatkami a strategickým výberom obsahu.

Aj dobre mienené weby často robia kritické chyby v sitemap, ktoré ticho obmedzujú ich AI viditeľnosť. Pochopenie a vyhýbanie sa týmto chybám je nevyhnutné pre maximalizáciu prítomnosti vo výsledkoch AI odpovedí:

Oprava týchto bežných chýb môže okamžite zlepšiť vašu AI viditeľnosť. Začnite auditom aktuálneho sitemapu podľa tohto zoznamu a opravte všetky zistené problémy.

Udržiavanie optimalizovaného sitemapu si vyžaduje priebežné monitorovanie a validáciu. Niekoľko nástrojov vám pomôže udržať sitemap efektívny pre AI roboty. Google Search Console poskytuje vstavanú validáciu sitemap a ukazuje, koľko URL z vášho sitemapu Google indexoval. Screaming Frog SEO Spider vám umožní prehľadať celý web a porovnať výsledky so sitemapom, čím odhalíte chýbajúce alebo neplatné URL. Validátory XML sitemap kontrolujú syntax sitemapu a zabezpečujú, že je v súlade s protokolom XML sitemap. Pre väčšie podniky ponúkajú SEO platformy ako Semrush a Ahrefs funkcie analýzy sitemap, ktoré sledujú zmeny v čase. Pravidelné audity—ideálne mesačne—vám pomôžu zachytiť problémy skôr, než ovplyvnia vašu AI viditeľnosť. Nastavte si pripomienky na kontrolu sitemap vždy, keď robíte významné zmeny obsahu, spúšťate nové sekcie alebo meníte štruktúru webu.

Pochopenie, ako AI roboty interagujú s vaším sitemapom, si vyžaduje aktívne monitorovanie a analýzu. Vaše serverové logy obsahujú cenné údaje o tom, ktoré AI roboty navštevujú váš web, ako často prehľadávajú a ktoré stránky uprednostňujú. Analýzou týchto logov môžete identifikovať vzory a optimalizovať podľa nich svoj sitemap. Nástroje ako AmICited.com vám pomôžu monitorovať, ako často je váš obsah citovaný AI systémami ako ChatGPT, Claude, Perplexity a Google AI Overviews, čím získate priamu spätnú väzbu o efektívnosti svojho sitemapu. Google Analytics možno nastaviť na sledovanie referenčnej návštevnosti z AI systémov, aby ste zistili, ktoré stránky generujú najväčšiu AI viditeľnosť. Koreláciou týchto dát so štruktúrou sitemapu môžete zistiť, ktoré typy obsahu a témy najviac rezonujú s AI systémami. Tento prístup založený na dátach vám umožní neustále vylepšovať svoju stratégiu sitemap a uprednostňovať obsah, ktorý prináša najviac AI citácií a viditeľnosti.

Okrem základnej optimalizácie sitemap môžu pokročilé stratégie výrazne zvýšiť vašu AI viditeľnosť. Vytvorenie samostatných sitemap pre rôzne typy obsahu—ako samostatné sitemap pre blogy, produkty a videá—vám umožní aplikovať špecifické optimalizačné stratégie. Dynamické generovanie sitemap, kde sa sitemap aktualizuje v reálnom čase pri zmene obsahu, zabezpečí, že AI roboty vždy uvidia váš najaktuálnejší obsah. Pre veľké podnikové weby s tisíckami stránok implementácia hierarchií sitemap a strategická priorizácia pomáhajú AI robotom zamerať sa na najcennejší obsah. Niektoré organizácie vytvárajú AI-špecifické sitemapy, ktoré zvýrazňujú len najautoritnejší, najviac citovateľný obsah, čím AI systémom signalizujú, ktoré stránky si zaslúžia prioritnú pozornosť. Integrácia stratégie sitemap s vaším systémom správy obsahu zabezpečí, že optimalizácia prebieha automaticky a nevyžaduje manuálne aktualizácie. Tieto pokročilé prístupy si vyžadujú viac technickej zdatnosti, ale môžu priniesť významné zlepšenia AI viditeľnosti pre organizácie s komplexným obsahovým ekosystémom.

Prostredie AI robotov sa rýchlo vyvíja, s pravidelným príchodom nových robotov a rastom štandardov ako llms.txt. Budovanie odolnej stratégie sitemap znamená vložiť flexibilitu do svojich systémov a zostať informovaný o vývoji v odvetví. Implementujte systémy generovania sitemap, ktoré dokážu jednoducho prijať nové požiadavky robotov bez manuálnej rekonfigurácie. Sledujte oznámenia hlavných AI spoločností o nových robotoch a podľa toho aktualizujte svoj robots.txt a stratégie sitemap. Zvážte dlhodobú hodnotu AI viditeľnosti v porovnaní s kontrolou nad obsahom—hoci niektoré organizácie sa rozhodnú AI robotov blokovať, trend naznačuje, že AI citácie budú čoraz dôležitejšie pre viditeľnosť značky. Vypracujte jasné pravidlá, ako bude vaša organizácia spravovať prístup AI robotov a používanie obsahu. Ak budete na sitemap nazerať ako na živý dokument, ktorý sa vyvíja spolu s AI prostredím, zabezpečíte, že váš obsah zostane objaviteľný a citovateľný aj pri ďalšej transformácii mechanizmov vyhľadávania a objavovania.

Svoj sitemap by ste mali aktualizovať vždy, keď publikujete nový obsah alebo robíte významné zmeny na existujúcich stránkach. Ideálne je implementovať automatizovanú generáciu sitemap, aby sa aktualizácie uskutočňovali okamžite. Pre stránky s častými zmenami obsahu sa odporúčajú denné aktualizácie. Pre statické stránky postačujú mesačné kontroly.

Väčšina hlavných AI robotov ako GPTBot a ClaudeBot rešpektuje direktívy robots.txt, ale nie všetky. Najlepšou praxou je výslovne povoliť AI roboty vo vašom súbore robots.txt namiesto spoliehania sa na predvolené správanie. Sledujte svoje serverové logy, aby ste overili, že roboty sa správajú podľa očakávaní.

XML sitemapy sú strojovo čitateľné súbory, ktoré uvádzajú všetky vaše URL s metadátami ako časové pečiatky lastmod. llms.txt je novší štandard založený na Markdowne, navrhnutý na poskytnutie AI systémom ľahko čitateľného obsahu. XML sitemapy sú v súčasnosti dôležitejšie pre AI viditeľnosť, zatiaľ čo llms.txt by sa mal považovať za doplnok.

Skontrolujte svoje serverové logy pre user agentov ako 'GPTBot', 'ClaudeBot', 'PerplexityBot' a 'Google-Extended'. Môžete tiež použiť nástroje ako AmICited.com na monitorovanie, ako často je váš obsah citovaný AI systémami, čo naznačuje úspešné prehľadávanie a indexovanie.

Áno, vytvorenie samostatných sitemap pre blogy, produkty, videá a obrázky vám umožňuje aplikovať špecifické optimalizačné stratégie. To tiež pomáha AI robotom lepšie pochopiť štruktúru vášho obsahu a môže zlepšiť efektivitu prehľadávania pre veľké stránky.

XML sitemap by mal obsahovať maximálne 50 000 URL na súbor. Pre väčšie stránky použite indexy sitemap na organizovanie viacerých súborov sitemap. AI roboty zvládnu veľké sitemapy, ale rozdelenie na logické sekcie zlepšuje efektivitu prehľadávania a uľahčuje správu.

Časové pečiatky lastmod signalizujú AI robotom aktuálnosť obsahu. Novosť je silným faktorom hodnotenia v AI systémoch, preto presné časové pečiatky pomáhajú vášmu obsahu súťažiť o citácie. Vždy používajte automatizované systémy na aktualizáciu časových pečiatok len vtedy, keď sa obsah skutočne zmení—nikdy nenastavujte nepravdivé časové pečiatky ručne.

Áno, zle udržiavaný sitemap môže výrazne poškodiť vašu AI viditeľnosť. Neplatné odkazy, zastarané URL, nepresné časové pečiatky a neúplné pokrytie všetko znižuje vaše šance na citovanie AI systémami. Pravidelné audity a údržba sú nevyhnutné pre ochranu vašej AI viditeľnosti.

Sledujte, ako často je váš obsah citovaný ChatGPT, Claude, Perplexity a Google AI Overviews. Optimalizujte svoju stratégiu sitemap na základe reálnych AI údajov o citáciách.

Naučte sa, ako konfigurovať robots.txt pre AI crawlery vrátane GPTBot, ClaudeBot a PerplexityBot. Pochopte kategórie AI crawlerov, stratégie blokovania a najlep...

Kompletný referenčný sprievodca AI crawlermi a botmi. Identifikujte GPTBot, ClaudeBot, Google-Extended a viac ako 20 ďalších AI crawlerov s user agentmi, rýchlo...

Zistite, ako povoliť AI robotom ako GPTBot, PerplexityBot a ClaudeBot prehľadávať váš web. Nakonfigurujte robots.txt, nastavte llms.txt a optimalizujte pre AI v...