AI-špecifický Robots.txt

Naučte sa, ako konfigurovať robots.txt pre AI crawlery vrátane GPTBot, ClaudeBot a PerplexityBot. Pochopte kategórie AI crawlerov, stratégie blokovania a najlep...

Zistite, ako Web Application Firewall poskytuje pokročilú kontrolu nad AI robotmi nad rámec robots.txt. Implementujte WAF pravidlá na ochranu svojho obsahu pred neautorizovaným AI scrapingom a sledujte AI citácie s AmICited.

Nedostatočnosť robots.txt ako samostatného obranného mechanizmu sa v ére AI konzumácie obsahu stáva čoraz zjavnejšou. Zatiaľ čo tradičné vyhľadávače vo všeobecnosti rešpektujú pravidlá robots.txt, moderné AI roboty fungujú na základe zásadne odlišných motivácií a vynucovacích mechanizmov, vďaka čomu sú jednoduché textové politiky nedostatočné na ochranu obsahu. Podľa analýzy Cloudflare tvoria AI roboty už takmer 80 % všetkej botovej návštevnosti webových stránok; tréningové roboty spotrebúvajú obrovské množstvo obsahu, no vracajú minimálnu odkazovú návštevnosť—OpenAI roboty majú pomer crawl/referral 400:1, zatiaľ čo u Anthropic je to až 38 000:1. Pre vydavateľov a vlastníkov obsahu tento asymetrický vzťah predstavuje zásadné obchodné riziko, keďže AI modely trénované na ich obsahu môžu priamo znižovať organickú návštevnosť a znehodnocovať ich duševné vlastníctvo.

Web Application Firewall (WAF) funguje ako reverzný proxy medzi používateľmi a webovým serverom a v reálnom čase kontroluje každú HTTP požiadavku, aby filtroval neželanú návštevnosť na základe konfigurovateľných pravidiel. Na rozdiel od robots.txt, ktorý sa spolieha na dobrovoľnú spoluprácu robotov, WAF vynucuje ochranu na úrovni infraštruktúry a je preto omnoho účinnejší na kontrolu prístupu AI robotov. Nasledujúca tabuľka ukazuje, ako sa WAF líši od tradičných bezpečnostných prístupov:

| Funkcia | Robots.txt | Tradičný firewall | Moderný WAF |

|---|---|---|---|

| Úroveň vynucovania | Odporúčacie/dobrovoľné | IP-blokovanie | Aplikačne orientovaná kontrola |

| Detekcia AI robotov | Len podľa user-agent | Obmedzené rozpoznanie botov | Behaviorálna analýza + fingerprinting |

| Adaptácia v reálnom čase | Statický súbor | Vyžaduje manuálne úpravy | Kontinuálna threat intelligence |

| Granularita kontroly | Iba na úrovni cesty | Široké IP rozsahy | Politiky na úrovni požiadavky |

| Strojové učenie | Žiadne | Žiadne | Pokročilá klasifikácia botov |

WAF poskytuje granulárnu klasifikáciu botov pomocou device fingerprintingu, behaviorálnej analýzy a strojového učenia na profilovanie robotov podľa zámeru a vyspelosti, čo umožňuje oveľa jemnejšiu kontrolu ako jednoduché pravidlá povolenia/zákazu.

AI roboty spadajú do troch kategórií, z ktorých každá predstavuje iný typ rizika a vyžaduje odlišnú stratégiu ochrany. Tréningové roboty ako GPTBot, ClaudeBot a Google-Extended systematicky zbierajú webový obsah na tvorbu datasetov pre veľké jazykové modely, tvoria približne 80 % AI robotickej návštevnosti a neposkytujú vydavateľom žiadnu odkazovú hodnotu. Vyhľadávacie a citačné roboty ako OAI-SearchBot a PerplexityBot indexujú obsah pre AI-poháňané vyhľadávače a môžu generovať určitú odkazovú návštevnosť cez citácie, no v podstatne menšom objeme ako tradičné vyhľadávače. Roboty spustené používateľom sa aktivujú len keď používateľ výslovne požiada AI asistenta o daný obsah; ide o minimálne objemy s jednorazovými požiadavkami namiesto systematického crawlovania. Medzi hrozby patria:

Moderné WAF využívajú pokročilé technické detekčné metódy, ktoré presahujú jednoduché rozpoznávanie podľa user-agent reťazcov na presnú identifikáciu a klasifikáciu AI robotov. Tieto systémy používajú behaviorálnu analýzu na skúmanie vzorcov požiadaviek, ako sú rýchlosť crawlovania, sekvencovanie požiadaviek a spracovanie odpovedí, ktorými sa odlišujú roboty od ľudí. Device fingerprinting analyzuje HTTP hlavičky, TLS podpisy a vlastnosti prehliadača na odhalenie podvrhnutých agentov, ktorí sa snažia obísť tradičné ochrany. Modely strojového učenia trénované na miliónoch požiadaviek dokážu v reálnom čase detekovať nové roboty a taktiky, bez potreby manuálnych aktualizácií pravidiel. Navyše, WAF môže overovať legitimitu robota porovnaním IP adresy požiadavky s oficiálnymi IP rozsahmi publikovanými hlavnými AI spoločnosťami—OpenAI zverejňuje overené IP na https://openai.com/gptbot.json, Amazon na https://developer.amazon.com/amazonbot/ip-addresses/—čo zabezpečuje, že sú povolené iba autentické roboty z dôveryhodných zdrojov.

Efektívna implementácia WAF pravidiel pre AI roboty si vyžaduje viacvrstvový prístup kombinujúci blokovanie podľa user-agent, overovanie IP a behaviorálne politiky. Nasledujúci príklad ukazuje základnú konfiguráciu WAF pravidiel, ktorá blokuje známe tréningové roboty a zároveň povoľuje legitimnu vyhľadávaciu funkcionalitu:

# WAF pravidlo: Blokovať AI tréningové roboty

Názov pravidla: Block-AI-Training-Crawlers

Podmienka 1: HTTP User-Agent zodpovedá (GPTBot|ClaudeBot|anthropic-ai|Google-Extended|Meta-ExternalAgent|Amazonbot|CCBot|Bytespider)

Akcia: Blokovať (vrátiť 403 Forbidden)

# WAF pravidlo: Povoliť overené vyhľadávacie roboty

Názov pravidla: Allow-Verified-Search-Crawlers

Podmienka 1: HTTP User-Agent zodpovedá (OAI-SearchBot|PerplexityBot)

Podmienka 2: Zdrojová IP v overenom rozsahu

Akcia: Povoliť

# WAF pravidlo: Limitovať podozrivú botovú prevádzku

Názov pravidla: Rate-Limit-Suspicious-Bots

Podmienka 1: Počet požiadaviek prekročí 100 za minútu

Podmienka 2: User-Agent obsahuje indikátory bota

Podmienka 3: Žiadna zhoda s overenou IP

Akcia: Výzva (CAPTCHA) alebo Blokovať

Organizácie by mali starostlivo nastaviť poradie pravidiel, aby špecifické pravidlá (napr. overenie IP pre legitimné roboty) boli vykonané pred všeobecnými blokovacími pravidlami. Pravidelné testovanie a monitoring účinnosti pravidiel je kľúčové, keďže user-agent reťazce a IP rozsahy robotov sa často menia. Mnoho WAF poskytovateľov ponúka predpripravené sady pravidiel zamerané na správu AI robotov, čo znižuje komplexnosť implementácie pri zachovaní vysokej úrovne ochrany.

Overenie a allowlisting IP adries predstavuje najspoľahlivejší spôsob rozlíšenia legitímnych AI robotov od podvrhnutých požiadaviek, keďže user-agent reťazce sú ľahko falšovateľné, kým IP adresy je ťažké spoofovať vo veľkom. Veľké AI spoločnosti zverejňujú oficiálne IP rozsahy vo formáte JSON, čo umožňuje automatizované overenie bez manuálnej údržby—OpenAI poskytuje samostatné IP zoznamy pre GPTBot, OAI-SearchBot a ChatGPT-User, Amazon udržiava komplexný zoznam pre Amazonbot. WAF pravidlá môžu byť nastavené tak, aby povolili iba požiadavky pochádzajúce z týchto overených IP rozsahov, čím efektívne zabránia neautorizovaným aktérom obísť obmedzenia len zmenou user-agent hlavičky. Organizácie využívajúce blokovanie na úrovni servera cez .htaccess alebo firewall pravidlá môžu kombináciou overenia IP a user-agent získať vrstvenú ochranu, ktorá funguje nezávisle od konfigurácie WAF. Niektoré roboty zároveň rešpektujú HTML meta tagy ako <meta name="robots" content="noarchive">, ktoré signalizujú, že obsah nemá byť použitý na tréning modelov—a poskytujú doplnkovú kontrolu pre vydavateľov, ktorí chcú ochranu na úrovni jednotlivých stránok.

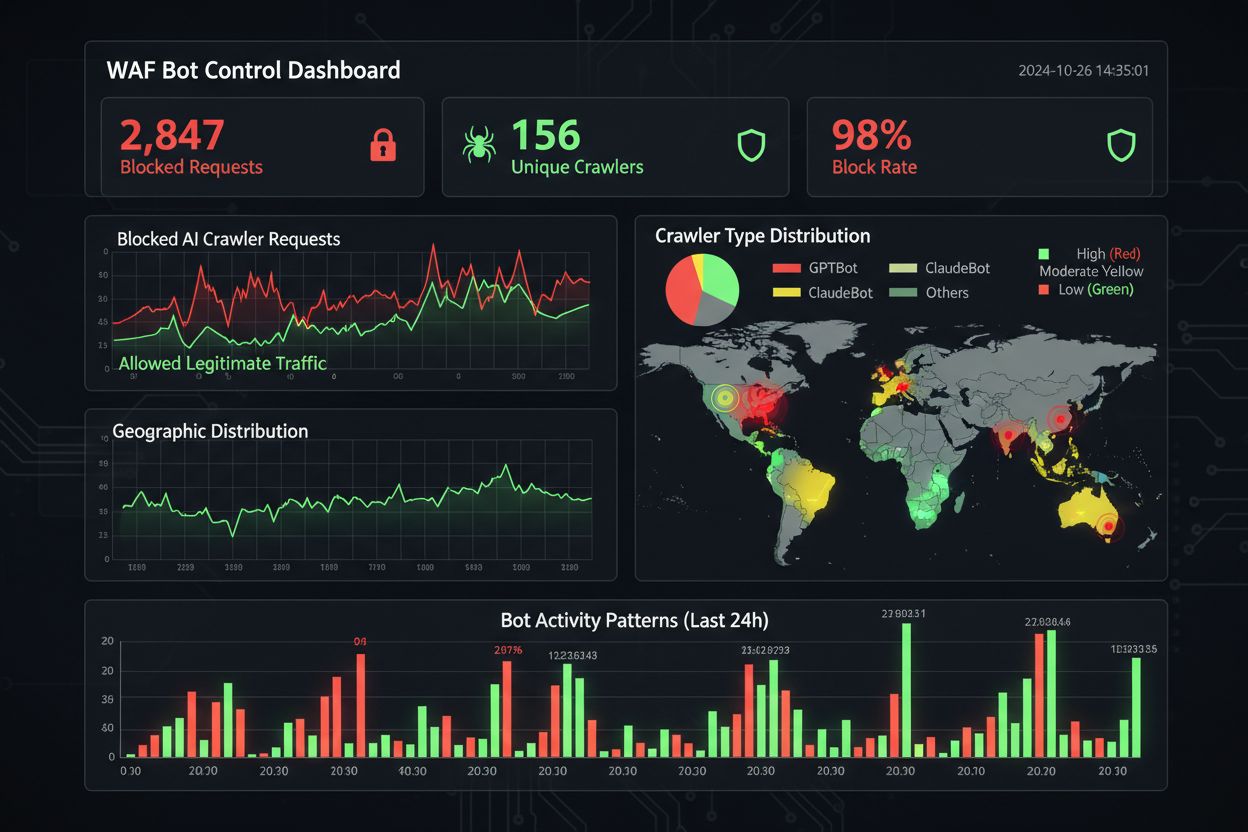

Efektívny monitoring a compliance vyžaduje nepretržitý prehľad o aktivite robotov a overenie, že blokovacie pravidlá fungujú podľa očakávaní. Organizácie by mali pravidelne analyzovať prístupové logy servera a zisťovať, ktoré roboty pristupujú na stránky a či zablokované roboty stále posielajú požiadavky—Apache logy sú typicky v /var/log/apache2/access.log, Nginx logy v /var/log/nginx/access.log, a podozrivé vzorce sa dajú rýchlo identifikovať pomocou grep. Analytické platformy čoraz viac rozlišujú botovú návštevnosť od ľudskej, čo umožňuje merať dopad blokovania robotov na metriky ako bounce rate, konverzie a SEO. Nástroje ako Cloudflare Radar poskytujú globálny pohľad na AI botovú prevádzku a dokážu identifikovať nové roboty, ktoré ešte nemáte na blockliste. Z pohľadu compliance generujú WAF logy auditné záznamy, ktoré dokazujú, že firma urobila primerané bezpečnostné opatrenia na ochranu údajov zákazníkov a duševného vlastníctva, čo je čoraz dôležitejšie pre GDPR, CCPA a ďalšie regulácie. Štvrťročná revízia blocklistu je nevyhnutná, keďže sa pravidelne objavujú nové AI roboty a existujúce menia svoje user-agent—komunitný ai.robots.txt projekt na GitHube

je užitočným zdrojom pre sledovanie nových hrozieb.

Nájsť rovnováhu medzi ochranou obsahu a obchodnými cieľmi si vyžaduje dôkladnú analýzu, ktoré roboty blokovať a ktoré povoliť, pretože príliš agresívne blokovanie môže obmedziť viditeľnosť v nových AI kanáloch objavenia obsahu. Blokovanie tréningových robotov ako GPTBot a ClaudeBot chráni duševné vlastníctvo, no nemá priamy vplyv na návštevnosť, keďže tieto roboty neposielajú referral traffic. Blokovanie vyhľadávacích robotov ako OAI-SearchBot a PerplexityBot však môže znížiť viditeľnosť vo výsledkoch AI vyhľadávania, kde používatelia hľadajú citácie a zdroje—čo je kompromis závislý od vašej obsahovej stratégie a publika. Niektorí vydavatelia skúšajú alternatívne prístupy, napríklad povoliť vyhľadávacie roboty a zároveň blokovať tréningové, prípadne implementovať pay-per-crawl modely, kde AI firmy platia za prístup k obsahu. Nástroje ako AmICited.com pomáhajú vydavateľom sledovať, či je ich obsah citovaný v AI odpovediach, a poskytujú údaje pre rozhodovanie o blokovaní. Optimálna WAF konfigurácia závisí od vášho obchodného modelu: spravodajské weby môžu uprednostniť blokovanie tréningových robotov a povolenie vyhľadávacích pre viditeľnosť, zatiaľ čo SaaS firmy môžu blokovať všetky AI roboty, aby chránili ceny a funkcie pred konkurenciou. Pravidelný monitoring návštevnosti a príjmov po implementácii WAF pravidiel zabezpečí, že vaša stratégia ochrany bude v súlade s reálnymi obchodnými výsledkami.

Pri porovnávaní WAF riešení na správu AI robotov by mali organizácie posudzovať kľúčové schopnosti, ktoré odlišujú enterprise platformy od základných produktov. Cloudflare AI Crawl Control je integrovaný s WAF a ponúka predpripravené pravidlá pre známe AI roboty, s možnosťou blokovania, povolenia alebo monetizácie cez pay-per-crawl—poradie pravidiel zabezpečuje, že WAF pravidlá majú prednosť pred ostatnými bezpečnostnými vrstvami. AWS WAF Bot Control poskytuje základnú aj pokročilú úroveň ochrany, pričom pokročilá využíva prehliadačové testy, fingerprinting a behaviorálne heuristiky na detekciu sofistikovaných robotov, ktorí sa neidentifikujú, plus voliteľnú analýzu strojovým učením. Azure WAF má podobné možnosti cez managed rule sets, no s menšou AI špecializáciou než Cloudflare alebo AWS. Okrem týchto veľkých platforiem ponúkajú špecializované riešenia na správu botov od poskytovateľov ako DataDome pokročilé modely strojového učenia trénované špecificky na AI roboty, aj keď za vyššiu cenu. Výber závisí od vašej infraštruktúry, rozpočtu a požadovanej úrovne pokročilosti—organizácie využívajúce Cloudflare majú plynulú integráciu, AWS zákazníci môžu použiť Bot Control v rámci existujúceho WAF.

Najlepšie postupy pri správe AI robotov kladú dôraz na viacvrstvovú ochranu kombinujúcu viaceré kontrolné mechanizmy namiesto spoliehania sa na jedno riešenie. Organizácie by mali realizovať štvrťročné revízie blocklistu na zachytenie nových robotov a aktualizovaných user-agent reťazcov, udržiavať analýzu serverových logov na overenie, že zablokované roboty pravidlá neobchádzajú, a pravidelne testovať WAF konfigurácie, či pravidlá fungujú v správnom poradí. Budúcnosť WAF technológií bude čoraz viac využívať AI-poháňanú detekciu hrozieb, ktorá sa v reálnom čase prispôsobí novým technikám robotov, s integráciou do širších bezpečnostných ekosystémov pre kontextovo citlivú ochranu. S prísnejšími reguláciami okolo scraping-u a tréningu AI dát sa WAF stane nevyhnutným compliance nástrojom, nie len voliteľnou bezpečnostnou vrstvou. Organizácie by mali začať implementovať komplexné WAF pravidlá pre AI roboty už teraz, kým sa nerozšíria nové hrozby ako browser-based AI agenti a headless browser roboty—cena nečinnosti, vyjadrená stratou návštevnosti, skreslenou analytikou a potenciálnymi právnymi rizikami, výrazne prevyšuje investíciu do robustnej ochrany.

Robots.txt je odporúčací súbor, ktorý sa spolieha na dobrovoľné rešpektovanie pokynov zo strany robotov, zatiaľ čo WAF pravidlá sú vynucované na infraštruktúrnej úrovni a vzťahujú sa na všetky požiadavky bez ohľadu na súlad robota. WAF poskytuje detekciu a blokovanie v reálnom čase, kým robots.txt je statický a ľahko obídený nevyhovujúcimi robotmi.

Áno, mnoho AI robotov ignoruje pravidlá robots.txt, pretože sú navrhnuté tak, aby maximalizovali zber tréningových dát. Kým dobre správané roboty od veľkých spoločností zvyčajne rešpektujú robots.txt, zlí aktéri a niektoré nové roboty nie. Preto poskytujú WAF pravidlá spoľahlivejšiu ochranu.

Skontrolujte prístupové logy servera (zvyčajne v /var/log/apache2/access.log alebo /var/log/nginx/access.log) pre user-agent reťazce obsahujúce identifikátory robotov. Nástroje ako Cloudflare Radar poskytujú globálny prehľad o AI robotoch, a analytické platformy čoraz častejšie rozlišujú botovú návštevnosť od ľudskej.

Blokovanie tréningových robotov ako GPTBot nemá priamy vplyv na SEO, pretože neposielajú odkazovú návštevnosť. Blokovanie vyhľadávacích robotov ako OAI-SearchBot však môže znížiť viditeľnosť vo výsledkoch AI vyhľadávania. Google AI Overviews dodržiava štandardné pravidlá Googlebotu, takže blokovanie Google-Extended neovplyvňuje bežnú indexáciu vyhľadávača.

Cloudflare AI Crawl Control, AWS WAF Bot Control a Azure WAF ponúkajú účinné riešenia. Cloudflare má najviac AI-špecifických funkcií s predpripravenými pravidlami a možnosťou platby za crawl. AWS ponúka pokročilú detekciu strojovým učením, Azure má kvalitné spravované pravidlá. Vyberte podľa vašej infraštruktúry a rozpočtu.

Minimálne štvrťročne kontrolujte a aktualizujte WAF pravidlá, keďže sa pravidelne objavujú nové AI roboty a existujúce menia user-agent reťazce. Sledujte komunitou spravovaný projekt ai.robots.txt na GitHube pre nové hrozby a mesačne kontrolujte serverové logy, aby ste objavili nových robotov na vašom webe.

Áno, toto je bežná stratégia. Môžete nastaviť WAF pravidlá na blokovanie tréningových robotov ako GPTBot a ClaudeBot, pričom povolíte vyhľadávacie roboty ako OAI-SearchBot a PerplexityBot. Takto ochránite obsah pred tréningom modelov, no zachováte viditeľnosť vo vyhľadávaní poháňanom AI.

Ceny WAF závisia od poskytovateľa. Cloudflare ponúka WAF od 20 $/mesačne s AI Crawl Control funkciami. AWS WAF účtuje za ACL a pravidlo, typicky 5-10 $/mesačne za základnú ochranu. Azure WAF je súčasťou Application Gateway. Náklady na implementáciu sú minimálne v porovnaní s hodnotou ochrany vášho obsahu a presných analytík.

AmICited sleduje aktivitu AI robotov a monitoruje, ako je váš obsah citovaný v ChatGPT, Perplexity, Google AI Overviews a na ďalších AI platformách. Získajte prehľad o svojej AI prítomnosti a pochopte, ktoré roboty majú prístup k vášmu obsahu.

Naučte sa, ako konfigurovať robots.txt pre AI crawlery vrátane GPTBot, ClaudeBot a PerplexityBot. Pochopte kategórie AI crawlerov, stratégie blokovania a najlep...

Diskusia komunity o tom, či povoliť AI botom prehľadávať váš web. Skutočné skúsenosti s konfiguráciou robots.txt, implementáciou llms.txt a správou AI crawlerov...

Zistite, ako nakonfigurovať robots.txt pre kontrolu prístupu AI crawlerov vrátane GPTBot, ClaudeBot a Perplexity. Spravujte viditeľnosť svojej značky v AI-gener...

Súhlas s cookies

Používame cookies na vylepšenie vášho prehliadania a analýzu našej návštevnosti. See our privacy policy.