Výber zdrojov AI

Zistite, ako systémy AI vyberajú a zoraďujú zdroje na citácie. Objavte algoritmy, signály a faktory, ktoré určujú, ktoré webstránky platformy AI ako ChatGPT, Pe...

Zistite, čo je bias vo výbere zdrojov v AI, ako ovplyvňuje modely strojového učenia, reálne príklady a stratégie na detekciu a zmiernenie tohto kľúčového problému férovosti.

Bias vo výbere zdrojov nastáva, keď tréningové dáta nereprezentujú celkovú populáciu alebo reálne rozdelenie, čo spôsobuje, že AI modely robia nepresné predpovede pre nedostatočne zastúpené skupiny alebo situácie.

Bias vo výbere zdrojov je zásadný problém v umelej inteligencii, ktorý vzniká, keď dáta použité na trénovanie modelov strojového učenia presne nereprezentujú reálnu populáciu alebo rozdelenie, ktorým majú slúžiť. Tento typ biasu vzniká, keď sú datasety vyberané spôsobom, ktorý systematicky vylučuje alebo nedostatočne zastupuje určité skupiny, situácie alebo charakteristiky. Následkom je, že AI modely sa učia vzory z neúplných alebo skreslených dát, čo vedie k predikciám, ktoré sú nepresné, neférové alebo diskriminačné voči nedostatočne zastúpeným populáciám. Pochopenie tohto biasu je kľúčové pre každého, kto AI systémy vyvíja, nasadzuje alebo na ne spolieha, pretože priamo ovplyvňuje férovosť, presnosť a spoľahlivosť automatizovaného rozhodovania v rôznych odvetviach.

Bias vo výbere zdrojov sa odlišuje od iných foriem biasu tým, že vzniká už v samotnej fáze zberu dát. Namiesto toho, aby vznikal v dôsledku výberu algoritmov alebo ľudských predpokladov počas vývoja modelu, je bias vo výbere zdrojov „zabudovaný“ do základov tréningového datasetu. To ho robí obzvlášť zákerným, pretože modely trénované na zaujatých dátach budú tieto biasy vo svojich predikciách ďalej šíriť a zosilňovať, bez ohľadu na sofistikovanosť algoritmu. Problém je ešte kritickejší, ak sú AI systémy nasadzované v oblastiach s vysokým dopadom ako zdravotníctvo, financie, trestná justícia a nábor zamestnancov, kde môžu zaujaté predikcie vážne ovplyvniť jednotlivcov aj komunity.

Bias vo výbere zdrojov vzniká viacerými rôznymi mechanizmami počas procesu zberu a úpravy dát. Najbežnejšou cestou je coverage bias (bias pokrytia), kde sú určité populácie alebo scenáre systematicky vylúčené z tréningového datasetu. Napríklad, ak je systém na rozpoznávanie tváre trénovaný prevažne na obrázkoch ľudí so svetlou pokožkou, bude mať slabé pokrytie tvárí s tmavšou pokožkou, čo vedie k vyššej chybovosti pre tieto populácie. Toto sa stáva preto, že zberači dát môžu mať obmedzený prístup k rôznorodým populáciám alebo môžu nevedomky uprednostňovať určité skupiny pri zbere dát.

Ďalším dôležitým mechanizmom je non-response bias (bias neodpovede), nazývaný aj bias účasti, ktorý nastáva, keď niektoré skupiny majú menšiu pravdepodobnosť zúčastniť sa zberu dát. Predstavte si dataset založený na prieskumoch na predikciu spotrebiteľských preferencií: ak určité demografické skupiny majú výrazne nižšiu mieru odpovedí na prieskumy, ich preferencie budú v tréningových dátach nedostatočne zastúpené. Takýto dataset sa môže javiť ako vyvážený, no v skutočnosti odráža vzory účasti, nie skutočné charakteristiky populácie. V zdravotníctve napríklad, ak dáta z klinických štúdií pochádzajú prevažne z mestských populácií s prístupom k pokročilej zdravotnej starostlivosti, výsledné AI modely nemusia dobre generalizovať na vidiecke alebo znevýhodnené komunity.

Sampling bias (bias vzorkovania) predstavuje tretí mechanizmus, kde nie je použitá správna randomizácia počas zberu dát. Namiesto náhodného výberu dátových bodov môžu zberači vyberať prvé dostupné vzorky alebo použiť metódy pohodlného výberu. To zavádza systematické chyby, pretože vybrané vzorky nereprezentujú širšiu populáciu. Napríklad, ak je AI model na predikciu nesplácania úverov trénovaný na dátach zo špecifického geografického regiónu alebo časového obdobia, nemusí presne predpovedať nesplácanie v iných regiónoch alebo počas iných ekonomických podmienok.

| Typ biasu | Mechanizmus | Reálny príklad |

|---|---|---|

| Coverage bias | Systematické vylúčenie populácií | Rozpoznávanie tváre trénované len na svetlých tvárach |

| Non-response bias | Medzery v účasti pri zbere dát | Zdravotnícke modely trénované len na mestských populáciách |

| Sampling bias | Nesprávna randomizácia výberu | Modely na predikciu úverov trénované na jednom geografickom regióne |

| Temporal bias | Dáta zo špecifických časových období | Modely trénované na predpandemických dátach použité po pandémii |

| Source diversity bias | Obmedzené zdrojové dáta | Datasets medicínskeho zobrazovania iba z jednej nemocnice |

Dôsledky biasu vo výbere zdrojov v AI systémoch sú výrazné a ďalekosiahle, ovplyvňujú jednotlivcov aj organizácie. V zdravotníctve viedol bias vo výbere zdrojov k diagnostickým systémom, ktoré fungujú výrazne horšie pre určité skupiny pacientov. Výskumy ukázali, že AI algoritmy na diagnostiku rakoviny kože majú podstatne nižšiu presnosť pre pacientov s tmavšou pokožkou – niektoré štúdie uvádzajú len polovicu diagnostickej presnosti v porovnaní s pacientmi so svetlou pokožkou. Tento rozdiel priamo vedie k oneskoreným diagnózam, nevhodným odporúčaniam liečby a horším zdravotným výsledkom pre nedostatočne zastúpené populácie. Ak tréningové dáta pochádzajú prevažne od pacientov jednej demografickej skupiny, výsledné modely sa naučia vzory špecifické pre túto skupinu a nezvládnu generalizovať na ostatné.

Vo finančných službách bias vo výbere zdrojov v algoritmoch na hodnotenie úverovej bonity a poskytovanie pôžičiek udržiava historickú diskrimináciu. Modely trénované na historických dátach o schvaľovaní úverov, ktoré odrážajú minulé diskriminačné postupy, reprodukujú tie isté biasy pri nových rozhodnutiach. Ak boli určité skupiny historicky odmietané kvôli systémovej diskriminácii a tieto historické dáta sa použijú na trénovanie AI modelov, modely sa naučia odmietať úvery podobným skupinám v budúcnosti. Tak vzniká bludný kruh, kde sa historické nerovnosti zabudovávajú do algoritmického rozhodovania a ovplyvňujú prístup k kapitálu a ekonomickým príležitostiam.

Nábor a prijímanie zamestnancov je ďalšou kritickou oblasťou, kde bias vo výbere zdrojov spôsobuje značné škody. AI nástroje na prezeranie životopisov vykazovali bias na základe vnímanej rasy a pohlavia, pričom niektoré štúdie ukazujú, že mená spájané s belochmi boli uprednostnené v 85 % prípadov. Ak tréningové dáta pochádzajú z historických záznamov o prijímaní, ktoré odrážajú minulú diskrimináciu alebo homogénne vzory zamestnávania, výsledné AI modely tieto vzory replikujú. Znamená to, že bias vo výbere zdrojov v dátach o náboroch udržiava diskrimináciu v pracovnom prostredí v širokom meradle, obmedzuje príležitosti pre nedostatočne zastúpené skupiny a znižuje rozmanitosť pracovnej sily.

V trestnej justícii viedol bias vo výbere zdrojov v systémoch prediktívneho policajného dohľadu k neúmernému zameriavaniu sa na určité komunity. Ak tréningové dáta pochádzajú z historických záznamov o zatknutiach, ktoré sú samy o sebe zaujaté proti marginalizovaným skupinám, výsledné modely tieto biasy zosilňujú tým, že predpovedajú vyššiu kriminalitu v týchto komunitách. Vzniká tak spätná väzba, kde zaujaté predikcie vedú k intenzívnejšiemu policajnému dohľadu v niektorých oblastiach, čo generuje viac dát o zatknutiach z týchto oblastí a ďalej posilňuje bias v modeli.

Detekcia biasu vo výbere zdrojov vyžaduje systematický prístup kombinujúci kvantitatívnu analýzu, kvalitatívne hodnotenie a nepretržité monitorovanie počas celého životného cyklu modelu. Prvým krokom je kompletný audit dát, ktorý skúma zdroje, metódy zberu a reprezentatívnosť vašich tréningových dát. Zahŕňa to dokumentáciu pôvodu dát, spôsobu ich zberu a posúdenie, či proces zberu systematicky nevylúčil určité populácie alebo scenáre. Kladieme si zásadné otázky: Boli všetky relevantné demografické skupiny zahrnuté v procese zberu dát? Existovali bariéry účasti, ktoré mohli niektoré skupiny odradiť? Obmedzilo časové obdobie alebo geografický rozsah zberu dát reprezentatívnosť?

Analýza demografickej parity poskytuje kvantitatívny spôsob detekcie biasu vo výbere zdrojov. Zahŕňa porovnanie rozdelenia kľúčových charakteristík v tréningových dátach s rozdelením v reálnej populácii, ktorej má model slúžiť. Ak vaše tréningové dáta výrazne podreprezentujú určité demografické skupiny, vekové kategórie, regióny alebo iné relevantné charakteristiky, máte dôkaz o biase vo výbere zdrojov. Napríklad, ak tréningové dáta obsahujú iba 5 % zastúpenie žien, hoci cieľová populácia je 50 % žien, ide o vážny bias pokrytia, ktorý pravdepodobne povedie k slabému výkonu modelu pre ženy.

Analýza výkonu podľa skupín je ďalšia kľúčová detekčná technika, kde hodnotíte výkon modelu osobitne pre rôzne demografické skupiny a podpopulácie. Aj keď je celková presnosť modelu prijateľná, výkon sa môže medzi skupinami výrazne líšiť. Ak váš model dosahuje 95 % presnosť celkovo, ale len 70 % pre určitú skupinu, znamená to, že bias vo výbere zdrojov spôsobil, že model sa naučil vzory špecifické pre väčšinovú skupinu, no nie pre menšinovú. Táto analýza by mala byť vykonávaná nielen na celkovej presnosti, ale aj na metrikách férovosti ako „equalized odds“ a „disparate impact“.

Adverzariálne testovanie zahŕňa zámerné vytváranie testovacích prípadov, ktoré majú odhaliť potenciálne biasy. Môže to zahŕňať testovanie modelu na dátach z nedostatočne zastúpených populácií, okrajových prípadov alebo scenárov, ktoré nie sú v tréningových dátach dobre zastúpené. Takýmto „stres-testovaním“ modelu na rôznorodých vstupoch môžete identifikovať, kde bias vo výbere zdrojov vytvoril slepé miesta. Napríklad, ak bol model trénovaný prevažne na dátach z mestských oblastí, testujte ho dôkladne na vidieckych dátach a sledujte, či sa výkon zhoršuje. Ak tréningové dáta pochádzali z konkrétneho časového obdobia, testujte model aj na dátach z iných období, aby ste odhalili temporálny bias.

Zmiernenie biasu vo výbere zdrojov si vyžaduje zásahy v rôznych fázach vývoja AI, od zberu dát až po hodnotenie a nasadenie modelu. Najefektívnejším prístupom je data-centric mitigation – zameranie na zdroj biasu zvyšovaním kvality a reprezentatívnosti tréningových dát. Začína to rôznorodým zberom dát, kde aktívne pracujete na zahrnutí nedostatočne zastúpených populácií a scenárov do tréningového datasetu. Namiesto spoliehania sa na pohodlné vzorkovanie či existujúce datasety by organizácie mali vykonávať cielený zber dát, aby zabezpečili adekvátne zastúpenie všetkých relevantných demografických skupín a prípadov použitia.

Techniky pre-vzorkovania a prevažovania poskytujú praktické metódy na riešenie nerovnováh v existujúcich datasetoch. Náhodné nadvzorkovanie duplikuje príklady z nedostatočne zastúpených skupín, zatiaľ čo náhodné podvzorkovanie redukuje príklady z nadmerne zastúpených skupín. Sofistikovanejšie prístupy, ako stratifikované vzorkovanie, zabezpečujú proporcionálne zastúpenie naprieč viacerými dimenziami naraz. Prevažovanie priraďuje vyššiu dôležitosť nedostatočne zastúpeným vzorkám počas tréningu modelu, čím „učí“ algoritmus venovať väčšiu pozornosť vzorom v menšinových skupinách. Tieto techniky najlepšie fungujú v kombinácii so zberom nových dát, nie len pre-vzorkovaním obmedzených dát.

Generovanie syntetických dát predstavuje ďalšiu možnosť, najmä ak je zber reálnych dát z nedostatočne zastúpených skupín náročný alebo drahý. Techniky ako Generatívne Adverzariálne Siete (GANs) a Variational Autoencoders (VAEs) dokážu vytvoriť realistické syntetické príklady pre nedostatočne zastúpené skupiny. Cielenejšie prístupy ako SMOTE (Synthetic Minority Over-sampling Technique) generujú syntetické príklady interpolovaním medzi existujúcimi minoritnými vzorkami. Syntetické dáta je však nutné používať opatrne a dôkladne validovať, pretože pri ich generovaní môžu vzniknúť vlastné biasy.

Algoritmy zohľadňujúce férovosť predstavujú ďalšiu stratégiu, ktorá funguje na úrovni tréningu modelu. Tieto algoritmy explicitne vkladajú férovostné obmedzenia do procesu učenia, aby model dosahoval prijateľný výkon naprieč všetkými demografickými skupinami, nielen väčšinovou. Adverzariálne odbiasovanie napríklad využíva adverzariálnu sieť na to, aby predikcie modelu nemohli byť použité na odvodenie chránených charakteristík ako rasa alebo pohlavie. Férovostné regularizácie pridávajú penalizačné členy do stratovej funkcie, ktoré odrádzajú od diskriminačného správania. Tieto prístupy umožňujú explicitne vyvažovať medzi celkovou presnosťou a férovosťou podľa vašich etických priorít.

Neustále monitorovanie a pretrénovanie zabezpečujú, že bias vo výbere zdrojov sa časom neobjaví alebo nezhorší. Aj keď sú vaše počiatočné tréningové dáta reprezentatívne, reálne rozdelenie populácie sa môže meniť vplyvom demografických zmien, ekonomických faktorov či iných okolností. Implementácia systémov monitorovania výkonu, ktoré sledujú presnosť modelu osobitne pre jednotlivé demografické skupiny, umožňuje detegovať vznikajúci bias. Pri zistení degradácie výkonu je možné model pretrénovať na aktualizovaných dátach odrážajúcich aktuálne rozdelenie populácie a tým obnoviť férovosť. Tento proces uznáva, že zmierňovanie biasu nie je jednorazová úloha, ale nepretržitá zodpovednosť.

Pochopenie biasu vo výbere zdrojov je čoraz dôležitejšie v kontexte monitoringu AI odpovedí a sledovania prítomnosti značky. Ako sa AI systémy ako ChatGPT, Perplexity a ďalšie generátory odpovedí stávajú hlavným zdrojom informácií pre používateľov, zdroje, ktoré tieto systémy citujú a informácie, ktoré prezentujú, sú formované ich tréningovými dátami. Ak tréningové dáta, na ktorých sú tieto AI systémy postavené, vykazujú bias vo výbere zdrojov, odpovede, ktoré generujú, budú tento bias odrážať. Napríklad, ak tréningové dáta AI systému nadmerne zastupujú určité webstránky, publikácie či pohľady a iné naopak podreprezentujú, systém bude častejšie citovať a šíriť informácie z nadmerne zastúpených zdrojov.

To má priamy dopad na monitoring značky a viditeľnosť obsahu. Ak je vaša značka, doména alebo URL nedostatočne zastúpená v tréningových dátach hlavných AI systémov, váš obsah môže byť systematicky vylučovaný alebo podreprezentovaný v AI-generovaných odpovediach. Naopak, ak sú konkurenčné značky alebo dezinformačné zdroje nadmerne zastúpené v tréningových dátach, získajú neprimeranú viditeľnosť v AI odpovediach. Monitorovanie toho, ako sa vaša značka objavuje v AI-generovaných odpovediach na rôznych platformách, vám umožní pochopiť, či bias vo výbere zdrojov v týchto systémoch ovplyvňuje vašu viditeľnosť a reputáciu. Sledovaním, ktoré zdroje sú citované, ako často sa váš obsah objavuje a či sú prezentované informácie presné, môžete identifikovať potenciálne biasy v prezentácii vašej značky a odvetvia AI systémami.

Bias vo výbere zdrojov v AI je zásadný problém férovosti, ktorý vzniká už vo fáze zberu dát a šíri sa všetkými ďalšími aplikáciami modelov strojového učenia. Nastáva vtedy, keď tréningové dáta systematicky vylučujú alebo nedostatočne zastupujú určité populácie, scenáre alebo charakteristiky, čo vedie k modelom, ktoré robia nepresné alebo neférové predikcie pre nedostatočne zastúpené skupiny. Dôsledky sú vážne a ďalekosiahle – ovplyvňujú zdravotné výsledky, prístup k financiám, pracovné príležitosti aj rozhodnutia v justícii. Detekcia biasu vo výbere zdrojov si vyžaduje komplexné audity dát, analýzy demografickej parity, analýzu výkonu podľa skupín a adverzariálne testovanie. Jeho zmiernenie si vyžaduje viacúrovňový prístup vrátane rôznorodého zberu dát, pre-vzorkovania a prevažovania, generovania syntetických dát, férovostne orientovaných algoritmov a neustáleho monitoringu. Organizácie si musia uvedomiť, že riešenie biasu vo výbere zdrojov nie je voliteľné, ale nevyhnutné na budovanie AI systémov, ktoré budú férové, presné a dôveryhodné pre všetky populácie a prípady použitia.

Zaistite, aby sa vaša značka zobrazovala presne v odpovediach generovaných AI naprieč ChatGPT, Perplexity a ďalšími AI platformami. Sledujte, ako AI systémy citujú váš obsah a identifikujte potenciálne biasy v AI odpovediach.

Zistite, ako systémy AI vyberajú a zoraďujú zdroje na citácie. Objavte algoritmy, signály a faktory, ktoré určujú, ktoré webstránky platformy AI ako ChatGPT, Pe...

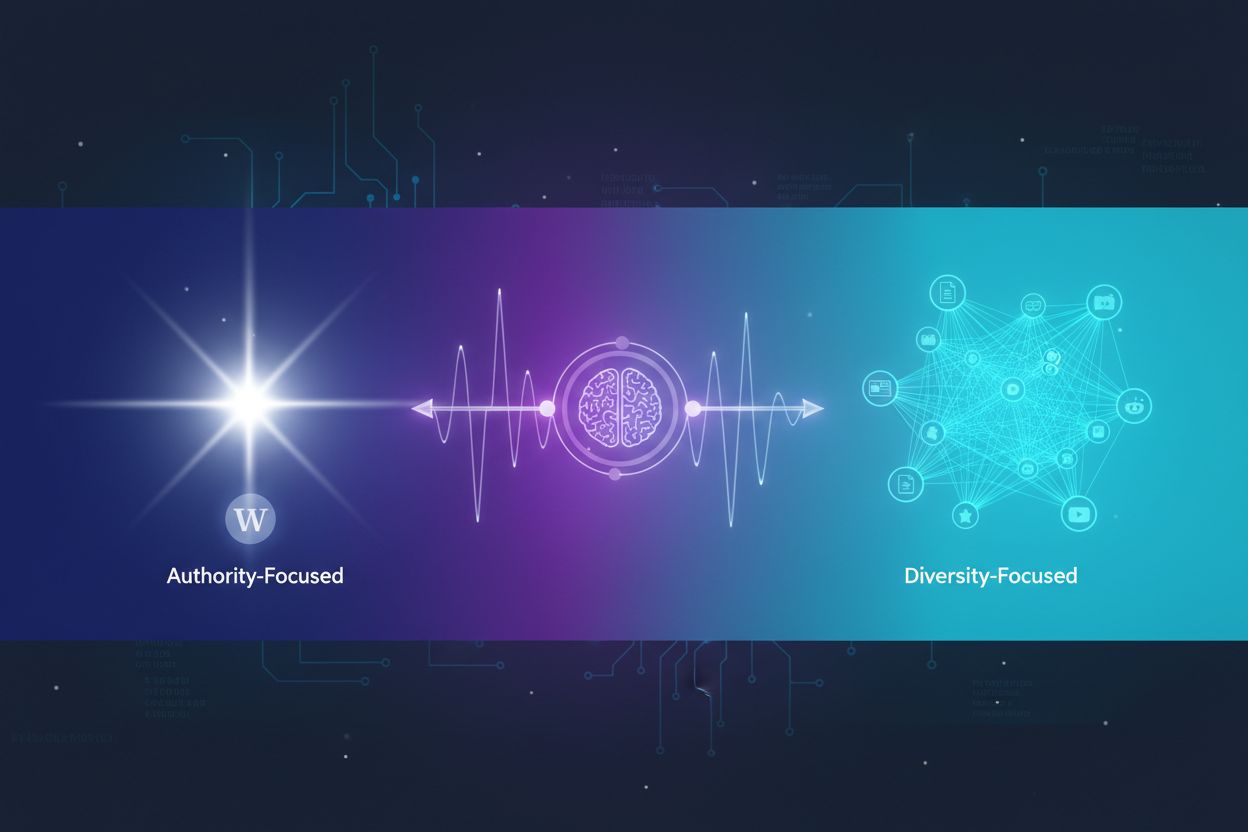

Zistite, ako AI systémy rozhodujú medzi citovaním viacerých zdrojov alebo sústredením sa na autoritatívne. Pochopte vzorce citovania v ChatGPT, Google AI Overvi...

Zistite, ako AI modely spracovávajú a riešia protichodné informácie prostredníctvom hodnotenia dôveryhodnosti, agregácie dát, pravdepodobnostného uvažovania a a...

Súhlas s cookies

Používame cookies na vylepšenie vášho prehliadania a analýzu našej návštevnosti. See our privacy policy.