Čo je Crawl Budget pre AI? Pochopenie rozdelenia zdrojov AI botov

Zistite, čo znamená crawl budget pre AI, ako sa líši od tradičných crawl budgetov vyhľadávačov a prečo je dôležitý pre viditeľnosť vašej značky v AI-generovanýc...

Techniky na zabezpečenie efektívneho prístupu a indexácie najdôležitejšieho obsahu na webovej stránke AI crawlermi v rámci ich limitov. Optimalizácia crawl budgetu vyvažuje kapacitu prechádzania (zdroje servera) a dopyt po prechádzaní (požiadavky botov), aby sa maximalizovala viditeľnosť v AI-generovaných odpovediach a zároveň kontrolovali prevádzkové náklady a zaťaženie servera.

Techniky na zabezpečenie efektívneho prístupu a indexácie najdôležitejšieho obsahu na webovej stránke AI crawlermi v rámci ich limitov. Optimalizácia crawl budgetu vyvažuje kapacitu prechádzania (zdroje servera) a dopyt po prechádzaní (požiadavky botov), aby sa maximalizovala viditeľnosť v AI-generovaných odpovediach a zároveň kontrolovali prevádzkové náklady a zaťaženie servera.

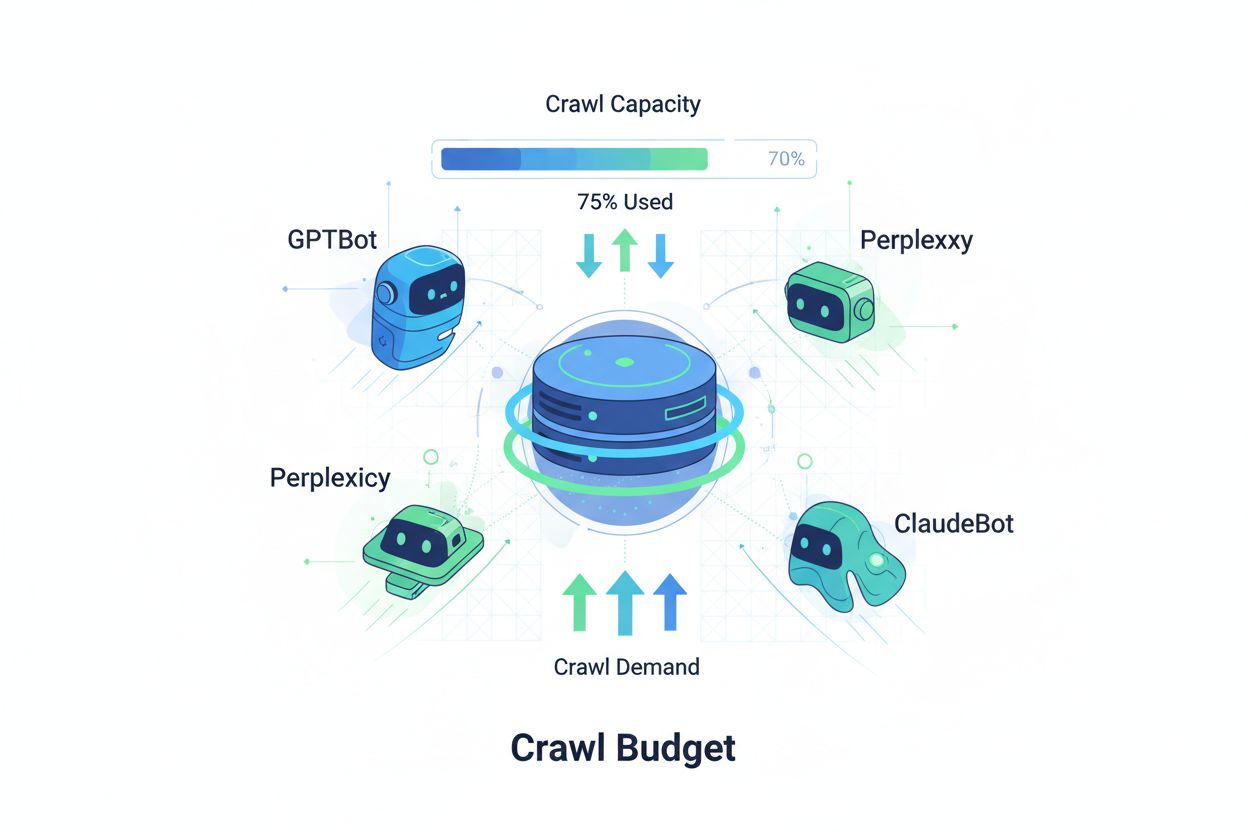

Crawl budget označuje množstvo zdrojov – meraných požiadavkami a šírkou pásma –, ktoré vyhľadávače a AI boti alokujú na prechádzanie vášho webu. Tradične sa tento koncept týkal najmä správania Google, no nástup AI-robotov zásadne zmenil spôsob, akým musia organizácie premýšľať o správe crawl budgetu. Rovnica crawl budgetu pozostáva z dvoch kľúčových premenných: kapacita prechádzania (maximálny počet stránok, ktoré môže bot prejsť) a dopyt po prechádzaní (skutočný počet stránok, ktoré chce bot prejsť). V ére AI sa táto dynamika mnohonásobne skomplikovala, keďže boti ako GPTBot (OpenAI), Perplexity Bot a ClaudeBot (Anthropic) teraz súťažia o serverové zdroje spolu s tradičnými vyhľadávacími crawlermi. Tieto AI boti fungujú s inými prioritami a vzormi než Googlebot, často spotrebujú výrazne viac šírky pásma a sledujú iné indexačné ciele, vďaka čomu optimalizácia crawl budgetu už nie je voliteľná, ale nevyhnutná pre udržanie výkonu webu a kontrolu prevádzkových nákladov.

AI crawlery sa zásadne líšia od tradičných vyhľadávacích botov vo vzoroch prechádzania, frekvencii a spotrebe zdrojov. Zatiaľ čo Googlebot rešpektuje limity crawl budgetu a využíva sofistikované mechanizmy obmedzovania, AI boti často prejavujú agresívnejšie správanie, niekedy žiadajú ten istý obsah opakovane a menej rešpektujú signály zaťaženia servera. Výskumy ukazujú, že GPTBot od OpenAI môže spotrebovať 12-15-krát viac šírky pásma ako crawler od Google na niektorých webstránkach, najmä na stránkach s veľkými knižnicami obsahu alebo často aktualizovanými stránkami. Tento agresívny prístup vyplýva z požiadaviek na trénovanie AI – tieto boti potrebujú neustále získavať nový obsah pre zlepšenie výkonu modelu, čo vytvára zásadne inú filozofiu prechádzania ako vyhľadávače zamerané na indexáciu pre vyhľadávanie. Dopad na server je značný: organizácie hlásia výrazné zvýšenie nákladov na šírku pásma, využívanie CPU a zaťaženie servera spôsobené priamo AI boti. Navyše kumulatívny efekt viacerých AI botov prechádzajúcich súčasne môže zhoršiť užívateľský zážitok, spomaliť načítanie stránok a zvýšiť výdavky na hosting, čím sa rozdiel medzi tradičnými a AI crawlermi stáva kritickou obchodnou otázkou, nie len technickou zaujímavosťou.

| Charakteristika | Tradičné crawlery (Googlebot) | AI crawlery (GPTBot, ClaudeBot) |

|---|---|---|

| Frekvencia prechádzania | Adaptívna, rešpektuje crawl budget | Agresívna, nepretržitá |

| Spotreba šírky pásma | Mierna, optimalizovaná | Vysoká, náročná na zdroje |

| Rešpektovanie robots.txt | Prísne dodržiavanie | Rôzna úroveň dodržiavania |

| Správanie pri cacheovaní | Sofistikované cacheovanie | Časté opakované požiadavky |

| Identifikácia user-agenta | Jasná, konzistentná | Niekedy maskovaná |

| Obchodný cieľ | Indexácia do vyhľadávania | Tréning modelu/zbieranie dát |

| Dopad na náklady | Minimálny | Výrazný (12-15x vyšší) |

Porozumenie crawl budgetu vyžaduje zvládnutie jeho dvoch základných komponentov: kapacity prechádzania a dopytu po prechádzaní. Kapacita prechádzania predstavuje maximálny počet URL, ktoré váš server zvládne prechádzať v danom časovom rámci, určený viacerými prepojenými faktormi. Kapacitu ovplyvňuje:

Dopyt po prechádzaní naopak predstavuje, koľko stránok boti skutočne chcú prechádzať, podľa charakteristík obsahu a priorít botov. Faktory ovplyvňujúce dopyt po prechádzaní zahŕňajú:

Optimalizačná výzva nastáva, keď dopyt po prechádzaní prevyšuje kapacitu – boti si musia vybrať, ktoré stránky prejdú a môžu vynechať dôležité aktualizácie. Naopak, ak kapacita výrazne prevyšuje dopyt, plytváte serverovými zdrojmi. Cieľom je dosiahnuť crawl efektívnosť: maximalizovať prehľadávanie dôležitých stránok a minimalizovať plytvanie na málo hodnotný obsah. Táto rovnováha je čoraz zložitejšia v AI ére, kde viacero typov botov s rôznymi prioritami súťaží o rovnaké serverové zdroje a vyžaduje sofistikované stratégie na efektívne rozdelenie crawl budgetu medzi všetkých aktérov.

Meranie výkonu crawl budgetu začína v Google Search Console, kde v sekcii „Nastavenia“ nájdete štatistiky prechádzania: denné požiadavky, stiahnuté bajty a časy odozvy. Na výpočet crawl efektívnosti vydelte počet úspešných prechodov (HTTP 200 odpovede) celkovým počtom požiadaviek; zdravé weby bežne dosahujú efektívnosť 85-95 %. Základný vzorec: (úspešné prechody ÷ celkový počet požiadaviek) × 100 = % efektívnosti. Okrem údajov od Google je v praxi potrebné:

Pre monitoring AI crawlerov ponúka AmICited.com špecializované sledovanie aktivít GPTBot, ClaudeBot a Perplexity Bot, vrátane toho, ktoré stránky boti uprednostňujú a ako často sa vracajú. Implementácia vlastných upozornení na neočakávané špičky v crawl aktivite – najmä od AI botov – umožňuje rýchlo reagovať na neočakávanú spotrebu zdrojov. Kľúčová metrika je cena prechádzania za stránku: vydelením celkových serverových zdrojov spotrebovaných prechádzaním počtom unikátnych prechádzaných stránok zistíte, či crawl budget využívate efektívne alebo plytváte na málo hodnotný obsah.

Optimalizácia crawl budgetu pre AI botov vyžaduje viacvrstvový prístup kombinujúci technickú implementáciu so strategickým rozhodovaním. Hlavné optimalizačné taktiky zahŕňajú:

Voľba konkrétnej taktiky závisí od vášho obchodného modelu a obsahovej stratégie. E-shopy môžu blokovať AI crawlery na produktových stránkach, aby zabránili tréningu konkurencie na ich dátach, kým vydavatelia obsahu môžu povoliť prechádzanie na zvýšenie viditeľnosti v AI odpovediach. Pri skutočnom serverovom preťažení AI boti je najpriamejším riešením blokovanie podľa user-agenta v robots.txt: User-agent: GPTBot následne Disallow: / úplne zabráni crawleru OpenAI prístup na stránku. Tento prístup však obetuje potenciálnu viditeľnosť v odpovediach ChatGPT a iných AI aplikáciách. Nuansovanejšou stratégiou je selektívne blokovanie: povoliť AI crawlerom prístup k verejnému obsahu a blokovať citlivé sekcie, archívy alebo duplicity, ktoré plytvajú crawl budgetom bez prínosu pre bota alebo vašich užívateľov.

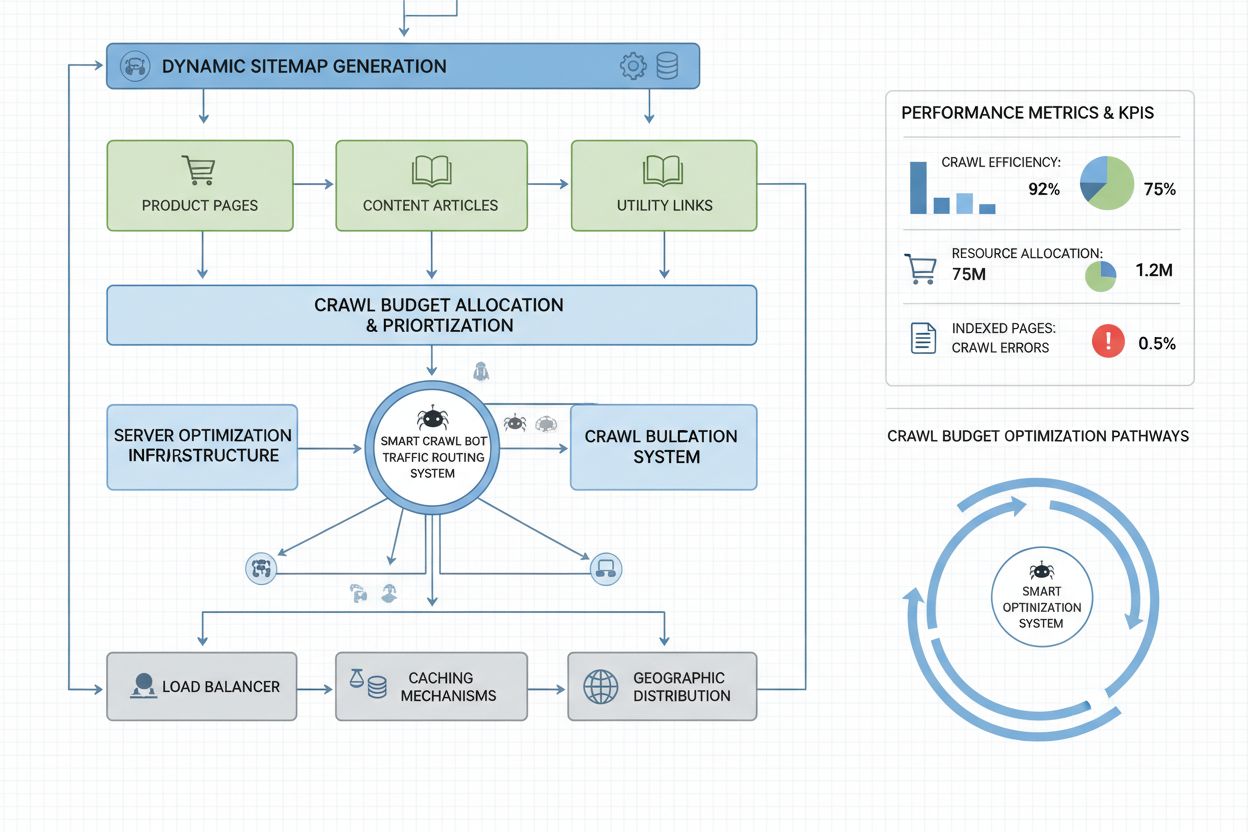

Weby na úrovni enterprise s miliónmi stránok vyžadujú pokročilé stratégie optimalizácie crawl budgetu nad rámec základnej konfigurácie robots.txt. Dynamické sitemap predstavujú zásadný pokrok, keď sa sitemap generujú v reálnom čase podľa čerstvosti obsahu, dôležitosti a histórie prechádzania. Namiesto statických XML sitemap so všetkými stránkami dynamické sitemap uprednostňujú nedávno aktualizované, vysoko navštevované a konverzné stránky, aby boti využívali crawl budget na najdôležitejší obsah. Segmentácia URL rozdeľuje web na logické crawl zóny s vlastnými optimalizačnými stratégiami – spravodajské sekcie môžu používať agresívne aktualizácie sitemap na okamžité prechádzanie denného obsahu, zatiaľ čo evergreen obsah má menej časté aktualizácie.

Optimalizácia na strane servera zahŕňa caching stratégie citlivé na crawlery, ktoré servírujú cachovaný obsah botom a čerstvý obsah užívateľom, čím znižujú záťaž pri opakovaných požiadavkách botov. Content delivery networky (CDN) s bot-specifickým smerovaním môžu izolovať bot návštevnosť od užívateľov a zabrániť, aby crawlery spotrebovali šírku pásma určenú návštevníkom. Obmedzovanie rýchlosti podľa user-agenta umožňuje serveru obmedziť požiadavky AI botov pri zachovaní normálnej rýchlosti pre Googlebot a užívateľov. Pri skutočne veľkých prevádzkach distribuovaná správa crawl budgetu naprieč viacerými serverovými regiónmi zabraňuje jedinému bodu zlyhania a umožňuje geografické rozloženie záťaže botov. Predikcia crawlovania pomocou strojového učenia analyzuje historické vzory crawlovania na predpovedanie, ktoré stránky boti budú žiadať najbližšie, čím možno proaktívne optimalizovať výkon a cache týchto stránok. Tieto enterprise stratégie menia crawl budget z obmedzenia na riadený zdroj, vďaka čomu môžu veľké organizácie obsluhovať miliardy stránok pri zachovaní optimálneho výkonu pre botov aj užívateľov.

Rozhodnutie blokovať alebo povoliť AI crawlery je zásadnou obchodnou stratégiou s významnými dôsledkami pre viditeľnosť, konkurencieschopnosť a prevádzkové náklady. Povolenie AI crawlerov prináša významné výhody: váš obsah sa môže objaviť v AI-generovaných odpovediach, čo môže priviesť návštevnosť z ChatGPT, Claude, Perplexity a ďalších AI aplikácií; vaša značka získa viditeľnosť v novom distribučnom kanáli a profitujete zo SEO signálov vyplývajúcich z citovania AI systémami. Tieto výhody však prichádzajú s nákladmi: zvýšené serverové zaťaženie a spotreba šírky pásma, potenciálne trénovanie konkurenčných AI modelov na vašom obsahu a strata kontroly nad prezentáciou a atribúciou vašich informácií v AI odpovediach.

Blokovanie AI crawlerov tieto náklady eliminuje, ale obetuje výhody viditeľnosti a môže prenechať trhový podiel konkurencii, ktorá prehľadávanie povolí. Optimálna stratégia závisí od vášho obchodného modelu: vydavatelia obsahu a spravodajské organizácie najčastejšie profitujú z povolenia prechádzania kvôli distribúcii cez AI sumáre; SaaS spoločnosti a e-shopy môžu crawlery blokovať, aby zabránili konkurencii trénovať modely na ich dátach; vzdelávacie a výskumné inštitúcie zvyčajne povolia prechádzanie na maximalizáciu šírenia poznatkov. Hybridný prístup ponúka kompromis: povoliť prechádzanie verejného obsahu a blokovať prístup k citlivým sekciám, užívateľskému obsahu alebo chráneným informáciám. Táto stratégia maximalizuje výhody viditeľnosti a zároveň chráni hodnotné aktíva. Navyše, monitoring cez AmICited.com a podobné nástroje ukáže, či je váš obsah skutočne citovaný AI systémami – ak sa váš web v AI odpovediach napriek povoleniu prechádzania neobjavuje, blokovanie sa stáva lákavejšie, pretože znášate náklady bez prínosu z viditeľnosti.

Efektívna správa crawl budgetu vyžaduje špecializované nástroje, ktoré poskytujú prehľad o správaní botov a umožňujú optimalizáciu na základe dát. Conductor a Sitebulb ponúkajú enterprise analýzu crawl budgetu, simulujú prechádzanie webu vyhľadávačmi a identifikujú neefektívnosti, plytvanie crawl budgetu na chybové stránky a príležitosti na zlepšenie rozdelenia rozpočtu. Cloudflare poskytuje správu botov na sieťovej úrovni, umožňuje detailnú kontrolu nad prístupom botov a obmedzenie rýchlosti špecificky pre AI crawlerov. Pre monitoring AI crawlerov je najkomplexnejším riešením AmICited.com, ktorý sleduje GPTBot, ClaudeBot, Perplexity Bot a ďalšie AI crawlery s detailnou analytikou, ktorá ukazuje, ktoré stránky boti navštevujú, ako často sa vracajú a či sa váš obsah objavuje v AI-generovaných odpovediach.

Analýza serverových logov zostáva základom optimalizácie crawl budgetu – nástroje ako Splunk, Datadog alebo open-source ELK Stack umožňujú analyzovať surové prístupové logy a segmentovať návštevnosť podľa user-agenta, identifikovať, ktorí boti spotrebúvajú najviac zdrojov a ktoré stránky sú najviac prechádzané. Vlastné dashboardy na sledovanie trendov crawlovania v čase ukazujú, či optimalizačné snahy fungujú a či sa objavujú nové typy botov. Google Search Console poskytuje základné údaje o správaní Googlebotu, zatiaľ čo Bing Webmaster Tools ponúka podobné dáta pre crawler od Microsoftu. Najsofistikovanejšie organizácie zavádzajú multinástrojové monitorovanie: Google Search Console na tradičné crawl dáta, AmICited.com na monitoring AI crawlerov, analýzu serverových logov na úplný prehľad botov a špecializované nástroje ako Conductor na simuláciu crawlovania a analýzu efektívnosti. Tento vrstvený prístup poskytuje úplný prehľad o interakcii všetkých botov s vaším webom a umožňuje optimalizačné rozhodnutia založené na komplexných dátach, nie dohade. Pravidelné monitorovanie – ideálne týždenné kontroly crawl metrík – umožňuje rýchlo identifikovať problémy ako neočakávané špičky, nárast chýb alebo nové agresívne boty a rýchlo reagovať ešte predtým, ako crawl budget ovplyvní výkon webu alebo prevádzkové náklady.

AI boti ako GPTBot a ClaudeBot fungujú s inými prioritami ako Googlebot. Kým Googlebot rešpektuje limity crawl budgetu a využíva sofistikované obmedzovanie, AI boti často prejavujú agresívnejšie prehľadávacie vzory a spotrebujú 12-15-krát viac šírky pásma. AI boti uprednostňujú nepretržité získavanie obsahu na trénovanie modelov namiesto indexovania pre vyhľadávanie, čo robí ich správanie zásadne odlišným a vyžaduje špecifické optimalizačné stratégie.

Výskum ukazuje, že GPTBot od OpenAI môže spotrebovať 12-15-krát viac šírky pásma ako crawler od Google na niektorých webstránkach, najmä na stránkach s veľkými knižnicami obsahu. Presná spotreba závisí od veľkosti vášho webu, frekvencie aktualizácie obsahu a počtu AI botov, ktoré prechádzajú naraz. Viacero AI botov súčasne môže výrazne zvýšiť zaťaženie servera a náklady na hosting.

Áno, môžete zablokovať konkrétnych AI crawlerov pomocou robots.txt bez vplyvu na tradičné SEO. Zablokovanie AI crawlerov však znamená obetovať viditeľnosť v AI-generovaných odpovediach z ChatGPT, Claude, Perplexity a ďalších AI aplikácií. Rozhodnutie závisí od vášho obchodného modelu – vydavatelia obsahu zvyčajne profitujú z povolenia prehľadávania, zatiaľ čo e-shopy môžu blokovať, aby zabránili tréningu konkurencie.

Zlá správa crawl budgetu môže viesť k tomu, že dôležité stránky nebudú prehľadané alebo indexované, spomalí sa indexácia nového obsahu, zvýši sa zaťaženie servera a náklady na šírku pásma, zhorší sa užívateľský zážitok kvôli spotrebe zdrojov botmi a prídete o príležitosti na viditeľnosť v tradičnom vyhľadávaní aj AI-generovaných odpovediach. Najviac ohrozené sú veľké weby s miliónmi stránok.

Pre optimálne výsledky sledujte metriky crawl budgetu týždenne, s dennými kontrolami počas väčších spustení obsahu alebo pri neočakávaných špičkách návštevnosti. Používajte Google Search Console na tradičné údaje o prechádzaní, AmICited.com na sledovanie AI crawlerov a serverové logy na komplexný prehľad o botoch. Pravidelné monitorovanie umožňuje rýchlo identifikovať problémy ešte predtým, ako ovplyvnia výkon webu.

Robots.txt má pre AI boty rôznu účinnosť. Zatiaľ čo Googlebot striktne rešpektuje pravidlá robots.txt, AI boti ich dodržiavajú nejednotne – niektorí rešpektujú, iní ignorujú. Pre spoľahlivejšiu kontrolu použite blokovanie podľa user-agenta, obmedzenie rýchlosti na úrovni servera alebo CDN nástroje na správu botov, ako je Cloudflare, pre detailnejšiu kontrolu.

Crawl budget priamo ovplyvňuje AI viditeľnosť, pretože AI boti nemôžu citovať alebo odkazovať na obsah, ktorý neprešli. Ak vaše dôležité stránky nie sú prehľadané kvôli obmedzeniam rozpočtu, neobjavia sa v AI-generovaných odpovediach. Optimalizácia crawl budgetu zabezpečí, že váš najlepší obsah objavia AI boti, čím sa zvýši šanca na citovanie v odpovediach ChatGPT, Claude a Perplexity.

Uprednostnite stránky pomocou dynamických sitemap, ktoré zvýrazňujú nedávno aktualizovaný obsah, stránky s vysokou návštevnosťou a stránky s konverzným potenciálom. Použite robots.txt na blokovanie stránok s nízkou hodnotou, ako sú archívy a duplicity. Implementujte čisté URL a strategické interné prelinkovanie, aby ste nasmerovali botov na dôležitý obsah. Sledujte, ktoré stránky AI boti skutočne prechádzajú pomocou nástrojov ako AmICited.com a podľa toho upravujte svoju stratégiu.

Sledujte, ako AI boti prechádzajú váš web a optimalizujte svoju viditeľnosť v AI-generovaných odpovediach s komplexnou platformou na monitoring AI crawlerov od AmICited.com.

Zistite, čo znamená crawl budget pre AI, ako sa líši od tradičných crawl budgetov vyhľadávačov a prečo je dôležitý pre viditeľnosť vašej značky v AI-generovanýc...

Crawl budget je počet stránok, ktoré vyhľadávače prehľadávajú na vašej webstránke v rámci určitého časového obdobia. Naučte sa, ako optimalizovať crawl budget p...

Zistite, ako používať robots.txt na kontrolu, ktoré AI boty majú prístup k vášmu obsahu. Kompletný sprievodca blokovaním GPTBot, ClaudeBot a ďalších AI crawlero...

Súhlas s cookies

Používame cookies na vylepšenie vášho prehliadania a analýzu našej návštevnosti. See our privacy policy.