Robots.txt pre AI: Ako kontrolovať, ktoré boty majú prístup k vášmu obsahu

Zistite, ako používať robots.txt na kontrolu, ktoré AI boty majú prístup k vášmu obsahu. Kompletný sprievodca blokovaním GPTBot, ClaudeBot a ďalších AI crawlero...

Strategický prístup, ktorý umožňuje vlastníkom webových stránok selektívne povoliť niektoré AI prehliadače (crawlery), pričom iné blokujú na základe obchodných cieľov, licenčných dohôd o obsahu a hodnotového posúdenia. Namiesto plošných politík sa diferencovaný prístup posudzuje individuálne pre každý crawler, aby sa určilo, či prináša návštevnosť, rešpektuje licenčné podmienky alebo zodpovedá monetizačným cieľom. Vydavatelia používajú nástroje ako robots.txt, HTTP hlavičky a platformovo špecifické ovládacie prvky na implementáciu detailných politík prístupu. Táto metóda vyvažuje príležitosti na inovácie s ochranou obsahu a spravodlivou kompenzáciou.

Strategický prístup, ktorý umožňuje vlastníkom webových stránok selektívne povoliť niektoré AI prehliadače (crawlery), pričom iné blokujú na základe obchodných cieľov, licenčných dohôd o obsahu a hodnotového posúdenia. Namiesto plošných politík sa diferencovaný prístup posudzuje individuálne pre každý crawler, aby sa určilo, či prináša návštevnosť, rešpektuje licenčné podmienky alebo zodpovedá monetizačným cieľom. Vydavatelia používajú nástroje ako robots.txt, HTTP hlavičky a platformovo špecifické ovládacie prvky na implementáciu detailných politík prístupu. Táto metóda vyvažuje príležitosti na inovácie s ochranou obsahu a spravodlivou kompenzáciou.

Exploze AI crawlerov zásadne narušila desaťročia starý vzťah medzi vlastníkmi webstránok a botmi. Roky fungoval internet na jednoduchom princípe: vyhľadávače typu Google indexovali obsah a smerovali návštevnosť späť k pôvodným zdrojom, čím vytvárali symbiotický vzťah, ktorý odmeňoval kvalitnú tvorbu obsahu. Dnes nová generácia AI crawlerov – vrátane GPTBot, ClaudeBot, PerplexityBot a desiatok ďalších – funguje podľa iných pravidiel. Tieto boty obsah neskenujú kvôli objaveniu, ale aby ho priamo vložili do AI modelov, ktoré generujú odpovede bez odkazovania používateľov späť na pôvodný zdroj. Dôsledky sú zrejmé: podľa údajov Cloudflare má GPTBot od OpenAI pomer crawl/referral približne 1 700:1, zatiaľ čo ClaudeBot od Anthropicu až 73 000:1 – na každého návštevníka poslaného späť na stránku je vycrawlovaných tisíce stránok za účelom trénovania. Tento narušený výmenný obchod núti vydavateľov prehodnotiť politiku prístupu crawlerov a posunúť sa od binárnej voľby „povoliť všetko“ alebo „blokovať všetko“ k prepracovanejšej stratégii: diferencovaný prístup crawlerov. Namiesto plošných pravidiel teraz skúsení vydavatelia hodnotia každý crawler individuálne a kladú si zásadné otázky o hodnote, licencovaní a súlade s obchodnými cieľmi.

Pochopenie rôznych typov AI crawlerov je kľúčové pre efektívnu implementáciu diferencovaného prístupu, keďže každý z nich má iný účel a rôzny dopad na vaše podnikanie. AI crawlery patria do troch hlavných kategórií: trénovacie crawlery (GPTBot, ClaudeBot, anthropic-ai, CCBot, Bytespider), ktoré zbierajú obsah pre trénovanie modelov; vyhľadávacie crawlery (OAI-SearchBot, PerplexityBot, Google-Extended), ktoré indexujú obsah pre AI-poháňané vyhľadávanie; a agenti vyvolaní používateľom (ChatGPT-User, Claude-Web, Perplexity-User), ktorí siahajú po obsahu len na explicitnú žiadosť používateľa. Hodnota sa medzi týmito kategóriami dramaticky líši. Trénovacie crawlery zvyčajne neprinášajú takmer žiadnu návštevnosť – čerpajú hodnotu bez protihodnoty – preto sú hlavnými kandidátmi na blokovanie. Vyhľadávacie crawlery naopak môžu privádzať významnú návštevnosť a konverzie predplatiteľov, podobne ako tradičné vyhľadávače. Agenti vyvolaní používateľom predstavujú strednú cestu, aktivujú sa len pri aktívnej interakcii používateľa s AI systémom. The Atlantic, jeden z najväčších digitálnych vydavateľov, zaviedol sofistikovaný skórovací systém na hodnotenie crawlerov, kde sleduje objem návštevnosti a konverzie predplatiteľov pre každý bot. Ich analýza ukázala, že niektoré crawlery prinášajú reálnu hodnotu, iné generujú takmer nulovú návštevnosť, no spotrebúvajú významnú šírku pásma. Tento dátovo riadený prístup umožňuje vydavateľom rozhodovať sa na základe faktov, nie predpokladov.

| Typ crawlera | Príklady | Hlavný účel | Typická hodnota návštevnosti | Odporúčaný prístup |

|---|---|---|---|---|

| Trénovací | GPTBot, ClaudeBot, anthropic-ai, CCBot, Bytespider | Dataset na tréning modelov | Veľmi nízka (1 700:1 - 73 000:1 pomer) | Často blokovať |

| Vyhľadávací | OAI-SearchBot, PerplexityBot, Google-Extended | Indexácia pre AI vyhľadávanie | Stredná až vysoká | Často povoliť |

| Vyvolaný používateľom | ChatGPT-User, Claude-Web, Perplexity-User | Priama požiadavka používateľa | Rôzna | Individuálne posúdiť |

Implementácia diferencovaného prístupu crawlerov si vyžaduje kombináciu technických nástrojov a strategického rozhodovania, pričom dostupné metódy závisia od vašich technických možností a obchodných požiadaviek. Najzákladnejším nástrojom je robots.txt, jednoduchý textový súbor v koreňovom adresári webu, ktorý komunikuje preferencie prístupu crawlerov prostredníctvom User-agent direktív. Hoci robots.txt je dobrovoľný a rešpektuje ho len 40–60 % AI botov, stále predstavuje prvú líniu obrany a jeho implementácia je bezplatná. Pre vydavateľov, ktorí požadujú silnejšie vynútenie, Cloudflare managed robots.txt automaticky vytvára a aktualizuje direktívy pre crawlery, pričom ich pridáva k vášmu súboru a eliminuje potrebu ručnej správy. Okrem robots.txt existuje viacero ďalších mechanizmov na zvýšenie kontroly:

Najefektívnejší prístup kombinuje viaceré vrstvy: robots.txt pre poctivých crawlerov, WAF pravidlá pre vynútenie a monitorovacie nástroje na sledovanie účinnosti a identifikáciu nových hrozieb.

Implementácia diferencovaného prístupu crawlerov vyžaduje prekročiť rámec technickej realizácie a vytvoriť ucelenú obchodnú stratégiu v súlade s vaším príjmovým modelom a konkurenčným postavením. Prístup The Atlantic ponúka praktický rámec: hodnotia každý crawler podľa dvoch základných metrík – objem návštevnosti a konverzie predplatiteľov – a pýtajú sa, či daný crawler generuje dostatočnú hodnotu na to, aby mal prístup k obsahu. Pre vydavateľa s hodnotou predplatiteľa 80 $ ročne predstavuje crawler, ktorý prinesie 1 000 predplatiteľov, ročný príjem 80 000 $, čo zásadne ovplyvňuje rozhodovanie o prístupe. Návštevnosť a konverzie však tvoria len časť rovnice. Vydavatelia by mali zvážiť aj:

Najstrategickejší vydavatelia implementujú stupňovité politiky: povolia vyhľadávacie crawlery, ktoré prinášajú návštevnosť, blokujú trénovacie crawlery bez hodnoty a s najhodnotnejšími AI spoločnosťami vyjednávajú licenčné zmluvy. Tento prístup maximalizuje viditeľnosť aj príjmy, pričom chráni duševné vlastníctvo.

Hoci diferencovaný prístup crawlerov prináša významné výhody, realita je zložitejšia a existuje niekoľko zásadných výziev, ktoré obmedzujú efektívnosť a vyžadujú neustály manažment. Najdôležitejším obmedzením je, že robots.txt je dobrovoľný – crawlery ho rešpektujú z vlastnej vôle, nie z povinnosti. Výskumy ukazujú, že robots.txt zastaví len 40–60 % AI botov, ďalších 30–40 % zachytí blokovanie User-Agentov a 10–30 % crawlerov funguje úplne bez obmedzení. Niektoré AI firmy a škodliví aktéri zámerne ignorujú robots.txt, pretože prístup k obsahu je pre nich cennejší než dodržiavanie pravidiel. Okrem toho sa techniky obchádzania crawlerov neustále vyvíjajú: pokročilé boty spoofujú User-Agent, tvária sa ako bežné prehliadače, využívajú distribuované IP adresy na obídenie detekcie a používajú headless prehliadače napodobňujúce správanie človeka. Dilema Google-Extended je príkladom tejto zložitosti: blokovanie Google-Extended zabráni použitiu vášho obsahu na trénovanie Gemini AI, ale Google AI Overviews (zobrazované vo výsledkoch vyhľadávania) používajú štandardné Googlebot pravidlá, takže sa z AI Overviews nedá odhlásiť bez straty viditeľnosti vo vyhľadávaní. Monitorovanie a vynucovanie si tiež vyžaduje značné zdroje – sledovanie nových crawlerov, aktualizácia politík a overovanie účinnosti si vyžaduje trvalú pozornosť. Nakoniec, právne prostredie je neisté: hoci právo na autorské dielo by malo chrániť obsah, vymáhanie voči AI spoločnostiam je nákladné a výsledky nepredvídateľné, takže vydavatelia majú technickú kontrolu, no nie právnu istotu.

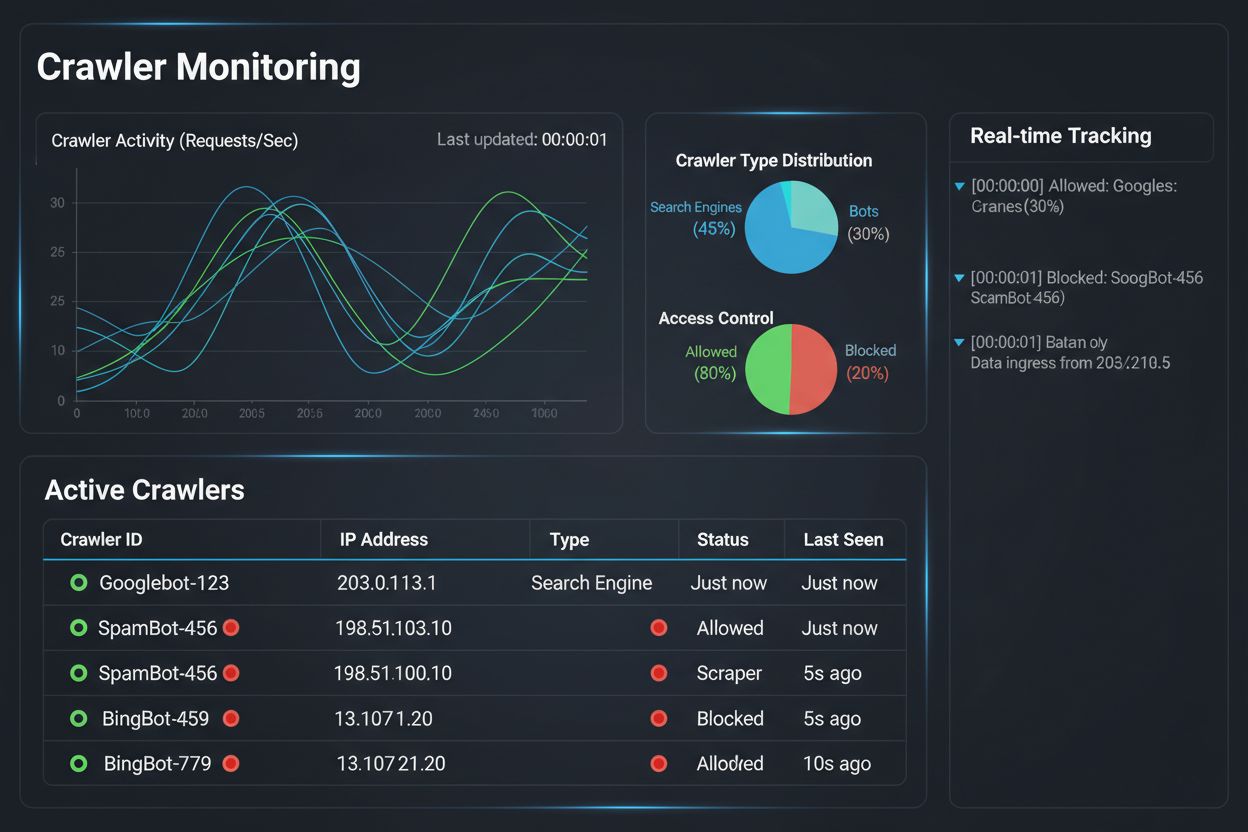

Implementácia diferencovaného prístupu crawlerov je len polovica úspechu; druhú polovicu tvorí pochopenie skutočného dopadu vašich politík prostredníctvom dôkladného monitorovania a merania. Tu sa AmICited.com stáva neoddeliteľnou súčasťou vašej stratégie riadenia crawlerov. AmICited sa špecializuje na monitorovanie toho, ako AI systémy odkazujú a citujú vašu značku naprieč GPT, Perplexity, Google AI Overviews a inými AI platformami – poskytuje prehľad o tom, ktoré crawlery skutočne využívajú váš obsah a ako sa zobrazuje v AI-generovaných odpovediach. Namiesto spoliehania sa na serverové logy a dohady vám monitorovací panel AmICited presne ukáže, ktoré AI systémy pristupovali k vášmu obsahu, ako často a hlavne, či je váš obsah citovaný alebo len absorbovaný do trénovacích dát bez atribúcie. Tieto poznatky priamo ovplyvňujú vaše rozhodnutia o prístupe: ak crawler využíva váš obsah, no nikdy ho necituje v AI odpovediach, blokovanie je jasné obchodné rozhodnutie. AmICited umožňuje aj konkurenčné porovnávanie – ukáže vám, ako je vaša značka viditeľná v AI systémoch v porovnaní s konkurenciou, takže rýchlejšie zistíte, či sú vaše politiky príliš prísne alebo príliš voľné. Platforma ponúka aj okamžité notifikácie, keď nové AI systémy začnú odkazovať na váš obsah, vďaka čomu môžete rýchlo upraviť pravidlá. Kombináciou monitorovacích možností AmICited s vynucovacími nástrojmi Cloudflare získajú vydavatelia úplnú kontrolu a prehľad: vidia, ktoré crawlery pristupujú k obsahu, merajú obchodný dopad a podľa toho upravujú politiky. Tento dátovo riadený prístup mení správu crawlerov z technickej povinnosti na strategickú obchodnú funkciu.

Prostredie diferencovaného prístupu crawlerov sa rýchlo mení – vznikajúce štandardy a obchodné modely pretvárajú vzťahy medzi vydavateľmi a AI spoločnosťami v oblasti obsahu. IETF AI preferences proposal predstavuje významný posun, keďže zavádza štandardizované možnosti, ako môžu weby komunikovať svoje preferencie ohľadom AI trénovania, inferencie a vyhľadávania. Namiesto spoliehania sa na robots.txt – 30 rokov starý štandard určený pre vyhľadávače – tento rámec poskytuje explicitnú a detailnú kontrolu nad tým, ako môžu AI systémy používať obsah. Súčasne sa presadzujú obchodné modely založené na povoleniach, pričom Cloudflare so svojou iniciatívou Pay Per Crawl zavádza rámec, kde AI spoločnosti platia vydavateľom za prístup k obsahu, a tak sa crawlery menia z hrozby na zdroj príjmov. Tento posun od blokovania k licencovaniu znamená zásadnú zmenu v internetovej ekonomike: namiesto boja o prístup vydavatelia a AI firmy vyjednávajú o spravodlivej kompenzácii. Štandardy autentifikácie a verifikácie crawlerov sa taktiež posúvajú vpred, pričom kryptografické metódy umožňujú overiť identitu crawlera a zabrániť podvodným požiadavkám. Do budúcnosti možno očakávať aj zvýšenie regulačných rámcov ohľadom trénovacích dát AI, ktoré môžu vyžadovať výslovný súhlas a kompenzáciu za využitie obsahu. Súhra týchto trendov – technické štandardy, licenčné modely, autentifikácia a regulačný tlak – napovedá, že diferencovaný prístup crawlerov sa vyvinie z defenzívnej stratégie na sofistikovanú obchodnú funkciu, v rámci ktorej vydavatelia aktívne riadia, monitorujú a monetizujú prístup AI crawlerov. Tí, ktorí dnes implementujú komplexný monitoring a strategické politiky, budú najlepšie pripravení využiť nové príležitosti.

Blokovanie všetkých crawlerov úplne odstráni váš obsah z AI systémov, čím sa eliminujú aj riziká, aj príležitosti. Diferencovaný prístup vám umožňuje hodnotiť každý crawler individuálne, blokovať tých, ktorí neprinášajú hodnotu, a povoliť tých, ktorí prinášajú návštevnosť alebo predstavujú licenčnú príležitosť. Tento nuansovaný prístup maximalizuje viditeľnosť aj príjmy a zároveň chráni duševné vlastníctvo.

Aktivitu crawlerov môžete sledovať cez serverové logy, analytický panel Cloudflare alebo špecializované monitorovacie nástroje ako AmICited.com. AmICited špecificky zaznamenáva, ktoré AI systémy pristupujú k vášmu obsahu a ako sa vaša značka zobrazuje v AI-generovaných odpovediach, čím poskytuje obchodné poznatky nad rámec technických logov.

Nie. Blokovanie AI crawlerov určených na trénovanie, ako GPTBot, ClaudeBot a CCBot, neovplyvňuje vaše pozície vo vyhľadávačoch Google alebo Bing. Tradičné vyhľadávače používajú iné crawlery (Googlebot, Bingbot), ktoré fungujú nezávisle. Blokujte ich len v prípade, že chcete úplne zmiznúť z výsledkov vyhľadávania.

Áno, pre mnohých vydavateľov je to najstrategickejší prístup. Môžete povoliť vyhľadávacie crawlery ako OAI-SearchBot a PerplexityBot (ktoré privádzajú návštevnosť), pričom zablokujete trénovacie crawlery ako GPTBot a ClaudeBot (ktoré väčšinou neprinášajú návštevnosť). Takto si udržíte viditeľnosť vo výsledkoch AI vyhľadávania a zároveň ochránite obsah pred zaradením do trénovacích datasetov.

Zatiaľ čo hlavné crawlery od OpenAI, Anthropic a Google rešpektujú robots.txt, niektoré boty ho zámerne ignorujú. Ak crawler nerešpektuje váš robots.txt, budete potrebovať ďalšie metódy vynútenia, ako WAF pravidlá, blokovanie IP alebo funkcie správy botov od Cloudflare. Preto sú monitorovacie nástroje ako AmICited kľúčové – ukážu vám, ktoré crawlery naozaj rešpektujú vaše pravidlá.

Vaše politiky prehodnocujte aspoň štvrťročne, keďže AI spoločnosti pravidelne predstavujú nové crawlery. Anthropic zlúčil svoje boty 'anthropic-ai' a 'Claude-Web' do 'ClaudeBot', čím nový bot dočasne získal neobmedzený prístup na stránky, ktoré pravidlá neaktualizovali. Pravidelné monitorovanie pomocou nástrojov ako AmICited vám pomôže držať krok so zmenami.

Googlebot je vyhľadávací crawler Googlu, ktorý indexuje obsah pre výsledky vyhľadávania. Google-Extended je kontrolný token, ktorý konkrétne riadi, či sa váš obsah použije na trénovanie Gemini AI. Google-Extended môžete zablokovať bez vplyvu na pozície vo vyhľadávaní, no treba vedieť, že Google AI Overviews (ktoré sa zobrazujú vo výsledkoch vyhľadávania) používajú štandardné pravidlá Googlebotu, takže sa z AI Overviews nemôžete odhlásiť bez straty viditeľnosti vo vyhľadávaní.

Áno, vznikajúce licenčné modely ako Pay Per Crawl od Cloudflare umožňujú vydavateľom účtovať AI spoločnostiam za prístup k obsahu. Takto sa crawlery menia z hrozby na zdroj príjmu. Vyžaduje to však vyjednávanie s AI spoločnosťami a môže zahŕňať právne dohody. Monitoring AmICited vám pomôže identifikovať, ktoré crawlery predstavujú najhodnotnejšie licenčné príležitosti.

Sledujte, ktoré AI systémy pristupujú k vášmu obsahu a ako sa vaša značka zobrazuje v AI-generovaných odpovediach. Získajte okamžité prehľady o správaní crawlerov a merajte obchodný dopad vašich diferencovaných politík prístupu.

Zistite, ako používať robots.txt na kontrolu, ktoré AI boty majú prístup k vášmu obsahu. Kompletný sprievodca blokovaním GPTBot, ClaudeBot a ďalších AI crawlero...

Kompletný referenčný sprievodca AI crawlermi a botmi. Identifikujte GPTBot, ClaudeBot, Google-Extended a viac ako 20 ďalších AI crawlerov s user agentmi, rýchlo...

Naučte sa identifikovať a monitorovať AI crawlery ako GPTBot, ClaudeBot a PerplexityBot vo vašich serverových logoch. Kompletný sprievodca s user-agent reťazcam...