Impresia

Zistite, čo je impresia vo výsledkoch vyhľadávania a AI monitoringu. Pochopte, ako sa impresie počítajú v Google Search, Perplexity, ChatGPT a na ďalších platfo...

Inferencia je proces, pri ktorom trénovaný AI model generuje výstupy, predikcie alebo závery z nových vstupných údajov aplikovaním vzorcov a znalostí získaných počas tréningu. Predstavuje prevádzkovú fázu, keď AI systémy aplikujú naučenú inteligenciu na riešenie reálnych problémov v produkčných prostrediach.

Inferencia je proces, pri ktorom trénovaný AI model generuje výstupy, predikcie alebo závery z nových vstupných údajov aplikovaním vzorcov a znalostí získaných počas tréningu. Predstavuje prevádzkovú fázu, keď AI systémy aplikujú naučenú inteligenciu na riešenie reálnych problémov v produkčných prostrediach.

Inferencia je proces, pri ktorom trénovaný model umelej inteligencie generuje výstupy, predikcie alebo závery z nových vstupných údajov aplikovaním vzorcov a znalostí získaných počas fázy tréningu. V kontexte AI systémov inferencia predstavuje prevádzkovú fázu, v ktorej modely strojového učenia prechádzajú z laboratória do produkčných prostredí, aby riešili reálne problémy. Keď komunikujete s ChatGPT, Perplexity, Google AI Overviews alebo Claude, zažívate inferenciu v praxi—model prijíma váš vstup a generuje inteligentné odpovede na základe vzorcov, ktoré sa naučil z obrovských trénovacích dátových súborov. Inferencia sa zásadne líši od tréningu; zatiaľ čo tréning učí model, čo má robiť, inferencia je fáza, v ktorej model skutočne koná a aplikuje naučené poznatky na dáta, s ktorými sa nikdy predtým nestretol.

Rozdiel medzi AI tréningom a AI inferenciou je kľúčový pre pochopenie fungovania moderných systémov umelej inteligencie. Počas fázy tréningu dátoví vedci vkladajú obrovské, starostlivo vybrané dátové súbory do neurónových sietí, čím model získava vzorce, vzťahy a rozhodovacie pravidlá prostredníctvom iteratívnej optimalizácie. Tento proces je výpočtovo náročný, často vyžaduje týždne alebo mesiace spracovania na špecializovanom hardvéri, ako sú GPU a TPU. Po ukončení tréningu a dosiahnutí optimálnych váh a parametrov model vstupuje do fázy inferencie. V tomto bode je model „zmrazený“—už sa neučí z nových dát—a namiesto toho aplikuje naučené vzorce na generovanie predikcií alebo výstupov na predtým nevidených vstupoch. Podľa výskumu IBM a Oracle je inferencia miestom, kde sa realizuje skutočná obchodná hodnota AI, pretože umožňuje organizáciám nasadzovať AI vo veľkom rozsahu v produkčných systémoch. Trh s AI inferenciou mal v roku 2025 hodnotu 106,15 miliardy USD a predpokladá sa, že do roku 2030 narastie na 254,98 miliardy USD, čo odráža explozívny dopyt po inferenčných schopnostiach naprieč odvetviami.

AI inferencia prebieha viacstupňovým procesom, ktorý premieňa surové vstupné údaje na inteligentné výstupy. Keď používateľ zadá požiadavku do veľkého jazykového modelu, ako je ChatGPT, inferenčný reťazec začína enkódovaním vstupu, pri ktorom sa text prevedie na číselné tokeny, ktoré môže neurónová sieť spracovať. Model potom vstupuje do fázy prefill, kde sa všetky vstupné tokeny spracovávajú súčasne cez každú vrstvu neurónovej siete, čo umožňuje modelu porozumieť kontextu a vzťahom v používateľovej požiadavke. Táto fáza je výpočtovo náročná, ale nevyhnutná pre pochopenie. Po fáze prefill model prechádza do fázy decode, kde generuje výstupné tokeny sekvenčne, jeden po druhom, pričom každý nový token závisí od všetkých predchádzajúcich v sekvencii. Toto sekvenčné generovanie vytvára charakteristický „streamingový“ efekt, ktorý používateľ vidí pri interakcii s AI chatbotmi. Nakoniec fáza konverzie výstupu premieňa predikované tokeny späť na ľudsky čitateľný text, obrázky alebo iné formáty, ktorým používatelia rozumejú a s ktorými môžu interagovať. Celý tento proces musí prebiehať v milisekundách pre aplikácie v reálnom čase, čo robí optimalizáciu latencie inferencie kľúčovou pre poskytovateľov AI služieb.

Organizácie nasadzujúce AI systémy si musia vybrať medzi troma hlavnými architektúrami inferencie, pričom každá je optimalizovaná pre iné prípady použitia a výkonnostné požiadavky. Batch inferencia spracováva veľké objemy dát offline v plánovaných intervaloch, čo ju robí ideálnou pre scenáre, kde nie sú potrebné okamžité odpovede, napríklad pri generovaní denných analytických dashboardov, týždenných hodnotení rizík či nočných aktualizáciách odporúčaní. Tento prístup je vysoko efektívny a nákladovo výhodný, pretože dokáže spracovať tisíce predikcií naraz a rozložiť výpočtové náklady na mnoho požiadaviek. Online inferencia, nazývaná aj dynamická inferencia, generuje predikcie okamžite na požiadanie s minimálnou latenciou, čo je nevyhnutné pre interaktívne aplikácie, ako sú chatboty, vyhľadávače či systémy detekcie podvodov v reálnom čase. Online inferencia vyžaduje sofistikovanú infraštruktúru na udržanie nízkej latencie a vysokej dostupnosti, často s využitím cache-ovania a optimalizačných techník modelu na zabezpečenie doručenia odpovedí v milisekundách. Streaming inferencia nepretržite spracováva dáta prichádzajúce zo senzorov, IoT zariadení alebo dátových tokov v reálnom čase a generuje predikcie na každý prichádzajúci údaj. Tento typ poháňa aplikácie, ako sú prediktívne údržbové systémy monitorujúce priemyselné zariadenia, autonómne vozidlá spracúvajúce senzorové dáta v reálnom čase či systémy inteligentných miest analyzujúce dopravné vzory nepretržite. Každý typ inferencie si vyžaduje iné architektonické riešenia, hardvérové požiadavky a optimalizačné stratégie.

| Aspekt | Batch inferencia | Online inferencia | Streaming inferencia |

|---|---|---|---|

| Požiadavka na latenciu | Sekundy až minúty | Milisekundy | Reálny čas (subsekundová) |

| Spracovanie dát | Veľké datasety offline | Jednotlivé požiadavky na požiadanie | Kontinuálny dátový tok |

| Použitie | Analýzy, reporting, odporúčania | Chatboty, vyhľadávanie, detekcia podvodov | IoT monitoring, autonómne systémy |

| Nákladová efektívnosť | Vysoká (rozložená na mnoho predikcií) | Stredná (vyžaduje stále bežiacu infraštruktúru) | Stredná až vysoká (závisí od objemu dát) |

| Škálovateľnosť | Výborná (spracovanie vo veľkom) | Dobrá (vyžaduje load balancing) | Výborná (distribuované spracovanie) |

| Priorita optimalizácie modelu | Priepustnosť | Rovnováha latencie a priepustnosti | Rovnováha latencie a presnosti |

| Hardvérové požiadavky | Štandardné GPU/CPU | Výkonné GPU/TPU | Špecializovaný edge hardvér alebo distribuované systémy |

Optimalizácia inferencie sa stala kľúčovou disciplínou, keďže organizácie sa snažia nasadzovať AI modely efektívnejšie a s nižšími nákladmi. Kvantizácia je jednou z najúčinnejších optimalizačných techník, ktorá znižuje číselnú presnosť váh modelu z bežných 32-bitových hodnot s pohyblivou rádovou čiarkou na 8-bitové alebo dokonca 4-bitové celé čísla. Toto zníženie môže zmenšiť veľkosť modelu o 75-90 % pri zachovaní 95-99 % pôvodnej presnosti, čo vedie k rýchlejšej inferencii a nižším pamäťovým nárokom. Prerezávanie modelu odstraňuje nekritické neuróny, spojenia alebo celé vrstvy z neurónovej siete, čím eliminuje redundantné parametre bez výraznej straty presnosti. Výskumy ukazujú, že prerezávanie môže znížiť komplexnosť modelu o 50-80 % bez výraznej straty presnosti. Destilácia znalostí trénuje menší, rýchlejší „študentský“ model, aby napodobnil správanie väčšieho, presnejšieho „učiteľského“ modelu, čo umožňuje nasadenie na zariadeniach s obmedzenými zdrojmi pri zachovaní prijateľného výkonu. Optimalizácia dávkového spracovania zoskupuje viacero inferenčných požiadaviek do dávok na maximalizáciu využitia GPU a priepustnosti. Key-value cache ukladá výsledky čiastkových výpočtov, aby sa zabránilo zbytočným opakovaniam výpočtov počas decode fázy inferencie jazykových modelov. Podľa výskumu NVIDIA môže kombinácia viacerých optimalizačných techník priniesť 10-násobné zlepšenie výkonu a zároveň znížiť náklady na infraštruktúru o 60-70 %. Tieto optimalizácie sú nevyhnutné pre škálované nasadzovanie inferencie, najmä pre organizácie, ktoré spracúvajú tisíce súbežných inferenčných požiadaviek.

Hardvérová akcelerácia je základom splnenia požiadaviek na latenciu a priepustnosť moderných inferenčných pracovných záťaží AI. Grafické procesory (GPU) zostávajú najpoužívanejšími akcelerátormi inferencie vďaka svojej architektúre paralelného spracovania, ktorá prirodzene vyhovuje maticovým operáciám dominujúcim v neurónových sieťach. NVIDIA GPU poháňajú väčšinu nasadení inferencie veľkých jazykových modelov na svete so svojimi špecializovanými CUDA jadrami umožňujúcimi masívny paralelizmus. Tensor Processing Units (TPU) vyvinuté spoločnosťou Google sú špeciálne navrhnuté ASIC čipy optimalizované pre neurónové siete, ktoré ponúkajú lepší výkon na watt v porovnaní s univerzálnymi GPU pri určitých záťažiach. Field-Programmable Gate Arrays (FPGA) poskytujú prispôsobiteľný hardvér, ktorý sa dá preprogramovať pre špecifické úlohy inferencie a ponúka flexibilitu pre špecializované aplikácie. Application-Specific Integrated Circuits (ASIC) ako Google TPU alebo Cerebras WSE-3 sú navrhnuté pre konkrétne inferenčné záťaže a poskytujú výnimočný výkon, avšak s obmedzenou flexibilitou. Výber hardvéru závisí od viacerých faktorov: architektúra modelu, požadovaná latencia, priepustnosť, energetické limity a celkové náklady vlastníctva. Na edge inferenciu na mobilných zariadeniach alebo IoT senzoroch umožňujú špecializované edge akcelerátory a neurónové procesorové jednotky (NPU) efektívnu inferenciu s minimálnou spotrebou energie. Globálny posun smerom k AI fabrikám—vysoko optimalizovanej infraštruktúre na „výrobu“ inteligencie vo veľkom—spôsobil masívne investície do inferenčného hardvéru, pričom podniky nasadzujú tisícky GPU a TPU v dátových centrách, aby uspokojili rastúci dopyt po AI službách.

Generatívne AI systémy ako ChatGPT, Claude a Perplexity sú úplne závislé od inferencie pri generovaní ľudsky pôsobiaceho textu, kódu, obrázkov a ďalšieho obsahu. Keď odošlete prompt týmto systémom, inferenčný proces začína tokenizáciou vášho vstupu na číselné reprezentácie, ktoré môže neurónová sieť spracovať. Model následne vykonáva fázu prefill, v ktorej spracuje všetky vaše vstupné tokeny naraz, aby si vytvoril komplexné porozumenie vašej požiadavky vrátane kontextu, zámeru a nuansy. Následne model prechádza do fázy decode, v ktorej generuje výstupné tokeny sekvenčne, predikujúc najpravdepodobnejší ďalší token na základe všetkých predchádzajúcich tokenov a naučených vzorcov z trénovacích dát. Toto generovanie token po tokene vysvetľuje, prečo pri používaní týchto služieb vidíte prúdiaci text v reálnom čase. Inferenčný proces musí vyvažovať rôzne ciele: generovať presné, koherentné a kontextuálne vhodné odpovede pri zachovaní nízkej latencie, aby bol používateľ zapojený. Špekulatívne dekódovanie, pokročilá optimalizačná technika inferencie, umožňuje menšiemu modelu predikovať viacero budúcich tokenov, zatiaľ čo väčší model tieto predikcie overuje, čím sa výrazne znižuje latencia. Rozsah inferencie veľkých jazykových modelov je ohromujúci—ChatGPT od OpenAI spracováva denne milióny inferenčných požiadaviek, pričom každá generuje stovky až tisíce tokenov, čo si vyžaduje masívnu výpočtovú infraštruktúru a sofistikované optimalizačné stratégie na ekonomickú prevádzku.

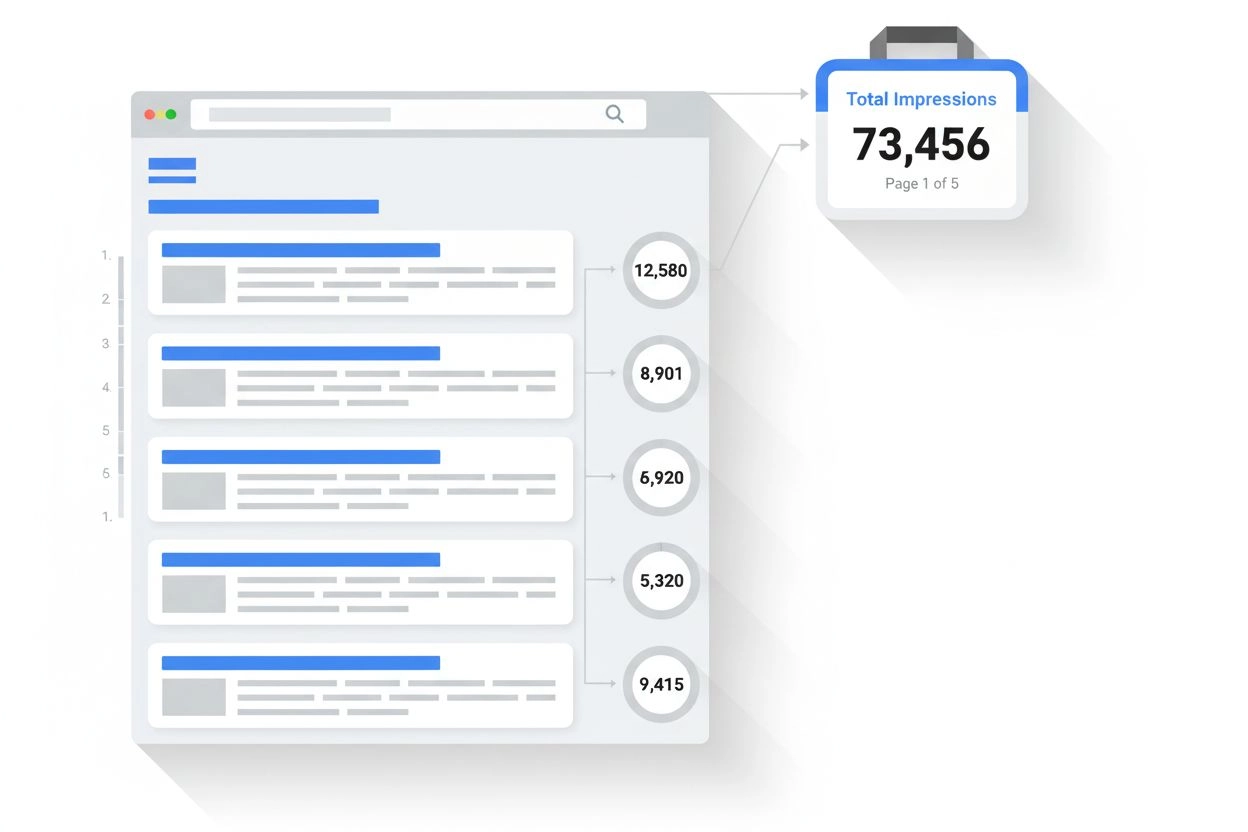

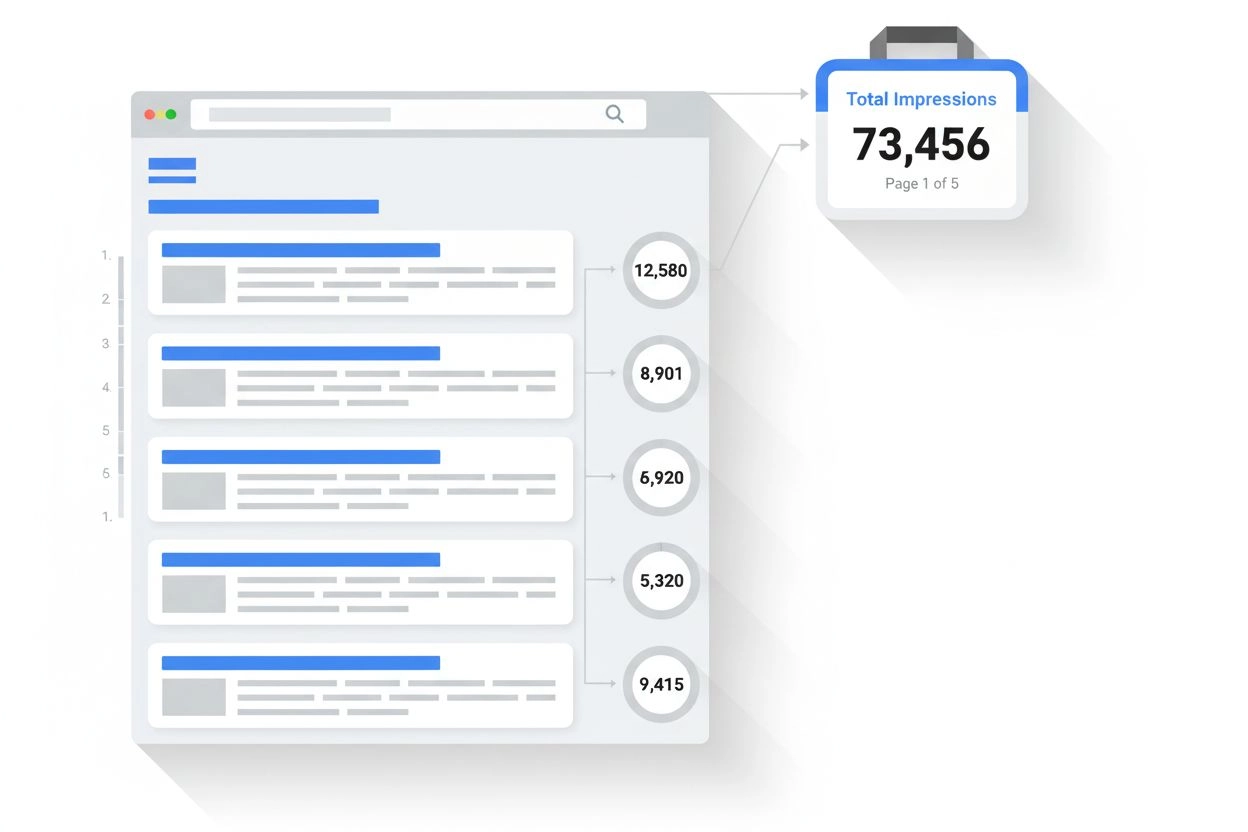

Pre organizácie, ktorým záleží na prítomnosti ich značky a citovaní ich obsahu v AI-generovaných odpovediach, sa monitorovanie inferencie stáva čoraz dôležitejším. Keď systémy ako Perplexity, Google AI Overviews alebo Claude generujú odpovede, vykonávajú inferenciu na svojich trénovaných modeloch s cieľom vytvárať výstupy, ktoré môžu odkazovať alebo citovať vašu doménu, značku či obsah. Pochopenie toho, ako inferenčné systémy fungujú, pomáha organizáciám optimalizovať obsahovú stratégiu na zabezpečenie správnej reprezentácie v AI výstupoch. AmICited sa špecializuje na monitorovanie výskytu značiek a domén vo výstupoch inferencie AI naprieč viacerými platformami, čím poskytuje prehľad o tom, ako AI systémy citujú a odkazujú na váš obsah. Toto monitorovanie je kľúčové, pretože inferenčné systémy môžu generovať odpovede, ktoré vašu značku zahrnú alebo vynechajú na základe kvality trénovacích dát, signálov relevantnosti a optimalizačných rozhodnutí modelu. Organizácie môžu využívať údaje z monitorovania inferencie na pochopenie toho, ktorý obsah je citovaný, ako často sa ich značka objavuje v AI odpovediach a či je ich doména správne pripisovaná. Táto inteligencia umožňuje dátovo podložené rozhodnutia o optimalizácii obsahu, SEO stratégii a pozíciovaní značky v novom AI-poháňanom vyhľadávacom prostredí. Keďže inferencia sa stáva hlavným rozhraním, cez ktoré používatelia objavujú informácie, sledovanie vašej prítomnosti vo výstupoch AI je rovnako dôležité ako tradičná optimalizácia pre vyhľadávače.

Nasadzovanie inferenčných systémov vo veľkom prináša množstvo technických, prevádzkových a strategických výziev, ktoré musia organizácie riešiť. Riadenie latencie ostáva neustálou výzvou, pretože používatelia očakávajú subsekundové odpovede od interaktívnych AI aplikácií, zatiaľ čo komplexné modely s miliardami parametrov vyžadujú značný výpočtový čas. Optimalizácia priepustnosti je rovnako kritická—organizácie musia obsluhovať tisíce až milióny súbežných inferenčných požiadaviek pri zachovaní akceptovateľnej latencie a presnosti. Drift modelu nastáva, keď sa výkon inferencie časom zhoršuje v dôsledku posunu reálnych dát oproti trénovacím údajom, čo si vyžaduje nepretržité monitorovanie a pravidelný retréning modelu. Interpretovateľnosť a vysvetliteľnosť naberajú na význame, keďže inferenčné systémy AI robia rozhodnutia ovplyvňujúce používateľov, a organizácie musia rozumieť, ako modely dochádzajú ku konkrétnym predikciám. Regulačná zhoda predstavuje rastúcu výzvu, pričom nariadenia ako EU AI Act ukladajú požiadavky na transparentnosť, detekciu zaujatosti a ľudský dohľad v AI inferenčných systémoch. Kvalita dát ostáva základom—výstupy inferencie môžu byť len také dobré, aké sú trénovacie údaje, pričom nekvalitné dáta vedú k zaujatým, nepresným alebo škodlivým výsledkom. Náklady na infraštruktúru môžu byť značné, keďže veľkorozsiahle nasadenia inferencie vyžadujú veľké investície do GPU, TPU, sietí a chladenia. Nedostatok odborníkov znamená, že organizácie ťažko hľadajú inžinierov a dátových vedcov so skúsenosťami s optimalizáciou inferencie, nasadzovaním modelov a MLOps, čo zvyšuje náklady na zamestnancov a predlžuje čas nasadenia.

Budúcnosť AI inferencie sa rýchlo vyvíja v niekoľkých transformačných smeroch, ktoré zmenia spôsob nasadzovania a využívania AI systémov. Edge inferencia—spúšťanie inferencie na lokálnych zariadeniach namiesto cloudových dátových centier—nabieha na obrátkach vďaka pokrokom v kompresii modelov, špecializovanému edge hardvéru a požiadavkám na súkromie. Tento posun umožní AI v reálnom čase na smartfónoch, IoT zariadeniach a autonómnych systémoch bez závislosti od cloudového pripojenia. Multimodálna inferencia, kde modely spracúvajú a generujú text, obrázky, zvuk aj video súčasne, je čoraz bežnejšia a vyžaduje nové optimalizačné stratégie a hardvérové riešenia. Objavujú sa modely uvažovania, ktoré vykonávajú viacstupňové inferencie na riešenie komplexných úloh, pričom systémy ako OpenAI o1 ukazujú, že inferencia sa dá škálovať aj zvýšením výpočtového času a počtu tokenov, nielen veľkosťou modelu. Disaggregované serverové architektúry získavajú na popularite, keď samostatné hardvérové clustre obsluhujú prefill a decode fázy inferencie, čo optimalizuje využitie zdrojov pre odlišné výpočtové vzory. Špekulatívne dekódovanie a ďalšie pokročilé inferenčné techniky sa stávajú štandardom, umožňujúc 2-3-násobné zníženie latencie. Edge inferencia v kombinácii s federatívnym učením umožní organizáciám nasadzovať AI lokálne pri zachovaní súkromia a znížení nárokov na prenos dát. Trh s AI inferenciou by mal rásť CAGR 19,2 % do roku 2030, poháňaný rastúcim prijatím v podnikoch, novými prípadmi použitia a ekonomickým tlakom na optimalizáciu nákladov inferencie. Keďže inferencia sa stáva dominantnou záťažou AI infraštruktúry, optimalizačné techniky, špecializovaný hardvér a softvérové rámce špecifické pre inferenciu budú čoraz sofistikovanejšie a kľúčové pre konkurenčnú výhodu.

AI tréning je proces, pri ktorom sa model učí rozpoznávať vzorce pomocou veľkých dátových súborov, zatiaľ čo AI inferencia je, keď tento trénovaný model aplikuje, čo sa naučil, na generovanie predikcií alebo výstupov na nových dátach. Tréning je výpočtovo náročný a prebieha raz, zatiaľ čo inferencia je zvyčajne rýchlejšia, menej zdrojovo náročná a prebieha nepretržite v produkčných prostrediach. Tréning si predstavte ako štúdium na skúšku a inferenciu ako samotné absolvovanie skúšky.

Latencia inferencie—čas, ktorý model potrebuje na vygenerovanie výstupu—je kľúčová pre používateľskú skúsenosť a aplikácie v reálnom čase. Nízka latencia umožňuje okamžité reakcie v chatbot-och, preklade v reálnom čase, autonómnych vozidlách a systémoch detekcie podvodov. Vysoká latencia môže spôsobiť, že aplikácie budú pre časovo citlivé úlohy nepoužiteľné. Podniky optimalizujú latenciu pomocou techník, ako sú kvantizácia, prerezávanie modelu a špecializovaný hardvér ako GPU a TPU, aby splnili servisné úrovne.

Tri hlavné typy sú batch inferencia (spracovanie veľkých dátových súborov offline), online inferencia (generovanie predikcií okamžite na požiadanie) a streaming inferencia (nepretržité spracovanie dát zo senzorov alebo IoT zariadení). Batch inferencia je vhodná pre scenáre ako denné analytické dashboardy, online inferencia poháňa chatboty a vyhľadávače a streaming inferencia umožňuje systémy monitorovania v reálnom čase. Každý typ má odlišné požiadavky na latenciu a použitie.

Kvantizácia znižuje číselnú presnosť váh modelu z 32-bitov na 8-bitov alebo menej, čím výrazne znižuje veľkosť modelu a výpočtové požiadavky pri zachovaní presnosti. Prerezávanie odstraňuje nekritické neuróny alebo spojenia z neurónovej siete, čím znižuje komplexnosť. Obe techniky môžu znížiť latenciu inferencie o 50-80 % a znížiť hardvérové náklady. Tieto optimalizačné metódy sú nevyhnutné pre nasadenie modelov na edge zariadeniach a mobilných platformách.

Inferencia je základným mechanizmom, ktorý umožňuje generatívnym AI systémom produkovať text, obrázky a kód. Keď zadáte požiadavku do ChatGPT, inferenčný proces tokenizuje váš vstup, spracuje ho cez vrstvy trénovanej neurónovej siete a generuje výstupné tokeny jeden po druhom. Fáza prefill spracuje všetky vstupné tokeny naraz, zatiaľ čo fáza decode generuje výstup sekvenčne. Táto schopnosť inferencie je to, čo robí veľké jazykové modely pohotovými a praktickými pre reálne aplikácie.

Monitorovanie inferencie sleduje, ako AI modely fungujú v produkcii, vrátane presnosti, latencie a kvality výstupov. Platformy ako AmICited monitorujú, kde sa značky a domény objavujú v AI-generovaných odpovediach v systémoch ako ChatGPT, Perplexity a Google AI Overviews. Pochopenie správania inferencie pomáha organizáciám zabezpečiť, že ich obsah je správne citovaný a reprezentovaný, keď AI systémy generujú výstupy, ktoré odkazujú na ich domény alebo značky.

Bežné akcelerátory inferencie zahŕňajú GPU (grafické procesory) na paralelné spracovanie, TPU (Tensor Processing Units) optimalizované pre neurónové siete, FPGA (Field-Programmable Gate Arrays) na prispôsobiteľné úlohy a ASIC (Application-Specific Integrated Circuits) navrhnuté pre špecifické úlohy. GPU sa využívajú najviac vďaka pomeru výkonu a ceny, zatiaľ čo TPU vynikajú pri veľkorozsiahlej inferencii. Výber závisí od požiadaviek na priepustnosť, latenciu a rozpočet.

Globálny trh s AI inferenciou mal hodnotu 106,15 miliardy USD v roku 2025 a predpokladá sa, že do roku 2030 dosiahne 254,98 miliardy USD, čo predstavuje zloženú ročnú mieru rastu (CAGR) 19,2 %. Tento rýchly rast odzrkadľuje rastúce prijatie AI v podnikoch, pričom v roku 2024 AI využívalo 78 % organizácií, oproti 55 % v roku 2023. Expanzia je poháňaná dopytom po AI aplikáciách v reálnom čase naprieč sektormi ako zdravotníctvo, financie, maloobchod a autonómne systémy.

Začnite sledovať, ako AI chatboty spomínajú vašu značku na ChatGPT, Perplexity a ďalších platformách. Získajte použiteľné poznatky na zlepšenie vašej prítomnosti v AI.

Zistite, čo je impresia vo výsledkoch vyhľadávania a AI monitoringu. Pochopte, ako sa impresie počítajú v Google Search, Perplexity, ChatGPT a na ďalších platfo...

Zistite, ako jasné definície zvyšujú viditeľnosť v AI vyhľadávaní, zlepšujú sémantické porozumenie a pomáhajú vášmu obsahu dosiahnuť lepšie umiestnenie v AI Ove...

Zistite, ako strategická injekcia štatistík zlepšuje AI citácie. Objavte, prečo AI systémy uprednostňujú obsah podporený dátami a ako efektívne implementovať št...

Súhlas s cookies

Používame cookies na vylepšenie vášho prehliadania a analýzu našej návštevnosti. See our privacy policy.