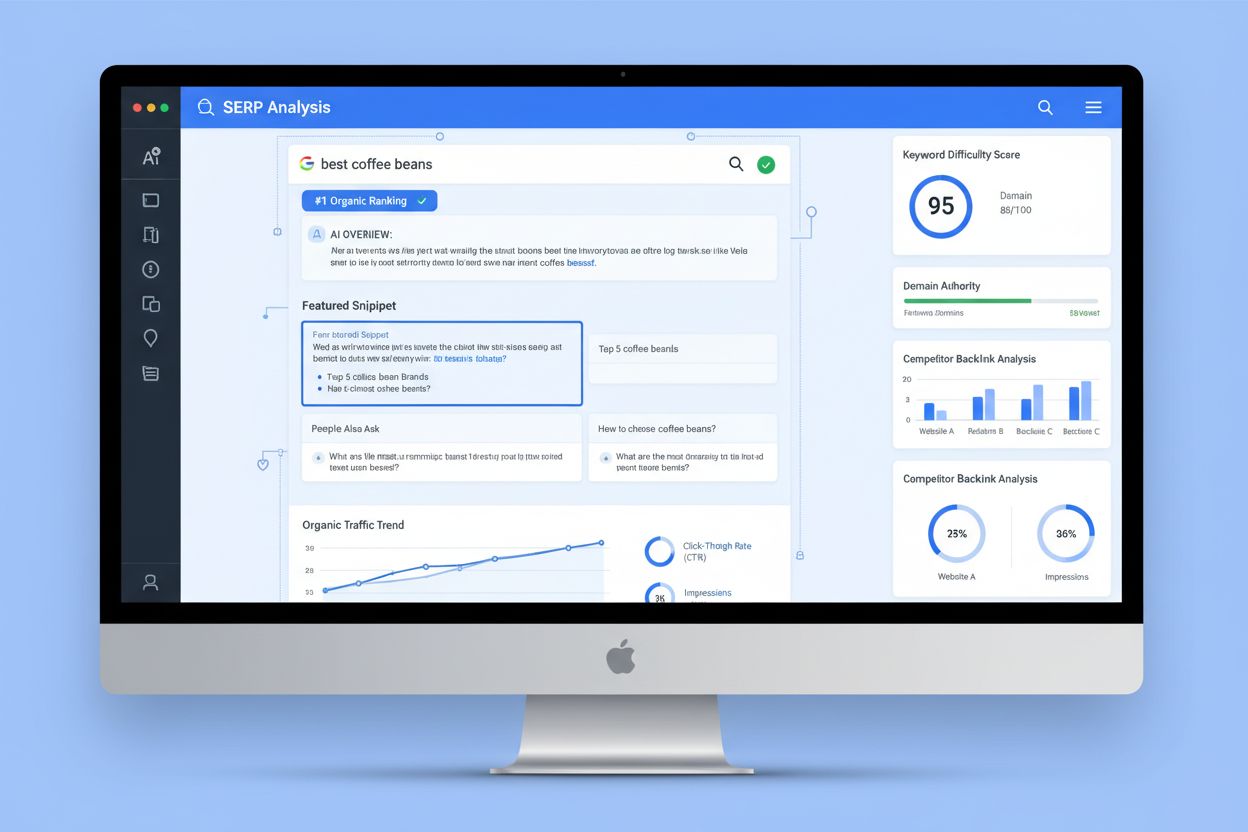

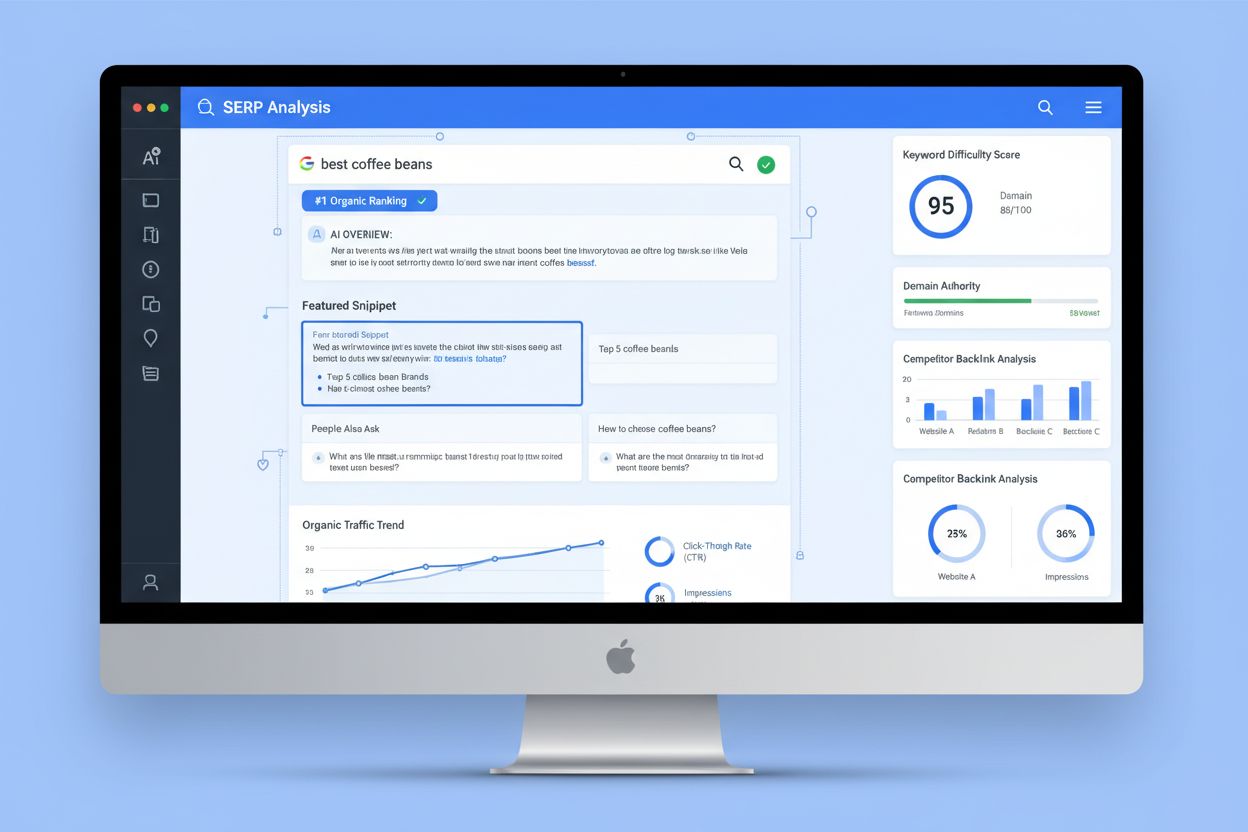

Analýza SERP

Analýza SERP je proces skúmania stránok s výsledkami vyhľadávania s cieľom pochopiť náročnosť získania pozícií, vyhľadávací zámer a stratégie konkurencie. Naučt...

Analýza log súborov je proces skúmania prístupových logov servera s cieľom pochopiť, ako prehľadávače vyhľadávačov a AI boty interagujú s webovou stránkou, čo odhaľuje vzory prehľadávania, technické problémy a možnosti optimalizácie pre SEO výkonnosť.

Analýza log súborov je proces skúmania prístupových logov servera s cieľom pochopiť, ako prehľadávače vyhľadávačov a AI boty interagujú s webovou stránkou, čo odhaľuje vzory prehľadávania, technické problémy a možnosti optimalizácie pre SEO výkonnosť.

Analýza log súborov je systematické skúmanie prístupových logov servera s cieľom pochopiť, ako prehľadávače vyhľadávačov, AI boty a používatelia interagujú s webovou stránkou. Tieto logy sú automaticky generované web servermi a obsahujú podrobné záznamy o každej HTTP požiadavke smerovanej na vašu stránku, vrátane IP adresy žiadateľa, časovej pečiatky, požadovaného URL, HTTP status kódu a user-agent reťazca. Pre SEO špecialistov predstavuje analýza log súborov definitívny zdroj pravdy o správaní prehľadávačov, odhaľujúc vzory, ktoré povrchové nástroje ako Google Search Console alebo tradičné prehľadávače nedokážu zachytiť. Na rozdiel od simulovaných crawlov či agregovaných analytických údajov poskytujú serverové logy nefiltrované, prvostranové dôkazy o tom, čo presne vyhľadávače a AI systémy na vašom webe v reálnom čase robia.

Význam analýzy log súborov exponenciálne rastie s vývojom digitálneho prostredia. Viac ako 51 % globálnej internetovej prevádzky dnes generujú boty (ACS, 2025) a AI prehľadávače ako GPTBot, ClaudeBot či PerplexityBot sú pravidelnými návštevníkmi webov, takže pochopenie správania prehľadávačov už nie je voliteľné—je nevyhnutné pre zachovanie viditeľnosti v tradičnom aj novom AI-poháňanom vyhľadávaní. Analýza log súborov preklenuje priepasť medzi tým, čo si myslíte, že sa na vašom webe deje, a tým, čo sa skutočne deje, čím umožňuje rozhodnutia založené na dátach, ktoré priamo ovplyvňujú pozície vo vyhľadávačoch, rýchlosť indexácie a celkový organický výkon.

Analýza log súborov je základom technického SEO už desaťročia, no jej význam v posledných rokoch dramaticky vzrástol. Historicky sa SEO špecialisti spoliehali najmä na Google Search Console a nástroje tretích strán na pochopenie správania vyhľadávačov. Tieto nástroje však majú významné obmedzenia: Google Search Console poskytuje len agregované, vzorkované dáta z Google robotov; tretie strany simulujú správanie robotov namiesto zachytenia skutočných interakcií; a ani jeden nástroj účinne nesleduje ne-Google vyhľadávače či AI boty.

Vzostup AI-poháňaných vyhľadávacích platforiem zásadne zmenil situáciu. Podľa výskumu Cloudflare z roku 2024 Googlebot tvorí 39 % všetkej AI a vyhľadávacej bot prevádzky, zatiaľ čo AI špecifické prehľadávače predstavujú najrýchlejšie rastúci segment. Samotné Meta AI boty generujú 52 % AI bot prevádzky, čo je viac ako dvojnásobok Google (23 %) či OpenAI (20 %). Tento posun znamená, že webstránky dnes navštevujú desiatky rôznych typov botov, z ktorých mnohé nedodržiavajú tradičné SEO protokoly alebo nerešpektujú pravidlá robots.txt. Analýza log súborov je jedinou metódou, ktorá tento úplný obraz zachytáva, a preto je nenahraditeľná pre modernú SEO stratégiu.

Globálny trh s log manažmentom sa podľa prognóz zvýši z 3 228,5 milióna USD v roku 2025 na výrazne vyššie hodnoty do roku 2029, s ročným rastom (CAGR) 14,6 %. Tento rast odráža rastúce uznanie zo strany firiem, že analýza logov je kľúčová pre bezpečnosť, monitoring výkonu aj SEO optimalizáciu. Organizácie masívne investujú do automatizovaných nástrojov na analýzu logov a AI-poháňaných platforiem, ktoré dokážu spracovať milióny log záznamov v reálnom čase a premieňať surové dáta na akcieschopné poznatky, ktoré podporujú obchodné výsledky.

Keď užívateľ alebo bot žiada stránku na vašom webe, web server túto požiadavku spracuje a zaznamená podrobné informácie o interakcii. Tento proces prebieha automaticky a nepretržite, čím vzniká komplexná auditná stopa všetkej serverovej aktivity. Porozumieť tomuto procesu je kľúčové pre správnu interpretáciu dát z log súborov.

Typický priebeh začína, keď prehľadávač (či už Googlebot, AI bot alebo prehliadač užívateľa) odošle HTTP GET požiadavku na váš server, pričom zahrnie user-agent reťazec identifikujúci žiadateľa. Server prijme požiadavku, spracuje ju a vráti HTTP status kód (200 pre úspech, 404 pre nenájdené, 301 pre trvalé presmerovanie atď.) spolu s požadovaným obsahom. Každá z týchto interakcií sa zaznamenáva do prístupového log súboru servera, čím vzniká časovo označený záznam obsahujúci IP adresu, požadované URL, HTTP metódu, status kód, veľkosť odpovede, referer a user-agent reťazec.

HTTP status kódy sú obzvlášť dôležité pre SEO analýzu. Kód 200 znamená úspešné doručenie stránky; 3xx kódy signalizujú presmerovania; 4xx kódy označujú klientské chyby (napr. 404 Nenájdené); 5xx kódy signalizujú chyby servera. Analýzou rozloženia týchto kódov v logoch môžete identifikovať technické problémy, ktoré bránia prehľadávačom v prístupe k obsahu. Ak napríklad prehľadávač opakovane dostáva 404 odpovede pri pokuse o prístup na dôležité stránky, signalizuje to problém s nefunkčnými odkazmi alebo chýbajúcim obsahom, ktorý si vyžaduje okamžitú pozornosť.

User-agent reťazce sú rovnako kľúčové na identifikáciu, ktoré boty navštevujú váš web. Každý prehľadávač má unikátny user-agent reťazec. User-agent Googlebotu obsahuje “Googlebot/2.1”, GPTBot obsahuje “GPTBot/1.0” a ClaudeBot obsahuje “ClaudeBot”. Parsovaním týchto reťazcov môžete segmentovať log dáta a analyzovať správanie podľa typu prehľadávača, čo odhalí, ktoré boty uprednostňujú aký obsah a ako sa ich vzory prehľadávania líšia. Táto detailná analýza umožňuje cielené optimalizačné stratégie pre rôzne vyhľadávacie platformy a AI systémy.

| Aspekt | Analýza log súborov | Google Search Console | Prehľadávače tretích strán | Analytické nástroje |

|---|---|---|---|---|

| Zdroj dát | Serverové logy (prvostranové) | Dáta z prehľadávania Google | Simulované prehľadávania | Sledovanie správania užívateľov |

| Kompletnosť | 100 % všetkých požiadaviek | Vzorkované, agregované dáta | Len simulované | Len ľudská prevádzka |

| Pokrytie botov | Všetky prehľadávače (Google, Bing, AI boty) | Len Google | Simulované prehľadávače | Žiadne dáta o botech |

| Historické dáta | Plná história (podľa retencie) | Obmedzené obdobie | Jednorazový snapshot | História dostupná |

| Poznatky v reálnom čase | Áno (s automatizáciou) | Opoždnené reporty | Nie | Opoždnené reporty |

| Viditeľnosť crawl budgetu | Presné vzory prehľadávania | Vysoká úroveň súhrnu | Odhadované | Nepoužiteľné |

| Technické problémy | Detailné (status kódy, časy odpovede) | Obmedzená viditeľnosť | Simulované problémy | Nepoužiteľné |

| Sledovanie AI botov | Áno (GPTBot, ClaudeBot, atď.) | Nie | Nie | Nie |

| Cena | Zadarmo (serverové logy) | Zadarmo | Platené nástroje | Zadarmo/Platené |

| Náročnosť nastavenia | Stredná až vysoká | Jednoduché | Jednoduché | Jednoduché |

Analýza log súborov je dnes nepostrádateľná pre pochopenie, ako vyhľadávače a AI systémy interagujú s vašou webstránkou. Na rozdiel od Google Search Console, ktorá poskytuje len pohľad Google a agregované dáta, logy zachytávajú kompletný obraz všetkej aktivity prehľadávačov. Tento celistvý pohľad je nevyhnutný na identifikáciu plytvania crawl budgetom, keď vyhľadávače míňajú zdroje na prehľadávanie málo hodnotných stránok namiesto dôležitého obsahu. Výskumy ukazujú, že veľké weby často minú 30–50 % crawl budgetu na neesenciálne URL ako stránkované archívy, filtrovanú navigáciu alebo zastaraný obsah.

Vzostup AI-poháňaného vyhľadávania urobil analýzu log súborov ešte dôležitejšou. Ako AI boty ako GPTBot, ClaudeBot a PerplexityBot pravidelne navštevujú weby, pochopenie ich správania je kľúčové pre optimalizáciu viditeľnosti v AI-generovaných odpovediach. Tieto boty sa často správajú inak ako tradičné prehľadávače—môžu ignorovať pravidlá robots.txt, prehľadávať agresívnejšie alebo sa zameriavať na špecifické typy obsahu. Analýza log súborov je jedinou metódou, ktorá tieto vzory odhalí, čím vám umožní optimalizovať stránku pre AI objavenie a zároveň riadiť prístup botov cez cielené pravidlá.

Technické SEO problémy, ktoré by inak zostali neodhalené, možno identifikovať práve cez analýzu logov. Reťazce presmerovaní, 5xx chyby servera, pomalé načítania stránok či problémy s renderovaním JavaScriptu všetky zanechávajú stopy v serverových logoch. Analýzou týchto vzorov môžete stanoviť priority opráv, ktoré priamo ovplyvňujú prístupnosť pre vyhľadávače a rýchlosť indexácie. Ak napríklad logy ukazujú, že Googlebot opakovane dostáva 503 Service Unavailable chyby pri prehľadávaní určitej sekcie, viete presne, kam zamerať svoje technické úsilie.

Získanie serverových logov je prvým krokom analýzy, no postup sa líši podľa hostingu. Pre vlastné servery s Apache alebo NGINX sú logy zvyčajne uložené v /var/log/apache2/access.log alebo /var/log/nginx/access.log. K týmto súborom sa dostanete cez SSH alebo správcu súborov servera. Pre managed WordPress hostingy ako WP Engine či Kinsta môžu byť logy dostupné cez hostingový dashboard alebo SFTP, hoci niektorí poskytovatelia prístup obmedzujú na ochranu výkonu servera.

Content Delivery Networky (CDN) ako Cloudflare, AWS CloudFront a Akamai vyžadujú špeciálne nastavenie na prístup k logom. Cloudflare ponúka Logpush, ktorý odosiela HTTP logy do vybraných úložísk (AWS S3, Google Cloud Storage, Azure Blob Storage) na ďalšie spracovanie a analýzu. AWS CloudFront poskytuje štandardné logovanie, ktoré možno nastaviť na ukladanie logov do S3 bucketov. Tieto CDN logy sú nevyhnutné na pochopenie, ako boty interagujú s vaším webom pri doručovaní obsahu cez CDN, keďže zachytávajú požiadavky na hrane, nie na pôvodnom serveri.

Zdieľané hostingy často poskytujú obmedzený prístup k logom. Poskytovatelia ako Bluehost a GoDaddy môžu ponúknuť čiastočné logy cez cPanel, no tieto sa často rotujú a môžu chýbať dôležité polia. Ak ste na zdieľanom hostingu a potrebujete kompletnú analýzu logov, zvážte prechod na VPS alebo managed hosting s plným prístupom k logom.

Po získaní logov je nevyhnutná príprava dát. Surové log súbory obsahujú požiadavky od všetkých zdrojov—používateľov, botov, scraperov aj škodlivých aktérov. Pre SEO analýzu je potrebné odfiltrovať nerelevantnú prevádzku a sústrediť sa na aktivitu vyhľadávačov a AI botov. Typicky to zahŕňa:

Analýza log súborov odhaľuje poznatky, ktoré sú pre iné SEO nástroje neviditeľné, a poskytuje základ pre strategické rozhodnutia. Jedným z najhodnotnejších je analýza vzorov prehľadávania, ktorá presne ukazuje, ktoré stránky vyhľadávače navštevujú a ako často. Sledovaním frekvencie prehľadávania v čase môžete zistiť, či Google zvyšuje alebo znižuje pozornosť voči konkrétnym častiam webu. Náhle poklesy môžu signalizovať technické problémy alebo zmenu v dôležitosti stránky, zatiaľ čo nárasty naznačujú pozitívnu reakciu na optimalizáciu.

Efektivita crawl budgetu je ďalší kľúčový poznatok. Analýzou pomeru úspešných (2xx) a chybových odpovedí (4xx, 5xx) zistíte, kde prehľadávače narážajú na problémy. Ak napríklad konkrétny adresár permanentne vracia 404 chyby, plytvá sa crawl budgetom na nefunkčné adresy. Podobne, ak prehľadávače trávia neúmerne veľa času na stránkovaných URL alebo filtrovaných navigáciách, míňate budget na nízko hodnotný obsah. Log analýza toto plytvanie kvantifikuje a umožní vám vyčísliť dopad optimalizačných zásahov.

Odhaľovanie osirelých stránok je unikátnou výhodou analýzy log súborov. Osirelé stránky sú URL bez interných odkazov, ktoré existujú mimo štruktúry webu. Tradičné prehľadávače ich často nenájdu, pretože ich cez interné linky neobjavia. Logy však ukazujú, že ich vyhľadávače aj tak prehľadávajú—často vďaka externým odkazom alebo starým sitemapám. Identifikáciou týchto stránok môžete rozhodnúť, či ich znovu začleniť do štruktúry webu, presmerovať alebo úplne odstrániť.

Analýza správania AI botov je čoraz dôležitejšia. Segmentáciou logov podľa user-agent AI botov vidíte, aký obsah uprednostňujú, ako často navštevujú váš web a či narážajú na technické bariéry. Ak napríklad GPTBot často prehľadáva FAQ stránky, ale len zriedka blog, znamená to, že AI systémy považujú FAQ obsah za hodnotnejší pre trénovanie. Tento poznatok môže ovplyvniť vašu obsahovú stratégiu a pomôcť optimalizovať pre AI viditeľnosť.

Úspešná analýza log súborov vyžaduje správne nástroje aj strategický prístup. Log File Analyzer od Screaming Frog patrí medzi najpopulárnejšie špecializované nástroje, ponúka pohodlné rozhranie na spracovanie veľkých log súborov, identifikáciu vzorov botov a vizualizáciu crawl dát. Botify poskytuje enterprise analýzu logov integrovanú s SEO metrikami, čo umožňuje prepájať aktivitu botov s pozíciami a návštevnosťou. Bot Clarity od seoClarity integruje analýzu logov priamo do SEO platformy, takže môžete jednoducho prepájať crawl dáta s ďalšími SEO ukazovateľmi.

Pre organizácie s vysokou návštevnosťou alebo zložitou infraštruktúrou ponúkajú AI-poháňané platformy ako Splunk, Sumo Logic a Elastic Stack pokročilé možnosti ako automatizované rozpoznávanie vzorov, detekciu anomálií a prediktívnu analytiku. Tieto platformy spracujú milióny záznamov v reálnom čase, automaticky identifikujú nové typy botov a signalizujú nezvyčajnú aktivitu, ktorá môže znamenať bezpečnostné riziká alebo technické problémy.

Najlepšie postupy pre analýzu log súborov zahŕňajú:

S rastúcim významom AI-poháňaného vyhľadávania sa monitoring AI botov prostredníctvom analýzy log súborov stal kľúčovou SEO funkciou. Sledovaním, ktoré AI boty navštevujú váš web, aký obsah pristupujú a ako často prehľadávajú, pochopíte, ako váš obsah vstupuje do AI vyhľadávačov a generatívnych AI modelov. Tieto dáta vám umožnia rozhodnúť, či konkrétne AI boty povoliť, blokovať alebo obmedziť cez robots.txt alebo HTTP hlavičky.

Optimalizácia crawl budgetu je azda najvýznamnejšou aplikáciou analýzy log súborov. Pri veľkých weboch s tisíckami či miliónmi stránok je crawl budget obmedzený zdroj. Analýzou logov identifikujete stránky, ktoré sú prehľadávané neúmerne často vzhľadom na ich význam, a tie, ktoré by mali byť prehľadávané častejšie, ale nie sú. Bežné scenáre plytvania crawl budgetom zahŕňajú:

Riešením týchto problémov—cez pravidlá robots.txt, kanonické značky, noindex tagy či technické úpravy—presmerujete crawl budget na hodnotný obsah, čím zlepšíte rýchlosť indexácie a viditeľnosť stránok, na ktorých vám najviac záleží.

Budúcnosť analýzy log súborov formuje rýchly rozvoj AI-poháňaného vyhľadávania. Ako do ekosystému pribúdajú nové AI boty a ich správanie sa stáva sofistikovanejším, analýza logov bude ešte kľúčovejšia pre pochopenie, ako je váš obsah objavovaný, pristupovaný a využívaný AI systémami. Medzi nové trendy patria:

Analýza logov v reálnom čase poháňaná machine learningom umožní SEO špecialistom detegovať a riešiť crawl problémy v priebehu minút namiesto dní. Automatizované systémy budú identifikovať nové typy botov, signalizovať neobvyklé vzory a navrhovať optimalizačné kroky bez manuálneho zásahu. Tento posun od reaktívnej k proaktívnej analýze umožní SEO špecialistom udržať optimálnu prehľadávateľnosť a indexáciu neustále.

Integrácia s monitoringom AI viditeľnosti prepojí log dáta s výkonnostnými metrikami v AI vyhľadávaní. Namiesto izolovanej analýzy logov budú SEO špecialisti prepájať správanie botov s reálnou viditeľnosťou v AI-generovaných odpovediach, čím presne zistia, ako vzory prehľadávania ovplyvňujú poradie vo vyhľadávaní AI. Táto integrácia prinesie bezprecedentný vhľad do toho, ako obsah putuje od crawl po tréning AI až po odpovede pre používateľov.

Etické riadenie botov bude čoraz dôležitejšie, keď sa firmy budú rozhodovať, ktorým AI botom umožniť prístup k obsahu. Analýza logov umožní detailnú kontrolu prístupu, takže vydavatelia môžu povoliť len prospešné AI prehľadávače a blokovať tie, ktoré neprinášajú hodnotu alebo atribúciu. Štandardy ako vznikajúci LLMs.txt protokol poskytnú štruktúrovaný spôsob komunikácie pravidiel pre boty a analýza logov overí ich dodržiavanie.

Analýza s dôrazom na súkromie sa bude rozvíjať, aby vyvážila potrebu podrobných crawl poznatkov s nariadeniami ako GDPR. Pokročilé anonymizačné techniky a nástroje orientované na ochranu súkromia umožnia firmám získavať cenné poznatky bez uchovávania alebo zverejňovania osobných údajov. To bude obzvlášť dôležité, ako sa analýza logov stane bežnejšou a regulácie ochrany dát prísnejšie.

Konvergencia tradičného SEO a optimalizácie pre AI vyhľadávanie znamená, že analýza log súborov zostane základom technickej SEO stratégie aj v nasledujúcich rokoch. Firmy, ktoré zvládnu analýzu logov dnes, budú najlepšie pripravené udržať si viditeľnosť a výkon, ako sa vyh

Analýza log súborov poskytuje kompletné, nevzorkované dáta zo servera, zachytávajúce každú požiadavku od všetkých prehľadávačov, zatiaľ čo štatistiky prehľadávania v Google Search Console zobrazujú len agregované, vzorkované dáta od Google prehľadávačov. Log súbory ponúkajú detailné historické údaje a poznatky o správaní ne-Google botov, vrátane AI prehľadávačov ako GPTBot a ClaudeBot, vďaka čomu sú komplexnejším zdrojom pre pochopenie skutočného správania prehľadávačov a identifikovanie technických problémov, ktoré GSC môže prehliadnuť.

Pre stránky s vysokou návštevnosťou sa odporúča týždenná analýza log súborov, aby ste včas zachytili problémy a monitorovali zmeny vo vzoroch prehľadávania. Menším stránkam prospievajú mesačné prehľady na sledovanie trendov a identifikáciu nových botov. Bez ohľadu na veľkosť stránky pomáha zavedenie kontinuálneho monitoringu cez automatizované nástroje detegovať anomálie v reálnom čase, čo zaručí rýchlu reakciu na plytvanie crawl budgetom alebo technické problémy ovplyvňujúce viditeľnosť vo vyhľadávačoch.

Áno, analýza log súborov je jedným z najefektívnejších spôsobov sledovania AI botov. Skúmaním user-agent reťazcov a IP adries v serverových logoch môžete zistiť, ktoré AI boty navštevujú vašu stránku, aký obsah pristupujú a ako často prehľadávajú. Tieto údaje sú kľúčové na pochopenie, ako sa váš obsah dostáva do AI vyhľadávačov a generatívnych AI modelov, čo vám umožní optimalizovať viditeľnosť v AI a riadiť prístup botov cez pravidlá v robots.txt.

Analýza log súborov odhaľuje množstvo technických SEO problémov vrátane chýb pri prehľadávaní (4xx a 5xx kódy), reťazcov presmerovaní, pomalých načítaní stránok, osirelých stránok bez interných odkazov, plytvania crawl budgetom na nízko hodnotných URL, problémov s renderovaním JavaScriptu a duplicity obsahu. Identifikuje tiež falošnú bot aktivitu a pomáha odhaliť, keď majú legitímne prehľadávače problémy s prístupnosťou, čo vám umožní stanoviť priority opráv ovplyvňujúcich viditeľnosť a indexáciu vo vyhľadávačoch.

Analýza log súborov presne ukazuje, ktoré stránky vyhľadávače prehľadávajú a ako často, čím odhaľuje, kde sa plytvá crawl budgetom na nízko hodnotný obsah ako stránkované archívy, filtrovanú navigáciu alebo zastarané URL. Identifikovaním týchto neefektívností môžete upraviť robots.txt, zlepšiť interné prelinkovanie na prioritné stránky a implementovať kanonické tagy, aby ste presmerovali pozornosť prehľadávačov na hodnotný obsah, čím zabezpečíte, že vyhľadávače sa sústredia na stránky najdôležitejšie pre vaše podnikanie.

Serverové logy zvyčajne zaznamenávajú IP adresy (identifikujúce zdroj požiadavky), časové pečiatky (kedy požiadavky nastali), HTTP metódy (zvyčajne GET alebo POST), požadované URL (konkrétne navštívené stránky), HTTP status kódy (200, 404, 301 atď.), veľkosti odpovede v bajtoch, informácie o refereri a user-agent reťazce (identifikujúce prehľadávač alebo prehliadač). Tieto komplexné dáta umožňujú SEO špecialistom presne rekonštruovať, čo sa udialo počas každej serverovej interakcie a identifikovať vzory ovplyvňujúce prehľadávateľnosť a indexáciu.

Falošné boty sa vydávajú za legitímne prehľadávače, ale ich IP adresy nezodpovedajú oficiálnym rozsahom IP vyhľadávačov. Na ich identifikáciu porovnajte user-agent reťazce (napr. 'Googlebot') s oficiálnymi IP rozsahmi zverejnenými Google, Bing a ďalšími vyhľadávačmi. Nástroje ako Log File Analyzer od Screaming Frog automaticky overujú pravosť botov. Falošné boty plytvajú crawl budgetom a môžu zaťažovať váš server, preto sa odporúča ich blokovať cez robots.txt alebo firewall pravidlá.

Začnite sledovať, ako AI chatboty spomínajú vašu značku na ChatGPT, Perplexity a ďalších platformách. Získajte použiteľné poznatky na zlepšenie vašej prítomnosti v AI.

Analýza SERP je proces skúmania stránok s výsledkami vyhľadávania s cieľom pochopiť náročnosť získania pozícií, vyhľadávací zámer a stratégie konkurencie. Naučt...

Zistite, čo je správa o vyhľadávacích dopytoch, ako sleduje skutočné vyhľadávacie výrazy a prečo je nevyhnutná pre pochopenie zámeru používateľov, optimalizáciu...

Zistite, čo je analytika AI prehliadania a ako analýza serverových logov sleduje správanie AI crawlerov, vzorce prístupu k obsahu a viditeľnosť vo vyhľadávacích...

Súhlas s cookies

Používame cookies na vylepšenie vášho prehliadania a analýzu našej návštevnosti. See our privacy policy.