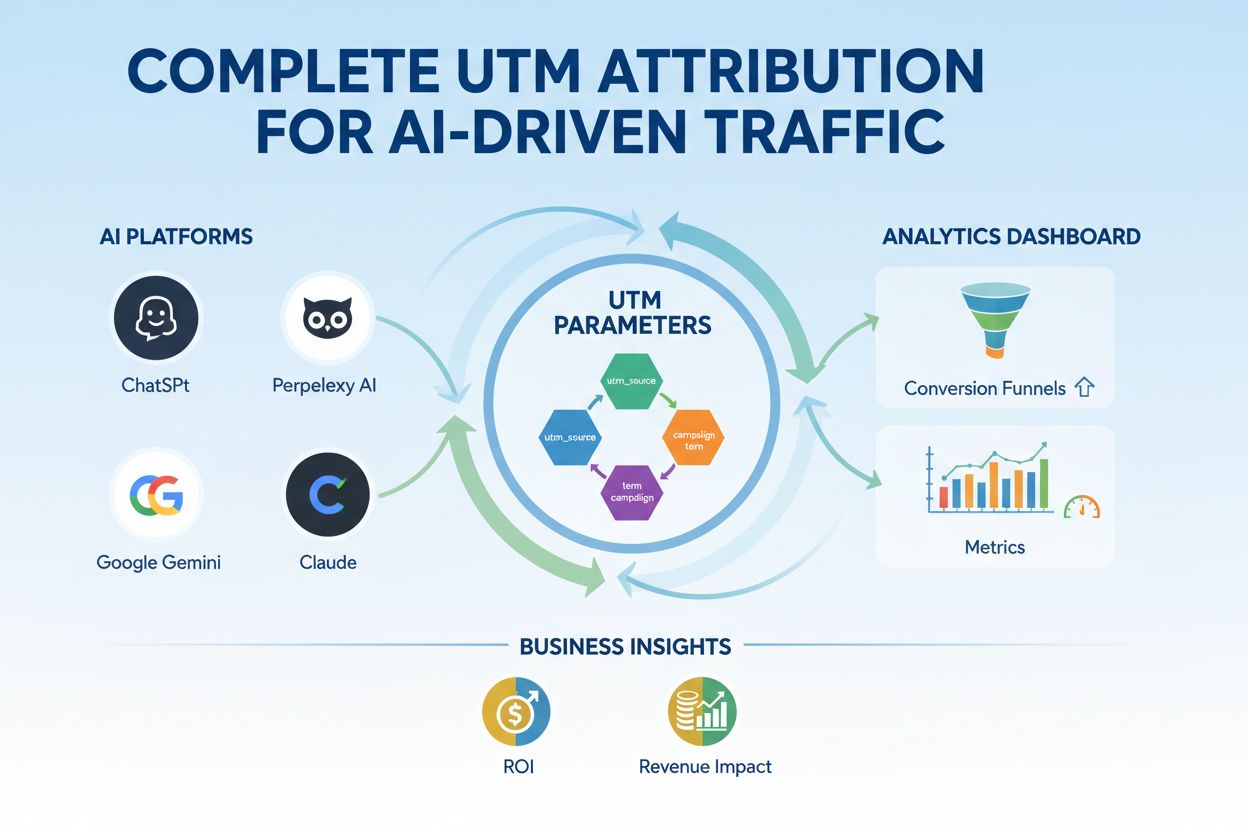

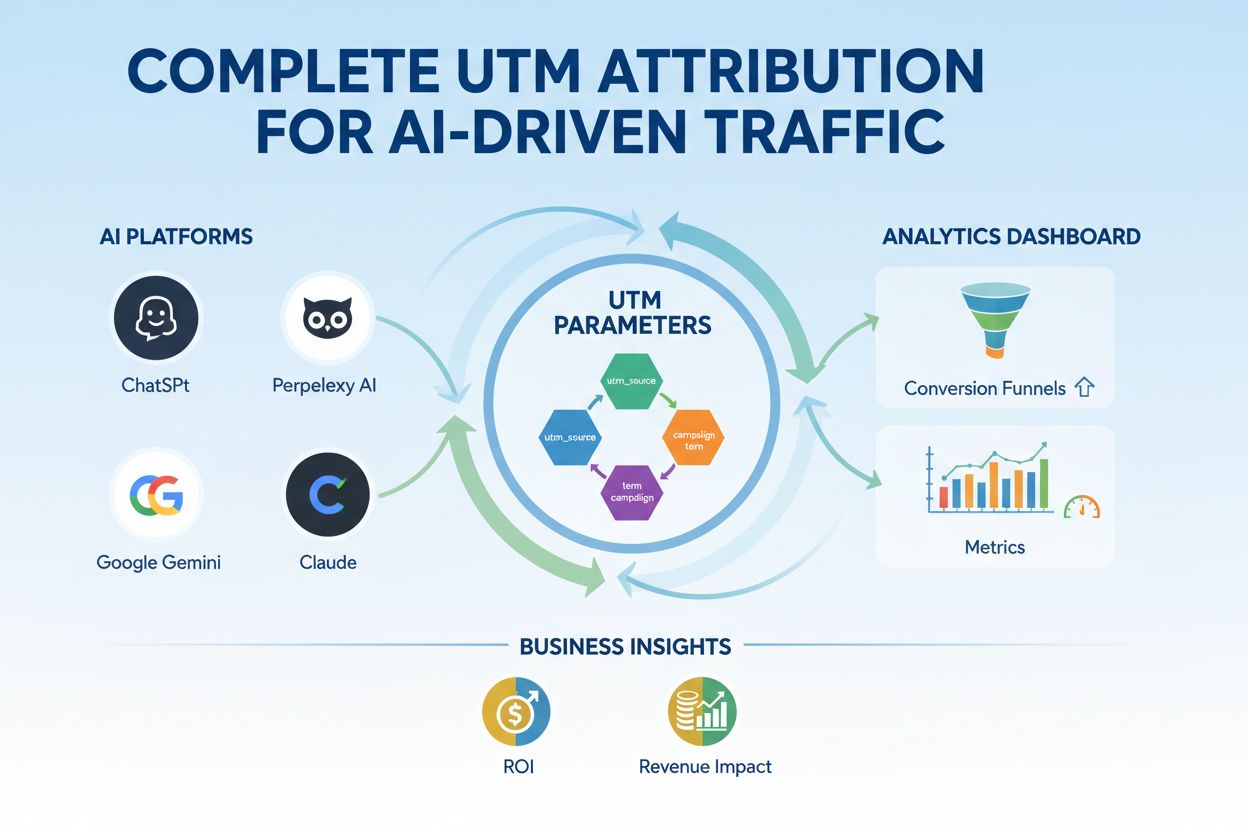

UTM parametre pre AI-riadenú návštevnosť

Zvládnite UTM sledovanie pre AI platformy ako ChatGPT, Perplexity a Google Gemini. Naučte sa nastavenie, najlepšie postupy a ako presne priradiť AI návštevnosť ...

Parametre modelu sú naučiteľné premenné v rámci AI modelov, ako sú váhy a biasy, ktoré sa automaticky upravujú počas trénovania s cieľom optimalizovať schopnosť modelu robiť presné predikcie a určujú, ako model spracováva vstupné dáta na generovanie výstupov.

Parametre modelu sú naučiteľné premenné v rámci AI modelov, ako sú váhy a biasy, ktoré sa automaticky upravujú počas trénovania s cieľom optimalizovať schopnosť modelu robiť presné predikcie a určujú, ako model spracováva vstupné dáta na generovanie výstupov.

Parametre modelu sú naučiteľné premenné v rámci modelov umelej inteligencie, ktoré sa automaticky upravujú počas procesu trénovania s cieľom optimalizovať schopnosť modelu robiť presné predikcie a určujú, ako model spracováva vstupné dáta na generovanie výstupov. Tieto parametre slúžia ako základné „ovládacie gombíky“ systémov strojového učenia, ktoré určujú presné správanie a vzory rozhodovania AI modelov. V kontexte hlbokého učenia a neurónových sietí sa parametre skladajú najmä z vách a biasov—číselných hodnôt, ktoré riadia, ako informácia prechádza sieťou a ako silno rôzne črty ovplyvňujú predikcie. Cieľom trénovania je objaviť optimálne hodnoty týchto parametrov, ktoré minimalizujú chyby predikcií a umožnia modelu dobre generalizovať na nové, neznáme dáta. Pochopenie parametrov modelu je zásadné pre porozumenie fungovania moderných AI systémov ako ChatGPT, Claude, Perplexity a Google AI Overviews a pre pochopenie, prečo produkujú odlišné výstupy na rovnaký vstup.

Koncept naučiteľných parametrov v strojovom učení siaha do raných čias umelých neurónových sietí v 50. a 60. rokoch 20. storočia, keď vedci prvýkrát rozpoznali, že siete môžu upravovať vnútorné hodnoty a učiť sa z dát. Praktické využitie parametrov však ostalo obmedzené až do nástupu spätného šírenia v 80. rokoch, ktoré poskytlo efektívny algoritmus na výpočet, ako parametre upravovať na zníženie chýb. Explózia počtu parametrov sa dramaticky zrýchlila s nástupom hlbokého učenia v 10. rokoch 21. storočia. Prvé konvolučné neurónové siete na rozpoznávanie obrázkov obsahovali milióny parametrov, zatiaľ čo moderné veľké jazykové modely (LLM) obsahujú stovky miliárd alebo dokonca bilióny parametrov. Podľa výskumov Our World in Data a Epoch AI počet parametrov v významných AI systémoch exponenciálne rastie: GPT-3 má 175 miliárd parametrov, GPT-4o približne 200 miliárd parametrov, pričom niektoré odhady naznačujú, že GPT-4 môže obsahovať až 1,8 bilióna parametrov pri započítaní architektúr typu mixture-of-experts. Tento dramatický nárast zásadne zmenil schopnosti AI systémov a umožnil im zachytávať stále komplexnejšie vzory v jazyku, videní a úlohách vyžadujúcich uvažovanie.

Parametre modelu fungujú na matematickom princípe, kde každý parameter predstavuje číselnú hodnotu ovplyvňujúcu spôsob, akým model transformuje vstupy na výstupy. V jednoduchom lineárnom regresnom modeli tvoria parametre smernica (m) a priesečník (b) v rovnici y = mx + b, kde tieto dve hodnoty určujú priamku najlepšie vystihujúcu dáta. V neurónových sieťach je situácia exponenciálne komplexnejšia. Každý neurón v vrstve prijíma vstupy z predchádzajúcej vrstvy, násobí každý vstup príslušnou váhovou hodnotou, sčíta tieto vážené vstupy, pripočíta bias a výsledok preženie aktivačnou funkciou na výstup. Tento výstup sa stáva vstupom pre neuróny v ďalšej vrstve, čím vzniká kaskádový reťazec transformácií riadených parametrami. Počas trénovania model používa gradientný zostup a príbuzné optimalizačné algoritmy na výpočet, ako má každý parameter upraviť, aby znížil stratovú funkciu—matematickú mieru chyby predikcie. Gradient straty voči každému parametru ukazuje smer a veľkosť potrebnej úpravy. Prostredníctvom spätného šírenia tieto gradienty prechádzajú naspäť sieťou, čo optimalizátoru umožňuje aktualizovať všetky parametre súčasne koordinovaným spôsobom. Tento iteratívny proces pokračuje cez viacero epoch trénovania, až kým sa parametre nezbiehajú k hodnotám, ktoré minimalizujú stratu na trénovacích dátach a zároveň zabezpečujú dobrú generalizáciu na nové dáta.

| Aspekt | Parametre modelu | Hyperparametre | Črty (features) |

|---|---|---|---|

| Definícia | Naučiteľné premenné upravované počas trénovania | Nastavenia konfigurácie dané pred trénovaním | Vlastnosti vstupných dát používané modelom |

| Kedy sa nastavujú | Automaticky učené optimalizáciou | Manuálne nastavované odborníkmi | Extrahované alebo vytvorené z pôvodných dát |

| Príklady | Váhy, biasy v neurónových sieťach | Rýchlosť učenia, batch size, počet vrstiev | Hodnoty pixelov v obrazoch, embeddingy slov v texte |

| Vplyv na model | Určujú mapovanie vstupov na výstupy | Kontrolujú proces trénovania a štruktúru modelu | Poskytujú surové informácie, z ktorých sa model učí |

| Optimalizačná metóda | Gradientný zostup, Adam, AdaGrad | Grid search, náhodné hľadanie, Bayesovská optimalizácia | Feature engineering, výber čŕt |

| Počet vo veľkých modeloch | Miliardy až bilióny (napr. 200B v GPT-4o) | Typicky 5–20 kľúčových hyperparametrov | Tisíce až milióny podľa dát |

| Výpočtové náklady | Vysoké počas trénovania; ovplyvňujú rýchlosť inferencie | Minimálne náklady na nastavenie | Určené zberom a predspracovaním dát |

| Prenositeľnosť | Dá sa preniesť pomocou dolaďovania a transferu učenia | Musia sa znova nastaviť pre nové úlohy | Môžu vyžadovať nové spracovanie pre nové domény |

Parametre modelu majú rôzne podoby v závislosti od architektúry a typu použitého strojového učenia. V konvolučných neurónových sieťach (CNN) používaných na rozpoznávanie obrázkov patria medzi parametre váhy v konvolučných filtroch (nazývané aj jadrá), ktoré detegujú priestorové vzory ako hrany, textúry a tvary v rôznych mierkach. Rekurentné neurónové siete (RNN) a long short-term memory (LSTM) siete obsahujú parametre, ktoré riadia tok informácií v čase, vrátane parametrov brán určujúcich, aké informácie si pamätať alebo zabudnúť. Transformátorové modely, ktoré poháňajú moderné veľké jazykové modely, obsahujú parametre vo viacerých komponentoch: váhy pozornosti, ktoré určujú, na ktoré časti vstupu sa sústrediť, váhy feed-forward sietí a parametre normalizácie vrstiev. V pravdepodobnostných modeloch ako Naivný Bayes parametre definujú podmienené pravdepodobnostné rozdelenia. Support vector machines používajú parametre na určenie polohy a orientácie rozhodovacích hraníc v priestore čŕt. Mixture of Experts (MoE) modely, použité v niektorých verziách GPT-4, obsahujú parametre pre viacero špecializovaných podsietí plus parametre smerovania, ktoré určujú, ktorý expert spracuje daný vstup. Táto architektonická rozmanitosť znamená, že povaha a počet parametrov sa medzi modelmi výrazne líši, no základný princíp ostáva rovnaký: parametre sú naučené hodnoty umožňujúce modelu vykonávať jeho úlohu.

Váhy a biasy predstavujú dva základné typy parametrov v neurónových sieťach a tvoria základ toho, ako sa tieto modely učia. Váhy sú číselné hodnoty priradené spojeniam medzi neurónmi a určujú silu a smer vplyvu výstupu jedného neurónu na vstup druhého neurónu. Vo vrstve s 1 000 vstupnými a 500 výstupnými neurónmi by bolo 500 000 váhových parametrov—jeden pre každé spojenie. Počas trénovania sa váhy upravujú tak, aby zvýšili alebo znížili vplyv konkrétnych čŕt na predikcie. Veľká kladná váha znamená, že črta silno aktivuje ďalší neurón, záporná váha ho inhibuje. Biasy sú ďalšie parametre, jeden na neurón vo vrstve, ktoré poskytujú konštantný posun k súčtu vstupov neurónu pred aplikovaním aktivačnej funkcie. Matematicky, ak neurón dostane vážené vstupy, ktorých súčet je nula, bias umožňuje produkovať nenulový výstup, čím poskytuje dôležitú flexibilitu. Táto flexibilita umožňuje neurónovým sieťam učiť sa komplexné rozhodovacie hranice a zachytávať vzory, ktoré by s váhami samotnými neboli možné. V modeli s 200 miliardami parametrov ako GPT-4o tvorí väčšinu váh v pozornostných mechanizmoch a feed-forward sieťach, pričom biasy predstavujú menšiu, no stále významnú časť. Spolu umožňujú váhy a biasy modelu naučiť sa prepracované vzory v jazyku, videní či iných oblastiach, čo robí moderné AI systémy takými výkonnými.

Počet parametrov v modeli má zásadný vplyv na jeho schopnosť učiť sa komplexné vzory aj na celkový výkon. Výskum opakovane ukazuje, že škálovacie zákony opisujú vzťah medzi počtom parametrov, veľkosťou trénovacích dát a výkonom modelu. Modely s väčším počtom parametrov dokážu reprezentovať komplexnejšie funkcie a zachytávať jemnejšie vzory v dátach, čo zvyčajne vedie k lepšiemu výkonu v náročných úlohách. GPT-3 so 175 miliardami parametrov predviedol pozoruhodné schopnosti few-shot učenia, ktoré menšie modely nemali. GPT-4o s 200 miliardami parametrov ukazuje ďalšie zlepšenia v uvažovaní, generovaní kódu a multimodálnom porozumení. Vzťah medzi parametrami a výkonom však nie je lineárny a kriticky závisí od množstva a kvality trénovacích dát. Model s príliš veľa parametrami vzhľadom na dáta sa preučí, zapamätá si konkrétne príklady namiesto učenia generalizovaných vzorov a dosiahne slabý výkon na nových dátach. Naopak, model s príliš málo parametrami môže podučiť a nezachytiť dôležité vzory, čo vedie k podpriemernému výkonu aj na trénovacích dátach. Optimálny počet parametrov závisí od zložitosti úlohy, veľkosti a rôznorodosti trénovacej sady, ako aj od výpočtových obmedzení. Výskum Epoch AI ukazuje, že moderné AI systémy dosiahli výnimočný výkon práve masívnym škálovaním, pričom niektoré modely obsahujú bilióny parametrov, najmä v architektúrach mixture-of-experts, kde nie všetky parametre sú aktívne pri každom vstupe.

Aj keď veľké modely s miliardami parametrov dosahujú pôsobivý výkon, výpočtové náklady na ich trénovanie a nasadenie sú značné. To podnietilo výskum efektívneho dolaďovania parametrov, ktoré umožňuje prispôsobiť predtrénované modely novým úlohám bez nutnosti aktualizovať všetky parametre. LoRA (Low-Rank Adaptation) je významná technika, ktorá zamrazí väčšinu predtrénovaných parametrov a trénuje len malú sadu ďalších nízkorozmerných matíc, čím znižuje počet trénovaných parametrov o niekoľko rádov pri zachovaní výkonu. Napríklad dolaďovanie 7-miliardového modelu pomocou LoRA zahŕňa trénovanie len 1–2 miliónov dodatočných parametrov namiesto všetkých 7 miliárd. Adapter moduly vkladajú malé trénovateľné siete medzi vrstvy zmrazeného predtrénovaného modelu, čo pridáva len malé percento parametrov pri umožnení špecifickej adaptácie. Inžinierstvo promptov a učenie v kontexte sú alternatívne prístupy, ktoré nemenia parametre vôbec, ale využívajú existujúce parametre modelu efektívnejšie prostredníctvom starostlivo vytvorených vstupov. Tieto efektívne prístupy demokratizovali prístup k veľkým jazykovým modelom a umožnili organizáciám s obmedzenými výpočtovými zdrojmi prispôsobiť špičkové modely svojim špecifickým potrebám. Rovnováha medzi efektivitou parametrov a výkonom ostáva aktívnou oblasťou výskumu, pričom odborníci vyvažujú výpočtovú efektivitu s požiadavkami na presnosť pri konkrétnych úlohách.

Pochopenie parametrov modelu je kľúčové pre platformy ako AmICited, ktoré sledujú, ako sa značky a domény objavujú v AI-generovaných odpovediach v systémoch ako ChatGPT, Perplexity, Claude či Google AI Overviews. Rôzne AI modely s odlišnými konfiguráciami parametrov produkujú odlišné výstupy na tú istú otázku, čo ovplyvňuje, kde a ako sú značky spomenuté. 200 miliárd parametrov v GPT-4o je nakonfigurovaných inak než parametre v Claude 3.5 Sonnet alebo modeloch Perplexity, čo vedie k variáciám v generovaní odpovedí. Parametre naučené počas trénovania na rôznych datasetoch a s rôznymi cieľmi trénovania spôsobujú, že modely majú rozdielne znalosti, vzorce uvažovania a citačné správanie. Pri monitorovaní zmienok značky v AI odpovediach pomáha pochopenie, že tieto rozdiely vyplývajú z rozdielov v parametroch, vysvetliť, prečo môže byť značka výrazne spomenutá v odpovedi jedného AI systému, no len okrajovo v inom. Parametre riadiace mechanizmy pozornosti určujú, ktoré časti trénovacích dát modelu sú najrelevantnejšie pre otázku, čo ovplyvňuje citačné vzory. Parametre vo vrstvách generujúcich výstup určujú, ako model štruktúruje a prezentuje informácie. Sledovaním, ako rôzne AI systémy s rôznou konfiguráciou parametrov spomínajú značky, poskytuje AmICited prehľad o tom, ako parametrami riadené správanie modelu ovplyvňuje viditeľnosť značky v AI vyhľadávacom prostredí.

Budúcnosť parametrov modelu ovplyvňuje viacero konvergujúcich trendov, ktoré zásadne menia návrh a nasadzovanie AI systémov. Architektúry Mixture of Experts (MoE) predstavujú významný posun, keď modely obsahujú viacero špecializovaných podsietí (expertov) s vlastnými parametrami a mechanizmus smerovania určuje, ktorý expert spracuje daný vstup. Tento prístup umožňuje modelom škálovať na bilióny parametrov pri zachovaní výpočtovej efektivity počas inferencie, keďže nie všetky parametre sú aktívne pri každom vstupe. GPT-4 údajne využíva MoE architektúru so 16 expertmi, pričom každý obsahuje 110 miliárd parametrov, spolu 1,8 bilióna, no pri inferencii sa používa len časť z nich. Vyvíjajú sa riedke parametre a prerezávacie techniky na identifikáciu a odstránenie menej dôležitých parametrov, čím sa znižuje veľkosť modelu bez straty výkonu. Prístupy kontinuálneho učenia sa zameriavajú na efektívnu aktualizáciu parametrov s príchodom nových dát, čo umožňuje modelom adaptovať sa bez úplného pretrénovania. Federované učenie rozkladá trénovanie parametrov na viaceré zariadenia pri zachovaní súkromia, takže organizácie môžu využívať veľké trénovacie celky bez centralizácie citlivých údajov. Objavenie sa malých jazykových modelov (SLM) s miliardami namiesto stoviek miliárd parametrov naznačuje budúcnosť, kde efektivita parametrov bude rovnako dôležitá ako ich počet. Ako sa AI systémy stávajú súčasťou kritických aplikácií, pochopenie a kontrola parametrov modelu bude čoraz dôležitejšia pre bezpečnosť, férovosť a súlad s ľudskými hodnotami. Vzťah medzi počtom parametrov a správaním modelu ostane ústrednou témou AI výskumu s dôsledkami od výpočtovej udržateľnosti až po interpretovateľnosť a dôveryhodnosť AI systémov.

Parametre modelu sú vnútorné premenné učené počas trénovania prostredníctvom optimalizačných algoritmov ako je gradientný zostup, zatiaľ čo hyperparametre sú vonkajšie nastavenia konfigurované pred začiatkom trénovania. Parametre určujú, ako model mapuje vstupy na výstupy, kým hyperparametre riadia samotný proces trénovania, ako je rýchlosť učenia a počet epoch. Napríklad váhy a biasy v neurónových sieťach sú parametre, zatiaľ čo rýchlosť učenia je hyperparameter.

Moderné veľké jazykové modely obsahujú miliardy až bilióny parametrov. GPT-4o obsahuje približne 200 miliárd parametrov, kým GPT-4o-mini má asi 8 miliárd parametrov. Claude 3.5 Sonnet tiež pracuje so stovkami miliárd parametrov. Tieto obrovské počty parametrov umožňujú týmto modelom zachytávať komplexné vzory v jazyku a generovať sofistikované, kontextovo relevantné odpovede naprieč rôznymi témami.

Viac parametrov zvyšuje kapacitu modelu učiť sa komplexné vzory a vzťahy v dátach. S ďalšími parametrami môžu modely reprezentovať jemnejšie črty a interakcie, čo vedie k vyššej presnosti na trénovacích dátach. Existuje však kritická rovnováha: príliš veľa parametrov vzhľadom na trénovacie dáta môže viesť k preučeniu, keď si model zapamätá šum namiesto učenia všeobecných vzorov, čo spôsobuje slabý výkon na nových, neznámych dátach.

Parametre modelu sa aktualizujú pomocou spätného šírenia a optimalizačných algoritmov, ako je gradientný zostup. Počas trénovania model vytvára predikcie, vypočíta stratu (chybu) medzi predikciami a skutočnými hodnotami a potom vypočíta gradienty, ktoré ukazujú, ako každý parameter prispel k tejto chybe. Optimalizátor potom upraví parametre v smere, ktorý znižuje stratu, pričom tento proces opakuje cez viacero trénovacích iterácií, až kým model nekonverguje k optimálnym hodnotám.

Váhy určujú silu spojení medzi neurónmi v neurónových sieťach, teda ovládajú, ako silno vstupné črty ovplyvňujú výstupy. Biasy fungujú ako prahové nastavovače, umožňujú neurónom aktivovať sa aj vtedy, keď vážené vstupy sú nulové, čím poskytujú flexibilitu a umožňujú modelu naučiť sa bazálne vzory. Spolu tvoria váhy a biasy základné naučiteľné parametre, ktoré umožňujú neurónovým sieťam aproximovať komplexné funkcie a robiť presné predikcie.

Parametre modelu priamo ovplyvňujú, ako AI systémy ako ChatGPT, Perplexity a Claude spracovávajú a reagujú na otázky. Pochopenie počtu a konfigurácie parametrov pomáha vysvetliť, prečo rôzne AI modely produkujú odlišné výstupy na rovnakú výzvu. Pre platformy na monitoring značky ako AmICited je sledovanie toho, ako parametre ovplyvňujú správanie modelu, kľúčové na predpovedanie, kde sa značky objavia v AI odpovediach a pochopenie konzistencie naprieč rôznymi AI systémami.

Áno, pomocou transferového učenia sa parametre z predtrénovaného modelu môžu prispôsobiť na nové úlohy. Tento prístup, nazývaný doladiťovanie (fine-tuning), zahŕňa prevzatie modelu s naučenými parametrami a ich úpravu na nových dátach pre špecifické aplikácie. Metódy efektívneho dolaďovania parametrov ako LoRA (Low-Rank Adaptation) umožňujú selektívnu aktualizáciu parametrov, čím znižujú výpočtové náklady pri zachovaní výkonu. Táto technika je široko používaná na prispôsobenie veľkých jazykových modelov pre špecializované domény.

Parametre modelu priamo ovplyvňujú výpočtové požiadavky počas trénovania aj inferencie. Viac parametrov vyžaduje viac pamäte, výpočtového výkonu a času na trénovanie a nasadenie. Model so 175 miliardami parametrov (ako GPT-3) vyžaduje výrazne viac výpočtových zdrojov než model so 7 miliardami parametrov. Tento vzťah je kľúčový pre organizácie nasadzujúce AI systémy, keďže počet parametrov ovplyvňuje náklady na infraštruktúru, latenciu a spotrebu energie v produkčnom prostredí.

Začnite sledovať, ako AI chatboty spomínajú vašu značku na ChatGPT, Perplexity a ďalších platformách. Získajte použiteľné poznatky na zlepšenie vašej prítomnosti v AI.

Zvládnite UTM sledovanie pre AI platformy ako ChatGPT, Perplexity a Google Gemini. Naučte sa nastavenie, najlepšie postupy a ako presne priradiť AI návštevnosť ...

Zistite viac o modeloch atribúcie viditeľnosti AI – rámcoch, ktoré využívajú strojové učenie na priradenie zásluh marketingovým kontaktným bodom v zákazníckych ...

Zistite, ako AI modely spracúvajú text prostredníctvom tokenizácie, embeddingov, transformačných blokov a neurónových sietí. Pochopte kompletný proces od vstupu...

Súhlas s cookies

Používame cookies na vylepšenie vášho prehliadania a analýzu našej návštevnosti. See our privacy policy.