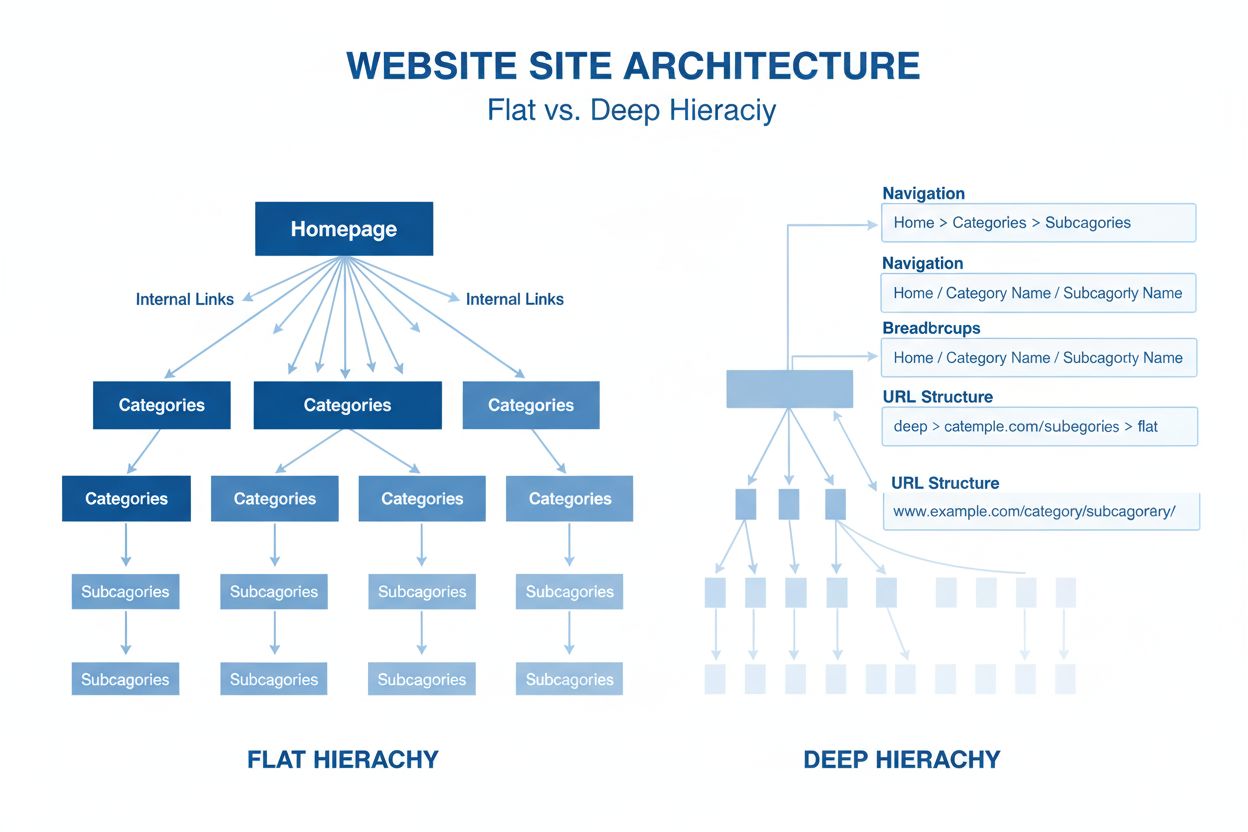

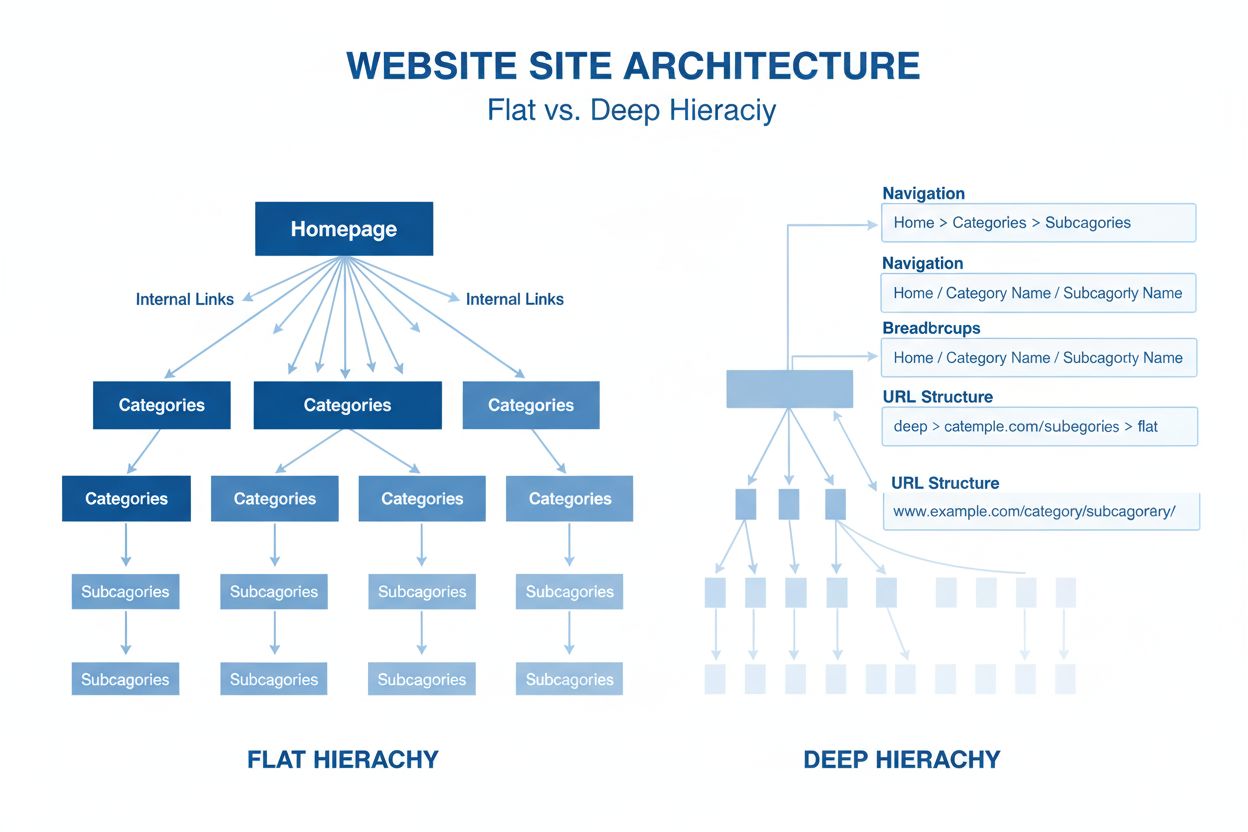

Architektúra webu

Architektúra webu je hierarchická organizácia stránok a obsahu webstránky. Zistite, ako správna štruktúra zlepšuje SEO, používateľský zážitok a viditeľnosť v AI...

Architektúra neurónových sietí založená na mechanizmoch viacnásobnej self-attention, ktorá spracováva sekvenčné dáta paralelne a umožňuje vývoj moderných veľkých jazykových modelov, ako sú ChatGPT, Claude a Perplexity. Zavedené v roku 2017 v článku ‘Attention is All You Need’, transformery sa stali základnou technológiou, ktorá je základom prakticky všetkých špičkových AI systémov.

Architektúra neurónových sietí založená na mechanizmoch viacnásobnej self-attention, ktorá spracováva sekvenčné dáta paralelne a umožňuje vývoj moderných veľkých jazykových modelov, ako sú ChatGPT, Claude a Perplexity. Zavedené v roku 2017 v článku 'Attention is All You Need', transformery sa stali základnou technológiou, ktorá je základom prakticky všetkých špičkových AI systémov.

Architektúra Transformera je revolučný návrh neurónových sietí predstavený v článku “Attention is All You Need” z roku 2017 od výskumníkov spoločnosti Google. Základom je mechanizmus viacnásobnej self-attention, ktorý umožňuje modelom spracovávať celé sekvencie dát paralelne namiesto sekvenčne. Architektúra sa skladá z vrstvených enkóderových a dekóderových vrstiev, z ktorých každá obsahuje self-attention podvrstvy a dopredné neurónové siete, prepojené cez reziduálne spojenia a normalizáciu vrstiev. Architektúra Transformera sa stala základnou technológiou, ktorá je základom prakticky všetkých moderných veľkých jazykových modelov (LLM), vrátane ChatGPT, Claude, Perplexity a Google AI Overviews, čo z nej robí pravdepodobne najdôležitejšiu inováciu v oblasti neurónových sietí za posledné desaťročie.

Význam architektúry Transformera ďaleko presahuje jej technickú eleganciu. Spomínaný článok “Attention is All You Need” z roku 2017 bol citovaný viac ako 208 000-krát, čím sa stal jedným z najvplyvnejších vedeckých článkov v histórii strojového učenia. Táto architektúra zásadne zmenila spôsob, akým AI systémy spracúvajú a chápu jazyk, umožnila vývoj modelov s miliardami parametrov, ktoré dokážu vykonávať sofistikované uvažovanie, kreatívne písanie a riešenie zložitých problémov. Trh podnikových LLM, postavený takmer výlučne na technológii transformerov, bol v roku 2024 ocenený na 6,7 miliardy dolárov a očakáva sa, že bude rásť zloženou ročnou mierou rastu 26,1 % do roku 2034, čo dokazuje kľúčový význam architektúry pre modernú AI infraštruktúru.

Vývoj architektúry Transformera predstavuje zlomový moment v histórii hlbokého učenia a vychádza z desaťročí výskumu neurónových sietí na spracovanie sekvenčných dát. Pred transformermi dominovali úlohám spracovania prirodzeného jazyka rekurentné neurónové siete (RNN) a ich varianty, najmä siete s dlhodobou krátkodobou pamäťou (LSTM). Tieto architektúry však mali zásadné obmedzenia: sekvencie spracovávali sekvenčne, po jednom prvku, čo ich robilo pomalými na tréning a mali problém zachytávať závislosti medzi vzdialenými prvkami v dlhých sekvenciách. Problém miznúcich gradientov ďalej obmedzoval schopnosť RNN učiť sa dlhodobé vzťahy, keďže gradienty sa pri spätnej propagácii cez množstvo vrstiev exponenciálne zmenšovali.

Zavedenie attention mechanizmov v roku 2014 Bahdanauom a kolegami prinieslo prelom, pretože modelom umožnilo sústrediť sa na relevantné časti vstupných sekvencií bez ohľadu na vzdialenosť. Attention však spočiatku slúžila len ako vylepšenie RNN, nie ako ich náhrada. Transformery v článku z roku 2017 tento koncept posunuli ďalej a navrhli, že attention je všetko, čo potrebujete – teda že celá neurónová sieť môže byť postavená len na attention mechanizmoch a dopredných vrstvách, pričom rekurencia je úplne odstránená. Tento postreh bol transformačný. Odstránením sekvenčného spracovania umožnili transformery masívnu paralelizáciu, čo výskumníkom umožnilo trénovať na nevídanom množstve dát pomocou GPU a TPU. Najväčší transformer model v pôvodnom článku, trénovaný na 8 GPU počas 3,5 dňa, ukázal, že rozsah a paralelizácia vedú k dramaticky lepším výsledkom.

Po pôvodnom článku o transformeroch architektúra rýchlo napredovala. BERT (Bidirectional Encoder Representations from Transformers), vydaný Googlom v roku 2019, ukázal, že transformer enkódery sa dajú predtrénovať na obrovských textových korpusoch a doladiť pre rôzne úlohy. Najväčší BERT model mal 345 miliónov parametrov a bol trénovaný na 64 špecializovaných TPU štyri dni za odhadovanú cenu 7 000 dolárov, pričom dosiahol špičkové výsledky v mnohých jazykových benchmarkoch. Zároveň séria OpenAI GPT nasledovala inú cestu a použila čisto dekóderové transformer architektúry trénované na úlohe jazykového modelovania. GPT-2 s 1,5 miliardou parametrov prekvapila komunitu, keď ukázala, že samotné jazykové modelovanie môže viesť k prekvapivo schopným systémom. GPT-3 so 175 miliardami parametrov predviedla emergentné schopnosti – zručnosti, ktoré sa objavili až v dostatočnej škále, vrátane few-shot učenia a komplexného uvažovania – čo zásadne zmenilo očakávania od AI systémov.

Architektúra Transformera pozostáva z niekoľkých navzájom prepojených technických komponentov, ktoré spolu umožňujú efektívne paralelné spracovanie a vyspelé chápanie kontextu. Vstupná embedding vrstva konvertuje diskrétne tokeny (slová alebo subslová) na spojité vektorové reprezentácie, typicky s rozmerom 512 alebo viac. Tieto embeddingy sú následne rozšírené o pozičné kódovanie, ktoré pridáva informáciu o pozícii každého tokenu v sekvencii pomocou sínusových a kosínusových funkcií s rôznymi frekvenciami. Táto pozičná informácia je nevyhnutná, pretože na rozdiel od RNN, ktoré prirodzene uchovávajú poradie vďaka rekurencii, transformery spracovávajú všetky tokeny súčasne a potrebujú explicitné signály na pochopenie poradia a vzdialenosti slov.

Mechanizmus self-attention je architektonickou inováciou, ktorá odlišuje transformery od všetkých predchádzajúcich návrhov neurónových sietí. Pre každý token vo vstupnej sekvencii model vypočíta tri vektory: Query vektor (čo token hľadá), Key vektory (čo každý token obsahuje) a Value vektory (skutočná informácia na prenesenie ďalej). Attention mechanizmus vypočíta skóre podobnosti medzi Query každého tokenu a všetkými Key pomocou skalárneho súčinu, tieto skóre znormalizuje softmaxom na attention váhy medzi 0 a 1 a tieto váhy použije na vytvorenie váženého súčtu Value vektorov. Tento proces umožňuje každému tokenu selektívne sa zamerať na iné relevantné tokeny, vďaka čomu model chápe kontext a vzťahy.

Viacnásobná pozornosť (multi-head attention) rozširuje tento koncept spustením viacerých paralelných attention mechanizmov súčasne, typicky 8, 12 alebo 16 hláv. Každá hlava pracuje s inými lineárne projekciami Query, Key a Value vektorov, čo umožňuje modelu sústrediť sa na rôzne typy vzťahov a vzorcov v odlišných reprezentáciách. Napríklad jedna hlava sa môže zamerať na syntaktické vzťahy medzi slovami, iná na sémantické súvislosti alebo dlhodobé závislosti. Výstupy všetkých hláv sa spoja a lineárne transformujú, vďaka čomu model získava bohaté, mnohovrstevné kontextové informácie. Tento prístup sa ukázal ako mimoriadne efektívny a výskum preukázal, že rôzne hlavy sa špecializujú na rôzne jazykové javy.

Štruktúra enkóder-dekóder organizuje tieto attention mechanizmy do hierarchického spracovateľského potrubia. Enkóder pozostáva z viacerých vrstiev (typicky 6 a viac), z ktorých každá obsahuje podvrstvu viacnásobnej self-attention a doprednú sieť. Reziduálne spojenia okolo každej podvrstvy umožňujú gradientom prúdiť sieťou pri tréningu, čo zlepšuje stabilitu a umožňuje hlbšie architektúry. Normalizácia vrstiev sa aplikuje po každej podvrstve a normalizuje aktivácie, aby sa zachovali konzistentné škály v sieti. Dekóder má podobnú štruktúru, ale obsahuje aj enkóder-dekóder attention vrstvu, ktorá umožňuje dekóderu sústrediť sa na výstupy enkódera a generovať relevantné tokeny. V čisto dekóderových architektúrach ako GPT dekóder generuje výstupné tokeny autoregresívne, pričom každý nový token závisí na všetkých predchádzajúcich.

| Aspekt | Architektúra Transformera | RNN/LSTM | Konvolučné neurónové siete (CNN) |

|---|---|---|---|

| Metóda spracovania | Paralelné spracovanie celých sekvencií pomocou attention | Sekvenčné spracovanie, po jednom prvku | Lokálne konvolučné operácie na oknách pevnej veľkosti |

| Dlhodobé závislosti | Výborné; attention môže priamo spájať vzdialené tokeny | Slabé; obmedzené miznúcimi gradientmi a sekvenčnosťou | Obmedzené; lokálne pole vnímania vyžaduje veľa vrstiev |

| Rýchlosť tréningu | Veľmi rýchla; masívna paralelizácia na GPU/TPU | Pomalá; sekvenčné spracovanie bráni paralelizácii | Rýchla pre pevné vstupy; menej vhodná pre variabilné sekvencie |

| Pamäťové nároky | Vysoké; kvadratické vzhľadom na dĺžku sekvencie kvôli attention | Nižšie; lineárne vzhľadom na dĺžku sekvencie | Stredné; závisí od veľkosti jadra a hĺbky |

| Škálovateľnosť | Výborná; škáluje sa na miliardy parametrov | Obmedzená; ťažké trénovať veľmi veľké modely | Dobrá pre obrazy; menej vhodná pre sekvencie |

| Typické použitia | Jazykové modelovanie, strojový preklad, generovanie textu | Časové rady, sekvenčné predikcie (už menej bežné) | Klasifikácia obrazov, detekcia objektov, počítačové videnie |

| Tok gradientu | Stabilný; reziduálne spojenia umožňujú hlboké siete | Problémový; miznúce/ explodujúce gradienty | Väčšinou stabilný; lokálne spojenia pomáhajú toku gradientu |

| Informácia o pozícii | Vyžaduje explicitné pozičné kódovanie | Implicitne cez sekvenčné spracovanie | Implicitne cez priestorovú štruktúru |

| Špičkové LLM | GPT, Claude, Llama, Granite, Perplexity | Zriedka používané v moderných LLM | Nepoužívané pre jazykové modelovanie |

Vzťah medzi architektúrou Transformera a modernými veľkými jazykovými modelmi je zásadný a neoddeliteľný. Každý významný LLM vydaný za posledných päť rokov – vrátane OpenAI GPT-4, Anthropic Claude, Meta Llama, Google Gemini, IBM Granite a modelov Perplexity AI – je postavený na architektúre transformerov. Schopnosť architektúry efektívne sa škálovať s veľkosťou modelu aj množstvom tréningových dát je kľúčová pre dosiahnutie možností, ktoré definujú moderné AI systémy. Keď výskumníci zväčšovali modely z miliónov na miliardy až stovky miliárd parametrov, paralelizácia a attention mechanizmy transformerov to umožnili bez úmerného nárastu času tréningu.

Autoregresívne dekódovanie, používané v moderných LLM, je priamou aplikáciou dekóderovej architektúry transformera. Pri generovaní textu tieto modely spracujú vstupný prompt cez enkóder (alebo v dekóder-only modeloch cez celý dekóder) a potom generujú výstupné tokeny po jednom. Každý nový token sa generuje výpočtom pravdepodobnostného rozdelenia nad celým slovníkom pomocou softmaxu, pričom model zvolí najpravdepodobnejší token (alebo vzorkuje podľa nastavenia teploty). Tento proces, opakovaný stokrát až tisíckrát, vedie k súvislému, kontextovo vhodnému textu. Mechanizmus self-attention umožňuje modelu udržať kontext naprieč celou generovanou sekvenciou, takže dokáže vytvárať dlhé, konzistentné pasáže s udržaním témy, postáv a logického toku.

Emergentné schopnosti, pozorované vo veľkých transformer modeloch – schopnosti, ktoré sa objavia až v dostatočnej škále, ako few-shot učenie, chain-of-thought uvažovanie či učenie v kontexte – sú priamym dôsledkom návrhu transformer architektúry. Schopnosť viacnásobnej pozornosti zachytávať rozmanité vzťahy, v kombinácii s obrovským počtom parametrov a tréningom na rozmanitých dátach, umožňuje týmto systémom vykonávať úlohy, na ktoré neboli explicitne trénované. Napríklad GPT-3 dokáže počítať, písať kód či odpovedať na vedomostné otázky, hoci bolo trénované iba na jazykovom modelovaní. Tieto emergentné vlastnosti urobili z transformerových LLM základ modernej AI revolúcie, s využitím od konverzačnej AI a generovania obsahu cez syntézu kódu až po asistenciu vo vedeckom výskume.

Mechanizmus self-attention je architektonickou inováciou, ktorá zásadným spôsobom odlišuje transformery a vysvetľuje ich vyšší výkon oproti predchádzajúcim prístupom. Na pochopenie self-attention si predstavme výzvu interpretácie nejednoznačných zámen v jazyku. Vo vete “Trofej sa nezmestí do kufra, pretože je príliš veľká” môže zámeno “je” odkazovať na trofej alebo kufor, no kontext jasne naznačuje trofej. Vo vete “Trofej sa nezmestí do kufra, pretože je príliš malý” to isté zámeno odkazuje na kufor. Transformer model sa musí naučiť takéto nejednoznačnosti rozlíšiť pochopením vzťahov medzi slovami.

Self-attention to dosahuje matematicky elegantným procesom. Pre každý token vo vstupnej sekvencii model vypočíta Query vektor vynásobením embeddingu tokenu naučenou váhovou maticou WQ. Podobne vypočíta Key vektory (pomocou WK) a Value vektory (pomocou WV) pre všetky tokeny. Attention skóre medzi Query tokenu a Key iného tokenu je skalárny súčin týchto vektorov, normalizovaný druhou odmocninou z rozmeru Key (typicky √64 ≈ 8). Tieto surové skóre prejdú softmaxom, ktorý ich znormalizuje na váhy, ktoré sa sčítajú na 1. Výstup pre každý token je potom vážený súčet všetkých Value vektorov, kde váhy sú attention skóre. Tento proces umožňuje každému tokenu selektívne agregovať informáciu od všetkých ostatných tokenov, pričom váhy sa naučia počas tréningu zachytávať významné vzťahy.

Matematická elegancia self-attention umožňuje efektívne výpočty. Celý proces sa dá vyjadriť maticovými operáciami: Attention(Q, K, V) = softmax(QK^T / √d_k)V, kde Q, K a V sú matice obsahujúce všetky query, key a value vektory. Táto maticová formulácia umožňuje akceleráciu pomocou GPU, vďaka čomu transformery spracujú celé sekvencie paralelne namiesto sekvenčne. Sekvenciu 512 tokenov možno spracovať zhruba za rovnaký čas ako jeden token v RNN, takže transformery sú rádovo rýchlejšie na tréning. Táto výpočtová efektivita, v kombinácii so schopnosťou attention mechanizmu zachytávať dlhodobé závislosti, vysvetľuje dominanciu transformerov v jazykovom modelovaní.

Viacnásobná pozornosť (multi-head attention) rozširuje mechanizmus self-attention spustením viacerých paralelných attention operácií, pričom každá sa učí iné aspekty vzťahov medzi tokenmi. V typickom transformeri s 8 hlavami sú vstupné embeddingy lineárne projektované do 8 rôznych reprezentácií, pričom každá má vlastné váhové matice Query, Key a Value. Každá hlava nezávisle vypočíta attention váhy a vytvorí výstupné vektory. Tieto výstupy sa následne spoja a lineárne transformujú cez finálnu váhovú maticu, čím vznikne konečný výstup multi-head attention. Táto architektúra umožňuje modelu súčasne sa zamerať na informácie z rôznych reprezentácií na rôznych pozíciách.

Výskum analyzujúci natrénované transformer modely ukázal, že rôzne attention hlavy sa špecializujú na rôzne jazykové javy. Niektoré sa zameriavajú na syntaktické vzťahy, učia sa venovať pozornosť gramaticky príbuzným slovám (napr. slovesá subjektom a objektom). Iné sa zameriavajú na sémantické vzťahy a učia sa venovať pozornosť slovám s podobným významom. Ďalšie zachytávajú dlhodobé závislosti a venujú pozornosť slovám, ktoré sú ďaleko v sekvencii, ale sémanticky súvisia. Niektoré hlavy dokonca venujú pozornosť predovšetkým aktuálnemu tokenu, čím pôsobia ako identita. Táto špecializácia vzniká prirodzene počas tréningu bez explicitného dozoru, čo dokazuje silu multi-head architektúry na učenie rozmanitých, doplňujúcich sa reprezentácií.

Počet attention hláv je kľúčový architektonický hyperparameter. Väčšie modely často používajú viac hláv (16, 32 a viac), čo im umožňuje zachytiť rozmanitejšie vzťahy. Celková dimenzionalita attention je však zvyčajne konštantná, takže viac hláv znamená nižšiu dimenziu na hlavu. Toto rozhodnutie vyvažuje prínosy viacerých reprezentácií a výpočtovú efektivitu. Multi-head prístup sa ukázal natoľko efektívny, že sa stal štandardom vo všetkých moderných transformer implementáciách, od BERT a GPT až po špecializované architektúry pre videnie, audio či multimodálne úlohy.

Pôvodná architektúra transformera, ako bola opísaná v článku “Attention is All You Need”, používa štruktúru enkóder-dekóder optimalizovanú pre úlohy typu sekvencia-na-sekvenciu, napríklad strojový preklad. Enkóder spracováva vstupnú sekvenciu a vytvára sekvenciu kontextovo bohatých reprezentácií. Každá enkóderová vrstva obsahuje dve hlavné zložky: multi-head self-attention podvrstvu, ktorá umožňuje tokenom venovať pozornosť iným tokenom vo vstupe, a doprednú sieť, ktorá aplikuje rovnakú nelineárnu transformáciu na každú pozíciu nezávisle. Tieto podvrstvy sú prepojené cez reziduálne spojenia (skip connections), ktoré pridávajú vstup k výstupu každej podvrstvy. Tento návrh, inšpirovaný reziduálnymi sieťami z počítačového videnia, umožňuje tréning veľmi hlbokých sietí tým, že gradienty môžu prúdiť sieťou priamo.

Dekóder generuje výstupnú sekvenciu po jednom tokene, pričom využíva informácie z enkódera aj predtým vygenerovaných tokenov. Každá dekóderová vrstva obsahuje tri hlavné zložky: maskovanú self-attention podvrstvu, ktorá umožňuje tokenom venovať pozornosť len predchádzajúcim tokenom (čím zabraňuje “podvádzaniu” počas tréningu), enkóder-dekóder attention podvrstvu, ktorá umožňuje dekóderovým tokenom venovať pozornosť výstupom enkódera, a doprednú sieť. Maskovanie v self-attention podvrstve je kľúčové: zabraňuje toku informácie z budúcich pozícií do minulých, aby predikcie na pozícii i záviseli len od známych výstupov na pozíciách menších než i. Táto autoregresívna štruktúra je nevyhnutná na generovanie sekvencií po jednom tokene.

Architektúra enkóder-dekóder je mimoriadne efektívna pre úlohy, kde vstup a výstup majú odlišnú štruktúru alebo dĺžku, ako je strojový preklad (preklad z jedného jazyka do druhého), sumarizácia (skrátenie dlhých textov) a odpovedanie na otázky (generovanie odpovedí na základe kontextu). Moderné LLM ako GPT však používajú čisto dekóderové architektúry, kde jeden zásobník dekóderových vrstiev spracováva vstupný prompt aj generuje výstup. Toto zjednodušenie znižuje komplexnosť modelu a ukázalo sa ako rovnako alebo ešte efektívnejšie pre jazykové modelovanie, pravdepodobne preto, že model sa dokáže naučiť využívať self-attention na spracovanie vstupu i generovanie výstupu v jednotnej štruktúre.

Kritickou výzvou v architektúre Transformera je reprezentácia poradia tokenov v sekvencii. Na rozdiel od RNN, ktoré prirodzene uchovávajú poradie vďaka rekurentnej štruktúre, transformery spracovávajú všetky tokeny paralelne a nemajú zabudovanú predstavu o pozícii. Bez explicitných informácií o pozícii by transformer nerozlíšil sekvenciu “The cat sat on the mat” od “mat the on sat cat The”, čo by bolo pre pochopenie jazyka katastrofálne. Riešením je pozičné kódovanie, ktoré pridáva pozíciovo závislé vektory k embeddingom tokenov pred spracovaním.

Pôvodný článok o transformeroch používa sín

Architektúra Transformera spracováva celé sekvencie paralelne pomocou self-attention, zatiaľ čo RNN a LSTM spracovávajú sekvencie sekvenčne, po jednom prvku. Táto paralelizácia robí transformery výrazne rýchlejšími na tréning a lepšími v zachytávaní dlhodobých závislostí medzi vzdialenými slovami alebo tokenmi. Transformery sa tiež vyhýbajú problému miznúcich gradientov, ktorý trápil RNN, čo im umožňuje efektívne učiť sa z oveľa dlhších sekvencií.

Self-attention vypočíta tri vektory (Query, Key a Value) pre každý token v vstupnej sekvencii. Query vektor z jedného tokenu sa porovnáva s Key vektormi všetkých tokenov na určenie skóre relevantnosti, ktoré sú normalizované pomocou softmaxu. Tieto attention váhy sa potom aplikujú na Value vektory na vytvorenie kontextovo závislých reprezentácií. Tento mechanizmus umožňuje každému tokenu 'venovať pozornosť' alebo sa zamerať na iné relevantné tokeny v sekvencii, vďaka čomu model chápe kontext a vzťahy.

Medzi hlavné komponenty patria: (1) Vstupné embeddingy a pozičné kódovanie na reprezentáciu tokenov a ich pozícií, (2) vrstvy viacnásobnej self-attention, ktoré vypočítavajú pozornosť naprieč viacerými reprezentáciami, (3) dopredné neurónové siete aplikované na každú pozíciu nezávisle, (4) zásobník enkódera na spracovanie vstupných sekvencií, (5) zásobník dekódera na generovanie výstupných sekvencií a (6) reziduálne spojenia a normalizácia vrstiev pre tréningovú stabilitu. Tieto komponenty spolupracujú na efektívnom paralelnom spracovaní a pochopení kontextu.

Architektúra Transformera vyniká pri LLM, pretože umožňuje paralelné spracovanie celých sekvencií, čo dramaticky skracuje čas tréningu v porovnaní so sekvenčnými RNN. Efektívnejšie zachytáva dlhodobé závislosti cez self-attention, vďaka čomu modely chápu kontext naprieč celými dokumentmi. Architektúra sa tiež efektívne škáluje s väčšími dátovými súbormi a viac parametrami, čo sa ukázalo ako nevyhnutné pre tréning modelov s miliardami parametrov, ktoré vykazujú emergentné schopnosti.

Viacnásobná pozornosť spúšťa viacero paralelných mechanizmov pozornosti (typicky 8 alebo 16 hláv) súčasne, pričom každá pracuje v inej reprezentácii. Každá hlava sa učí zameriavať na rôzne typy vzťahov a vzorcov v dátach. Výstupy všetkých hláv sa spoja a lineárne transformujú, čo modelu umožňuje zachytiť rozmanité kontextové informácie. Tento prístup výrazne zlepšuje schopnosť modelu chápať komplexné vzťahy a celkový výkon.

Pozičné kódovanie pridáva informáciu o pozícii tokenov k vstupným embeddingom pomocou sínusových a kosínusových funkcií s rôznymi frekvenciami. Keďže transformery spracovávajú všetky tokeny paralelne (na rozdiel od sekvenčných RNN), potrebujú explicitnú informáciu o pozícii na pochopenie poradia slov. Vektory pozičného kódovania sa pridávajú k embeddingom tokenov pred spracovaním, čo modelu umožňuje naučiť sa, ako pozícia ovplyvňuje význam a umožňuje mu generalizovať na dlhšie sekvencie, než na akých bol trénovaný.

Enkóder spracováva vstupnú sekvenciu a vytvára bohaté kontextové reprezentácie pomocou viacerých vrstiev self-attention a dopredných sietí. Dekóder generuje výstupnú sekvenciu po jednom tokene, pričom využíva enkóder-dekóder pozornosť na sústredenie sa na relevantné časti vstupu. Táto štruktúra je obzvlášť užitočná pre úlohy typu sekvencia-na-sekvenciu, ako je strojový preklad, avšak moderné LLM často používajú iba dekóderové architektúry pre generovanie textu.

Architektúra Transformera poháňa AI systémy, ktoré generujú odpovede na platformách ako ChatGPT, Claude, Perplexity a Google AI Overviews. Pochopenie toho, ako transformery spracovávajú a generujú text, je kľúčové pre platformy na monitorovanie AI, ako je AmICited, ktoré sledujú, kde sa značky a domény objavujú v AI-generovaných odpovediach. Schopnosť architektúry chápať kontext a generovať súvislý text priamo ovplyvňuje, ako sú značky spomínané a reprezentované v AI výstupoch.

Začnite sledovať, ako AI chatboty spomínajú vašu značku na ChatGPT, Perplexity a ďalších platformách. Získajte použiteľné poznatky na zlepšenie vašej prítomnosti v AI.

Architektúra webu je hierarchická organizácia stránok a obsahu webstránky. Zistite, ako správna štruktúra zlepšuje SEO, používateľský zážitok a viditeľnosť v AI...

Diskusia komunity o technológii živého vyhľadávania Perplexity. Vývojári a marketéri analyzujú, ako Perplexity získava informácie, generuje odpovede a vyberá zd...

GPT-4 je pokročilý multimodálny LLM od OpenAI, ktorý kombinuje spracovanie textu a obrazu. Zistite jeho schopnosti, architektúru a vplyv na monitorovanie AI a s...

Súhlas s cookies

Používame cookies na vylepšenie vášho prehliadania a analýzu našej návštevnosti. See our privacy policy.