Hur fungerar indexering för AI-sökning? Är det annorlunda än Google-indexering?

Diskussion i communityn om hur AI-sökmotorer indexerar och upptäcker innehåll. Tekniska experter förklarar skillnaderna mellan traditionell sökindexering och AI...

Upptäck de grundläggande skillnaderna mellan AI-indexering och Google-indexering. Lär dig hur LLM:er, vektorinbäddningar och semantisk sökning omformar informationsåtervinning och vad det betyder för din innehållssynlighet.

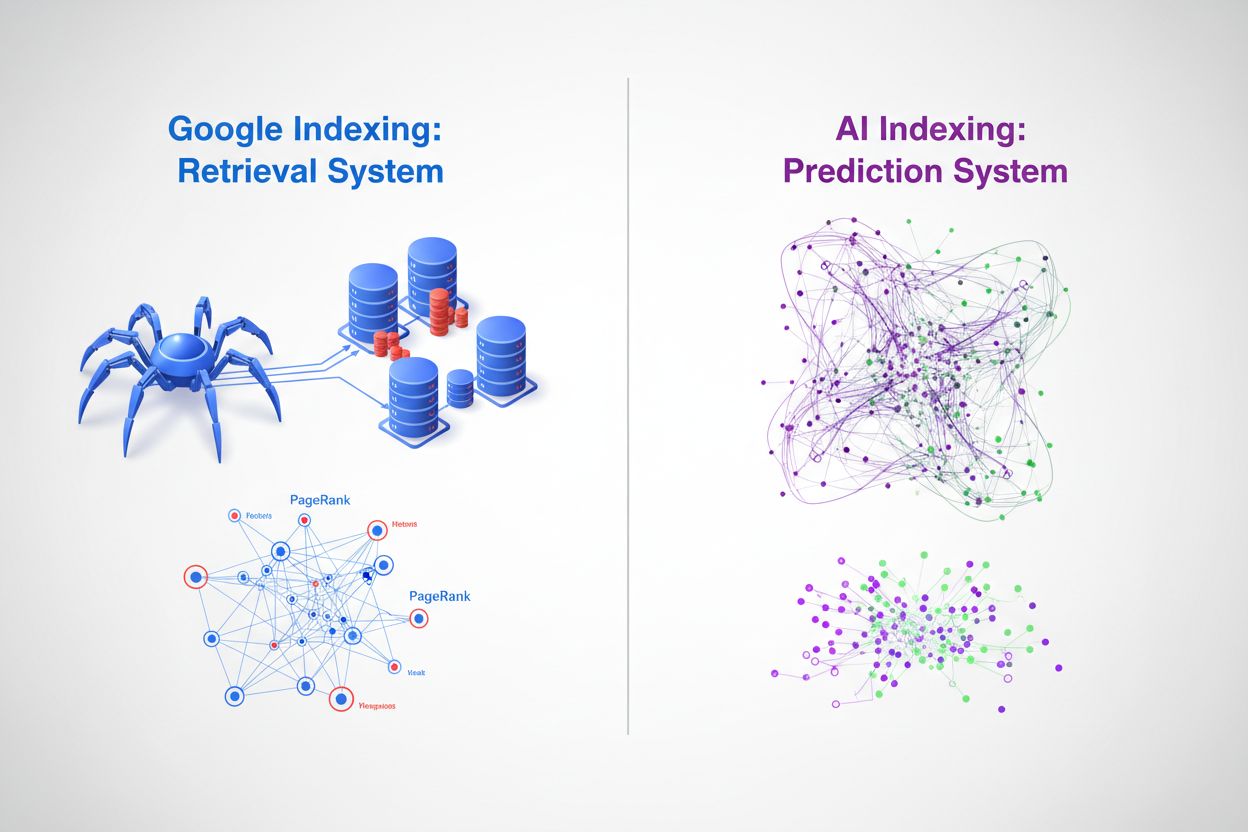

I grunden representerar Google-indexering och AI-indexering två fundamentalt olika sätt att organisera och hämta information. Googles traditionella sökmotor fungerar som ett återvinningssystem—den genomsöker webben, katalogiserar innehåll och returnerar rankade länkar när användare söker på specifika nyckelord. Däremot fungerar AI-indexering via stora språkmodeller (LLM:er) som ChatGPT, Gemini och Copilot som ett prediktionssystem—den kodar enorma mängder träningsdata i neurala nätverk och genererar kontextuellt relevanta svar direkt. Medan Google frågar “var finns denna information?”, frågar AI “vad är det mest relevanta svaret?” Denna skillnad förändrar i grunden hur innehåll upptäcks, rankas och presenteras för användare, och skapar två parallella men alltmer sammankopplade informationssystem.

Googles indexeringsprocess följer en väletablerad pipeline som har dominerat sökmarknaden i över två decennier. Googlebot-crawlers traverserar systematiskt webben, följer länkar från sida till sida och samlar in innehåll som därefter bearbetas via Googles indexeringsinfrastruktur. Systemet extraherar nyckelsignaler såsom nyckelord, metadata och länkstruktur, och lagrar denna information i massiva distribuerade databaser. Googles egenutvecklade PageRank-algoritm bedömer sidornas betydelse baserat på mängden och kvaliteten av länkar som pekar på dem, enligt principen att viktiga sidor får fler länkar från andra viktiga sidor. Nyckelordsöverensstämmelse är fortsatt centralt för relevansbedömning—när en användare gör en sökning identifierar Googles system sidor som innehåller dessa exakta eller semantiskt liknande termer och rankar dem utifrån hundratals rankningsfaktorer såsom domänauktoritet, innehållets färskhet, användarupplevelse och ämnesrelevans. Detta tillvägagångssätt är utmärkt för att snabbt hitta specifik information och har visat sig vara mycket effektivt för navigations- och transaktionssökningar, vilket förklarar Googles 89,56 % marknadsdominans och att de hanterar 8,5–13,7 miljarder sökningar dagligen.

| Aspekt | Google-indexering | Detaljer |

|---|---|---|

| Huvudmekanism | Webb-crawling & indexering | Googlebot traverserar systematiskt webbsidor |

| Rankningsalgoritm | PageRank + 200+ faktorer | Länkar, nyckelord, färskhet, användarupplevelse |

| Datarepresentation | Nyckelord & länkar | Texttokens och hyperlänksrelationer |

| Uppdateringsfrekvens | Kontinuerlig crawling | Realtidsindexering av nytt/uppdaterat innehåll |

| Frågehantering | Nyckelordsöverensstämmelse | Exakt och semantisk nyckelordsöverensstämmelse |

| Marknadsandel | 89,56 % globalt | 8,5–13,7 miljarder sökningar dagligen |

AI-modeller använder en helt annan indexeringsmekanism baserad på vektorinbäddningar och semantisk förståelse snarare än nyckelordsöverensstämmelse. Under träningen bearbetar LLM:er miljarder texttokens och lär sig att representera begrepp, relationer och betydelser som högdimensionella vektorer i en process kallad inbäddningsgenerering. Dessa inbäddningar fångar semantiska relationer—till exempel kan “kung” minus “man” plus “kvinna” ge “drottning”—vilket gör att modellen kan förstå kontext och avsikt snarare än bara matcha teckensträngar. Indexeringsprocessen i AI-system involverar flera nyckelmekanismer:

Detta gör att AI-system kan förstå användarens avsikt även när frågor använder annan terminologi än källmaterialet, och att syntetisera information över flera begrepp för att skapa nya svar. Resultatet är ett fundamentalt annorlunda återvinningsparadigm där “indexet” är distribuerat över de neurala nätverkens vikter snarare än lagrat i en traditionell databas.

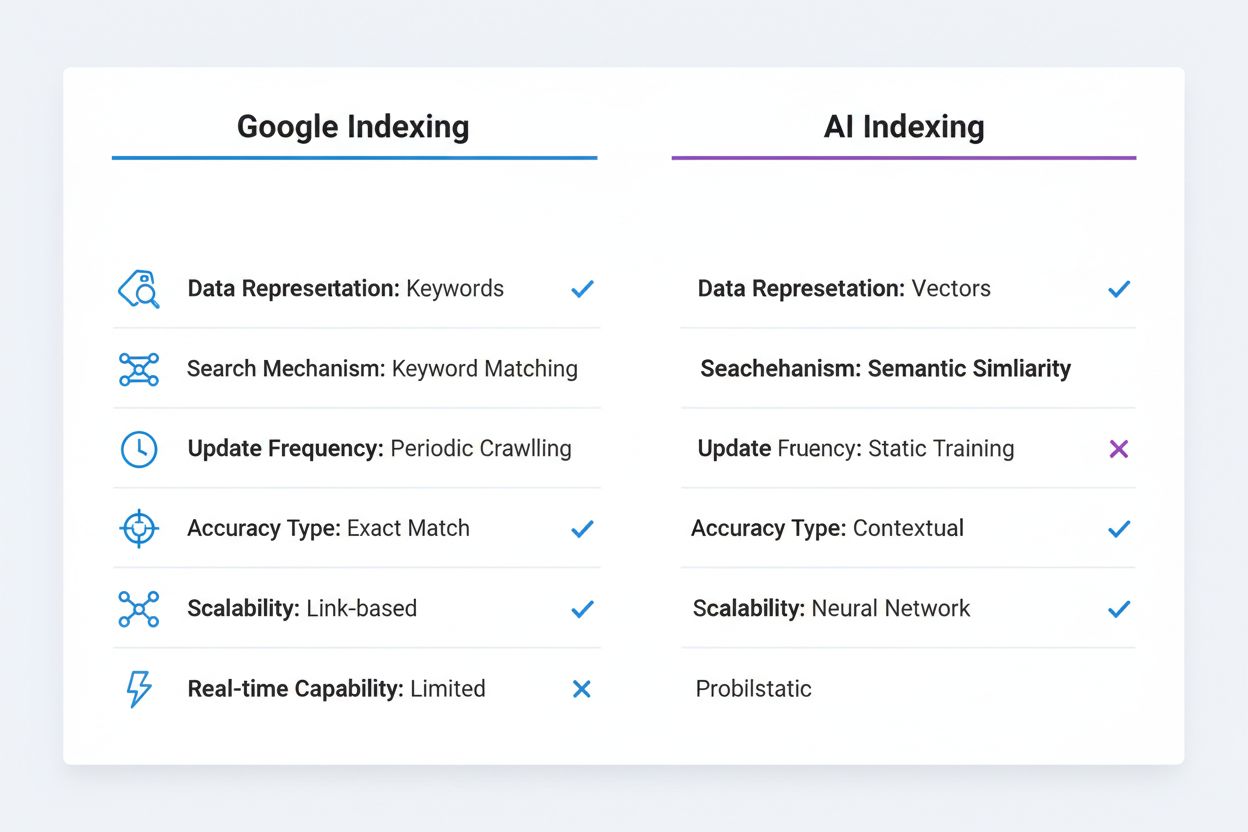

De tekniska skillnaderna mellan Google-indexering och AI-indexering har stora konsekvenser för innehållsupptäckt och synlighet. Exakt nyckelordsöverensstämmelse, som fortfarande är viktig i Googles algoritm, är i stort sett irrelevant i AI-system—en LLM förstår att “automobil”, “bil” och “fordon” är semantiskt likvärdiga utan att kräva explicit nyckelordsoptimering. Googles indexering är deterministisk och reproducerbar; samma fråga ger samma rankade resultat för olika användare och vid olika tidpunkter (förutom personalisering). AI-indexering är probabilistisk och variabel; samma fråga kan ge olika svar beroende på temperaturinställningar och samplingparametrar, även om den underliggande kunskapen är densamma. Googles system är särskilt effektivt för strukturerad, diskret information som produktpriser, öppettider och faktauppgifter, vilket kan visas i rich snippets och kunskapspaneler. AI-system har svårare för denna typ av exakt, aktuell information eftersom deras träningsdata har en kunskapsgräns och de inte kan få tillgång till realtidsinformation utan externa verktyg. Däremot briljerar AI-system inom kontextuell förståelse och syntes, och kan koppla ihop avlägsna begrepp och förklara komplexa relationer på naturligt språk. Googles indexering kräver explicit länkning och citering—innehåll måste publiceras på webben och länkas för att upptäckas. AI-indexering bygger på implicit kunskap inbäddad under träningen, vilket innebär att värdefull information som finns i PDF:er, betalmurade sidor eller privata databaser förblir osynlig för båda systemen, men av olika skäl.

| Jämförelseaspekt | Google-indexering | AI-indexering |

|---|---|---|

| Datarepresentation | Nyckelord & länkar | Vektorinbäddningar |

| Sökmekanism | Nyckelordsöverensstämmelse | Semantisk likhet |

| Uppdateringsfrekvens | Periodisk crawling | Statisk träningsdata |

| Noggrannhetstyp | Exakt matchningsfokus | Kontextuell förståelse |

| Skalbarhetsmodell | Länkburen auktoritet | Neurala nätverksvikter |

| Realtidskapacitet | Ja (med crawling) | Begränsad (utan RAG) |

Framväxten av vektordatabaser utgör en avgörande brygga mellan traditionell indexering och AI-baserad återvinning, och gör det möjligt för organisationer att implementera semantisk sökning i stor skala. Vektordatabaser som Pinecone, Weaviate och Milvus lagrar högdimensionella inbäddningar och utför likhetssökningar med hjälp av mått som cosinuslikhet och euklidiskt avstånd, vilket gör att systemen kan hitta semantiskt relaterat innehåll även när exakta nyckelord inte matchar. Denna teknik driver Retrieval-Augmented Generation (RAG), en metod där AI-system frågar vektordatabaser för att hämta relevant kontext innan de genererar svar, vilket dramatiskt förbättrar noggrannheten och möjliggör åtkomst till skyddad eller aktuell information. RAG-system kan hämta de mest semantiskt liknande dokumenten till en användarfråga på millisekunder och ge AI-modellen grundad information att citera och vidareutveckla. Google har integrerat semantisk förståelse i sin kärnalgoritm via BERT och senare modeller, och rör sig därmed bortom enbart nyckelordsöverensstämmelse mot att förstå sökintention och innehållsbetydelse. Vektordatabaser möjliggör realtidsåtervinning av relevant information, så att AI-system kan komma åt aktuell data, företagsspecifika kunskapsbaser och specialiserad information utan omträning. Denna förmåga är särskilt kraftfull för företag som behöver att AI-system kan besvara frågor om egen information med bibehållen noggrannhet och verifierbara källor.

AI-indexeringens framväxt omformar i grunden hur innehåll blir synligt och driver trafik. Nollklicksfenomenet—där Google besvarar frågor direkt i sökresultaten utan att användaren klickar vidare till källwebbplatser—har accelererat kraftigt med AI-integration, och AI-chattbottar tar detta ännu längre genom att generera svar utan synlig attribuering. Traditionell trafik via klick ersätts av AI-citat, där innehållsskapare får synlighet genom omnämnanden i AI-genererade svar snarare än användarklick. Denna förändring har stora konsekvenser: ett varumärke som nämns i ett ChatGPT-svar når miljontals användare men genererar ingen direkt trafik och ger ingen analysdata om engagemang. Varumärkesauktoritet och ämnesexpertis blir allt viktigare då AI-system tränas för att citera auktoritativa källor och känna igen domänexpertis, vilket gör det avgörande för organisationer att tydligt signalera auktoritet i sitt innehåll. Strukturerad datamärkning blir mer värdefull i detta landskap, eftersom det hjälper både Google och AI-system att förstå innehållets kontext och trovärdighet. Synlighetsarbetet handlar inte längre enbart om att ranka på nyckelord—det handlar om att bli erkänd som en auktoritativ källa värd att citeras av AI-system som processar miljarder dokument och måste skilja tillförlitlig information från felaktigheter.

Istället för att AI-indexering ersätter Google-indexering ser framtiden ut att bli en av konvergens och samexistens. Google har redan börjat integrera AI-funktioner direkt i sökningen via sin funktion AI Overview (tidigare SGE), som genererar AI-drivna sammanfattningar vid sidan av traditionella sökresultat och därmed skapar ett hybridsystem som kombinerar Googles indexeringsinfrastruktur med generativa AI-kapaciteter. Detta tillvägagångssätt låter Google behålla sin kärnstyrka—omfattande webindexering och länkanalys—samtidigt som AI:s förmåga att syntetisera och kontextualisera information adderas. Andra sökmotorer och AI-företag följer liknande spår; Perplexity kombinerar webbsök med AI-generering, och Microsoft integrerar ChatGPT i Bing. De mest sofistikerade informationsåtervinningssystemen kommer sannolikt att använda multimodala indexeringsstrategier som kombinerar traditionell nyckelordsbaserad återvinning för exakt information och semantisk/vektorbaserad återvinning för kontextuell förståelse. Organisationer och innehållsskapare måste förbereda sig för en miljö där innehåll behöver optimeras för flera upptäcktsmekanismer samtidigt—traditionell SEO för Googles algoritm, strukturerad data för AI-system och semantisk rikedom för vektorbaserad återvinning.

Innehållsstrateger och marknadsförare måste nu anta ett dubbelt optimeringsperspektiv som täcker både traditionella sök- och AI-indexeringsmekanismer. Det innebär att bibehålla stark nyckelordsoptimering och länkstrategier för Google, samtidigt som innehållet ska uppvisa ämnesauktoritet, semantiskt djup och kontextuell rikedom som AI-system kan känna igen och citera. Implementering av omfattande strukturerad datamärkning (Schema.org) blir avgörande, eftersom det hjälper både Google och AI-system att förstå innehållets kontext, trovärdighet och relationer—detta är särskilt viktigt för E-E-A-T-signaler (Erfarenhet, Expertis, Auktoritet, Trovärdighet) som påverkar både rankning och citeringssannolikhet. Att skapa djupgående, heltäckande innehåll som grundligt utforskar ämnen är mer värdefullt än någonsin, då AI-system oftare citerar auktoritativa, välresearchade källor som ger komplett kontext, snarare än tunna, nyckelordsoptimerade sidor. Organisationer bör implementera citatspårningssystem för att övervaka omnämnanden i AI-genererade svar, ungefär som de spårar bakåtlänkar, och förstå att synlighet i AI-utmatningar är en ny form av förtjänad media. Att bygga en kunskapsbas eller innehållshubb som tydligt visar expertis inom specifika områden ökar sannolikheten att bli erkänd som en auktoritativ källa av AI-system. Slutligen innebär framväxten av Generative Engine Optimization (GEO) som disciplin att marknadsförare måste förstå hur man strukturerar innehåll, använder naturliga språkstrukturer och bygger auktoritetssignaler som tilltalar både algoritmiska rankningssystem och AI-citeringsmekanismer—ett mer nyanserat och sofistikerat tillvägagångssätt än traditionell SEO ensam.

Skillnaden mellan AI-indexering och Google-indexering handlar inte om att den ena ersätter den andra, utan om en grundläggande utvidgning av hur information organiseras, hämtas och presenteras för användare. Googles återvinningsbaserade tillvägagångssätt är fortsatt kraftfullt för att snabbt hitta specifik information, medan AI:s prediktionsbaserade tillvägagångssätt briljerar inom syntes, kontext och att förstå användarens avsikt. De mest framgångsrika organisationerna blir de som inser denna dualitet och optimerar sitt innehåll och digitala närvaro för båda systemen samtidigt. Genom att förstå de tekniska skillnaderna mellan dessa indexeringsmetoder, implementera strukturerad data, bygga ämnesauktoritet och spåra synlighet både i traditionell sök och på AI-plattformar, kan organisationer säkerställa att deras innehåll förblir upptäckbart och värdefullt i ett allt mer komplext informationslandskap. Sökningens framtid är inte singulär—den är plural, distribuerad och allt mer intelligent.

Google-indexering är ett återvinningssystem som genomsöker webben, katalogiserar innehåll och returnerar rankade länkar baserat på nyckelord och länkar. AI-indexering är ett prediktionssystem som kodar träningsdata i neurala nätverk och genererar kontextuellt relevanta svar direkt. Google frågar 'var finns denna information?' medan AI frågar 'vad är det mest relevanta svaret?'

Vektorinbäddningar omvandlar text och annan data till högdimensionella numeriska matriser som fångar semantisk betydelse. Dessa inbäddningar gör det möjligt för AI-system att förstå att 'bil', 'automobil' och 'fordon' är semantiskt likvärdiga utan exakt nyckelordsöverensstämmelse. Liknande begrepp representeras som vektorer nära varandra i högdimensionellt utrymme.

Traditionella AI-modeller har en kunskapsgräns och kan inte tillförlitligt få tillgång till information i realtid. Däremot kan Retrieval-Augmented Generation (RAG)-system fråga vektordatabaser och webbkällor för att hämta aktuell information innan de genererar svar, vilket överbryggar denna klyfta.

GEO är en framväxande disciplin som fokuserar på att optimera innehåll för AI-genererade svar istället för traditionella sökrankningar. Det betonar ämnesauktoritet, strukturerad data, semantiskt djup och varumärkes trovärdighet för att öka sannolikheten att bli citerad av AI-system.

Nyckelordssökning matchar exakta eller liknande ord i dokument. Semantisk sökning förstår betydelsen och avsikten bakom frågor, vilket gör det möjligt att hitta relevanta resultat även när olika terminologi används. Till exempel kan en semantisk sökning på 'smartphone' också ge resultat för 'mobil enhet' eller 'mobiltelefon.'

Istället för att ersätta verkar framtiden vara konvergens. Google integrerar AI-funktioner i sin sökning genom funktioner som AI Overviews, och skapar hybridsystem som kombinerar traditionell indexering med generativ AI. Organisationer behöver optimera för båda systemen samtidigt.

En vektordatabas lagrar högdimensionella inbäddningar och utför likhetssökningar med hjälp av mått som cosinuslikhet. Den är avgörande för att implementera semantisk sökning och Retrieval-Augmented Generation (RAG), vilket gör det möjligt för AI-system att komma åt och hämta relevant information i stor skala på millisekunder.

Marknadsförare bör anta en dubbel optimeringsstrategi: bibehålla traditionell SEO för Google samtidigt som de bygger ämnesauktoritet, implementerar strukturerad data, skapar omfattande innehåll och spårar AI-citat. Fokusera på att visa expertis och trovärdighet för att bli erkänd som en auktoritativ källa av AI-system.

Spåra hur ditt varumärke syns i AI-genererade svar från ChatGPT, Gemini, Perplexity och Google AI Overviews. Få insikter i realtid om dina AI-citat och synlighet.

Diskussion i communityn om hur AI-sökmotorer indexerar och upptäcker innehåll. Tekniska experter förklarar skillnaderna mellan traditionell sökindexering och AI...

Lär dig hur AI-sökindex fungerar, skillnaderna mellan ChatGPT:s, Perplexitys och SearchGPT:s indexeringsmetoder och hur du optimerar ditt innehåll för AI-synlig...

Lär dig hur AI-sökindexering omvandlar data till sökbara vektorer, vilket gör det möjligt för AI-system som ChatGPT och Perplexity att hämta och citera relevant...