Hur fallstudier presterar i AI-sökresultat

Lär dig hur fallstudier rankas i AI-sökmotorer som ChatGPT, Perplexity och Google AI Overviews. Upptäck varför AI-system citerar fallstudier som auktoritativa k...

Lär dig hur du formaterar fallstudier för AI-citat. Upptäck ritningen för att strukturera framgångshistorier som LLMs citerar i AI Overviews, ChatGPT och Perplexity.

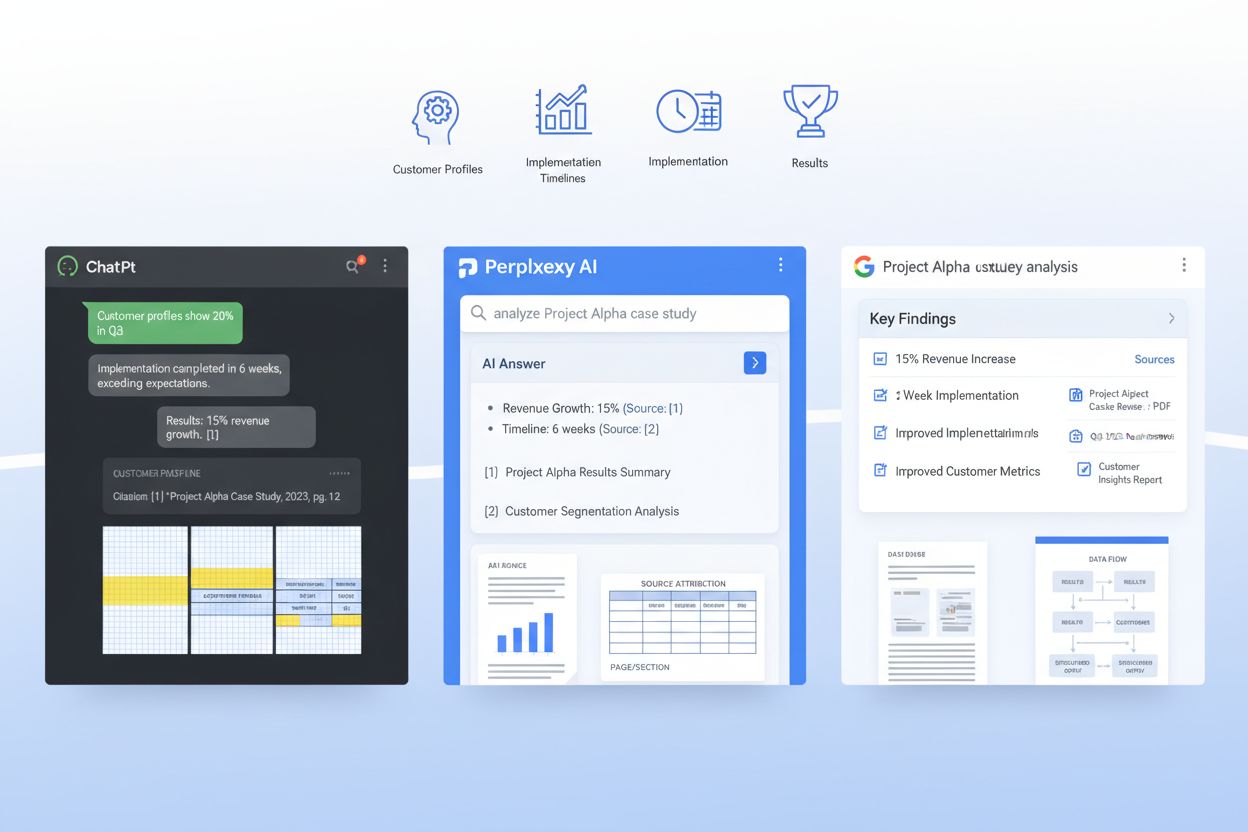

AI-system som ChatGPT, Perplexity och Googles AI Overviews förändrar i grunden hur B2B-köpare upptäcker och validerar fallstudier—ändå publicerar de flesta företag dem fortfarande i format som LLMs knappt kan tolka. När en företagsköpare frågar ett AI-system “Vilka SaaS-plattformar fungerar bäst för vårt användningsområde?”, söker systemet igenom miljoner dokument för att hitta relevanta bevispunkter, men dåligt formaterade fallstudier förblir osynliga för dessa återvinningssystem. Detta skapar en kritisk lucka: medan traditionella fallstudier ger en grundläggande vinstfrekvens på 21% i sena säljstadier, kan AI-optimerade fallstudier öka citeringssannolikheten med 28–40% när de är korrekt strukturerade för maskininlärningsmodeller. Företag som vinner i detta nya landskap förstår att förstapartsdatans fördel kommer av att vara upptäckbar av AI-system, inte bara av mänskliga läsare. Utan avsiktlig optimering för LLM-återvinning är dina mest övertygande kundframgångshistorier i praktiken låsta för de AI-system som nu påverkar över 60% av företagsköpen.

En AI-klar fallstudie är inte bara en välskriven berättelse—det är ett strategiskt strukturerat dokument som tjänar både mänskliga läsare och maskininlärningsmodeller samtidigt. De mest effektiva fallstudierna följer en konsekvent arkitektur som gör det möjligt för LLMs att extrahera nyckelinformation, förstå kontext och citera ditt företag med självförtroende. Nedan är den essentiella ritningen som skiljer AI-upptäckbara fallstudier från dem som går förlorade i återvinningssystem:

| Sektion | Syfte | AI-optimering |

|---|---|---|

| TL;DR-sammanfattning | Omedelbar kontext för stressade läsare | Placeras högst upp för tidig token-konsumtion; 50–75 ord |

| Kundöversikt | Snabb identifiering av företagets profil | Strukturerad som: Bransch / Företagsstorlek / Plats / Roll |

| Affärskontext | Problembeskrivning och marknadssituation | Använd konsekvent terminologi; undvik variationsrik jargong |

| Mål | Specifika, mätbara mål kunden hade | Formatera som numrerad lista; inkludera kvantifierade mål |

| Lösning | Hur din produkt/tjänst mötte behovet | Förklara funktion-till-nytta-koppling tydligt |

| Implementering | Tidslinje, process och införandedetaljer | Dela upp i faser; inkludera varaktighet och milstolpar |

| Resultat | Kvantifierade utfall och effektmått | Presentera som: Mätetal / Baslinje / Slutvärde / Förbättring % |

| Bevis | Data, skärmdumpar eller tredjepartsvalidering | Inkludera tabeller för mätetal; citera källor tydligt |

| Kundcitat | Äkta röst och emotionell validering | Attribuera med namn, titel, företag; 1–2 meningar vardera |

| Återanvändningssignaler | Internlänkning och korsmarknadsföringskrokar | Föreslå relaterade fallstudier, webbinarier eller resurser |

Denna struktur säkerställer att varje sektion tjänar ett dubbelt syfte: det läses naturligt för människor samtidigt som det ger semantisk tydlighet för RAG-system (Retrieval-Augmented Generation) som driver moderna LLMs. Konsekvensen i detta format över ditt fallstudiebibliotek gör det exponentiellt enklare för AI-system att extrahera jämförbara datapunkter och citera ditt företag med tillförsikt.

Förutom struktur har de specifika formateringsvalen du gör en dramatisk inverkan på om AI-system faktiskt kan hitta och citera dina fallstudier. LLMs behandlar dokument annorlunda än människor—de skummar inte eller använder visuell hierarki på samma sätt som läsare, men de är mycket känsliga för semantiska markörer och konsekventa formateringsmönster. Här är formateringselementen som mest signifikant ökar AI-återvinning:

Dessa formateringsval handlar inte om estetik—de handlar om att göra din fallstudie maskinläsbar så att när en LLM söker efter relevanta bevispunkter är det din företagsberättelse som blir citerad.

Det mest sofistikerade tillvägagångssättet för AI-klara fallstudier innebär att bädda in ett JSON-schema direkt i din fallstudiedokument eller metadatalager, vilket skapar ett dubbellager där människor läser berättelsen medan maskiner läser de strukturerade uppgifterna. JSON-scheman ger LLMs otvetydiga, maskinläsbara representationer av din fallstudies nyckelinformation, vilket dramatiskt förbättrar citeringsnoggrannhet och relevans. Här är ett exempel på hur du kan strukturera detta:

{

"@context": "https://schema.org",

"@type": "CaseStudy",

"name": "Enterprise SaaS Platform Reduces Onboarding Time by 60%",

"customer": {

"name": "TechCorp Industries",

"industry": "Financial Services",

"companySize": "500-1000 employees",

"location": "San Francisco, CA"

},

"solution": {

"productName": "Your Product Name",

"category": "Workflow Automation",

"implementationDuration": "8 weeks"

},

"results": {

"metrics": [

{"name": "Onboarding Time Reduction", "baseline": "120 days", "final": "48 days", "improvement": "60%"},

{"name": "User Adoption Rate", "baseline": "45%", "final": "89%", "improvement": "97%"},

{"name": "Support Ticket Reduction", "baseline": "450/month", "final": "120/month", "improvement": "73%"}

]

},

"datePublished": "2024-01-15",

"author": {"@type": "Organization", "name": "Your Company"}

}

Genom att implementera schema.org-kompatibla JSON-strukturer ger du i praktiken LLMs ett standardiserat sätt att förstå och citera din fallstudie. Detta tillvägagångssätt integreras sömlöst med RAG-system, vilket möjliggör för AI-modeller att extrahera exakta mätetal, förstå kundkontext och attribuera citat tillbaka till ditt företag med hög säkerhet. Företag som använder JSON-strukturerade fallstudier ser 3–4 gånger högre citeringsnoggrannhet i AI-genererade svar jämfört med enbart narrativt format.

RAG-system behandlar inte hela din fallstudie som ett monolitiskt block—de delar upp den i semantiska chunkar som passar inom en LLM:s kontextfönster, och hur du strukturerar ditt dokument avgör direkt om dessa chunkar är användbara eller fragmenterade. Effektiv chunking innebär att organisera din fallstudie så att naturliga semantiska gränser sammanfaller med hur RAG-system kommer att dela upp innehållet. Detta kräver avsiktlig styckeslängd: varje stycke bör fokusera på en enda idé eller datapunkt, typiskt 100–150 ord, så att när ett RAG-system extraherar en chunk innehåller den fullständig, sammanhängande information istället för övergivna meningar. Narrativ separation är avgörande—använd tydliga avsnittsbrytningar mellan problembeskrivning, lösningsbeskrivning och resultat så att en LLM kan extrahera “resultatavsnittet” som en sammanhängande enhet utan att oavsiktligt blanda in implementeringsdetaljer. Dessutom spelar tokeneffektivitet roll: genom att använda tabeller för mätetal istället för prosa minskar du antalet tokens som behövs för att förmedla samma information, vilket gör att LLMs kan inkludera mer av din fallstudie i sitt svar utan att nå kontextgränser. Målet är att göra din fallstudie “RAG-vänlig” så att varje chunk ett AI-system extraherar är självständigt värdefull och korrekt kontextualiserad.

Att publicera fallstudier för AI-system kräver balans mellan den specifika informationen som gör dem trovärdiga och de sekretesskrav du har mot dina kunder. Många företag tvekar att publicera detaljerade fallstudier av rädsla för att avslöja känslig affärsinformation, men strategisk avidentifiering och anonymisering gör det möjligt att behålla både transparens och förtroende. Det mest effektiva tillvägagångssättet är att skapa flera versioner av varje fallstudie: en fullständigt detaljerad intern version med kompletta kundnamn, exakta mätetal och proprietära implementeringsdetaljer, samt en publik AI-optimerad version som anonymiserar kunden men bevarar kvantifierad effekt och strategiska insikter. Till exempel, istället för “TechCorp Industries sparade 2,3 MUSD årligen”, kan du publicera “Medelstort finansbolag minskade driftkostnaderna med 34%"—måttet är fortfarande tillräckligt specifikt för att LLMs ska kunna citera, men kundens identitet skyddas. Versionskontroll och efterlevnadsspårning är avgörande: behåll tydliga register över vilken information som avidentifierats, varför och när, så att ditt fallstudiebibliotek förblir redo för revision. Detta styrningssätt stärker faktiskt din AI-citeringsstrategi eftersom det gör att du kan publicera fler fallstudier oftare utan juridiska hinder, vilket ger LLMs fler bevispunkter att upptäcka och citera.

Innan du publicerar en fallstudie, validera att den faktiskt presterar bra när den behandlas av LLMs och RAG-system—anta inte att bra formatering automatiskt ger bra AI-prestanda. Att testa dina fallstudier mot verkliga AI-system visar om din struktur, metadata och innehåll faktiskt möjliggör korrekt citering och återvinning. Här är fem viktiga testmetoder:

Relevanskontroll: Mata in din fallstudie i ChatGPT, Perplexity eller Claude med frågor relaterade till din lösningskategori. Hämtar och citerar AI-systemet din fallstudie vid relevanta frågor?

Sammanfattningsnoggrannhet: Be en LLM sammanfatta din fallstudie och verifiera att sammanfattningen fångar de viktigaste mätetalen, kundkontexten och affärseffekten utan förvrängning eller hallucination.

Mätetalsextraktion: Testa om AI-systemet kan extrahera specifika siffror ur din fallstudie (t.ex. “Vad var förbättringen av time-to-value?”). Tabeller bör ge över 96% noggrannhet; prosa ska testas separat.

Attributionsfidelitet: Kontrollera att när LLM citerar din fallstudie så attribueras informationen korrekt till ditt företag och kund, inte till en konkurrent eller generisk källa.

Edge-case-frågor: Testa med ovanliga eller tangentiella frågor för att säkerställa att din fallstudie inte tillämpas på användningsområden den inte egentligen adresserar.

Dessa tester bör köras kvartalsvis i takt med att LLM-beteende utvecklas, och resultaten ska vägleda uppdateringar av ditt fallstudieformat och struktur.

Att mäta effekten av AI-optimerade fallstudier kräver att du spårar både AI-relaterade mätetal (hur ofta dina fallstudier citeras av LLMs) och mänskliga mätetal (hur dessa citat påverkar verkliga affärer). På AI-sidan, använd AmICited.com för att övervaka citeringsfrekvens över ChatGPT, Perplexity och Google AI Overviews—spåra hur ofta ditt företag förekommer i AI-genererade svar för relevanta frågor, och mät om citeringsfrekvensen ökar efter att du publicerat nya AI-optimerade fallstudier. Skapa ett nuläge för din nuvarande citeringsgrad och sätt ett mål att öka citaten med 40–60% inom sex månader efter att du infört AI-klara format. På människosidan, korrelera ökningar i AI-citat med nedströmsmätetal: spåra hur många affärer som nämner “Jag hittade er via en AI-sökning” eller “en AI rekommenderade er fallstudie”, mät förbättringar i vinstfrekvens i affärer där din fallstudie citerades av ett AI-system (mål: 28–40% förbättring över 21%-baslinjen), och övervaka förkortning av säljcirklar i konton där prospekt stött på din fallstudie via AI-upptäckt. Övervaka även SEO-mätetal—AI-optimerade fallstudier med korrekt schema-markering rankar ofta bättre i traditionell sökning, vilket ger en dubbelfördel. Kvalitativ feedback från ditt säljteam är också viktigt: fråga om prospekt kommer med djupare produktkunskap, och om fallstudiecitat minskar tiden för invändningshantering. Den ultimata KPI:n är intäkt: spåra den extra ARR som kan kopplas till affärer påverkade av AI-citerade fallstudier, så har du en tydlig ROI-motivering för fortsatt investering i detta format.

Att optimera fallstudier för AI-citat ger bara ROI om processen blir operationaliserad och upprepad, inte ett engångsprojekt. Börja med att koda din AI-klara fallstudiemall till ett standardiserat format som dina marknads- och säljteam använder för varje ny kundframgångshistoria—detta säkerställer konsekvens över ditt bibliotek och minskar tiden för att publicera nya fallstudier. Integrera denna mall i ditt CMS eller innehållssystem så att publicering av en ny fallstudie automatiskt genererar JSON-schema, metadatahuvuden och formateringselement utan manuellt arbete. Gör skapandet av fallstudier till en kvartals- eller månadsvis rutin, inte en årlig händelse, eftersom LLMs oftare upptäcker och citerar företag med djupare, mer aktuella fallstudiebibliotek. Positionera fallstudier som en kärnkomponent i din bredare intäktsstrategi: de ska ingå i säljmateriel, produktmarknadsföring, efterfrågegenereringskampanjer och kundframgångsplaybooks. Slutligen, etablera en kontinuerlig förbättringscykel där du övervakar vilka fallstudier som genererar flest AI-citat, vilka mätetal som resonerar mest med LLMs och vilka kundsegment som oftast citeras—använd sedan dessa insikter för att informera nästa generations fallstudier. Företag som vinner i AI-eran skriver inte bara bättre fallstudier; de behandlar fallstudier som strategiska intäktsresurser som kräver ständig optimering, mätning och förfining.

Börja med att extrahera text från dina PDF:er och mappa befintligt innehåll till ett standardiserat schema med fält som kundprofil, utmaning, lösning och resultat. Skapa sedan en lättviktig HTML- eller CMS-version av varje berättelse med tydliga rubriker och metadata, och behåll original-PDF:en som en nedladdningsbar tillgång istället för primär källa för AI-återvinning.

Marknadsföring eller produktmarknadsföring äger vanligtvis berättelsen, men sälj, lösningsingenjörer och kundframgång bör bidra med rådata, implementeringsdetaljer och validering. Juridik, dataskydd och RevOps-team hjälper till att säkerställa styrning, korrekt avidentifiering och anpassning till befintliga system som ert CRM och säljstödplattformar.

Ett headless CMS eller strukturerad innehållsplattform är idealisk för att lagra scheman och metadata, medan ett CRM eller säljstödsverktyg kan lyfta fram rätt berättelser i arbetsflödet. För AI-återvinning kombinerar du vanligtvis en vektordatabas med ett LLM-orkestreringslager som LangChain eller LlamaIndex.

Transkribera videotestimonials och webbinarier, och tagga sedan transkripten med samma fält och sektioner som dina skrivna fallstudier så att AI kan citera dem. För grafik och diagram, inkludera kort alt-text eller bildtexter som beskriver den viktigaste insikten så att återvinningsmodeller kan koppla visuella tillgångar till specifika frågor.

Behåll ditt kärnschema och ID:n konsekvent globalt, och skapa sedan översatta varianter som anpassar språk, valuta och regulatorisk kontext samtidigt som du bevarar kanoniska mätetal. Spara lokalversioner som separata men länkade objekt så att AI-system kan prioritera svar på användarens språk utan att fragmentera din datamodell.

Granska affärskritiska fallstudier minst årligen, eller tidigare om det sker stora produktändringar, nya mätetal eller förändringar i kundkontexten. Använd ett enkelt versionsarbetsflöde med senast-granskat-datum och statusflaggor för att signalera till AI-system och människor vilka berättelser som är mest aktuella.

Integrera fallstudie-återvinning direkt i de verktyg som representanter redan använder och skapa konkreta playbooks som visar hur man promptar assistenten för relevant bevis. Förstärk adoptionen genom att dela framgångshistorier där skräddarsydda, AI-framtagna fallstudier hjälpte till att stänga affärer snabbare eller låsa upp nya beslutsfattare.

Traditionella fallstudier är skrivna för mänskliga läsare med narrativt flöde och visuell design. AI-optimerade fallstudier behåller det narrativet men lägger till strukturerad metadata, konsekvent formatering, JSON-scheman och semantisk tydlighet som gör att LLMs kan extrahera, förstå och citera specifik information med över 96% noggrannhet.

Spåra hur AI-system citerar ditt varumärke i ChatGPT, Perplexity och Google AI Overviews. Få insikter om din AI-synlighet och optimera din innehållsstrategi.

Lär dig hur fallstudier rankas i AI-sökmotorer som ChatGPT, Perplexity och Google AI Overviews. Upptäck varför AI-system citerar fallstudier som auktoritativa k...

Diskussion i communityt om hur fallstudier presterar i AI-sökresultat. Riktiga erfarenheter från marknadsförare som spårar citat av fallstudier i ChatGPT, Perpl...

Lär dig hur affiliatelänkar påverkar AI-citat i ChatGPT, Perplexity och andra AI-sökmotorer. Upptäck varför trovärdighet är viktigare än länktyp och hur du opti...