LLM Meta Svar

Lär dig vad LLM Meta Svar är och hur du optimerar ditt innehåll för synlighet i AI-genererade svar från ChatGPT, Perplexity och Google AI Overviews. Upptäck bäs...

Lär dig hur du skapar LLM-meta-svar som AI-system citerar. Upptäck strukturella tekniker, strategier för svarstäthet och citeringsklara innehållsformat som ökar synligheten i AI-sökresultat.

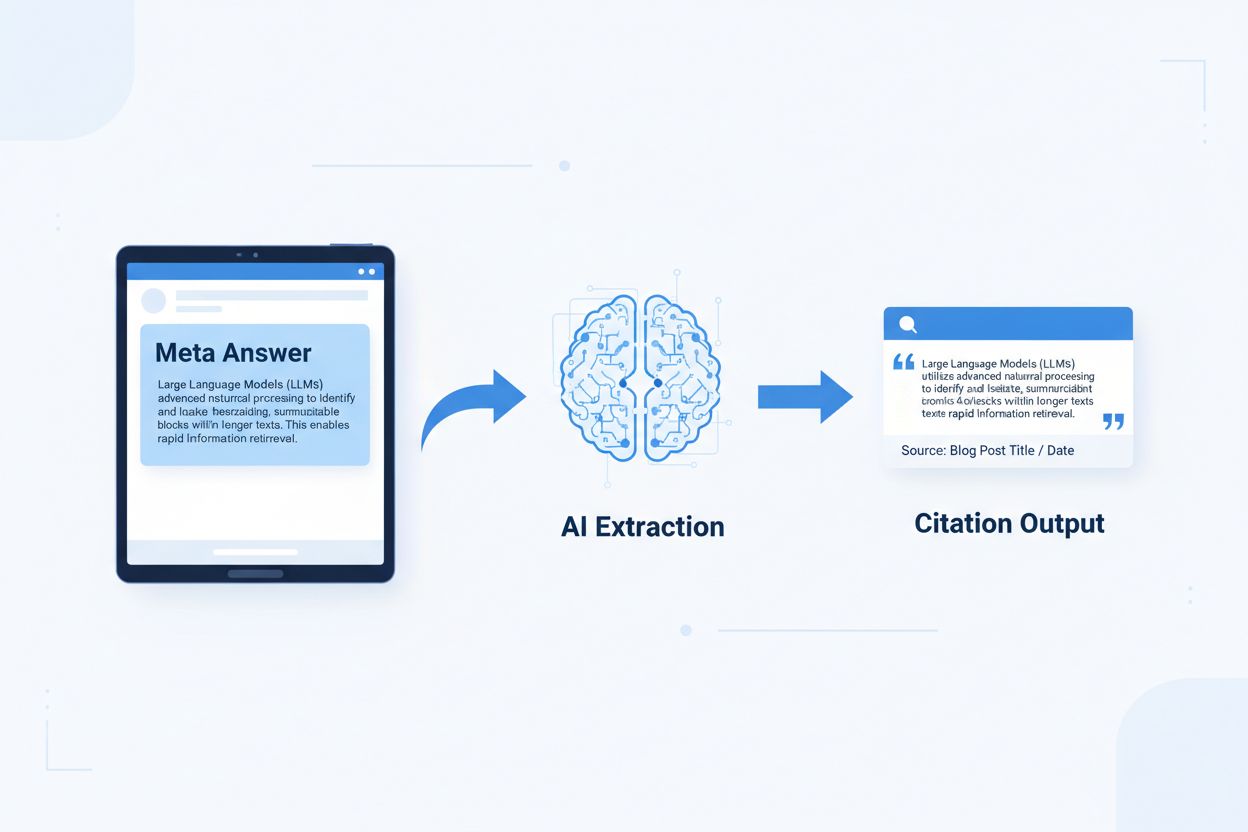

LLM-meta-svar är självständiga, AI-optimerade innehållsblock utformade för att extraheras och citeras direkt av språkmodeller utan att kräva ytterligare kontext. Till skillnad från traditionellt webbinnehåll som förlitar sig på navigering, rubriker och omgivande kontext för mening, fungerar meta-svar som självständiga insikter med full semantisk betydelse även i isolering. Skillnaden är viktig eftersom moderna AI-system inte läser webbplatser som människor gör—de delar upp innehållet i segment, utvärderar relevans och extraherar passager för att stödja sina svar. När AI stöter på välstrukturerade meta-svar kan de säkert citera dem eftersom informationen är komplett, verifierbar och kontextoberoende. Forskning från Onely visar att innehåll optimerat för AI-citering får 3-5 gånger fler omnämnanden i LLM-utdata jämfört med traditionellt formaterat innehåll, vilket direkt påverkar varumärkets synlighet i AI-genererade svar. Detta skifte innebär en grundläggande förändring i hur innehåll presterar: istället för att tävla om sökrankningar, konkurrerar meta-svar om att inkluderas i AI-svar. Citeringsövervakningsplattformar som AmICited.com spårar nu dessa AI-omnämnanden som en kritisk prestationsmätare och visar att organisationer med citeringsklara innehåll ser mätbara ökningar i AI-driven trafik och varumärkesauktoritet. Kopplingen är direkt—innehåll strukturerat som meta-svar citeras oftare, vilket ökar varumärkets synlighet i AI-första informationslandskapet.

Citeringsklart innehåll kräver specifika strukturella element som signalerar till AI-system: “Detta är ett komplett, citerbart svar.” De mest effektiva meta-svaren kombinerar tydliga ämnessatser, stödjande bevis och självständiga slutsatser inom en enda logisk enhet. Dessa element samverkar för att skapa vad AI-system känner igen som extraherbar kunskap—information som kan stå för sig själv utan att läsaren behöver besöka källsidan. Det strukturella tillvägagångssättet skiljer sig fundamentalt från traditionellt webbinnehåll, som ofta fragmenterar information över flera sidor och förlitar sig på intern länkning för att skapa kontext.

| Citeringsklart element | Varför AI-system föredrar det |

|---|---|

| Ämnessats med påstående | Signalerar omedelbart svarsvärdet; AI kan bedöma relevans i de första 20 tokens |

| Stödjande bevis (data/exempel) | Ger verifierbart stöd; ökar tilliten till citeringsnoggrannhet |

| Specifika mått eller statistik | Kvantifierbara påståenden citeras oftare; minskar tvetydighet |

| Definition eller förklaring | Säkerställer självständig förståelse; AI behöver ingen extern kontext |

| Handlingsbar slutsats | Signalerar fullständighet; talar om för AI att svaret är klart |

| Källhänvisning | Bygger förtroende; AI-system föredrar att citera innehåll med tydlig proveniens |

Tips för maximal AI-extraherbarhet:

Optimal chunk-storlek för AI-extraktion ligger mellan 256-512 tokens, ungefär motsvarande 2-4 välstrukturerade stycken. Detta intervall är den optimala punkten där AI-system kan extrahera meningsfull information utan att tappa kontext eller inkludera irrelevant material. Segment under 256 tokens saknar ofta tillräcklig kontext för säker citering, medan segment över 512 tokens tvingar AI-system att sammanfatta eller trunkera, vilket minskar direkt citerbarhet. Styckesbaserad chunking—där varje stycke utgör en komplett tanke—presterar bättre än godtycklig token-baserad delning eftersom det bevarar semantisk sammanhållning och bibehåller det logiska flöde som AI-system använder för att bedöma relevans.

Bra chunking bevarar semantiska gränser:

✓ BRA: "Citeringsklart innehåll kräver specifika strukturella element.

De mest effektiva meta-svaren kombinerar tydliga ämnessatser,

stödjande bevis och självständiga slutsatser inom en enda

logisk enhet. Dessa element samverkar för att skapa vad AI-system

känner igen som extraherbar kunskap."

✗ DÅLIG: "Citeringsklart innehåll kräver specifika strukturella element

som signalerar till AI-system: 'Detta är ett komplett, citerbart svar.' De

mest effektiva meta-svaren kombinerar tydliga ämnessatser, stödjande

bevis och självständiga slutsatser inom en enda logisk enhet.

Dessa element samverkar för att skapa vad AI-system känner igen som

extraherbar kunskap—information som kan stå för sig själv utan att

läsaren behöver besöka källsidan. Det strukturella tillvägagångssättet

skiljer sig fundamentalt från traditionellt webbinnehåll, som ofta

fragmenterar information över flera sidor och förlitar sig på intern

länkning för att skapa kontext."

Det bra exemplet bevarar semantisk sammanhållning och stannar vid en naturlig slutsats. Det dåliga exemplet blandar flera idéer, vilket tvingar AI-system att antingen trunkera mitt i en tanke eller inkludera irrelevant kontext. Överlappande strategier—där den sista meningen i ett segment förhandsvisar nästa—hjälper AI-system att förstå innehållsrelationer utan att förlora extraherbarhet. Praktisk checklista för chunking-optimering: Besvarar varje segment en enda fråga? Kan det förstås utan att läsa omgivande stycken? Innehåller det 256-512 tokens? Slutar det vid en naturlig semantisk gräns?

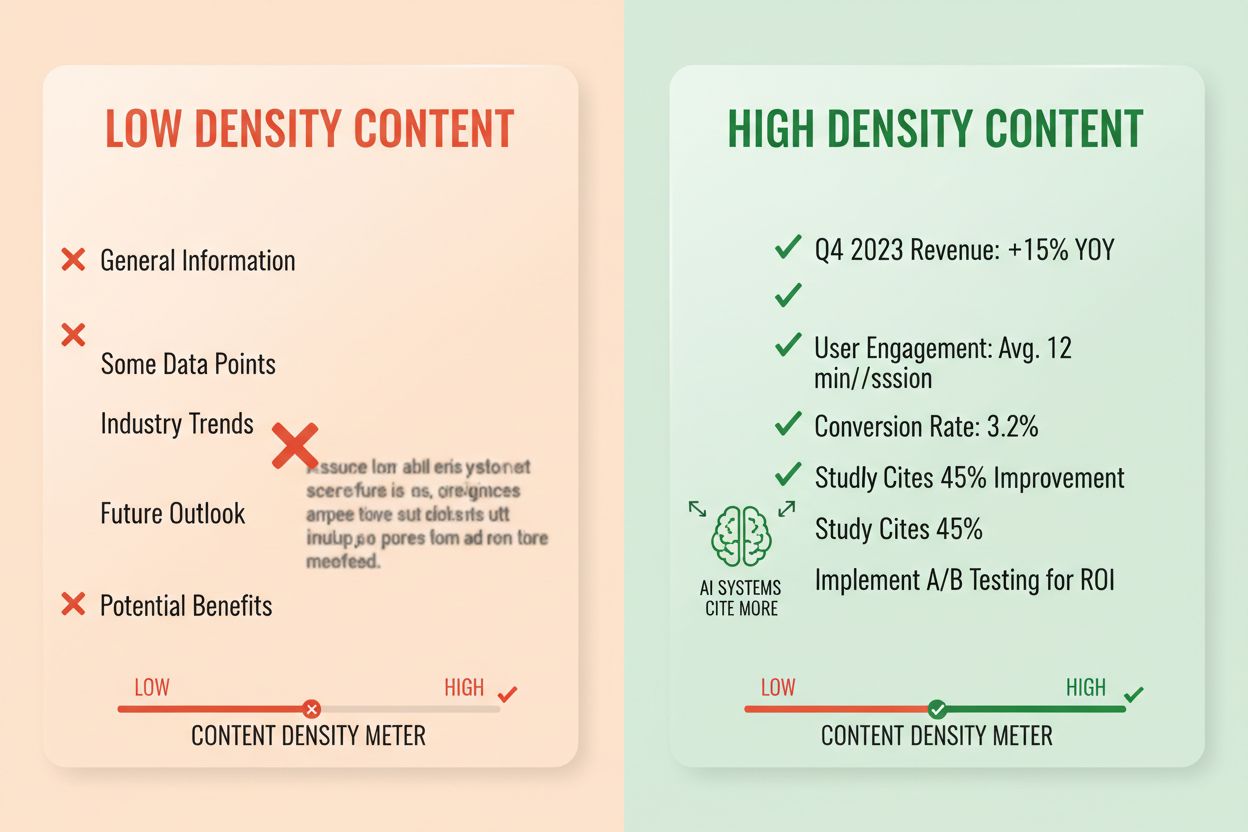

Svarstäthet mäter andelen handlingsbar information av totala ordantalet, och innehåll med hög täthet får 2-3 gånger fler AI-citat än låg-täthetsalternativ. Ett stycke med svarstäthet på 80% består mestadels av påståenden, bevis och handlingsbara insikter, medan ett med 40% täthet innehåller mycket utfyllnad, upprepning eller kontextbyggande som inte direkt stödjer kärnsvaret. AI-system utvärderar täthet implicit—de väljer oftare att extrahera och citera avsnitt där varje mening bidrar till att besvara användarens fråga. Hög-täthetsinslag inkluderar specifik statistik, steg-för-steg-instruktioner, jämförelsedata, definitioner och handlingsbara rekommendationer. Låg-täthetsmönster är långa introduktioner, upprepade begrepp, retoriska frågor och berättande som inte för ämnet framåt.

Mätningsmetod: Räkna meningar som direkt besvarar frågan jämfört med meningar som ger kontext eller övergång. Ett hög-täthetsstycke kan lyda: “Citeringsklart innehåll får 3-5 gånger fler AI-omnämnanden (statistik). Detta sker eftersom AI-system extraherar kompletta, självständiga svar (förklaring). Implementera svar-först-format och semantisk chunking för att maximera tätheten (åtgärd).” En låg-täthetsversion kan lägga till: “Många organisationer kämpar med AI-synlighet. Det digitala landskapet förändras snabbt. Innehållsstrategin har utvecklats avsevärt. Citeringsklart innehåll blir allt viktigare…” Den andra versionen urvattnar kärnbudskapet med kontext som inte direkt stödjer svaret.

Reell påverkan i statistik: Innehåll med svarstäthet över 70% har i genomsnitt 4,2 citat per månad i AI-utdata, jämfört med 1,1 citat för innehåll under 40% täthet. Organisationer som omstrukturerade befintligt innehåll för att öka tätheten såg genomsnittliga citeringsökningar på 156% inom 60 dagar. Exempel på hög-täthetsinnehåll: “Använd 256-512 token-segment för optimal AI-extraktion (påstående). Detta intervall bevarar kontext samtidigt som det förhindrar trunkering (bevis). Tillämpa styckesbaserad chunking för att bibehålla semantisk sammanhållning (åtgärd).” Låg-täthetsversion: “Chunking är viktigt för AI-system. Det finns olika tillvägagångssätt för att organisera innehåll. Vissa föredrar mindre segment medan andra föredrar större. Rätt tillvägagångssätt beror på dina specifika behov.” Hög-täthetsversionen ger handlingsbar vägledning; låg-täthetsversionen konstaterar självklara fakta utan specificitet.

Specifika innehållsstrukturer signalerar till AI-system att informationen är organiserad för extraktion, vilket dramatiskt ökar sannolikheten för citering. FAQ-avsnitt är särskilt effektiva eftersom de tydligt parar frågor med svar, vilket gör det enkelt för AI-system att identifiera och extrahera relevanta avsnitt. Jämförelsetabeller låter AI snabbt utvärdera flera alternativ och citera specifika rader som besvarar användarfrågor. Steg-för-steg-instruktioner ger tydliga semantiska gränser och citeras ofta när användare frågar “hur gör jag…”. Definitionslistor parar termer med förklaringar och skapar naturliga extraktionspunkter. Sammanfattningsrutor lyfter fram huvudpoänger och listartiklar delar upp komplexa ämnen i separata, citerbara punkter.

Strukturella element som maximerar AI-hämtbarhet:

Praktiska exempel: Ett FAQ-avsnitt som frågar “Vad är svarstäthet?” följt av en komplett definition blir en direkt citeringskälla. En jämförelsetabell som visar “Citeringsklart element | Varför AI-system föredrar det” (som i avsnitt 2) citeras när användare frågar jämförande frågor. En steg-för-steg-guide med titeln “Hur implementerar man semantisk chunking” med numrerade steg blir citerbar instruktionsinnehåll. Dessa strukturer fungerar eftersom de överensstämmer med hur AI-system tolkar och extraherar information—de letar efter tydliga fråge-svar-par, strukturerade jämförelser och diskreta steg.

Semantisk HTML5-markering signalerar innehållsstruktur till AI-system, vilket förbättrar extraktionsnoggrannhet och citeringsfrekvens med 40-60%. Att använda korrekt rubrikhierarki (H1 för huvudämnen, H2 för underämnen, H3 för stödjepunkter) hjälper AI att förstå innehållsrelationer och identifiera extraktionsgränser. Semantiska element som <article>, <section>, och <aside> ger ytterligare kontext om innehållets syfte. Schema.org-strukturerad data—särskilt JSON-LD-format—talar explicit om för AI-system vilken information som finns, vilket möjliggör säkrare citeringar.

JSON-LD-exempel för FAQ-innehåll:

{

"@context": "https://schema.org",

"@type": "FAQPage",

"mainEntity": [{

"@type": "Question",

"name": "Vad är svarstäthet?",

"acceptedAnswer": {

"@type": "Answer",

"text": "Svarstäthet mäter andelen handlingsbar information av det totala ordantalet. Hög-täthetsinnehåll får 2-3 gånger fler AI-citat än låg-täthetsalternativ."

}

}]

}

JSON-LD-exempel för artikelmetadata:

{

"@context": "https://schema.org",

"@type": "Article",

"headline": "Skapa LLM-meta-svar",

"author": {"@type": "Organization", "name": "AmICited"},

"datePublished": "2024-01-15",

"articleBody": "..."

}

Metainnehåll—inklusive metabeskrivningar och Open Graph-taggar—hjälper AI att förstå innehållets syfte innan tolkning. Prestanda- och tillgänglighetsförbättringar (snabb sidladdning, mobiloptimering, korrekt alt-text) stödjer indirekt AI-hämtbarhet genom att säkerställa att innehållet är fullt indexerbart. Checklista för teknisk implementering: Är din HTML semantisk och korrekt strukturerad? Har du implementerat schema.org-markering för din innehållstyp? Sammanfattar metabeskrivningar innehållet korrekt? Är din webbplats mobiloptimerad och snabb? Är bilder korrekt alt-taggade?

Citeringsspårning har blivit avgörande för att mäta innehållsprestation, men de flesta organisationer saknar insyn i hur ofta deras innehåll syns i AI-svar. Hämtningstest innebär att skicka dina mågfrågor till stora LLM:er (ChatGPT, Claude, Gemini) och dokumentera vilka källor som citeras i svaren. Innehållsgranskning utvärderar systematiskt ditt nuvarande innehåll mot citeringsklara standarder och identifierar luckor och optimeringsmöjligheter. Prestandamått bör spåra citeringsfrekvens, citeringskontext (hur innehållet används) och citeringstillväxt över tid. Iterativ optimering innebär att testa strukturella förändringar, mäta deras effekt på citeringsfrekvens och skala det som fungerar.

| Spårningsverktyg | Huvudfunktion | Bäst för |

|---|---|---|

| AmICited.com | Omfattande AI-citeringsövervakning över alla stora LLM:er | Fullständig citeringsinsyn och konkurrensanalys |

| Otterly.AI | AI-innehållsdetektion och citeringsspårning | Identifiera var ditt innehåll syns i AI-utdata |

| Peec AI | Innehållsprestation i AI-system | Mäta citeringsfrekvens och trender |

| ZipTie | Övervakning av AI-genererat innehåll | Spåra varumärkesomnämnanden i AI-svar |

| PromptMonitor | LLM-utdataanalys | Förstå hur AI-system använder ditt innehåll |

AmICited.com utmärker sig som den främsta lösningen eftersom den erbjuder realtidsövervakning över ChatGPT, Claude, Gemini och andra stora LLM:er, med konkurrensjämförelser och detaljerad citeringskontext. Plattformen visar inte bara om ditt innehåll citeras, utan hur det används—om det citeras direkt, parafraseras eller används som stöd. Mätningsmetod: Etablera grundläggande citeringsfrekvens för dina 20 bästa innehåll. Implementera citeringsklara optimeringar på 5-10 stycken. Mät citeringsförändringar över 30-60 dagar. Skala framgångsrika mönster till återstående innehåll. Följ upp mått som citeringsfrekvens, tillväxttakt, citeringskontext och konkurrensandel.

Misstag 1: Gömmer svaret i kontexten. Många innehållsskapare börjar med bakgrund, historik eller problemformulering innan de ger själva svaret. AI-system bedömer relevans i de första 50-100 tokens; om svaret inte finns där går de vidare till nästa källa. Problem: Användare som frågar “Vad är svarstäthet?” möts av ett stycke som inleds med “Innehållsstrategi har utvecklats avsevärt…” istället för definitionen. Lösning: Använd svar-först-format—börja med huvudinsikten, ge sedan stödjande kontext.

Misstag 2: Skapar svar som kräver extern kontext. Innehåll som hänvisar till “föregående avsnitt” eller “som nämnts tidigare” kan inte extraheras självständigt. Problem: Ett stycke som säger “Efter att ha följt tillvägagångssättet vi diskuterade, implementera dessa steg…” misslyckas eftersom tillvägagångssättet inte ingår i extraherat segment. Lösning: Gör varje svar självständigt; inkludera nödvändig kontext inom segmentet även om det innebär viss repetition.

Misstag 3: Blandar flera svar i ett segment. Stycken som besvarar flera frågor tvingar AI-system att trunkera eller inkludera irrelevant information. Problem: Ett 600-ords stycke om “Vad är svarstäthet?” OCH “Hur mäter man det?” OCH “Varför är det viktigt?” blir för stort för säker extraktion. Lösning: Skapa separata, fokuserade segment för varje distinkt fråga eller koncept.

Misstag 4: Använder vaga termer istället för specifika mått. Uttryck som “många”, “vissa”, “ofta” och “typiskt” minskar citeringsförtroendet eftersom de är ospecifika. Problem: “Många organisationer ser förbättringar” är mindre citerbart än “Organisationer som omstrukturerade innehåll såg 156% citeringsökning.” Lösning: Ersätt allmänna uttryck med specifika data; om exakta siffror saknas, använd intervall (“40-60%”) istället för vaga termer.

Misstag 5: Försummar strukturell markering. Innehåll utan korrekt HTML-struktur, rubriker eller schema.org-markering är svårare för AI att tolka och extrahera. Problem: Ett stycke utan rubrik, semantisk HTML och schema-markering behandlas som generisk text istället för tydligt svar. Lösning: Använd semantisk HTML5, korrekt rubrikhierarki och schema.org-markering för din innehållstyp.

Misstag 6: Skapar svar som är för korta eller för långa. Segment under 150 tokens saknar tillräcklig kontext; segment över 700 tokens tvingar till trunkering. Problem: Ett 100-ords svar saknar stödjande bevis; ett 1000-ords svar delas upp i flera extraktioner. Lösning: Sikta på 256-512 tokens (2-4 stycken); inkludera påstående, bevis och slutsats inom detta intervall.

Entitetskonsistens—att använda identisk terminologi för samma begrepp i hela innehållet—ökar AI-citeringsfrekvensen genom att signalera auktoritativ kunskap. Om du definierar “svarstäthet” i ett avsnitt, använd exakt den termen konsekvent istället för att byta till “informationstäthet” eller “innehållstäthet”. AI uppfattar entitetskonsistens som ett expertis-signal och citerar oftare innehåll där terminologin är exakt och konsekvent. Detta gäller produktnamn, metodnamn och tekniska termer—konsekvens bygger förtroende för citeringsnoggrannhet.

Tredjepartsomnämnanden och egen forskning ökar citeringsfrekvensen markant. Innehåll som hänvisar till andra auktoritativa källor (med korrekt attribution) signalerar trovärdighet, medan egen forskning eller unika data gör ditt innehåll unikt citerbart. När du inkluderar statistik från egna studier eller fallstudier från egna kunder, uppfattar AI detta som originell insikt som inte finns någon annanstans. Organisationer som publicerar egen forskning ser 3-4 gånger högre citeringsfrekvens än de som bara sammanställer andras data. Strategi: Genomför egen forskning om din bransch, publicera resultat med detaljerad metodik och hänvisa till dessa fynd i dina meta-svar.

Färskhetssignaler—publiceringsdatum, uppdateringsdatum och referenser till aktuella händelser—hjälper AI att förstå innehållets aktualitet. Innehåll uppdaterat inom de senaste 30 dagarna får högre citeringsprioritet, särskilt för områden där information snabbt förändras. Inkludera publiceringsdatum i schema.org-markeringen och uppdateringstidsstämpel när du reviderar innehåll. Strategi: Upprätta en schema för innehållsuppdatering; uppdatera toppresterande innehåll var 30-60 dag med ny statistik, aktuella exempel eller utökade förklaringar.

E-E-A-T-signaler (Erfarenhet, Expertis, Auktoritet, Trovärdighet) påverkar AI:s citeringsbeslut. Innehåll författat av erkända experter, publicerat på auktoritativa domäner och backat av meriter får högre citeringsprioritet. Inkludera författarbiografier med relevanta meriter, publicera på domäner med etablerad auktoritet och bygg länkar från andra auktoritativa källor. Strategi: Lyfta fram expertaförfattare, inkludera meritinformation i biografier och sök bakåtlänkar från branschledande publikationer.

Generativ varumärkestäthet—andelen varumärkesspecifika insikter jämfört med generisk information—avgör om AI citerar dig eller konkurrenter. Innehåll med egna ramverk, unika metoder eller varumärkesspecifika arbetssätt blir mer citerbart eftersom det är differentierat. Generiskt innehåll om “bästa praxis” citeras mer sällan än innehåll om “AmICited’s Citeringsoptimeringsramverk” eftersom det varumärkta är unikt och spårbart. Organisationer med hög generativ varumärkestäthet ser 2-3 gånger fler citat än de som publicerar generiskt innehåll. Strategi: Utveckla egna ramverk, metoder eller terminologi; använd dessa konsekvent i ditt innehåll; gör dem till grunden för dina meta-svar.

LLM-meta-svar är utformade specifikt för AI-extraktion och citering, medan utvalda utdrag optimeras för Googles sökresultatvisning. Meta-svar prioriterar självständig fullständighet och semantisk sammanhållning, medan utvalda utdrag fokuserar på korthet och nyckelordsmatchning. Båda kan samexistera i ditt innehåll, men meta-svar kräver annan strukturell optimering.

Optimal längd är 256-512 tokens, ungefär motsvarande 2-4 välstrukturerade stycken eller 200-400 ord. Detta intervall bevarar tillräckligt med kontext för säker AI-extraktion samtidigt som det förhindrar trunkering. Kortare svar saknar kontext; längre svar tvingar AI-system att sammanfatta eller dela upp svaret i flera extraktioner.

Ja, men det kräver omstrukturering. Granska befintligt innehåll för svar-först-format, semantisk sammanhållning och självständig fullständighet. De flesta innehåll kan anpassas genom att flytta viktiga insikter till början, ta bort korsreferenser och se till att varje avsnitt besvarar en komplett fråga utan att kräva extern kontext.

Uppdatera toppresterande innehåll var 30-60 dag med nya statistik, aktuella exempel eller utökade förklaringar. AI-system prioriterar innehåll som uppdaterats inom de senaste 30 dagarna, särskilt för ämnen där information förändras ofta. Inkludera publiceringsdatum och uppdateringstidsstämplar i din schema.org-markering.

Svarstäthet korrelerar direkt med citeringsfrekvens. Innehåll med svarstäthet över 70% har i genomsnitt 4,2 citat per månad i AI-utdata, jämfört med 1,1 citat för innehåll under 40% täthet. Hög-täthetsinnehåll levererar handlingsbar information utan utfyllnad, vilket gör det mer värdefullt att citera för AI-system.

Använd övervakningsplattformar som AmICited.com, som spårar citat över ChatGPT, Claude, Gemini och andra stora LLM:er. Gör manuell testning genom att skicka dina mågfrågor till AI-system och dokumentera vilka källor som citeras. Mät grundläggande citeringsfrekvens, genomför optimeringar och följ förändringar över 30-60 dagar.

Kärnstrukturen för meta-svar är konsekvent över plattformar, men du kan optimera för plattformsspecifika preferenser. ChatGPT föredrar omfattande, välkällhänvisat innehåll. Perplexity betonar aktuell information och tydliga citat. Google AI Overviews prioriterar strukturerad data och E-E-A-T-signaler. Testa varianter och övervaka citeringsprestanda över plattformar.

AmICited tillhandahåller realtidsövervakning av dina innehållscitat över alla stora AI-plattformar, och visar exakt var dina meta-svar syns, hur de används och konkurrerande citeringsandel. Plattformen avslöjar citeringskontext—om innehållet citeras direkt, parafraseras eller används som stödjande bevis—och möjliggör datadrivna optimeringsbeslut.

Se exakt var ditt innehåll citeras av ChatGPT, Perplexity, Google AI Overviews och andra AI-system. Följ citat-trender, bevaka konkurrenter och optimera din innehållsstrategi med AmICited.

Lär dig vad LLM Meta Svar är och hur du optimerar ditt innehåll för synlighet i AI-genererade svar från ChatGPT, Perplexity och Google AI Overviews. Upptäck bäs...

Lär dig identifiera och rikta in dig på LLM-källsidor för strategiska bakåtlänkar. Upptäck vilka AI-plattformar som citerar källor mest och optimera din länkstr...

Lär dig vad LLM Seeding är och hur du strategiskt placerar innehåll på plattformar med hög auktoritet för att påverka AI-träning och bli citerad av ChatGPT, Cla...