Datadriven PR: Skapa forskning som AI vill citera

Lär dig hur du skapar originalforskning och datadrivet PR-innehåll som AI-system aktivt citerar. Upptäck de 5 egenskaperna hos innehåll värt att citera och stra...

Lär dig hur egen enkätdata och unika statistik blir citeringsmagneter för LLM:er. Upptäck strategier för att öka AI-synligheten och få fler citeringar från ChatGPT, Perplexity och Google AI Overviews.

Stora språkmodeller hittar inte på data – de hämtar från verifierbara källor. När ditt team publicerar unika statistikuppgifter eller originella metoder, äger ni tillfälligt den kunskapen, vilket ger LLM:er en anledning att citera er för att styrka sina svar. Detta är grunden för det som IDX kallar “Authority Flywheel” – ett system där egen forskning blir din kraftfullaste citeringsmagnet.

Mekaniken är enkel: AI-modeller bedömer källor utifrån om de kan verifiera påståenden via flera kanaler. När du publicerar originell forskning skapar du en kunskapsresurs som inte finns någon annanstans på webben. Denna unikhet tvingar LLM:er att citera din källa om de vill inkludera datan i sina svar. En kampanj för The Zebra, en försäkringsplattform, visar detta tydligt – kombinationen av egen forskning och Digital PR genererade över 1 580 högkvalitativa medialänkar och ökade den organiska trafiken med 354 %.

Enligt ny forskning identifierade 48,6 % av SEO-experter Digital PR som den mest effektiva länkbyggande taktiken för 2025. Men den verkliga styrkan ligger i vad som händer sedan: när din egen data distribueras över många högnivådomäner via Digital PR, bekräftas din auktoritet i flera kunskapsnätverk samtidigt. Denna multikanalvalidering är precis vad LLM:er letar efter när de avgör om de ska citera ditt varumärke.

Den viktigaste insikten: Egen data skapar det forskare kallar “tillfälligt kunskapsägande”. Till skillnad från generiskt innehåll som konkurrerar med tusentals liknande artiklar är din originella forskning den enda källan till just den datan. Denna bristprincip gör att LLM:er oftare citerar dig, eftersom det är enda vägen att inkludera informationen i sina svar.

Att förstå hur LLM:er faktiskt hämtar och väljer källor är avgörande för att optimera för citeringar. Dessa system fungerar inte som traditionella sökmotorer. Istället arbetar de genom två olika kunskapsvägar: parametriskt minne (kunskap lagrad vid träning) och hämtad kunskap (realtidsinformation via Retrieval-Augmented Generation, eller RAG).

Parametrisk kunskap representerar allt en LLM “kan” från förträningen. Denna kunskap är statisk och fast vid modellens träningsstopp. Cirka 60 % av ChatGPT-frågor besvaras enbart utifrån parametrisk kunskap utan webbsökning. Entiteter som nämnts ofta i auktoritativa källor under träningen får starkare neurala representationer och är mer sannolika att återkallas. Wikipedia-innehåll utgör cirka 22 % av större LLM:ers träningsdata, vilket förklarar varför Wikipedia-citeringar är så vanliga i AI-genererade svar.

Hämtad kunskap fungerar annorlunda. När en LLM behöver aktuell information använder den RAG-system som kombinerar semantisk sökning (täta vektorer) med nyckelords-matchning (BM25) via Reciprocal Rank Fusion. Forskning visar att hybridretrieval ger 48 % förbättring jämfört med enskilda metoder. Systemet omprioriterar sedan resultaten med cross-encoder-modeller innan de 5–10 bästa fragmenten injiceras i LLM:ens prompt som kontext.

| Signal | Traditionell SEO-prioritet | LLM-citeringsprioritet | Varför det spelar roll |

|---|---|---|---|

| Domänauktoritet | Hög (kärnrankingfaktor) | Svag/Neutral | LLM:er prioriterar innehållsstruktur över domänstyrka |

| Länkantal | Hög (primär signal) | Svag/Neutral | LLM:er bedömer källans trovärdighet annorlunda |

| Innehållsstruktur | Medel | Kritisk | Tydliga rubriker och svarsrutor krävs för extraktion |

| Egen data | Låg | Mycket hög | Unik information tvingar fram citering |

| Varumärkessökvolym | Låg | Högst (0,334 korrelation) | Indikerar verklig auktoritet och efterfrågan |

| Färskhet | Medel | Hög | LLM:er föredrar nyligen uppdaterat innehåll |

| E-E-A-T-signaler | Medel | Hög | Författaruppgifter och transparens är viktiga |

Den avgörande skillnaden: LLM:er rankar inte sidor – de extraherar semantiska fragment. En sida med svaga traditionella SEO-mått men kristallklar struktur och egen data kan prestera bättre än en auktoritetsstark sida med otydlig positionering. Denna förändring innebär att din citeringsstrategi måste prioritera maskinläsbarhet och innehållsklarhet framför traditionella länkbyggande mått.

De mått som är viktiga för AI-synlighet har fundamentalt skiftat från traditionella SEO-signaler. I två decennier var domänauktoritet, bakåtlänkar och nyckelordsrankningar avgörande. 2025 är dessa mått nästan irrelevanta för LLM-citeringar. Istället har en ny hierarki vuxit fram – baserad på hur AI-system faktiskt utvärderar och väljer källor.

Varumärkessökvolym är nu den starkaste prediktorn för LLM-citeringar, med en korrelationskoefficient på 0,334 – betydligt högre än något traditionellt SEO-mått. Det är logiskt: om miljoner söker på ditt varumärke signalerar det verklig auktoritet och efterfrågan. LLM:er känner igen detta och värderar det högt vid citeringsbeslut. Samtidigt visar bakåtlänkar svag eller neutral korrelation mot AI-citeringar, vilket motsäger decennier av SEO-praktik.

Förändringen gäller även innehållsutvärdering. Att lägga till statistik i ditt innehåll ökar AI-synligheten med 22 %. Att inkludera citat ökar synligheten med 37 %. Originell forskning citeras tre gånger oftare än generiskt innehåll. Detta är inte marginella förbättringar – det är grundläggande förändringar i hur LLM:er bedömer källkvalitet.

| Mått | Tidigare fokus (före 2024) | Nytt fokus (2025+) | Effekt på LLM-citeringar |

|---|---|---|---|

| Länkvalitetsindikator | Domänauktoritetspoäng (DA/DR) | Ämnesrelevans & redaktionell kontext | Grundning och källdiversitet |

| Ankartextstrategi | Exakta nyckelord | Varumärkes-/entitetsomnämnanden | Entitetsigenkänning och konsekvens |

| Innehållstyp | Gästinlägg (volym) | Originell forskning/datajournalistik | 3x högre citeringssannolikhet |

| Målmätning | Ökad rankingposition | Citeringsfrekvens i AI Overviews | Förtroende och auktoritetsvalidering |

| Outreach-metod | Länkförvärv | Relationsbyggande/tillhandahålla värde | Högre redaktionell kvalitet |

Matrisen visar en viktig insikt: varumärken som vinner AI-synligheten är inte nödvändigtvis de med flest bakåtlänkar eller högst domänauktoritet. Det är de som skapar originell forskning, upprätthåller konsekventa varumärkessignaler och publicerar innehåll strukturerat för maskinell extraktion. Konkurrensfördelen har flyttat från länkvolym till innehållskvalitet och unikhet.

Egen enkätdata fyller en unik roll i AI-synlighetsstrategin. Till skillnad från generiska branschrapporter som LLM:er kan hitta från flera källor kan din originella enkätdata bara citeras från din webbplats. Det skapar en citeringsfördel som konkurrenter inte kan replikera, oavsett hur starka deras länkprofiler är.

Enkätdata fungerar eftersom det ger det LLM:er kallar “grundning” – verifierbart bevis som styrker påståenden. När du skriver “78 % av marknadsledarna prioriterar AI-synlighet” kan LLM:er citera din enkät som bevis. Utan denna egen data vore samma påstående spekulativt, och LLM:er skulle antingen hoppa över det eller citera en konkurrents forskning istället.

Den mest effektiva enkätdata besvarar specifika frågor som din målgrupp ställer:

Effekten är mätbar. Forskning visar att statistik ökar AI-synligheten med 22 %, medan citat ökar den med 37 %. Originell forskning citeras tre gånger oftare än generiskt innehåll. Dessa multiplikatorer förstärks när du kombinerar flera typer av egen data i samma innehållsresurs.

Nyckeln är transparens. LLM:er utvärderar metodik lika noggrant som resultat. Om din enkätmetodik är sund, urvalet tillräckligt stort och resultaten presenteras ärligt (inklusive begränsningar), citerar LLM:er dig med förtroende. Om metodiken är vag eller resultaten verkar vinklade, prioriterar LLM:er mer transparenta konkurrenter.

Att publicera egen data är bara halva jobbet. Den andra halvan är att strukturera datan så att LLM:er enkelt kan extrahera och citera den. Innehållsarkitektur är lika viktigt som datan i sig.

Börja med direkta svar. LLM:er föredrar innehåll som inleds med svaret, inte resan dit. Istället för “Vi genomförde en enkät för att förstå marknadsprioriteringar, och här är resultatet”, skriv “78 % av marknadsledarna prioriterar nu AI-synlighet i sin strategi för 2025.” Denna direkta struktur gör det enklare att extrahera och ökar citeringssannolikheten.

Optimal styckeslängd för LLM-extraktion är 40–60 ord. Då kan LLM:er hämta en hel tanke utan att den kapas. Längre stycken delas upp och kan tappa kontext. Kortare stycken kan sakna tillräcklig information för att vara användbara.

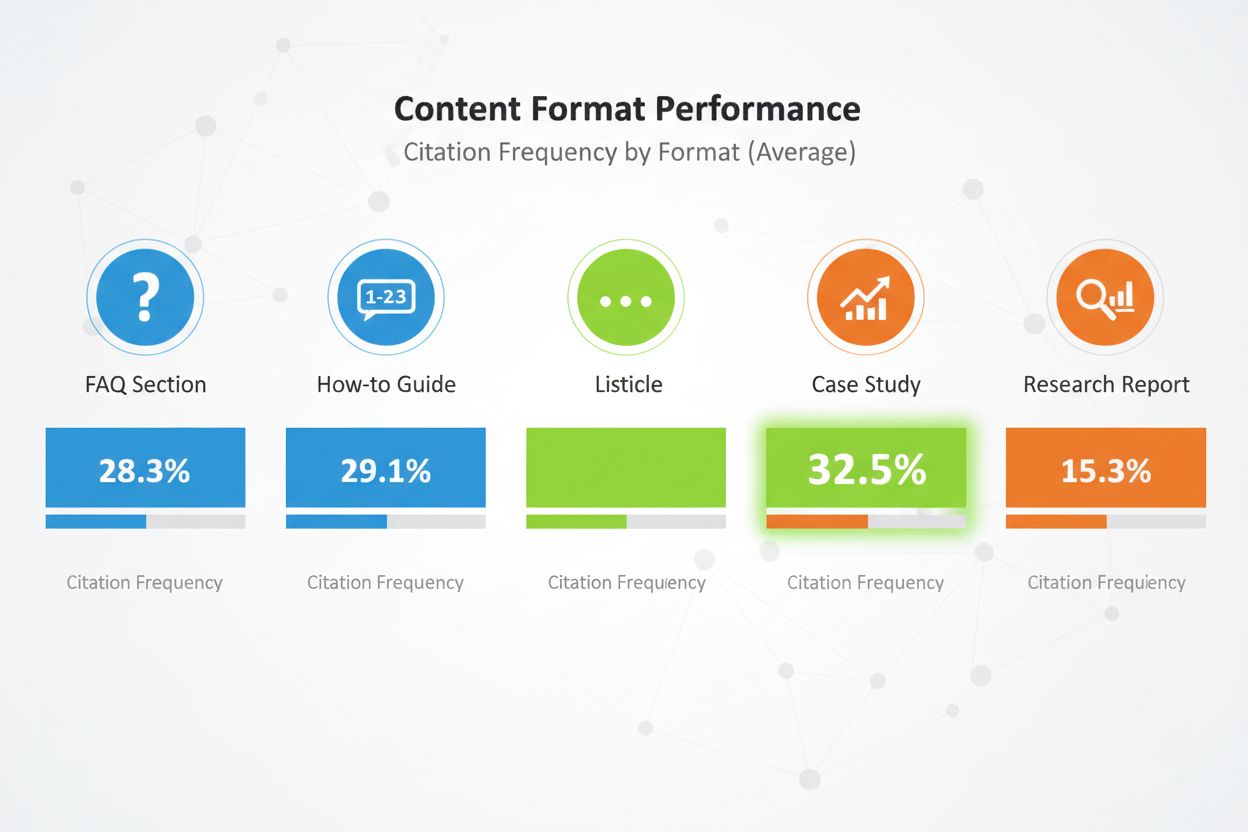

Innehållsformat spelar stor roll. Jämförande listiklar får 32,5 % av alla AI-citeringar – högst av alla format. FAQ-avsnitt fungerar särskilt bra eftersom de matchar hur användare frågar AI-system. Instruktionsguider, fallstudier och forskningsrapporter fungerar också bra, men listiklar överpresterar konsekvent.

Strukturera innehållet med tydlig rubrikhierarki. Använd H2-rubriker som speglar troliga sökfrågor. Under varje H2, använd H3 för underteman. Denna hierarki hjälper LLM:er att förstå strukturen och extrahera relevanta avsnitt.

Implementera E-E-A-T-signaler överallt. Inkludera författarbios med meriter och verklig erfarenhet. Länka till tredjepartsvalidering av dina påståenden. Var transparent med metodiken. Citerar dina källor. Dessa signaler talar om för LLM:er att ditt innehåll är pålitligt och värt att citera.

Använd semantisk HTML. Strukturera data med riktiga <table>, <ul> och <ol>-taggar istället för CSS-stylade divar. Det gör innehållet lättare för AI att tolka och sammanfatta. Inkludera schema-markup (Article, FAQPage, HowTo) för ytterligare kontext om innehållstypen.

Slutligen – uppdatera innehållet regelbundet. LLM:er föredrar färskare innehåll, särskilt för tidskänslig data. Om din enkät är från 2024, uppdatera den 2025. Lägg till “Senast uppdaterad”-stämplar för att visa att du aktivt underhåller innehållet. Det signalerar för LLM:er att din data är aktuell och pålitlig.

Att publicera egen data på din webbplats är nödvändigt men otillräckligt. LLM:er upptäcker innehåll via flera kanaler, och din distributionsstrategi avgör hur många av dessa kanaler som bär din data.

Digital PR är den effektivaste distributionskanalen för egen data. När din forskning syns i branschpublikationer, nyhetsmedia och auktoritativa bloggar skapas många citeringsmöjligheter. LLM:er indexerar dessa tredjepartsomnämnanden och använder dem för att validera din ursprungskälla. Ett varumärke som syns på 4+ plattformar är 2,8 gånger mer sannolikt att citeras i ChatGPT-svar jämfört med varumärken med begränsad närvaro.

Effektiva distributionskanaler inkluderar:

Varje kanal fyller en funktion. Pressmeddelanden ger initial synlighet och medietäckning. Branschmedia ger trovärdighet och når beslutsfattare. LinkedIn når yrkespersoner i stor skala. Reddit visar communityförtroende. Recensionsplattformar ger strukturerad data som LLM:er enkelt kan tolka.

Multiplikatoreffekten är stor. När din egen data syns i flera auktoritativa källor ser LLM:er konsekventa signaler över webben. Denna konsekvens ökar förtroendet för din data och gör citering mer trolig. Ett enda omnämnande på din egen webbplats kan förbises. Samma data omnämnd på din sida, i ett pressmeddelande, i en branschpublikation och på en recensionsplattform blir omöjlig att ignorera.

Timing är också viktigt. Distribuera egen data strategiskt. Släpp den först på din webbplats med ett pressmeddelande. Följ upp med placeringar i branschmedia. Amplifiera sedan via sociala kanaler och community-engagemang. Denna stegvisa process skapar en våg av synlighet snarare än en ensam topp.

Att publicera egen data utan att mäta effekten är som att annonsera utan att spåra konverteringar. Du behöver se om din data faktiskt ger citeringar och förbättrar din AI-synlighet.

Börja med att spåra citeringsfrekvens. Identifiera 20–50 viktiga köparfrågor som din egen data besvarar. Fråga stora AI-plattformar (ChatGPT, Perplexity, Claude, Google AI Overviews) månatligen med dessa frågor. Dokumentera om ditt varumärke nämns, på vilken position, och om citeringen innehåller en länk till din webbplats.

Beräkna din citeringsfrekvens i procent: (Antal prompts där du nämns) / (Totalt antal prompts) × 100. Sikta på 30 % eller högre för kärnfrågor inom din kategori. Toppvarumärken i konkurrensutsatta kategorier når över 50 % citeringsfrekvens.

Spåra AI Share of Voice (AI SOV) genom att köra identiska prompts och räkna din andel av alla varumärkesomnämnanden. Om ditt varumärke syns i 3 av 10 AI-svar och konkurrenter i 2 vardera är din AI SOV 30 %. I konkurrensutsatta kategorier bör du sikta på AI SOV som överstiger din traditionella marknadsandel med 10–20 %.

Övervaka sentimentsanalys. Utöver omnämnanden, mät om AI-system beskriver ditt varumärke positivt, neutralt eller negativt. Använd verktyg som Profound AI som specialiserar sig på hallucinationsdetektion – alltså att identifiera när AI ger falsk eller föråldrad information om ditt varumärke. Sikta på minst 70 % positiva omnämnanden över AI-plattformar.

Sätt upp en Knowledge-Based Indicator (KBI)-dashboard som spårar:

Uppdatera dessa mått månadsvis. Se efter trender snarare än enstaka datapunkter. En enda månad med låg citeringsfrekvens kan vara brus. Tre månader med minskande citeringar kräver åtgärd.

Att manuellt spåra citeringar av egen data är tidskrävande och felbenäget. AmICited.com erbjuder infrastrukturen för att övervaka din AI-synlighet i stor skala, särskilt utformat för varumärken som använder egen data som citeringsstrategi.

Plattformen övervakar hur AI-system citerar din egen forskning i ChatGPT, Perplexity, Google AI Overviews, Claude, Gemini och nya AI-plattformar. Istället för att manuellt fråga varje plattform varje månad, automatiserar AmICited processen, kör dina målfrågor kontinuerligt och spårar citeringsmönster i realtid.

Nyckelfunktioner inkluderar:

Plattformen integreras med din befintliga analysstack och matar in AI-citeringsdata i dina marknadsdashboards tillsammans med traditionella SEO-mått. Denna samlade vy hjälper dig förstå den fulla effekten av din datastrategi på varumärkessynlighet och pipeline.

För varumärken som satsar seriöst på AI-synlighet ger AmICited den mätinfrastruktur som gör optimering möjlig. Du kan inte förbättra det du inte mäter, och traditionella analysverktyg är inte designade för att spåra LLM-citeringar. AmICited fyller det gapet och ger dig insynen du behöver för att maximera ROI på dina investeringar i egen data.

Även välmenande strategier kring egen data misslyckas ofta på grund av undvikbara misstag. Att förstå dessa fallgropar hjälper dig att undvika dem.

Det vanligaste misstaget är att gömma data bakom “Kontakta sälj”-formulär. LLM:er kan inte se låst innehåll och förlitar sig istället på ofullständig eller spekulativ information från forum. Om enkätresultaten är dolda citerar LLM:er ett Reddit-inlägg om din produkt istället för din officiella forskning. Publicera viktiga resultat öppet med transparent metodik. Du kan låsa detaljerade rapporter, men låt sammanfattande data och insikter vara publika.

Inkonsekvent terminologi skapar förvirring. Om din webbplats kallar produkten “marknadsföringsautomationsplattform” medan din LinkedIn säger “CRM-programvara”, har LLM:er svårt att bygga en koherent bild. Använd konsekvent kategorispråk överallt. Definiera din terminologikarta och tillämpa den på webbplats, LinkedIn, Crunchbase och andra plattformar.

Saknade författaruppgifter minskar förtroendet. LLM:er utvärderar E-E-A-T-signaler noggrant. Om din enkät saknar författarbios med verkliga meriter nedprioriteras den. Inkludera detaljerade bios med relevant erfarenhet, certifikat och tidigare publikationer. Länka till författarprofiler på LinkedIn och andra plattformar.

Föråldrad statistik skadar trovärdigheten. Om din enkät är från 2023 men du fortfarande hänvisar till den 2025 märker LLM:er det. Uppdatera forskningen regelbundet. Lägg till “Senast uppdaterad”-stämplar. Gör nya enkäter varje år för att bibehålla färskhet. LLM:er föredrar aktuell data, särskilt för tidskänsliga ämnen.

Oklar metodik minskar citeringssannolikheten. Om enkätmetodiken inte är transparent ifrågasätter LLM:er resultaten. Publicera metodiken öppet. Beskriv urvalsstorlek, urvalsmetod, undersökningsperiod och begränsningar. Transparens bygger förtroende.

Keyword-stuffing i innehåll om egen data fungerar sämre i AI-system än i traditionell sök. LLM:er upptäcker och straffar konstlat språk. Skriv naturligt. Fokusera på tydlighet och precision snarare än nyckelordsdensitet. Din data ska kännas som genuin forskning, inte marknadsföring.

Tunt innehåll kring din egna data straffas. Ett enda stycke om enkätresultaten räcker inte. Skapa omfattande innehåll som utforskar implikationer, ger sammanhang och besvarar följdfrågor. Sikta på minst 2 000 ord substantiellt innehåll kring varje stor egen datatillgång.

Exempel från verkligheten visar kraften i egen data för AI-synlighet. Dessa varumärken satsade på originell forskning och såg mätbara resultat.

The Zebra:s Digital PR-framgång: The Zebra, en jämförelsetjänst för försäkringar, kombinerade egen forskning med Digital PR och genererade över 1 580 kvalitetslänkar och en ökning av organisk trafik med 354 %. Genom att publicera originell försäkringsstatistik och distribuera den via earned media blev The Zebra en självklar källa för försäkringsdata. LLM:er citerar nu ofta Zebras forskning om branschtrender och priser.

Tallys community-engagemang: Tally, en online-enkättjänst, ökade sin AI-synlighet genom att aktivt delta i forum och dela sin produktutveckling. Istället för att bara publicera forskning blev Tally en betrodd röst i användargemenskaper. Detta autentiska engagemang gjorde ChatGPT till en av de främsta källorna för nya användare, med kraftigt ökade veckoregistreringar. Genom att grunda GPT-4 i kuraterade, kontextspecifika bevis ökade Tally faktakorrektheten från 56 % till 89 %.

HubSpots forskningsprogram: HubSpot publicerar regelbundet rapporter om marknadstrender, säljframgång och kundservice. Dessa rapporter har blivit branschstandard som LLM:er ofta citerar. HubSpots satsning på kontinuerlig forskning har gjort varumärket synonymt med marknadsdata och insikter. När LLM:er besvarar frågor om marknadstrender syns HubSpots forskning återkommande.

Dessa fallstudier har gemensamt: originell forskning, transparent metodik, konsekvent distribution och kontinuerliga uppdateringar. Ingen av dessa varumärken förlitade sig på ett enskilt forskningsprojekt utan byggde program som ständigt genererar ny egen data och därmed varaktig citeringsfördel.

Lärdomen är tydlig: Egen data är ingen engångstaktik. Det är en strategisk investering i att bli den auktoritativa källan i din kategori. Varumärken som satsar på regelbunden forskning, transparent metodik och strategisk distribution får kontinuerliga citeringar från LLM:er och bygger långsiktig konkurrensfördel i AI-synlighet.

Du behöver inte enorma datamängder. Även en riktad enkät med 100–500 svarande kan ge värdefulla egna insikter som LLM:er kommer att citera. Det viktiga är att datan är originell, att metoden är transparent och att resultaten är användbara. Kvalitet och unikhet är viktigare än kvantitet.

Kundnöjdhetsundersökningar, branschtrender, konkurrensanalys, studier av användarbeteenden och marknadsstorleksundersökningar fungerar alla bra. Den bästa datan besvarar specifika frågor som din målgrupp ställer och ger insikter som konkurrenterna saknar.

Realtidsplattformar som Perplexity kan citera färska data inom några veckor. ChatGPT och andra modeller med mindre frekventa uppdateringar kan ta 2–3 månader. Kontinuerlig, högkvalitativ egen data ger oftast mätbara ökningar av citeringar inom 3–6 månader.

Nej. LLM:er kan inte komma åt låst innehåll och kommer istället att förlita sig på ofullständig eller spekulativ information från forum. Publicera viktiga resultat öppet med transparent metodik. Du kan låsa detaljerade rapporter, men håll sammanfattande data och insikter publikt tillgängliga.

Använd tydlig och konsekvent terminologi på alla plattformar. Inkludera transparent metodik i din forskning. Lägg till författaruppgifter och certifikat. Länka till tredjepartsvalidering. Använd schema-markup för att strukturera din data. Övervaka citeringar månadsvis och rätta felaktigheter snabbt.

Ja. Originell forskning ger ofta länkar och mediauppmärksamhet, vilket förbättrar traditionella rankningar. Dessutom skapar egen data innehåll som är mer heltäckande och auktoritativt, vilket hjälper både traditionell SEO och AI-synlighet.

Egen data är originell forskning som du själv genomför. Generiska rapporter finns tillgängliga överallt. LLM:er föredrar egen data eftersom den är unik och bara kan citeras från din källa. Det ger en citeringsfördel som konkurrenterna inte enkelt kan kopiera.

Spåra citeringsfrekvens, AI Share of Voice, varumärkessökvolym och trafik från AI-plattformar. Jämför dessa mått före och efter publicering av egen data. Beräkna värdet av AI-hänvisad trafik (ofta 4,4x högre konverteringsgrad än traditionell organisk) för att avgöra ROI.

Övervaka hur AI-system citerar din egen data i ChatGPT, Perplexity, Google AI Overviews med flera. Få insikter i realtid om din AI-synlighet och konkurrensposition.

Lär dig hur du skapar originalforskning och datadrivet PR-innehåll som AI-system aktivt citerar. Upptäck de 5 egenskaperna hos innehåll värt att citera och stra...

Lär dig hur akademiska citeringar påverkar din synlighet i AI-genererade svar. Upptäck varför citeringar är viktigare än trafik för AI-sökmotorer och hur du opt...

Diskussion i communityn om huruvida citering av myndighetskällor förbättrar AI-synlighet. Verkliga erfarenheter från innehållsskapare som har testat auktoritati...