Hur du konfigurerar robots.txt för AI-crawlers: Komplett guide

Lär dig hur du konfigurerar robots.txt för att kontrollera AI-crawler-åtkomst, inklusive GPTBot, ClaudeBot och Perplexity. Hantera din varumärkesexponering i AI...

Lär dig hur webbapplikationsbrandväggar ger avancerad kontroll över AI-crawlers bortom robots.txt. Implementera WAF-regler för att skydda ditt innehåll mot obehörig AI-skrapning och övervaka AI-citeringar med AmICited.

Otillräckligheten hos robots.txt som en ensam försvarsmekanism har blivit alltmer tydlig i en era av AI-driven konsumtion av innehåll. Medan traditionella sökmotorer generellt respekterar robots.txt-direktiv, arbetar moderna AI-crawlers med fundamentalt andra incitament och genomförandemekanismer, vilket gör enkla textbaserade policyer otillräckliga för att skydda innehåll. Enligt Cloudflares analys står AI-crawlers nu för nästan 80 % av all bottrafik till webbplatser, där träningscrawlers konsumerar enorma mängder innehåll och ger minimal hänvisningstrafik tillbaka—OpenAI:s crawlers har ett 400:1-förhållande mellan crawling och hänvisning, medan Anthropics är så högt som 38 000:1. För utgivare och innehållsägare utgör denna asymmetriska relation ett kritiskt affärshot, eftersom AI-modeller tränade på deras innehåll direkt kan minska organisk trafik och sänka värdet på deras immateriella rättigheter.

En Webbapplikationsbrandvägg (WAF) fungerar som en omvänd proxy placerad mellan användare och webbservrar, och inspekterar varje HTTP-förfrågan i realtid för att filtrera oönskad trafik baserat på konfigurerbara regler. Till skillnad från robots.txt, som litar på frivillig följsamhet från crawlers, upprätthåller WAF:er skydd på infrastrukturnivå, vilket gör dem betydligt effektivare för att kontrollera AI-crawleråtkomst. Följande jämförelse visar hur WAF:er skiljer sig från traditionella säkerhetsmetoder:

| Funktion | Robots.txt | Traditionell brandvägg | Modern WAF |

|---|---|---|---|

| Genomförandenivå | Rådgivande/frivillig | IP-baserad blockering | Applikationsmedveten inspektion |

| AI-crawlerdetektering | Endast user-agent-matchning | Begränsad botigenkänning | Beteendeanalys + fingeravtryck |

| Realtidsanpassning | Statisk fil | Manuella uppdateringar krävs | Kontinuerlig hotinformation |

| Granulär kontroll | Endast sökvägsnivå | Breda IP-intervall | Policys på förfrågningsnivå |

| Maskininlärning | Ingen | Ingen | Avancerad botklassificering |

WAF:er tillhandahåller granulär botklassificering genom att använda enhetsfingeravtryck, beteendeanalys och maskininlärning för att profilera bots utifrån avsikt och sofistikering, vilket möjliggör betydligt mer nyanserad kontroll än enkla tillåt/blockera-regler.

AI-crawlers delas in i tre distinkta kategorier, var och en med olika hot och kräver olika skyddsstrategier. Träningscrawlers som GPTBot, ClaudeBot och Google-Extended samlar systematiskt in webbplatsinnehåll för att bygga dataset för utveckling av stora språkmodeller, står för cirka 80 % av all AI-crawlertrafik och ger inget hänvisningsvärde till utgivare. Sök- och citeringscrawlers såsom OAI-SearchBot och PerplexityBot indexerar innehåll för AI-drivna sökupplevelser och kan ge viss hänvisningstrafik via citeringar, men i betydligt lägre volymer än traditionella sökmotorer. Användaraktiverade hämtare aktiveras endast när användare specifikt ber om innehåll via AI-assistenter, vilket sker i mycket låg omfattning med enskilda förfrågningar snarare än systematiska crawlingmönster. Hotlandskapet omfattar:

Moderna WAF:er använder sofistikerade tekniska detektionsmetoder som går långt bortom enkel matchning av user-agent-strängar för att identifiera och klassificera AI-crawlers med hög noggrannhet. Dessa system använder beteendeanalys för att undersöka förfrågningsmönster, inklusive crawl-hastighet, sekvensering av förfrågningar och responskaraktäristik som särskiljer bots från människor. Enhetsfingeravtryck analyserar HTTP-headrar, TLS-signaturer och webbläsaregenskaper för att identifiera förfalskade user agents som försöker kringgå traditionella försvar. Maskininlärningsmodeller tränade på miljontals förfrågningar kan upptäcka nya crawler-signaturer och nya bottekniker i realtid, och anpassar sig till nya hot utan att manuella regler måste uppdateras. Dessutom kan WAF:er verifiera crawlerns legitimitet genom att korsreferera begärande IP-adresser mot publicerade IP-intervall som underhålls av stora AI-företag—OpenAI publicerar verifierade IP-adresser på https://openai.com/gptbot.json, medan Amazon tillhandahåller sina på https://developer.amazon.com/amazonbot/ip-addresses/—och säkerställer att endast autentiserade crawlers från legitima källor släpps igenom.

Att implementera effektiva WAF-regler för AI-crawlers kräver ett flerskiktat angreppssätt som kombinerar user-agent-blockering, IP-verifiering och beteendepolicys. Följande kodexempel visar en grundläggande WAF-regelkonfiguration som blockerar kända träningscrawlers samtidigt som legitim sökfunktionalitet tillåts:

# WAF-regel: Blockera AI-träningscrawlers

Regelnamn: Block-AI-Training-Crawlers

Villkor 1: HTTP User-Agent matchar (GPTBot|ClaudeBot|anthropic-ai|Google-Extended|Meta-ExternalAgent|Amazonbot|CCBot|Bytespider)

Åtgärd: Blockera (returnera 403 Forbidden)

# WAF-regel: Tillåt verifierade sökcrawlers

Regelnamn: Allow-Verified-Search-Crawlers

Villkor 1: HTTP User-Agent matchar (OAI-SearchBot|PerplexityBot)

Villkor 2: Käll-IP inom verifierat IP-intervall

Åtgärd: Tillåt

# WAF-regel: Begränsa misstänkt bottrafik

Regelnamn: Rate-Limit-Suspicious-Bots

Villkor 1: Begärandehastighet överstiger 100 förfrågningar/minut

Villkor 2: User-Agent innehåller botindikatorer

Villkor 3: Ingen verifierad IP-match

Åtgärd: Utmana (CAPTCHA) eller Blockera

Organisationer bör implementera regelprioritering noggrant, så att mer specifika regler (som IP-verifiering för legitima crawlers) körs före bredare blockregler. Regelbunden testning och övervakning av reglers effektivitet är avgörande, eftersom crawler user-agent-strängar och IP-intervall ofta förändras. Många WAF-leverantörer erbjuder förbyggda regeluppsättningar specifikt för AI-crawlerhantering, vilket minskar implementeringskomplexiteten och upprätthåller ett heltäckande skydd.

IP-verifiering och vitlistning är den mest tillförlitliga metoden för att särskilja legitima AI-crawlers från förfalskade förfrågningar, eftersom user-agent-strängar är lätta att förfalska medan IP-adresser är betydligt svårare att förfalska i stor skala. Stora AI-företag publicerar officiella IP-intervall i JSON-format, vilket möjliggör automatiserad verifiering utan manuell hantering—OpenAI tillhandahåller separata IP-listor för GPTBot, OAI-SearchBot och ChatGPT-User, medan Amazon har en omfattande lista för Amazonbot. WAF-regler kan konfigureras för att vitlista endast förfrågningar som kommer från dessa verifierade IP-intervall, vilket effektivt hindrar illasinnade aktörer från att kringgå begränsningar genom att bara ändra user-agent-headern. För organisationer som använder servernivåblockering via .htaccess eller brandväggsregler ger kombinationen av IP-verifiering och user-agent-matchning ett djupförsvar som fungerar oberoende av WAF-konfiguration. Dessutom respekterar vissa crawlers HTML meta-taggar som <meta name="robots" content="noarchive">, vilket signalerar till följsamma crawlers att innehållet inte ska användas för modellträning, och ger en kompletterande kontroll för utgivare som vill ha granulärt skydd på sidnivå.

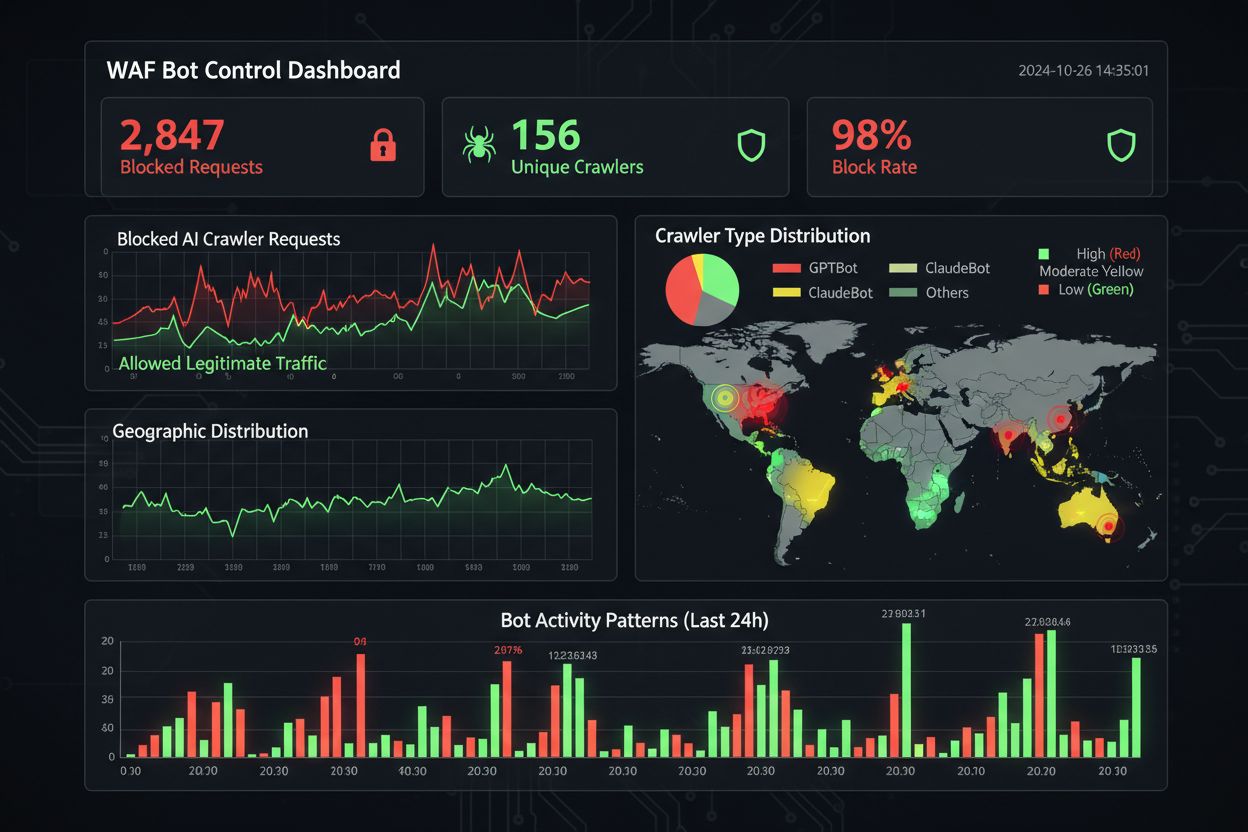

Effektiv övervakning och efterlevnad kräver kontinuerlig insyn i crawleraktivitet och verifiering av att blockregler fungerar som avsett. Organisationer bör regelbundet analysera serveråtkomstloggar för att identifiera vilka crawlers som får åtkomst till deras webbplatser och om blockerade crawlers fortfarande gör förfrågningar—Apache-loggar finns vanligtvis i /var/log/apache2/access.log medan Nginx-loggar finns i /var/log/nginx/access.log, och grep-baserad filtrering kan snabbt identifiera misstänkta mönster. Analysplattformar skiljer alltmer på bottrafik och mänskliga besökare, vilket möjliggör mätning av effekten av crawlerblockering på legitima mätvärden som avvisningsfrekvens, konverteringsspårning och SEO-prestanda. Verktyg som Cloudflare Radar ger global översikt över AI-bottrafikmönster och kan identifiera nya crawlers som ännu inte finns på din blocklista. Ur ett efterlevnadsperspektiv genererar WAF-loggar revisionsspår som visar att organisationen har implementerat rimliga säkerhetsåtgärder för att skydda kunddata och immateriella rättigheter, vilket blir allt viktigare för GDPR, CCPA och andra dataskyddsregler. Kvartalsvisa genomgångar av din crawlerblocklista är avgörande, eftersom nya AI-crawlers tillkommer regelbundet och befintliga crawlers uppdaterar sina user-agent-strängar—det communityunderhållna ai.robots.txt-projektet på GitHub

är en värdefull resurs för att hålla koll på nya hot.

Att balansera innehållsskydd med affärsmål kräver noggrann analys av vilka crawlers som ska blockeras kontra tillåtas, eftersom alltför aggressiv blockering kan minska synligheten i nya AI-drivna upptäcktskanaler. Att blockera träningscrawlers som GPTBot och ClaudeBot skyddar immateriella rättigheter men har ingen direkt trafikpåverkan, då dessa crawlers aldrig skickar hänvisningstrafik. Däremot kan blockering av sökcrawlers som OAI-SearchBot och PerplexityBot minska synligheten i AI-drivna sökresultat där användare aktivt söker efter källor och citeringar—en avvägning som beror på din innehållsstrategi och målgrupp. Vissa utgivare utforskar alternativa angreppssätt, till exempel att tillåta sökcrawlers men blockera träningscrawlers, eller att införa pay-per-crawl-modeller där AI-företag kompenserar utgivare för åtkomst till innehåll. Verktyg som AmICited.com hjälper utgivare att spåra om deras innehåll citeras i AI-genererade svar och ger data för att fatta blockbeslut. Den optimala WAF-konfigurationen beror på din affärsmodell: nyhetsutgivare kan prioritera att blockera träningscrawlers för att skydda innehåll men tillåta sökcrawlers för synlighet, medan SaaS-företag kan välja att blockera alla AI-crawlers för att hindra konkurrenter från att analysera priser och funktioner. Regelbunden övervakning av trafikmönster och intäktsmätvärden efter att WAF-regler har implementerats säkerställer att din skyddsstrategi är i linje med faktiska affärsresultat.

Vid jämförelse av WAF-lösningar för AI-crawlerhantering bör organisationer utvärdera flera viktiga funktioner som särskiljer företagsklassade plattformar från enklare alternativ. Cloudflares AI Crawl Control integreras med dess WAF för att tillhandahålla färdigbyggda regler för kända AI-crawlers, med möjligheten att blockera, tillåta eller införa pay-per-crawl-intäktsmodeller för specifika crawlers—plattformens prioritetsordning säkerställer att WAF-regler körs före andra säkerhetslager. AWS WAF Bot Control erbjuder både grundläggande och riktat skydd, där det riktade skyddet använder webbläsarinterrogation, fingeravtryck och beteendeheuristik för att upptäcka sofistikerade bots som inte identifierar sig själva, samt valfri maskininlärningsanalys av trafikstatistik. Azure WAF erbjuder liknande funktioner genom sina hanterade regeluppsättningar, men med mindre AI-specifik specialisering än Cloudflare eller AWS. Förutom dessa större plattformar erbjuder specialiserade bot-hanteringslösningar från leverantörer som DataDome avancerade maskininlärningsmodeller som tränats specifikt på AI-crawlerbeteende, men till högre kostnad. Valet av lösning beror på din befintliga infrastruktur, budget och önskad sofistikeringsnivå—organisationer som redan använder Cloudflare drar nytta av sömlös integration, medan AWS-kunder kan utnyttja Bot Control inom sin befintliga WAF-infrastruktur.

Bästa praxis för AI-crawlerhantering betonar ett djupförsvar där flera kontrollmekanismer kombineras snarare än att förlita sig på en enda lösning. Organisationer bör genomföra kvartalsvisa blocklistgranskningar för att fånga nya crawlers och uppdaterade user-agent-strängar, upprätthålla serverlogg-analys för att verifiera att blockerade crawlers inte kringgår regler, och regelbundet testa WAF-konfigurationer för att säkerställa att regler körs i rätt ordning. Framtiden för WAF-teknik kommer i allt högre grad att integrera AI-drivna hotdetektering som anpassar sig i realtid till nya crawlertaktiker, med integration i bredare säkerhetsekosystem för kontextmedvetet skydd. I takt med att regler kring dataskrapning och AI-träningsdata skärps kommer WAF:er att bli avgörande efterlevnadsverktyg snarare än valbara säkerhetsfunktioner. Organisationer bör börja implementera omfattande WAF-regler för AI-crawlers redan nu, innan nya hot som AI-agenter i webbläsare och headless-browser-crawlers blir utbredda—kostnaden för passivitet, mätt i förlorad trafik, komprometterad analys och potentiell juridisk risk, överstiger vida investeringen i en robust skyddsinfrastruktur.

Robots.txt är en rådgivande fil som bygger på att crawlers frivilligt respekterar dina direktiv, medan WAF-regler upprätthålls på infrastrukturnivå och gäller för alla förfrågningar oavsett crawlerns följsamhet. WAF:er ger realtidsdetektering och blockering, medan robots.txt är statisk och lätt kan kringgås av icke-följsamma crawlers.

Ja, många AI-crawlers ignorerar robots.txt-direktiv eftersom de är utformade för att maximera insamling av träningsdata. Medan välbeteende crawlers från stora företag generellt respekterar robots.txt, gör inte illasinnade aktörer och vissa nya crawlers det. Därför ger WAF-regler ett mer tillförlitligt skydd.

Kontrollera dina serveråtkomstloggar (oftast i /var/log/apache2/access.log eller /var/log/nginx/access.log) efter user-agent-strängar som innehåller bot-identifikationer. Verktyg som Cloudflare Radar ger global insyn i AI-crawlertrafikmönster, och analysplattformar skiljer alltmer på bottrafik och mänskliga besökare.

Att blockera träningscrawlers som GPTBot har ingen direkt SEO-påverkan eftersom de inte skickar hänvisningstrafik. Men att blockera sökcrawlers som OAI-SearchBot kan minska synligheten i AI-drivna sökresultat. Googles AI Overviews följer vanliga Googlebot-regler, så blockering av Google-Extended påverkar inte vanlig sökindexering.

Cloudflares AI Crawl Control, AWS WAF Bot Control och Azure WAF erbjuder alla effektiva lösningar. Cloudflare har de mest AI-specifika funktionerna med förbyggda regler och pay-per-crawl-alternativ. AWS erbjuder avancerad maskininlärningsdetektering, medan Azure har solida hanterade regeluppsättningar. Välj baserat på din befintliga infrastruktur och budget.

Granska och uppdatera dina WAF-regler minst kvartalsvis, eftersom nya AI-crawlers dyker upp regelbundet och befintliga crawlers uppdaterar sina user-agent-strängar. Övervaka det communityunderhållna ai.robots.txt-projektet på GitHub för nya hot, och kontrollera serverloggar varje månad för att identifiera nya crawlers på din webbplats.

Ja, detta är en vanlig strategi. Du kan konfigurera WAF-regler för att blockera träningscrawlers som GPTBot och ClaudeBot men tillåta sökcrawlers som OAI-SearchBot och PerplexityBot. Detta skyddar ditt innehåll från att användas i modellträning och behåller synligheten i AI-drivna sökresultat.

WAF-priser varierar beroende på leverantör. Cloudflare erbjuder WAF från 20 USD/månad med AI Crawl Control-funktioner. AWS WAF debiterar per web ACL och regel, vanligtvis 5–10 USD/månad för grundläggande skydd. Azure WAF ingår med Application Gateway. Implementeringskostnaderna är små jämfört med värdet av att skydda ditt innehåll och behålla korrekt analysdata.

AmICited spårar AI-crawleraktivitet och övervakar hur ditt innehåll citeras över ChatGPT, Perplexity, Google AI Overviews och andra AI-plattformar. Få insikt i din AI-närvaro och förstå vilka crawlers som får åtkomst till ditt innehåll.

Lär dig hur du konfigurerar robots.txt för att kontrollera AI-crawler-åtkomst, inklusive GPTBot, ClaudeBot och Perplexity. Hantera din varumärkesexponering i AI...

Diskussion i communityn om att låta AI-botar crawla din sajt. Verkliga erfarenheter av robots.txt-konfiguration, llms.txt-implementering och hantering av AI-cra...

Lär dig hur du granskar AI-crawlers åtkomst till din webbplats. Upptäck vilka botar som kan se ditt innehåll och åtgärda hinder som förhindrar AI-synlighet i Ch...